![Biggest AI Tool and Model Updates in 2023 [With Features]](https://meetcody.ai/wp-content/uploads/2023/11/All-AI-Tool-and-Model-Updates.png)

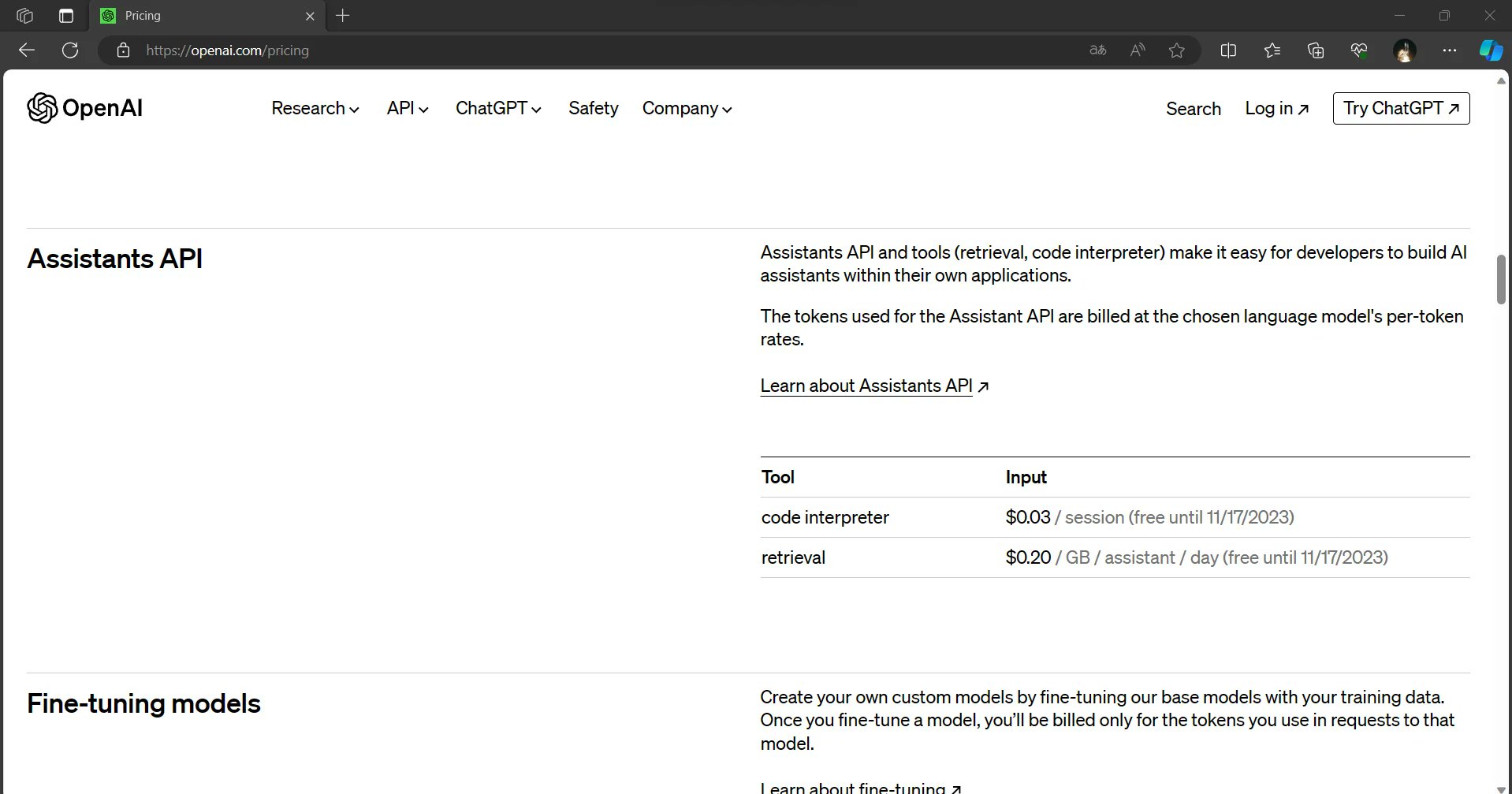

AI市場の成長率は

38%

に成長し、その大きな理由のひとつは、大手ブランドが導入した多数のAIモデルやツールである!

しかし、なぜ企業はビジネス用のAIモデルやツールを発表するのだろうか?

PWC

は、AIが2025年までに従業員の潜在能力を最大40%高めることができると報告している!

AI市場の前年比収益予測(2018-2025年)については、以下のグラフをご覧ください。

米国には

米国だけで14,700の新興企業がある。

2023年3月現在、米国だけでも14,700の新興企業があり、AIのビジネスの可能性は間違いなく大きい!

AIにおける大規模言語モデル(LLM)とは?

大規模言語モデル(LLM)は、言語理解と生成を通じて人間のような知性をシミュレートするために設計された高度なAIツールである。 これらのモデルは、膨大なデータを統計的に分析し、単語やフレーズがどのように相互に結びついているかを学習することで作動する。

人工知能のサブセットとして、LLMはテキストの作成、分類、対話での質問への回答、言語の翻訳など、さまざまなタスクに長けている。

この “大規模 “という呼称は、彼らがトレーニングした膨大なデータセットに由来する。 LLMの基礎は機械学習、特にトランスフォーマーモデルとして知られるニューラルネットワークのフレームワークにある。 これにより、さまざまな自然言語処理(NLP)タスクを効果的に処理することができ、言語を理解し操作する上での多用途性を示すことができる。

続きを読む

RAG (Retrieval-Augmented Generation) vs LLM?

2023年、オープンソースLLMのトップは?

2023年9月現在

ファルコン180B

は、Hugging Face Open LLM Leaderboardにおいて、事前学習済みの大規模言語モデルとしてトップに浮上し、最高のパフォーマンス・ランキングを達成しました。

2023年のAIモデル・トップ7を紹介しよう。

1.ファルコンLLM

ファルコンLLM

は、AI言語処理の能力を再定義した、強力な事前学習済みのオープンラージ言語モデルです。

このモデルには1800億のパラメータがあり、3兆5000億のトークンで訓練されている。 商業用にも研究用にも使える。

2023年6月、ファルコンLLMはHuggingFaceのオープンLLMリーダーボードでトップに立ち、「キング・オブ・オープンソースLLM」の称号を得た。

ファルコンLLMの特徴

- 推論、熟練度、コーディング、知識テストにおいて好成績を収める。

- FlashAttentionとマルチクエリーアテンションにより、より高速な推論と優れたスケーラビリティを実現。

- ロイヤリティの義務や制限なしに商用利用が可能。

- このプラットフォームは無料で利用できる。

2.ラマ2

メタがリリース

ラマ2

訓練済みのオンライン・データ・ソースで、無料で利用できる。 Llama 2はLlamaの2番目のバージョンで、コンテキストの長さが2倍になり、トレーニング量も40%増えた。

また、ラマ2には、ベストプラクティスと安全性評価を理解するための「責任ある使用ガイド」も用意されている。

ラマ2の特徴

- Llama 2は、研究および商用利用ともに無料でご利用いただけます。

- 学習済みバージョンと会話微調整バージョンの両方のモデル重みと開始コードを含みます。

- アマゾン・ウェブ・サービス(AWS)やハギング・フェイスなど、さまざまなプロバイダーを通じてアクセスできる。

- 倫理的かつ責任ある利用を確保するため、利用ポリシーを実施する。

3.クロード2.0と2.1

クロード 2 は、Anthropic社が開発した高度な言語モデルである。 このモデルは、APIと新しい一般向けベータ版ウェブサイトclaude.aiの両方を通じて、改善されたパフォーマンス、より長い応答、およびアクセシビリティを誇っている。

ChatGPTの後、このモデルはより大きなコンテキストウィンドウを提供し、最も効率的なチャットボットの一つと考えられています。

クロード2の特徴

- 前モデルより性能が向上し、より長いレスポンスを実現。

- APIアクセスと新しい一般向けベータ版ウェブサイトclaude.aiの両方を通じて、ユーザーがクロード2と対話できるようにする。

- 従来モデルより長い記憶力を発揮。

- セーフティ・テクニックを駆使し、広範囲に及ぶレッド・チームを編成して、攻撃的あるいは危険なアウトプットを軽減する。

無料版: 利用可能

価格 20ドル/月

クロード2.1モデル

クロード2.1モデル

2023年11月21日に導入され、エンタープライズ・アプリケーションに特筆すべき改善がもたらされた。 最先端の20万トークンコンテキストウィンドウを備え、モデルの幻覚を大幅に減らし、システムプロンプトを強化し、ツールの使用に焦点を当てた新しいベータ機能を導入している。

クロード2.1は、企業にとって重要な機能の進歩をもたらすだけでなく、20万トークンという新たな制限を設けることで、システムに伝達できる情報量を倍増させた。

これは約15万ワード、500ページ以上のコンテンツに相当する。 ユーザーは、完全なコードベース、S-1フォームのような包括的な財務諸表、あるいは “イーリアス “や “オデュッセイア “のような長大な文学作品など、広範な技術文書をアップロードできるようになった。

クロードは、大量のコンテンツやデータを処理し、対話する能力によって、情報の要約、質疑応答、トレンド予測、複数のドキュメントの比較対照などを効率的に行うことができる。

クロード2.1の特徴

- 幻覚率の2倍減少

- APIツールの使用

- 開発者エクスペリエンスの向上

価格 未定

4.MPT-7B

MPT-7BはMosaicML前訓練変換器の略で、1兆トークンのテキストとコードでゼロから訓練された。 GPTと同様、MPTもデコーダのみのトランスで動作しますが、いくつかの改良が加えられています。

費用は20万ドル

MPT-7B

はMosaicMLプラットフォーム上で9.5日間、人手を介さずにトレーニングされた。

特徴

- 様々な会話タスクのためのダイアログを生成します。

- シームレスで魅力的なマルチターン・インタラクションのための設備が整っている。

- データ準備、トレーニング、微調整、配備を含む。

- 文脈を失うことなく、非常に長い入力を処理できる。

- 無料で利用できる。

5.コードラマ

Code Llamaは、特にテキストプロンプトに基づいてコードを生成し、議論するために設計された大規模言語モデル(LLM)です。 これは、一般に公開されているコーディングタスク用のLLMの中では、最先端の開発である。

によると

メタのニュースブログ

Code Llamaはオープンモデルの評価をサポートし、コミュニティが能力を評価し、問題を特定し、脆弱性を修正できるようにすることを目的としている。

CodeLIamaの特徴:

- コーディング学習者の参入障壁を下げる。

- 堅牢で文書化されたソフトウェアを書くための生産性向上および教育ツールとしての役割を果たす。

- Python、C++、Java、PHP、Typescript(Javascript)、C#、Bashなど、一般的なプログラミング言語に対応。

- パラメータは7B、13B、34Bの3つのサイズがあり、それぞれ500Bトークンのコードとコード関連データで学習される。

- コストゼロで導入できる。

6.ミストラル-7B AIモデル

ミストラル 7B はMistral AIチームによって開発された大規模な言語モデルである。 これは73億ものパラメータを持つ言語モデルであり、複雑な言語パターンを理解し、生成する能力があることを示している。

さらに、ミストラル -7Bは、史上最高の7Bモデルであると主張している。

史上最高の7Bモデル

いくつかのベンチマークでLlama 2 13Bを上回り、言語学習における有効性を証明している。

ミストラル-7Bの特徴

- グループ化されたクエリー・アテンション(GQA)を利用して推論を高速化し、クエリーの処理効率を向上。

- スライディングウィンドウアテンション(SWA)を実装し、より長いシーケンスをより少ない計算コストで処理。

- さまざまなタスクの微調整が容易で、さまざまな用途に適応できる。

- 利用は無料。

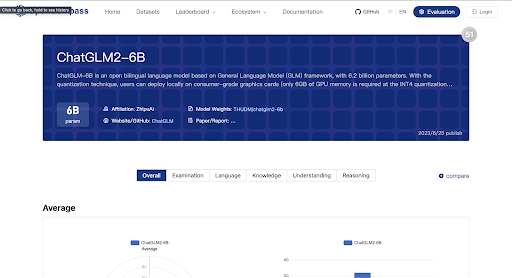

7.チャットGLM2-6B

ChatGLM2-6B

は、オープンソースのバイリンガル(中国語-英語)チャットモデルChatGLM-6Bの第2バージョンです。ChatGPTに代わる軽量なチャットモデルの需要に応えて、中国の清華大学の研究者によって開発されました。

ChatGLM2-6B 特徴

- 英語と中国語の1兆以上のトークンで学習。

- 1兆4,000億以上のトークンで事前学習し、言語理解を向上。

- 2Kから32Kに拡張された、より長いコンテクストをサポート。

- 様々なデータセット(MMLU、CEval、BBH)において、同規模の競合モデルを凌駕。

無料版: 利用可能

価格 お問い合わせください。

AIツールとは何か?

AIツールは、人工知能アルゴリズムを利用して特定のタスクを実行し、複雑な問題を解決するソフトウェア・アプリケーションである。 これらのツールは、医療、金融、マーケティング、教育など、さまざまな業界に応用され、タスクの自動化、データの分析、意思決定の支援に役立っている。

AIツールの利点には、プロセスの効率化、時間の節約、バイアスの軽減、反復作業の自動化などがある。

しかし、導入にコストがかかる、雇用が奪われる可能性がある、感情的・創造的能力が不足している、といった課題が目立っている。 こうしたデメリットを軽減するために、重要なのは適切なAIツールを選択することだ。

2023年、最高のAIツールはどれか?

AIツールの思慮深い選択と戦略的導入は、特定のニーズに対して最も価値を提供するものに集中することでコストを削減することができる。 AIツールを慎重に選択し、統合することで、AIツールの利点を活用しながら課題を最小限に抑え、よりバランスの取れた効果的なテクノロジーの活用につなげることができる。

2023年のAIツール・トップ13はこれだ。

1.AIのチャットGPTを開く

チャットGPT は自然言語処理AIモデルで、人間のような会話の答えを生成する。 ケーキの焼き方」という簡単な質問から、高度なコードを書くこともできる。 エッセイ、ソーシャルメディアへの投稿、電子メール、コードなどを生成することができる。

このボットを使って、最もシンプルな方法で新しいコンセプトを学ぶことができます。

このAIチャットボットは、2022年11月にResearch and Artificial companyであるOpen AIによって構築・発表され、瞬く間にネットユーザーの間でセンセーションを巻き起こした。

特徴

- AIはチャットボットのようで、ユーザーフレンドリーになっている。

- 様々なトピックに関する知識がある。

- 多言語対応で、50以上の言語に対応している。

- GPT 3バージョンは無料で使用できる。

無料版: 利用可能

価格設定:

- チャットGPT-3: 無料

- チャットGPTプラス: 20ドル/月

ラーフル・ショーカンド

共同創設者

ウィリエール

最近、私たちはChatGPTを使って、企業顧客から最もリクエストの多かったAndroidアプリの機能を実装しました。 顧客にとって適切なSaaSであるためには、その機能を開発しなければならなかった。 ChatGPTを使うことで、複雑な数学的、論理的なJAVA関数を命令することができ、私たちの要求を正確に満たすことができました。 1週間もかからずに、JAVAのコードを修正して適応させることで、この機能をエンタープライズのお客様に提供することができました。 この機能を立ち上げると、すぐにB2B SaaSの契約数と収益が25~30%増加しました。

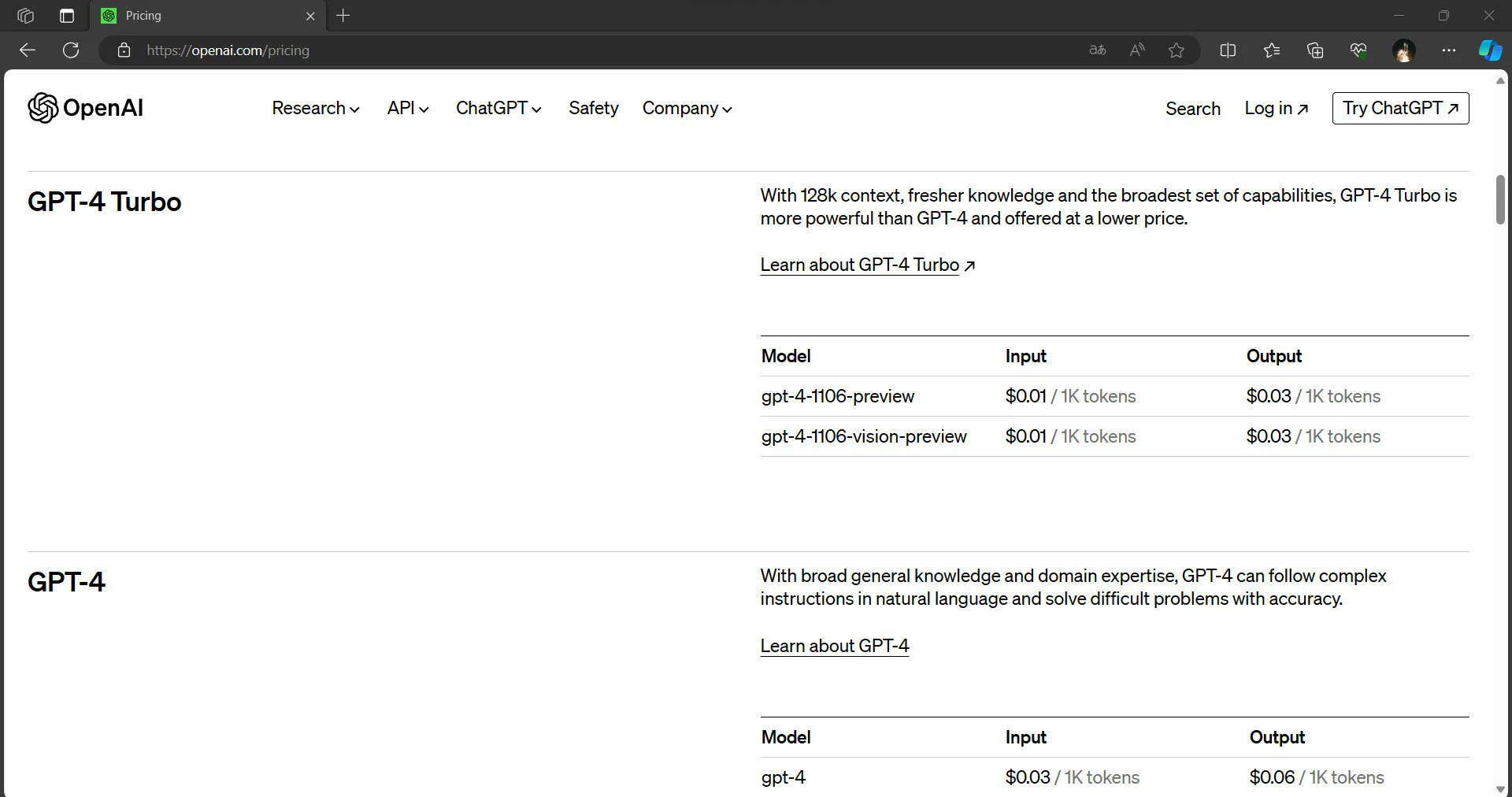

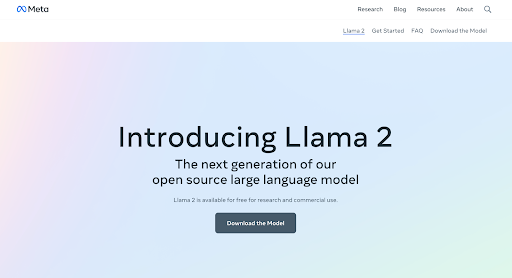

2.GPT-4 ターボ 128K コンテキスト

GPT-4 ターボ 128K コンテキスト

は、GPT 3.5の改良された高度なバージョンとしてリリースされました。 128Kのコンテキスト・ウィンドウでは、RAG(Retrieval Augmented Generation)のようなテクニックを使用して、アプリケーションのためにはるかに多くのカスタム・データを取得することができます。

特徴

- ユーザーの自然言語入力に基づき、機能的な呼び出しを強化。

- JSONモードを使用したソフトウェアシステムとの相互運用。

- シードパラメータを使用した再現性のある出力を提供。

- 2023年4月まで19ヶ月間、知識の締め切りを延長する。

無料版 利用不可

価格設定:

- 入力 0.01ドル/1000トークン

- 出力 0.3ドル/1000トークン

3.チャットGPT4ビジョン

オープンAIがマルチモーダル

GPT-4ビジョン

2023年3月 このバージョンは、様々な種類のテキストやビジュアル形式を処理することができるので、チャットGPTの最も便利なバージョンの一つです。 GPT-4は高度な画像とナレーション機能を備えており、さまざまなイノベーションとユースケースを解き放つ。

ChatGPT-4の生成AIは、ChatGPT-3の500倍にあたる100兆個のパラメータで学習される。

特徴

- 写真、文書、手書きのメモ、スクリーンショットなど、視覚的な入力を理解する。

- 入力としてアップロードされたビジュアルをもとに、オブジェクトや図形を検出・分析。

- グラフやチャートなどのビジュアル形式のデータ分析を提供。

- 3倍の費用対効果モデルを提供

- 4096個の出力トークンを返す

無料版 利用不可

価格設定 使用した分だけ支払うモデル

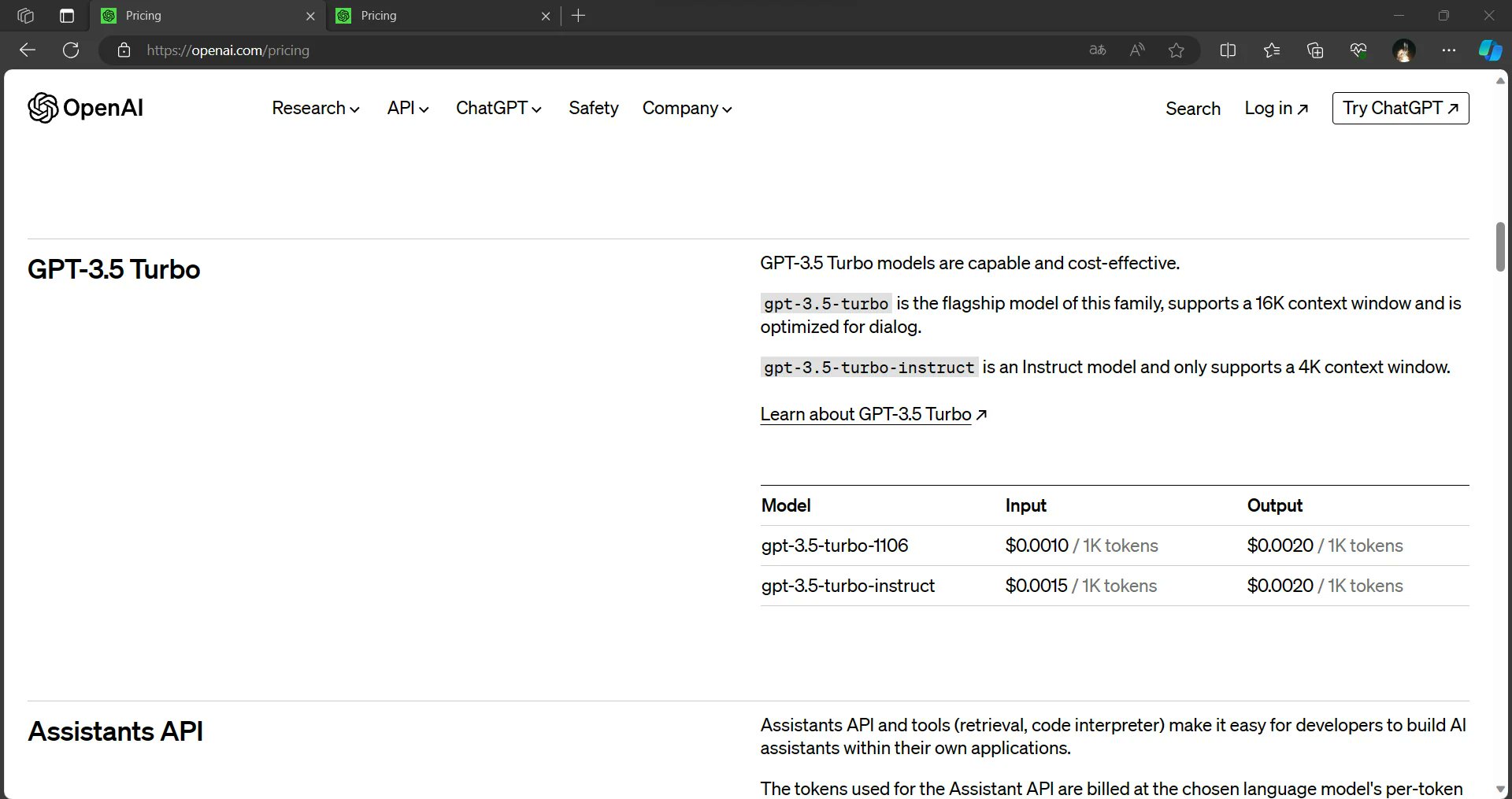

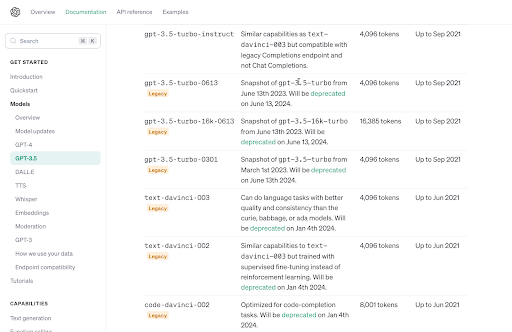

4.GPT3.5ターボ・インストラクター

GPT3.5ターボ・インストラクター は、GPT-3バージョンで再発した問題を軽減するためにリリースされた。 これらの問題には、不正確な情報、古い事実などが含まれる。

そのため、3.5バージョンは、ユーザーのクエリに対して論理的、文脈的に正しく、直接的なレスポンスを返すように特別に設計されている。

特徴

- 指示を理解し、効率的に実行する。

- 数少ないトークンを使って、より簡潔で的確なものを作る。

- ユーザーのニーズに合わせた、より迅速で正確な回答を提供。

- 暗記よりも精神的な推理力を重視。

無料版 利用不可

価格設定:

- 入力 0.0015ドル/1000トークン

- 出力 0.0020ドル/1000トークン

5.マイクロソフトのAIツール「コパイロット

コパイロット365 は、マイクロソフト・オフィス全体で動作する本格的なAIツールである。 このAIを使えば、文書の作成、電子メールの読み取り、要約、返信、プレゼンテーションの作成などができる。 従業員の生産性を向上させ、ワークフローを合理化するために特別に設計されています。

特徴

- 文書やロングチェーンの電子メールを要約します。

- プレゼンテーションを作成し、要約する。

- Excelシートを分析し、データを示すグラフを作成する。

- Outlookの受信トレイをより速くクリーンアップ。

- 提供された情報に基づいてEメールを書く。

無料版 30日間無料トライアル

価格30ドル/月

6.SAPのジェネレーティブAIアシスタントジュール

ジュールはジェネレーティブ

AIアシスタントです。

人事、財務、サプライチェーン、調達、カスタマーエクスペリエンスなどのSAPアプリケーションに組み込まれている。

このAI技術を使えば、必要なときにいつでも迅速な対応と洞察に満ちた洞察を得ることができ、遅滞なく迅速な意思決定が可能になる。

特徴

- 販売実績の把握と改善、問題点の特定、解決策の提案を支援する。

- すべてのSAPソリューションの新しいシナリオを継続的に提供する。

- 偏りのない職務内容や適切な面接質問を作成することで、人事に役立ちます。

- 平易な言語によるクエリに基づいてインテリジェントな回答を提供することで、SAPのユーザーエクスペリエンスを変革します。

無料版: 利用可能

価格お問い合わせください。

7.メタのAIスタジオ

メタのAIスタジオ は、企業が顧客と交流する方法を向上させるというビジョンを持って構築されている。 Instagram、Facebook、Messengerなど、さまざまなプラットフォーム上のメッセージング・サービスを使って顧客と対話するためのカスタムAIチャットボットを企業が作成できる。

AI Studioの主なユースケースは、eコマースとカスタマーサポートの分野である。

特徴

- 文書やロングチェーンの電子メールを要約します。

- プレゼンテーションを作成し、要約する。

- Excelシートを分析し、データを示すグラフを作成する。

- Outlookの受信トレイをより速くクリーンアップ。

- 提供された情報に基づいてEメールを書く。

無料版 30日間無料トライアル

価格30ドル/月

8.EYのAIツール

EY AI は、人間の能力と人工知能(AI)を統合し、組織によるAIの確実かつ責任ある採用を促進する。 EYの豊富なビジネス経験、業界の専門知識、先進的なテクノロジー・プラットフォームを活用し、変革的なソリューションを提供します。

特徴

- 様々な領域での経験を活かし、特定のビジネスニーズに合わせたAIソリューションとインサイトを提供。

- EY Fabricを通じて、最先端のAI機能を包括的なソリューションにシームレスに統合。

- EY Fabricを通じて、AI機能をスピードとスケールで組み込む。

無料版 EY従業員は無料

価格お問い合わせください。

9.アマゾンの販売者向けジェネレーティブAIツール

アマゾンは最近

Amazonセラー向けAI

それは、製品に関連するいくつかの機能を支援するものである。 商品タイトル、箇条書き、説明文、リスト詳細などを簡単に書くことができます。

このAIは、出品者のために最小限の時間と労力で高品質の出品と魅力的な商品情報を作成することを目指している。

特徴

- 売り手にとって魅力的な商品タイトル、箇条書き、説明文を作成。

- 自動モニタリングで製品のボトルネックを見つける。

- 自動チャットボットを生成し、顧客満足度を高める。

- 時系列とデータタイプを使用して、エンドツーエンドの予測モデルを生成します。

無料版 無料トライアルあり

価格お問い合わせください。

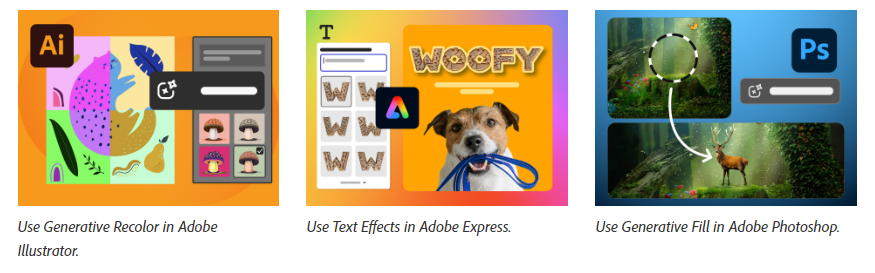

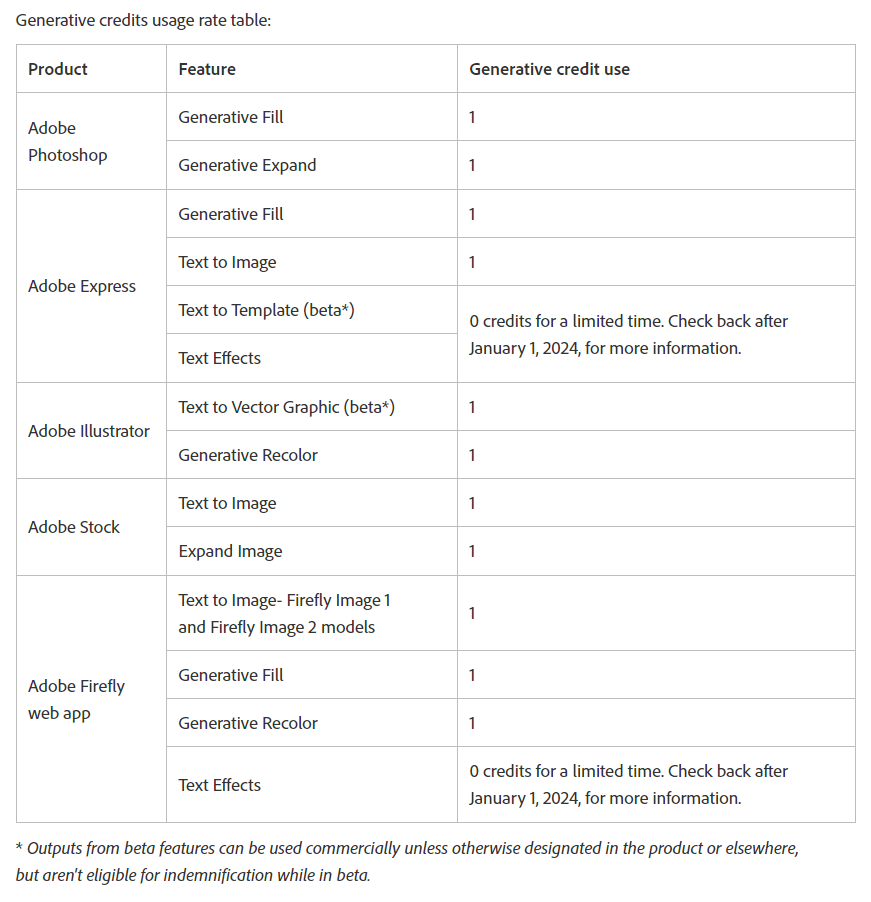

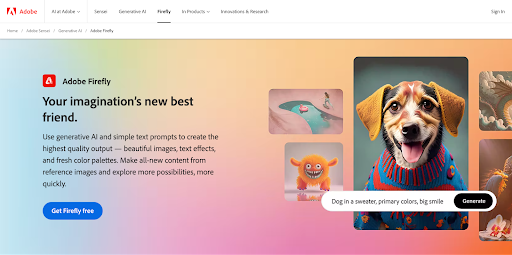

10.アドビのデザイナー向けジェネレーティブAIツール

アドビのジェネレーティブAI for Designersは、デザイナーの創造的なプロセスを強化することを目的としている。 このツールを使えば、プロンプトを使って数秒でシームレスにグラフィックを生成したり、画像を拡大したり、画像内の要素を移動したりすることができます。

このAIは、画像内のあらゆる場所を移動、追加、置換、削除できるようにすることで、デザイナーの自然な創造性を拡大し、サポートすることを目的としている。

特徴

- テキストプロンプトを画像に変換。

- オブジェクトを削除したり、新しいオブジェクトをペイントするためのブラシを提供します。

- ユニークなテキスト効果を提供します。

- 3D要素を画像に変換。

- 画像内のオブジェクトを移動する。

無料版: 利用可能

価格月額4.99ドル

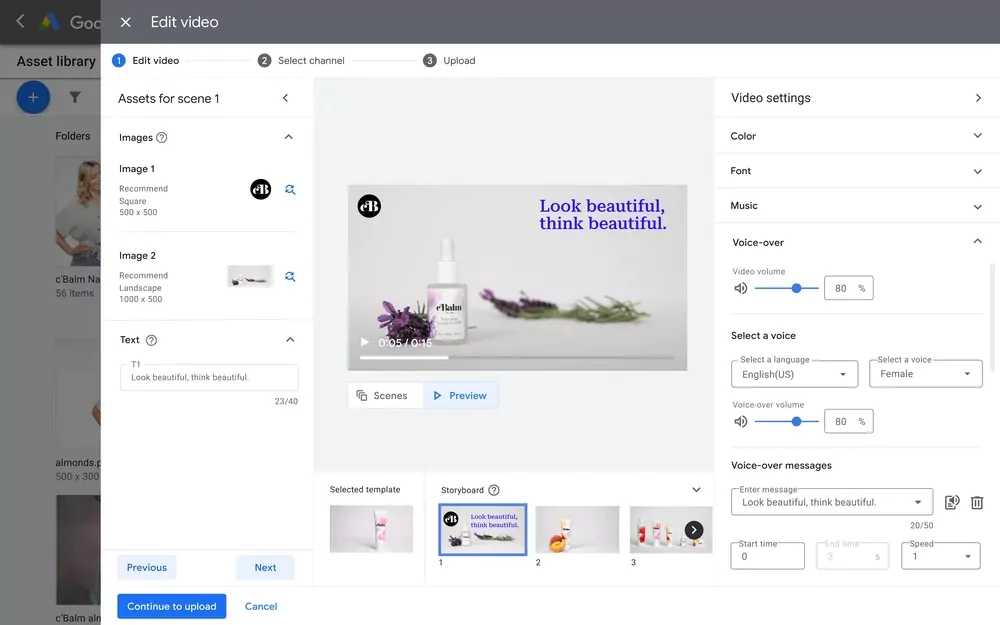

11.グーグルのクリエイティブ・ガイダンスAIツール

グーグルは、動画アナリティクスのオプションで、広告最適化のための新しいAI製品「Creative Guidance AI」を発表した。

クリエイティブガイダンスAI

. このツールは、あなたの広告動画を分析し、Googleのベストプラクティスと要件に基づいて洞察力のあるフィードバックを提供します。

さらに、ビデオを作成するのではなく、既存のビデオを最適化するための貴重なフィードバックを提供する。

特徴

- 動画の5秒以内にブランドロゴが表示されているかどうかを調べる。

- マーケティングの目的に基づき、動画の長さを分析する。

- 高品質のボイスオーバーをスキャンする。

- 映像のアスペクト比を分析する。

無料版 無料

価格お問い合わせください。

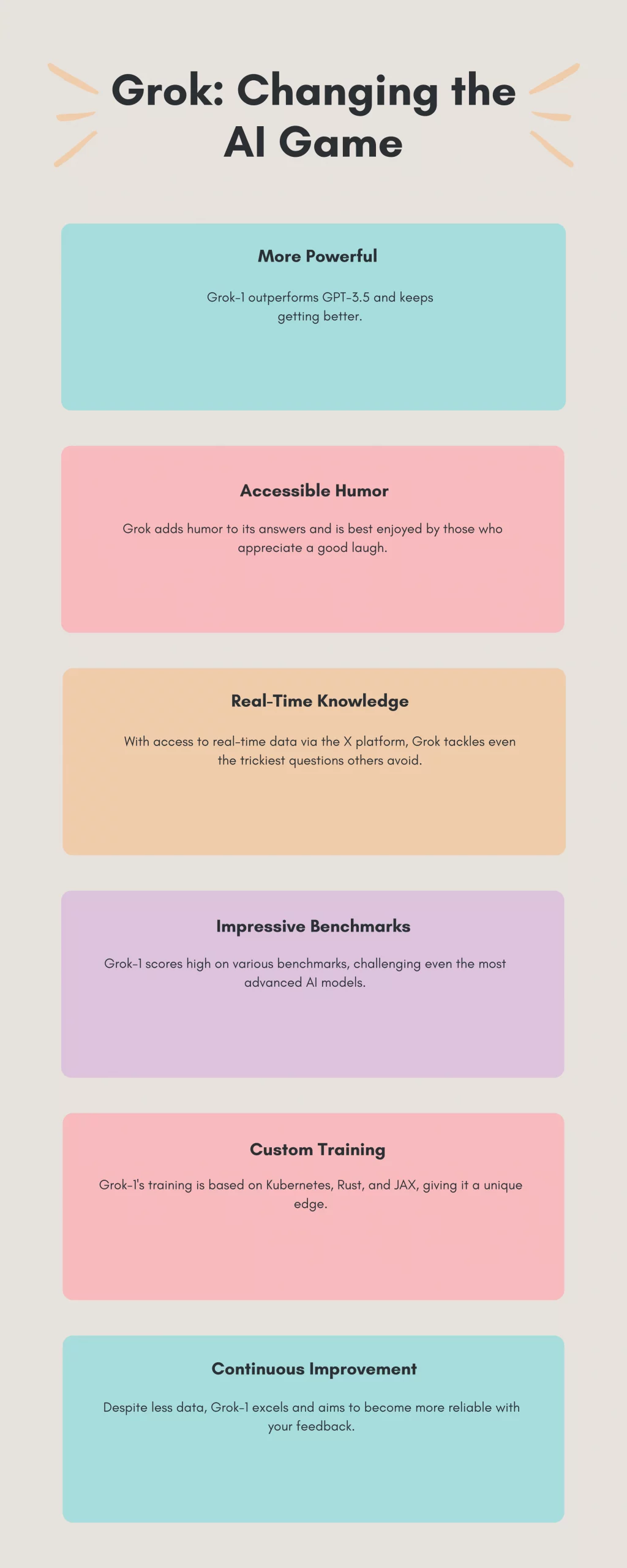

12.Grok: 次世代の生成AIツール

Grok AI は、イーロン・マスクのAIスタートアップであるxAIが開発した大規模な言語モジュールである。 このツールは330億のパラメータでトレーニングされており、700億のパラメータを持つMetaのLLaMA 2に匹敵する。

実際、次のように語っている。

インディアン・エクスプレス

最新のレポートによると、ゴーク1号はクラウズ2号とGPT3.5を上回っているが、GPT4号はまだ上回っていない。

特徴

- Xプラットフォーム(旧Twitter)からリアルタイム情報を抽出。

- ブースト・インタラクションへの対応にユーモアや皮肉を取り入れる、

- 多くのAIが拒否する「スパイシーな質問」に答えることができる。

無料版 30日間無料トライアル

価格16ドル/月

生産性をお探しですか? ここでは、あなたが知っておくべき10のユニークなAIツールを紹介する!

大規模言語モデル(LLM)とAIツール:その違いは?

LLMは生成AIの特殊なサブセットであるが、すべての生成AIツールがLLMフレームワーク上に構築されているわけではない。 ジェネレーティブAIは、テキスト、画像、音楽など、さまざまな形式のオリジナルコンテンツを作成できる、より広範なAI技術を包含している。 これらのツールは、コンテンツを生成するために、LLMを含む基礎となるAIモデルに依存している。

一方、LLMは言語ベースのタスクのために特別に設計されている。 ディープラーニングとニューラルネットワークを活用し、人間のようなテキストを理解、解釈、生成することに優れている。 彼らは主に言語処理に重点を置いており、テキスト生成、翻訳、質問応答などのタスクに長けている。

重要な違いは、その範囲と適用範囲にある: ジェネレーティブAIとは、複数の領域にわたってオリジナルのコンテンツを創造するあらゆるAIを指す広義のカテゴリーであり、LLMは言語関連のタスクに特化したジェネレーティブAIの一種である。 この区別は、AIランドスケープにおけるそれぞれの役割と能力を理解する上で極めて重要である。

デイビッド・ワトキンス

製品管理ディレクター

エトス

–EthOSでは、Alを私たちのプラットフォームに統合した経験は、変革をもたらしました。 IBM Watsonのセンチメントとトーン分析を活用することで、新しいウェブサイトのデザイン、家庭内での製品テスト、その他多くの定性調査において、顧客のセンチメントや感情を迅速に収集することができます。

13.コーディーを試して、ビジネスを簡素化しよう!

Codyは、OpenAIの高度なGPTモデル、特に3.5ターボと4.5ターボを使用してチャットボットを作成するための、アクセス可能でコードなしのソリューションです。 このツールは使いやすく設計されており、技術的なスキルを必要としないため、幅広いユーザーに適しています。 Codyにデータを入力するだけで、あとはCodyが効率的に管理し、手間のかからない体験をお約束します。

Codyの際立った特徴は、特定のモデルのバージョンから独立していることで、ユーザーはボットを再教育することなく、最新のLLMアップデートに対応することができる。 また、カスタマイズ可能なナレッジベースが組み込まれており、継続的に進化することで能力を高めている。

企業内でのプロトタイピングに理想的なCodyは、AIモデルを一から構築する複雑さを伴うことなく、GPTモデルの可能性を示す。 パーソナライズされたモデル・トレーニングのために、様々な形式の企業データを使用することができますが、プライバシーと整合性を維持するために、機密性のない一般公開されているデータを使用することをお勧めします。

堅牢なGPTエコシステムを求める企業向けに、コーディはエンタープライズグレードのソリューションを提供している。 そのAI APIは、さまざまなアプリケーションやサービスへのシームレスな統合を容易にし、ボット管理、メッセージ送信、会話追跡などの機能を提供する。

さらに、Codyは以下のようなプラットフォームと統合することができる。

スラック

,

Discord

そして

Zapier

そして

ボットを他人と共有

. モデルの選択、ボットの性格、信頼度、データソースの参照など、さまざまなカスタマイズオプションが用意されており、特定のニーズに合ったチャットボットを作成することができます。

Codyの使いやすさとカスタマイズ・オプションの融合は、複雑なAIモデル開発に踏み込むことなくGPTテクノロジーの活用を目指す企業にとって優れた選択肢となっている。

次のステップへ

最も簡単なAIのサインアップ

!