SearchGPT発表

OpenAIは、 SearchGPTと呼ばれる画期的なプロトタイプを発表した。SearchGPTは、ユーザーがオンラインで情報にアクセスする方法を変革するために開発されたAI搭載の検索エンジンである。

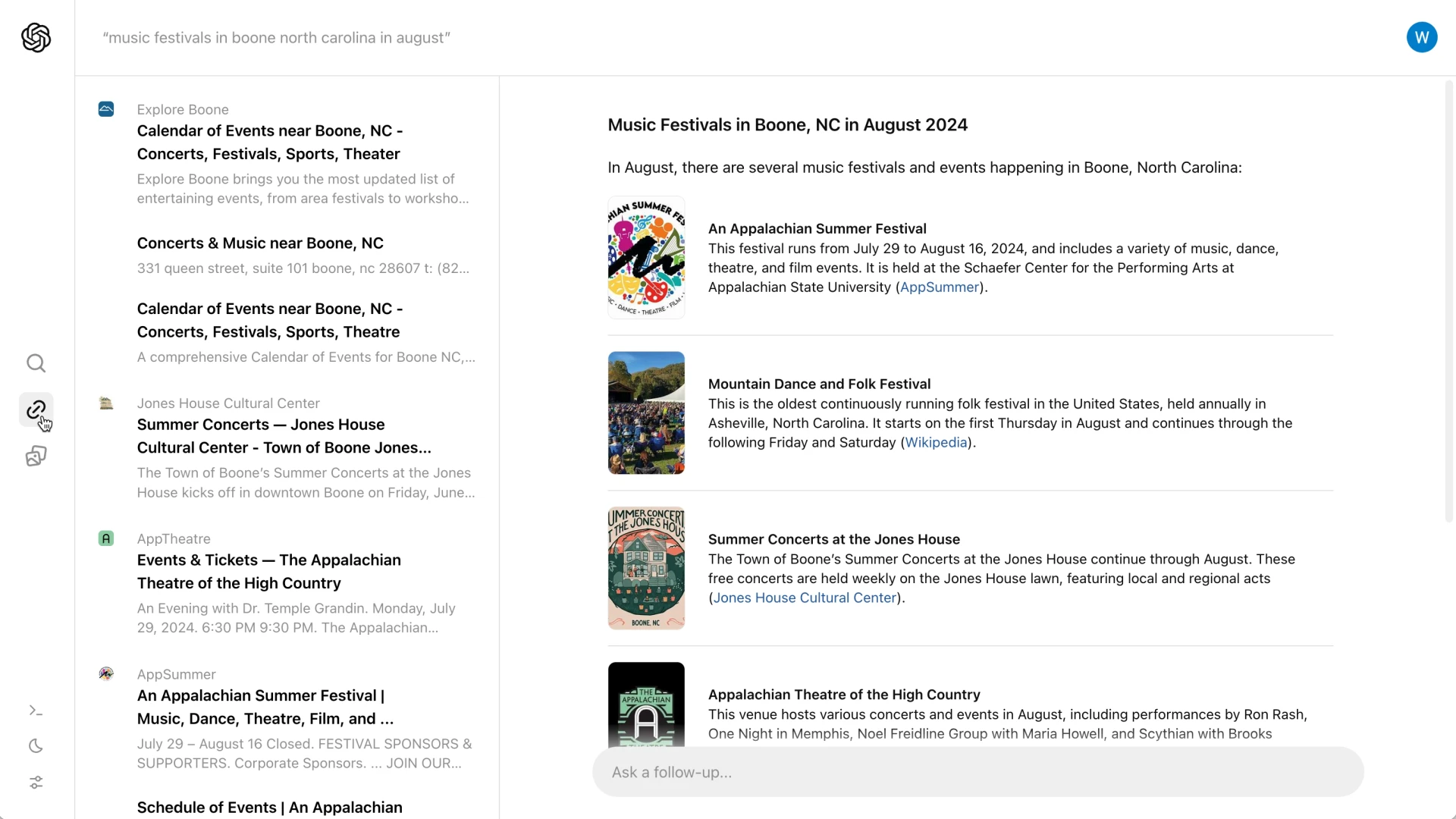

リアルタイムのウェブデータと統合された高度な会話モデルを活用することで、SearchGPTはユーザーのクエリに対して、迅速、正確、タイムリーな回答を提供することを目指している。

リンクのリストを提示する従来の検索エンジンとは異なり、SearchGPTは明確な属性を伴う包括的な要約を提供し、ユーザーが正確で関連性の高い情報を迅速に入手できるようにします。

この革新的なアプローチは、検索体験を合理化し、ユーザーにとってより効果的でインタラクティブなものになるよう設計されています。

主な特徴と目的

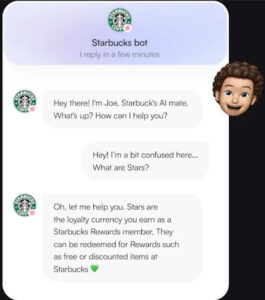

SearchGPTは、従来の検索体験をより合理的で会話的なインタラクションに変えるように設計されています。

リンクのリストを表示する従来の検索エンジンとは異なり、SearchGPTは属性リンクを伴う簡潔な要約を提供します。

このアプローチにより、ユーザーはクエリのエッセンスを素早く把握することができ、同時に元のウェブサイトでさらに詳細を調べることができる。

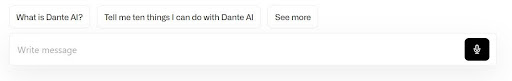

また、このプラットフォームには、ユーザーがフォローアップの質問をすることができるインタラクティブな機能があり、検索プロセスの会話的な側面を豊かにしている。

さらに、サイドバーには関連リンクが追加表示され、ユーザーが包括的な情報を見つける能力をさらに高めている。

目玉機能のひとつは、AIが生成した動画を紹介する「ビジュアルアンサー」の導入で、ユーザーにより魅力的で有益な検索体験を提供する。

出版社とのコラボレーション

SearchGPTは、提供する情報の品質と信頼性を確保するために、報道機関との強力なパートナーシップを築くことを優先してきました。

The Atlantic、News Corp、The Associated Pressのような信頼できる出版社と協力することで、OpenAIはユーザーに正確で信頼できる検索結果を確実に提供します。

また、これらのパートナーシップにより、出版社は検索結果で自社のコンテンツがどのように表示されるかをよりコントロールできるようになります。

出版社は、OpenAIのAIモデルのトレーニングに自社のコンテンツが使用されないようにすることができる。

このアプローチは、オリジナルコンテンツの完全性と出所を保護することを目的としており、ユーザーとコンテンツ制作者の双方にとってメリットがある。

競合他社との差別化

SearchGPTは、AI統合型検索エンジンに内在する重大な問題に取り組むことで、Googleのような競合他社とは一線を画している。

Googleのアプローチは、検索結果内で直接的な回答を提供することにより、不正確さやオリジナルコンテンツソースへのトラフィックを減少させるという批判にしばしば直面する。

対照的に、SearchGPTは明確なアトリビューションを保証し、詳細な情報を得るためにパブリッシャーのサイトを訪問することをユーザーに促している。

この戦略は、正確で信頼できるデータによってユーザーエクスペリエンスを向上させるだけでなく、責任あるコンテンツ共有を通じてパブリッシャーの健全なエコシステムを維持することを目的としています。

ユーザーからのフィードバックと今後の統合

SearchGPTの現在のリリースはプロトタイプで、一部のユーザーとパブリッシャーに提供されています。

この限定的な展開は、貴重なフィードバックと洞察を収集し、サービスの改良と強化に役立てるためのものです。

OpenAIは最終的に、SearchGPTの最も成功した機能をChatGPTに統合し、AIとリアルタイムのウェブ情報をより密接に結びつけることを計画しています。

プロトタイプのテストに興味のあるユーザーはウェイティングリストに参加する機会があり、パブリッシャーはその体験についてフィードバックを提供することが奨励されている。

このフィードバックは、SearchGPTがユーザーのニーズを満たし、高水準の精度と信頼性を維持できるよう、今後のSearchGPTを形作る上で極めて重要です。

課題と考察

SearchGPTはプロトタイプの段階に入り、様々な課題に直面している。

重要な側面の一つは、情報の正確さと情報源への適切な帰属を確保することである。

グーグルが直面した落とし穴を教訓に、SearchGPTは誤報や誤帰属につながるミスを避けなければならない。

もう一つの大きな課題は、収益化にある。

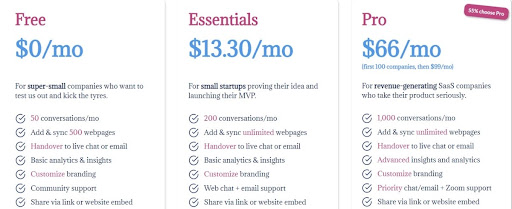

現在、SearchGPTは無料であり、立ち上げ当初は広告なしで運営されている。

この広告なしのアプローチは、AIのトレーニングと推論に関連する膨大なコストを支えることができる持続可能なビジネスモデルを開発するためのハードルとなる。

このような財政的な要求に対処することは、サービスの長期的な実行可能性にとって不可欠である。

まとめると、SearchGPTが成功するためには、OpenAIはこれらの技術的・経済的課題を乗り越え、プラットフォームの精度を確保し、実現可能な収益化戦略を開発しなければならない。

結論

SearchGPTは、AIを活用した検索技術の領域における重要な進歩を意味する。

品質、信頼性、パブリッシャーとのコラボレーションを優先することで、OpenAIはより効率的で信頼できる検索体験を提供することを目指しています。

会話モデルとリアルタイムのウェブ情報の統合により、SearchGPTは従来の検索エンジンやGoogleのようなライバルとは一線を画している。

ユーザーやパブリッシャーからのフィードバックは、この革新的なツールの今後の進化を形作る上で極めて重要である。

プロトタイプの段階が進むにつれ、OpenAIはSearchGPTを改良し、ユーザーのニーズと期待に応えられるようにする計画です。

この継続的なコラボレーションと反復的な改善プロセスは、コンテンツ制作者とユーザーの双方に利益をもたらすバランスの取れたエコシステムの実現に役立つでしょう。

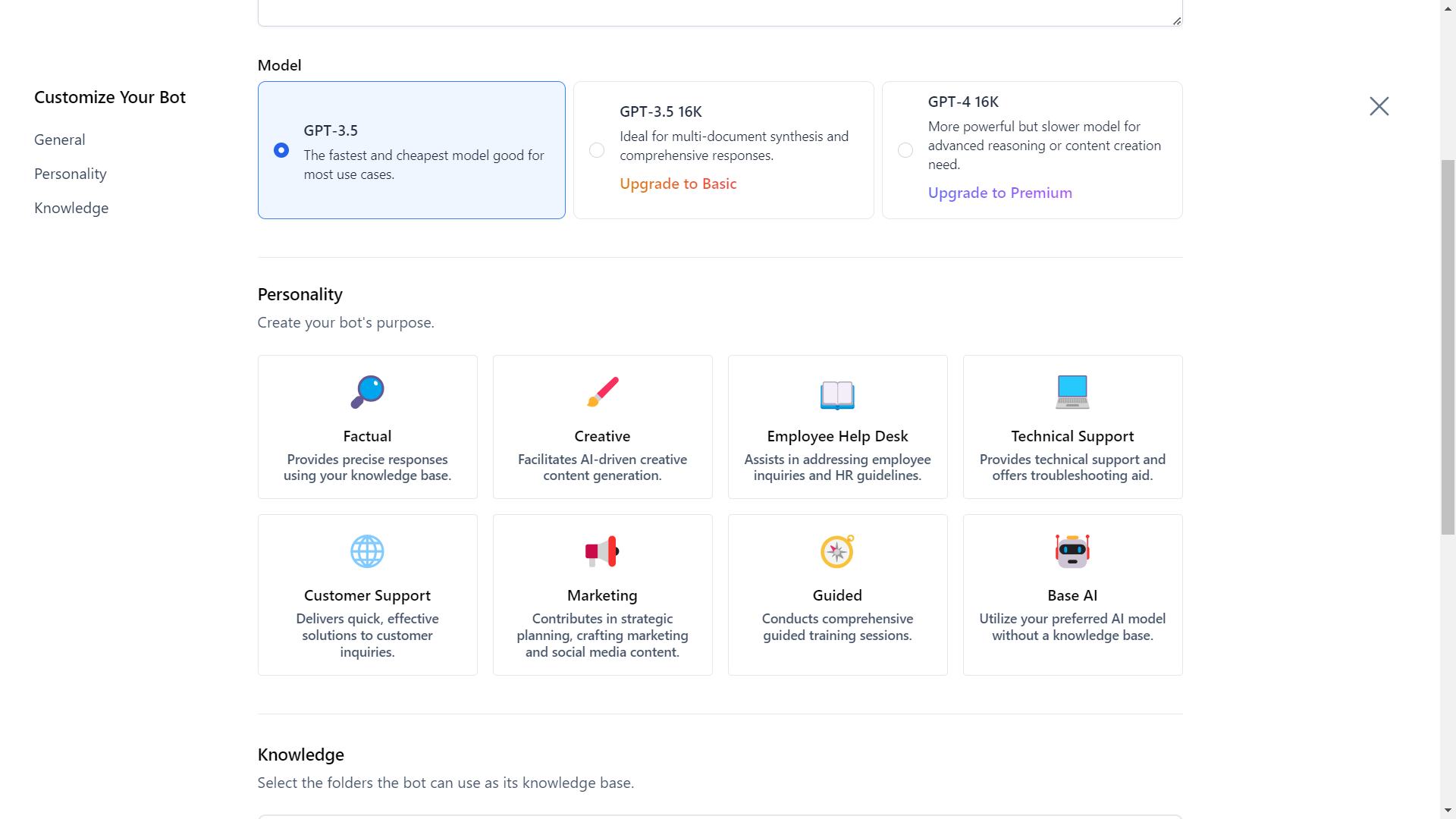

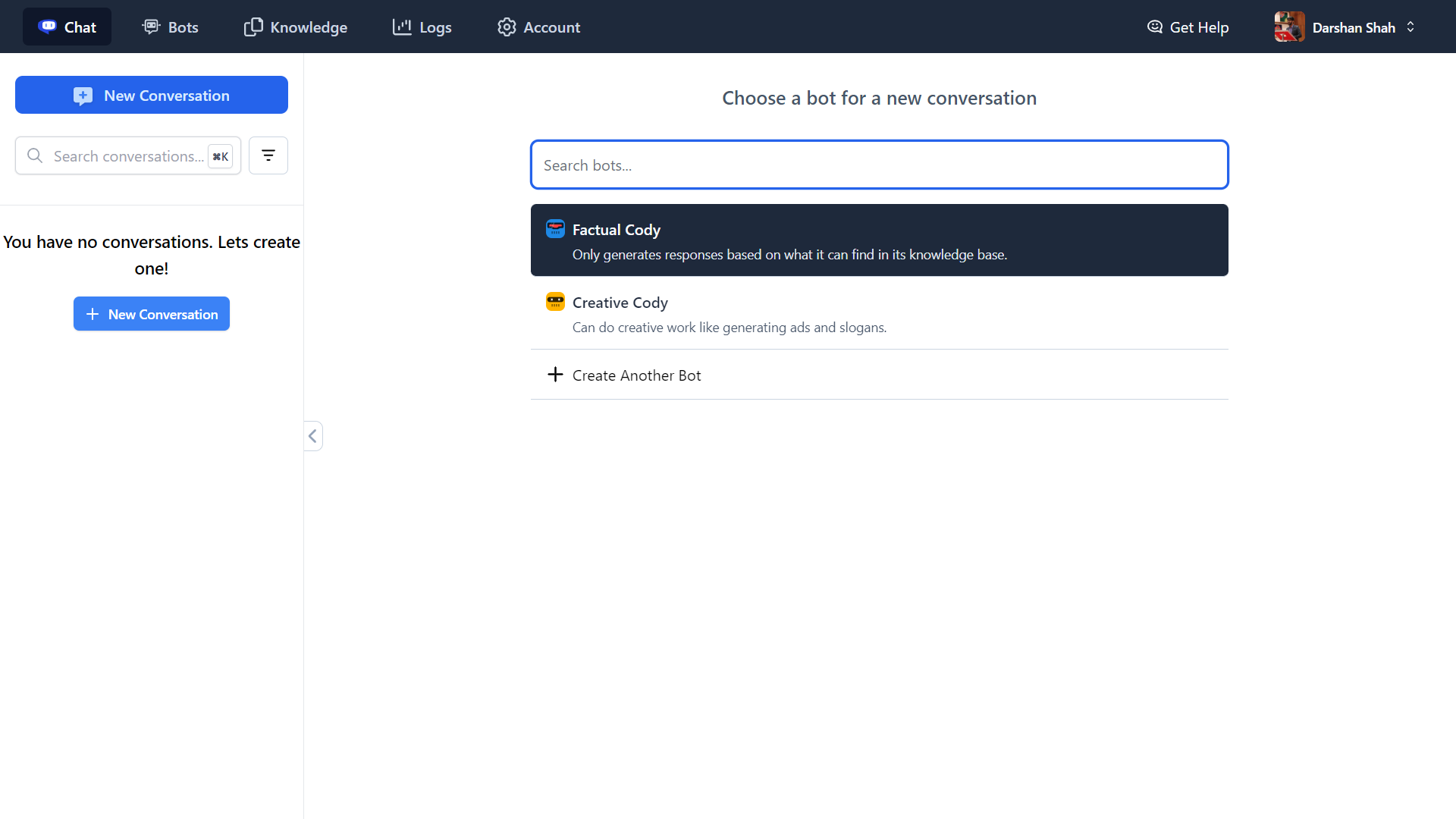

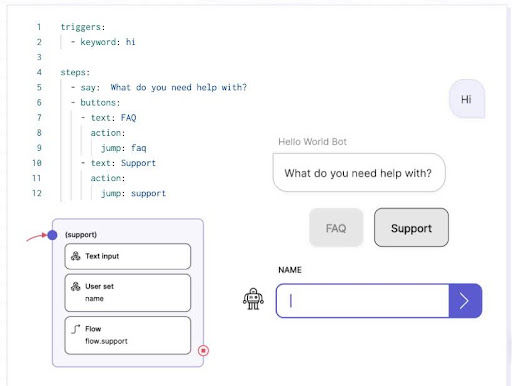

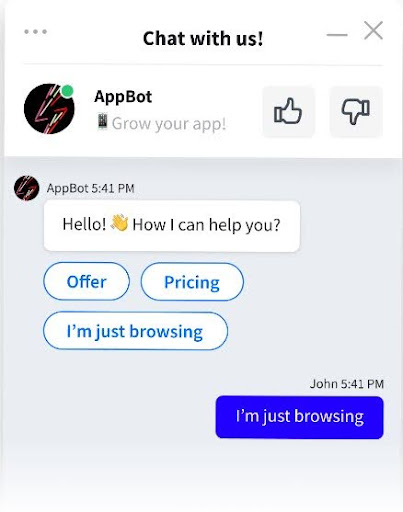

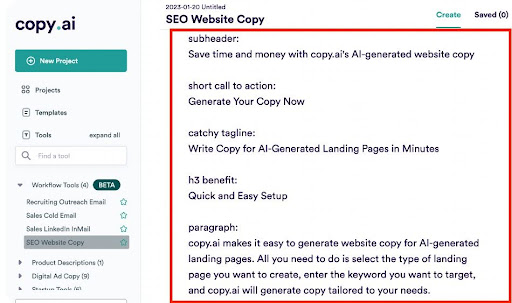

単なるチャットを超えたインテリジェントなAIアシスタント、Cody AIでビジネスインテリジェンスの未来を切り開きましょう。

あなたのビジネス、チーム、プロセス、クライアントの知識をCodyにシームレスに統合し、生産性を向上させます。

回答、創造的なソリューション、トラブルシューティング、ブレーンストーミングなど、どのようなニーズにもCodyが対応します。

今すぐCody AIをお試しいただき、貴社のビジネスを変革してください!