Nawigacja po przyszłości automatyzacji sieci

Szybki postęp w dziedzinie sztucznej inteligencji na nowo definiuje sposób, w jaki wchodzimy w interakcje z siecią.

Zautomatyzowane przeglądanie stron internetowych i ekstrakcja danych, niegdyś złożone zadania wymagające specjalistycznych umiejętności, stają się teraz dostępne dla szerszego grona odbiorców.

Zmiana ta jest w dużej mierze przypisywana integracji dużych modeli językowych (LLM) i zaawansowanych platform, które upraszczają te procesy.

Zmierzając ku przyszłości napędzanej przez sztuczną inteligencję, narzędzia takie jak agent sieciowy AI firmy Apify, Induced.ai i Multi-ON znajdują się w czołówce, oferując innowacyjne rozwiązania do automatyzacji sieci i zwiększania produktywności.

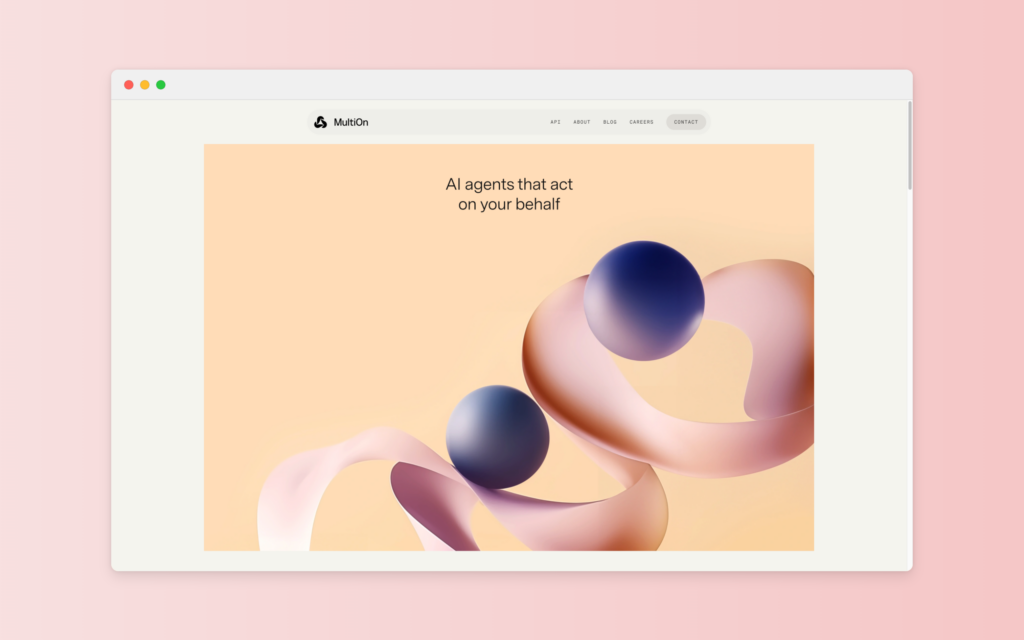

Multi-On

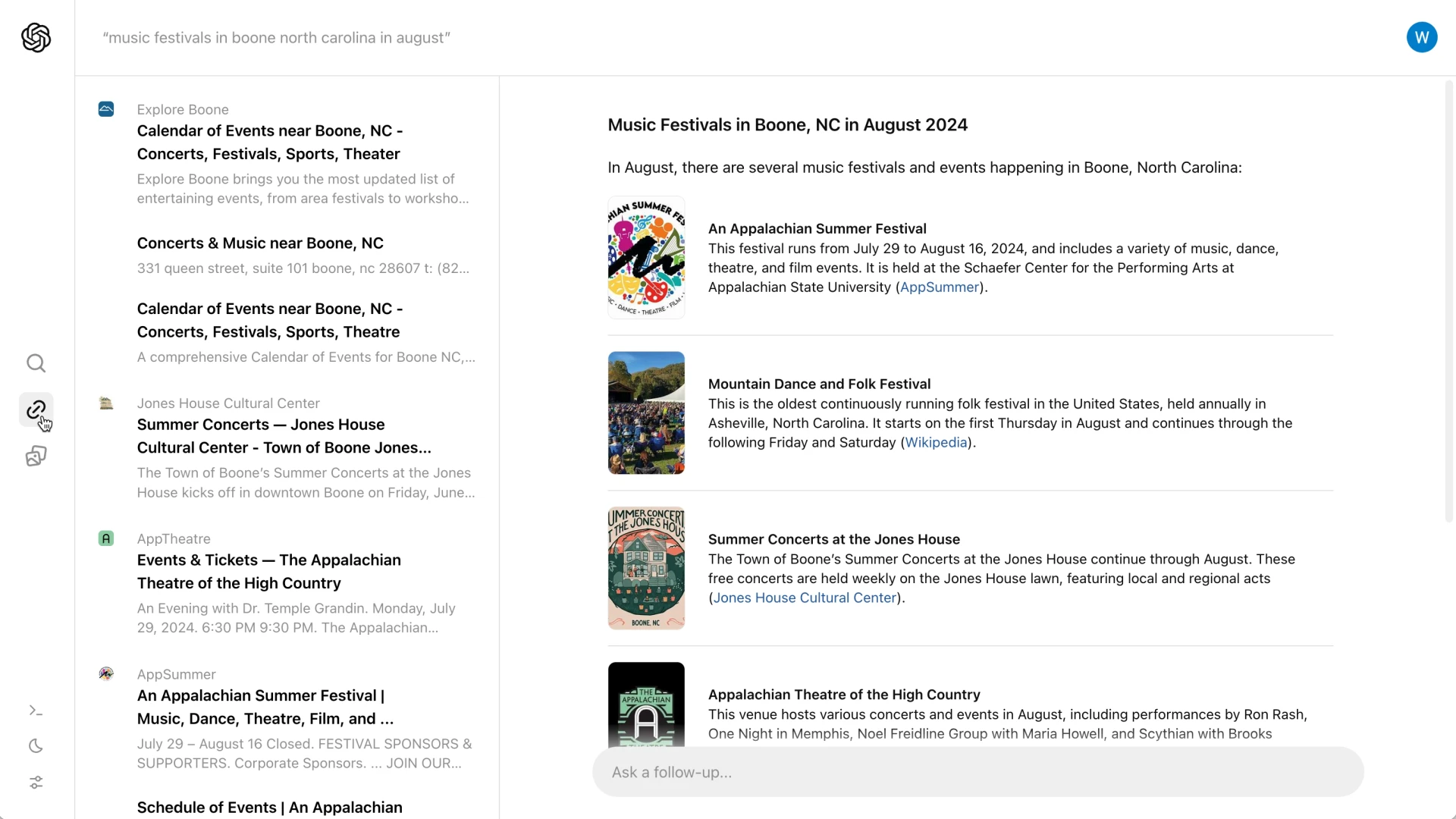

Multi-On wyróżnia się jako pionierski agent przeglądania ai, wykorzystujący moc ChatGPT do redefiniowania przeglądania stron internetowych i wykonywania zadań.

Zaprojektowany z myślą o zwiększonej produktywności, Multi-ON oferuje wspólne przeglądanie, które pomaga użytkownikom w efektywnym poruszaniu się po sieci.

Kluczową cechą tej platformy jest jej zdolność do płynnego zarządzania wieloma zadaniami, zapewniając użytkownikom bardziej usprawnione wrażenia online.

W przeciwieństwie do eksperymentalnego charakteru agenta internetowego ai, Multi-ON jest specjalnie ukierunkowany na optymalizację produktywności użytkowników dzięki możliwościom opartym na sztucznej inteligencji.

Niezależnie od tego, czy użytkownicy prowadzą badania, czy obsługują złożone zadania internetowe, zaawansowana sztuczna inteligencja Multi-ON zapewnia szybkie i dokładne wykonywanie zadań.

Koncentracja tej platformy na współpracy i produktywności użytkowników odróżnia ją od tradycyjnych narzędzi internetowych, oferując unikalne podejście do działań online.

Dzięki integracji z ChatGPT, Multi-ON ma na celu zapewnienie bardziej intuicyjnego i efektywnego przeglądania stron internetowych.

Indukowana sztuczna inteligencja

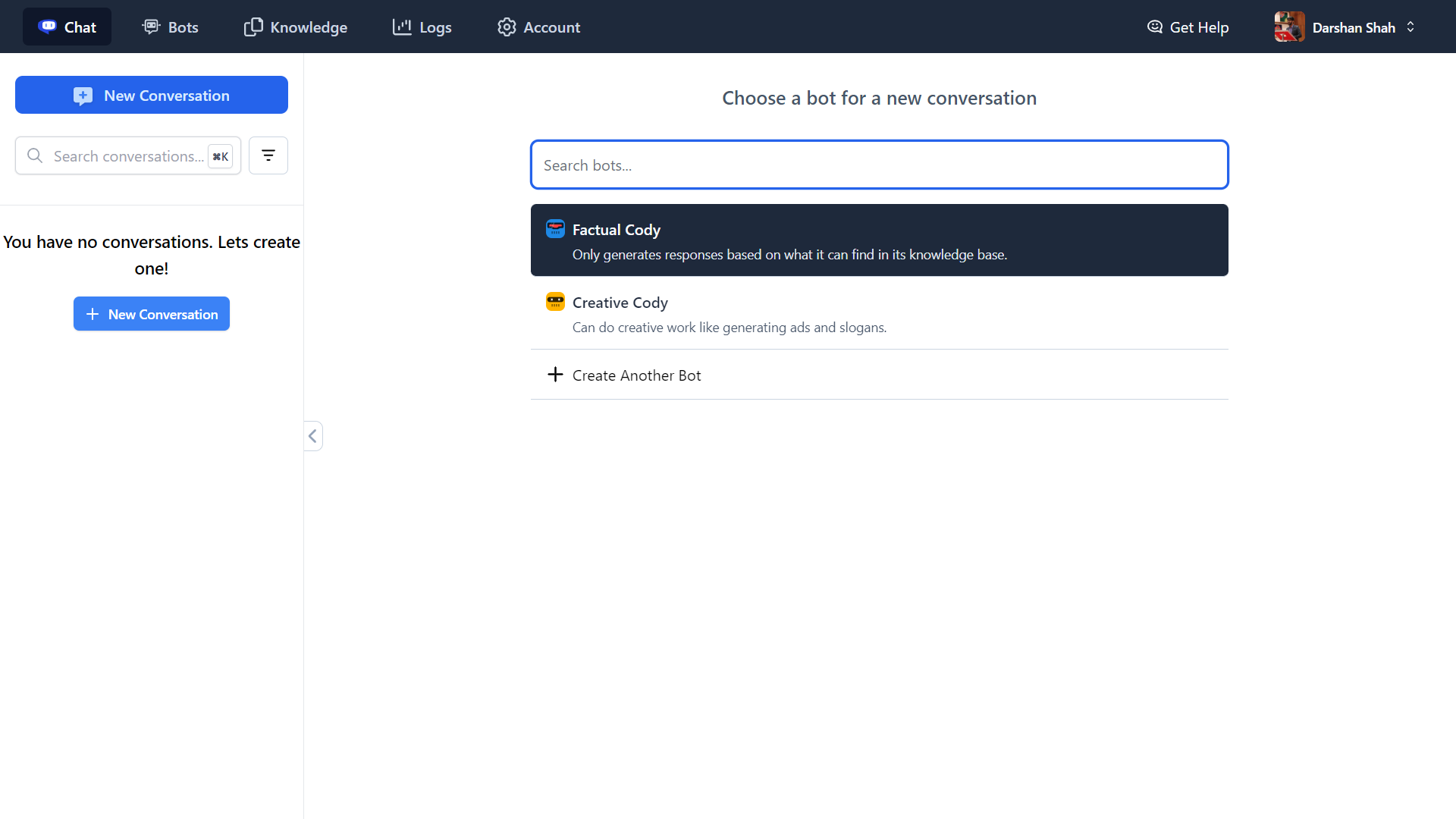

Induced. ai wyróżnia się proaktywnym podejściem do agenta internetowego ai i zarządzania zadaniami.

Platforma została zaprojektowana w celu usprawnienia potoków rozwoju poprzez konsolidację wielu narzędzi w jednym, spójnym interfejsie.

Integracja ta jest chwalona za zdolność do znacznego skrócenia czasu i wysiłku wymaganego do zarządzania różnymi zadaniami internetowymi.

Jedną z kluczowych zalet Induced.ai jest proaktywny system wsparcia.

Użytkownicy mogą szybko rozwiązywać zapytania za pośrednictwem Slacka lub poczty elektronicznej, zapewniając, że procesy rozwoju pozostają nieprzerwane i wydajne.

To wsparcie w czasie rzeczywistym jest kluczową funkcją dla programistów, którzy potrzebują natychmiastowej pomocy, aby utrzymać produktywność.

Nacisk Induced.ai na płynne zarządzanie i szybkie rozwiązywanie problemów sprawia, że jest to idealna opcja dla programistów poszukujących niezawodnej platformy do obsługi automatyzacji sieci i zarządzania zadaniami.

Podejście skoncentrowane na użytkowniku i wspierający ekosystem sprawiają, że jest to solidna alternatywa dla innych narzędzi agenta przeglądającego ai.

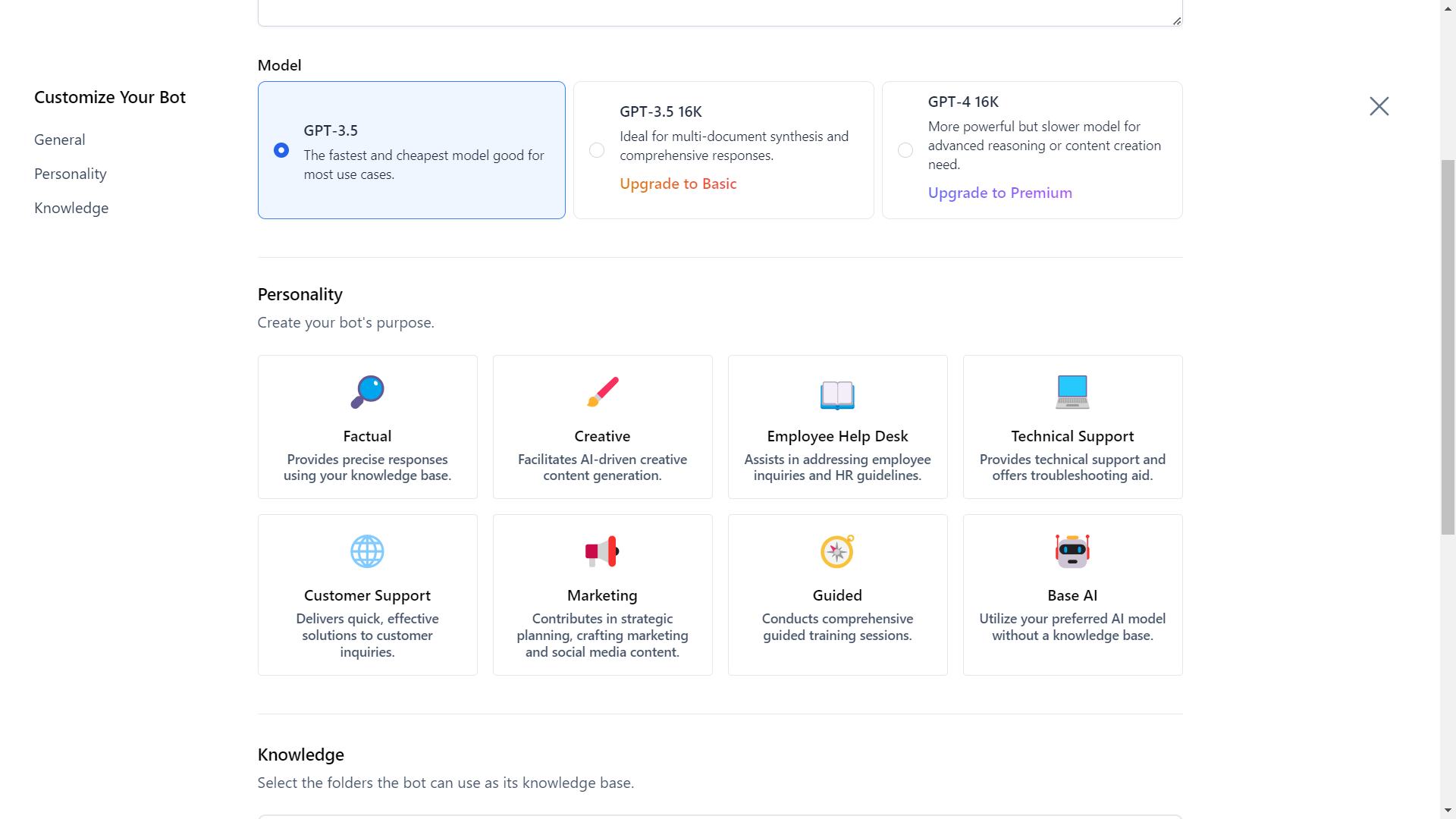

Apify Web Agent

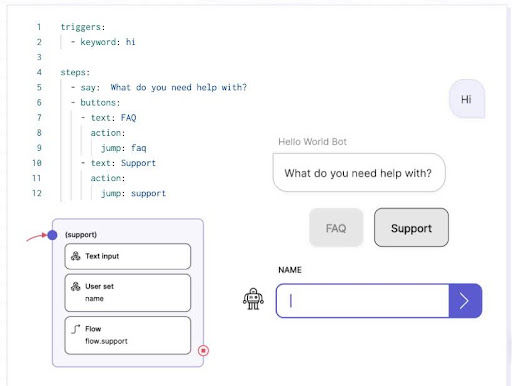

Agent sieciowy Apify ai, opracowany przez Apify, to innowacyjne narzędzie zaprojektowane w celu ułatwienia przeglądania stron internetowych i ekstrakcji danych za pomocą instrukcji w języku naturalnym.

Pomimo tego, że znajduje się w fazie eksperymentalnej, narzędzie to wykazuje znaczny potencjał, wykorzystując platformę Apify i duże modele językowe OpenAI (LLM) do automatyzacji działań internetowych.

Konfiguracja jest przyjazna dla użytkownika, wymagając jedynie początkowego adresu URL strony, opisów zadań w prostym języku i klucza API OpenAI.

Kluczowe ustawienia konfiguracji obejmują początkowy adres URL strony internetowej, którą odwiedzi agent, wymagany klucz API dla usług OpenAI, wybrany model GPT do interpretacji instrukcji oraz konfiguracje proxy, aby uniknąć blokowania przez docelowe strony internetowe.

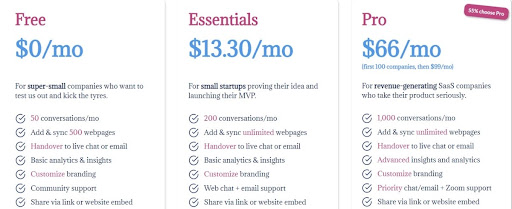

Przykładowo, użytkownicy mogą poprosić agenta przeglądania ai o znalezienie najtańszego planu cenowego na stronie Apify, dostarczając prostych instrukcji do wykonania tego zadania.

Narzędzie nawiguje i wykonuje zadania za pomocą przeglądarki bezgłowej, a koszty są obliczane na podstawie tokenów zużywanych przez LLM i czas działania przeglądarki.

Dodatkowo, możliwości agenta sieciowego ai można rozszerzyć za pomocą interfejsu API Apify, umożliwiając integrację z różnymi środowiskami programistycznymi, takimi jak Python i Node.js.

Należy jednak zwrócić uwagę na jego eksperymentalny charakter, potencjalne koszty i potrzebę wkładu społeczności w celu dalszego zwiększenia jego funkcjonalności.

Porównanie

Porównując agenta internetowego ai firmy Apify z platformami takimi jak Induced.ai i Multi-ON, pojawia się kilka kluczowych różnic, z których każda zaspokaja różne potrzeby użytkowników.

Agent internetowy ai wyróżnia się integracją z interfejsem API OpenAI, umożliwiając wykonywanie zadań za pomocą instrukcji w języku naturalnym i obsługując różne modele GPT w celu zapewnienia elastyczności pod względem kosztów i możliwości.

Pomimo swoich mocnych stron, agent sieciowy ai znajduje się obecnie w fazie eksperymentalnej i nie jest aktywnie utrzymywany, co może stanowić wyzwanie dla długoterminowego użytkowania.

Z drugiej strony, Induced.ai kładzie nacisk na solidne wsparcie i proaktywne rozwiązywanie zapytań za pośrednictwem Slacka lub poczty elektronicznej, dzięki czemu idealnie nadaje się do efektywnego zarządzania potokami rozwoju.

Platforma konsoliduje wiele narzędzi w jednym interfejsie, znacznie oszczędzając czas użytkowników.

Tymczasem Multi-ON, oznaczony jako pierwszy na świecie AI Web Co-Pilot obsługiwany przez ChatGPT, koncentruje się na zwiększaniu produktywności użytkowników poprzez wspólne przeglądanie.

Jego celem jest usprawnienie działań online poprzez zapewnienie pomocy opartej na sztucznej inteligencji, co czyni go cennym narzędziem dla użytkowników, którzy chcą zoptymalizować swoje zadania związane z przeglądaniem sieci.

Każda platforma oferuje unikalne zalety, przy czym agent sieciowy ai wyróżnia się przetwarzaniem języka naturalnego i rozszerzalnością, Induced.ai wsparciem i integracją, a Multi-ON wspólnym przeglądaniem i zarządzaniem zadaniami.

Podsumowanie: Wykorzystanie potencjału przeglądania sieci opartego na sztucznej inteligencji

W miarę jak poruszamy się po przyszłości automatyzacji sieci, potencjał narzędzi opartych na sztucznej inteligencji, takich jak agent sieciowy AI firmy Apify, Induced.ai i Multi-ON, staje się coraz bardziej oczywisty.

Platformy te oferują rewolucyjne możliwości w zakresie zautomatyzowanego przeglądania stron internetowych i zarządzania zadaniami, a każda z nich posiada unikalne funkcje dostosowane do różnych potrzeb użytkowników.

Chociaż agent sieciowy AI Apify wyróżnia się przetwarzaniem języka naturalnego i elastycznością integracji, pozostaje eksperymentalny, a zatem wymaga wkładu społeczności i starannego rozważenia związanych z tym kosztów.