Annonce de la SearchGPT

OpenAI a dévoilé un prototype révolutionnaire appelé SearchGPT, un moteur de recherche alimenté par l’IA conçu pour transformer la manière dont les utilisateurs accèdent à l’information en ligne.

En s’appuyant sur des modèles conversationnels avancés intégrés à des données web en temps réel, SearchGPT vise à fournir des réponses rapides, précises et opportunes aux requêtes des utilisateurs.

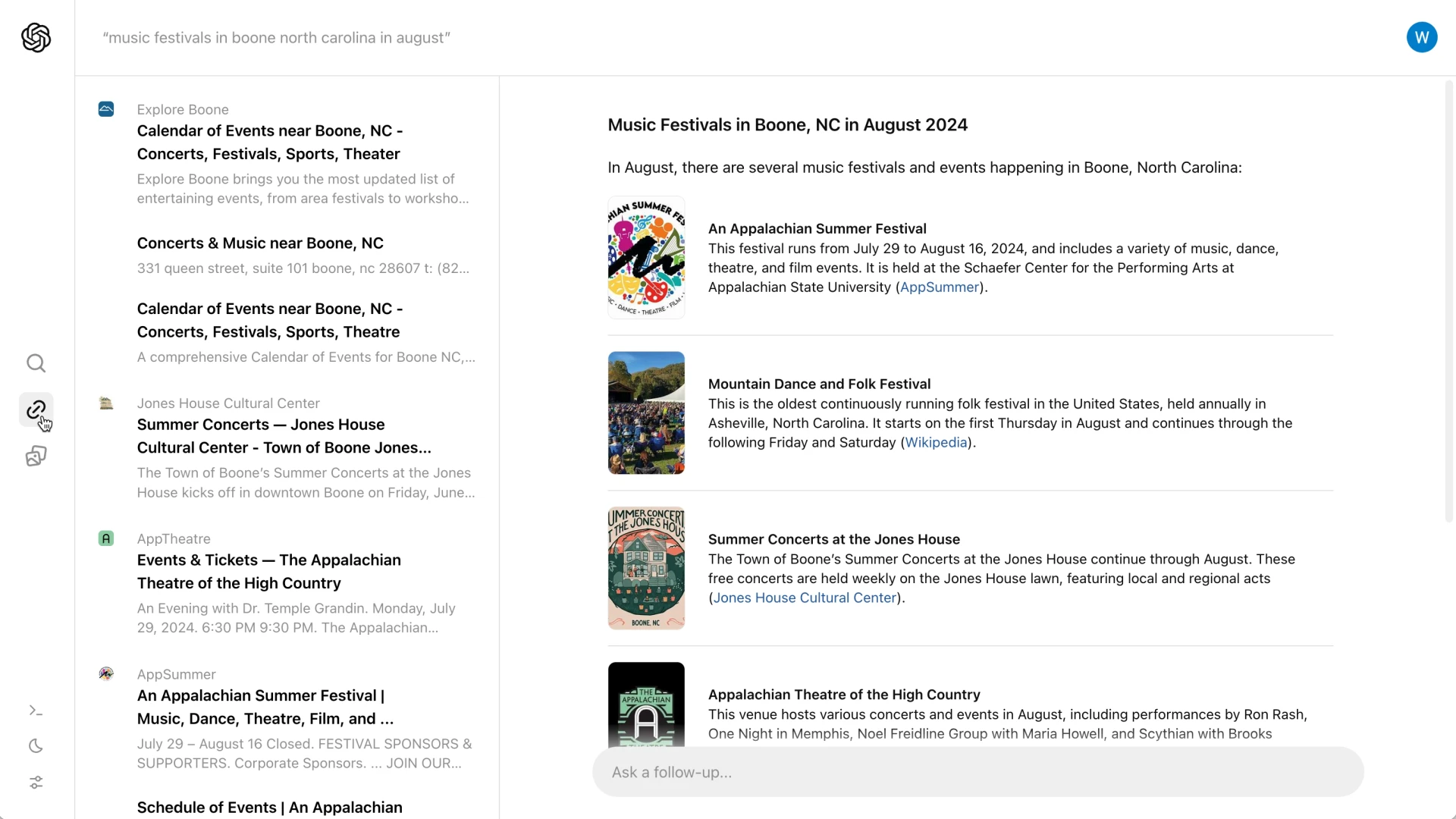

Contrairement aux moteurs de recherche traditionnels qui présentent une liste de liens, SearchGPT propose des résumés complets accompagnés d’attributions claires, garantissant ainsi que les utilisateurs obtiennent rapidement des informations précises et pertinentes.

Cette approche innovante est conçue pour rationaliser l’expérience de recherche, la rendant plus efficace et interactive pour les utilisateurs.

Caractéristiques et objectifs principaux

SearchGPT est conçu pour transformer l’expérience de recherche traditionnelle en une interaction plus rationnelle et conversationnelle.

Contrairement aux moteurs de recherche conventionnels qui affichent une liste de liens, SearchGPT fournit des résumés concis accompagnés de liens d’attribution.

Cette approche permet aux utilisateurs de saisir rapidement l’essence de leur requête tout en ayant la possibilité d’explorer plus en détail les sites web d’origine.

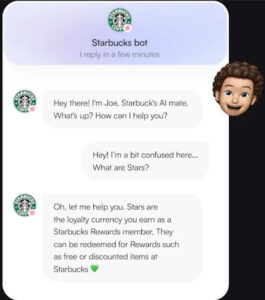

La plateforme comprend également une fonction interactive qui permet aux utilisateurs de poser des questions complémentaires, enrichissant ainsi l’aspect conversationnel du processus de recherche.

En outre, une barre latérale présente des liens pertinents supplémentaires, ce qui améliore encore la capacité de l’utilisateur à trouver des informations complètes.

L’une des caractéristiques les plus remarquables est l’introduction de “réponses visuelles”, qui présentent des vidéos générées par l’intelligence artificielle afin d’offrir aux utilisateurs une expérience de recherche plus attrayante et plus informative.

Collaboration avec les éditeurs

SearchGPT a donné la priorité à la création de partenariats solides avec des organismes de presse afin de garantir la qualité et la fiabilité des informations qu’elle fournit.

En collaborant avec des éditeurs réputés tels que The Atlantic, News Corp et The Associated Press, OpenAI s’assure que les utilisateurs reçoivent des résultats de recherche précis et fiables.

Ces partenariats permettent également aux éditeurs de mieux contrôler l’affichage de leur contenu dans les résultats de recherche.

Les éditeurs peuvent décider de ne pas voir leur contenu utilisé pour l’entraînement des modèles d’IA d’OpenAI, tout en continuant à figurer en bonne place dans les résultats de recherche.

Cette approche vise à protéger l’intégrité et la provenance du contenu original, ce qui en fait une solution gagnante à la fois pour les utilisateurs et les créateurs de contenu.

Différenciation par rapport aux concurrents

SearchGPT se distingue de ses concurrents tels que Google en s’attaquant à des problèmes importants inhérents aux moteurs de recherche intégrés à l’IA.

L’approche de Google est souvent critiquée pour ses inexactitudes et la réduction du trafic vers les sources de contenu original en fournissant des réponses directes dans les résultats de recherche.

En revanche, SearchGPT garantit une attribution claire et encourage les utilisateurs à visiter les sites des éditeurs pour obtenir des informations détaillées.

Cette stratégie permet non seulement d’améliorer l’expérience de l’utilisateur grâce à des données précises et crédibles, mais vise également à maintenir un écosystème sain pour les éditeurs grâce à un partage responsable du contenu.

Commentaires des utilisateurs et intégration future

La version actuelle de SearchGPT est un prototype, accessible à un groupe restreint d’utilisateurs et d’éditeurs.

Ce déploiement limité est conçu pour recueillir des commentaires et des idées précieuses, qui permettront d’affiner et d’améliorer le service.

OpenAI prévoit d’intégrer à terme les fonctionnalités les plus réussies de SearchGPT dans ChatGPT, ce qui permettra à l’IA d’être encore plus proche de l’information en temps réel sur le web.

Les utilisateurs qui souhaitent tester le prototype ont la possibilité de s’inscrire sur une liste d’attente, tandis que les éditeurs sont encouragés à faire part de leurs commentaires sur leur expérience.

Ce retour d’information sera crucial pour façonner les futures itérations de SearchGPT, en veillant à ce qu’il réponde aux besoins des utilisateurs et maintienne des normes élevées en matière de précision et de fiabilité.

Défis et considérations

Alors que la SearchGPT entre dans sa phase de prototypage, elle est confrontée à plusieurs défis.

L’un des aspects cruciaux est de garantir l’exactitude des informations et l’attribution correcte des sources.

Tirant les leçons des écueils rencontrés par Google, SearchGPT doit éviter les erreurs susceptibles de conduire à une désinformation ou à une attribution erronée, ce qui pourrait miner la confiance des utilisateurs et nuire aux relations avec les éditeurs.

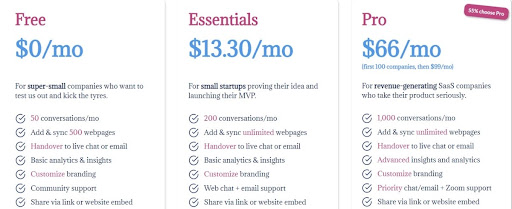

Un autre défi important réside dans la monétisation.

Actuellement, SearchGPT est gratuit et fonctionne sans publicité pendant sa phase initiale de lancement.

Cette approche sans publicité constitue un obstacle au développement d’un modèle commercial durable capable de supporter les coûts élevés associés à la formation et à l’inférence de l’IA.

Il sera essentiel de répondre à ces exigences financières pour assurer la viabilité à long terme du service.

En résumé, pour que SearchGPT réussisse, OpenAI doit relever ces défis techniques et économiques, en garantissant la précision de la plateforme et en développant une stratégie de monétisation réalisable.

Conclusion

SearchGPT marque une avancée significative dans le domaine de la technologie de recherche alimentée par l’IA.

En donnant la priorité à la qualité, à la fiabilité et à la collaboration avec les éditeurs, OpenAI vise à offrir une expérience de recherche plus efficace et plus fiable.

L’intégration de modèles conversationnels avec des informations en temps réel sur le web distingue SearchGPT des moteurs de recherche traditionnels et de ses rivaux comme Google.

Le retour d’information des utilisateurs et des éditeurs sera déterminant pour l’évolution future de cet outil innovant.

Au fur et à mesure que la phase de prototypage progresse, l’OpenAI prévoit d’affiner SearchGPT, en veillant à ce qu’il réponde aux besoins et aux attentes de ses utilisateurs.

Cette collaboration permanente et ce processus d’amélioration itératif contribueront à créer un écosystème équilibré qui profitera à la fois aux créateurs de contenu et aux utilisateurs.

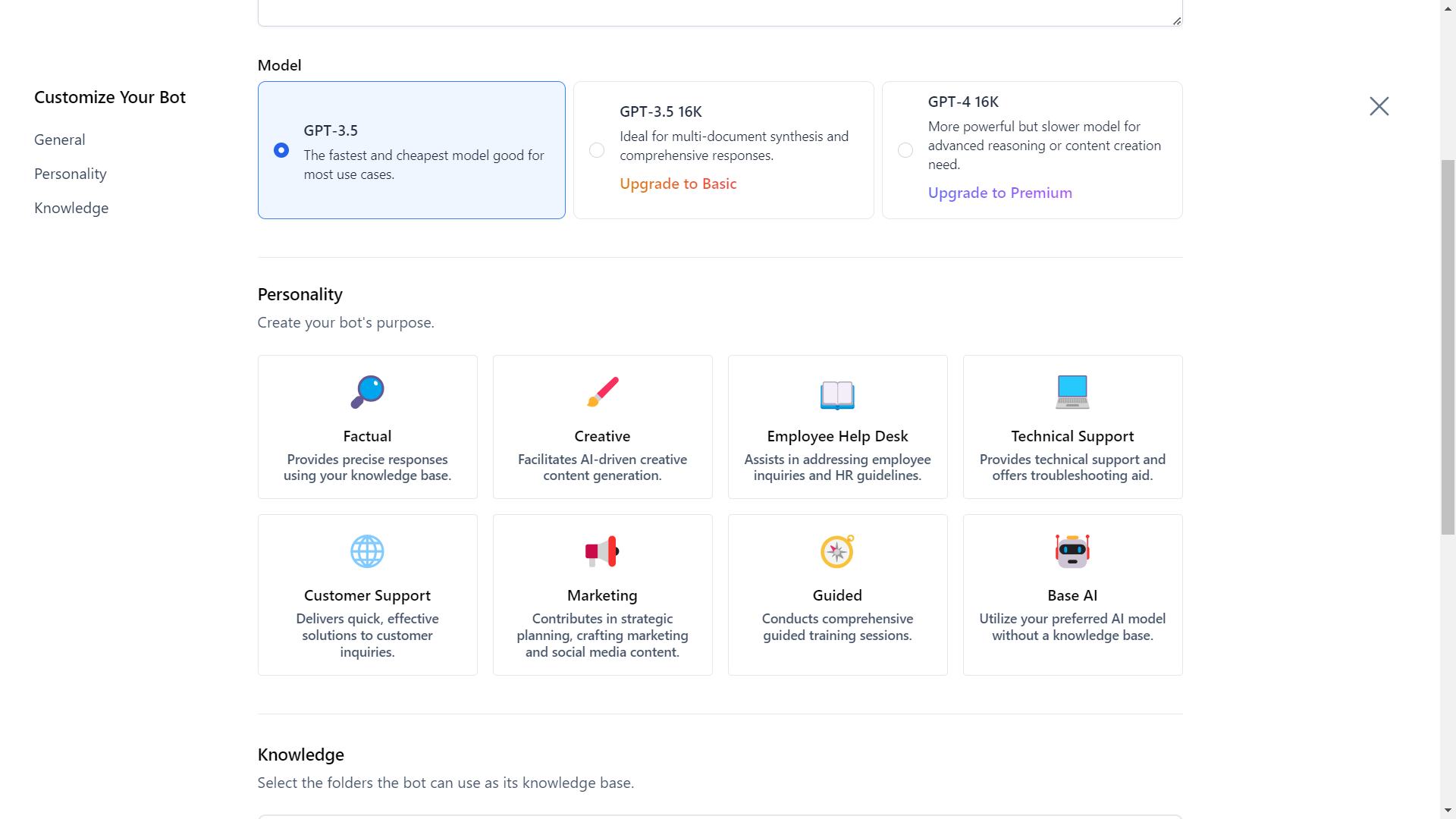

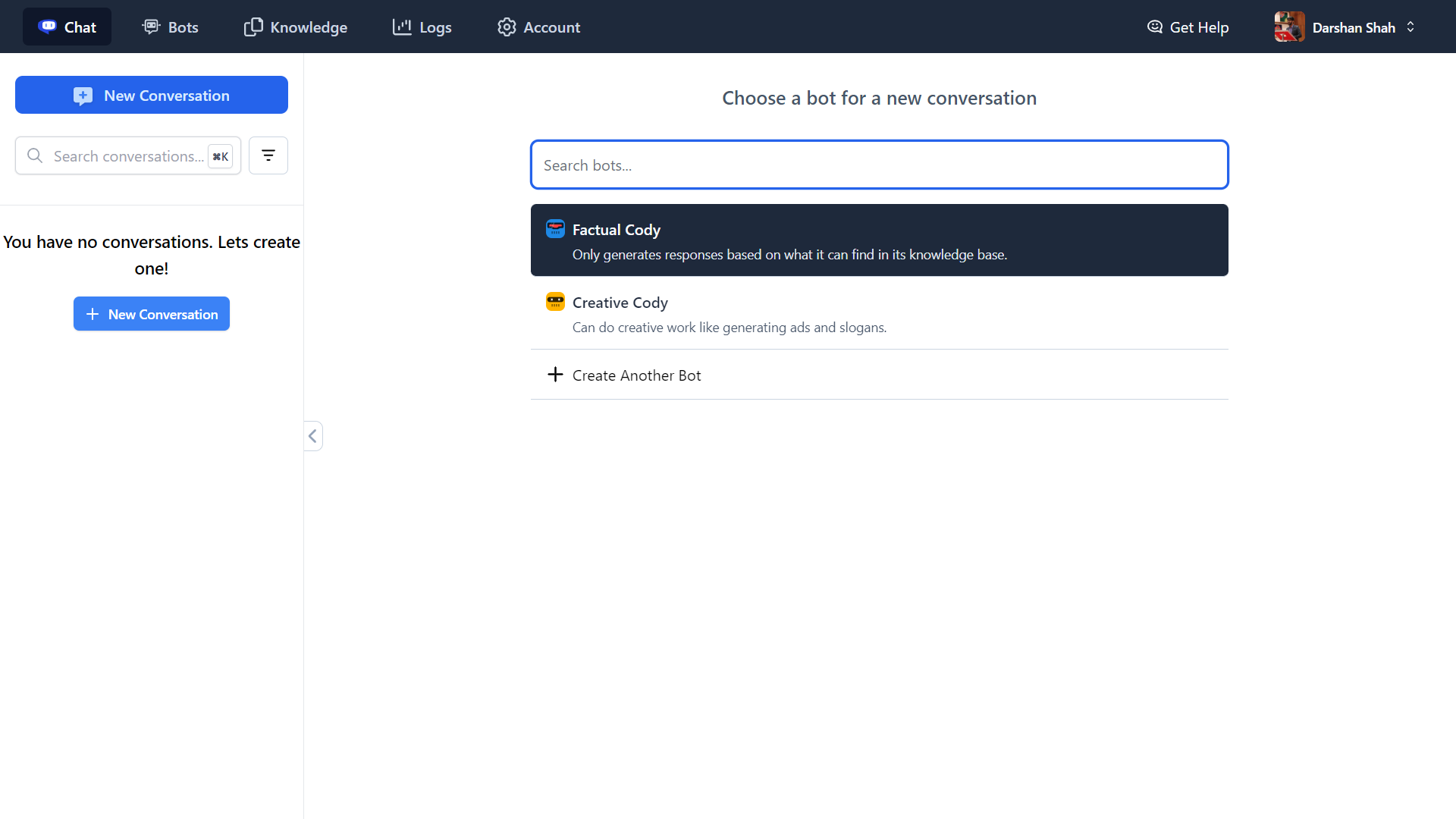

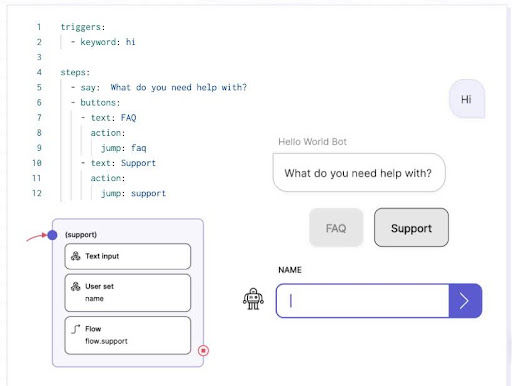

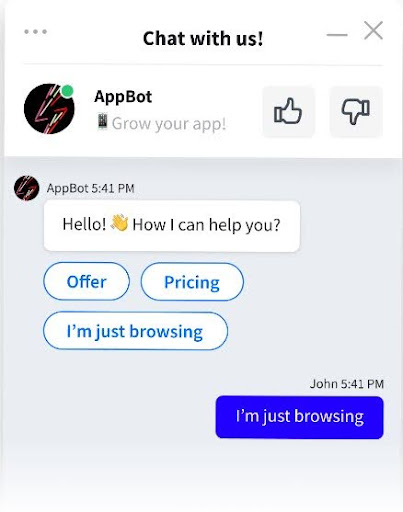

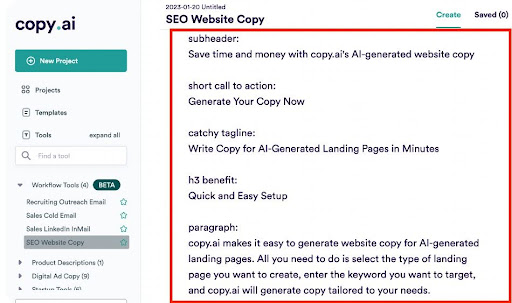

Découvrez l’avenir de l’intelligence économique avec Cody AI, votre assistant intelligent qui va au-delà du simple chat.

Intégrez de manière transparente votre entreprise, votre équipe, vos processus et votre connaissance des clients dans Cody afin de décupler votre productivité.

Que vous ayez besoin de réponses, de solutions créatives, de dépannage ou de brainstorming, Cody est là pour vous aider.

Explorez Cody AI dès maintenant et transformez vos opérations commerciales !