Anunciado el SearchGPT

OpenAI ha presentado un innovador prototipo llamado SearchGPT, un motor de búsqueda potenciado por IA desarrollado para transformar la forma en que los usuarios acceden a la información en línea.

Aprovechando modelos conversacionales avanzados integrados con datos web en tiempo real, SearchGPT pretende ofrecer respuestas rápidas, precisas y oportunas a las consultas de los usuarios.

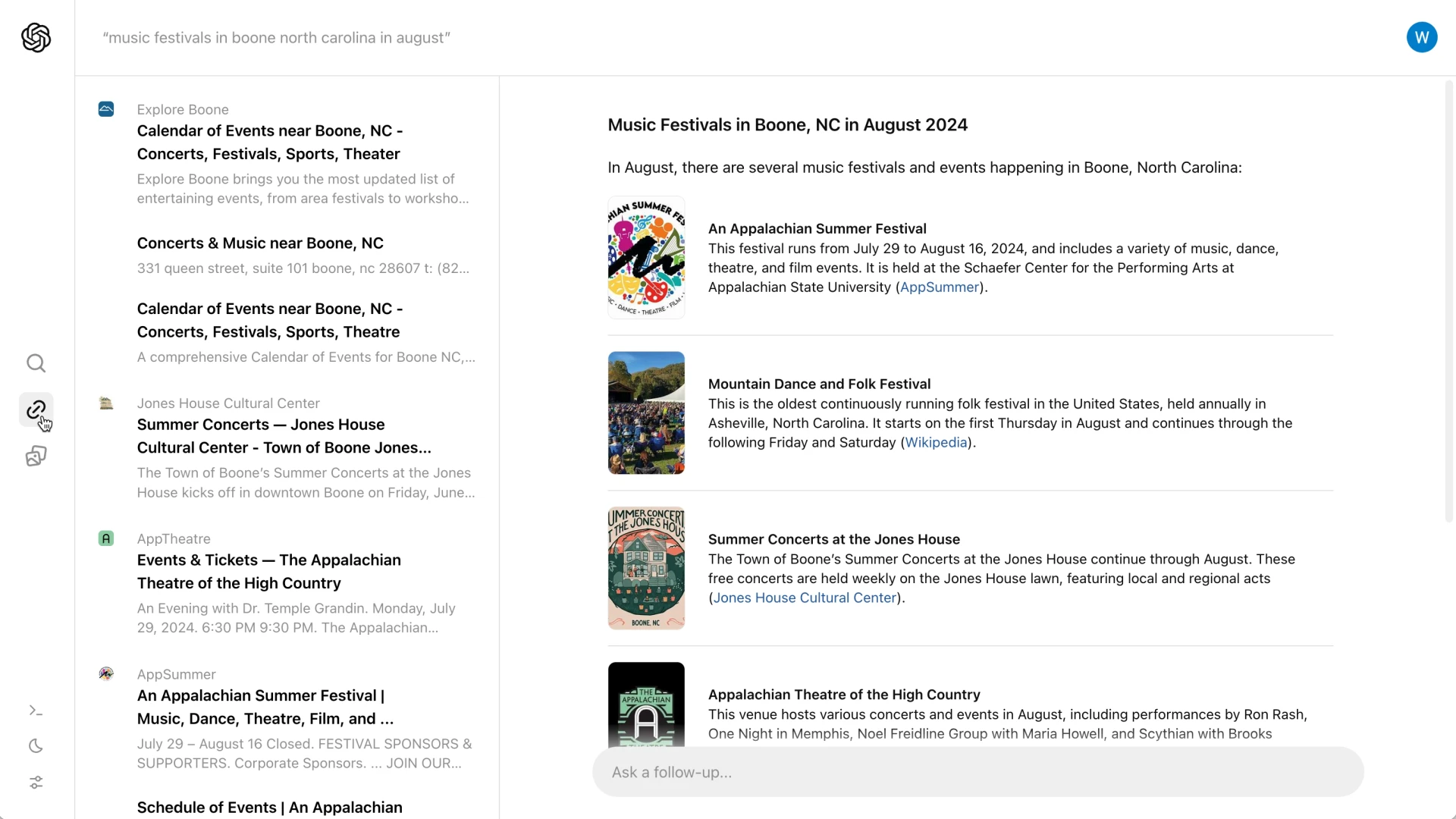

A diferencia de los motores de búsqueda tradicionales, que presentan una lista de enlaces, SearchGPT ofrece resúmenes exhaustivos acompañados de atribuciones claras, garantizando que los usuarios obtengan rápidamente información precisa y relevante.

Este enfoque innovador está diseñado para agilizar la experiencia de búsqueda, haciéndola más eficaz e interactiva para los usuarios.

Características y objetivos clave

SearchGPT está diseñado para transformar la experiencia de búsqueda tradicional en una interacción más ágil y conversacional.

A diferencia de los motores de búsqueda convencionales, que muestran una lista de enlaces, SearchGPT proporciona resúmenes concisos acompañados de enlaces de atribución.

Este enfoque permite a los usuarios captar rápidamente la esencia de su consulta, al tiempo que tienen la opción de explorar más detalles en los sitios web originales.

La plataforma también incluye una función interactiva en la que los usuarios pueden hacer preguntas de seguimiento, enriqueciendo así el aspecto conversacional del proceso de búsqueda.

Además, una barra lateral presenta enlaces relevantes adicionales, mejorando aún más la capacidad del usuario para encontrar información completa.

Una de las características más destacadas es la introducción de “respuestas visuales”, que muestran vídeos generados por IA para ofrecer a los usuarios una experiencia de búsqueda más atractiva e informativa.

Colaboración con editoriales

SearchGPT ha dado prioridad a la creación de asociaciones sólidas con organizaciones de noticias para garantizar la calidad y fiabilidad de la información que proporciona.

Al colaborar con editores de prestigio como The Atlantic, News Corp y The Associated Press, OpenAI garantiza que los usuarios reciban resultados de búsqueda precisos y fiables.

Estas colaboraciones también otorgan a los editores más control sobre cómo se muestra su contenido en los resultados de búsqueda.

Los editores pueden optar por que no se utilice su material para entrenar los modelos de IA de OpenAI, y seguir apareciendo de forma destacada en los resultados de las búsquedas.

Este enfoque pretende proteger la integridad y la procedencia del contenido original, por lo que tanto los usuarios como los creadores de contenidos salen ganando.

Diferenciación de la competencia

SearchGPT se diferencia de competidores como Google al abordar problemas importantes inherentes a los motores de búsqueda integrados en la IA.

El enfoque de Google a menudo se enfrenta a críticas por imprecisiones y por reducir el tráfico a las fuentes de contenido original al ofrecer respuestas directas dentro de los resultados de búsqueda.

En cambio, SearchGPT garantiza una atribución clara y anima a los usuarios a visitar los sitios de los editores para obtener información detallada.

Esta estrategia no sólo mejora la experiencia del usuario con datos precisos y creíbles, sino que también pretende mantener un ecosistema saludable para los editores mediante el intercambio responsable de contenidos.

Comentarios de los usuarios e integración futura

La versión actual de SearchGPT es un prototipo, disponible para un grupo selecto de usuarios y editores.

Este despliegue limitado está diseñado para recoger valiosos comentarios y opiniones, que ayudarán a perfeccionar y mejorar el servicio.

OpenAI planea integrar con el tiempo las características más exitosas de SearchGPT en ChatGPT, haciendo así que la IA esté aún más conectada con la información web en tiempo real.

Los usuarios interesados en probar el prototipo tienen la oportunidad de inscribirse en una lista de espera, mientras que a los editores se les anima a dar su opinión sobre sus experiencias.

Estos comentarios serán cruciales para dar forma a las futuras iteraciones de SearchGPT, garantizando que satisfaga las necesidades de los usuarios y mantenga altos niveles de precisión y fiabilidad.

Retos y consideraciones

A medida que SearchGPT entra en su fase de prototipo, se enfrenta a varios retos.

Un aspecto crucial es garantizar la exactitud de la información y la correcta atribución a las fuentes.

Aprendiendo de los escollos a los que se enfrentó Google, SearchGPT debe evitar errores que puedan dar lugar a desinformación o atribución errónea, lo que podría minar la confianza de los usuarios y dañar las relaciones con los editores .

Otro reto importante es la monetización.

Actualmente, SearchGPT es gratuito y funciona sin anuncios durante su fase inicial de lanzamiento.

Este enfoque sin anuncios supone un obstáculo para desarrollar un modelo de negocio sostenible capaz de soportar los elevados costes asociados al entrenamiento y la inferencia de la IA.

Abordar estas demandas financieras será esencial para la viabilidad a largo plazo del servicio .

En resumen, para que SearchGPT tenga éxito, OpenAI debe superar estos retos técnicos y económicos, garantizando la precisión de la plataforma y desarrollando una estrategia de monetización viable.

Conclusión

SearchGPT marca un avance significativo en el ámbito de la tecnología de búsqueda impulsada por IA.

Al dar prioridad a la calidad, la fiabilidad y la colaboración con los editores, OpenAI pretende ofrecer una experiencia de búsqueda más eficaz y fiable.

La integración de modelos conversacionales con información web en tiempo real diferencia a SearchGPT de los motores de búsqueda tradicionales y de rivales como Google.

Los comentarios de usuarios y editores serán cruciales para dar forma a la futura evolución de esta innovadora herramienta.

A medida que avance la fase de prototipo, OpenAI planea perfeccionar SearchGPT, asegurándose de que satisface las necesidades y expectativas de sus usuarios.

Esta colaboración continua y el proceso iterativo de mejora ayudarán a conseguir un ecosistema equilibrado que beneficie tanto a los creadores de contenidos como a los usuarios .

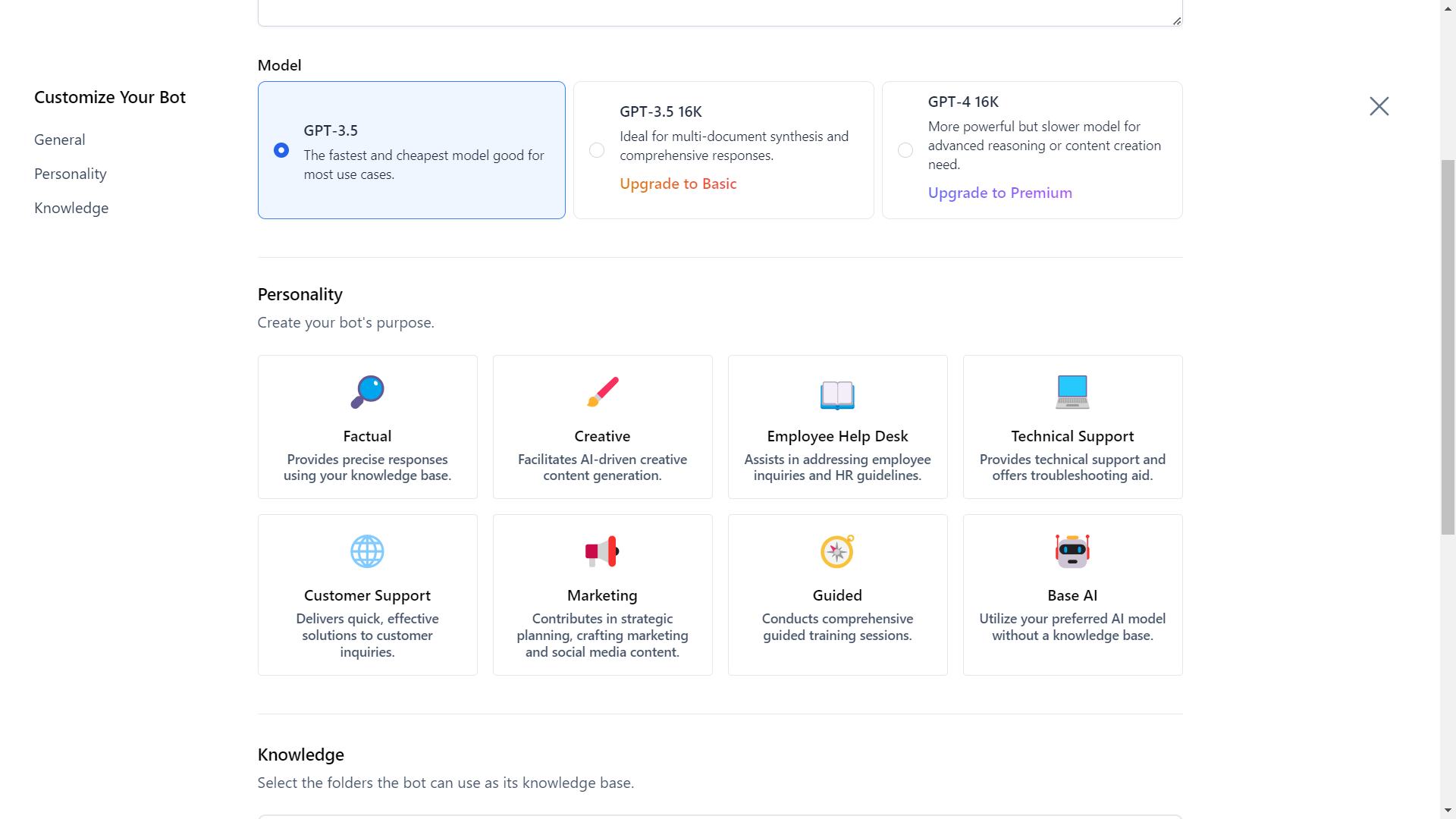

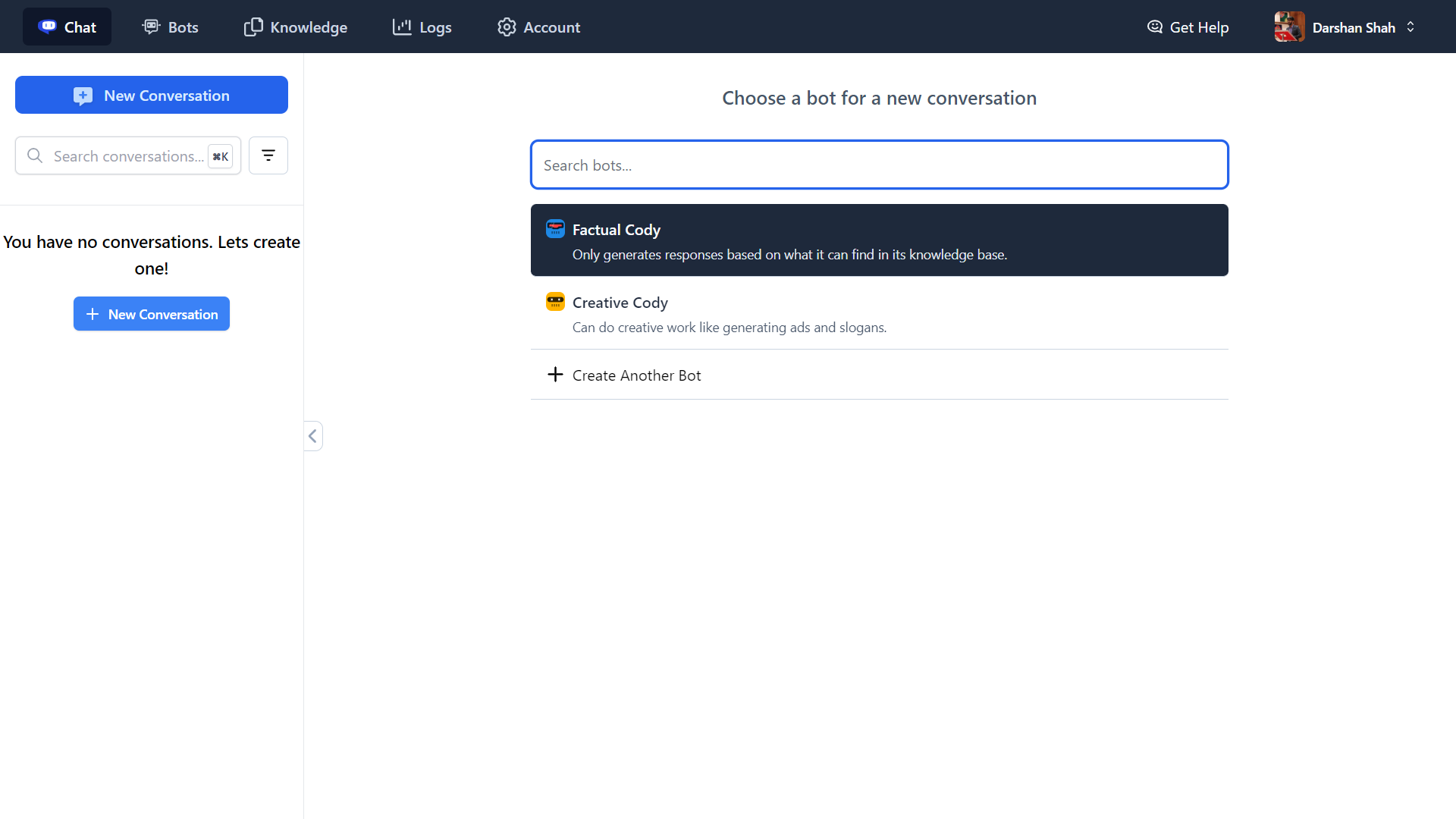

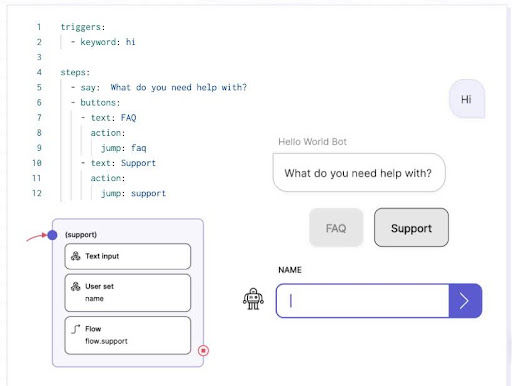

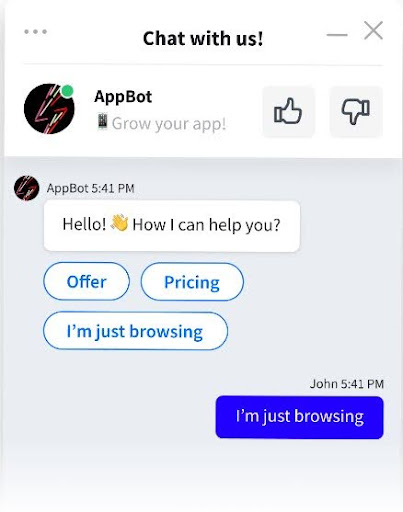

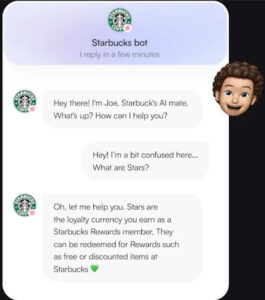

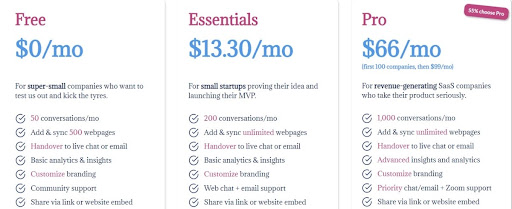

Desvela el futuro de la inteligencia empresarial con Cody AI, tu asistente inteligente de IA más allá del mero chat.

Integra perfectamente tu negocio, equipo, procesos y conocimiento del cliente en Cody para potenciar tu productividad.

Tanto si necesitas respuestas, soluciones creativas, resolución de problemas o lluvia de ideas, Cody está aquí para ayudarte.

¡Explora Cody AI ahora y transforma las operaciones de tu empresa!