SearchGPT anunciado

A OpenAI revelou um protótipo inovador chamado SearchGPT, um mecanismo de busca com tecnologia de IA desenvolvido para transformar a forma como os usuários acessam informações on-line.

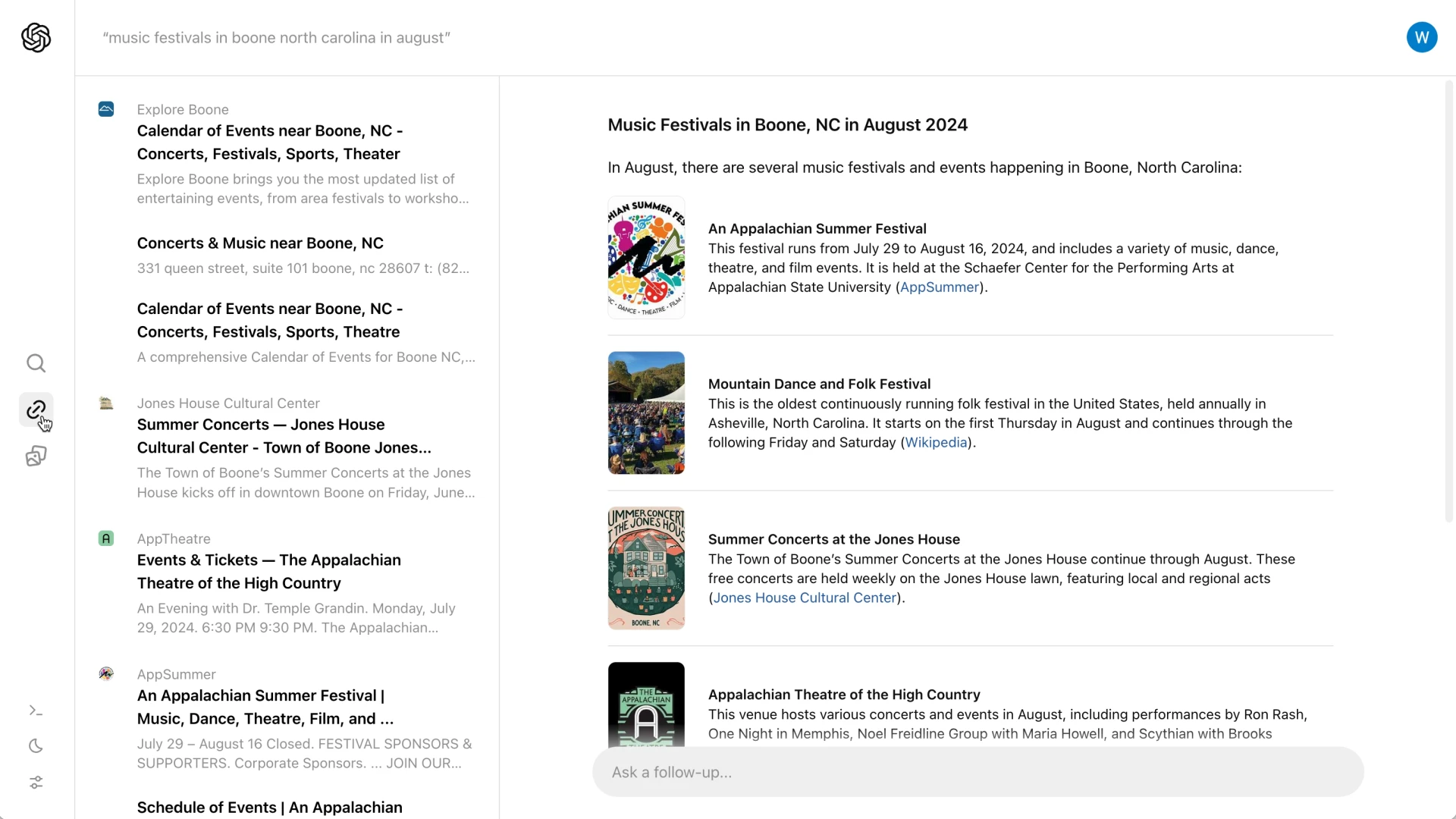

Ao utilizar modelos avançados de conversação integrados a dados da Web em tempo real, o SearchGPT tem como objetivo fornecer respostas rápidas, precisas e oportunas às consultas dos usuários.

Ao contrário dos mecanismos de pesquisa tradicionais que apresentam uma lista de links, o SearchGPT oferece resumos abrangentes acompanhados de atribuições claras, garantindo que os usuários obtenham informações precisas e relevantes imediatamente.

Essa abordagem inovadora foi projetada para simplificar a experiência de pesquisa, tornando-a mais eficaz e interativa para os usuários.

Principais recursos e objetivos

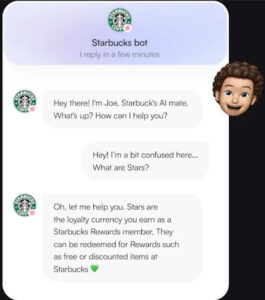

O SearchGPT foi projetado para transformar a experiência de pesquisa tradicional em uma interação mais simplificada e conversacional.

Ao contrário dos mecanismos de pesquisa convencionais que exibem uma lista de links, o SearchGPT fornece resumos concisos acompanhados de links de atribuição.

Essa abordagem permite que os usuários compreendam rapidamente a essência de sua consulta e, ao mesmo tempo, tenham a opção de explorar mais detalhes nos sites originais.

A plataforma também inclui um recurso interativo em que os usuários podem fazer perguntas de acompanhamento, enriquecendo assim o aspecto de conversação do processo de pesquisa.

Além disso, uma barra lateral apresenta outros links relevantes, aumentando ainda mais a capacidade do usuário de encontrar informações abrangentes.

Um dos recursos de destaque é a introdução de “respostas visuais”, que exibem vídeos gerados por IA para proporcionar aos usuários uma experiência de pesquisa mais envolvente e informativa.

Colaboração com editores

O SearchGPT priorizou a criação de parcerias sólidas com organizações de notícias para garantir a qualidade e a confiabilidade das informações que fornece.

Ao colaborar com editoras de renome, como The Atlantic, News Corp e The Associated Press, a OpenAI garante que os usuários recebam resultados de pesquisa precisos e confiáveis.

Essas parcerias também concedem aos editores mais controle sobre como seu conteúdo é exibido nos resultados de pesquisa.

Os editores podem optar por não ter seu material usado para treinar os modelos de IA da OpenAI e, ao mesmo tempo, continuar sendo exibido com destaque nos resultados de pesquisa.

Essa abordagem tem como objetivo proteger a integridade e a procedência do conteúdo original, tornando-o vantajoso tanto para os usuários quanto para os criadores de conteúdo.

Diferenciação dos concorrentes

O SearchGPT se diferencia dos concorrentes, como o Google, abordando problemas significativos inerentes aos mecanismos de pesquisa integrados à IA.

A abordagem do Google é frequentemente criticada por imprecisões e pela redução do tráfego para fontes de conteúdo original ao fornecer respostas diretas nos resultados de pesquisa.

Em contrapartida, o SearchGPT garante uma atribuição clara e incentiva os usuários a visitar os sites dos editores para obter informações detalhadas.

Essa estratégia não apenas aprimora a experiência do usuário com dados precisos e confiáveis, mas também visa manter um ecossistema saudável para os editores por meio do compartilhamento responsável de conteúdo.

Feedback do usuário e integração futura

A versão atual do SearchGPT é um protótipo, disponível para um grupo seleto de usuários e editores.

Essa implementação limitada foi projetada para reunir feedback e insights valiosos, que ajudarão a refinar e aprimorar o serviço.

A OpenAI planeja integrar os recursos mais bem-sucedidos do SearchGPT ao ChatGPT, tornando a IA ainda mais conectada às informações da Web em tempo real.

Os usuários interessados em testar o protótipo têm a oportunidade de entrar em uma lista de espera, enquanto os editores são incentivados a fornecer feedback sobre suas experiências.

Esse feedback será crucial para moldar as futuras iterações do SearchGPT, garantindo que ele atenda às necessidades dos usuários e mantenha altos padrões de precisão e confiabilidade.

Desafios e considerações

À medida que o SearchGPT entra em sua fase de protótipo, ele enfrenta vários desafios.

Um aspecto crucial é garantir a precisão das informações e a atribuição adequada às fontes.

Aprendendo com as armadilhas enfrentadas pelo Google, o SearchGPT deve evitar erros que possam levar à desinformação ou à atribuição incorreta, o que poderia minar a confiança do usuário e prejudicar o relacionamento com os editores.

Outro desafio significativo está na monetização.

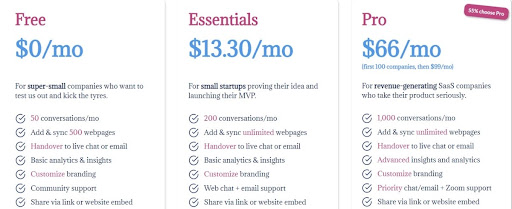

Atualmente, o SearchGPT é gratuito e opera sem anúncios durante sua fase inicial de lançamento.

Essa abordagem sem anúncios representa um obstáculo para o desenvolvimento de um modelo de negócios sustentável capaz de suportar os altos custos associados ao treinamento e à inferência de IA.

Atender a essas demandas financeiras será essencial para a viabilidade do serviço a longo prazo.

Em resumo, para que o SearchGPT seja bem-sucedido, a OpenAI deve enfrentar esses desafios técnicos e econômicos, garantindo a precisão da plataforma e desenvolvendo uma estratégia de monetização viável.

Conclusão

O SearchGPT marca um avanço significativo no campo da tecnologia de pesquisa com tecnologia de IA.

Ao priorizar a qualidade, a confiabilidade e a colaboração com os editores, a OpenAI tem como objetivo oferecer uma experiência de pesquisa mais eficiente e confiável.

A integração de modelos de conversação com informações da Web em tempo real diferencia o SearchGPT dos mecanismos de pesquisa tradicionais e de rivais como o Google.

O feedback dos usuários e editores será fundamental para moldar a evolução futura dessa ferramenta inovadora.

À medida que a fase de protótipo avança, a OpenAI planeja refinar o SearchGPT, garantindo que ele atenda às necessidades e expectativas de seus usuários.

Essa colaboração contínua e esse processo de aprimoramento iterativo ajudarão a criar um ecossistema equilibrado que beneficie tanto os criadores de conteúdo quanto os usuários.

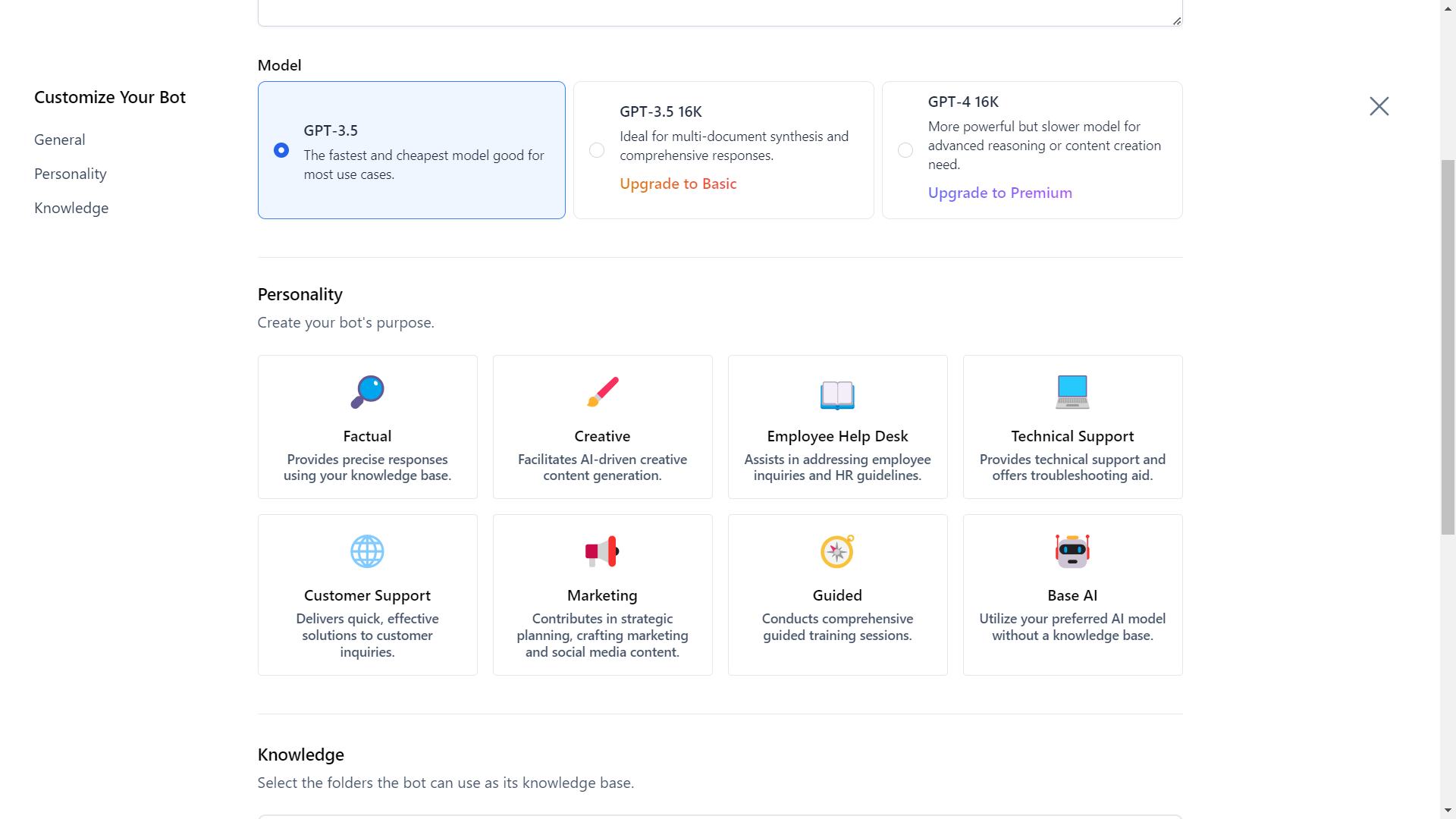

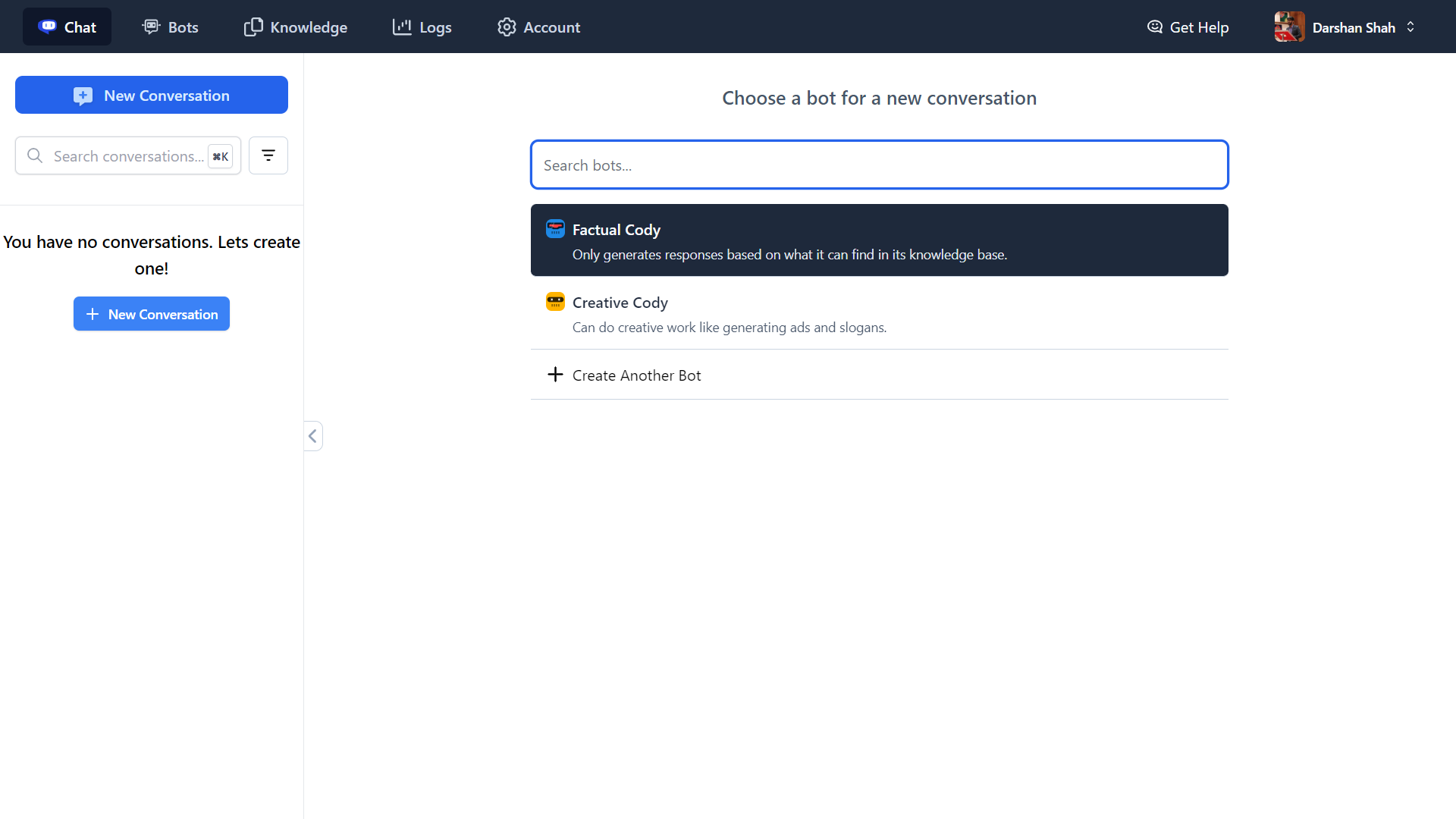

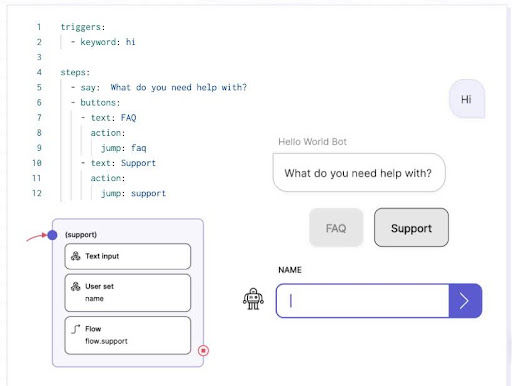

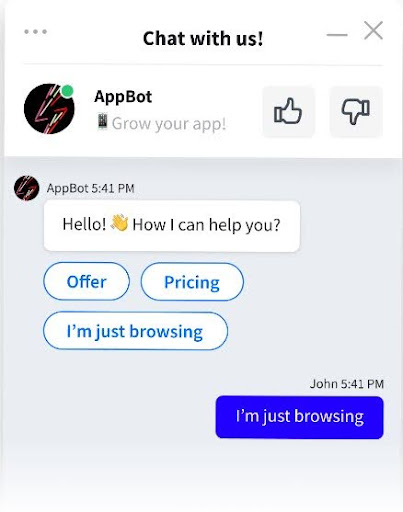

Descubra o futuro da inteligência comercial com a Cody AI, seu assistente inteligente de IA que vai além do bate-papo.

Integre perfeitamente seus negócios, sua equipe, seus processos e o conhecimento dos clientes na Cody para aumentar sua produtividade.

Se você precisa de respostas, soluções criativas, resolução de problemas ou brainstorming, a Cody está aqui para ajudar.

Explore a Cody AI agora e transforme suas operações comerciais!