SearchGPT Angekündigt

OpenAI hat einen bahnbrechenden Prototyp namens SearchGPT vorgestellt, eine KI-gestützte Suchmaschine, die entwickelt wurde, um die Art und Weise zu verändern, wie Nutzer online auf Informationen zugreifen.

SearchGPT nutzt fortschrittliche Konversationsmodelle, die mit Echtzeit-Webdaten integriert werden, um schnelle, präzise und zeitnahe Antworten auf Benutzeranfragen zu liefern.

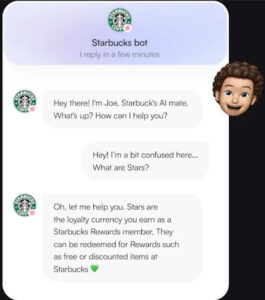

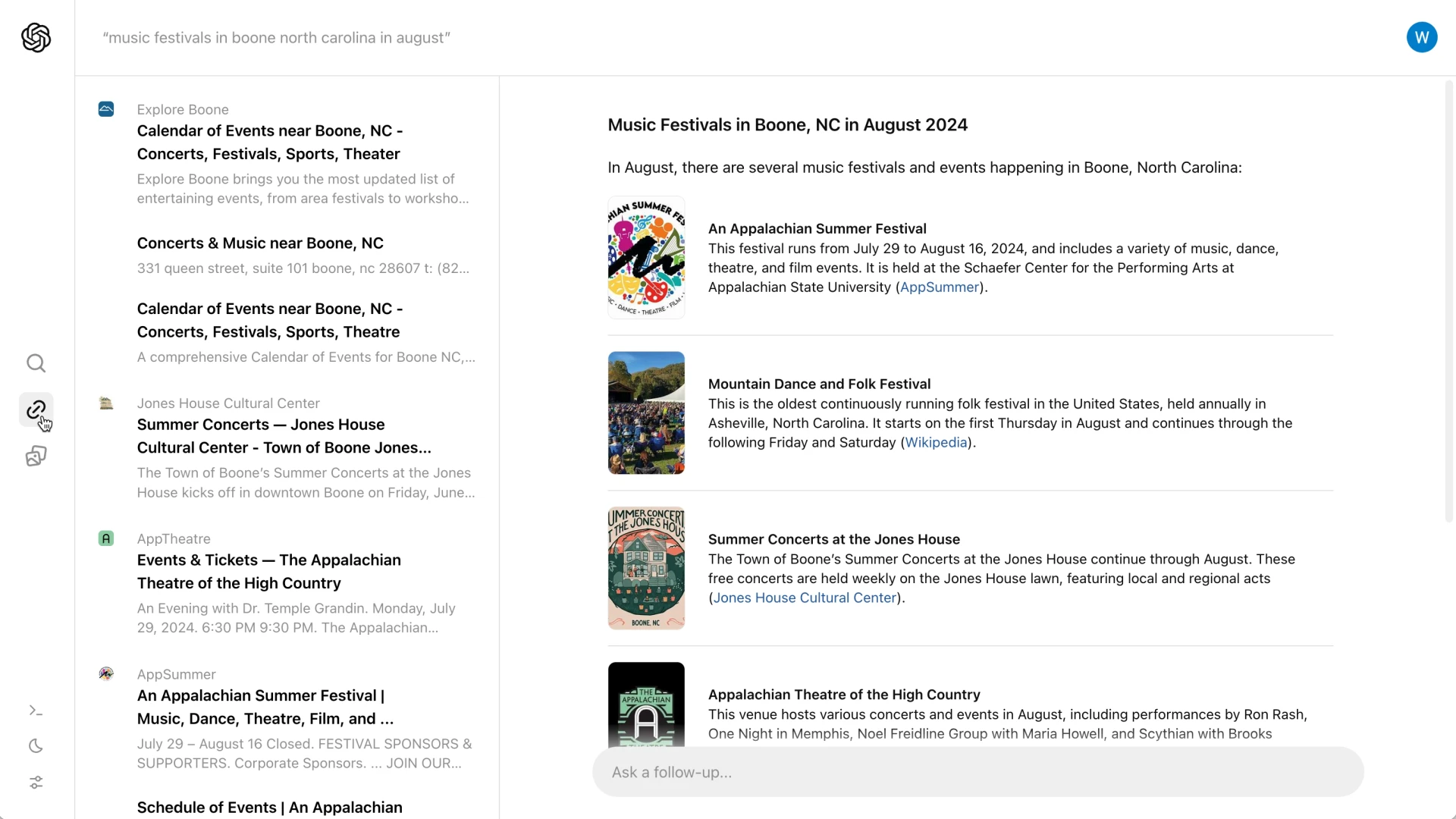

Im Gegensatz zu herkömmlichen Suchmaschinen, die eine Liste von Links präsentieren, bietet SearchGPT umfassende Zusammenfassungen mit klaren Zuordnungen, die sicherstellen, dass die Nutzer umgehend genaue und relevante Informationen erhalten.

Dieser innovative Ansatz soll das Sucherlebnis rationalisieren und es für die Nutzer effektiver und interaktiver machen.

Hauptmerkmale und Ziele

SearchGPT wurde entwickelt, um die herkömmliche Suche in eine schlankere und unterhaltsamere Interaktion zu verwandeln.

Im Gegensatz zu herkömmlichen Suchmaschinen, die eine Liste von Links anzeigen, bietet SearchGPT prägnante Zusammenfassungen, die von Links zu den Quellen begleitet werden.

Dieser Ansatz ermöglicht es den Nutzern, das Wesentliche ihrer Anfrage schnell zu erfassen und gleichzeitig die Möglichkeit zu haben, weitere Details auf den ursprünglichen Websites zu erkunden.

Die Plattform enthält auch eine interaktive Funktion, mit der die Benutzer Folgefragen stellen können und so den Gesprächsaspekt des Suchprozesses bereichern.

Außerdem werden in einer Seitenleiste zusätzliche relevante Links angezeigt, so dass der Benutzer noch besser in der Lage ist, umfassende Informationen zu finden.

Eine der herausragenden Funktionen ist die Einführung von “visuellen Antworten”, bei denen KI-generierte Videos gezeigt werden, um den Nutzern ein attraktiveres und informativeres Sucherlebnis zu bieten.

Zusammenarbeit mit Verlegern

SearchGPT hat es sich zur Aufgabe gemacht, starke Partnerschaften mit Nachrichtenorganisationen einzugehen, um die Qualität und Zuverlässigkeit der angebotenen Informationen zu gewährleisten.

Durch die Zusammenarbeit mit angesehenen Verlagen wie The Atlantic, News Corp und The Associated Press stellt OpenAI sicher, dass die Nutzer genaue und vertrauenswürdige Suchergebnisse erhalten.

Diese Partnerschaften geben den Verlagen auch mehr Kontrolle darüber, wie ihre Inhalte in den Suchergebnissen angezeigt werden.

Verlage können sich dagegen entscheiden, dass ihr Material für das Training der KI-Modelle von OpenAI verwendet wird, werden aber dennoch prominent in den Suchergebnissen angezeigt.

Dieser Ansatz zielt darauf ab, die Integrität und Herkunft von Originalinhalten zu schützen, so dass sowohl die Nutzer als auch die Ersteller von Inhalten davon profitieren.

Differenzierung von Mitbewerbern

SearchGPT hebt sich von Konkurrenten wie Google ab, indem es sich mit wichtigen Problemen befasst, die mit KI-integrierten Suchmaschinen verbunden sind.

Der Ansatz von Google wird oft kritisiert, weil er ungenau ist und den Verkehr zu den ursprünglichen Inhaltsquellen reduziert, indem er direkte Antworten in den Suchergebnissen liefert.

Im Gegensatz dazu sorgt SearchGPT für eine klare Zuordnung und ermutigt die Nutzer, die Websites der Herausgeber zu besuchen, um detaillierte Informationen zu erhalten.

Diese Strategie verbessert nicht nur das Nutzererlebnis durch genaue und glaubwürdige Daten, sondern zielt auch darauf ab, ein gesundes Ökosystem für Verlage durch verantwortungsvollen Austausch von Inhalten zu erhalten.

Benutzer-Feedback und zukünftige Integration

Die aktuelle Version von SearchGPT ist ein Prototyp, der einer ausgewählten Gruppe von Nutzern und Verlagen zur Verfügung steht.

Diese begrenzte Einführung dient dazu, wertvolles Feedback und Erkenntnisse zu sammeln, die zur Verfeinerung und Verbesserung des Dienstes beitragen werden.

OpenAI plant, die erfolgreichsten Funktionen von SearchGPT in ChatGPT zu integrieren und so die KI noch stärker mit Echtzeit-Webinformationen zu verknüpfen.

Nutzer, die den Prototyp testen möchten, haben die Möglichkeit, sich auf eine Warteliste setzen zu lassen, während Verlage aufgefordert sind, Feedback zu ihren Erfahrungen zu geben.

Dieses Feedback wird entscheidend sein für die Gestaltung zukünftiger Versionen von SearchGPT, um sicherzustellen, dass es die Bedürfnisse der Nutzer erfüllt und hohe Standards für Genauigkeit und Zuverlässigkeit beibehält.

Herausforderungen und Überlegungen

Während SearchGPT in die Prototyp-Phase eintritt, steht es vor verschiedenen Herausforderungen.

Ein entscheidender Aspekt ist die Sicherstellung der Richtigkeit der Informationen und der korrekten Zuordnung zu den Quellen.

SearchGPT muss aus den Fallstricken lernen, mit denen Google konfrontiert war, und Fehler vermeiden, die zu Fehlinformationen oder falschen Zuschreibungen führen könnten, die das Vertrauen der Nutzer untergraben und die Beziehungen zu den Verlagen beschädigen könnten.

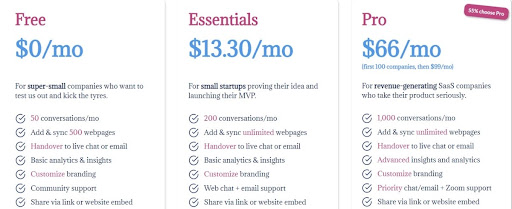

Eine weitere große Herausforderung liegt in der Monetarisierung.

Derzeit ist SearchGPT kostenlos und funktioniert in der Anfangsphase ohne Werbung.

Dieser werbefreie Ansatz stellt eine Hürde für die Entwicklung eines nachhaltigen Geschäftsmodells dar, das in der Lage ist, die mit dem KI-Training und der Inferenz verbundenen umfangreichen Kosten zu tragen.

Die Bewältigung dieser finanziellen Anforderungen wird für die langfristige Überlebensfähigkeit des Dienstes von entscheidender Bedeutung sein.

Zusammenfassend lässt sich sagen, dass OpenAI diese technischen und wirtschaftlichen Herausforderungen meistern muss, um den Erfolg von SearchGPT zu sichern, die Genauigkeit der Plattform zu gewährleisten und eine praktikable Monetarisierungsstrategie zu entwickeln.

Schlussfolgerung

SearchGPT ist ein bedeutender Fortschritt auf dem Gebiet der KI-gestützten Suchtechnologie.

Durch die Priorisierung von Qualität, Zuverlässigkeit und Zusammenarbeit mit Verlagen will OpenAI ein effizienteres und vertrauenswürdigeres Sucherlebnis bieten.

Die Integration von Konversationsmodellen mit Echtzeit-Webinformationen hebt SearchGPT von traditionellen Suchmaschinen und Konkurrenten wie Google ab.

Das Feedback von Nutzern und Verlagen wird für die zukünftige Entwicklung dieses innovativen Tools entscheidend sein.

Im Laufe der Prototyp-Phase plant OpenAI, SearchGPT zu verfeinern, um sicherzustellen, dass es die Bedürfnisse und Erwartungen seiner Nutzer erfüllt.

Diese kontinuierliche Zusammenarbeit und der iterative Verbesserungsprozess werden dazu beitragen, ein ausgewogenes Ökosystem zu schaffen, von dem sowohl die Ersteller von Inhalten als auch die Nutzer profitieren.

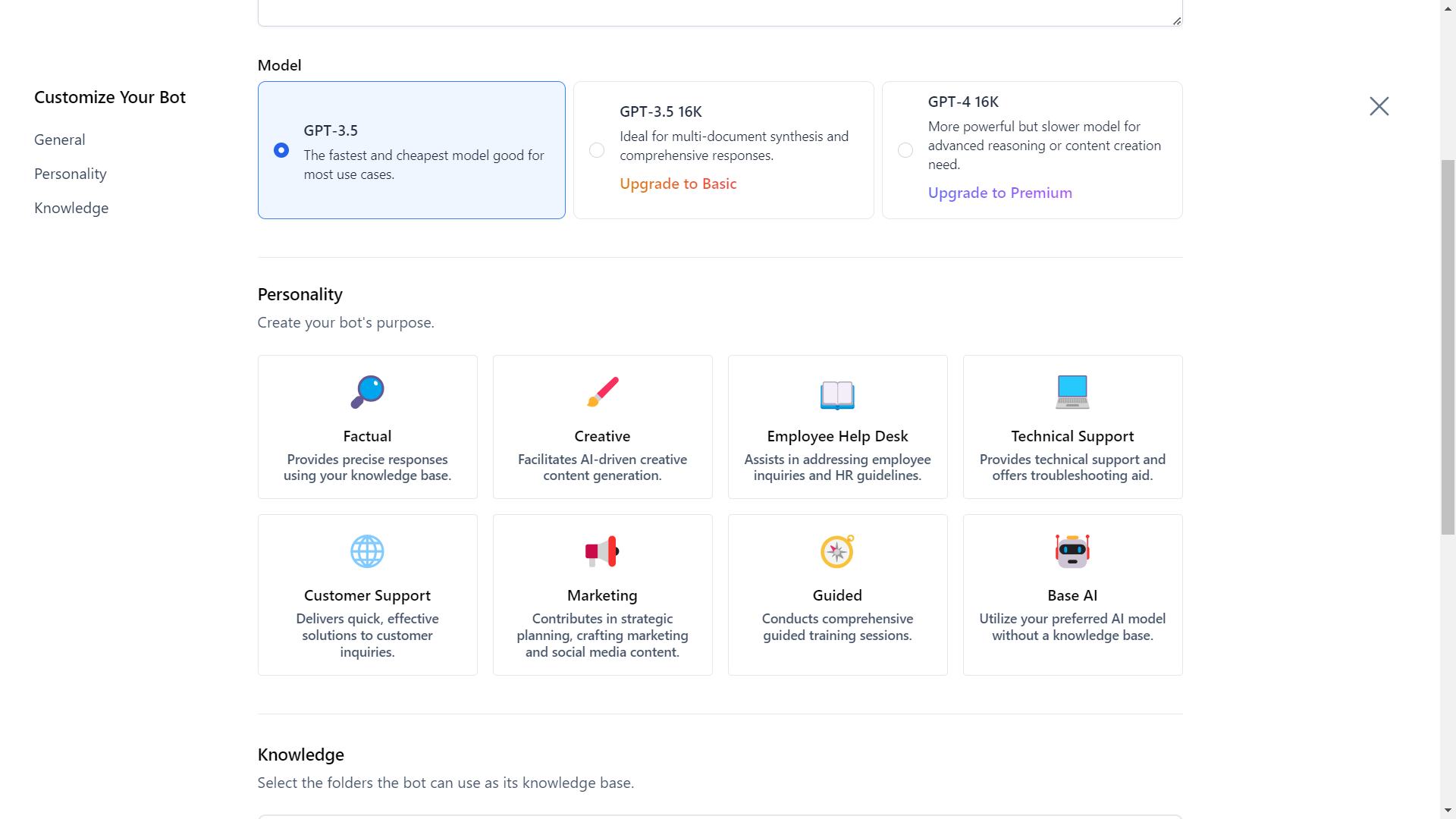

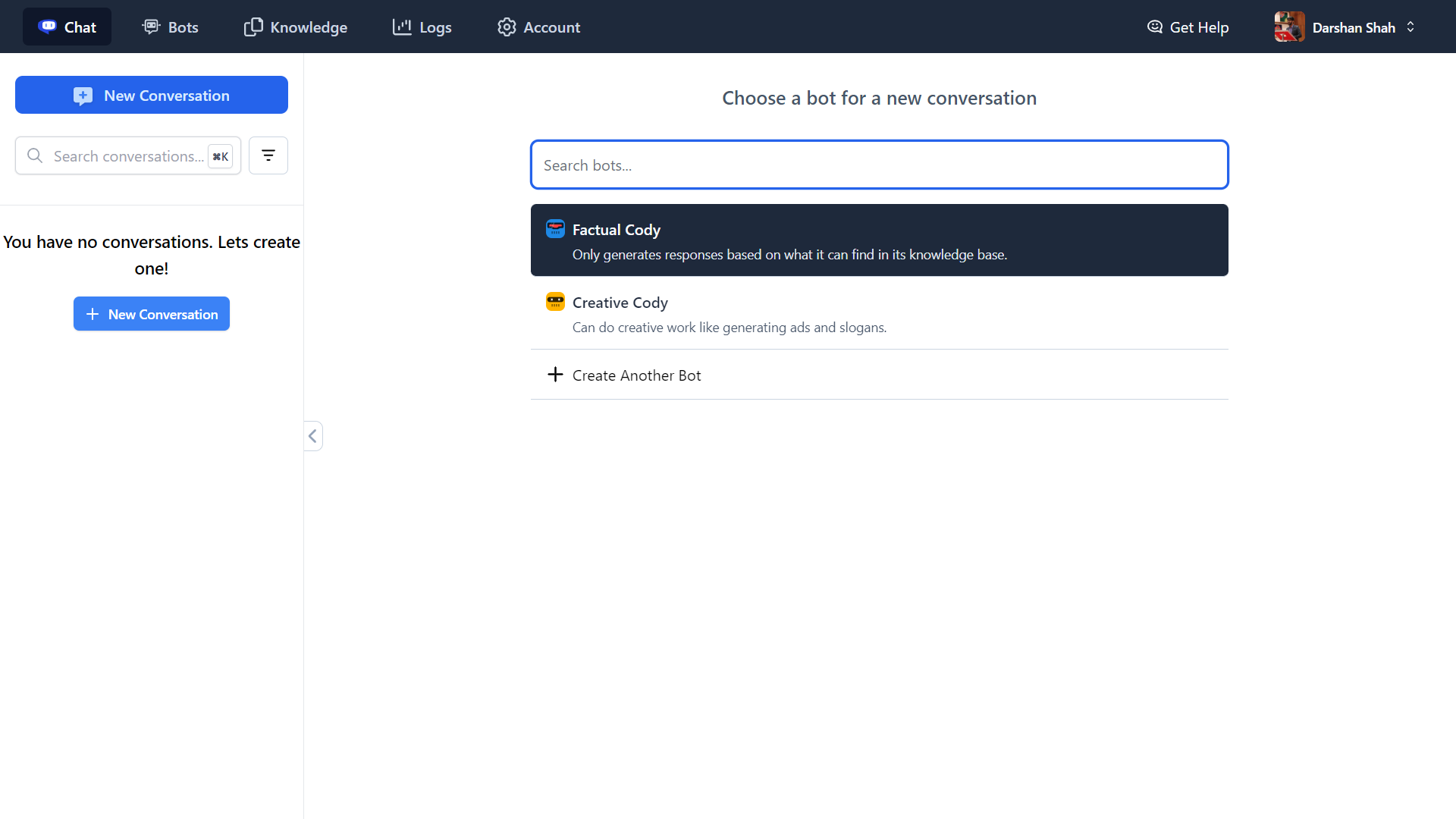

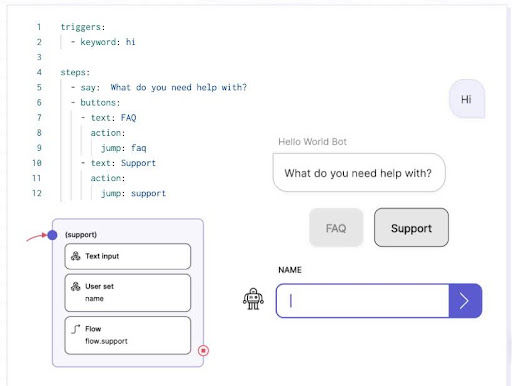

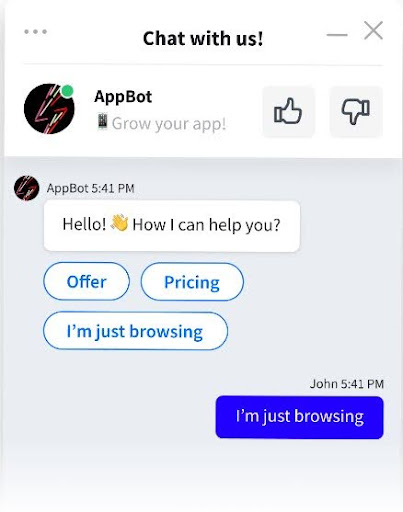

Entdecken Sie die Zukunft der Business Intelligence mit Cody AI, Ihrem intelligenten KI-Assistenten, der mehr kann als nur chatten.

Integrieren Sie Ihr Unternehmen, Ihr Team, Ihre Prozesse und Ihr Kundenwissen nahtlos in Cody, um Ihre Produktivität zu steigern.

Ganz gleich, ob Sie Antworten, kreative Lösungen, Fehlersuche oder Brainstorming benötigen, Cody ist für Sie da.

Entdecken Sie jetzt Cody AI und verändern Sie Ihre Geschäftsabläufe!