![Biggest AI Tool and Model Updates in 2023 [With Features]](https://meetcody.ai/wp-content/uploads/2023/11/All-AI-Tool-and-Model-Updates.png)

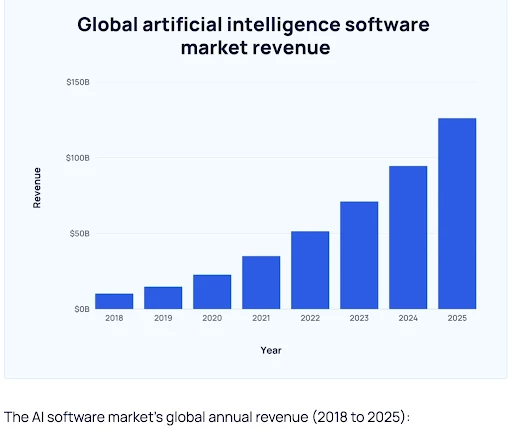

Rynek sztucznej inteligencji wzrósł o

38%

w 2023 roku, a jednym z głównych powodów jest duża liczba modeli i narzędzi AI wprowadzonych przez duże marki!

Ale dlaczego firmy wprowadzają modele i narzędzia AI dla biznesu?

PWC

donosi, że sztuczna inteligencja może zwiększyć potencjał pracowników nawet o 40% do 2025 roku!

Poniższy wykres przedstawia prognozy przychodów na rynku sztucznej inteligencji w ujęciu rok do roku (2018-2025).

Z łączną liczbą

14 700 startupów w samych Stanach Zjednoczonych

od marca 2023 r., potencjał biznesowy sztucznej inteligencji jest niewątpliwie ogromny!

Czym są duże modele językowe (LLM) w sztucznej inteligencji?

Duże modele językowe (LLM) to zaawansowane narzędzia sztucznej inteligencji zaprojektowane do symulowania inteligencji podobnej do ludzkiej poprzez rozumienie i generowanie języka. Modele te działają poprzez statystyczną analizę obszernych danych, aby dowiedzieć się, w jaki sposób słowa i frazy łączą się ze sobą.

Jako podzbiór sztucznej inteligencji, LLM są biegłe w wielu zadaniach, w tym w tworzeniu tekstu, kategoryzowaniu go, odpowiadaniu na pytania w dialogu i tłumaczeniu języków.

Ich “duże” oznaczenie wynika ze znacznych zbiorów danych, na których są szkolone. Podstawą LLM jest uczenie maszynowe, w szczególności w ramach sieci neuronowej znanej jako model transformatora. Pozwala im to skutecznie obsługiwać różne zadania przetwarzania języka naturalnego (NLP), pokazując ich wszechstronność w rozumieniu i manipulowaniu językiem.

Czytaj więcej:

RAG (Retrieval-Augmented Generation) vs LLMs?

Jakie są najlepsze studia LLM z otwartym kodem źródłowym w 2023 roku?

Od września 2023 r.

Falcon 180B

okazał się najlepszym wstępnie wytrenowanym dużym modelem językowym w rankingu Hugging Face Open LLM Leaderboard, osiągając najwyższą wydajność.

Zapoznajmy się z 7 najlepszymi modelami sztucznej inteligencji w 2023 roku –

1. Falcon LLM

Falcon LLM

to potężny, wstępnie wytrenowany otwarty duży model językowy, który na nowo zdefiniował możliwości przetwarzania języka przez sztuczną inteligencję.

Model ma 180 miliardów parametrów i został wytrenowany na 3,5 biliona tokenów. Może być używany zarówno do celów komercyjnych, jak i badawczych.

W czerwcu 2023 r. Falcon LLM znalazł się na szczycie rankingu Open LLM HuggingFace, zdobywając tytuł “Króla Open-Source LLM”.

Cechy Falcon LLM:

- Dobre wyniki w testach rozumowania, biegłości, kodowania i wiedzy.

- FlashAttention i multi-query attention dla szybszego wnioskowania i lepszej skalowalności.

- Umożliwia komercyjne wykorzystanie bez zobowiązań licencyjnych lub ograniczeń.

- Korzystanie z platformy jest bezpłatne.

2. Llama 2

Meta wydała

Llama 2

, wstępnie wytrenowane źródło danych online dostępne za darmo. Llama 2 to druga wersja Llamy, która ma podwojoną długość kontekstu i trenuje o 40% więcej niż jej poprzedniczka.

Llama 2 oferuje również Przewodnik Odpowiedzialnego Użytkowania, który pomaga użytkownikowi zrozumieć najlepsze praktyki i ocenę bezpieczeństwa.

Llama 2 Cechy:

- Llama 2 jest dostępna bezpłatnie zarówno do celów badawczych, jak i komercyjnych.

- Zawiera wagi modelu i kod startowy zarówno dla wersji wstępnie wytrenowanej, jak i dostrojonej do konwersacji.

- Dostępna za pośrednictwem różnych dostawców, w tym Amazon Web Services (AWS) i Hugging Face.

- Wdraża zasady dopuszczalnego użytkowania, aby zapewnić etyczne i odpowiedzialne korzystanie z aplikacji.

3. Claude 2.0 i 2.1

Claude 2 był zaawansowanym modelem językowym opracowanym przez Anthropic. Model ten oferuje lepszą wydajność, dłuższe odpowiedzi i dostępność zarówno poprzez API, jak i nową publiczną stronę internetową w wersji beta, claude.ai.

Po ChatGPT, model ten oferuje większe okno kontekstowe i jest uważany za jeden z najbardziej wydajnych chatbotów.

Claude 2 Cechy:

- Charakteryzuje się zwiększoną wydajnością w porównaniu do poprzednika, oferując dłuższe reakcje.

- Umożliwia użytkownikom interakcję z Claude 2 zarówno poprzez dostęp do API, jak i nową publiczną stronę internetową w wersji beta, claude.ai.

- Wykazuje dłuższą pamięć w porównaniu do poprzednich modeli.

- Wykorzystuje techniki bezpieczeństwa i szeroki red-teaming, aby ograniczyć ofensywne lub niebezpieczne wyjścia.

Wersja bezpłatna: Dostępna

Ceny: 20 USD/miesiąc

Model

Model Claude 2.1

wprowadzona 21 listopada 2023 r. wprowadza znaczące ulepszenia dla aplikacji korporacyjnych. Zawiera ona najnowocześniejsze okno kontekstowe z 200 tysiącami tokenów, znacznie zmniejsza liczbę przypadków halucynacji modelu, ulepsza podpowiedzi systemowe i wprowadza nową funkcję beta skoncentrowaną na korzystaniu z narzędzi.

Claude 2.1 nie tylko przynosi postępy w kluczowych funkcjach dla przedsiębiorstw, ale także podwaja ilość informacji, które można przekazać do systemu z nowym limitem 200 000 tokenów.

Odpowiada to około 150 000 słów lub ponad 500 stronom treści. Użytkownicy mają teraz możliwość przesyłania obszernej dokumentacji technicznej, w tym kompletnych baz kodów, kompleksowych sprawozdań finansowych, takich jak formularze S-1, lub długich dzieł literackich, takich jak “Iliada” lub “Odyseja”.

Dzięki możliwości przetwarzania i interakcji z dużymi ilościami treści lub danych, Claude może skutecznie podsumowywać informacje, przeprowadzać sesje pytań i odpowiedzi, prognozować trendy oraz porównywać i kontrastować wiele dokumentów, wśród innych funkcji.

Claude 2.1 Funkcje:

- 2x Spadek wskaźnika halucynacji

- Korzystanie z narzędzia API

- Lepsze doświadczenie dewelopera

Ceny: TBA

4. MPT-7B

MPT-7B to skrót od MosaicML Pretrained Transformer, wytrenowany od podstaw na 1 bilionie tokenów tekstów i kodów. Podobnie jak GPT, MPT działa również na transformatorach tylko z dekoderem, ale z kilkoma ulepszeniami.

Koszt 200 000 dolarów,

MPT-7B

został przeszkolony na platformie MosaicML w 9,5 dnia bez interwencji człowieka.

Cechy:

- Generuje dialogi dla różnych zadań konwersacyjnych.

- Dobrze wyposażony do płynnych, angażujących interakcji wieloobrotowych.

- Obejmuje przygotowanie danych, szkolenie, dostrojenie i wdrożenie.

- Zdolny do obsługi bardzo długich danych wejściowych bez utraty kontekstu.

- Dostępne bezpłatnie.

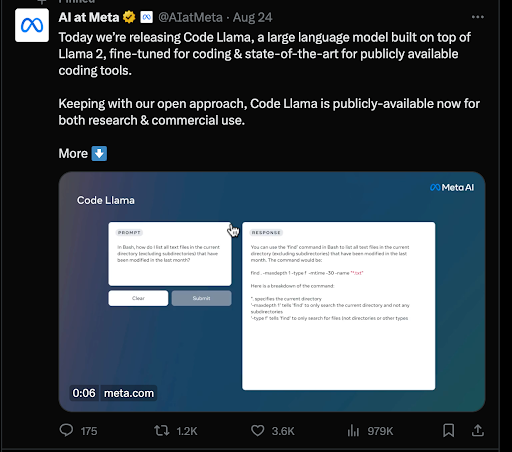

5. CodeLIama

Code Llama to duży model językowy (LLM) zaprojektowany specjalnie do generowania i omawiania kodu na podstawie podpowiedzi tekstowych. Reprezentuje on najnowocześniejszy rozwój wśród publicznie dostępnych LLM dla zadań kodowania.

Według

Meta’s news blog

Code Llama ma na celu wspieranie otwartej oceny modeli, umożliwiając społeczności ocenę możliwości, identyfikację problemów i naprawę luk w zabezpieczeniach.

CodeLIama Cechy:

- Obniża barierę wejścia dla osób uczących się kodowania.

- Służy jako produktywne i edukacyjne narzędzie do pisania solidnego, dobrze udokumentowanego oprogramowania.

- Kompatybilny z popularnymi językami programowania, w tym Python, C++, Java, PHP, Typescript (Javascript), C#, Bash i innymi.

- Dostępne są trzy rozmiary z parametrami 7B, 13B i 34B, z których każdy został przeszkolony z 500B tokenów kodu i danych związanych z kodem.

- Możliwość wdrożenia przy zerowych kosztach.

6. Model Mistral-7B AI

Mistral 7B to duży model językowy opracowany przez zespół Mistral AI. Jest to model językowy z 7,3 miliardami parametrów, co wskazuje na jego zdolność do rozumienia i generowania złożonych wzorców językowych.

Co więcej, Mistral -7B twierdzi, że jest

najlepszym modelem 7B w historii

przewyższając Llama 2 13B w kilku testach porównawczych, udowadniając swoją skuteczność w nauce języka.

Mistral-7B Cechy:

- Wykorzystuje grupowanie zapytań (GQA) w celu szybszego wnioskowania, poprawiając wydajność przetwarzania zapytań.

- Implementuje funkcję Sliding Window Attention (SWA) do obsługi dłuższych sekwencji przy zmniejszonych kosztach obliczeniowych.

- Łatwy do dostrojenia do różnych zadań, wykazujący zdolność adaptacji do różnych zastosowań.

- Darmowy w użyciu.

7. ChatGLM2-6B

ChatGLM2-6B

to druga wersja dwujęzycznego (chińsko-angielskiego) modelu czatu ChatGLM-6B o otwartym kodzie źródłowym, opracowana przez naukowców z Uniwersytetu Tsinghua w Chinach w odpowiedzi na zapotrzebowanie na lekką alternatywę dla ChatGPT.

ChatGLM2-6B Cechy:

- Przetrenowany na ponad 1 bilionie tokenów w języku angielskim i chińskim.

- Wstępnie wytrenowany na ponad 1,4 biliona tokenów dla lepszego zrozumienia języka.

- Obsługuje dłuższe konteksty, rozszerzone z 2K do 32K.

- Przewyższa konkurencyjne modele o podobnej wielkości w różnych zestawach danych (MMLU, CEval, BBH).

Wersja bezpłatna: Dostępna

Ceny: Na zapytanie

Czym są narzędzia AI?

Narzędzia AI to aplikacje wykorzystujące algorytmy sztucznej inteligencji do wykonywania określonych zadań i rozwiązywania złożonych problemów. Narzędzia te znajdują zastosowanie w różnych branżach, takich jak opieka zdrowotna, finanse, marketing i edukacja, gdzie automatyzują zadania, analizują dane i pomagają w podejmowaniu decyzji.

Korzyści z narzędzi AI obejmują wydajność w usprawnianiu procesów, oszczędność czasu, redukcję uprzedzeń i automatyzację powtarzalnych zadań.

Jednak wyzwania, takie jak kosztowne wdrożenie, potencjalna redukcja zatrudnienia oraz brak zdolności emocjonalnych i kreatywnych, są godne uwagi. Aby złagodzić te wady, kluczem jest wybór odpowiednich narzędzi AI.

Jakie są najlepsze narzędzia AI w 2023 roku?

Przemyślany wybór i strategiczne wdrożenie narzędzi AI może obniżyć koszty poprzez skupienie się na tych, które oferują największą wartość dla konkretnych potrzeb. Staranny wybór i integracja narzędzi AI może pomóc firmie wykorzystać zalety narzędzi AI przy jednoczesnym zminimalizowaniu wyzwań, co prowadzi do bardziej zrównoważonego i efektywnego wykorzystania technologii.

Oto 13 najpopularniejszych narzędzi AI w 2023 roku –

1. Otwórz GPT czatu AI

Czat GPT to model sztucznej inteligencji do przetwarzania języka naturalnego, który generuje odpowiedzi konwersacyjne podobne do ludzkich. Potrafi odpowiedzieć na proste pytanie typu “Jak upiec ciasto?”, a także pisać zaawansowane kody. Może generować eseje, posty w mediach społecznościowych, e-maile, kod itp.

Możesz użyć tego bota do nauki nowych pojęć w najprostszy sposób.

Ten chatbot AI został zbudowany i uruchomiony przez Open AI, firmę zajmującą się badaniami i sztuczną inteligencją, w listopadzie 2022 roku i szybko stał się sensacją wśród internautów.

Cechy:

- Sztuczna inteligencja wydaje się być chatbotem, dzięki czemu jest przyjazna dla użytkownika.

- Posiada wiedzę tematyczną na wiele różnych tematów.

- Jest wielojęzyczny i obsługuje ponad 50 języków.

- Wersja GPT 3 jest darmowa.

Wersja bezpłatna: Dostępna

Ceny:

- Czat GPT-3: Darmowy

- Chat GPT Plus: 20$/miesiąc

Rahul Shyokand

współzałożyciel

Wilyer:

Niedawno wykorzystaliśmy ChatGPT do wdrożenia najbardziej pożądanej przez klientów korporacyjnych funkcji naszej aplikacji na Androida. Musieliśmy opracować tę funkcję, abyśmy mogli być istotnym SaaS dla naszych klientów. Korzystając z ChatGPT, byliśmy w stanie polecić złożoną matematyczną i logiczną funkcję JAVA, która dokładnie spełniała nasze wymagania. W mniej niż tydzień byliśmy w stanie dostarczyć tę funkcję naszym klientom korporacyjnym, modyfikując i dostosowując kod JAVA. Natychmiast odblokowaliśmy wzrost o 25-30% w naszych subskrypcjach B2B SaaS i przychodach po uruchomieniu tej funkcji.

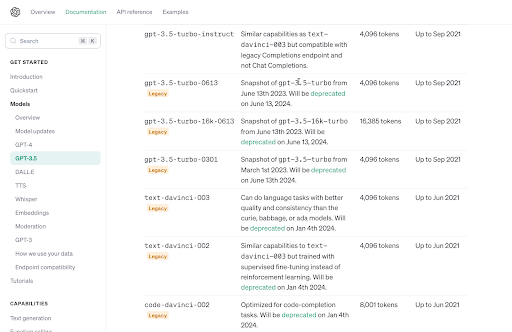

2. Kontekst GPT-4 Turbo 128K

GPT-4 Turbo 128K Context

został wydany jako ulepszona i zaawansowana wersja GPT 3.5. Dzięki oknu kontekstowemu 128K można uzyskać znacznie więcej niestandardowych danych dla aplikacji przy użyciu technik takich jak RAG (Retrieval Augmented Generation).

Cechy:

- Zapewnia ulepszone wywołania funkcjonalne w oparciu o dane wejściowe użytkownika w języku naturalnym.

- Współpracuje z systemami oprogramowania przy użyciu trybu JSON.

- Oferuje powtarzalne wyniki przy użyciu parametru Seed.

- Wydłuża termin utraty wiedzy o dziewiętnaście miesięcy do kwietnia 2023 r.

Wersja darmowa: Niedostępne

Ceny:

- Wejście: 0,01 USD/1000 tokenów

- Wydatek: 0,3 USD/1000 tokenów

3. Czat GPT4 Vision

Open AI uruchomiło multimodalny

GPT-4 Vision

w marcu 2023 roku. Ta wersja jest jedną z najbardziej instrumentalnych wersji Chat GPT, ponieważ może przetwarzać różne typy formatów tekstowych i wizualnych. GPT-4 oferuje zaawansowane funkcje obrazu i głosu, odblokowując różne innowacje i przypadki użycia.

Generatywna sztuczna inteligencja ChatGPT-4 jest trenowana pod 100 bilionami parametrów, co stanowi 500-krotność wersji ChatGPT-3.

Cechy:

- Rozumie wizualne dane wejściowe, takie jak zdjęcia, dokumenty, odręczne notatki i zrzuty ekranu.

- Wykrywa i analizuje obiekty i figury na podstawie obrazów przesłanych jako dane wejściowe.

- Oferuje analizę danych w formatach wizualnych, takich jak wykresy, diagramy itp.

- Oferuje 3x ekonomiczny model

- Zwraca 4096 tokenów wyjściowych

Wersja darmowa: Niedostępne

Ceny: Płać za to, z czego korzystasz Model

4. GPT 3.5 Turbo Instruct

GPT 3.5 Turbo Instruct została wydana w celu złagodzenia powtarzających się problemów w wersji GPT-3. Kwestie te obejmowały niedokładne informacje, nieaktualne fakty itp.

Tak więc, wersja 3.5 została specjalnie zaprojektowana do tworzenia logicznych, kontekstowo poprawnych i bezpośrednich odpowiedzi na zapytania użytkowników.

Cechy:

- Rozumie i sprawnie wykonuje instrukcje.

- Tworzy bardziej zwięzłe i trafne treści przy użyciu kilku tokenów.

- Oferuje szybsze i dokładniejsze odpowiedzi dostosowane do potrzeb użytkownika.

- Nacisk na umiejętności rozumowania umysłowego zamiast zapamiętywania.

Wersja darmowa: Niedostępne

Ceny:

- Wejście: 0,0015 USD/1000 tokenów

- Wydatek: 0,0020 USD/1000 tokenów

5. Narzędzie Microsoft Copilot AI

Copilot 365 to pełnoprawne narzędzie sztucznej inteligencji, które działa w pakiecie Microsoft Office. Za pomocą tej sztucznej inteligencji można tworzyć dokumenty, czytać, podsumowywać i odpowiadać na wiadomości e-mail, generować prezentacje i nie tylko. Został zaprojektowany specjalnie w celu zwiększenia produktywności pracowników i usprawnienia przepływu pracy.

Cechy:

- Podsumowuje dokumenty i wiadomości e-mail o długim łańcuchu.

- Generuje i podsumowuje prezentacje.

- Analizuje arkusze Excela i tworzy wykresy prezentujące dane.

- Szybsze czyszczenie skrzynki odbiorczej programu Outlook.

- Napisz wiadomości e-mail na podstawie dostarczonych informacji.

Wersja bezpłatna: 30-dniowa bezpłatna wersja próbna

Ceny: 30$/miesiąc

6. Asystent generatywnej sztucznej inteligencji SAP: Joule

Joule to generatywny asystent

asystent AI firmy SAP

który jest wbudowany w aplikacje SAP, w tym HR, finanse, łańcuch dostaw, zaopatrzenie i obsługę klienta.

Korzystając z tej technologii AI, możesz uzyskać szybkie odpowiedzi i wnikliwe spostrzeżenia, kiedy tylko ich potrzebujesz, umożliwiając szybsze podejmowanie decyzji bez żadnych opóźnień.

Cechy:

- Pomaga w zrozumieniu i poprawie wyników sprzedaży, identyfikowaniu problemów i sugerowaniu rozwiązań.

- Zapewnia ciągłe dostarczanie nowych scenariuszy dla wszystkich rozwiązań SAP.

- Pomaga w HR, generując bezstronne opisy stanowisk i odpowiednie pytania na rozmowy kwalifikacyjne.

- Przekształca doświadczenie użytkownika SAP poprzez dostarczanie inteligentnych odpowiedzi opartych na zapytaniach w prostym języku.

Wersja bezpłatna: Dostępna

Ceny: Na zapytanie

7. AI Studio by Meta

AI Studio by Meta została stworzona z myślą o usprawnieniu interakcji firm z klientami. Umożliwia on firmom tworzenie niestandardowych chatbotów AI do interakcji z klientami za pomocą usług przesyłania wiadomości na różnych platformach, w tym Instagramie, Facebooku i Messengerze.

Głównym scenariuszem zastosowania AI Studio jest sektor e-commerce i obsługi klienta.

Cechy:

- Podsumowuje dokumenty i wiadomości e-mail o długim łańcuchu.

- Generuje i podsumowuje prezentacje.

- Analizuje arkusze Excela i tworzy wykresy prezentujące dane.

- Szybsze czyszczenie skrzynki odbiorczej programu Outlook.

- Napisz wiadomości e-mail na podstawie dostarczonych informacji.

Wersja bezpłatna: 30-dniowy bezpłatny okres próbny

Ceny: 30$/miesiąc

8. Narzędzie sztucznej inteligencji EY

EY AI integruje ludzkie zdolności ze sztuczną inteligencją (AI), aby ułatwić pewne i odpowiedzialne przyjęcie AI przez organizacje. Wykorzystuje ogromne doświadczenie biznesowe EY, wiedzę branżową i zaawansowane platformy technologiczne, aby dostarczać transformacyjne rozwiązania.

Cechy:

- Wykorzystuje doświadczenie z różnych dziedzin, aby dostarczać rozwiązania AI i spostrzeżenia dostosowane do konkretnych potrzeb biznesowych.

- Zapewnia płynną integrację najnowocześniejszych możliwości AI z kompleksowymi rozwiązaniami za pośrednictwem EY Fabric.

- Osadza możliwości AI z szybkością i skalą dzięki EY Fabric.

Wersja bezpłatna: Bezpłatna dla pracowników EY

Ceny: Na zapytanie

9. Narzędzie generatywnej sztucznej inteligencji Amazon dla sprzedawców

Amazon niedawno uruchomił

Sztuczna inteligencja dla sprzedawców Amazon

które pomagają im w kilku funkcjach związanych z produktem. Upraszcza pisanie tytułów produktów, wypunktowań, opisów, szczegółów aukcji itp.

Ta sztuczna inteligencja ma na celu tworzenie wysokiej jakości ofert i angażujących informacji o produktach dla sprzedawców przy minimalnym nakładzie czasu i wysiłku.

Cechy:

- Tworzy atrakcyjne tytuły produktów, wypunktowania i opisy dla sprzedawców.

- Znajdź wąskie gardła produktów za pomocą automatycznego monitorowania.

- Generuje zautomatyzowane chatboty w celu zwiększenia satysfakcji klientów.

- Generuje kompleksowe modele predykcyjne przy użyciu szeregów czasowych i typów danych.

Darmowa wersja: Dostępna bezpłatna wersja próbna

Ceny: Na zapytanie

10. Generatywne narzędzie AI firmy Adobe dla projektantów

Generatywna sztuczna inteligencja Adobe for Designers ma na celu usprawnienie procesu twórczego projektantów. Korzystając z tego narzędzia, można płynnie generować grafikę w ciągu kilku sekund za pomocą podpowiedzi, rozszerzać obrazy, przenosić elementy w obrazach itp.

Sztuczna inteligencja ma na celu rozszerzenie i wspieranie naturalnej kreatywności projektantów, umożliwiając im przenoszenie, dodawanie, zastępowanie lub usuwanie czegokolwiek w dowolnym miejscu obrazu.

Cechy:

- Konwertowanie podpowiedzi tekstowych na obrazy.

- Oferuje pędzel do usuwania obiektów lub malowania nowych.

- Zapewnia unikalne efekty tekstowe.

- Konwertowanie elementów 3D na obrazy.

- Przesuwa obiekty na obrazie.

Wersja bezpłatna: Dostępna

Ceny: 4,99 USD/miesiąc

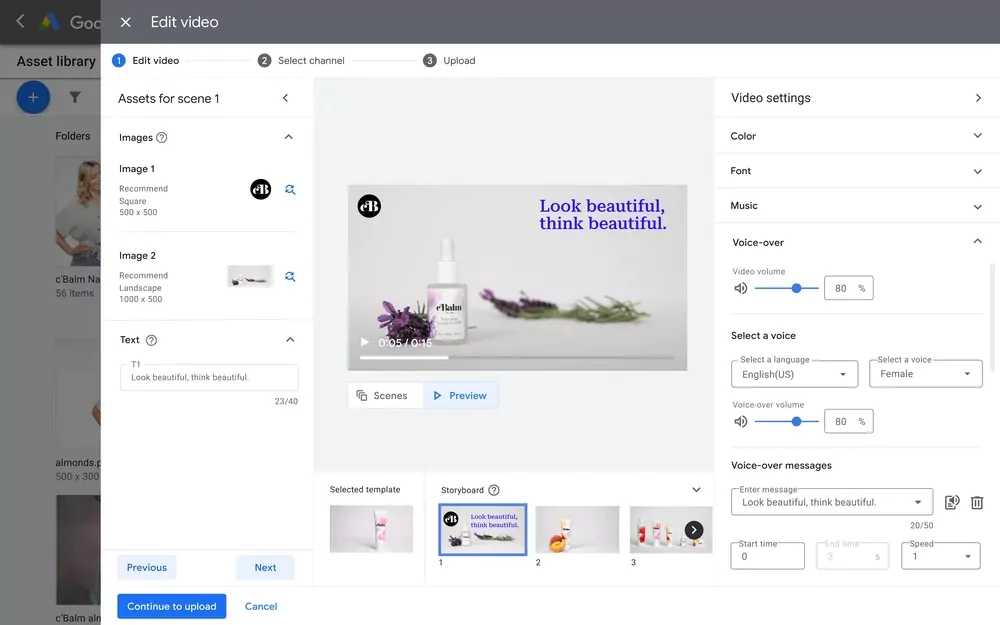

11. Narzędzie Google AI do kreatywnego doradztwa

Google uruchomił nowy produkt AI do optymalizacji reklam w ramach opcji Video Analytics o nazwie

Creative Guidance AI

. Narzędzie to analizuje filmy reklamowe i oferuje wnikliwe informacje zwrotne w oparciu o najlepsze praktyki i wymagania Google.

Ponadto nie tworzy wideo za Ciebie, ale zapewnia cenne informacje zwrotne w celu optymalizacji istniejącego wideo.

Cechy:

- Sprawdź, czy logo marki jest wyświetlane w ciągu 5 sekund filmu.

- Analizuj długość wideo w oparciu o cele marketingowe.

- Skanuje wysokiej jakości lektorów.

- Analiza proporcji obrazu wideo.

Darmowa wersja: Darmowa

Ceny: Na zapytanie

12. Grok: Generatywne narzędzie sztucznej inteligencji nowej generacji

Grok AI to duży moduł językowy opracowany przez xAI, startup Elona Muska zajmujący się sztuczną inteligencją. Narzędzie jest trenowane z 33 miliardami parametrów, co jest porównywalne z LLaMA 2 firmy Meta z 70 miliardami parametrów.

W rzeczywistości, według

The Indian Express

najnowszego raportu, Gork-1 przewyższa Clause 2 i GPT 3.5, ale wciąż nie GPT 4.

Cechy:

- Wyodrębnia informacje w czasie rzeczywistym z platformy X (dawniej Twitter).

- Wykorzystuje humor i sarkazm w swoich reakcjach na zwiększone interakcje,

- Potrafi odpowiadać na “pikantne pytania”, które wiele sztucznej inteligencji odrzuca.

Wersja bezpłatna: 30-dniowa bezpłatna wersja próbna

Ceny: 16 USD/miesiąc

Szukasz wydajności? Oto 10 unikalnych narzędzi AI, o których powinieneś wiedzieć!

Duże modele językowe (LLM) a narzędzia AI: Jaka jest różnica?

Podczas gdy LLM są wyspecjalizowanym podzbiorem generatywnej sztucznej inteligencji, nie wszystkie narzędzia generatywnej sztucznej inteligencji są oparte na frameworkach LLM. Generatywna sztuczna inteligencja obejmuje szerszy zakres technologii sztucznej inteligencji zdolnych do tworzenia oryginalnych treści w różnych formach, czy to tekstu, obrazów, muzyki i nie tylko. Narzędzia te opierają się na podstawowych modelach sztucznej inteligencji, w tym LLM, w celu generowania tej zawartości.

Z drugiej strony, LLM są specjalnie zaprojektowane do zadań opartych na języku. Wykorzystują one głębokie uczenie i sieci neuronowe, aby doskonalić się w rozumieniu, interpretowaniu i generowaniu tekstu podobnego do ludzkiego. Koncentrują się one głównie na przetwarzaniu języka, dzięki czemu doskonale radzą sobie z zadaniami takimi jak generowanie tekstu, tłumaczenie i odpowiadanie na pytania.

Kluczowa różnica polega na ich zakresie i zastosowaniu: Generatywna sztuczna inteligencja to szeroka kategoria dla każdej sztucznej inteligencji, która tworzy oryginalne treści w wielu domenach, podczas gdy LLM są ukierunkowanym typem generatywnej sztucznej inteligencji specjalizującej się w zadaniach związanych z językiem. To rozróżnienie ma kluczowe znaczenie dla zrozumienia ich roli i możliwości w środowisku sztucznej inteligencji.

David Watkins

dyrektor ds. zarządzania produktami w

Ethos

–W EthOS nasze doświadczenie z integracją Al z naszą platformą było transformacyjne. Wykorzystując analizę nastrojów i tonów IBM Watson, możemy szybko zbierać nastroje i emocje klientów dotyczące nowych projektów stron internetowych, testowania produktów w domu i wielu innych badań jakościowych.

13. Wypróbuj Cody’ego, uprość biznes!

Cody to przystępne, niekodowane rozwiązanie do tworzenia chatbotów przy użyciu zaawansowanych modeli GPT OpenAI, w szczególności 3.5 turbo i 4. Narzędzie to zostało zaprojektowane z myślą o łatwości użytkowania i nie wymaga umiejętności technicznych, dzięki czemu jest odpowiednie dla szerokiego grona użytkowników. Wystarczy wprowadzić dane do aplikacji Cody, a ona skutecznie zajmie się resztą, zapewniając bezproblemową obsługę.

Cechą wyróżniającą Cody jest jego niezależność od konkretnych wersji modeli, dzięki czemu użytkownicy mogą być na bieżąco z najnowszymi aktualizacjami LLM bez konieczności ponownego szkolenia swoich botów. Zawiera również konfigurowalną bazę wiedzy, stale rozwijaną w celu zwiększenia jej możliwości.

Idealny do prototypowania w firmach, Cody pokazuje potencjał modeli GPT bez złożoności budowania modelu AI od podstaw. Chociaż jest w stanie wykorzystywać dane firmy w różnych formatach do spersonalizowanego szkolenia modeli, zaleca się korzystanie z niewrażliwych, publicznie dostępnych danych w celu zachowania prywatności i integralności.

Dla firm poszukujących solidnego ekosystemu GPT, Cody oferuje rozwiązania klasy korporacyjnej. Jego AI API ułatwia płynną integrację z różnymi aplikacjami i usługami, zapewniając takie funkcje, jak zarządzanie botami, wysyłanie wiadomości i śledzenie konwersacji.

Co więcej, Cody można zintegrować z platformami takimi jak

Slack

,

Discord

i

Zapier

i pozwala na

udostępnianie bota innym osobom

. Oferuje szereg opcji dostosowywania, w tym wybór modelu, osobowość bota, poziom zaufania i odniesienie do źródła danych, umożliwiając stworzenie chatbota, który pasuje do konkretnych potrzeb.

Połączenie łatwości obsługi i opcji dostosowywania sprawia, że Cody jest doskonałym wyborem dla firm, które chcą wykorzystać technologię GPT bez zagłębiania się w skomplikowany rozwój modeli AI.

Przejdź do

najłatwiejszej rejestracji AI w historii

!