Ao entrarmos em 2025, a inteligência artificial (IA) está remodelando os setores, a sociedade e a forma como interagimos com a tecnologia de maneiras empolgantes e, às vezes, surpreendentes. De agentes de IA que podem trabalhar de forma independente a sistemas que integram perfeitamente texto, vídeo e áudio, o campo está evoluindo mais rápido do que nunca. Para os empreendedores e desenvolvedores de tecnologia, ficar à frente dessas mudanças não é apenas inteligente – é essencial.

Vamos entender as tendências, os avanços e os desafios que moldarão a IA em 2025 e nos anos seguintes.

Um rápido olhar para trás: como a IA mudou nosso mundo

A jornada da IA, desde a década de 1950 até hoje, tem sido uma história notável de evolução. De sistemas simples e baseados em regras, ela evoluiu para modelos sofisticados capazes de raciocínio, criatividade e autonomia. Na última década, a IA passou de experimental a indispensável, tornando-se um dos principais impulsionadores da inovação em todos os setores.

Cuidados com a saúde

As ferramentas com tecnologia de IA agora são parte integrante dos diagnósticos, da medicina personalizada e até mesmo da robótica cirúrgica. Tecnologias como imagens aprimoradas por IA ampliaram os limites da detecção precoce de doenças, rivalizando e superando as capacidades humanas em termos de precisão e velocidade.

Educação

As plataformas de IA adaptativa mudaram fundamentalmente a forma como os alunos aprendem. Elas usam a análise de dados granulares para adaptar o conteúdo, o ritmo e o envolvimento em um nível individual.

Transporte

Os sistemas autônomos evoluíram de protótipos experimentais para soluções viáveis em logística e transporte público, apoiados por avanços na fusão de sensores, visão computacional e tomada de decisões em tempo real.

Embora esses avanços tenham trazido um valor inegável, eles também expuseram questões complexas sobre ética, implicações para a força de trabalho e a distribuição equitativa dos benefícios da IA. Enfrentar esses desafios continua sendo uma prioridade à medida que a IA continua a se expandir.

Tecnologias de IA revolucionárias para você observar em 2025

Em 2025, o foco não está apenas em tornar a IA mais inteligente, mas em torná-la mais capaz, dimensionável e ética. Veja o que está moldando o cenário:

1. IA agêntica: além da automação de tarefas

A IA agêntica não é apenas mais uma palavra da moda. Esses sistemas podem tomar decisões e se adaptar a situações com pouca ou nenhuma intervenção humana. O que você acha de ter uma IA que gerencia sua agenda, lida com projetos ou até mesmo gera ideias criativas? É como adicionar um membro da equipe supereficiente que nunca dorme.

- Para empresas: Pense em gerentes de projeto virtuais que lidam com fluxos de trabalho complexos.

- Para profissionais de criação: Ferramentas que ajudam no brainstorming de ideias ou na edição de conteúdo junto com você.

Como destaca a Moody’s, a IA agêntica está pronta para se tornar uma força motriz por trás da produtividade e da inovação em todos os setores.

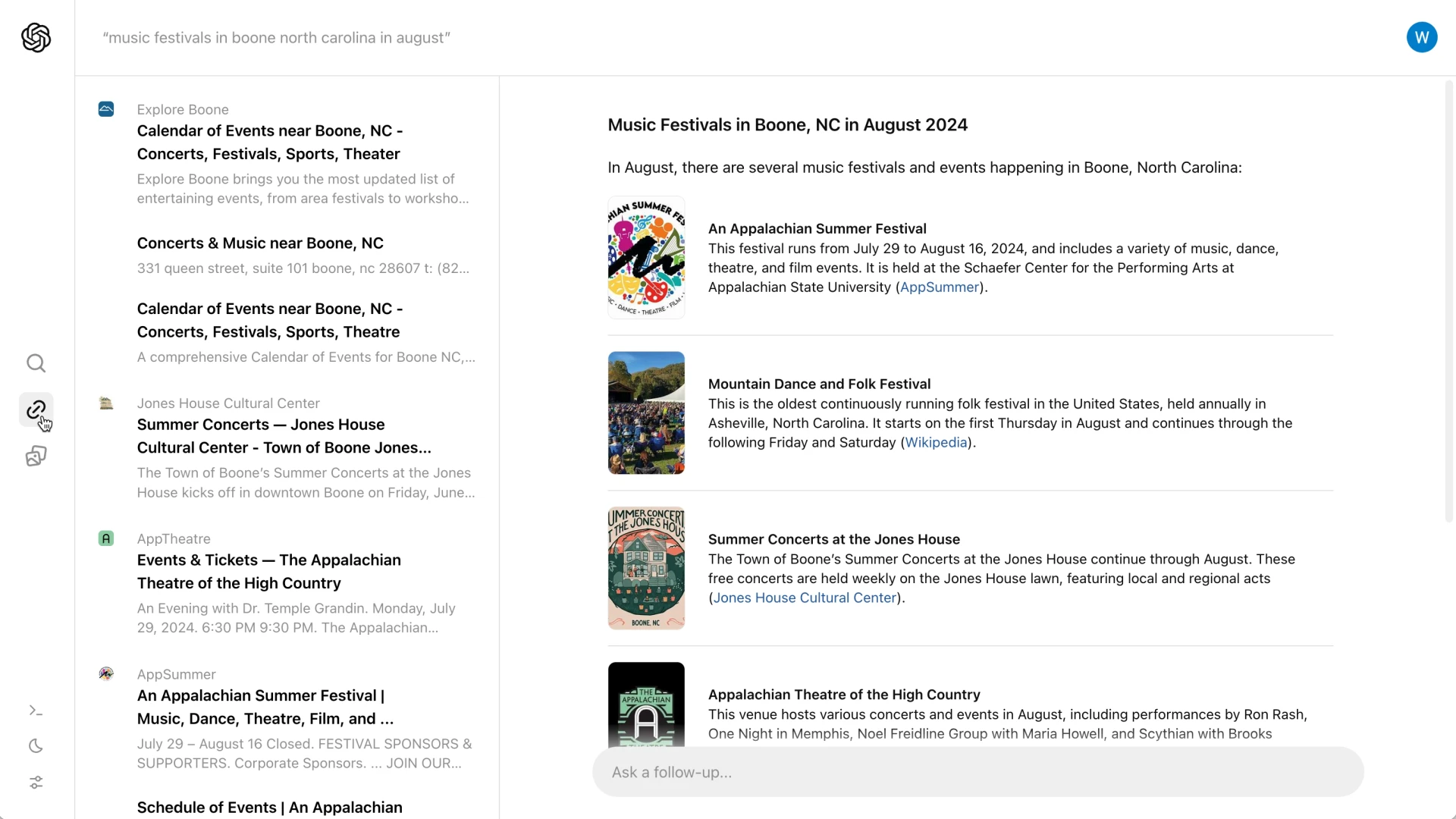

2. IA multimodal: a melhor solução para todos os tipos de problemas

Essa tecnologia reúne texto, imagens, áudio e vídeo em um sistema contínuo. É por isso que os futuros assistentes virtuais não entenderão apenas o que você está dizendo – eles captarão seu tom, expressões faciais e até mesmo o contexto do ambiente ao seu redor.

Aqui estão alguns exemplos:

- Cuidados com a saúde: Os sistemas multimodais poderiam analisar dados médicos de várias fontes para fornecer diagnósticos mais rápidos e mais precisos.

- Vida cotidiana: imagine um assistente que possa ajudar você a planejar uma viagem analisando avaliações, fotos e vídeos instantaneamente.

A Gartner prevê que, até 2027, 40% das soluções de IA generativa serão multimodais, em comparação com apenas 1% em 2023.

3. Dados sintéticos: A solução favorável à privacidade

Os sistemas de IA precisam de dados para aprender, mas os dados do mundo real geralmente apresentam problemas de privacidade ou disponibilidade. Você pode usar dados sintéticos – conjuntos de dados gerados artificialmente que imitam os dados reais sem expor informações confidenciais.

Veja como isso pode acontecer:

Inovação escalável: Do treinamento de veículos autônomos em ambientes simulados à geração de dados médicos raros para pesquisa farmacêutica.

Imperativos de governança: Os desenvolvedores estão cada vez mais integrando sistemas que facilitam a auditoria para garantir a transparência, a responsabilidade e o alinhamento com os padrões regulatórios.

Os dados sintéticos são vantajosos para todos, pois ajudam os desenvolvedores a inovar mais rapidamente e, ao mesmo tempo, respeitam a privacidade.

Setores que a IA está transformando no momento

A IA já está causando impacto nesses setores-chave:

| Setor | Porcentagem de entrevistados com uso regular de IA de geração em suas funções organizacionais(Fonte) |

| Marketing e vendas | 14% |

| Desenvolvimento de produtos e/ou serviços | 13% |

| Operações de serviço | 10% |

| Gerenciamento de riscos | 4% |

| Estratégia e finanças corporativas | 4% |

| RH | 3% |

| Gerenciamento da cadeia de suprimentos | 3% |

| Manufatura | 2% |

Cuidados com a saúde

A IA está salvando vidas. Desde a análise de imagens médicas até a recomendação de tratamentos personalizados, ela está tornando a assistência médica mais inteligente, mais rápida e mais acessível. As ferramentas de detecção precoce já estão superando os métodos tradicionais, ajudando os médicos a detectar problemas antes que eles se agravem.

Varejo

A IA geradora está permitindo campanhas de marketing hiperpersonalizadas, enquanto os modelos preditivos de estoque reduzem o desperdício alinhando as cadeias de suprimentos com mais precisão aos padrões de demanda. Os varejistas que adotam essas tecnologias estão relatando ganhos significativos em eficiência operacional. De acordo com a McKinsey, a IA generativa deve liberar de US$ 240 bilhões a US$ 390 bilhões em valor econômico para os varejistas.

Educação

Além da aprendizagem adaptativa, a IA agora está aumentando as metodologias de ensino. Por exemplo, as ferramentas de IA generativa auxiliam os educadores criando currículos personalizados e recursos de ensino interativos, simplificando os encargos administrativos.

Transporte e logística

A integração da IA com os sistemas de IoT possibilitou uma visibilidade inigualável das redes de logística, aprimorando a otimização de rotas, o gerenciamento de estoques e a mitigação de riscos para as cadeias de suprimentos globais.

O que vem por aí? Tendências de IA para você observar em 2025

Então, para onde a IA está indo? Aqui estão as grandes tendências que estão moldando o futuro:

1. Modelos de IA de autoaperfeiçoamento

Os sistemas de IA que se refinam em tempo real estão surgindo como uma tendência fundamental. Esses modelos de autoaperfeiçoamento aproveitam os ciclos de aprendizagem contínua, aumentando a precisão e a relevância com o mínimo de supervisão humana. Os casos de uso incluem detecção de fraudes em tempo real e segurança cibernética adaptável.

2. As novas fronteiras dos dados sintéticos

Os dados sintéticos estão indo além dos aplicativos voltados para a privacidade e se transformando em cenários mais sofisticados, como o treinamento de IA para casos extremos e a simulação de eventos raros ou perigosos. Setores como o de direção autônoma estão investindo pesadamente nessa área para modelar casos extremos em escala.

3. Arquiteturas de IA específicas do domínio

A era da IA generalizada está dando lugar a arquiteturas especializadas em domínios. Os desenvolvedores estão se concentrando no ajuste fino de modelos para setores verticais específicos, como finanças, modelagem climática e pesquisa genômica, desbloqueando novos níveis de precisão e eficiência.

4. IA de borda em escala

A IA de borda processa dados localmente em um dispositivo em vez de depender da nuvem. Seus recursos em tempo real estão evoluindo de aplicativos de nicho para a adoção convencional. Os setores estão aproveitando a computação de borda para implantar modelos de IA de baixa latência em ambientes com conectividade limitada, desde instalações remotas de saúde até fábricas inteligentes.

5. Ecossistemas colaborativos de IA

A IA está se tornando menos isolada, com ecossistemas que permitem a interoperabilidade entre diversos modelos e plataformas. Isso promove soluções mais robustas por meio da colaboração, especialmente em ambientes com várias partes interessadas, como saúde e planejamento urbano.

Os desafios futuros

Embora o futuro da IA seja brilhante, ele não está isento de obstáculos. Aqui está o que você precisa enfrentar:

Regulamentos e ética

A Lei de IA da União Europeia e as leis de transparência de dados da Califórnia são apenas o começo. Os desenvolvedores e os formuladores de políticas devem trabalhar juntos para garantir que a IA seja usada de forma responsável e ética.

Preconceito e imparcialidade

Mesmo com a melhoria da interpretabilidade do modelo, o risco de viés continua significativo. Os desenvolvedores devem priorizar conjuntos de dados diversos e de alta qualidade e incorporar métricas de imparcialidade em seus pipelines para atenuar consequências não intencionais.

Sustentabilidade

O treinamento de modelos massivos de IA consome muita energia. As inovações em compressão de modelos e hardware com eficiência energética são essenciais para alinhar o desenvolvimento da IA com as metas de sustentabilidade.

Olhando para o futuro: Como a IA moldará o futuro

O potencial da IA para remodelar os setores e enfrentar os desafios globais é imenso. Mas como exatamente ela afetará o nosso futuro? Aqui está uma visão mais detalhada:

Capacitação para os desafios globais

As ferramentas baseadas em IA estão analisando padrões climáticos, otimizando fontes de energia renovável e prevendo desastres naturais com maior precisão. Por exemplo, os modelos de IA podem ajudar os agricultores a se adaptarem às mudanças climáticas, prevendo padrões de chuva e sugerindo rotações de culturas ideais.

A IA está democratizando o acesso à saúde ao permitir diagnósticos remotos e recomendações de tratamento. Em áreas carentes, as ferramentas de IA estão atuando como prestadores de serviços de saúde virtuais, preenchendo a lacuna causada pela escassez de profissionais médicos.

Transformando o trabalho

Embora a IA automatize tarefas repetitivas, ela também está criando demanda para funções de ética em IA, treinamento de sistemas e colaboração entre humanos e IA. O local de trabalho está se tornando uma parceria dinâmica entre humanos e IA, onde as tarefas que exigem intuição e empatia são complementadas pela precisão e escala da IA.

As funções de trabalho evoluirão para a curadoria, o gerenciamento e a auditoria de sistemas de IA, em vez da execução direta de tarefas.

Como lidar com ameaças à segurança

A sofisticação da IA também apresenta riscos. Os ataques cibernéticos com tecnologia de IA e tecnologias deepfake estão se tornando mais predominantes. Para combater isso, os modelos preditivos de ameaças e os sistemas de resposta autônoma já estão reduzindo os tempos de resposta a violações de horas para segundos.

Concluindo: Você está pronto para o futuro?

2025 não é apenas mais um ano para a IA – é um ponto de inflexão. Com avanços como IA agêntica, sistemas multimodais e dados sintéticos remodelando os setores, cabe aos empreendedores e desenvolvedores de tecnologia navegar nesse cenário em evolução com precisão e previsão. O futuro não se resume à adoção da IA; trata-se de moldar sua trajetória de forma responsável.