À l’aube de 2025, l’intelligence artificielle (IA) est en train de remodeler les industries, la société et la façon dont nous interagissons avec la technologie de manière passionnante et parfois surprenante. Qu’il s’agisse d’agents d’IA capables de travailler de manière autonome ou de systèmes qui intègrent de manière transparente du texte, de la vidéo et de l’audio, le domaine évolue plus rapidement que jamais. Pour les entrepreneurs et les développeurs technologiques, rester à l’avant-garde de ces changements n’est pas seulement intelligent, c’est essentiel.

Comprenons les tendances, les percées et les défis qui façonneront l’IA en 2025 et au-delà.

Petit retour en arrière : comment l’IA a changé notre monde

Le parcours de l’IA, des années 1950 à aujourd’hui, est une remarquable histoire d’évolution. De simples systèmes basés sur des règles, elle a évolué vers des modèles sophistiqués capables de raisonnement, de créativité et d’autonomie. Au cours de la dernière décennie, l’IA est passée du stade expérimental à celui d’outil indispensable, devenant un moteur essentiel de l’innovation dans tous les secteurs d’activité.

Soins de santé

Les outils alimentés par l’IA font désormais partie intégrante des diagnostics, de la médecine personnalisée et même de la robotique chirurgicale. Des technologies telles que l’imagerie améliorée par l’IA ont repoussé les limites de la détection précoce des maladies, rivalisant et dépassant les capacités humaines en termes de précision et de rapidité.

L’éducation

Les plateformes d’IA adaptative ont fondamentalement changé la façon dont les étudiants apprennent. Elles utilisent une analyse granulaire des données pour adapter le contenu, le rythme et l’engagement au niveau individuel.

Transport

Les systèmes autonomes sont passés du stade de prototypes expérimentaux à celui de solutions viables dans les domaines de la logistique et des transports publics, grâce aux progrès réalisés dans les domaines de la fusion des capteurs, de la vision par ordinateur et de la prise de décision en temps réel.

Si ces progrès ont apporté une valeur indéniable, ils ont également soulevé des questions complexes concernant l’éthique, les implications pour la main-d’œuvre et la répartition équitable des avantages de l’IA. Relever ces défis reste une priorité à mesure que l’IA continue à se développer.

Les technologies d’IA qui changent la donne en 2025

En 2025, il ne s’agira pas seulement de rendre l’IA plus intelligente, mais aussi de la rendre plus performante, plus évolutive et plus éthique. Voici ce qui façonne le paysage :

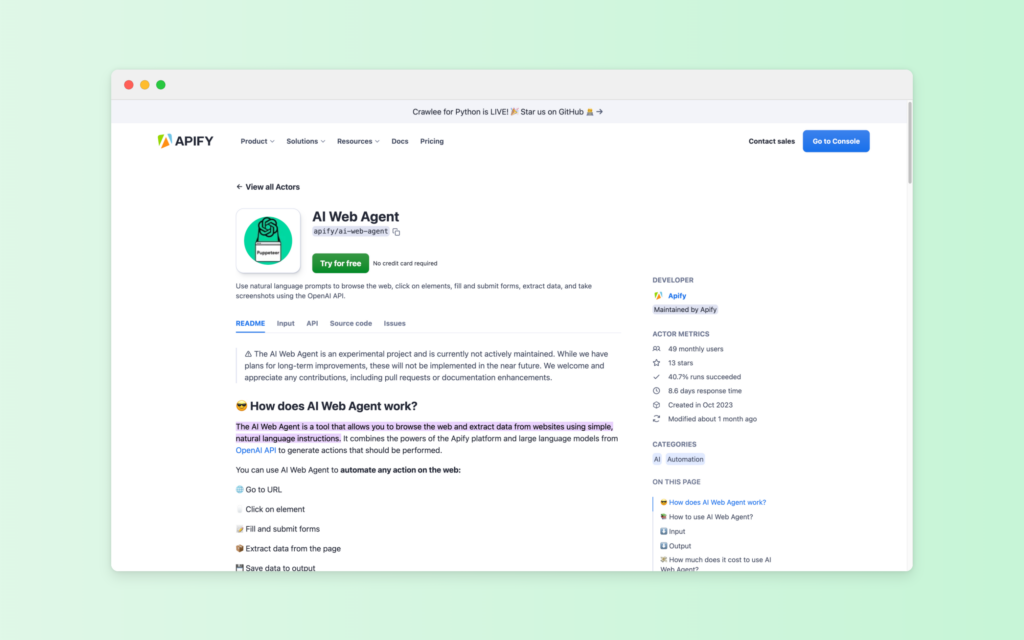

1. L’IA agentique : au-delà de l’automatisation des tâches

L’IA agentique n’est pas un simple mot à la mode. Ces systèmes peuvent prendre des décisions et s’adapter à des situations avec peu ou pas d’intervention humaine. Que diriez-vous d’avoir une IA qui gère votre emploi du temps, s’occupe de vos projets ou même génère des idées créatives ? C’est comme si vous vous adjoigniez un membre de l’équipe super efficace qui ne dort jamais.

- Pour les entreprises : Pensez à des chefs de projet virtuels qui gèrent des flux de travail complexes.

- Pour les créatifs : Des outils qui vous aident à trouver des idées ou à éditer du contenu en même temps que vous.

Comme le souligne Moody’s, l’IA agentique est appelée à devenir un moteur de productivité et d’innovation dans tous les secteurs d’activité.

2. L’IA multimodale : l’outil polyvalent par excellence

Cette technologie réunit le texte, les images, le son et la vidéo en un seul système homogène. C’est pourquoi les futurs assistants virtuels ne se contenteront pas de comprendre ce que vous dites : ils percevront votre ton, vos expressions faciales et même le contexte dans lequel vous vous trouvez.

Voici quelques exemples :

- Santé : Les systèmes multimodaux pourraient analyser des données médicales provenant de sources multiples afin de fournir des diagnostics plus rapides et plus précis.

- Vie quotidienne : imaginez un assistant qui vous aide à planifier un voyage en analysant instantanément les avis, les photos et les vidéos.

Gartner prévoit que d’ici 2027, 40 % des solutions d’IA générative seront multimodales, contre seulement 1 % en 2023.

3. Données synthétiques : La solution respectueuse de la vie privée

Les systèmes d’IA ont besoin de données pour apprendre, mais les données réelles posent souvent des problèmes de confidentialité ou de disponibilité. C’est là qu’interviennent les données synthétiques, des ensembles de données générées artificiellement qui imitent les données réelles sans exposer d’informations sensibles.

Voici comment cela pourrait se passer :

L’innovation évolutive : De la formation de véhicules autonomes dans des environnements simulés à la production de données médicales rares pour la recherche pharmaceutique.

Impératifs de gouvernance : Les développeurs intègrent de plus en plus des systèmes faciles à auditer pour garantir la transparence, la responsabilité et l’alignement sur les normes réglementaires.

Les données synthétiques sont bénéfiques pour tous, car elles aident les développeurs à innover plus rapidement tout en respectant la vie privée.

Les industries que l’IA est en train de transformer

L’IA fait déjà des vagues dans ces secteurs clés :

| L’industrie | Part des répondants utilisant régulièrement Gen AI dans le cadre de leurs fonctions organisationnelles(Source) |

| Marketing et ventes | 14% |

| Développement de produits et/ou de services | 13% |

| Opérations de service | 10% |

| Gestion des risques | 4% |

| Stratégie et finance d’entreprise | 4% |

| RH | 3% |

| Gestion de la chaîne d’approvisionnement | 3% |

| Industrie manufacturière | 2% |

Soins de santé

L’IA sauve des vies. De l’analyse des images médicales à la recommandation de traitements personnalisés, elle rend les soins de santé plus intelligents, plus rapides et plus accessibles. Les outils de détection précoce sont déjà plus performants que les méthodes traditionnelles, aidant les médecins à détecter les problèmes avant qu’ils ne s’aggravent.

Vente au détail

L’IA générative permet des campagnes de marketing hyperpersonnalisées, tandis que les modèles d’inventaire prédictifs réduisent le gaspillage en alignant plus précisément les chaînes d’approvisionnement sur les schémas de la demande. Les détaillants qui adoptent ces technologies font état de gains significatifs en termes d’efficacité opérationnelle. Selon McKinsey, l’IA générative devrait débloquer une valeur économique de 240 à 390 milliards de dollars pour les détaillants.

L’éducation

Au-delà de l’apprentissage adaptatif, l’IA renforce désormais les méthodes d’enseignement. Par exemple, les outils d’IA générative aident les éducateurs en créant des programmes d’études sur mesure et des aides pédagogiques interactives, rationalisant ainsi les charges administratives.

Transport et logistique

L’intégration de l’IA aux systèmes IoT a permis une visibilité inégalée des réseaux logistiques, améliorant l’optimisation des itinéraires, la gestion des stocks et l’atténuation des risques pour les chaînes d’approvisionnement mondiales.

Quel est l’avenir ? Tendances de l’IA à surveiller en 2025

Alors, où va l’IA ? Voici les grandes tendances qui façonnent l’avenir :

1. Modèles d’IA auto-améliorants

Les systèmes d’IA qui s’affinent eux-mêmes en temps réel sont en train d’émerger comme une tendance critique. Ces modèles d’auto-amélioration s’appuient sur des boucles d’apprentissage continu, améliorant la précision et la pertinence avec un minimum de supervision humaine. Les cas d’utilisation comprennent la détection des fraudes en temps réel et la cybersécurité adaptative.

2. Les nouvelles frontières des données synthétiques

Les données synthétiques dépassent les applications axées sur la protection de la vie privée pour s’orienter vers des scénarios plus sophistiqués, tels que l’entraînement de l’IA pour les cas limites et la simulation d’événements rares ou dangereux. Des secteurs comme la conduite autonome investissent massivement dans ce domaine afin de modéliser des cas extrêmes à grande échelle.

3. Architectures d’IA spécifiques à un domaine

L’ère de l’IA généralisée cède la place à des architectures spécialisées par domaine. Les développeurs s’attachent à affiner les modèles pour des secteurs verticaux spécifiques tels que la finance, la modélisation climatique et la recherche génomique, afin d’atteindre de nouveaux niveaux de précision et d’efficacité.

4. L’intelligence artificielle à grande échelle

L’IA périphérique traite les données localement sur un appareil au lieu de s’appuyer sur le nuage. Ses capacités en temps réel sont en train de passer d’applications de niche à une adoption généralisée. Les industries tirent parti de l’informatique périphérique pour déployer des modèles d’IA à faible latence dans des environnements à connectivité limitée, qu’il s’agisse d’établissements de santé éloignés ou d’usines de fabrication intelligentes.

5. Écosystèmes d’IA collaboratifs

L’IA est de moins en moins cloisonnée, avec des écosystèmes qui permettent l’interopérabilité entre divers modèles et plateformes. Cela favorise des solutions plus robustes grâce à la collaboration, en particulier dans des environnements multipartites tels que les soins de santé et la planification urbaine.

Les défis à venir

Si l’avenir de l’IA est prometteur, il n’est pas exempt d’obstacles. Voici ce à quoi nous devons nous attaquer :

Réglementation et éthique

La loi sur l’IA de l’Union européenne et les lois californiennes sur la transparence des données ne sont qu’un début. Les développeurs et les décideurs politiques doivent travailler ensemble pour s’assurer que l’IA est utilisée de manière responsable et éthique.

Préjugés et équité

Même si l’interprétation des modèles s’améliore, le risque de biais reste important. Les développeurs doivent donner la priorité à des ensembles de données diversifiés et de haute qualité et intégrer des mesures d’équité dans leurs pipelines afin d’atténuer les conséquences involontaires.

Durabilité

La formation de modèles d’IA massifs consomme beaucoup d ‘énergie. Les innovations en matière de compression de modèles et de matériel à faible consommation d’énergie sont essentielles pour aligner le développement de l’IA sur les objectifs de développement durable.

Regarder vers l’avenir : Comment l’IA façonnera l’avenir

Le potentiel de l’IA pour remodeler les industries et relever les défis mondiaux est immense. Mais quel sera l’impact de l’IA sur notre avenir ? Voici un examen plus approfondi :

Relever les défis mondiaux

Les outils alimentés par l’IA analysent les modèles climatiques, optimisent les sources d’énergie renouvelable et prédisent les catastrophes naturelles avec une plus grande précision. Par exemple, les modèles d’IA peuvent aider les agriculteurs à s’adapter au changement climatique en prédisant les régimes de précipitations et en suggérant des rotations de cultures optimales.

L’IA démocratise l’accès aux soins de santé en permettant des diagnostics et des recommandations de traitement à distance. Dans les régions mal desservies, les outils d’IA agissent comme des prestataires de soins de santé virtuels, comblant ainsi le fossé causé par la pénurie de professionnels de la santé.

Transformer le travail

Alors que l’IA automatisera les tâches répétitives, elle crée également une demande pour des rôles dans l’éthique de l’IA, la formation des systèmes et la collaboration entre l’homme et l’IA. Le lieu de travail devient un partenariat dynamique entre les humains et l’IA, où les tâches nécessitant de l’intuition et de l’empathie sont complétées par la précision et l’échelle de l’IA.

Les rôles professionnels évolueront vers la conservation, la gestion et l’audit des systèmes d’IA plutôt que vers l’exécution directe des tâches.

Lutter contre les menaces à la sécurité

La sophistication de l’IA introduit également des risques. Les cyberattaques alimentées par l’IA et les technologies “deepfake” sont de plus en plus fréquentes. Pour contrer ce phénomène, les modèles prédictifs de menaces et les systèmes de réponse autonomes réduisent déjà les temps de réponse aux violations de plusieurs heures à quelques secondes.

Pour conclure : Êtes-vous prêt pour l’avenir ?

2025 n’est pas une année comme les autres pour l’IA – c’est un point de basculement. Avec des avancées telles que l’IA agentique, les systèmes multimodaux et les données synthétiques qui remodèlent les industries, il incombe aux entrepreneurs et aux développeurs technologiques de naviguer dans ce paysage en évolution avec précision et prévoyance. L’avenir ne se résume pas à l’adoption de l’IA ; il s’agit de façonner sa trajectoire de manière responsable.