![Biggest AI Tool and Model Updates in 2023 [With Features]](https://meetcody.ai/wp-content/uploads/2023/11/All-AI-Tool-and-Model-Updates.png)

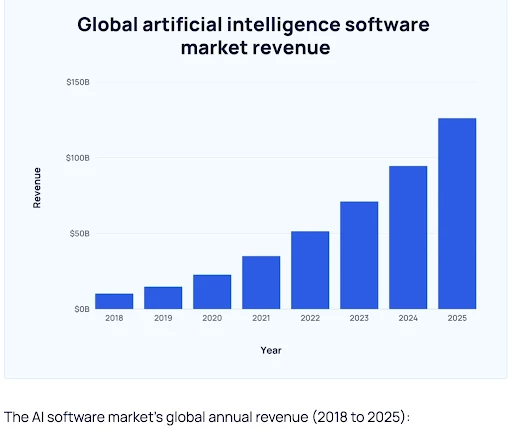

Der KI-Markt ist um

38%

im Jahr 2023, und einer der Hauptgründe dafür ist die große Anzahl von KI-Modellen und -Tools, die von großen Marken eingeführt werden!

Aber warum führen Unternehmen KI-Modelle und -Tools für Unternehmen ein?

PWC

berichtet, wie KI das Mitarbeiterpotenzial bis 2025 um bis zu 40 % steigern kann!

In der folgenden Grafik finden Sie die jährlichen Umsatzprognosen für den KI-Markt (2018-2025).

Mit einer Gesamtzahl von

14.700 Start-ups allein in den Vereinigten Staaten

allein in den USA (Stand März 2023) ist das Geschäftspotenzial der KI zweifellos enorm!

Was sind große Sprachmodelle (LLMs) in der KI?

Große Sprachmodelle (Large Language Models, LLM) sind fortschrittliche KI-Werkzeuge, die durch Sprachverständnis und -generierung eine menschenähnliche Intelligenz simulieren sollen. Diese Modelle arbeiten mit der statistischen Analyse umfangreicher Daten, um zu lernen, wie Wörter und Sätze miteinander verbunden sind.

Als Teilbereich der künstlichen Intelligenz sind LLMs in einer Reihe von Aufgaben versiert, darunter das Erstellen von Texten, das Kategorisieren von Texten, das Beantworten von Fragen im Dialog und das Übersetzen von Sprachen.

Die Bezeichnung “groß” kommt von den umfangreichen Datensätzen, auf denen sie trainiert wurden. Die Grundlage der LLMs liegt im maschinellen Lernen, insbesondere in einem neuronalen Netzwerk, das als Transformatormodell bekannt ist. Dadurch können sie verschiedene Aufgaben der Verarbeitung natürlicher Sprache (NLP) effektiv bewältigen und ihre Vielseitigkeit beim Verstehen und Verarbeiten von Sprache unter Beweis stellen.

Lesen Sie mehr:

RAG (Retrieval-Augmented Generation) vs. LLMs?

Welche sind die Top Open-Source LLMs im Jahr 2023?

Ab September 2023 wird die

Falke 180B

im September 2023 als bestes vortrainiertes Large Language Model auf dem Hugging Face Open LLM Leaderboard und erreichte damit die höchste Leistungsbewertung.

Wir stellen Ihnen die 7 wichtigsten KI-Modelle im Jahr 2023 vor.

1. Falke LLM

Falcon LLM

ist ein leistungsstarkes, vortrainiertes Open Large Language Model, das die Möglichkeiten der KI-Sprachverarbeitung neu definiert hat.

Das Modell hat 180 Milliarden Parameter und wurde mit 3,5 Billionen Token trainiert. Es kann sowohl für kommerzielle als auch für Forschungszwecke verwendet werden.

Im Juni 2023 führte Falcon LLM die Open LLM-Rangliste von HuggingFace an, was ihm den Titel “König der Open-Source-LLMs” einbrachte.

Falcon LLM Merkmale:

- Zeigt gute Leistungen bei Tests zum logischen Denken, zur Beherrschung der Sprache und zur Codierung sowie bei Wissenstests.

- FlashAttention und Multi-Query-Attention für schnellere Inferenz und bessere Skalierbarkeit.

- Erlaubt die kommerzielle Nutzung ohne Lizenzverpflichtungen oder Einschränkungen.

- Die Nutzung der Plattform ist kostenlos.

2. Lama 2

Meta hat veröffentlicht

Llama 2

eine kostenlos verfügbare, vortrainierte Online-Datenquelle. Llama 2 ist die zweite Version von Llama, die doppelt so lang ist und 40% mehr trainiert als ihr Vorgänger.

Llama 2 bietet auch einen Leitfaden zur verantwortungsvollen Nutzung, der dem Benutzer hilft, die besten Praktiken und die Sicherheitsbewertung zu verstehen.

Llama 2 Merkmale:

- Llama 2 ist sowohl für die Forschung als auch für die kommerzielle Nutzung kostenlos erhältlich.

- Enthält Modellgewichte und Startcode sowohl für die vortrainierte als auch für die auf Konversation getrimmte Version.

- Erreichbar über verschiedene Anbieter, darunter Amazon Web Services (AWS) und Hugging Face.

- eine Richtlinie zur akzeptablen Nutzung einführt, um eine ethische und verantwortungsvolle Nutzung zu gewährleisten.

3. Claude 2.0 und 2.1

Claude 2 war ein fortschrittliches Sprachmodell, das von Anthropic entwickelt wurde. Das Modell zeichnet sich durch verbesserte Leistung, längere Antwortzeiten und Zugänglichkeit über eine API und eine neue öffentliche Beta-Website, claude.ai, aus.

Nach ChatGPT bietet dieses Modell ein größeres Kontextfenster und gilt als einer der effizientesten Chatbots.

Claude 2 Merkmale:

- Bietet im Vergleich zu seinem Vorgänger eine verbesserte Leistung und längere Reaktionszeiten.

- Ermöglicht Nutzern die Interaktion mit Claude 2 sowohl über den API-Zugang als auch über eine neue öffentliche Beta-Website, claude.ai

- Zeigt im Vergleich zu den Vorgängermodellen ein längeres Gedächtnis.

- Nutzt Sicherheitstechniken und umfassendes Red-Teaming, um anstößige oder gefährliche Ergebnisse zu entschärfen.

Kostenlose Version: Verfügbar unter

Die Preise: $20/Monat

Das

Modell Claude 2.1

die am 21. November 2023 eingeführt wird, bringt bemerkenswerte Verbesserungen für Unternehmensanwendungen. Sie bietet ein modernes 200K-Token-Kontextfenster, reduziert die Anzahl der Modellhalluzinationen erheblich, verbessert die Systemaufforderungen und führt eine neue Beta-Funktion ein, die sich auf die Verwendung von Werkzeugen konzentriert.

Claude 2.1 bringt nicht nur Verbesserungen bei den wichtigsten Funktionen für Unternehmen, sondern verdoppelt auch die Menge der Informationen, die an das System übermittelt werden können, mit einer neuen Grenze von 200.000 Token.

Dies entspricht etwa 150.000 Wörtern oder über 500 Seiten Inhalt. Die Nutzer können nun umfangreiche technische Dokumentationen hochladen, darunter vollständige Codebasen, umfassende Finanzberichte wie S-1-Formulare oder lange literarische Werke wie “Die Ilias” oder “Die Odyssee”.

Mit der Fähigkeit, große Mengen an Inhalten oder Daten zu verarbeiten und mit ihnen zu interagieren, kann Claude unter anderem Informationen effizient zusammenfassen, Frage-und-Antwort-Sitzungen durchführen, Trends vorhersagen und mehrere Dokumente vergleichen und gegenüberstellen.

Claude 2.1 Merkmale:

- 2x Rückgang der Halluzinationsraten

- Verwendung von API-Tools

- Bessere Erfahrung für Entwickler

Preisgestaltung: TBA

4. MPT-7B

MPT-7B steht für MosaicML Pretrained Transformer, der von Grund auf auf 1 Billion Token von Texten und Codes trainiert wurde. Wie GPT funktioniert MPT auch bei reinen Decoder-Transformatoren, allerdings mit einigen Verbesserungen.

Die Kosten belaufen sich auf 200.000 $,

MPT-7B

auf der MosaicML-Plattform in 9,5 Tagen ohne menschliches Zutun trainiert.

Merkmale:

- Erzeugt Dialoge für verschiedene Konversationsaufgaben.

- Gut gerüstet für nahtlose, fesselnde Multiturn-Interaktionen.

- Umfasst Datenvorbereitung, Schulung, Feinabstimmung und Bereitstellung.

- Kann extrem lange Eingaben verarbeiten, ohne den Kontext zu verlieren.

- Kostenlos erhältlich.

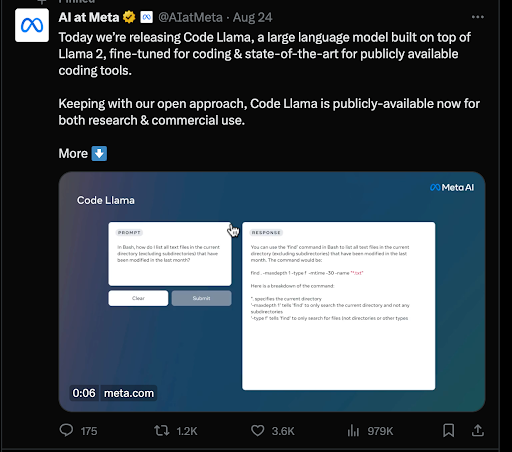

5. CodeLIama

Code Llama ist ein großes Sprachmodell (LLM), das speziell für die Generierung und Diskussion von Code auf der Grundlage von Textaufforderungen entwickelt wurde. Es stellt den neuesten Stand der Entwicklung unter den öffentlich verfügbaren LLMs für Codierungsaufgaben dar.

Laut dem

Metas Nachrichten-Blog

zielt Code Llama darauf ab, die Evaluierung offener Modelle zu unterstützen und es der Gemeinschaft zu ermöglichen, Fähigkeiten zu bewerten, Probleme zu identifizieren und Schwachstellen zu beheben.

CodeLIama Merkmale:

- Senkt die Einstiegshürde für Lernende im Bereich Codierung.

- Dient als Produktivitäts- und Lernwerkzeug für das Schreiben robuster, gut dokumentierter Software.

- Kompatibel mit gängigen Programmiersprachen, darunter Python, C++, Java, PHP, Typescript (Javascript), C#, Bash und anderen.

- Drei verfügbare Größen mit 7B, 13B und 34B Parametern, jeweils trainiert mit 500B Token Code und codebezogenen Daten.

- Kann zum Nulltarif eingesetzt werden.

6. Mistral-7B AI-Modell

Mistral 7B ist ein großes Sprachmodell, das vom Mistral-KI-Team entwickelt wurde. Es handelt sich um ein Sprachmodell mit 7,3 Milliarden Parametern, was auf seine Fähigkeit hinweist, komplexe Sprachmuster zu verstehen und zu erzeugen.

Der Mistral -7B behauptet außerdem, das

beste 7B-Modell aller Zeiten

und übertrifft Llama 2 13B in mehreren Benchmarks, was seine Effektivität beim Sprachenlernen beweist.

Mistral-7B Merkmale:

- Verwendet Grouped-Query-Attention (GQA) für schnellere Schlussfolgerungen und verbessert die Effizienz der Verarbeitung von Abfragen.

- Implementiert Sliding Window Attention (SWA), um längere Sequenzen mit geringerem Rechenaufwand zu verarbeiten.

- Einfache Feinabstimmung für verschiedene Aufgaben, was die Anpassungsfähigkeit an unterschiedliche Anwendungen beweist.

- Die Nutzung ist kostenlos.

7. ChatGLM2-6B

ChatGLM2-6B

ist die zweite Version des zweisprachigen (chinesisch-englischen) Open-Source-Chatmodells ChatGLM-6B. Es wurde von Forschern der Tsinghua-Universität, China, als Antwort auf die Nachfrage nach leichtgewichtigen Alternativen zu ChatGPT entwickelt.

ChatGLM2-6B Merkmale:

- Trainiert auf über 1 Billion Token in Englisch und Chinesisch.

- Vorgeprüft auf über 1,4 Billionen Token für ein besseres Sprachverständnis.

- Unterstützt längere Kontexte, erweitert von 2K auf 32K.

- Übertrifft konkurrierende Modelle ähnlicher Größe bei verschiedenen Datensätzen (MMLU, CEval, BBH).

Kostenlose Version: Verfügbar unter

Preisgestaltung: Auf Anfrage

Was sind AI-Tools?

KI-Tools sind Softwareanwendungen, die Algorithmen der künstlichen Intelligenz nutzen, um bestimmte Aufgaben auszuführen und komplexe Probleme zu lösen. Diese Tools finden in verschiedenen Branchen Anwendung, z. B. im Gesundheitswesen, im Finanzwesen, im Marketing und im Bildungswesen, wo sie Aufgaben automatisieren, Daten analysieren und bei der Entscheidungsfindung helfen.

Zu den Vorteilen von KI-Tools gehören die Effizienz bei der Rationalisierung von Prozessen, die Zeitersparnis, die Verringerung von Verzerrungen und die Automatisierung sich wiederholender Aufgaben.

Allerdings gibt es auch Herausforderungen wie die kostspielige Umsetzung, die mögliche Verlagerung von Arbeitsplätzen und das Fehlen emotionaler und kreativer Fähigkeiten. Um diese Nachteile abzumildern, liegt der Schlüssel in der Auswahl der richtigen KI-Tools.

Welches sind die besten KI-Tools im Jahr 2023?

Durch eine durchdachte Auswahl und strategische Implementierung von KI-Tools können die Kosten gesenkt werden, indem man sich auf diejenigen konzentriert, die den größten Nutzen für bestimmte Anforderungen bieten. Eine sorgfältige Auswahl und Integration von KI-Tools kann Ihrem Unternehmen helfen, die Vorteile von KI-Tools zu nutzen und gleichzeitig die Herausforderungen zu minimieren, was zu einer ausgewogenen und effektiven Nutzung der Technologie führt.

Hier sind die 13 wichtigsten KI-Tools im Jahr 2023 –

1. Öffnen Sie AI’s Chat GPT

Chat GPT ist ein KI-Modell für die Verarbeitung natürlicher Sprache, das menschenähnliche Antworten in Gesprächen liefert. Es kann eine einfache Frage wie “Wie backt man einen Kuchen?” beantworten und fortgeschrittene Codes schreiben. Es kann Aufsätze, Beiträge für soziale Medien, E-Mails, Codes usw. erstellen.

Mit diesem Bot können Sie neue Konzepte auf einfachste Weise lernen.

Dieser KI-Chatbot wurde von Open AI, einem Unternehmen für Forschung und künstliche Intelligenz, entwickelt und im November 2022 auf den Markt gebracht und erregte schnell großes Aufsehen bei den Internetnutzern.

Merkmale:

- Die KI scheint ein Chatbot zu sein, was sie benutzerfreundlich macht.

- Sie verfügt über Fachwissen zu einer Vielzahl von Themen.

- Sie ist mehrsprachig und umfasst mehr als 50 Sprachen.

- Die GPT 3-Version ist kostenlos.

Kostenlose Version: Verfügbar unter

Preisgestaltung:

- Chat GPT-3: Kostenlos

- Chat GPT Plus: 20$/Monat

Rahul Shyokand

, Mitbegründer von

Wilyer:

Wir haben ChatGPT kürzlich verwendet, um die von Unternehmenskunden am meisten gewünschte Funktion unserer Android-App zu implementieren. Wir mussten diese Funktion entwickeln, damit wir für unsere Kunden als SaaS relevant sind. Mit ChatGPT waren wir in der Lage, eine komplexe mathematische und logische JAVA-Funktion zu befehlen, die unsere Anforderungen genau erfüllte. In weniger als einer Woche konnten wir die Funktion für unsere Unternehmenskunden bereitstellen, indem wir den JAVA-Code modifizierten und anpassten. Als wir diese Funktion einführten, konnten wir sofort einen Anstieg von 25-30 % bei unseren B2B-SaaS-Abonnements und -Umsätzen verzeichnen.

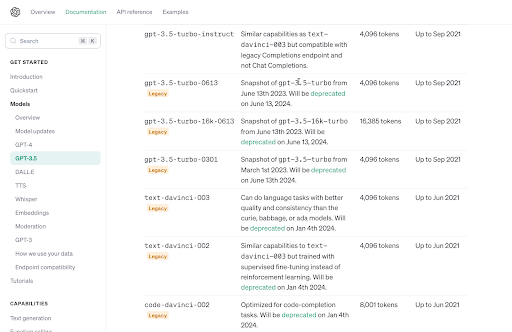

2. GPT-4 Turbo 128K-Kontext

GPT-4 Turbo 128K-Kontext

wurde als eine verbesserte und erweiterte Version von GPT 3.5 veröffentlicht. Mit einem 128K-Kontextfenster können Sie viel mehr benutzerdefinierte Daten für Ihre Anwendungen mit Techniken wie RAG (Retrieval Augmented Generation) erhalten.

Merkmale:

- Ermöglicht erweiterte Funktionsaufrufe auf der Grundlage von Benutzereingaben in natürlicher Sprache.

- Interoperabilität mit Softwaresystemen im JSON-Modus.

- Bietet eine reproduzierbare Ausgabe mit Seed-Parameter.

- Verlängert die Frist für die Kenntnisnahme um neunzehn Monate bis April 2023.

Freie Version: Nicht verfügbar

Preisgestaltung:

- Eingabe: 0,01 $/1000 Token

- Ausgabe: 0,3 $/1000 Token

3. Chat GPT4 Vision

Open AI hat die multimodale

GPT-4 Vision

im März 2023. Diese Version ist eine der instrumentalsten Versionen von Chat GPT, da sie verschiedene Arten von Text- und Bildformaten verarbeiten kann. Das GPT-4 verfügt über fortschrittliche Bild- und Voiceover-Funktionen, die verschiedene Innovationen und Anwendungsfälle ermöglichen.

Die generative KI von ChatGPT-4 wurde mit 100 Billionen Parametern trainiert, was dem 500-fachen der ChatGPT-3-Version entspricht.

Merkmale:

- Versteht visuellen Input wie Fotos, Dokumente, handschriftliche Notizen und Screenshots.

- Erkennt und analysiert Objekte und Figuren auf der Grundlage von Bildmaterial, das als Eingabe hochgeladen wurde.

- Bietet Datenanalyse in visuellen Formaten wie Diagrammen, Tabellen usw.

- Bietet 3x kostengünstiges Modell

- Gibt 4096 Ausgabe-Token zurück

Freie Version: Nicht verfügbar

Preisgestaltung: Zahlen Sie für das, was Sie nutzen Modell

4. GPT 3.5 Turbo Instruct

GPT 3.5 Turbo Instruct wurde veröffentlicht, um die wiederkehrenden Probleme in der GPT-3-Version zu entschärfen. Zu diesen Problemen gehörten ungenaue Informationen, veraltete Fakten usw.

Daher wurde die Version 3.5 speziell dafür entwickelt, logische, kontextuell korrekte und direkte Antworten auf Benutzeranfragen zu geben.

Merkmale:

- Versteht Anweisungen und führt sie effizient aus.

- Produziert prägnanter und punktgenauer mit wenigen Token.

- Bietet schnellere und präzisere Antworten, die auf die Bedürfnisse der Nutzer zugeschnitten sind.

- Die Betonung liegt auf dem logischen Denken und nicht auf dem Auswendiglernen.

Freie Version: Nicht verfügbar

Preisgestaltung:

- Eingabe: $0,0015/1000 Token

- Ausgabe: $0,0020/1000 Token

5. Microsoft Copilot AI-Werkzeug

Kopilot 365 ist ein vollwertiges KI-Tool, das mit Microsoft Office zusammenarbeitet. Mit dieser KI können Sie Dokumente erstellen, E-Mails lesen, zusammenfassen und beantworten, Präsentationen erstellen und vieles mehr. Es wurde speziell entwickelt, um die Produktivität der Mitarbeiter zu steigern und den Arbeitsablauf zu optimieren.

Merkmale:

- Fasst Dokumente und lange E-Mail-Ketten zusammen.

- Erstellt und fasst Präsentationen zusammen.

- Analysiert Excel-Tabellen und erstellt Diagramme zur Darstellung von Daten.

- Bereinigen Sie den Outlook-Posteingang schneller.

- Schreiben Sie E-Mails auf der Grundlage der bereitgestellten Informationen.

Kostenlose Version: 30 Tage kostenlose Testversion

Preisgestaltung: 30$/Monat

6. Der generative KI-Assistent von SAP: Joule

Joule ist ein generativer

KI-Assistent von SAP

der in SAP-Anwendungen eingebettet ist, darunter HR, Finanzen, Lieferkette, Beschaffung und Kundenerfahrung.

Mit dieser KI-Technologie erhalten Sie schnelle Antworten und aufschlussreiche Erkenntnisse, wann immer Sie sie benötigen, und können so ohne Verzögerungen schnellere Entscheidungen treffen.

Merkmale:

- Hilft beim Verstehen und Verbessern der Verkaufsleistung, identifiziert Probleme und schlägt Lösungen vor.

- Ermöglicht die kontinuierliche Bereitstellung neuer Szenarien für alle SAP-Lösungen.

- Unterstützt die Personalabteilung bei der Erstellung unvoreingenommener Stellenbeschreibungen und relevanter Interviewfragen.

- Verändert die SAP-Benutzererfahrung durch die Bereitstellung intelligenter Antworten auf Anfragen in einfacher Sprache.

Kostenlose Version: Verfügbar unter

Preisgestaltung: Auf Anfrage

7. AI Studio von Meta

AI Studio von Meta wurde mit der Vision entwickelt, die Interaktion zwischen Unternehmen und ihren Kunden zu verbessern. Sie ermöglicht es Unternehmen, benutzerdefinierte KI-Chatbots für die Interaktion mit Kunden über Messaging-Dienste auf verschiedenen Plattformen, darunter Instagram, Facebook und Messenger, zu erstellen.

Das primäre Anwendungsszenario für AI Studio ist der Bereich E-Commerce und Kundensupport.

Merkmale:

- Fasst Dokumente und lange E-Mail-Ketten zusammen.

- Erstellt und fasst Präsentationen zusammen.

- Analysiert Excel-Tabellen und erstellt Diagramme zur Darstellung von Daten.

- Bereinigen Sie den Outlook-Posteingang schneller.

- Schreiben Sie E-Mails auf der Grundlage der bereitgestellten Informationen.

Kostenlose Version: 30 Tage kostenlos testen

Preisgestaltung: 30$/Monat

8. Das AI-Tool von EY

EY AI integriert menschliche Fähigkeiten mit künstlicher Intelligenz (KI), um die vertrauensvolle und verantwortungsvolle Übernahme von KI durch Unternehmen zu erleichtern. Es nutzt die umfassende Geschäftserfahrung, das Branchenwissen und die fortschrittlichen Technologieplattformen von EY, um transformative Lösungen zu liefern.

Merkmale:

- Nutzt seine Erfahrung in verschiedenen Bereichen, um KI-Lösungen und Einblicke zu liefern, die auf spezifische Geschäftsanforderungen zugeschnitten sind.

- Sorgt für die nahtlose Integration modernster KI-Funktionen in umfassende Lösungen durch EY Fabric.

- Einbindung von KI-Funktionen mit Geschwindigkeit und Skalierung durch EY Fabric.

Kostenlose Version: Kostenlos für EY-Mitarbeiter

Preisgestaltung: Auf Anfrage

9. Amazons generatives KI-Tool für Verkäufer

Amazon hat kürzlich eine

KI für Amazon-Verkäufer

die sie bei verschiedenen produktbezogenen Funktionen unterstützen. Es vereinfacht das Schreiben von Produkttiteln, Aufzählungspunkten, Beschreibungen, Angebotsdetails usw.

Diese KI zielt darauf ab, mit minimalem Zeit- und Arbeitsaufwand hochwertige Angebote und ansprechende Produktinformationen für Verkäufer zu erstellen.

Merkmale:

- Erstellt aussagekräftige Produkttitel, Aufzählungspunkte und Beschreibungen für Verkäufer.

- Finden Sie Engpässe in der Produktion durch automatische Überwachung.

- Erzeugt automatisierte Chatbots zur Verbesserung der Kundenzufriedenheit.

- Generiert durchgängige Vorhersagemodelle unter Verwendung von Zeitreihen und Datentypen.

Kostenlose Version: Kostenlose Testversion verfügbar

Preisgestaltung: Auf Anfrage

10. Adobes generatives KI-Tool für Designer

Die generative KI von Adobe for Designers zielt darauf ab, den kreativen Prozess von Designern zu verbessern. Mit diesem Tool können Sie innerhalb von Sekunden nahtlos Grafiken mit Eingabeaufforderungen erstellen, Bilder erweitern, Elemente innerhalb von Bildern verschieben usw.

Die KI zielt darauf ab, die natürliche Kreativität von Designern zu erweitern und zu unterstützen, indem sie es ihnen ermöglicht, alles in einem Bild zu verschieben, hinzuzufügen, zu ersetzen oder zu entfernen.

Merkmale:

- Konvertieren Sie Textaufforderungen in Bilder.

- Bietet einen Pinsel zum Entfernen von Objekten oder zum Einfügen neuer Objekte.

- Bietet einzigartige Texteffekte.

- Konvertieren Sie 3D-Elemente in Bilder.

- Verschiebt die Objekte im Bild.

Kostenlose Version: Verfügbar unter

Preisgestaltung: 4,99 $/Monat

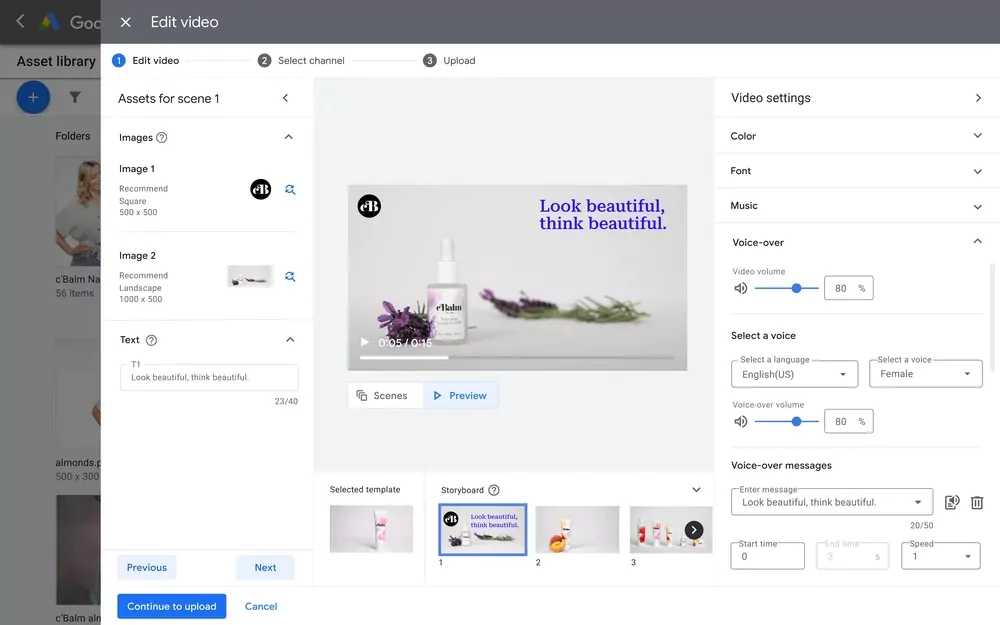

11. Googles KI-Tool Creative Guidance

Google hat ein neues KI-Produkt für die Anzeigenoptimierung unter der Option Video Analytics eingeführt.

Kreative Anleitung AI

. Dieses Tool analysiert Ihre Werbevideos und bietet Ihnen aufschlussreiches Feedback auf der Grundlage der bewährten Verfahren und Anforderungen von Google.

Außerdem wird kein Video für Sie erstellt, sondern Sie erhalten wertvolles Feedback zur Optimierung des vorhandenen Videos.

Merkmale:

- Prüfen Sie, ob das Markenlogo innerhalb von 5 Sekunden des Videos gezeigt wird.

- Analysieren Sie die Videolänge anhand der Marketingziele.

- Scannt hochwertige Voiceovers.

- Analyse des Seitenverhältnisses des Videos.

Freie Version: Kostenlos

Preisgestaltung: Auf Anfrage

12. Grok: Das generative KI-Werkzeug der nächsten Generation

Grok AI ist ein großes Sprachmodul, das von xAI, dem KI-Startup von Elon Musk, entwickelt wurde. Das Tool wurde mit 33 Milliarden Parametern trainiert, vergleichbar mit LLaMA 2 von Meta mit 70 Milliarden Parametern.

In der Tat, laut

dem jüngsten Bericht von The Indian Express

übertrifft Gork-1 die Klausel 2 und GPT 3.5, aber immer noch nicht GPT 4.

Merkmale:

- Extrahiert Echtzeitinformationen von der X-Plattform (früher Twitter).

- Bringt Humor und Sarkasmus in seine Reaktion auf Interaktionen mit ein,

- Sie sind in der Lage, “pikante Fragen” zu beantworten, die viele KI ablehnen.

Kostenlose Version: 30 Tage kostenlose Testversion

Die Preise: $16/Monat

Suchen Sie nach Produktivität? Hier sind 10 einzigartige KI-Tools, die Sie kennen sollten!

Große Sprachmodelle (LLMs) vs. KI-Tools: Was ist der Unterschied?

LLMs sind zwar eine spezialisierte Untergruppe der generativen KI, aber nicht alle generativen KI-Tools basieren auf LLM-Frameworks. Generative KI umfasst ein breiteres Spektrum von KI-Technologien, die in der Lage sind, originäre Inhalte in verschiedenen Formen zu erstellen, sei es Text, Bilder, Musik oder anderes. Diese Tools stützen sich auf zugrunde liegende KI-Modelle, einschließlich LLMs, um diese Inhalte zu generieren.

LLMs hingegen sind speziell für sprachbasierte Aufgaben konzipiert. Sie nutzen Deep Learning und neuronale Netze, um menschenähnliche Texte zu verstehen, zu interpretieren und zu erstellen. Ihr Schwerpunkt liegt in erster Linie auf der Sprachverarbeitung, so dass sie Aufgaben wie Texterstellung, Übersetzung und Beantwortung von Fragen gut bewältigen können.

Der Hauptunterschied liegt in ihrem Geltungsbereich und ihrer Anwendung: Generative KI ist eine weit gefasste Kategorie für jede KI, die originäre Inhalte in verschiedenen Bereichen erstellt, während LLMs eine spezielle Art generativer KI sind, die sich auf sprachbezogene Aufgaben spezialisiert. Diese Unterscheidung ist entscheidend für das Verständnis ihrer jeweiligen Rollen und Fähigkeiten innerhalb der KI-Landschaft.

David Watkins

Direktor für Produktmanagement bei

Ethos

–Bei EthOS haben wir mit der Integration von KI in unsere Plattform sehr gute Erfahrungen gemacht. Mithilfe der Stimmungs- und Tonwertanalyse von IBM Watson können wir in kürzester Zeit die Stimmung und Emotionen der Kunden für neue Website-Designs, Produkttests zu Hause und viele andere qualitative Forschungsstudien erfassen.

13. Versuchen Sie Cody, das Geschäft zu vereinfachen!

Cody ist eine leicht zugängliche No-Code-Lösung für die Erstellung von Chatbots unter Verwendung der fortschrittlichen GPT-Modelle von OpenAI, insbesondere 3.5 turbo und 4. Dieses Tool ist so konzipiert, dass es einfach zu bedienen ist und keine technischen Kenntnisse erfordert, so dass es für eine Vielzahl von Benutzern geeignet ist. Geben Sie einfach Ihre Daten in Cody ein, und Cody erledigt den Rest effizient und problemlos.

Ein herausragendes Merkmal von Cody ist seine Unabhängigkeit von bestimmten Modellversionen, so dass die Benutzer mit den neuesten LLM-Updates auf dem Laufenden bleiben können, ohne ihre Bots umschulen zu müssen. Außerdem enthält es eine anpassbare Wissensdatenbank, die ständig weiterentwickelt wird, um seine Fähigkeiten zu verbessern.

Cody ist ideal für das Prototyping in Unternehmen und zeigt das Potenzial von GPT-Modellen auf, ohne die Komplexität der Erstellung eines KI-Modells von Grund auf. Obwohl es in der Lage ist, die Daten Ihres Unternehmens in verschiedenen Formaten für das personalisierte Modelltraining zu verwenden, wird empfohlen, nicht sensible, öffentlich zugängliche Daten zu nutzen, um den Datenschutz und die Integrität zu wahren.

Für Unternehmen, die ein robustes GPT-Ökosystem suchen, bietet Cody Lösungen auf Unternehmensniveau. Seine KI-API ermöglicht die nahtlose Integration in verschiedene Anwendungen und Dienste und bietet Funktionen wie Bot-Management, Nachrichtenversand und Gesprächsverfolgung.

Darüber hinaus kann Cody in Plattformen integriert werden wie

Slack

,

Discord

und

Zapier

und ermöglicht es

Ihren Bot mit anderen zu teilen

. Es bietet eine Reihe von Anpassungsoptionen, einschließlich Modellauswahl, Bot-Persönlichkeit, Konfidenzniveau und Datenquellenreferenz, so dass Sie einen Chatbot erstellen können, der Ihren spezifischen Anforderungen entspricht.

Die Mischung aus Benutzerfreundlichkeit und Anpassungsoptionen macht Cody zu einer ausgezeichneten Wahl für Unternehmen, die die GPT-Technologie nutzen wollen, ohne sich in die Entwicklung komplexer KI-Modelle zu vertiefen.

Weiter geht’s zur

einfachsten AI-Anmeldung aller Zeiten

!