Im Jahr 2025 wird künstliche Intelligenz (KI) die Industrie, die Gesellschaft und die Art und Weise, wie wir mit Technologie interagieren, auf aufregende und manchmal überraschende Weise umgestalten. Von KI-Agenten, die unabhängig arbeiten können, bis hin zu Systemen, die Text, Video und Audio nahtlos integrieren, entwickelt sich das Feld schneller als je zuvor. Für Tech-Unternehmer und -Entwickler ist es nicht nur klug, sondern unerlässlich, diesen Veränderungen voraus zu sein.

Lassen Sie uns die Trends, Durchbrüche und Herausforderungen verstehen, die KI im Jahr 2025 und darüber hinaus prägen werden.

Ein kurzer Blick zurück: Wie KI unsere Welt verändert hat

Die Entwicklung der KI von den 1950er Jahren bis heute ist eine bemerkenswerte Geschichte der Evolution. Von einfachen, regelbasierten Systemen hat sie sich zu hochentwickelten Modellen entwickelt, die zu logischem Denken, Kreativität und Autonomie fähig sind. In den letzten zehn Jahren hat sich die KI von einem experimentellen zu einem unverzichtbaren Motor für Innovationen in allen Branchen entwickelt.

Gesundheitswesen

KI-gestützte Werkzeuge sind heute fester Bestandteil der Diagnostik, der personalisierten Medizin und sogar der chirurgischen Robotik. Technologien wie die KI-gestützte Bildgebung haben die Grenzen der Krankheitsfrüherkennung verschoben und übertreffen die menschlichen Fähigkeiten in Bezug auf Genauigkeit und Geschwindigkeit.

Bildung

Adaptive KI-Plattformen haben die Art und Weise, wie Studenten lernen, grundlegend verändert. Sie nutzen eine detaillierte Datenanalyse, um Inhalt, Tempo und Engagement auf individueller Ebene anzupassen.

Transport

Autonome Systeme haben sich von experimentellen Prototypen zu praktikablen Lösungen in der Logistik und im öffentlichen Verkehr entwickelt, unterstützt von Fortschritten bei der Sensorfusion, dem Computerbild und der Entscheidungsfindung in Echtzeit.

Während diese Fortschritte einen unbestreitbaren Nutzen gebracht haben, haben sie auch komplexe Fragen zu Ethik, Auswirkungen auf die Belegschaft und die gerechte Verteilung der Vorteile der KI aufgeworfen. Die Bewältigung dieser Herausforderungen bleibt eine Priorität, während sich die KI weiter ausbreitet.

Spielverändernde KI-Technologien im Jahr 2025

Im Jahr 2025 geht es nicht nur darum, KI intelligenter zu machen, sondern auch darum, sie leistungsfähiger, skalierbarer und ethischer zu machen. Hier sehen Sie, was die Landschaft prägen wird:

1. Agentische KI: Jenseits der Aufgabenautomatisierung

Agentische KI ist nicht nur ein weiteres Modewort. Diese Systeme können Entscheidungen treffen und sich an Situationen anpassen, ohne dass ein Mensch eingreifen muss. Wie wäre es mit einer KI, die Ihren Zeitplan verwaltet, Projekte abwickelt oder sogar kreative Ideen entwickelt? Das ist so, als ob Sie ein super effizientes Teammitglied hätten, das niemals schläft.

- Für Unternehmen: Denken Sie an virtuelle Projektmanager, die komplexe Arbeitsabläufe verwalten.

- Für Kreative: Tools, die Ihnen beim Brainstorming oder bei der Bearbeitung von Inhalten helfen.

Wie Moody’s hervorhebt, ist die agentenbasierte KI in der Lage, eine treibende Kraft für Produktivität und Innovation in allen Branchen zu werden.

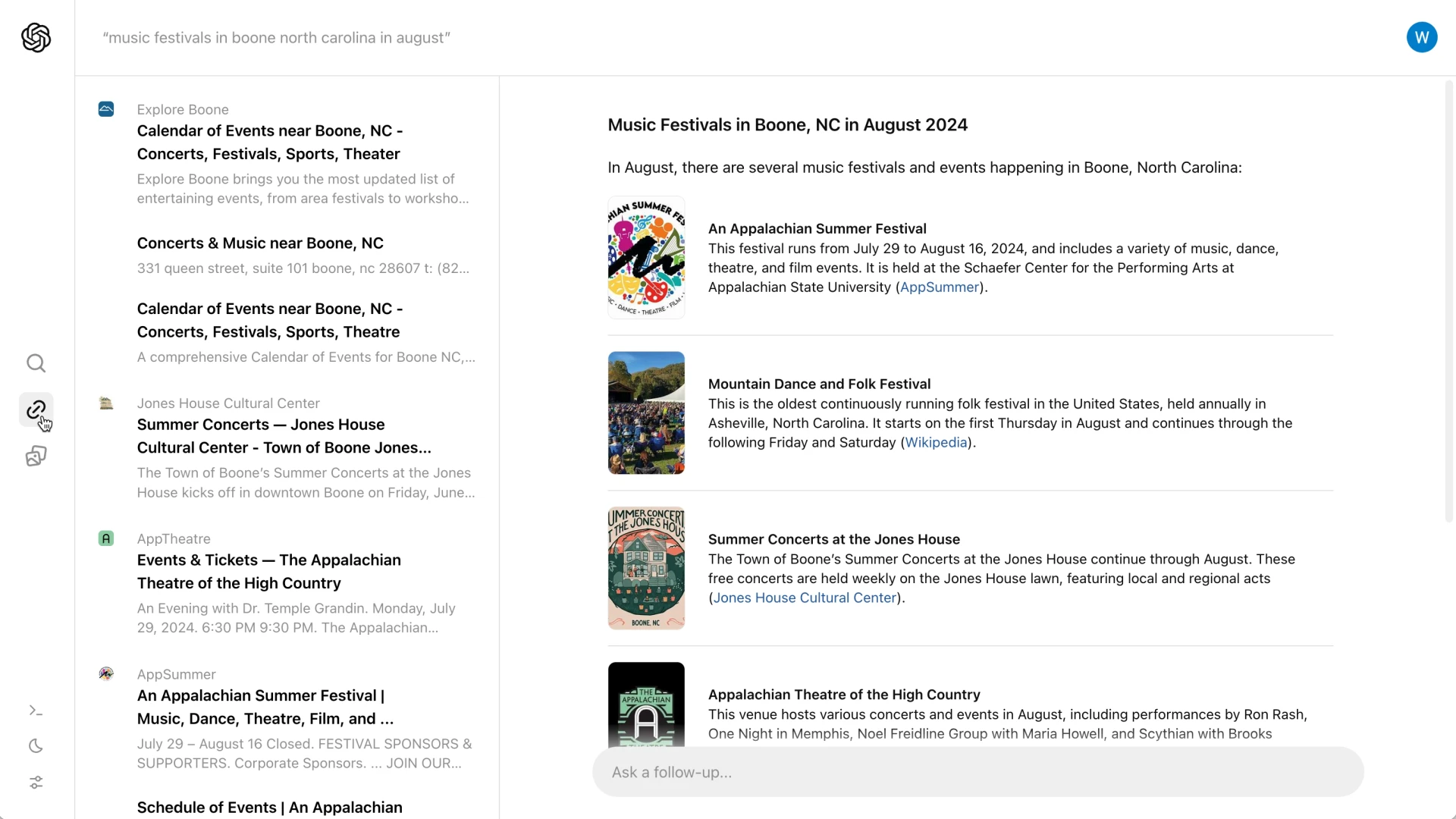

2. Multimodale KI: Der ultimative Alleskönner

Diese Technologie führt Text, Bilder, Audio und Video in einem nahtlosen System zusammen. Deshalb werden zukünftige virtuelle Assistenten nicht nur verstehen, was Sie sagen, sondern auch Ihren Tonfall, Ihre Mimik und sogar den Kontext Ihrer Umgebung erfassen.

Hier sind ein paar Beispiele:

- Gesundheitswesen: Multimodale Systeme könnten medizinische Daten aus verschiedenen Quellen analysieren, um schnellere und genauere Diagnosen zu stellen.

- Alltag: Stellen Sie sich einen Assistenten vor, der Ihnen bei der Planung einer Reise helfen kann, indem er Bewertungen, Fotos und Videos sofort analysiert.

Gartner prognostiziert, dass bis 2027 40% der generativen KI-Lösungen multimodal sein werden, gegenüber nur 1% im Jahr 2023.

3. Synthetische Daten: Die datenschutzfreundliche Lösung

KI-Systeme brauchen Daten, um zu lernen, aber reale Daten sind oft mit Datenschutzbedenken oder Problemen bei der Verfügbarkeit verbunden. Hier kommen synthetische Daten ins Spiel – künstlich erzeugte Datensätze, die die realen Daten imitieren, ohne sensible Informationen preiszugeben.

So könnte sich das abspielen:

Skalierbare Innovation: Vom Training autonomer Fahrzeuge in simulierten Umgebungen bis zur Generierung seltener medizinischer Daten für die Pharmaforschung.

Governance-Erfordernisse: Entwickler integrieren zunehmend prüfungsfreundliche Systeme, um Transparenz, Rechenschaftspflicht und die Anpassung an regulatorische Standards zu gewährleisten.

Synthetische Daten sind eine Win-Win-Situation, denn sie helfen Entwicklern, schneller zu innovieren und gleichzeitig die Privatsphäre zu respektieren.

Branchen, die KI gerade verändert

Die KI schlägt in diesen Schlüsselsektoren bereits Wellen:

| Industrie | Anteil der Befragten mit regelmäßiger Nutzung von Gen AI innerhalb ihrer organisatorischen Aufgaben(Quelle) |

| Marketing und Verkauf | 14% |

| Entwicklung von Produkten und/oder Dienstleistungen | 13% |

| Serviceleistungen | 10% |

| Risikomanagement | 4% |

| Strategie und Unternehmensfinanzierung | 4% |

| HR | 3% |

| Management der Lieferkette | 3% |

| Herstellung | 2% |

Gesundheitswesen

KI rettet Leben. Von der Analyse medizinischer Bilder bis hin zur Empfehlung personalisierter Behandlungen macht sie die Gesundheitsversorgung intelligenter, schneller und leichter zugänglich. Tools zur Früherkennung übertreffen bereits die traditionellen Methoden und helfen Ärzten, Probleme zu erkennen, bevor sie eskalieren.

Einzelhandel

Generative KI ermöglicht hyper-personalisierte Marketingkampagnen, während prädiktive Bestandsmodelle die Verschwendung reduzieren, indem sie die Lieferketten präziser auf die Nachfragemuster abstimmen. Einzelhändler, die diese Technologien einsetzen, berichten von erheblichen Steigerungen der betrieblichen Effizienz. Laut McKinsey wird generative KI für den Einzelhandel einen wirtschaftlichen Wert von 240 bis 390 Milliarden Dollar freisetzen.

Bildung

Über das adaptive Lernen hinaus erweitert die KI jetzt auch die Lehrmethoden. So helfen generative KI-Tools den Lehrkräften bei der Erstellung maßgeschneiderter Lehrpläne und interaktiver Lehrmittel und verringern so den Verwaltungsaufwand.

Transport & Logistik

Die Integration von KI in IoT-Systeme hat einen beispiellosen Einblick in Logistiknetzwerke ermöglicht und damit die Routenoptimierung, das Bestandsmanagement und die Risikominimierung für globale Lieferketten verbessert.

Was kommt als Nächstes? KI-Trends im Jahr 2025

Wohin steuert die KI also? Hier sind die großen Trends, die die Zukunft bestimmen:

1. Selbstverbessernde KI-Modelle

KI-Systeme, die sich selbst in Echtzeit verbessern, entwickeln sich zu einem wichtigen Trend. Diese sich selbst verbessernden Modelle nutzen kontinuierliche Lernschleifen und verbessern die Genauigkeit und Relevanz mit minimaler menschlicher Aufsicht. Zu den Anwendungsfällen gehören Betrugserkennung in Echtzeit und adaptive Cybersicherheit.

2. Die neuen Grenzen der synthetischen Daten

Synthetische Daten gehen über datenschutzbezogene Anwendungen hinaus und führen zu anspruchsvolleren Szenarien, wie dem Training von KI für Grenzfälle und der Simulation seltener oder gefährlicher Ereignisse. Branchen wie das autonome Fahren investieren stark in diesen Bereich, um Eckfälle in großem Umfang zu modellieren.

3. Domänenspezifische KI-Architekturen

Die Ära der allgemeinen KI weicht domänenspezifischen Architekturen. Die Entwickler konzentrieren sich auf die Feinabstimmung von Modellen für bestimmte Branchen wie Finanzen, Klimamodellierung und Genomforschung, um neue Ebenen der Präzision und Effizienz zu erschließen.

4. Edge AI in großem Maßstab

Edge AI verarbeitet Daten lokal auf einem Gerät, anstatt sich auf die Cloud zu verlassen. Ihre Echtzeit-Fähigkeiten entwickeln sich von Nischenanwendungen hin zur allgemeinen Anwendung. Die Industrie nutzt Edge Computing, um KI-Modelle mit geringer Latenz in Umgebungen mit begrenzter Konnektivität einzusetzen, von abgelegenen Gesundheitseinrichtungen bis hin zu intelligenten Fertigungsanlagen.

5. Kollaborative KI-Ökosysteme

KI wird immer weniger isoliert, mit Ökosystemen, die Interoperabilität zwischen verschiedenen Modellen und Plattformen ermöglichen. Dies fördert robustere Lösungen durch Zusammenarbeit, insbesondere in Umgebungen mit mehreren Interessengruppen wie dem Gesundheitswesen und der Stadtplanung.

Die bevorstehenden Herausforderungen

Die Zukunft der KI ist vielversprechend, aber sie ist nicht ohne Hürden. Hier ist, was wir angehen müssen:

Vorschriften und Ethik

Das KI-Gesetz der Europäischen Union und die kalifornischen Gesetze zur Datentransparenz sind erst der Anfang. Entwickler und politische Entscheidungsträger müssen zusammenarbeiten, um sicherzustellen, dass KI verantwortungsvoll und ethisch korrekt eingesetzt wird.

Voreingenommenheit und Fairness

Selbst wenn sich die Interpretierbarkeit der Modelle verbessert, bleibt das Risiko von Verzerrungen erheblich. Entwickler müssen vielfältigen, qualitativ hochwertigen Datensätzen den Vorzug geben und Fairness-Metriken in ihre Pipelines einbauen, um unbeabsichtigte Folgen abzuschwächen.

Nachhaltigkeit

Das Training umfangreicher KI-Modelle verbraucht viel Energie. Innovationen in der Modellkomprimierung und energieeffiziente Hardware sind entscheidend, um die KI-Entwicklung mit Nachhaltigkeitszielen in Einklang zu bringen.

Blick in die Zukunft: Wie KI die Zukunft prägen wird

Das Potenzial der KI, Branchen umzugestalten und globale Herausforderungen zu bewältigen, ist immens. Aber wie genau wird sie unsere Zukunft beeinflussen? Hier ist ein genauerer Blick:

Globale Herausforderungen bewältigen

KI-gestützte Tools analysieren Klimamuster, optimieren erneuerbare Energiequellen und sagen Naturkatastrophen mit größerer Genauigkeit voraus. KI-Modelle können beispielsweise Landwirten helfen, sich an den Klimawandel anzupassen, indem sie Niederschlagsmuster vorhersagen und optimale Fruchtfolgen vorschlagen.

KI demokratisiert den Zugang zur Gesundheitsversorgung, indem sie Ferndiagnosen und Behandlungsempfehlungen ermöglicht. In unterversorgten Gebieten fungieren KI-Tools als virtuelle Gesundheitsdienstleister und überbrücken die Lücke, die durch den Mangel an medizinischen Fachkräften entsteht.

Arbeit verwandeln

KI wird nicht nur repetitive Aufgaben automatisieren, sondern auch die Nachfrage nach Positionen in den Bereichen KI-Ethik, Systemtraining und Zusammenarbeit zwischen Mensch und KI steigern. Der Arbeitsplatz entwickelt sich zu einer dynamischen Partnerschaft zwischen Mensch und KI, in der Aufgaben, die Intuition und Einfühlungsvermögen erfordern, durch die Präzision und den Umfang der KI ergänzt werden.

Die Aufgaben werden sich eher in Richtung Kuratieren, Verwalten und Überprüfen von KI-Systemen als in Richtung direkter Aufgabenausführung entwickeln.

Umgang mit Sicherheitsbedrohungen

Die Raffinesse der KI bringt auch Risiken mit sich. Cyberangriffe, die von KI und Deepfake-Technologien angetrieben werden, werden immer häufiger vorkommen. Um dem entgegenzuwirken, verkürzen prädiktive Bedrohungsmodelle und autonome Reaktionssysteme die Reaktionszeiten auf Sicherheitsverletzungen bereits von Stunden auf Sekunden.

Zusammenfassung: Sind Sie bereit für die Zukunft?

2025 ist nicht nur ein weiteres Jahr für KI – es ist ein Wendepunkt. Mit Fortschritten wie agentenbasierter KI, multimodalen Systemen und synthetischen Daten, die die Industrie umgestalten, liegt es an den Unternehmern und Entwicklern, diese sich entwickelnde Landschaft mit Präzision und Weitsicht zu navigieren. In der Zukunft geht es nicht nur um die Einführung von KI, sondern auch darum, ihre Entwicklung verantwortungsvoll zu gestalten.