A medida que nos adentramos en 2025, la inteligencia artificial (IA) está remodelando las industrias, la sociedad y la forma en que interactuamos con la tecnología de maneras apasionantes y a veces sorprendentes. Desde agentes de IA que pueden trabajar de forma independiente hasta sistemas que integran a la perfección texto, vídeo y audio, este campo está evolucionando más rápido que nunca. Para los empresarios y desarrolladores tecnológicos, adelantarse a estos cambios no sólo es inteligente, sino esencial.

Comprendamos las tendencias, los avances y los retos que darán forma a la IA en 2025 y más allá.

Una rápida mirada retrospectiva: Cómo la IA cambió nuestro mundo

El viaje de la IA desde los años 50 hasta hoy ha sido una notable historia de evolución. De sistemas simples, basados en reglas, ha pasado a modelos sofisticados capaces de razonamiento, creatividad y autonomía. En la última década, la IA ha pasado de experimental a indispensable, convirtiéndose en un motor fundamental de la innovación en todos los sectores.

Sanidad

Las herramientas potenciadas por la IA son ahora parte integrante del diagnóstico, la medicina personalizada e incluso la robótica quirúrgica. Tecnologías como las imágenes mejoradas por IA han ampliado los límites de la detección precoz de enfermedades, rivalizando y superando las capacidades humanas en precisión y velocidad.

Educación

Las plataformas de IA adaptativa han cambiado radicalmente la forma de aprender de los alumnos. Utilizan el análisis granular de datos para adaptar el contenido, el ritmo y el compromiso a nivel individual.

Transporte

Los sistemas autónomos han pasado de ser prototipos experimentales a soluciones viables en logística y transporte público, respaldados por los avances en fusión de sensores, visión por ordenador y toma de decisiones en tiempo real.

Aunque estos avances han aportado un valor innegable, también han puesto de manifiesto cuestiones complejas en torno a la ética, las implicaciones para la mano de obra y la distribución equitativa de los beneficios de la IA. Abordar estos retos sigue siendo una prioridad a medida que la IA continúa creciendo.

Tecnologías de IA que cambiarán las reglas del juego en 2025

En 2025, la atención no se centrará sólo en hacer que la IA sea más inteligente, sino en hacerla más capaz, escalable y ética. Esto es lo que está configurando el panorama:

1. IA Agenética: Más allá de la Automatización de Tareas

La IA agenética no es sólo otra palabra de moda. Estos sistemas pueden tomar decisiones y adaptarse a situaciones sin apenas intervención humana. ¿Qué te parece tener una IA que gestione tu horario, se encargue de los proyectos o incluso genere ideas creativas? Es como añadir un miembro del equipo supereficiente que nunca duerme.

- Para las empresas: Piensa en gestores de proyectos virtuales que gestionen flujos de trabajo complejos.

- Para creativos: Herramientas que ayudan a generar ideas o a editar contenidos junto a ti.

Como destaca Moody’s, la IA agéntica está a punto de convertirse en una fuerza impulsora de la productividad y la innovación en todos los sectores.

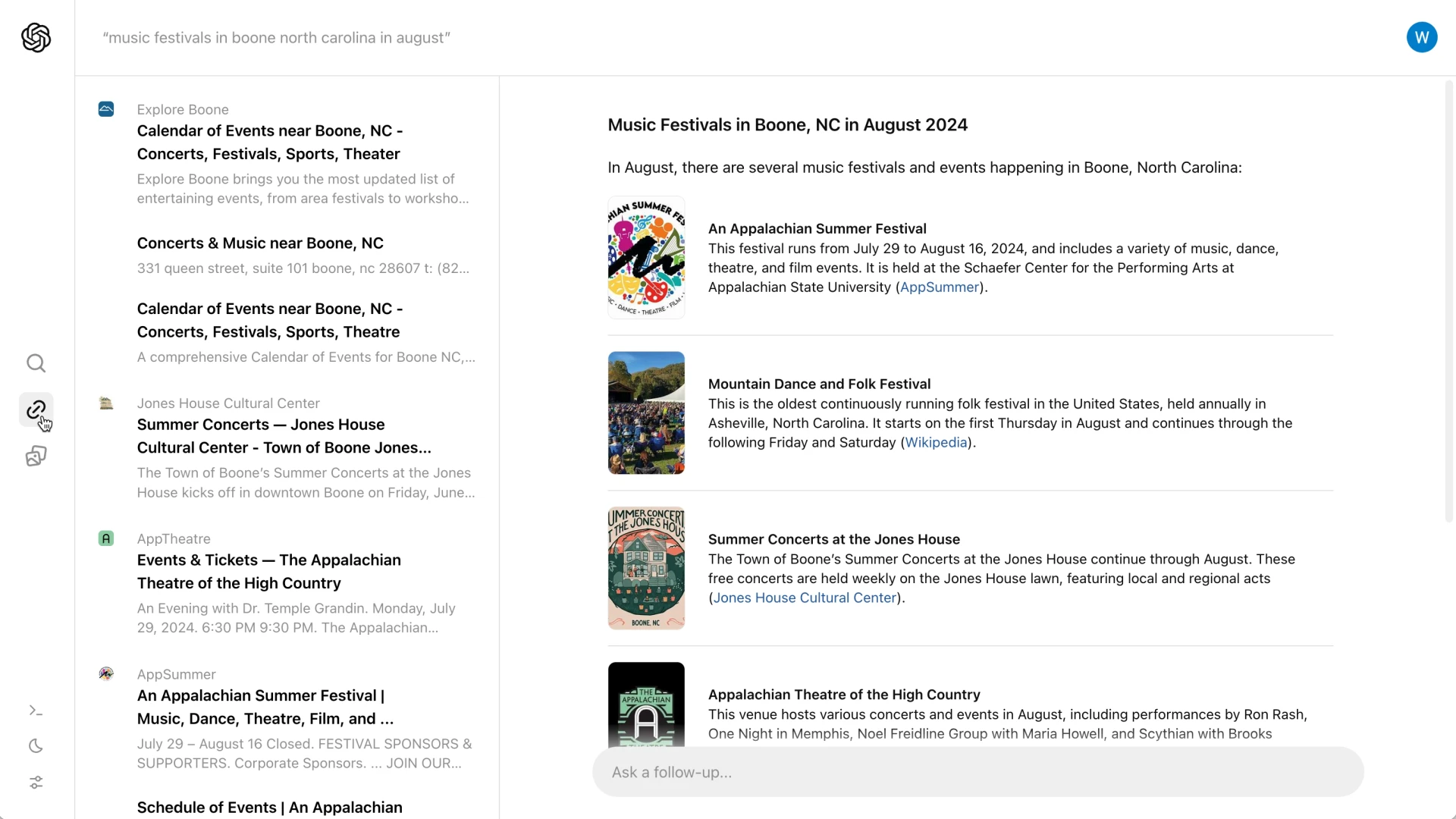

2. Inteligencia Artificial Multimodal: el último multitalento

Esta tecnología reúne texto, imágenes, audio y vídeo en un sistema sin fisuras. Por eso los futuros asistentes virtuales no sólo entenderán lo que dices, sino que captarán tu tono, tus expresiones faciales e incluso el contexto de tu entorno.

He aquí algunos ejemplos:

- Sanidad: Los sistemas multimodales podrían analizar datos médicos de múltiples fuentes para proporcionar diagnósticos más rápidos y precisos.

- Vida cotidiana: Imagina un asistente que pueda ayudarte a planificar un viaje analizando opiniones, fotos y vídeos al instante.

Gartner predice que para 2027, el 40% de las soluciones de IA generativa serán multimodales, frente a sólo el 1% en 2023.

3. Datos sintéticos: La solución respetuosa con la privacidad

Los sistemas de IA necesitan datos para aprender, pero los datos del mundo real suelen plantear problemas de privacidad o disponibilidad. Aparecen los datos sintéticos: conjuntos de datos generados artificialmente que imitan a los reales sin exponer información sensible.

Así es como podría desarrollarse:

Innovación escalable: Desde el entrenamiento de vehículos autónomos en entornos simulados hasta la generación de datos médicos poco comunes para la investigación farmacéutica.

Imperativos de gobernanza: Los desarrolladores integran cada vez más sistemas fáciles de auditar para garantizar la transparencia, la responsabilidad y la alineación con las normas reguladoras.

Los datos sintéticos son una ventaja para todos, ya que ayudan a los desarrolladores a innovar más rápidamente respetando la privacidad.

Industrias que la IA está transformando ahora mismo

La IA ya está causando estragos en estos sectores clave:

| Industria | Porcentaje de encuestados con un uso regular de Gen AI dentro de sus funciones organizativas(Fuente) |

| Marketing y ventas | 14% |

| Desarrollo de productos y/o servicios | 13% |

| Operaciones de servicio | 10% |

| Gestión de riesgos | 4% |

| Estrategia y finanzas corporativas | 4% |

| RRHH | 3% |

| Gestión de la cadena de suministro | 3% |

| Fabricación | 2% |

Sanidad

La IA está salvando vidas. Desde el análisis de imágenes médicas hasta la recomendación de tratamientos personalizados, está haciendo que la asistencia sanitaria sea más inteligente, rápida y accesible. Las herramientas de detección precoz ya están superando a los métodos tradicionales, ayudando a los médicos a detectar los problemas antes de que se agraven.

Venta al por menor

La IA generativa está permitiendo campañas de marketing hiperpersonalizadas, mientras que los modelos de inventario predictivo reducen el despilfarro al alinear las cadenas de suministro con mayor precisión con los patrones de demanda. Los minoristas que adoptan estas tecnologías informan de ganancias significativas en eficiencia operativa. Según McKinsey, la IA generativa está llamada a desbloquear entre 240.000 y 390.000 millones de dólares de valor económico para los minoristas.

Educación

Más allá del aprendizaje adaptativo, la IA está aumentando las metodologías de enseñanza. Por ejemplo, las herramientas de IA generativa ayudan a los educadores creando planes de estudios a medida y ayudas didácticas interactivas, racionalizando las cargas administrativas.

Transporte y logística

La integración de la IA con los sistemas IoT ha permitido una visibilidad sin precedentes de las redes logísticas, mejorando la optimización de rutas, la gestión de inventarios y la mitigación de riesgos para las cadenas de suministro globales.

¿Qué viene ahora? Tendencias de la IA a seguir en 2025

Entonces, ¿hacia dónde se dirige la IA? He aquí las grandes tendencias que configuran el futuro:

1. Modelos de IA que se mejoran a sí mismos

Los sistemas de IA que se perfeccionan a sí mismos en tiempo real están emergiendo como una tendencia crítica. Estos modelos autoperfeccionados aprovechan los bucles de aprendizaje continuo, mejorando la precisión y la relevancia con una supervisión humana mínima. Los casos de uso incluyen la detección del fraude en tiempo real y la ciberseguridad adaptativa.

2. Las nuevas fronteras de los datos sintéticos

Los datos sintéticos van más allá de las aplicaciones orientadas a la privacidad y se adentran en escenarios más sofisticados, como el entrenamiento de la IA para casos límite y la simulación de sucesos raros o peligrosos. Industrias como la conducción autónoma están invirtiendo mucho en este campo para modelar casos límite a escala.

3. Arquitecturas de IA específicas de cada dominio

La era de la IA generalizada está dando paso a arquitecturas especializadas en dominios concretos. Los desarrolladores se están centrando en afinar los modelos para verticales específicos como las finanzas, la modelización del clima y la investigación genómica, desbloqueando nuevos niveles de precisión y eficiencia.

4. IA Edge a escala

La IA Edge procesa los datos localmente en un dispositivo en lugar de depender de la nube. Sus capacidades en tiempo real están evolucionando desde aplicaciones nicho hasta su adopción generalizada. Las industrias están aprovechando la computación de borde para desplegar modelos de IA de baja latencia en entornos con conectividad limitada, desde centros sanitarios remotos hasta plantas de fabricación inteligentes.

5. Ecosistemas colaborativos de IA

La IA está cada vez menos aislada, con ecosistemas que permiten la interoperabilidad entre diversos modelos y plataformas. Esto fomenta soluciones más sólidas mediante la colaboración, sobre todo en entornos con múltiples partes interesadas, como la sanidad y la planificación urbana.

Los retos futuros

Aunque el futuro de la IA es brillante, no está exento de obstáculos. Esto es lo que tenemos que abordar:

Normativa y ética

La Ley de IA de la Unión Europea y las leyes de transparencia de datos de California son sólo el principio. Los desarrolladores y los responsables políticos deben trabajar juntos para garantizar que la IA se utiliza de forma responsable y ética.

Prejuicios e imparcialidad

Aunque mejore la interpretabilidad de los modelos, el riesgo de sesgo sigue siendo significativo. Los desarrolladores deben dar prioridad a los conjuntos de datos diversos y de alta calidad e incorporar métricas de imparcialidad en sus procesos para mitigar las consecuencias no deseadas.

Sostenibilidad

El entrenamiento de modelos masivos de IA consume mucha energía. Las innovaciones en la compresión de modelos y el hardware energéticamente eficiente son fundamentales para alinear el desarrollo de la IA con los objetivos de sostenibilidad.

Mirando hacia el futuro: Cómo la IA dará forma al futuro

El potencial de la IA para remodelar las industrias y abordar los retos mundiales es inmenso. Pero, ¿cómo afectará exactamente a nuestro futuro? He aquí un análisis más detallado:

Potenciar los retos globales

Las herramientas potenciadas por la IA están analizando los patrones climáticos, optimizando las fuentes de energía renovables y prediciendo catástrofes naturales con mayor precisión. Por ejemplo, los modelos de IA pueden ayudar a los agricultores a adaptarse al cambio climático prediciendo patrones de precipitaciones y sugiriendo rotaciones óptimas de cultivos.

La IA está democratizando el acceso a la asistencia sanitaria al permitir diagnósticos y recomendaciones de tratamiento a distancia. En zonas desatendidas, las herramientas de IA actúan como proveedores virtuales de asistencia sanitaria, salvando las distancias causadas por la escasez de profesionales médicos.

Transformar el trabajo

Aunque la IA automatizará las tareas repetitivas, también está creando demanda de puestos en ética de la IA, formación de sistemas y colaboración entre humanos e IA. El lugar de trabajo se está convirtiendo en una asociación dinámica entre humanos e IA, donde las tareas que requieren intuición y empatía se complementan con la precisión y la escala de la IA.

Los puestos de trabajo evolucionarán hacia la conservación, gestión y auditoría de los sistemas de IA, en lugar de la ejecución directa de tareas.

Afrontar las amenazas a la seguridad

La sofisticación de la IA también introduce riesgos. Los ciberataques impulsados por la IA y las tecnologías deepfake son cada vez más frecuentes. Para contrarrestarlo, los modelos predictivos de amenazas y los sistemas autónomos de respuesta ya están reduciendo los tiempos de respuesta a las brechas de horas a segundos.

Concluyendo: ¿Estás preparado para el futuro?

2025 no es un año más para la IA: es un punto de inflexión. Con avances como la IA agéntica, los sistemas multimodales y los datos sintéticos que reconfiguran las industrias, es responsabilidad de los empresarios y desarrolladores tecnológicos navegar por este panorama en evolución con precisión y previsión. El futuro no consiste sólo en adoptar la IA, sino en moldear su trayectoria de forma responsable.