Gdy wkraczamy w 2025 rok, sztuczna inteligencja (AI) przekształca branże, społeczeństwo i sposób, w jaki wchodzimy w interakcje z technologią na ekscytujące, a czasem zaskakujące sposoby. Od agentów AI, którzy mogą pracować niezależnie, po systemy, które płynnie integrują tekst, wideo i audio, dziedzina ta rozwija się szybciej niż kiedykolwiek. Dla przedsiębiorców technologicznych i deweloperów wyprzedzanie tych zmian jest nie tylko sprytne – jest niezbędne.

Zrozummy trendy, przełomy i wyzwania, które będą kształtować sztuczną inteligencję w 2025 roku i później.

Szybkie spojrzenie wstecz: jak sztuczna inteligencja zmieniła nasz świat

Podróż sztucznej inteligencji od lat 50. do dziś była niezwykłą historią ewolucji. Z prostych, opartych na regułach systemów przekształciła się w zaawansowane modele zdolne do rozumowania, kreatywności i autonomii. W ciągu ostatniej dekady sztuczna inteligencja przekształciła się z eksperymentalnej w niezbędną, stając się głównym motorem innowacji w różnych branżach.

Opieka zdrowotna

Narzędzia oparte na sztucznej inteligencji są obecnie integralną częścią diagnostyki, medycyny spersonalizowanej, a nawet robotyki chirurgicznej. Technologie takie jak obrazowanie wspomagane sztuczną inteligencją przesunęły granice wczesnego wykrywania chorób, rywalizując i przewyższając ludzkie możliwości w zakresie dokładności i szybkości.

Edukacja

Adaptacyjne platformy AI zasadniczo zmieniły sposób uczenia się uczniów. Wykorzystują one szczegółową analizę danych w celu dostosowania treści, tempa i zaangażowania na poziomie indywidualnym.

Transport

Systemy autonomiczne ewoluowały od eksperymentalnych prototypów do realnych rozwiązań w logistyce i transporcie publicznym, wspieranych przez postępy w fuzji czujników, wizji komputerowej i podejmowaniu decyzji w czasie rzeczywistym.

Chociaż postępy te przyniosły niezaprzeczalną wartość, ujawniły również złożone pytania dotyczące etyki, konsekwencji dla siły roboczej i sprawiedliwego podziału korzyści płynących ze sztucznej inteligencji. Podjęcie tych wyzwań pozostaje priorytetem w miarę dalszego rozwoju sztucznej inteligencji.

Przełomowe technologie AI do obejrzenia w 2025 roku

W 2025 r. nacisk zostanie położony nie tylko na uczynienie sztucznej inteligencji inteligentniejszą, ale także na zwiększenie jej możliwości, skalowalności i etyczności. Oto, co kształtuje krajobraz:

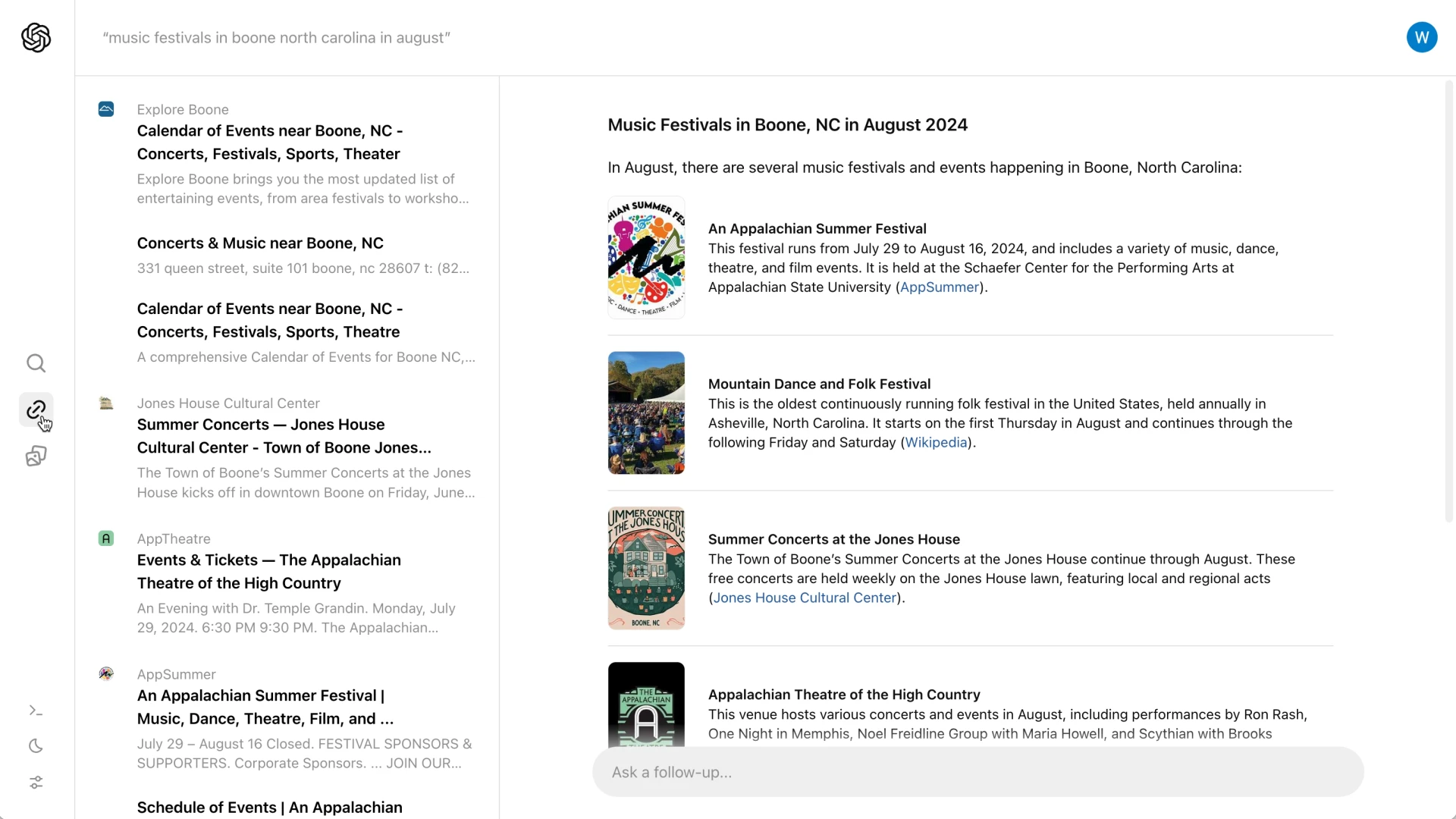

1. Sztuczna inteligencja agentowa: poza automatyzacją zadań

Sztuczna inteligencja nie jest tylko kolejnym modnym hasłem. Systemy te mogą podejmować decyzje i dostosowywać się do sytuacji przy niewielkim lub zerowym udziale człowieka. Co powiesz na posiadanie sztucznej inteligencji, która zarządza Twoim harmonogramem, obsługuje projekty, a nawet generuje kreatywne pomysły? To jak dodanie super wydajnego członka zespołu, który nigdy nie śpi.

- Dla firm: Pomyśl o wirtualnych kierownikach projektów obsługujących złożone przepływy pracy.

- Dla twórców: Narzędzia, które pomagają w burzy mózgów lub edycji treści.

Jak podkreśla Moody’s, agentowa sztuczna inteligencja ma szansę stać się siłą napędową produktywności i innowacji w różnych branżach.

2. Multimodalna sztuczna inteligencja: najbardziej wszechstronne rozwiązanie

Technologia ta łączy tekst, obrazy, dźwięk i wideo w jeden płynny system. Dlatego też przyszli wirtualni asystenci nie tylko zrozumieją, co mówisz – wychwycą Twój ton, mimikę twarzy, a nawet kontekst otoczenia.

Oto kilka przykładów:

- Opieka zdrowotna: Systemy multimodalne mogłyby analizować dane medyczne z wielu źródeł w celu zapewnienia szybszych i dokładniejszych diagnoz.

- Życie codzienne: Wyobraź sobie asystenta, który może pomóc Ci zaplanować podróż, natychmiast analizując recenzje, zdjęcia i filmy.

Gartner przewiduje, że do 2027 roku 40% rozwiązań generatywnej sztucznej inteligencji będzie multimodalnych, w porównaniu z zaledwie 1% w 2023 roku.

3. Dane syntetyczne: Rozwiązanie przyjazne dla prywatności

Systemy sztucznej inteligencji potrzebują danych do nauki, ale rzeczywiste dane często wiążą się z obawami o prywatność lub dostępność. Z pomocą przychodzą dane syntetyczne – sztucznie wygenerowane zbiory danych, które naśladują rzeczywiste dane bez ujawniania wrażliwych informacji.

Oto jak może się to rozegrać:

Skalowalne innowacje: Od szkolenia autonomicznych pojazdów w symulowanych środowiskach po generowanie rzadkich danych medycznych do badań farmaceutycznych.

Imperatywy związane z zarządzaniem: Deweloperzy coraz częściej integrują systemy przyjazne dla audytorów, aby zapewnić przejrzystość, odpowiedzialność i zgodność ze standardami regulacyjnymi.

Syntetyczne dane są korzystne dla obu stron, pomagając deweloperom szybciej wprowadzać innowacje przy jednoczesnym poszanowaniu prywatności.

Branże, które sztuczna inteligencja przekształca teraz

Sztuczna inteligencja już teraz robi furorę w tych kluczowych sektorach:

| Przemysł | Odsetek respondentów regularnie korzystających z Gen AI w ramach swoich ról organizacyjnych(Źródło) |

| Marketing i sprzedaż | 14% |

| Rozwój produktów i/lub usług | 13% |

| Operacje serwisowe | 10% |

| Zarządzanie ryzykiem | 4% |

| Strategia i finanse korporacyjne | 4% |

| HR | 3% |

| Zarządzanie łańcuchem dostaw | 3% |

| Produkcja | 2% |

Opieka zdrowotna

Sztuczna inteligencja ratuje życie. Od analizowania obrazów medycznych po rekomendowanie spersonalizowanych metod leczenia, sprawia ona, że opieka zdrowotna staje się inteligentniejsza, szybsza i bardziej dostępna. Narzędzia do wczesnego wykrywania już teraz przewyższają tradycyjne metody, pomagając lekarzom wychwycić problemy, zanim się nasilą.

Sprzedaż detaliczna

Generatywna sztuczna inteligencja umożliwia prowadzenie hiper-spersonalizowanych kampanii marketingowych, podczas gdy predykcyjne modele zapasów zmniejszają marnotrawstwo poprzez dokładniejsze dostosowanie łańcuchów dostaw do wzorców popytu. Detaliści wdrażający te technologie odnotowują znaczny wzrost wydajności operacyjnej. Według McKinsey, generatywna sztuczna inteligencja ma odblokować od 240 do 390 miliardów dolarów wartości ekonomicznej dla detalistów.

Edukacja

Oprócz adaptacyjnego uczenia się, sztuczna inteligencja rozszerza obecnie metodologie nauczania. Przykładowo, generatywne narzędzia sztucznej inteligencji pomagają nauczycielom, tworząc dostosowane programy nauczania i interaktywne pomoce dydaktyczne, usprawniając obciążenia administracyjne.

Transport i logistyka

Integracja sztucznej inteligencji z systemami IoT umożliwiła niezrównany wgląd w sieci logistyczne, usprawniając optymalizację tras, zarządzanie zapasami i ograniczanie ryzyka w globalnych łańcuchach dostaw.

Co dalej? Trendy AI, które warto obserwować w 2025 roku

Dokąd zmierza sztuczna inteligencja? Oto najważniejsze trendy kształtujące przyszłość:

1. Samodoskonalące się modele sztucznej inteligencji

Systemy sztucznej inteligencji, które doskonalą się w czasie rzeczywistym, wyłaniają się jako krytyczny trend. Te samodoskonalące się modele wykorzystują pętle ciągłego uczenia się, zwiększając dokładność i trafność przy minimalnym nadzorze człowieka. Przypadki użycia obejmują wykrywanie oszustw w czasie rzeczywistym i adaptacyjne cyberbezpieczeństwo.

2. Nowe granice danych syntetycznych

Dane syntetyczne wykraczają poza zastosowania związane z prywatnością w kierunku bardziej wyrafinowanych scenariuszy, takich jak szkolenie sztucznej inteligencji w przypadkach brzegowych i symulowanie rzadkich lub niebezpiecznych zdarzeń. Branże takie jak autonomiczna jazda intensywnie inwestują w ten obszar, aby modelować przypadki narożne na dużą skalę.

3. Architektury AI specyficzne dla danej dziedziny

Era uogólnionej sztucznej inteligencji ustępuje miejsca architekturom wyspecjalizowanym w danej dziedzinie. Deweloperzy koncentrują się na dostrajaniu modeli dla określonych branż, takich jak finanse, modelowanie klimatu i badania genomiczne, odblokowując nowe poziomy precyzji i wydajności.

4. Edge AI na dużą skalę

Edge AI przetwarza dane lokalnie na urządzeniu, zamiast polegać na chmurze. Jej możliwości w czasie rzeczywistym ewoluują od zastosowań niszowych do głównego nurtu. Branże wykorzystują przetwarzanie brzegowe do wdrażania modeli AI o niskich opóźnieniach w środowiskach o ograniczonej łączności, od zdalnych placówek opieki zdrowotnej po inteligentne zakłady produkcyjne.

5. Współpracujące ekosystemy AI

Sztuczna inteligencja staje się coraz mniej silosowa, a ekosystemy umożliwiają interoperacyjność między różnymi modelami i platformami. Sprzyja to bardziej solidnym rozwiązaniom dzięki współpracy, szczególnie w środowiskach wielopodmiotowych, takich jak opieka zdrowotna i planowanie urbanistyczne.

Nadchodzące wyzwania

Choć przyszłość sztucznej inteligencji rysuje się w jasnych barwach, nie jest ona pozbawiona przeszkód. Oto, z czym musimy się zmierzyć:

Przepisy i etyka

Ustawa Unii Europejskiej o sztucznej inteligencji i kalifornijskie przepisy dotyczące przejrzystości danych to dopiero początek. Deweloperzy i decydenci muszą współpracować, aby zapewnić, że sztuczna inteligencja jest wykorzystywana w sposób odpowiedzialny i etyczny.

Stronniczość i sprawiedliwość

Nawet w miarę poprawy interpretowalności modeli, ryzyko stronniczości pozostaje znaczące. Programiści muszą priorytetowo traktować różnorodne, wysokiej jakości zbiory danych i włączać wskaźniki uczciwości do swoich potoków, aby złagodzić niezamierzone konsekwencje.

Zrównoważony rozwój

Trenowanie ogromnych modeli sztucznej inteligencji zużywa dużo energii. Innowacje w zakresie kompresji modeli i energooszczędnego sprzętu mają kluczowe znaczenie dla dostosowania rozwoju sztucznej inteligencji do celów zrównoważonego rozwoju.

Patrząc w przyszłość: Jak sztuczna inteligencja ukształtuje przyszłość

Potencjał sztucznej inteligencji do przekształcania branż i stawiania czoła globalnym wyzwaniom jest ogromny. Ale jak dokładnie wpłynie ona na naszą przyszłość? Przyjrzyjmy się temu bliżej:

Wspieranie globalnych wyzwań

Narzędzia oparte na sztucznej inteligencji analizują wzorce klimatyczne, optymalizują odnawialne źródła energii i przewidują klęski żywiołowe z większą dokładnością. Przykładowo, modele AI mogą pomóc rolnikom dostosować się do zmian klimatycznych poprzez przewidywanie wzorców opadów i sugerowanie optymalnego płodozmianu.

Sztuczna inteligencja demokratyzuje dostęp do opieki zdrowotnej, umożliwiając zdalną diagnostykę i zalecenia dotyczące leczenia. Na obszarach niedostatecznie rozwiniętych narzędzia AI działają jako wirtualni dostawcy opieki zdrowotnej, wypełniając lukę spowodowaną niedoborem specjalistów medycznych.

Przekształcanie pracy

Podczas gdy sztuczna inteligencja zautomatyzuje powtarzalne zadania, tworzy również zapotrzebowanie na role w etyce sztucznej inteligencji, szkoleniach systemowych i współpracy między człowiekiem a sztuczną inteligencją. Miejsce pracy staje się dynamicznym partnerstwem między ludźmi a sztuczną inteligencją, w którym zadania wymagające intuicji i empatii są uzupełniane precyzją i skalą sztucznej inteligencji.

Role zawodowe będą ewoluować w kierunku kuratorowania, zarządzania i audytowania systemów AI, a nie bezpośredniego wykonywania zadań.

Radzenie sobie z zagrożeniami bezpieczeństwa

Zaawansowanie sztucznej inteligencji wiąże się również z ryzykiem. Cyberataki oparte na sztucznej inteligencji i technologiach deepfake stają się coraz bardziej powszechne. Aby temu przeciwdziałać, predykcyjne modele zagrożeń i autonomiczne systemy reagowania już teraz skracają czas reakcji na naruszenia z godzin do sekund.

Podsumowując: Czy jesteś gotowy na przyszłość?

Rok 2025 to nie tylko kolejny rok dla sztucznej inteligencji – to punkt zwrotny. Wraz z postępami, takimi jak sztuczna inteligencja agentowa, systemy multimodalne i dane syntetyczne, które przekształcają branże, na przedsiębiorcach technologicznych i programistach spoczywa obowiązek poruszania się po tym ewoluującym krajobrazie z precyzją i dalekowzrocznością. Przyszłość to nie tylko przyjęcie sztucznej inteligencji; chodzi o odpowiedzialne kształtowanie jej trajektorii.