グロックとラマ3:ゲームを変えるデュオ

数カ月前、「Groq」という名の新会社が突如として現れ、AI業界で画期的な進歩を遂げた。 LPUは、LLM、特にLlama、Mixtral、GemmaのようなオープンソースのLLMの推論エンジンとして、開発者がLPUにアクセスするためのプラットフォームを提供しました。 このブログでは、Groqの特徴を探り、LPUの背後にある驚異を掘り下げてみよう。

Groqとは?

“GroqはGenAIの推論速度の標準を設定する使命を担っており、リアルタイムのAIアプリケーションの実現を今日から支援しています。”- Groqウェブサイト

GroqはGPTやGeminiのようにLLMを開発する会社ではない。 その代わりにGroqは、これらの大規模な言語モデルの基盤、つまりそれらが動作するハードウェアを強化することに重点を置いている。 推論エンジン」の役割を果たす。 現在、市場にあるほとんどのLLMは、プライベートサーバーやクラウド上に配置された従来のGPUを利用している。 これらのGPUは、Nvidiaのような会社から供給される高価で強力なものですが、依然として伝統的なGPUアーキテクチャに依存しており、LLM推論には最適ではないかもしれません(しかし、強力であることに変わりはなく、モデルのトレーニングには適しています)。

Groqが提供する推論エンジンは、LPU(言語処理ユニット)上で動作する。

LPUとは何ですか?

言語処理ユニットはLLMのために特別に設計されたチップで、CPUとGPUを組み合わせた独自のアーキテクチャで構築されており、LLM向けのAIソリューションのペース、予測可能性、パフォーマンス、精度を一変させる。

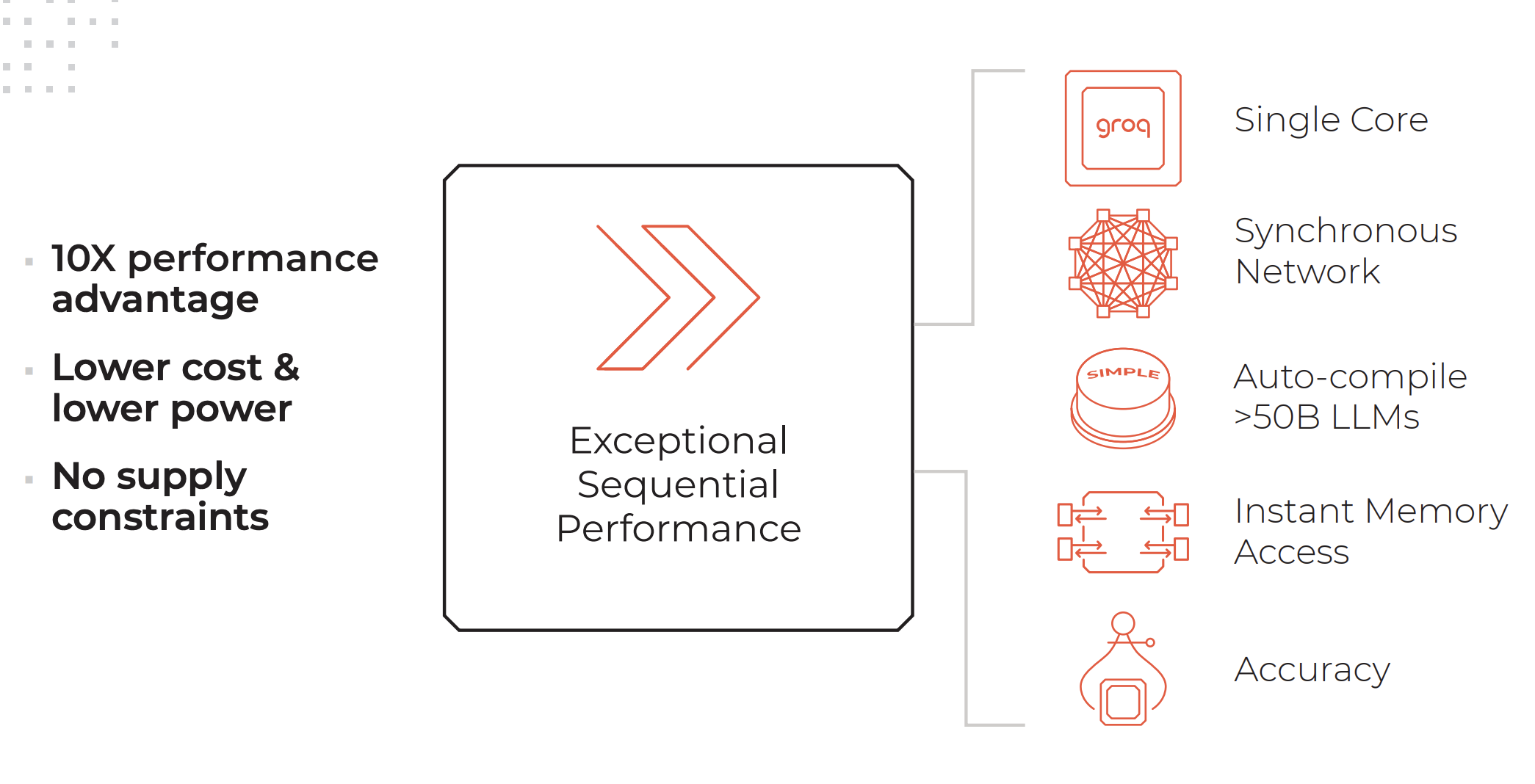

LPUシステムの主な特徴。 クレジットGroq

LPUシステムは、グラフィックプロセッサ(GPU)と同等かそれ以上の計算能力を持ち、1単語あたりの計算時間を短縮することで、より高速なテキストシーケンスの生成を可能にします。

Groqのウェブサイトに掲載されているLPU推論エンジンの特徴:

- 卓越したシーケンシャル性能

- シングル・コア・アーキテクチャ

- 大規模展開でも維持される同期ネットワーキング

- >50B LLMの自動コンパイル機能

- インスタント・メモリー・アクセス

- 低い精度レベルでも維持される高い精度

Groqが提供するサービス

- GroqCloudクラウド上のLPU

- GroqRack:最大64個のチップを相互接続できる42Uラック

- GroqNode:8台のGroqCard™アクセラレータを相互接続した4Uラック対応スケーラブル・コンピューティング・システム

- GroqCard:標準PCIe Gen 4×16フォームファクタのシングルチップで、手間のかからないサーバー統合を実現

「AIとは全く異なる種類のタスクを行うために設計されたCPUや、偶然AIのようなことを行うためにCPUをベースに設計されたGPUや、AIに適したものにするためにGPUを改良したTPUとは異なり、Groqは一から、第一原理から、AIのためのコンピューターシステムなのです」ダニエル・ウォーフィールド(データサイエンスに向けて

LPUがGPU、TPU、CPUとどのように異なるかについては、ダニエル・ウォーフィールド(Daniel Warfield)氏がTowards Data Scienceに寄稿した包括的な記事を読むことをお勧めします。

Groqは何のためにあるのか?

LLMは非常に強力で、非構造化データの解析から猫のかわいさに関する質問への回答まで、幅広いタスクをこなすことができる。 しかし、現在のところ、その主な欠点は応答時間にある。 応答時間の遅さは、バックエンドプロセスでLLMを使用する際に大きなレイテンシーにつながる。 例えば、データベースからデータをフェッチし、JSONフォーマットで表示するのは、データを変換するためにLLMを通すよりも、従来のロジックを使った方がはるかに速い。 しかし、LLMの利点は、データの例外を理解し処理する能力にある。

Groqが提供する驚異的な推論速度により、LLMのこの欠点は大幅に軽減される。 LPUを使えば、オープンソースのモデルをより安価に導入でき、レスポンスも速くなる。

Groqのラマ3

数週間前、メタ社は、すでにパワフルで非常に高性能なオープンソースのLLM-Llama 3の最新版を発表した。 スピード、データ理解力、トークン生成における典型的な強化に加えて、2つの重要な改善が目立つ:

- Llama 2の7倍のデータセットと4倍のコードで学習。

- コンテキストの長さを2倍の8,000トークンに。

Llama 2はすでに手ごわいオープンソースLLMだったが、これら2つのアップデートにより、Llama 3の性能は大幅に上昇すると予想される。

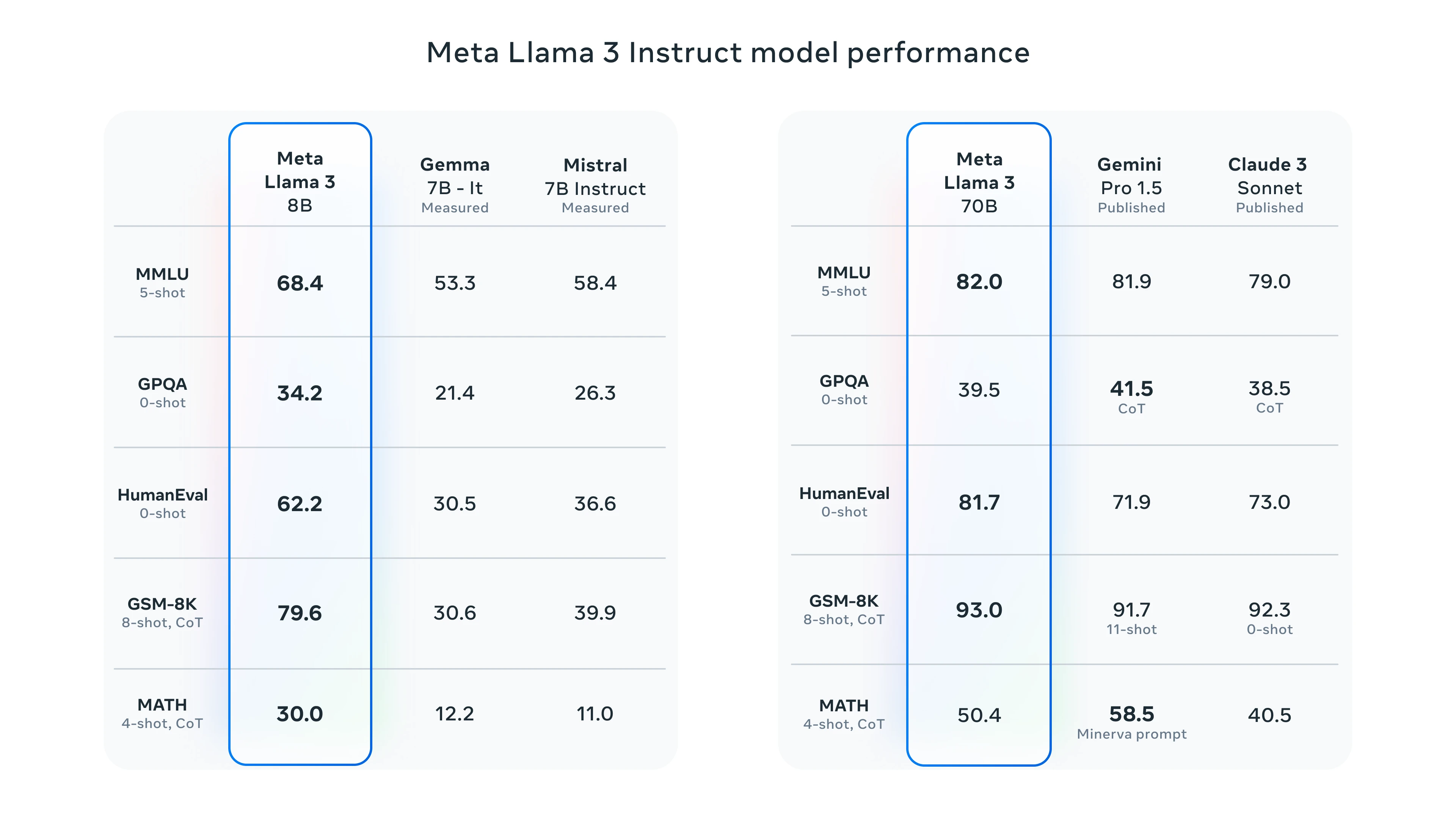

ラマ3ベンチマーク

ラマ3をテストするには、Meta AIまたはGroqプレイグラウンドを利用するオプションがある。 Llama3でテストすることで、Groqのパフォーマンスを紹介しよう。

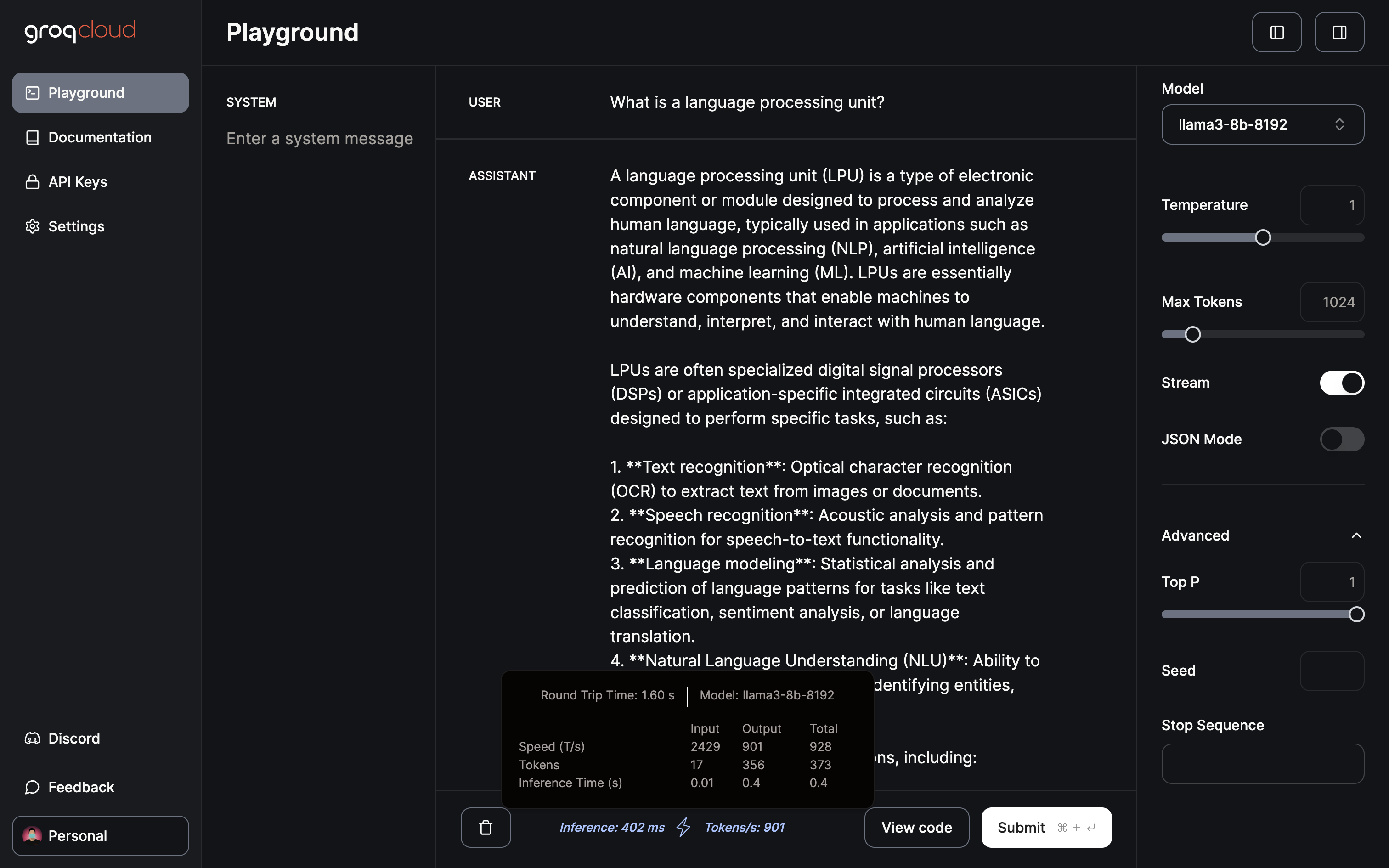

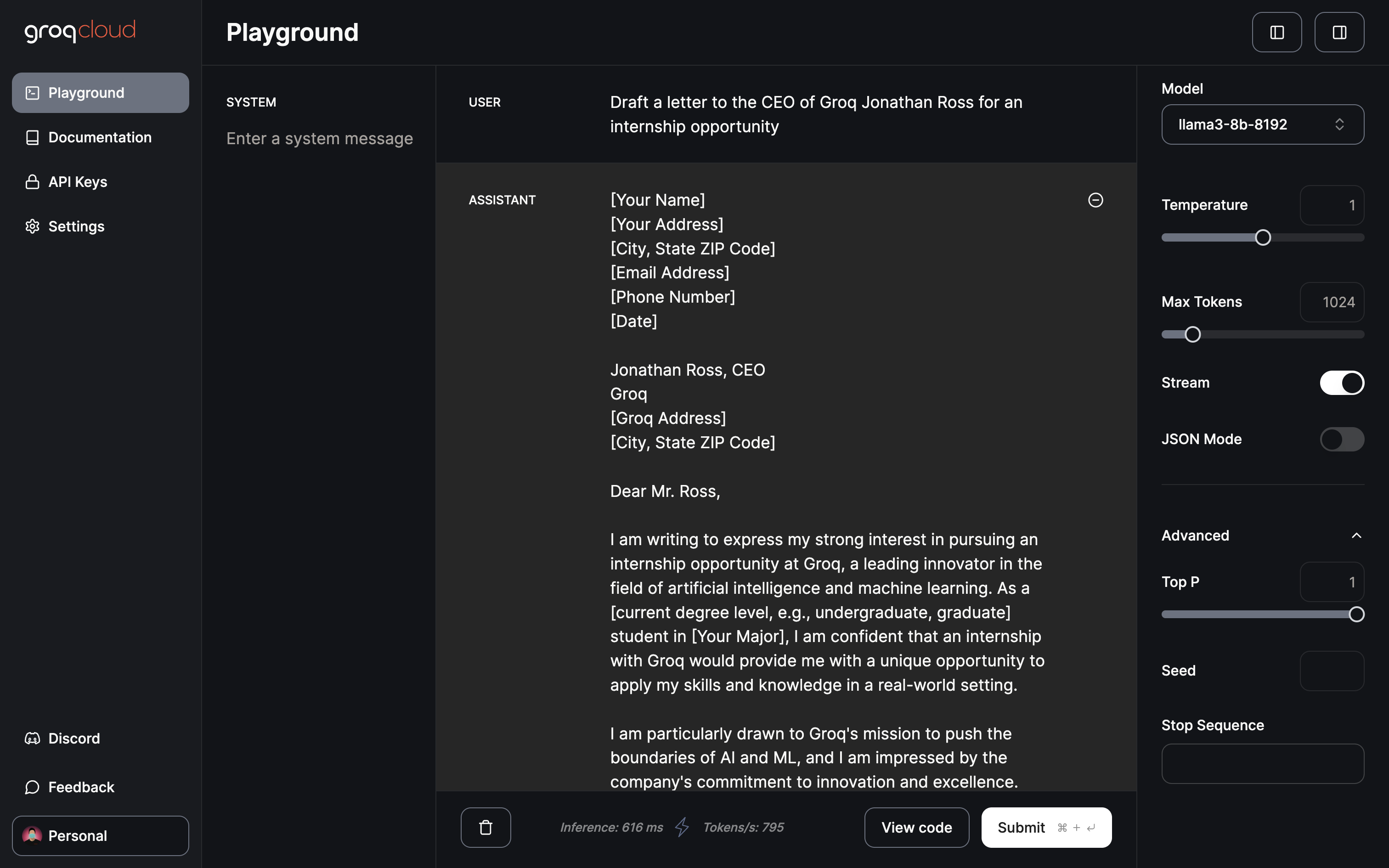

グロック・プレイグラウンド

現在、Groqプレーグラウンドでは、Gemma 7B、Llama 3 70Bと8B、Mixtral 8x7Bを無料で利用できる。 プレイグラウンドでは、温度、最大トークン、ストリーミング・トグルなどのパラメーターを調整できる。 さらに、JSON出力のみを生成する専用のJSONモードも備えている。

901トークン/秒の推論でわずか402ミリ秒

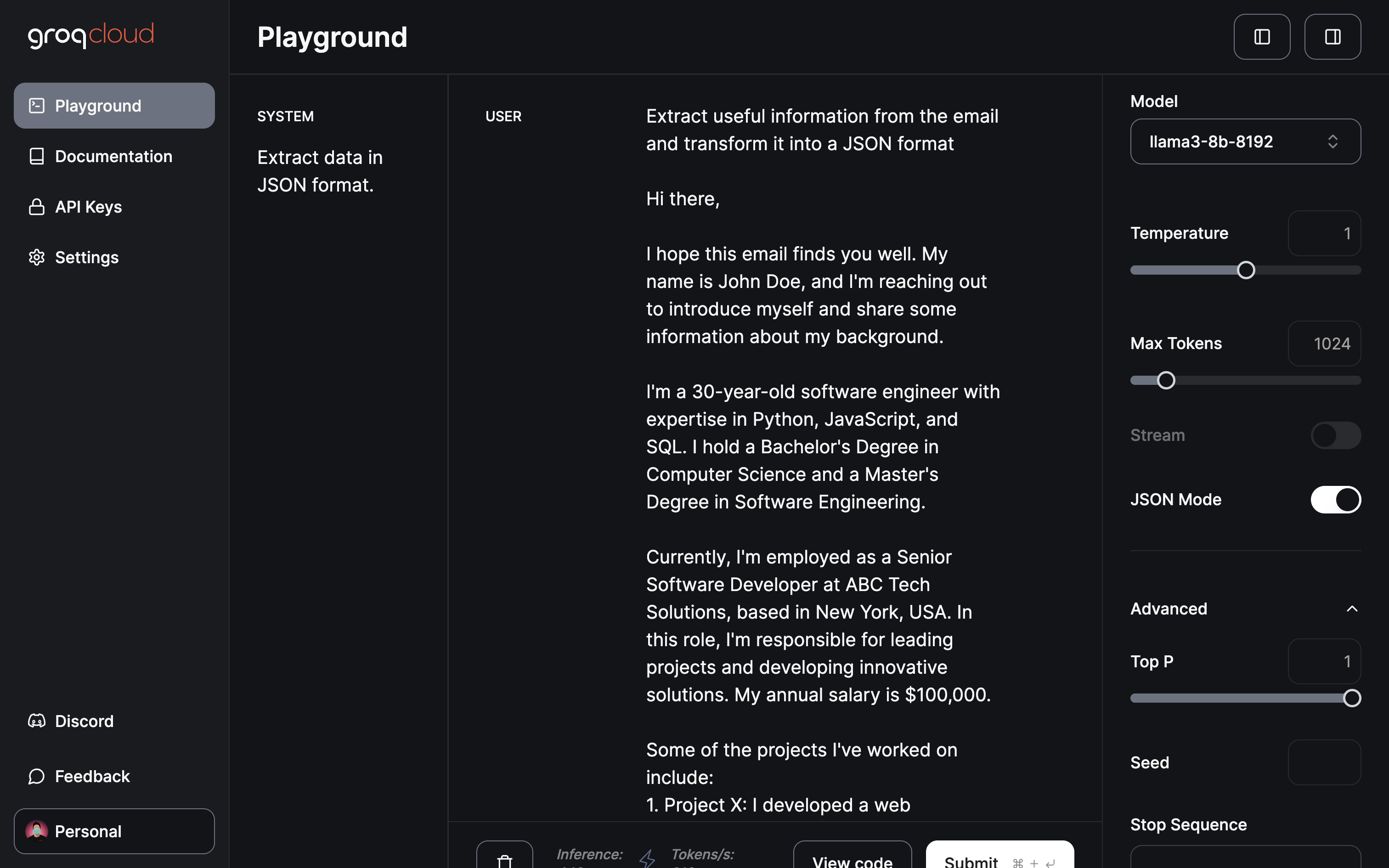

私が考える最もインパクトのある領域/アプリケーションは、データの抽出と変換である:

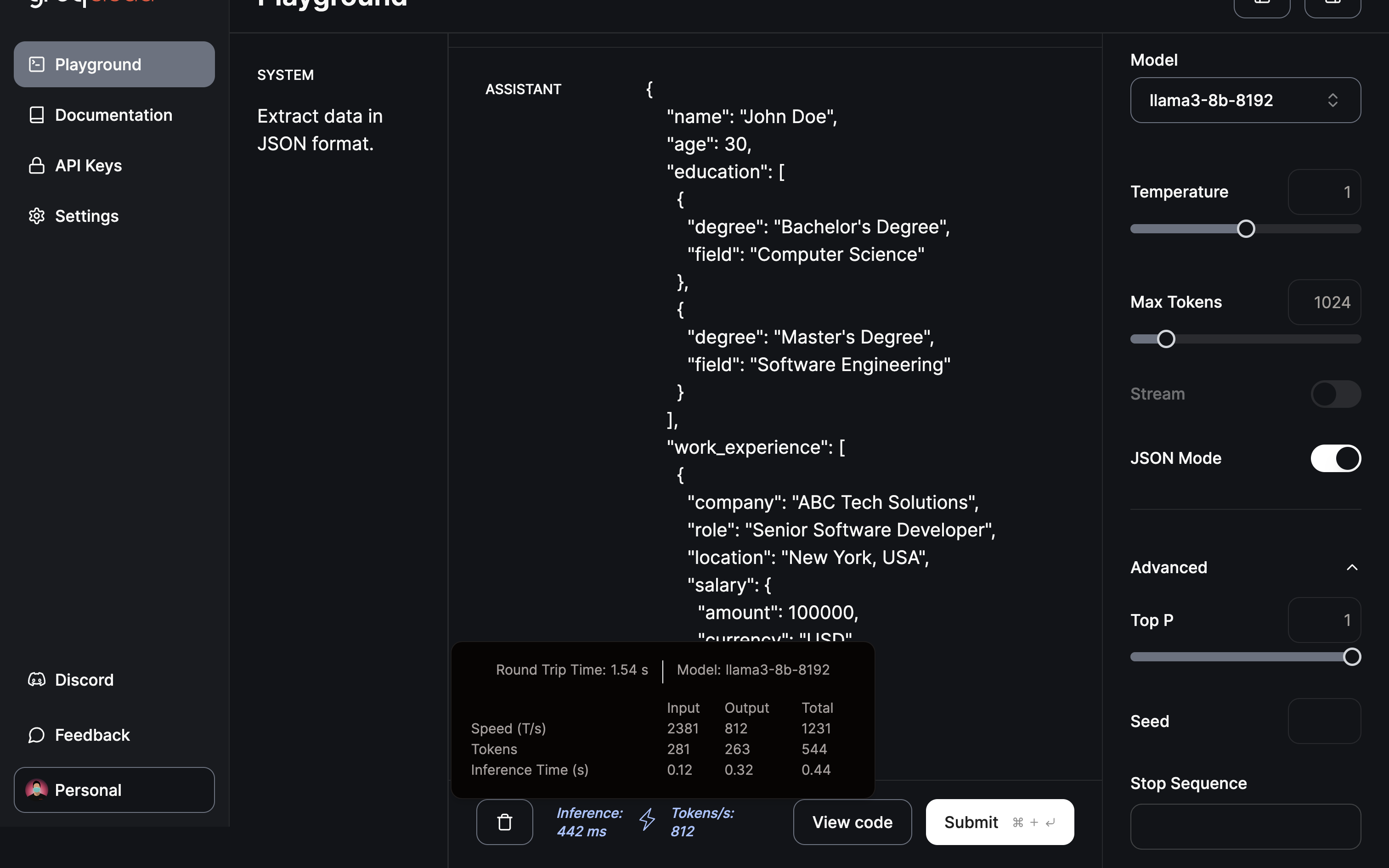

モデルに有用な情報の抽出を依頼し、JSONモードを使ってJSONを提供する。

抽出とJSONフォーマットへの変換は、0.5秒もかからずに完了した。

結論

実証されたように、Groqは革新的なLPU推論エンジンによって、LLMの状況を一変させる存在となった。 ここで示された急速な変革は、AIの応用を加速させる計り知れない可能性を示唆している。 今後、Groqがどのようなイノベーションを起こすかは、想像するしかない。 おそらく、画像処理ユニットが画像生成モデルに革命をもたらし、AI映像生成の進歩に貢献する可能性がある。 確かに、期待に胸を膨らませる未来だ。

今後、LLMトレーニングの効率化が進めば、自分のローカル・デバイスで、自分のデータをもとに微調整されたパーソナライズされたChatGPTを利用できる可能性が出てくる。 そのような機能を提供するプラットフォームのひとつが、ビジネスをさまざまな側面からサポートするために調整されたインテリジェントなAIアシスタント、Codyである。 ChatGPTのように、Codyはあなたのビジネスデータ、チーム、プロセス、顧客について、独自のナレッジベースを使ってトレーニングすることができます。

Codyを利用することで、企業はAIの力を活用し、ニーズに特化したパーソナライズされたインテリジェントなアシスタントを作成することができる。