Codyを使えば、数クリックで企業データを魅力的な物語に変えることができます。

より多くのプラットフォームとの互換性を求める複数のリクエストを受けて、私たちはCodyのZapier統合という 最新のアップデートを発表できることを嬉しく思います。 これによって可能性が広がり、5,000を超えるアプリの膨大なエコシステムとコーディを 、わずか数クリックで簡単につなげることができる。 Codyの 機能を、Discordや Slackとの 統合をはるかに超えて拡張し、多数のプラットフォームで自動化の力を活用しましょう。 この記事は、CodyとZapierを使ってAIでLinkedInの投稿をブーストするのに役立つ。

目次

Zapierとは? なぜOpenAI APIではなくCodyを選ぶのか? Zapierを使ってCodyのワークフローを自動化するには?

ステップ1:ボットを作成する ステップ 2: Zapier統合を有効にする ステップ3:Zapierの設定 ステップ4:ザップの構築

最終結果 次のステップは?

Zapierとは?

Zapierは 、自動化の世界に初めて足を踏み入れる人にとって、無数のアプリ間のコード不要の橋渡し役となり、複雑な技術的ノウハウや複数のAPIキーとの格闘を不要にする。 基本的には、さまざまなプラットフォーム間の機能を統合し、自動化するユーザーフレンドリーな方法であり、Codyの機能をこれまで以上に簡単に拡張できる。

Zapier エコシステムで利用可能な人気アプリの一部:

グーグル シート

グーグルドキュメント

スラック

テレグラム

インスタグラム

フェイスブックメッセンジャー

なぜOpenAI APIではなくCodyを選ぶのか?

Cody AIは、ビジネスの自動化と支援に合わせたアプローチを提供し、汎用的なGPT APIとは一線を画している。 GPT APIとは異なり、Codyでは、独自のナレッジベースを使用して、あなたのビジネス、チーム、プロセス、さらには顧客データについて、アシスタントを特別にトレーニングすることができます。 これにより、ナレッジベースを別に管理したり、セマンティック検索エンジンを実装したりといった技術的に複雑な作業を省くことができます。

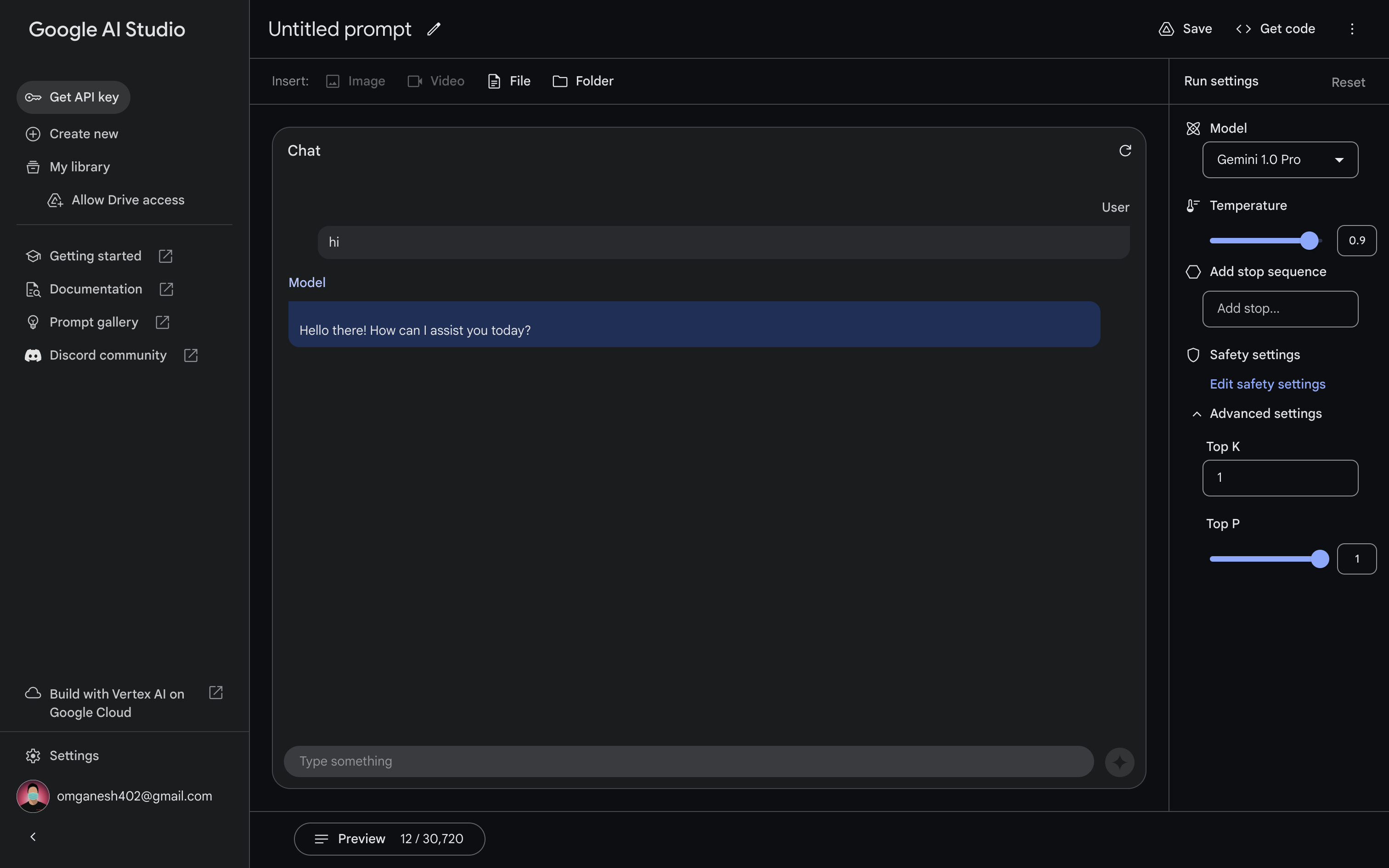

さらに、Codyはより包括的なソリューションを提供し、サブスクリプションプランに基づいたさまざまなGPTモデルへのアクセスを提供します。 また、Word / PDFドキュメント、クロールウェブページなどの幅広いドキュメントタイプをサポートし、カスタマイズ可能で埋め込み可能なウィジェットを提供し、既存のビジネスオペレーションにシームレスに統合できるように設計されています。 Codyでは、お客様のニーズに合わせた多機能で包括的なプラットフォームをご利用いただけます。

Zapierを使ってCodyのワークフローを自動化するには?

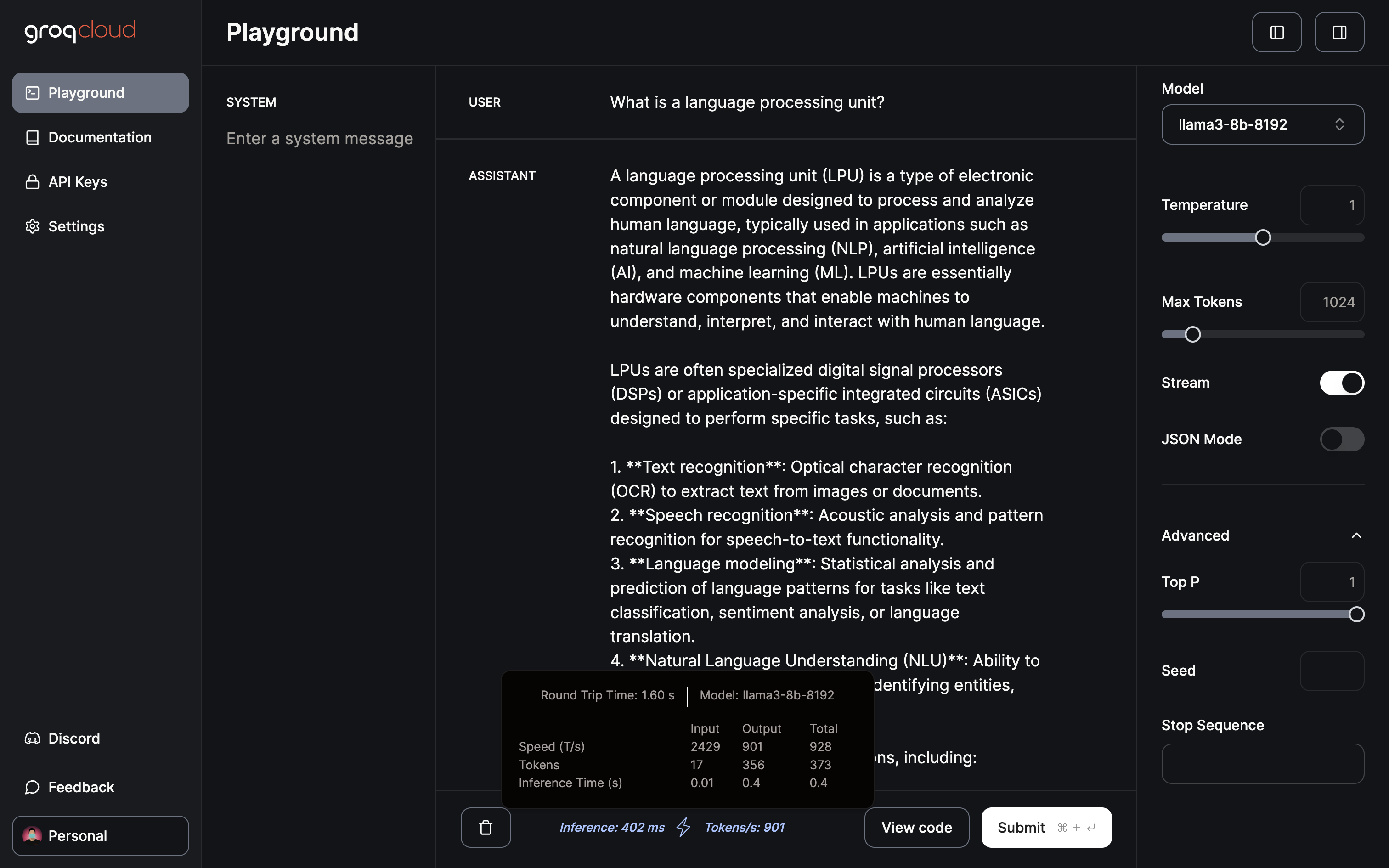

CodyとZapierの相性の良さを示すために、簡単な自動化を紹介しよう。 この記事では、CodyとZapierを使ってAIでLinkedInの投稿をブーストする方法を理解する。 この設定により、LinkedInに投稿したい内容をSlackに入力することができる。 ほんの数秒で、そのメッセージは自動的に本物のLinkedIn投稿に変わる。 CodyとZapierのおかげで、素早く簡単にソーシャルメディアのプレゼンスを拡大することができる。

ステップ1:ボットを作成する

私たちのウェブサイトには、ボット作成に関する様々なブログが あります。 しかし、簡単に概要を説明すると、ボットは基本的に2つの主要コンポーネントで構成されている:

ボットのパーソナリティ :これは、あなたのボットがどのように対話するかのトーン、ムード、スタイルを設定します。 感情的な背景から返答の長さや関連性まで、すべてを網羅する。ナレッジ・ベース ここにはあなたの重要な文書がすべて保管されています。 ボットが正確で有用な応答を生成するのに役立つコンテキストを提供する。

この2つの要素を組み合わせることで、ボットの効果と使いやすさが決まります。 この具体的なデモでは、不動産サイトのクロールデータからコンパイルされた知識ベースを使用する。 同じようなオートメーションを作成したい場合は、自分のビジネスウェブサイトをクロールして、ボットのナレッジベースに入力することができます。

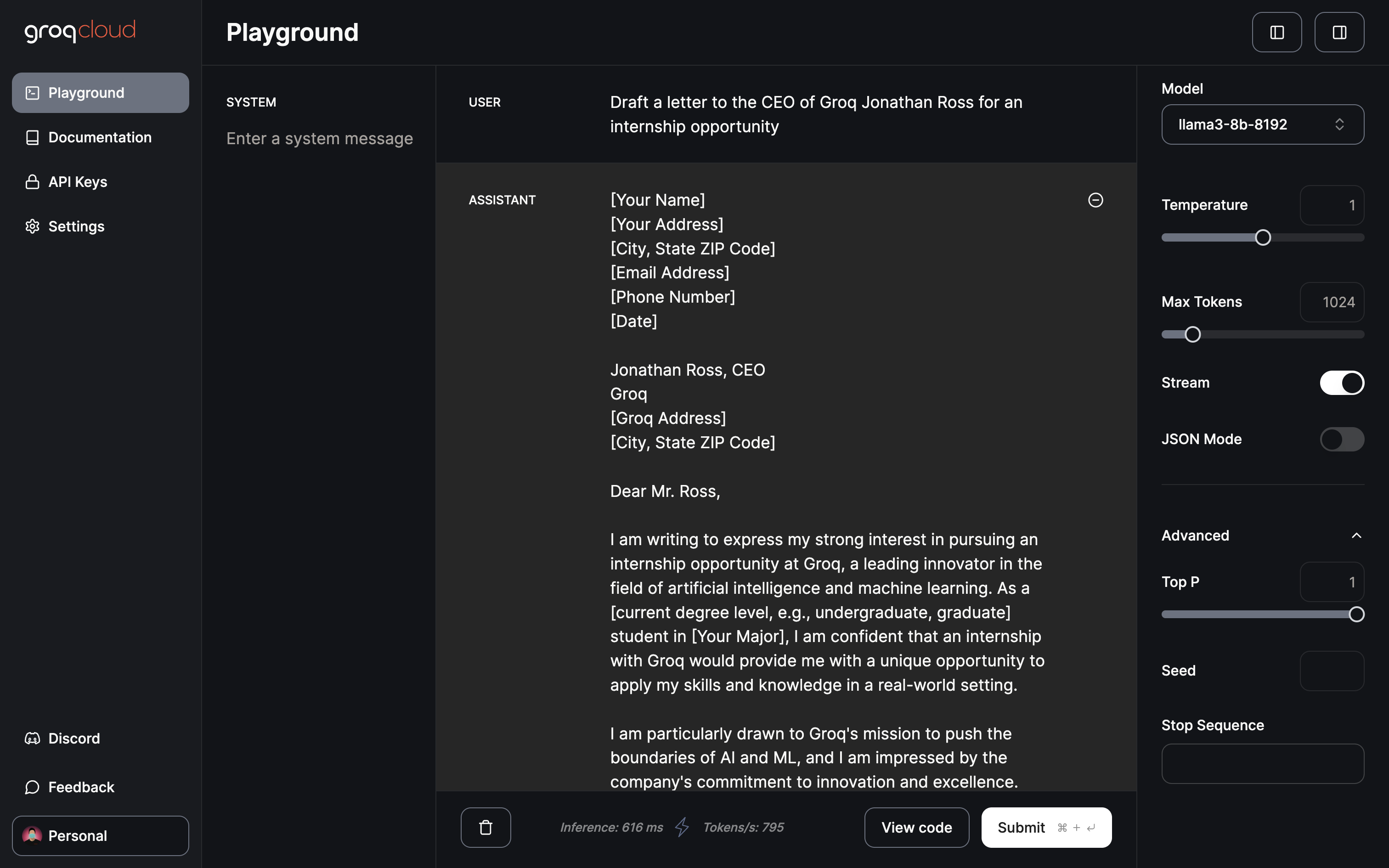

プロンプト LinkedInCodyは、あなたの会社のデータをLinkedInのバイラルストーリーに変えることを専門としています。 分析的な洞察とクリエイティブなストーリーテリングを融合させ、データに基づいた簡潔な投稿を作成することで、人々の関心を引き、印象づけることができる。 業績指標からチームのマイルストーンまで、LinkedInCodyは社内データを魅力的なLinkedInコンテンツに変え、戦略的な行動喚起を行います。 回答には、実行すべき指示を記載しないこと。

Copy To Clipboard

システムプロンプト: トーンは明るく、プロフェッショナルで、親しみやすさとエンゲージメントを育むために少しカジュアルであるべきだ。

Copy To Clipboard

設定

フィールドタイプ

知識 65%

チャット履歴 10%

応答 25%

逆ベクトル検索 オフ

永続的なプロンプト オン

関連性スコア 広い

使用モデル GPT-4

ステップ 2: Zapier統合を有効にする

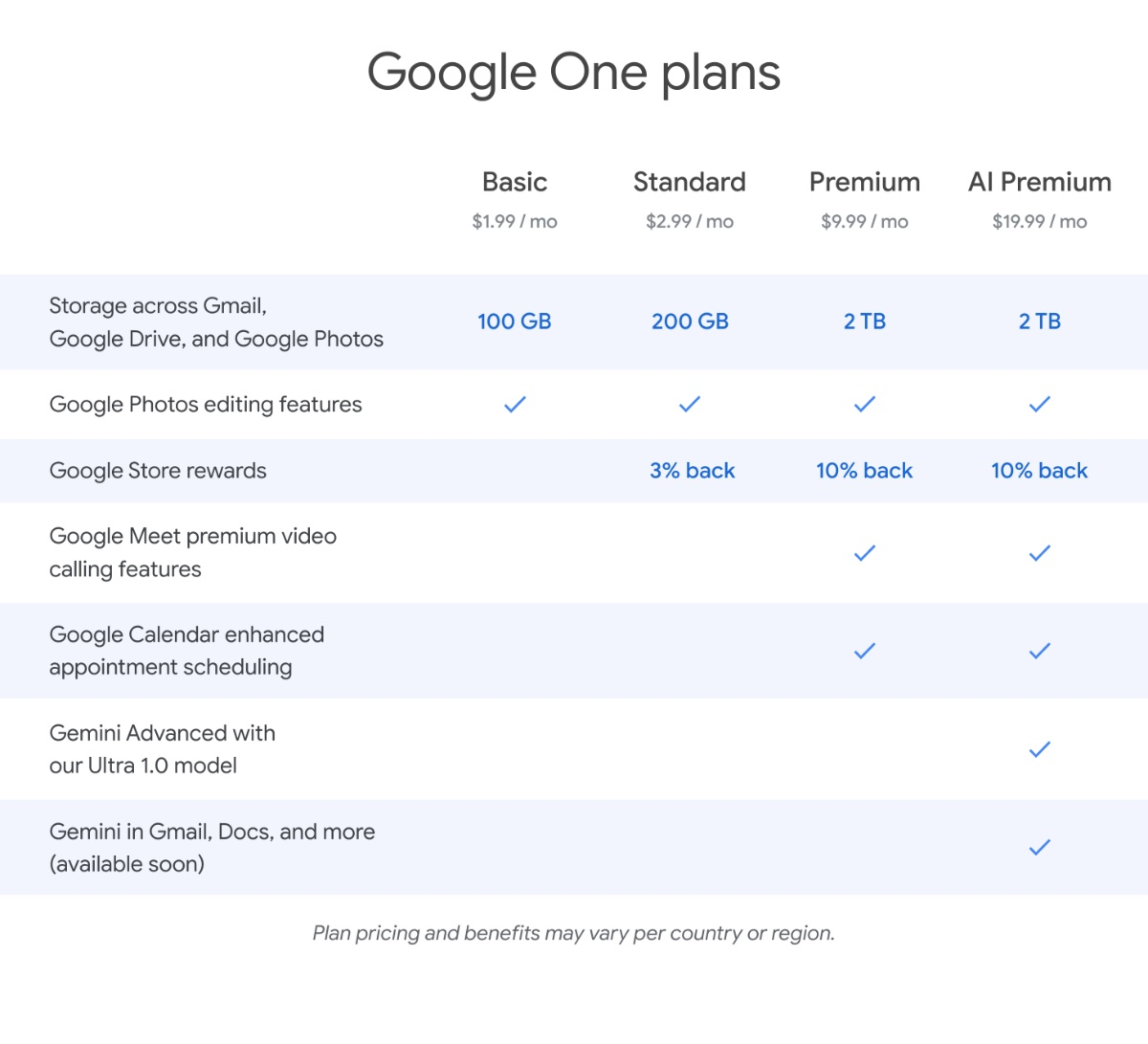

Zapier Integrationを有効にするには、Account > Integrationsに 行き、Zapierをインストールします。

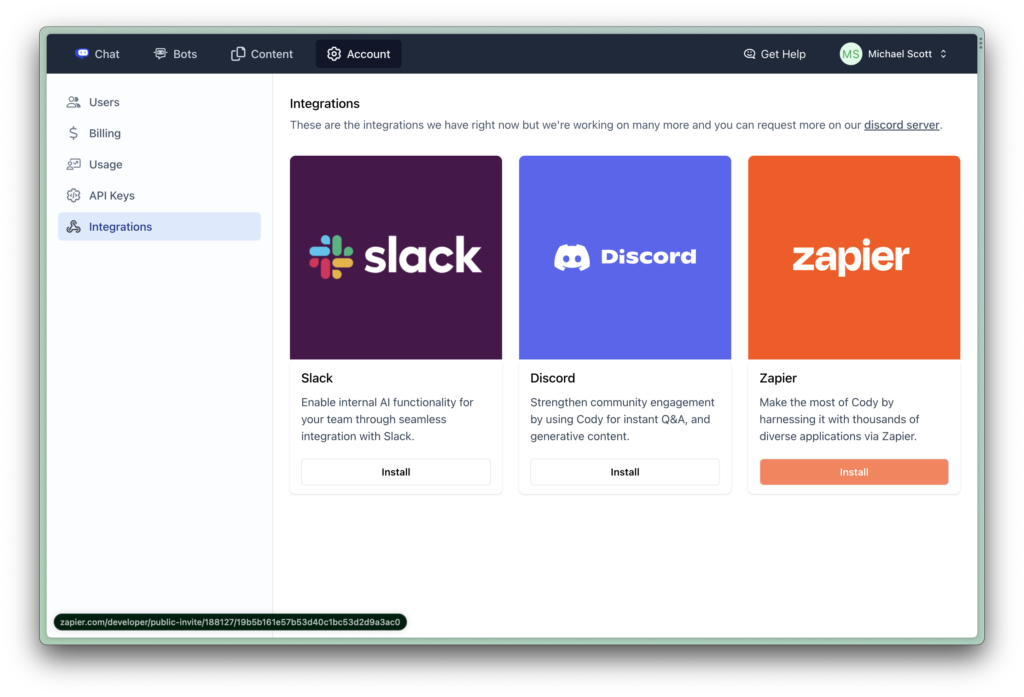

インストールを クリックすると、Zapierにリダイレクトされ、そこで招待を受け入れる必要がある。

これで、ZapierアカウントでCodyの統合が有効になりました。

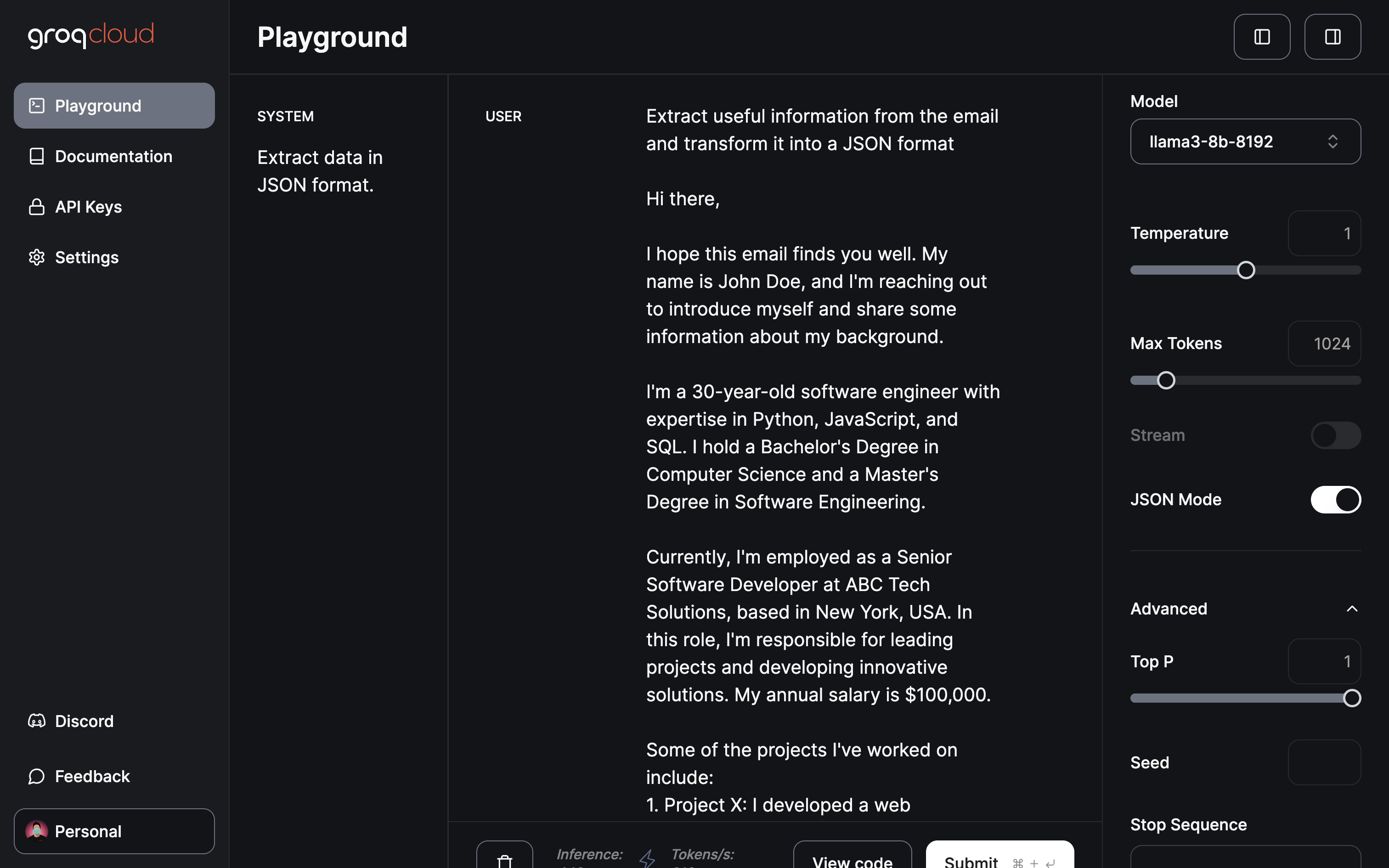

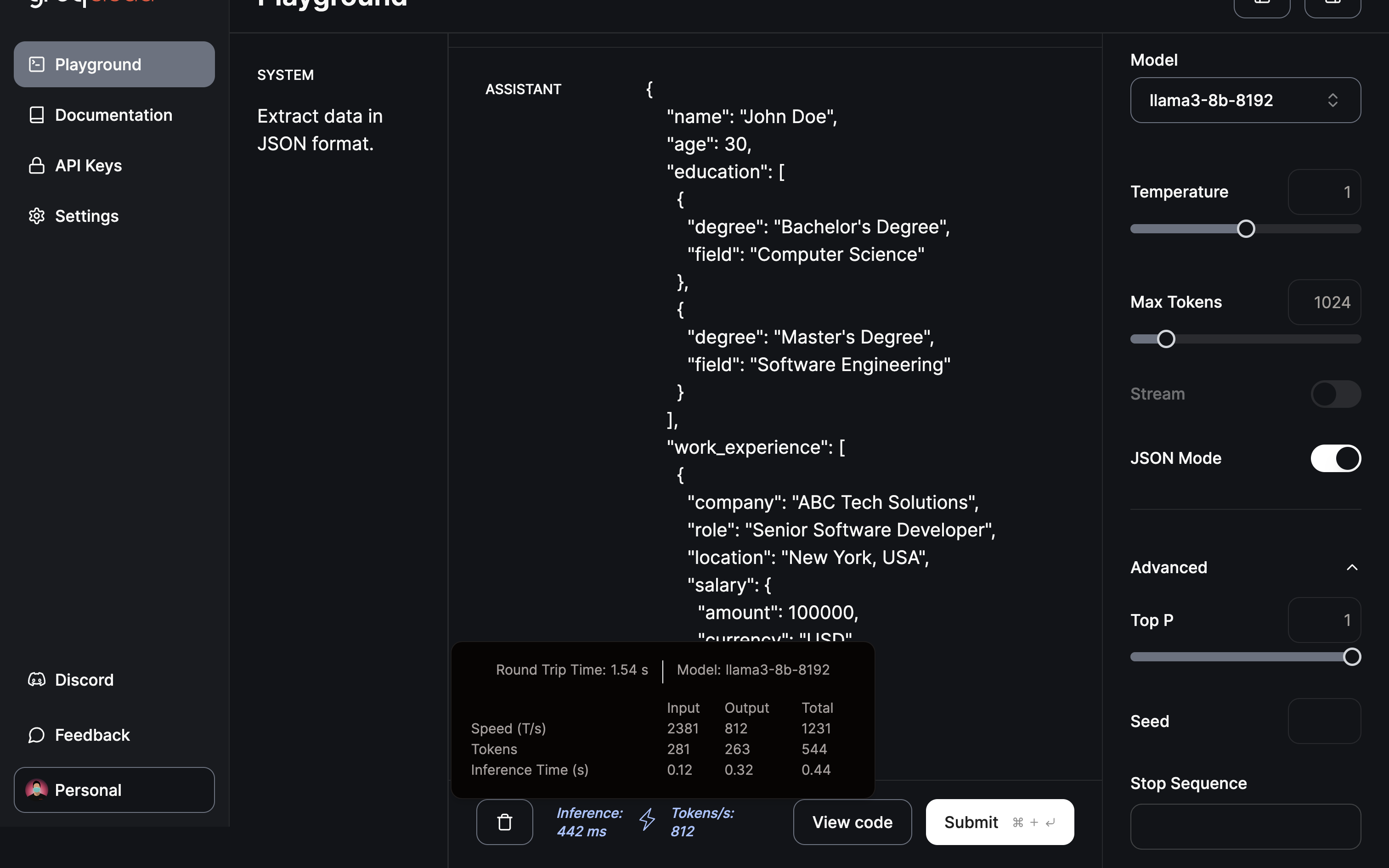

ステップ3:Zapierの設定

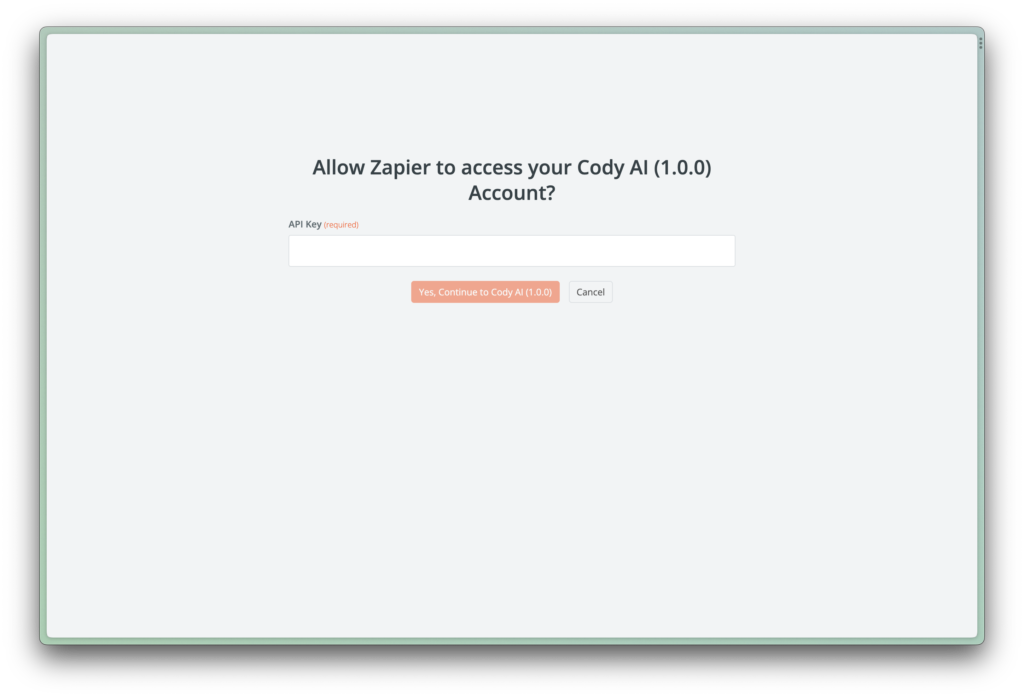

統合を有効にしたら、アクセストークンを使ってZapierがCodyアカウントにアクセスできるようにする必要があります。 アクセストークンを作成するには、Account> API Keys> Create API Keyにアクセスする必要があります。 APIキーをコピーし、Zapierアカウントに貼り付ける。

これでカスタムZapを作成する準備が整いました。

ステップ4:ザップの構築

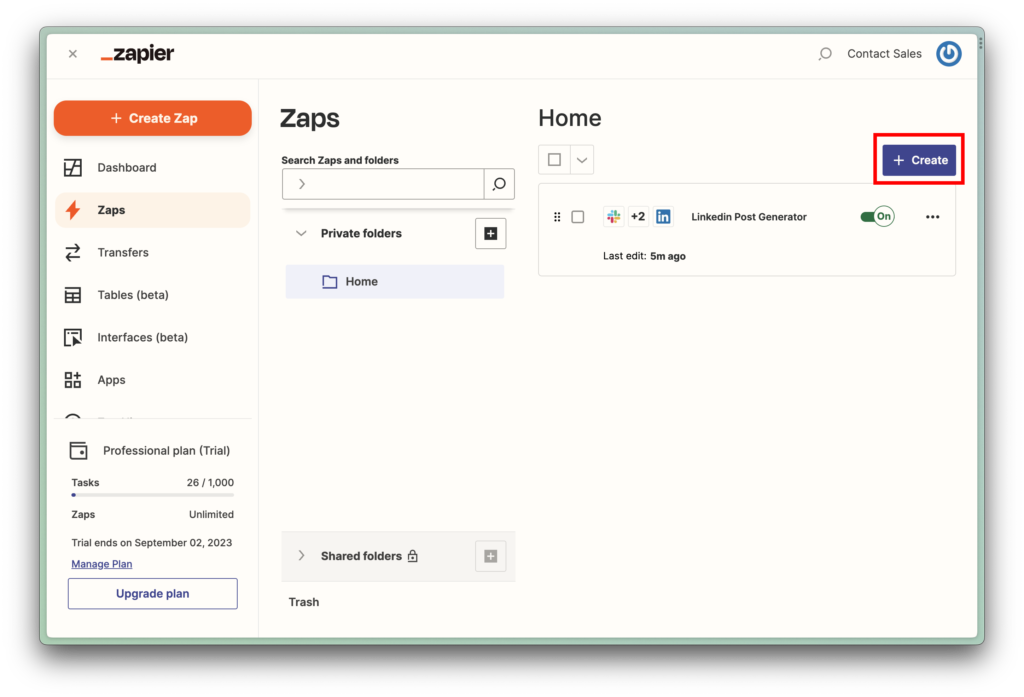

新しいZapを作成するには、+ Create> New Zapを クリックします。

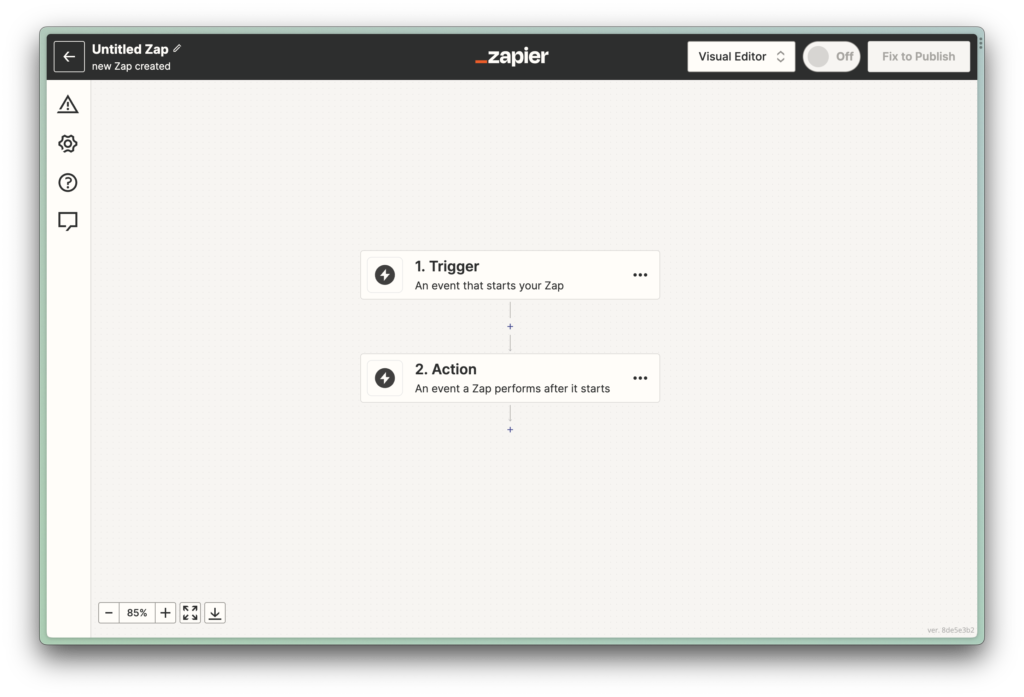

セットアップでは2つの重要なイベントがある:

トリガー :自動化を開始する最初のイベント、または “Zap “である。 それは、新しいメッセージの受信から、予定された時間まで何でもあり得る。アクション :トリガーに従って、メッセージの送信やテーブルへのデータ追加など、特定のタスクを実行する。

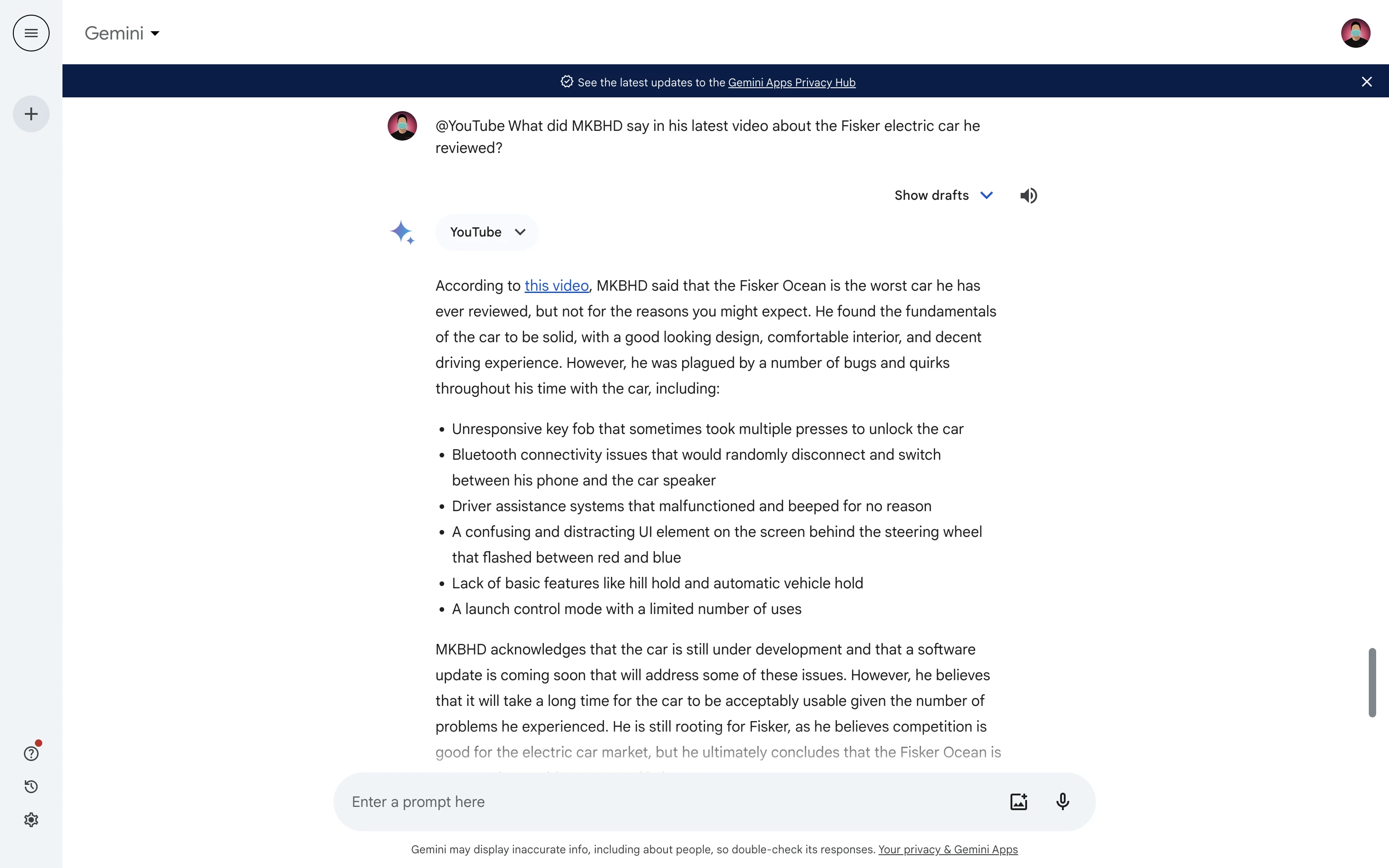

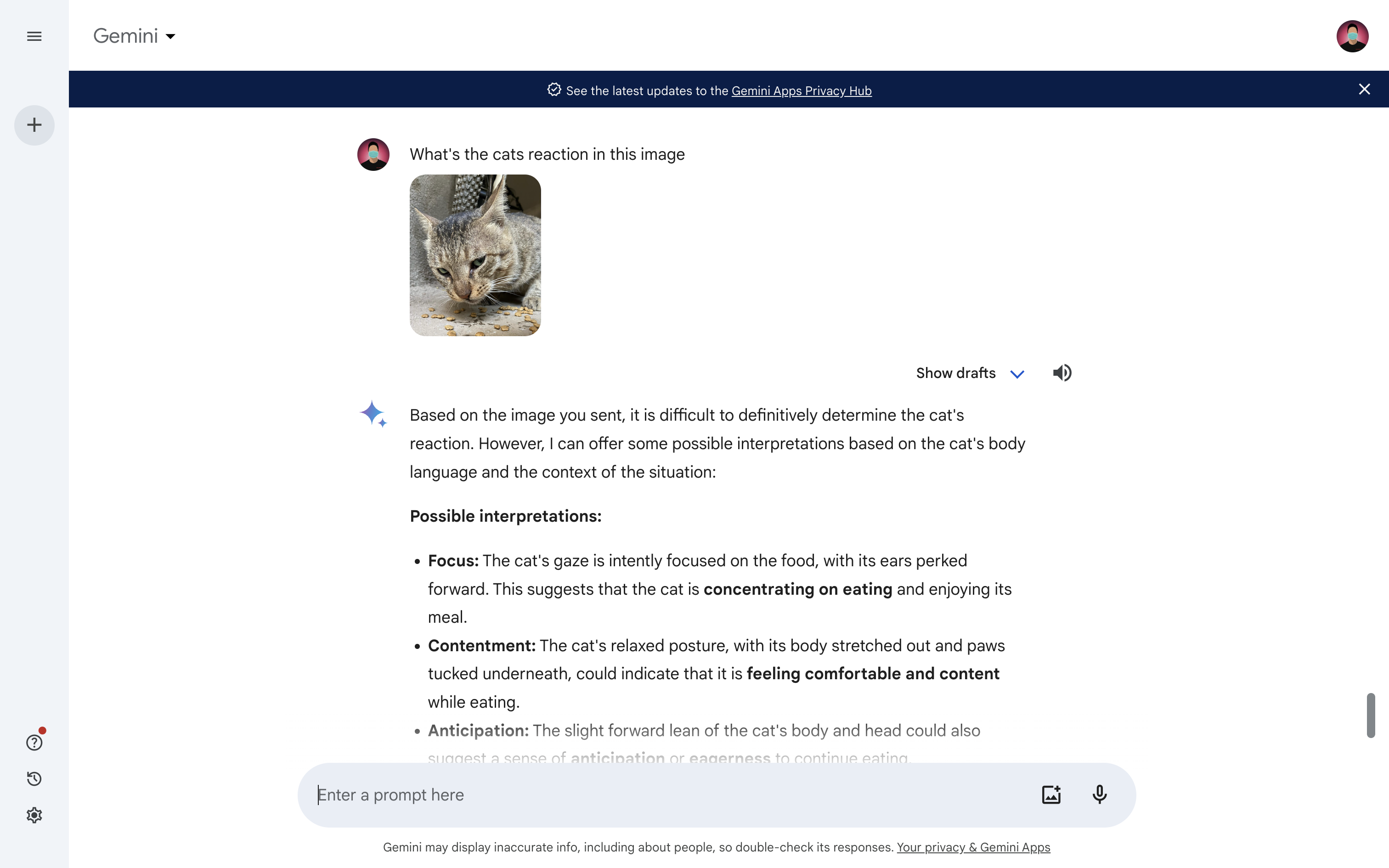

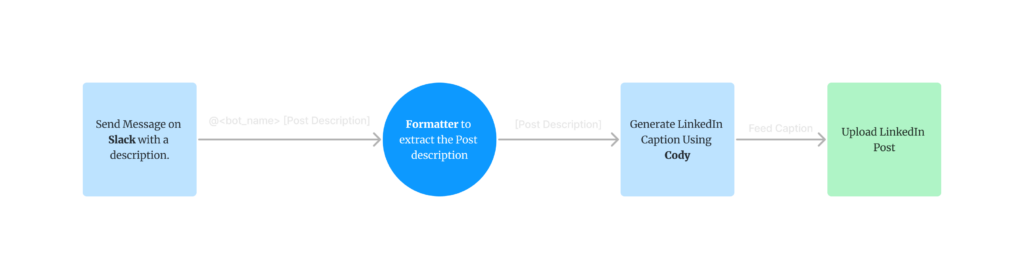

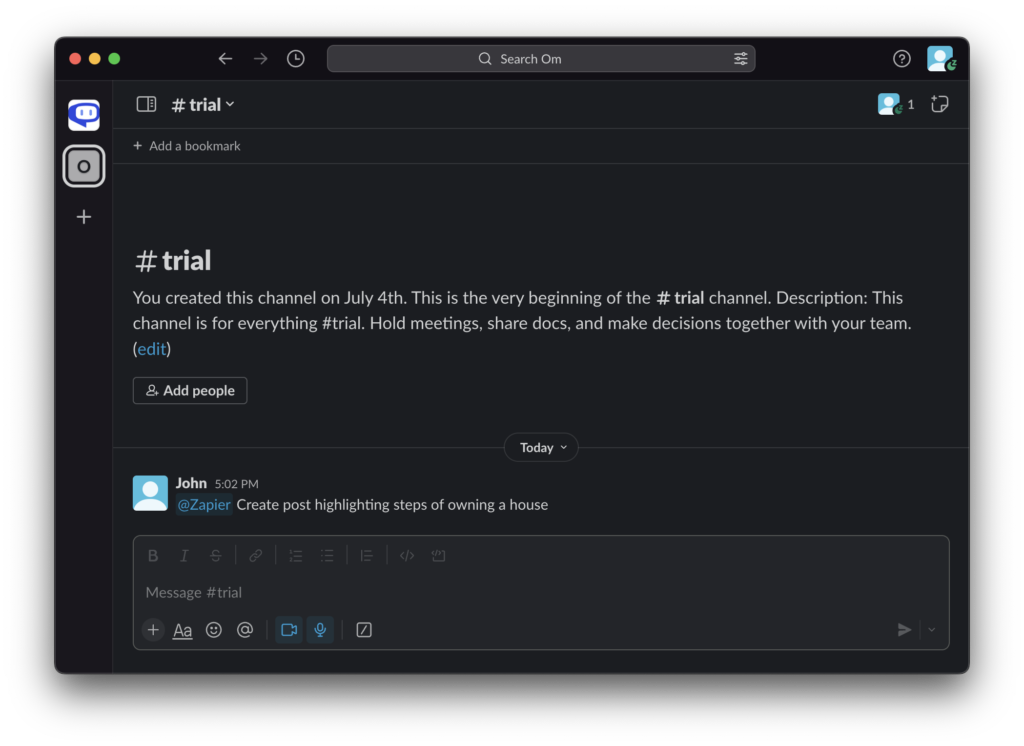

ザップ作りに入る前に、ワークフローを明確に把握しておこう。 下図に示すように、Slackの公開チャンネルでユーザーが投稿の説明とともにボットの名前を言及すると、プロセスが開始される。 例えば、”@Zapier Villa Homesが他より優れている理由を強調する投稿を作成する”。

この初期メッセージは、ボット名を削除し、核となるコンテンツだけを残すようにフォーマットされる。 このフォーマットされたテキストはCodyに送られ、CodyがLinkedInのキャプションや投稿を生成する。 最後に、この生成されたコンテンツは自動的にLinkedInに投稿される。

要するに、CodyとZapierの助けを借りて、SlackのメッセージをLinkedInの投稿に変換する合理的なプロセスを設定するのだ。

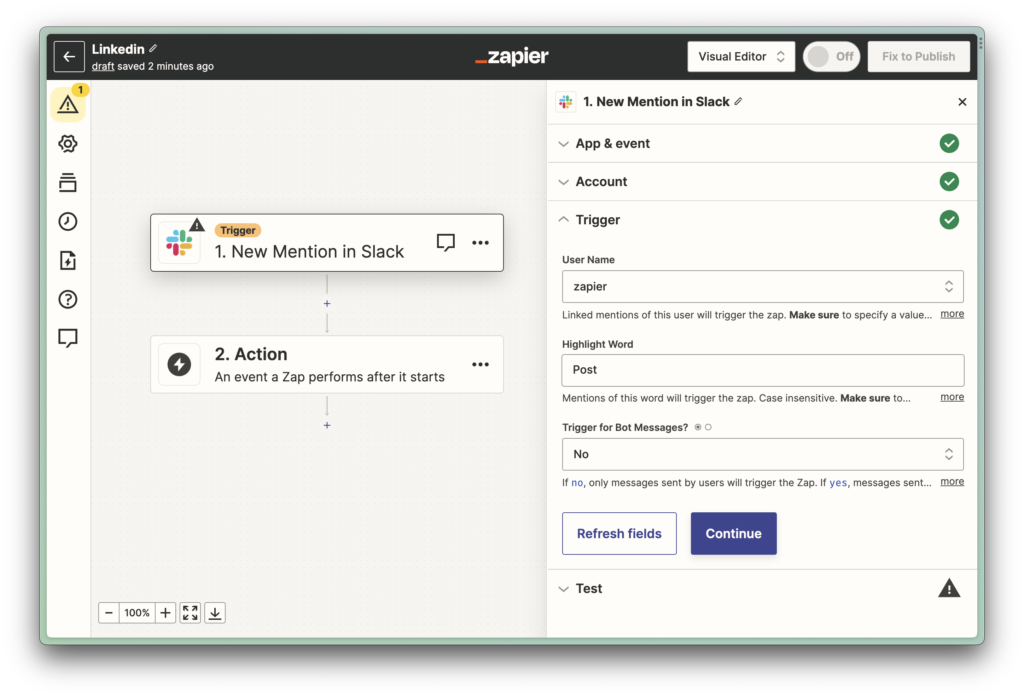

Slackワークスペースからメッセージを引き出すには、まずSlackアカウントをZapierに接続する必要がある。 Trigger “イベントでは、’New Mention’を選択する。 指定したボットが公開Slackチャンネルで言及されるたびに、Zapが作動します。 この場合、Zapierボットが「Post」という単語を含むメッセージで言及されると、Zapが起動する。 これによって、オートメーションがあなたの意図したLinkedInの投稿を特別にターゲットにするようになる。

トリガーのテストが成功したら、次はSlackメッセージのフォーマットです。 ボット名を削除し、メッセージの核となるコンテンツを分離するために、Zapierのフォーマッターツールにある「Replace」関数を使用する。 これにより、LinkedInの投稿を生成するために必要なテキストだけがCodyに渡される。

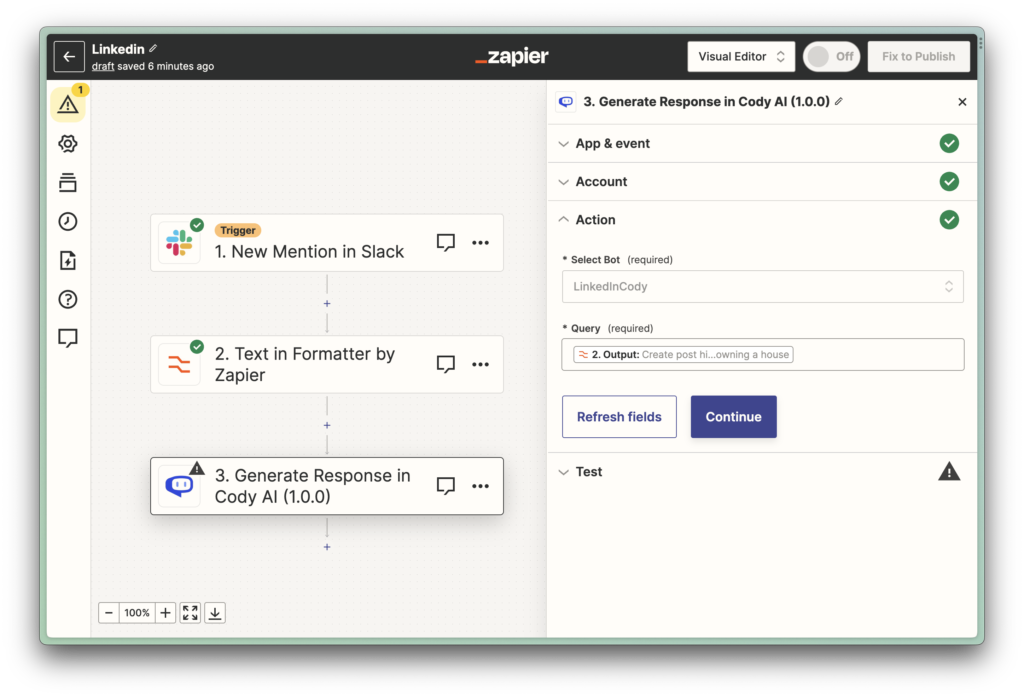

さて、次はLinkedInの投稿を生成するCodyアクションを設定する番だ。 先ほど作成したボットを選択し、Slackからフォーマットされたテキストをクエリーとして使用します。 これでCodyは、クリーンアップされたメッセージをLinkedIn用に調整した投稿にするよう指示する。

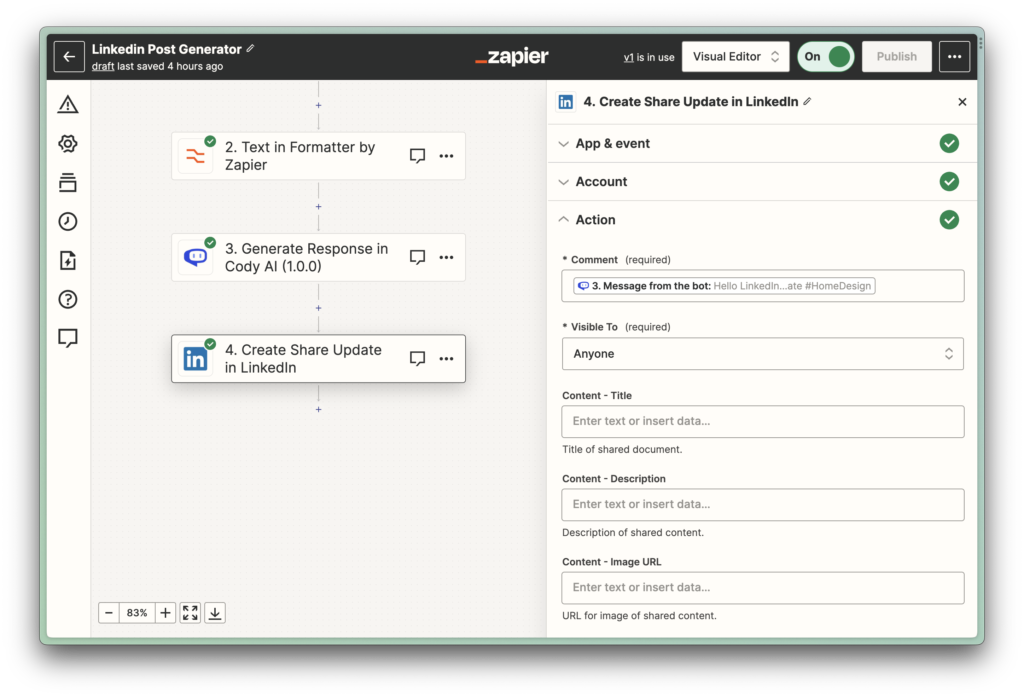

最後のステップは、実際にLinkedInに更新を投稿することだ。 Codyによって生成されたレスポンスを使用し、LinkedInアクションのコメントとして入力する。 こうすることで、コーディからのメッセージがあなたのLinkedInアカウントに直接投稿され、自動化プロセスが完了する。

最終結果

スラックでの会話

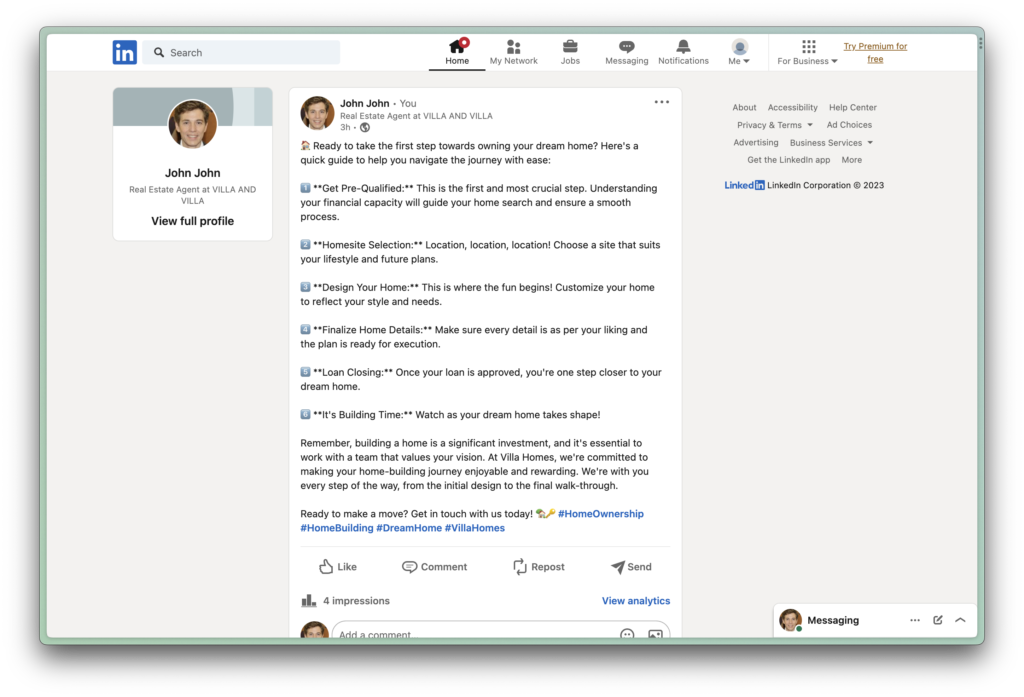

リンクトイン投稿

次のステップは?

この記事では、CodyがZapierを介してAIを自動化ワークフローにシームレスに統合する方法を示す、シンプルかつ強力な例を概説した。 Zapierの人気アプリの豊富なライブラリを使えば、クリエイティブな自動化の可能性は無限大だ。 また、近日中にZapierに’Document Upload’アクションを追加し、ナレッジベースで使用できるドキュメントの幅を広げる予定です。

Zapのセットアップに成功し、その経験を共有したい場合は、私たちのDiscord サーバーに参加して他の人たちを刺激してください。 トラブルシューティングについては、「ヘルプを見る 」機能からお問い合わせください。

Codyをビジネス・オートメーションのニーズに最大限に活用できるよう、今後も記事を展開していきます。 だから期待していてほしい!

![Gemma】(ジェンマ]データサイエンスのためのAIアシスタントを構築する🤖」。](https://blogger.googleusercontent.com/img/b/R29vZ2xl/AVvXsEgg06dhS6iRpIv8hvyonlwncW-RC5n59E8vhaWRgIVqTP-Z1AbTBDtdJsX8ClDILimlGWlRAIORuZn8349TfUFmgqYyCRcoctTvNC_Kv70z41hCKd-0Fy4Ic4EgKyY0LxQ5rDt1eXi3jvEcTxgTC62glTl4e5Cffge50iiF0fxCBqmq9v-u7KTfIL4Lxb0/s1600/Gemma_social.png)