Groq et Llama 3 : Un duo qui change la donne

Il y a quelques mois, une nouvelle entreprise baptisée “Groq” a émergé de nulle part, faisant une percée dans le secteur de l’IA. Ils ont fourni une plate-forme permettant aux développeurs d’accéder aux LPU en tant que moteurs d’inférence pour les LLM, en particulier ceux à code source ouvert tels que Llama, Mixtral et Gemma. Dans ce blog, nous allons explorer ce qui rend Groq si spécial et nous plonger dans les merveilles qui se cachent derrière les LPU.

Qu’est-ce que Groq ?

“Groq a pour mission d’établir la norme en matière de vitesse d’inférence GenAI, en aidant les applications d’IA en temps réel à voir le jour aujourd’hui. – Le site web de Groq

Groq n’est pas une entreprise qui développe des LLM comme GPT ou Gemini. Groq se concentre plutôt sur l’amélioration des fondements de ces grands modèles de langage, à savoir le matériel sur lequel ils fonctionnent. Il sert de “moteur d’inférence”. Actuellement, la plupart des LLM sur le marché utilisent des GPU traditionnels déployés sur des serveurs privés ou dans le nuage. Bien que ces GPU soient chers et puissants, provenant d’entreprises telles que Nvidia, ils reposent toujours sur l’architecture GPU traditionnelle, qui peut ne pas être adaptée de manière optimale à l’inférence LLM (bien qu’ils restent puissants et préférés pour les modèles d’entraînement).

Le moteur d’inférence fourni par Groq fonctionne sur des LPU (Language Processing Units).

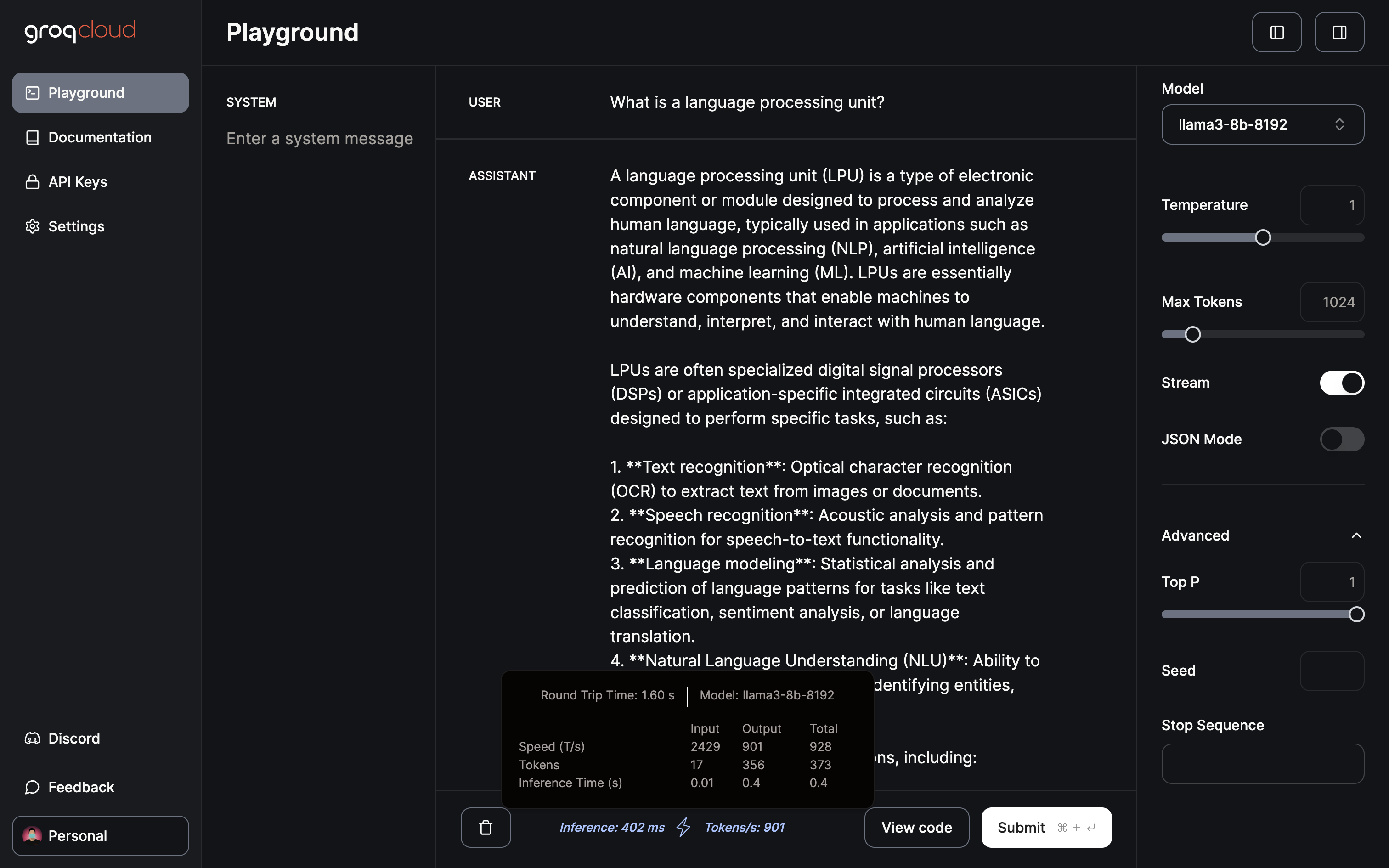

Qu’est-ce qu’un LPU ?

Une unité de traitement du langage est une puce spécialement conçue pour les LLM et repose sur une architecture unique combinant CPU et GPU pour transformer le rythme, la prévisibilité, la performance et la précision des solutions d’IA pour les LLM.

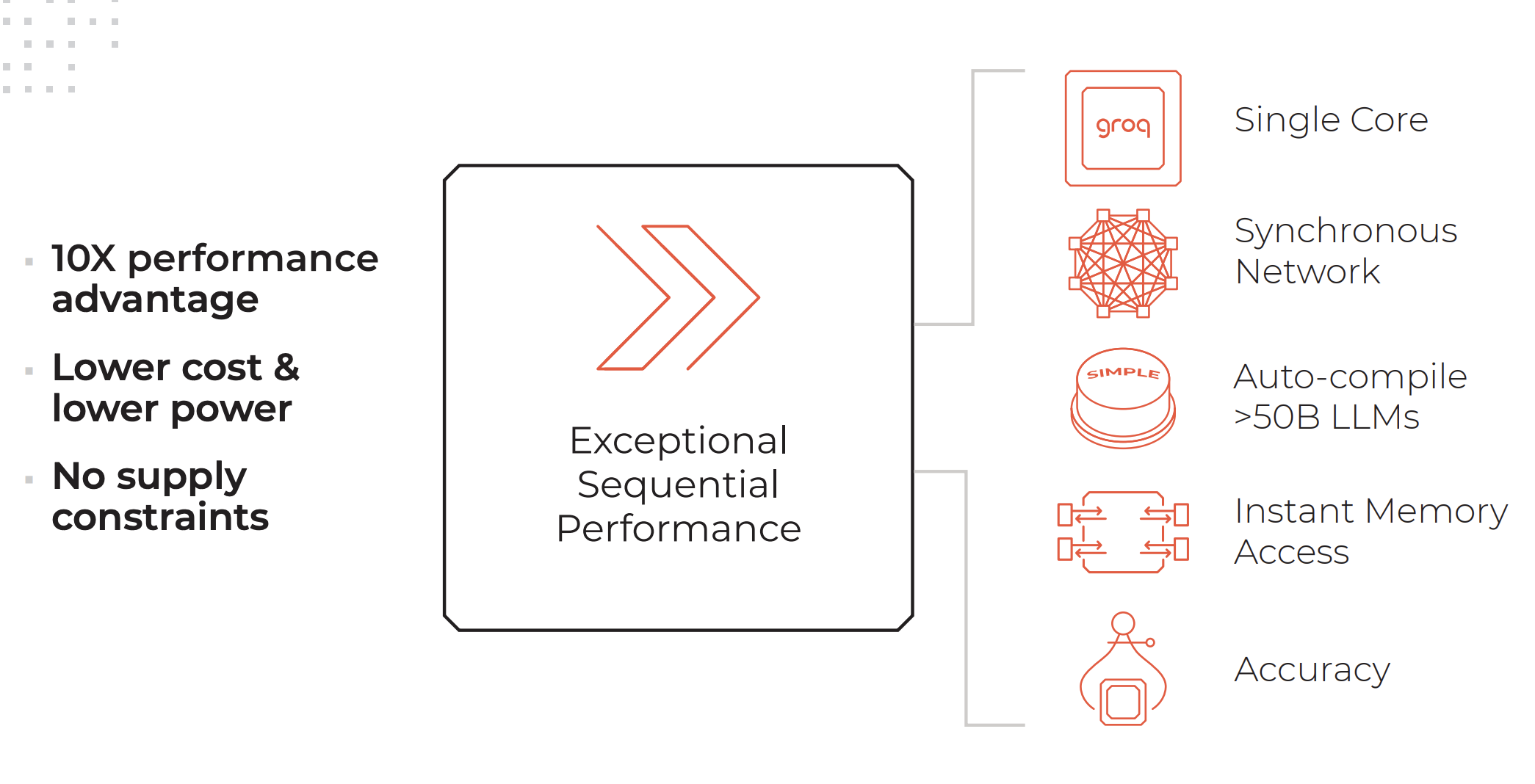

Caractéristiques principales d’un système LPU. Crédits : Groq

Un système LPU a autant ou plus de capacité de calcul qu’un processeur graphique (GPU) et réduit le temps de calcul par mot, ce qui permet de générer plus rapidement des séquences de texte.

Caractéristiques d’un moteur d’inférence LPU telles que listées sur le site web de Groq :

- Des performances séquentielles exceptionnelles

- Architecture à cœur unique

- Mise en réseau synchrone maintenue même pour les déploiements à grande échelle

- Possibilité de compiler automatiquement >50B LLMs

- Accès instantané à la mémoire

- Haute précision maintenue même à des niveaux de précision inférieurs

Services fournis par Groq :

- GroqCloud : LPUs sur le nuage

- GroqRack : rack 42U avec jusqu’à 64 puces interconnectées

- GroqNode : Système de calcul évolutif prêt à l’emploi en rack 4U comprenant huit accélérateurs GroqCard™ interconnectés.

- GroqCard : Une seule puce dans un format standard PCIe Gen 4×16 pour une intégration sans problème dans les serveurs.

“Contrairement au CPU qui a été conçu pour effectuer un type de tâche complètement différent de l’IA, ou au GPU qui a été conçu sur la base du CPU pour faire quelque chose qui ressemble à l’IA par accident, ou au TPU qui a modifié le GPU pour le rendre meilleur pour l’IA, Groq est dès le départ, selon les premiers principes, un système informatique pour l’IA”- Daniel Warfield, Towards Data Science

Pour en savoir plus sur les différences entre les LPU, les GPU, les TPU et les CPU, nous vous recommandons de lire cet article complet écrit par Daniel Warfield pour Towards Data Science.

Quel est l’intérêt de Groq ?

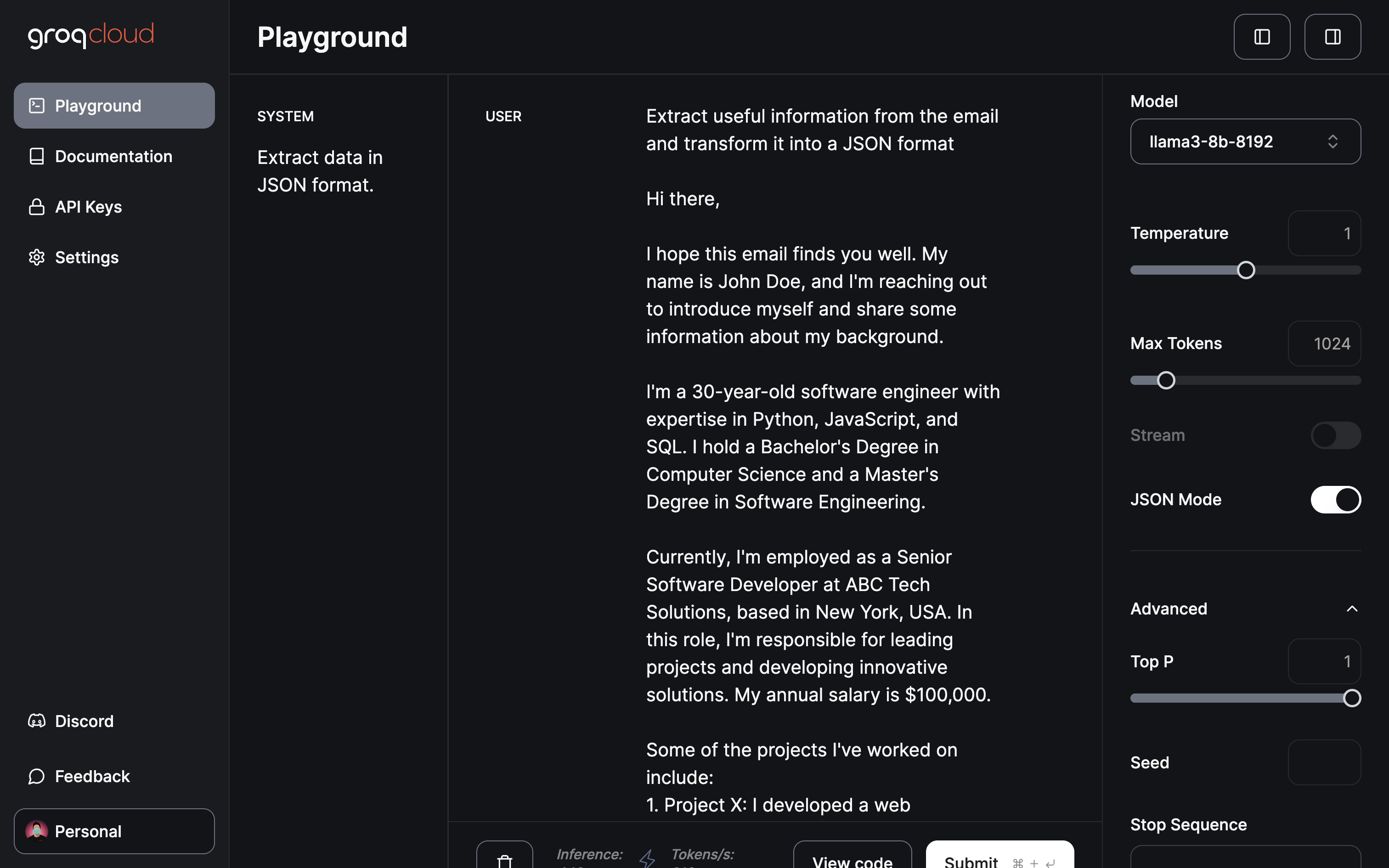

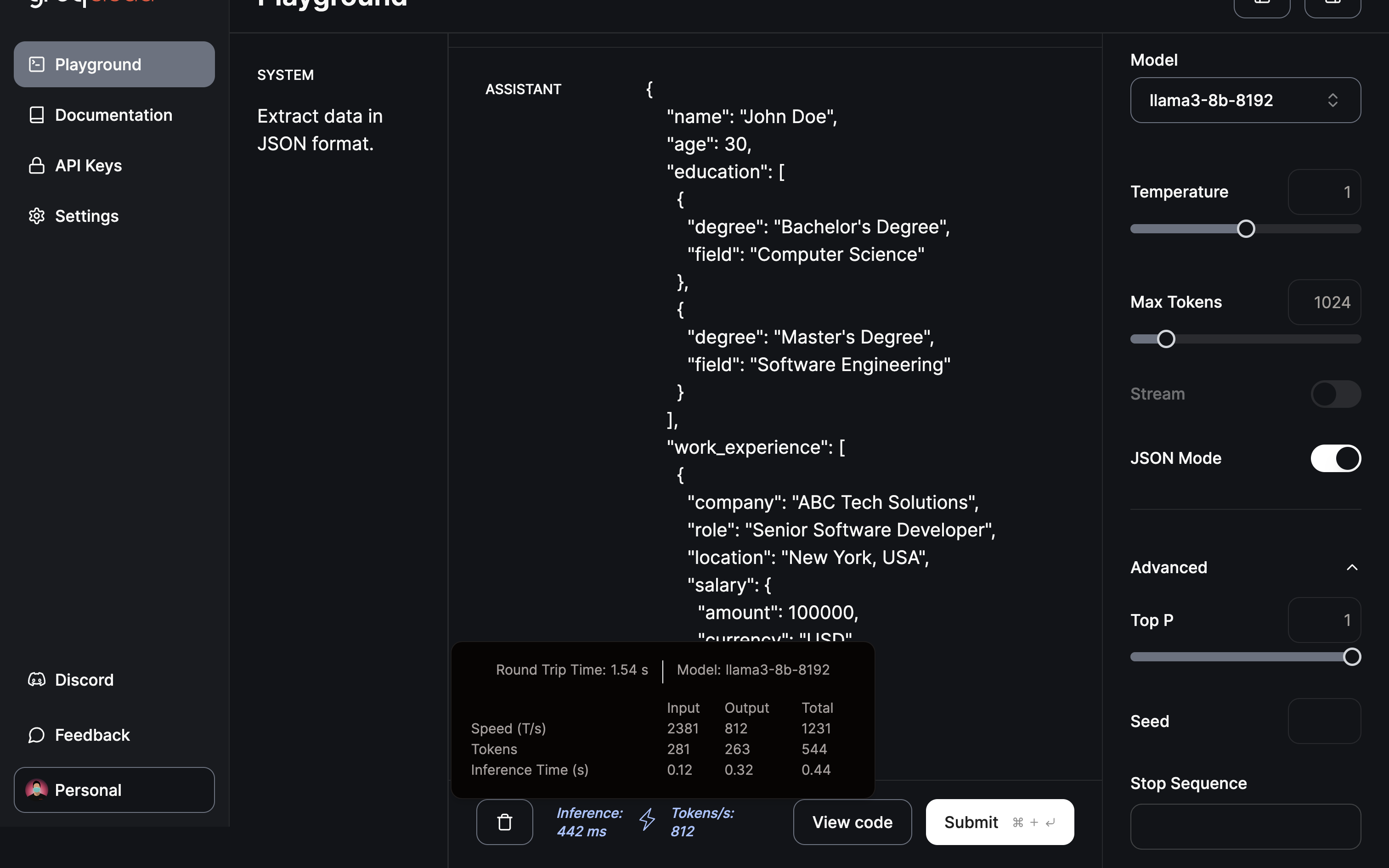

Les LLM sont incroyablement puissants, capables d’accomplir des tâches allant de l’analyse de données non structurées à la réponse à des questions sur la beauté des chats. Toutefois, leur principal inconvénient réside actuellement dans le temps de réponse. Le temps de réponse plus lent entraîne une latence significative lors de l’utilisation des LLM dans les processus backend. Par exemple, l’extraction de données d’une base de données et leur affichage au format JSON est actuellement beaucoup plus rapide lorsqu’elle est effectuée à l’aide d’une logique traditionnelle plutôt qu’en passant les données par un LLM pour les transformer. Cependant, l’avantage des LLM réside dans leur capacité à comprendre et à traiter les exceptions de données.

Grâce à l’incroyable vitesse d’inférence offerte par Groq, cet inconvénient des LLM peut être considérablement réduit. Cela permet d’améliorer et d’élargir les cas d’utilisation des LLM et de réduire les coûts, car avec une LPU, vous serez en mesure de déployer des modèles à source ouverte dont le fonctionnement est beaucoup moins coûteux et dont les temps de réponse sont très rapides.

Llama 3 sur Groq

Il y a quelques semaines, Meta a dévoilé sa dernière itération du logiciel libre LLM-Llama 3, déjà puissant et très performant. Outre les améliorations habituelles en matière de vitesse, de compréhension des données et de génération de jetons, deux améliorations significatives se distinguent :

- Entraîné sur un ensemble de données 7 fois plus grand que Llama 2, avec 4 fois plus de code.

- Doublement de la longueur du contexte à 8 000 jetons.

Llama 2 était déjà un formidable LLM open-source, mais avec ces deux mises à jour, les performances de Llama 3 devraient augmenter de manière significative.

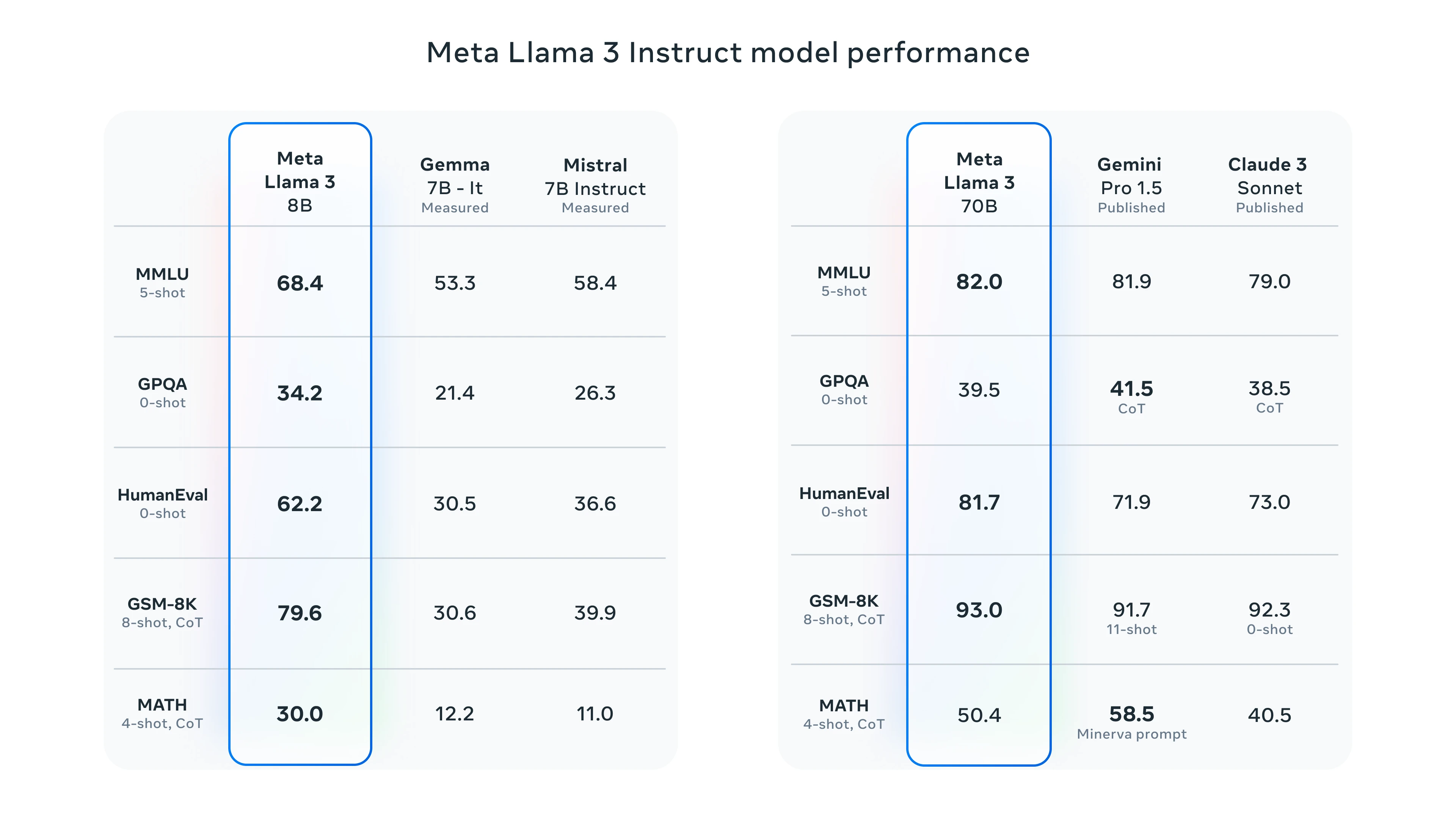

Llama 3 Benchmarks

Pour tester le Llama 3, vous avez la possibilité d’utiliser Meta AI ou le terrain de jeu Groq. Nous montrerons les performances de Groq en le testant avec Llama 3.

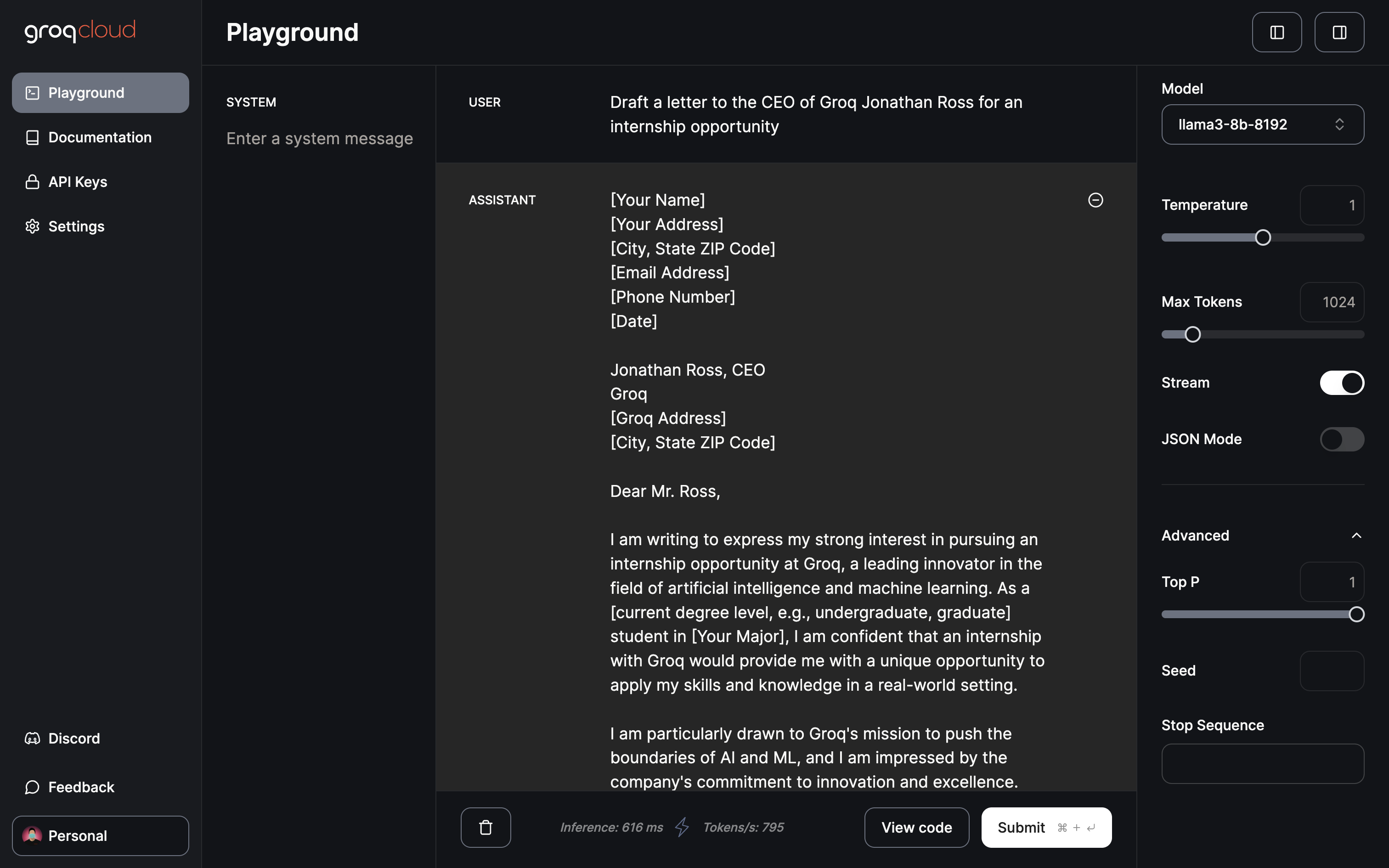

Terrain de jeux Groq

Actuellement, l’aire de jeux Groq offre un accès gratuit à Gemma 7B, Llama 3 70B et 8B, et Mixtral 8x7b. L’aire de jeu vous permet d’ajuster des paramètres tels que la température, le nombre maximum de jetons et la bascule de streaming. En outre, il dispose d’un mode JSON dédié qui permet de générer des sorties JSON uniquement.

Seulement 402 ms pour l’inférence à un taux de 901 tokens/s

J’en viens au domaine ou à l’application qui, à mon avis, a le plus d’impact, à savoir l’extraction et la transformation des données :

Demander au modèle d’extraire des informations utiles et fournir un JSON en utilisant le mode JSON.

L’extraction et la transformation au format JSON ont été réalisées en moins d’une demi-seconde.

Conclusion

Comme nous l’avons démontré, Groq a changé la donne dans le domaine du LLM grâce à son moteur d’inférence LPU innovant. La transformation rapide présentée ici laisse entrevoir l’immense potentiel d’accélération des applications de l’IA. Pour l’avenir, on ne peut que spéculer sur les futures innovations de Groq. Une unité de traitement d’images pourrait peut-être révolutionner les modèles de génération d’images, contribuant ainsi à faire progresser la génération de vidéos par l’IA. En effet, c’est un avenir passionnant à anticiper.

À l’avenir, alors que la formation LLM devient plus efficace, la possibilité d’avoir un ChatGPT personnalisé, affiné avec vos données sur votre appareil local, devient une perspective alléchante. Une plateforme qui offre de telles capacités est Cody, un assistant intelligent d’IA conçu pour soutenir les entreprises dans divers aspects. Tout comme ChatGPT, Cody peut être formé sur les données de votre entreprise, votre équipe, vos processus et vos clients, en utilisant votre base de connaissances unique.

Avec Cody, les entreprises peuvent exploiter la puissance de l’IA pour créer un assistant personnalisé et intelligent qui répond spécifiquement à leurs besoins, ce qui en fait un ajout prometteur au monde des solutions professionnelles basées sur l’IA.