Groq y Llama 3: Un dúo que cambia el juego

Hace un par de meses, una nueva empresa llamada “Groq” surgió aparentemente de la nada, haciendo un gran avance en la industria de la IA. Proporcionaron una plataforma para que los desarrolladores accedieran a las LPU como motores de inferencia para los LLM, especialmente los de código abierto como Llama, Mixtral y Gemma. En este blog, vamos a explorar qué hace que Groq sea tan especial y a profundizar en la maravilla que hay detrás de las LPU.

¿Qué es Groq?

“Groq tiene la misión de establecer el estándar para la velocidad de inferencia de GenAI, ayudando a que las aplicaciones de IA en tiempo real cobren vida hoy”. – El sitio web de Groq

Groq no es una empresa que desarrolle LLMs como GPT o Gemini. En cambio, Groq se centra en mejorar los fundamentos de estos grandes modelos lingüísticos: el hardware sobre el que funcionan. Sirve de “motor de inferencia”. Actualmente, la mayoría de los LLM del mercado utilizan GPU tradicionales desplegadas en servidores privados o en la nube. Aunque estas GPU son caras y potentes, y proceden de empresas como Nvidia, siguen basándose en la arquitectura tradicional de GPU, que puede no ser la más adecuada para la inferencia LLM (aunque siguen siendo potentes y las preferidas para los modelos de entrenamiento).

El motor de inferencia proporcionado por Groq funciona sobre LPUs – Unidades de Procesamiento del Lenguaje.

¿Qué es una LPU?

Una Unidad de Procesamiento Lingüístico es un chip diseñado específicamente para los LLM y se basa en una arquitectura única que combina CPU y GPU para transformar el ritmo, la previsibilidad, el rendimiento y la precisión de las soluciones de IA para los LLM.

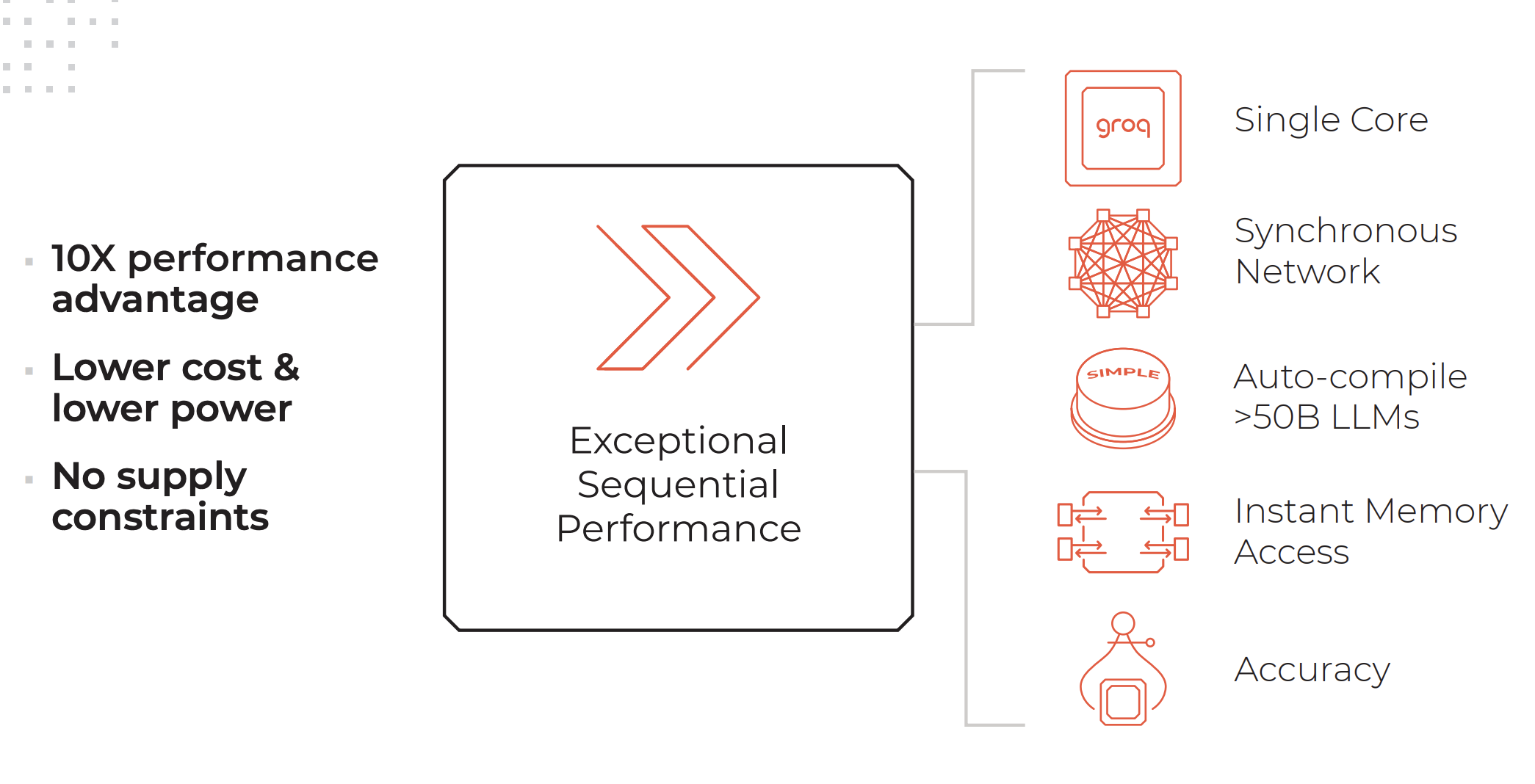

Atributos clave de un sistema LPU. Créditos: Groq

Un sistema LPU tiene tanto o más cálculo que un procesador gráfico (GPU) y reduce el tiempo de cálculo por palabra, lo que permite generar secuencias de texto más rápidamente.

Características de un motor de inferencia LPU según la lista del sitio web de Groq:

- Rendimiento secuencial excepcional

- Arquitectura mononúcleo

- Red sincrónica que se mantiene incluso en despliegues a gran escala

- Capacidad de autocompilación >50B LLMs

- Acceso instantáneo a la memoria

- Alta precisión que se mantiene incluso a niveles de precisión más bajos

Servicios prestados por Groq:

- GroqCloud: LPUs en la nube

- GroqRack: rack de 42U con hasta 64 chips interconectados

- GroqNode: Sistema informático escalable de 4U preparado para rack que incluye ocho aceleradores GroqCard™ interconectados

- GroqCard: Un único chip en un factor de forma estándar PCIe Gen 4×16 que proporciona una integración sin problemas en el servidor

“A diferencia de la CPU que se diseñó para hacer un tipo de tarea completamente diferente a la IA, o de la GPU que se diseñó basándose en la CPU para hacer algo parecido a la IA por accidente, o de la TPU que modificó la GPU para hacerla mejor para la IA, Groq es desde el principio, primeros principios, un sistema informático para la IA”- Daniel Warfield, Towards Data Science

Para saber más sobre en qué se diferencian las LPU de las GPU, las TPU y las CPU, te recomendamos que leas este completo artículo escrito por Daniel Warfield para Towards Data Science.

¿Para qué sirve Groq?

Los LLM son increíblemente potentes, capaces de realizar tareas que van desde analizar datos no estructurados hasta responder preguntas sobre la ternura de los gatos. Sin embargo, su principal inconveniente reside actualmente en el tiempo de respuesta. La lentitud del tiempo de respuesta provoca una latencia significativa cuando se utilizan LLM en procesos backend. Por ejemplo, obtener datos de una base de datos y mostrarlos en formato JSON es actualmente mucho más rápido cuando se hace utilizando la lógica tradicional en lugar de pasar los datos por un LLM para su transformación. Sin embargo, la ventaja de los LLM reside en su capacidad para comprender y manejar las excepciones de datos.

Con la increíble velocidad de inferencia que ofrece Groq, este inconveniente de los LLM puede reducirse enormemente. Esto abre casos de uso mejores y más amplios para los LLM y reduce los costes, ya que con una LPU podrás desplegar modelos de código abierto que son mucho más baratos de ejecutar con tiempos de respuesta realmente rápidos.

Llama 3 en Groq

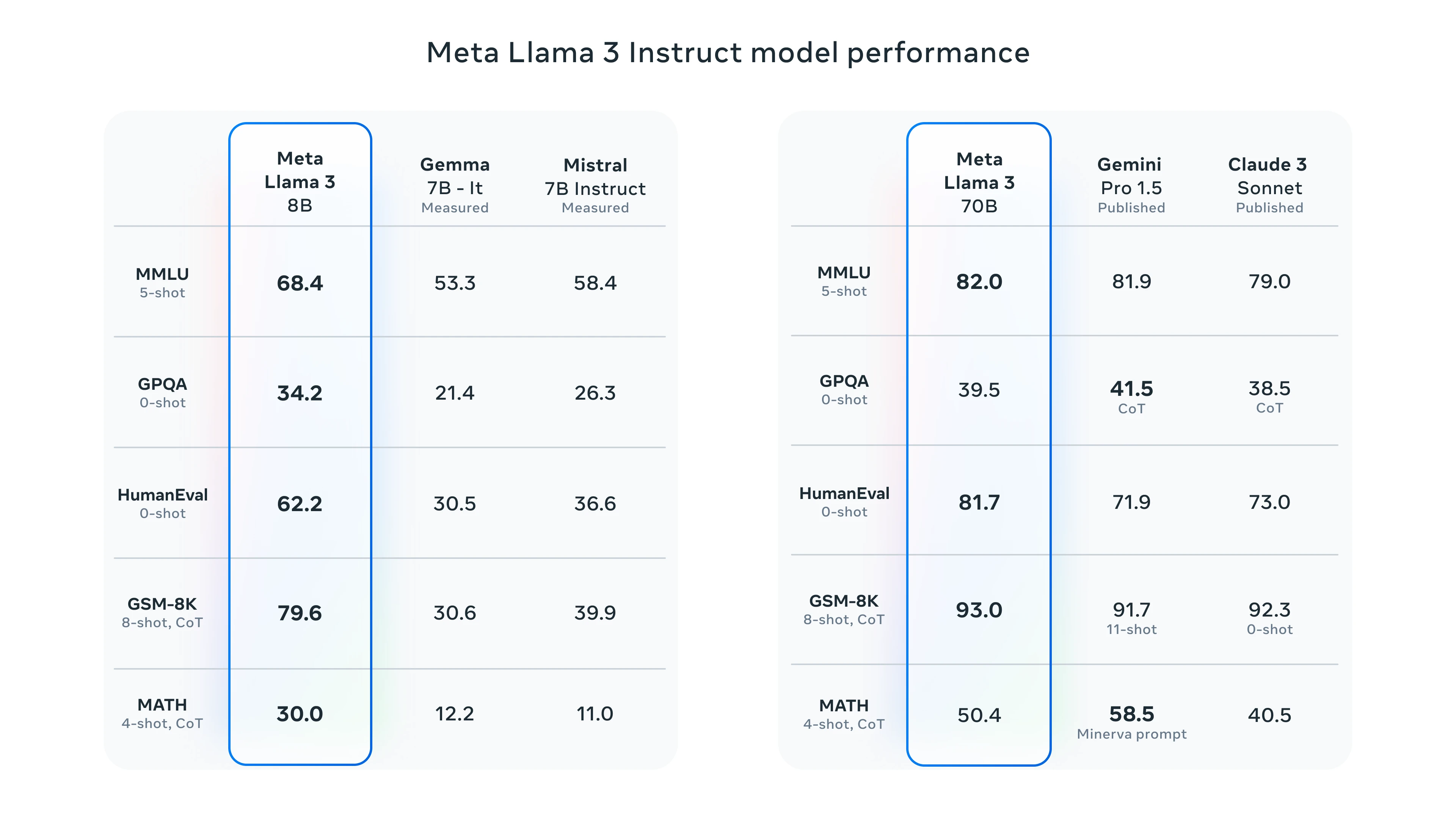

Hace un par de semanas, Meta presentó su última iteración del ya potente y muy capaz LLM-Llama 3 de código abierto. Junto a las mejoras típicas de velocidad, comprensión de datos y generación de fichas, destacan dos mejoras significativas:

- Entrenado en un conjunto de datos 7 veces mayor que Llama 2, con 4 veces más código.

- Duplicada la longitud del contexto a 8.000 fichas.

Llama 2 ya era un formidable LLM de código abierto, pero con estas dos actualizaciones, se espera que el rendimiento de Llama 3 aumente significativamente.

Puntos de referencia de Llama 3

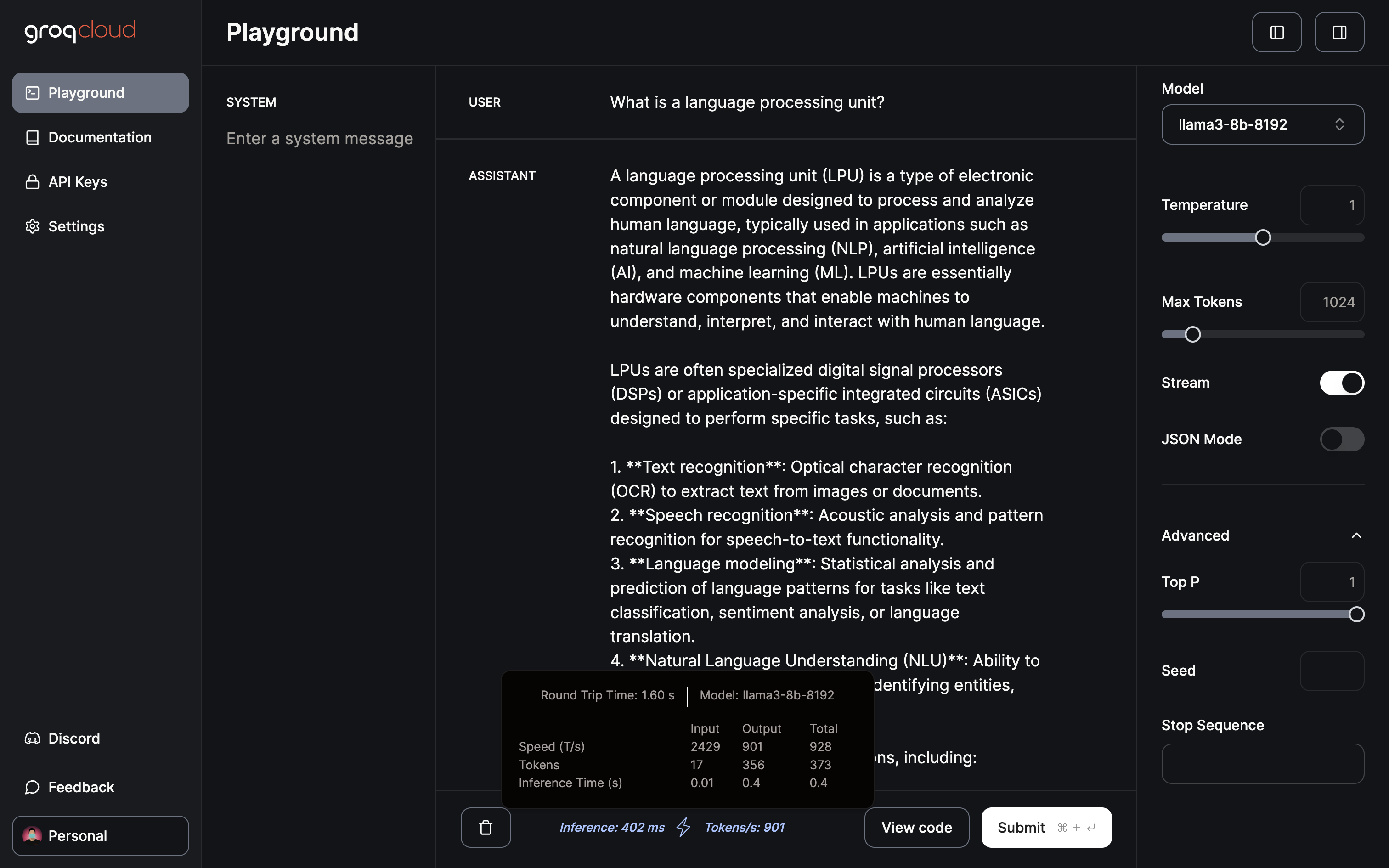

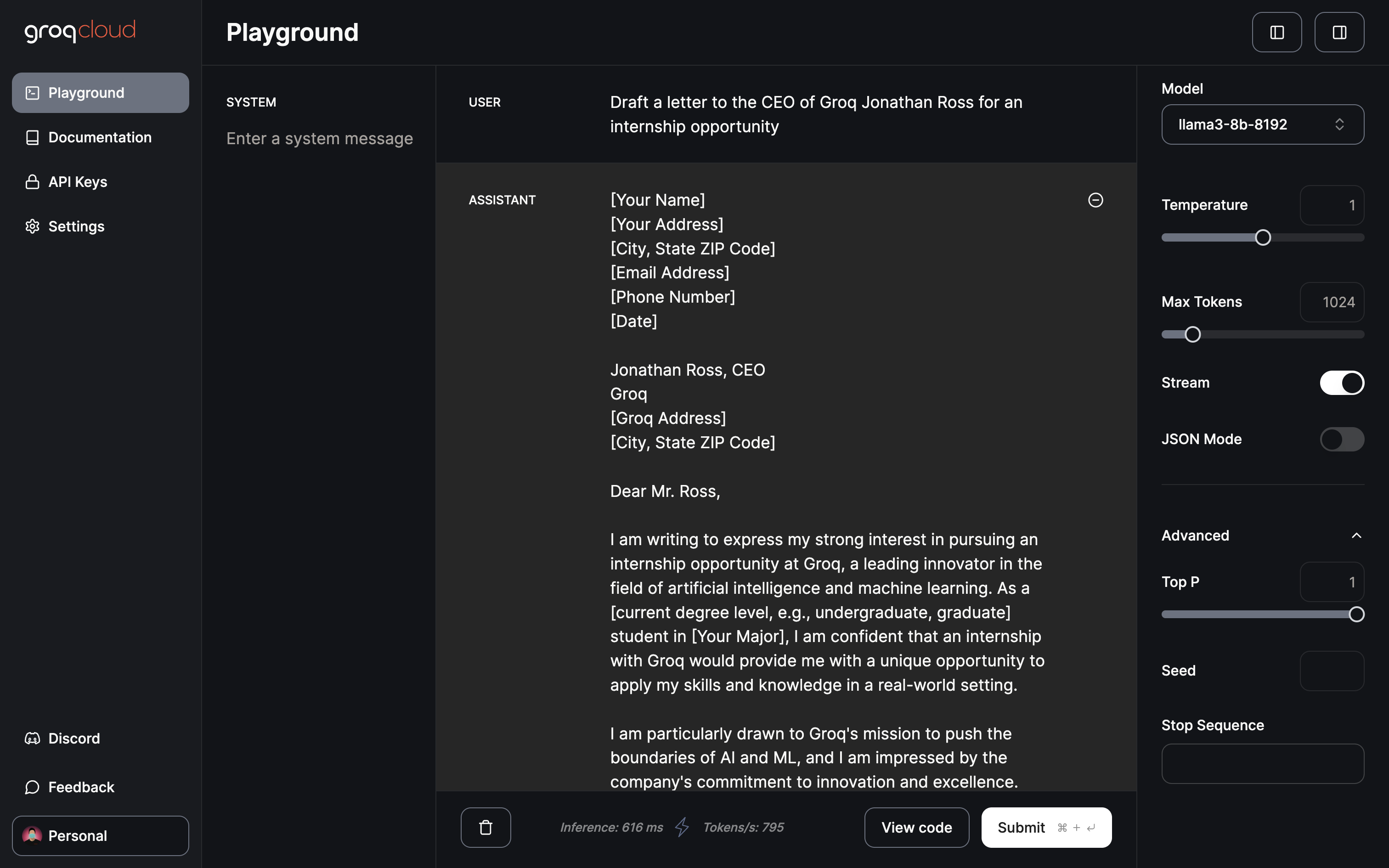

Para probar Llama 3, tienes la opción de utilizar Meta AI o el patio de recreo Groq. Mostraremos el rendimiento de Groq probándolo con Llama 3.

Parque infantil Groq

Actualmente, el parque infantil Groq ofrece acceso gratuito a Gemma 7B, Llama 3 70B y 8B, y Mixtral 8x7b. El campo de juego te permite ajustar parámetros como la temperatura, el máximo de fichas y la alternancia de secuencias. Además, cuenta con un modo JSON dedicado para generar sólo salida JSON.

Sólo 402 ms para la inferencia a un ritmo de 901 tokens/s

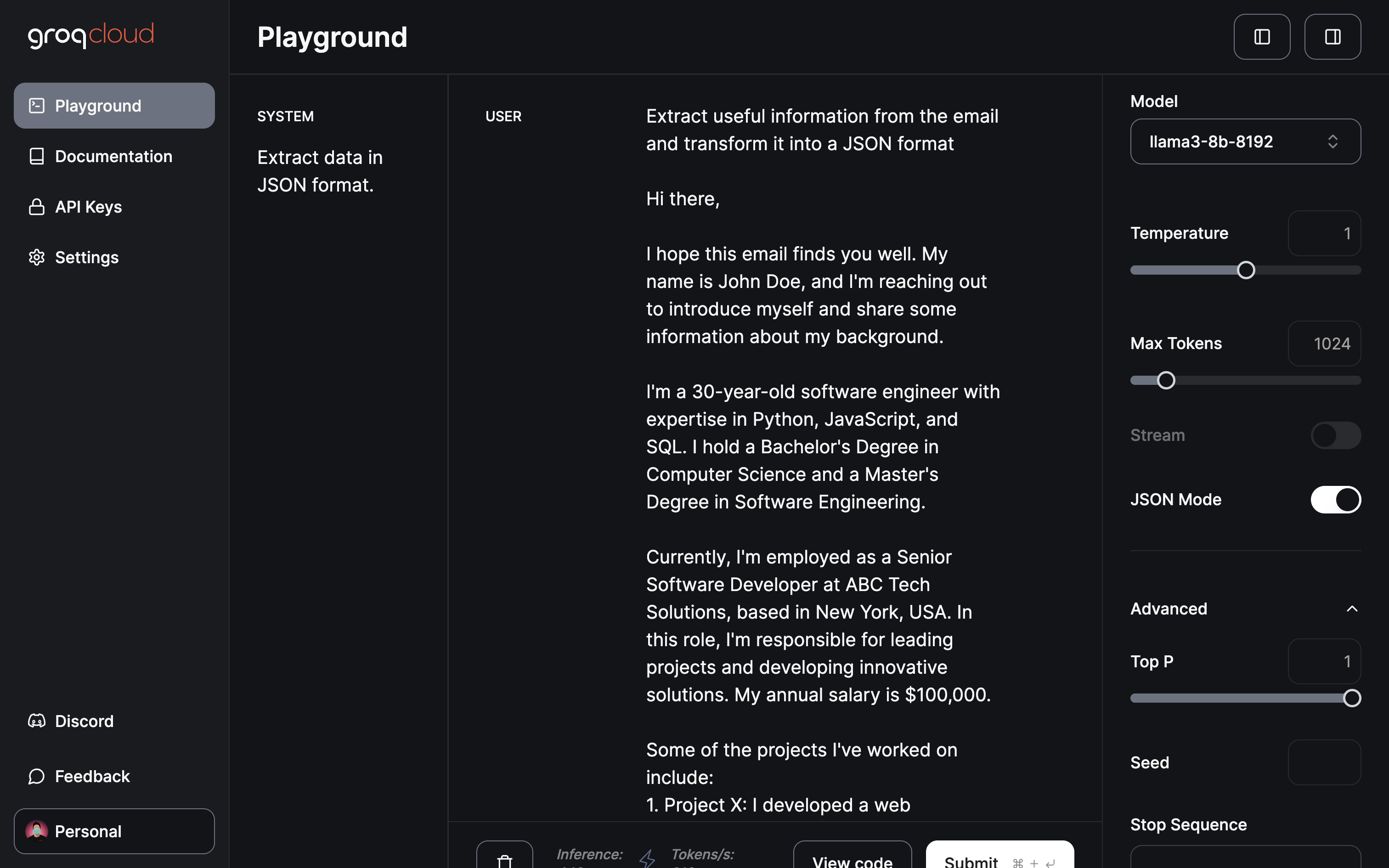

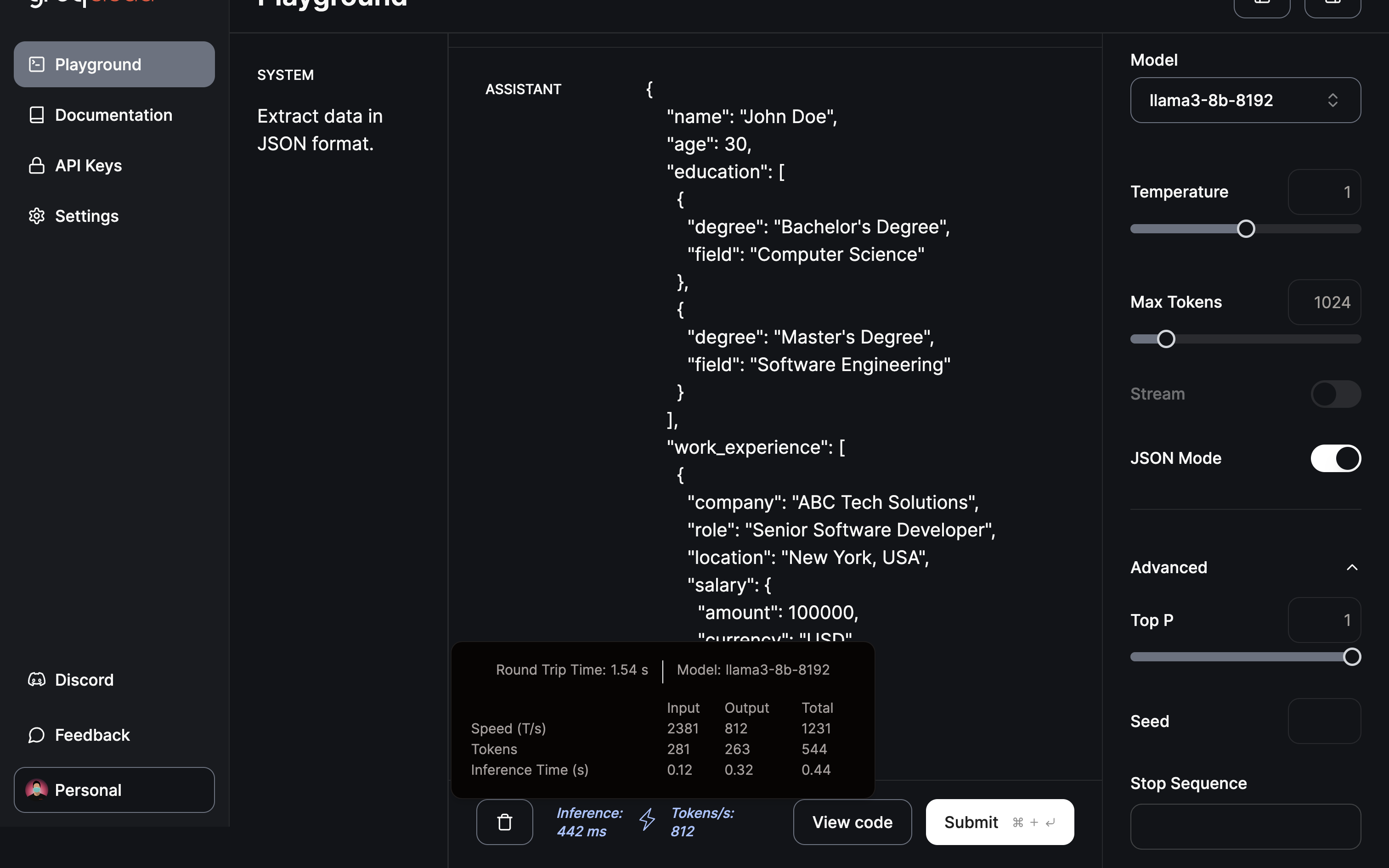

Llegando al dominio/aplicación más impactante en mi opinión, la extracción y transformación de datos:

Pedir al modelo que extraiga información útil y proporcionar un JSON utilizando el modo JSON.

La extracción y transformación a formato JSON se completó en menos de medio segundo.

Conclusión

Como se ha demostrado, Groq ha surgido como un cambio de juego en el panorama del LLM con su innovador motor de inferencia LPU. La rápida transformación que aquí se muestra es un indicio del inmenso potencial para acelerar las aplicaciones de la IA. De cara al futuro, sólo cabe especular sobre las futuras innovaciones de Groq. Tal vez, una Unidad de Procesamiento de Imágenes podría revolucionar los modelos de generación de imágenes, contribuyendo a los avances en la generación de vídeo con IA. En efecto, es un futuro apasionante que anticipar.

De cara al futuro, a medida que la formación LLM sea más eficiente, la posibilidad de disponer de un ChatGPT personalizado, ajustado con tus datos en tu dispositivo local, se convierte en una perspectiva tentadora. Una plataforma que ofrece estas capacidades es Cody, un asistente inteligente de IA hecho a medida para ayudar a las empresas en diversos aspectos. Al igual que ChatGPT, Cody puede ser entrenado en los datos de su negocio, equipo, procesos y clientes, utilizando su base de conocimientos única.

Con Cody, las empresas pueden aprovechar el poder de la IA para crear un asistente personalizado e inteligente que atienda específicamente a sus necesidades, lo que lo convierte en una prometedora incorporación al mundo de las soluciones empresariales basadas en IA.