그루크와 라마 3: 판도를 바꾸는 듀오

몇 달 전, ‘Groq’이라는 새로운 회사가 갑자기 등장해 AI 업계에 혁신을 일으켰습니다. 이들은 개발자들이 LLM, 특히 라마, 믹스트랄, 젬마와 같은 오픈 소스 엔진의 추론 엔진으로서 LPU에 액세스할 수 있는 플랫폼을 제공했습니다. 이 블로그에서는 Groq이 특별한 이유를 살펴보고 LPU의 놀라운 기능에 대해 자세히 알아보세요.

Groq이란 무엇인가요?

“Groq은 GenAI 추론 속도의 표준을 정립하여 오늘날 실시간 AI 애플리케이션을 실현하는 데 기여하는 것을 사명으로 삼고 있습니다.” – Groq 웹사이트

Groq은 GPT나 Gemini와 같은 LLM을 개발하는 회사가 아닙니다. 대신 Groq은 이러한 대규모 언어 모델의 기반, 즉 작동하는 하드웨어를 개선하는 데 집중합니다. ‘추론 엔진’ 역할을 합니다. 현재 시장에 나와 있는 대부분의 LLM은 프라이빗 서버나 클라우드에 배포된 기존 GPU를 활용합니다. 이러한 GPU는 엔비디아 같은 회사에서 공급하는 고가의 강력한 제품이지만, 여전히 전통적인 GPU 아키텍처에 의존하기 때문에 LLM 추론에 최적으로 적합하지 않을 수 있습니다(여전히 강력하고 훈련 모델에 선호되지만).

Groq에서 제공하는 추론 엔진은 LPU(언어 처리 장치)에서 작동합니다.

LPU란 무엇인가요?

언어 처리 장치는 LLM을 위해 특별히 설계된 칩으로, CPU와 GPU를 결합한 고유한 아키텍처를 기반으로 구축되어 LLM용 AI 솔루션의 속도, 예측 가능성, 성능 및 정확성을 혁신합니다.

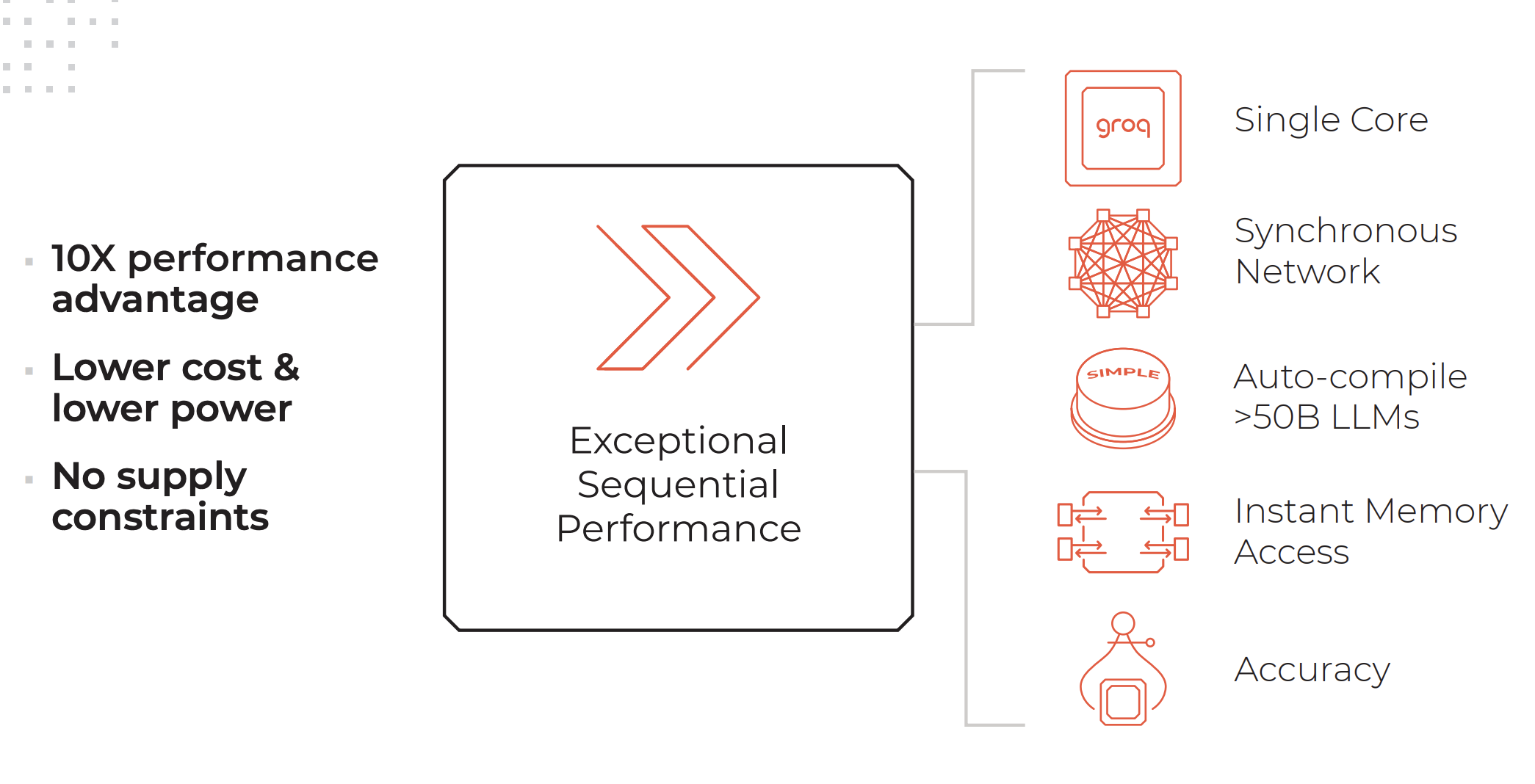

LPU 시스템의 주요 속성. 크레딧: Groq

LPU 시스템은 그래픽 프로세서(GPU)만큼 또는 그 이상의 연산 능력을 갖추고 있으며, 단어당 계산 시간을 줄여 텍스트 시퀀스를 더 빠르게 생성할 수 있습니다.

Groq 웹사이트에 나와 있는 LPU 추론 엔진의 특징:

- 탁월한 순차적 성능

- 단일 코어 아키텍처

- 대규모 배포 시에도 유지되는 동기식 네트워킹

- 자동 컴파일 기능( >50B LLM)

- 즉각적인 메모리 액세스

- 낮은 정밀도 수준에서도 유지되는 높은 정확도

Groq에서 제공하는 서비스:

- GroqCloud: 클라우드의 LPU

- GroqRack: 최대 64개의 칩이 상호 연결된 42U 랙

- GroqNode: 4U 랙 지원 확장형 컴퓨팅 시스템으로, 8개의 상호 연결된 GroqCard™ 가속기를 갖추고 있습니다.

- GroqCard: 표준 PCIe 4×16 폼 팩터의 단일 칩으로 번거로움 없는 서버 통합을 제공합니다.

“AI와 완전히 다른 유형의 작업을 수행하도록 설계된 CPU나 우연히 AI와 비슷한 작업을 수행하도록 CPU를 기반으로 설계된 GPU, 또는 AI에 더 적합하도록 GPU를 수정한 TPU와 달리, Groq은 처음부터 처음부터 AI를 위한 컴퓨터 시스템입니다.”- Daniel Warfield, Towards Data Science.

LPU가 GPU, TPU 및 CPU와 어떻게 다른지 자세히 알아보려면 Daniel Warfield가 Towards Data Science에 작성한 이 종합적인 글을 읽어보시기 바랍니다.

Groq의 요점은 무엇인가요?

LLM은 비정형 데이터 구문 분석부터 고양이의 귀여움에 대한 질문에 답하는 것까지 다양한 작업을 수행할 수 있는 매우 강력한 기능입니다. 그러나 현재 가장 큰 단점은 응답 시간입니다. 응답 시간이 느리면 백엔드 프로세스에서 LLM을 사용할 때 상당한 지연 시간이 발생합니다. 예를 들어, 데이터베이스에서 데이터를 가져와 JSON 형식으로 표시하는 작업은 현재 변환을 위해 LLM을 통해 데이터를 전달하는 것보다 기존 로직을 사용하는 것이 훨씬 빠릅니다. 그러나 LLM의 장점은 데이터 예외를 이해하고 처리하는 능력에 있습니다.

Groq이 제공하는 놀라운 추론 속도를 활용하면 LLM의 이러한 단점을 크게 줄일 수 있습니다. 이렇게 하면 LLM의 사용 사례가 더 넓어지고 비용을 절감할 수 있으며, LPU를 사용하면 훨씬 저렴하고 응답 시간이 매우 빠른 오픈 소스 모델을 배포할 수 있습니다.

Groq의 라마 3

몇 주 전 메타는 이미 강력하고 뛰어난 성능을 자랑하는 오픈 소스 LLM-Llama 3의 최신 버전을 공개했습니다. 속도, 데이터 이해도, 토큰 생성 등 일반적인 개선 사항과 함께 두 가지 중요한 개선 사항이 눈에 띕니다:

- 라마 2보다 7배 더 큰 데이터 세트와 4배 더 많은 코드에 대해 학습했습니다.

- 컨텍스트 길이를 8,000토큰으로 두 배 늘렸습니다.

라마 2는 이미 강력한 오픈소스 LLM이었지만, 이 두 가지 업데이트를 통해 라마 3의 성능이 크게 향상될 것으로 예상됩니다.

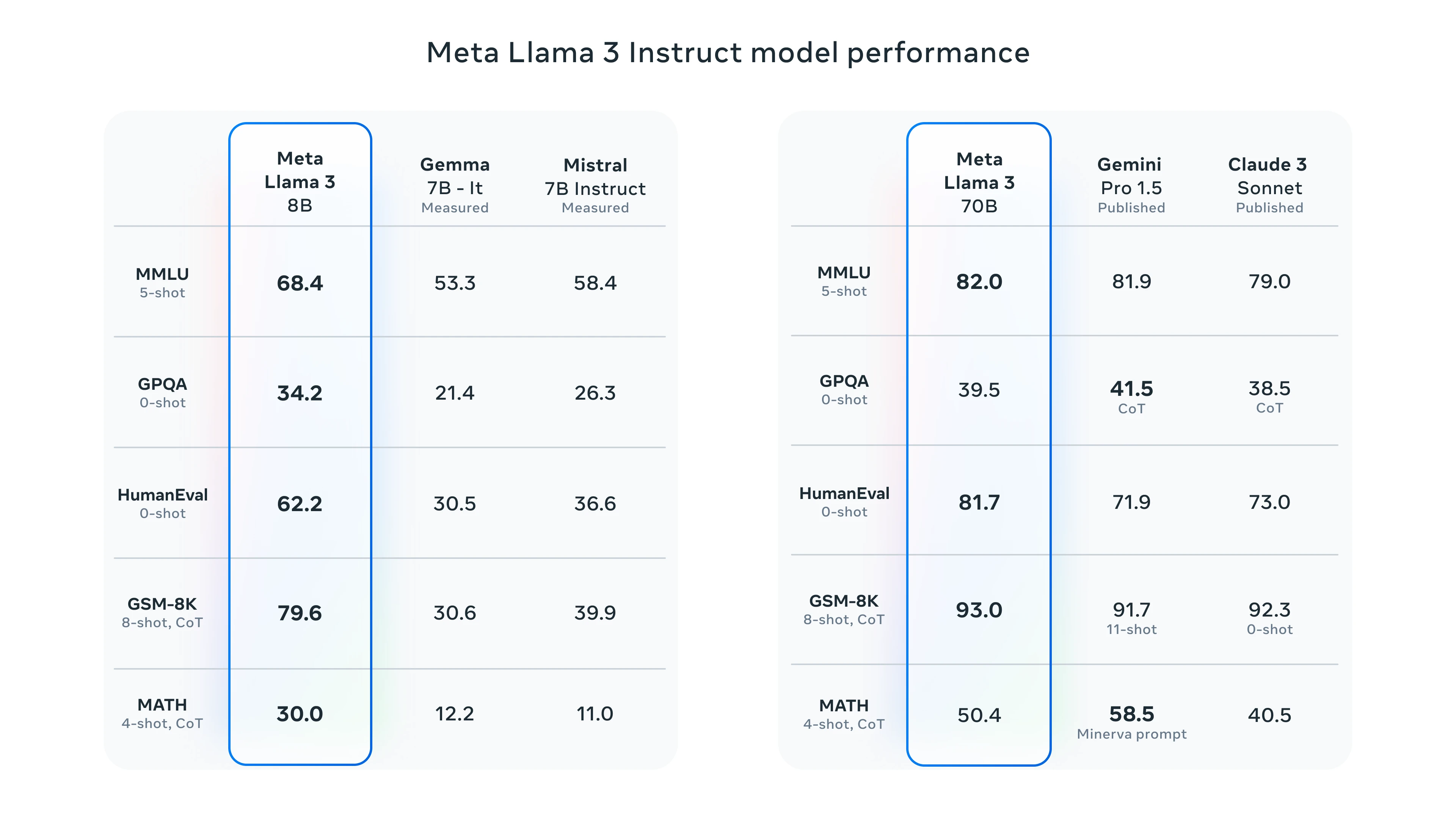

라마 3 벤치마크

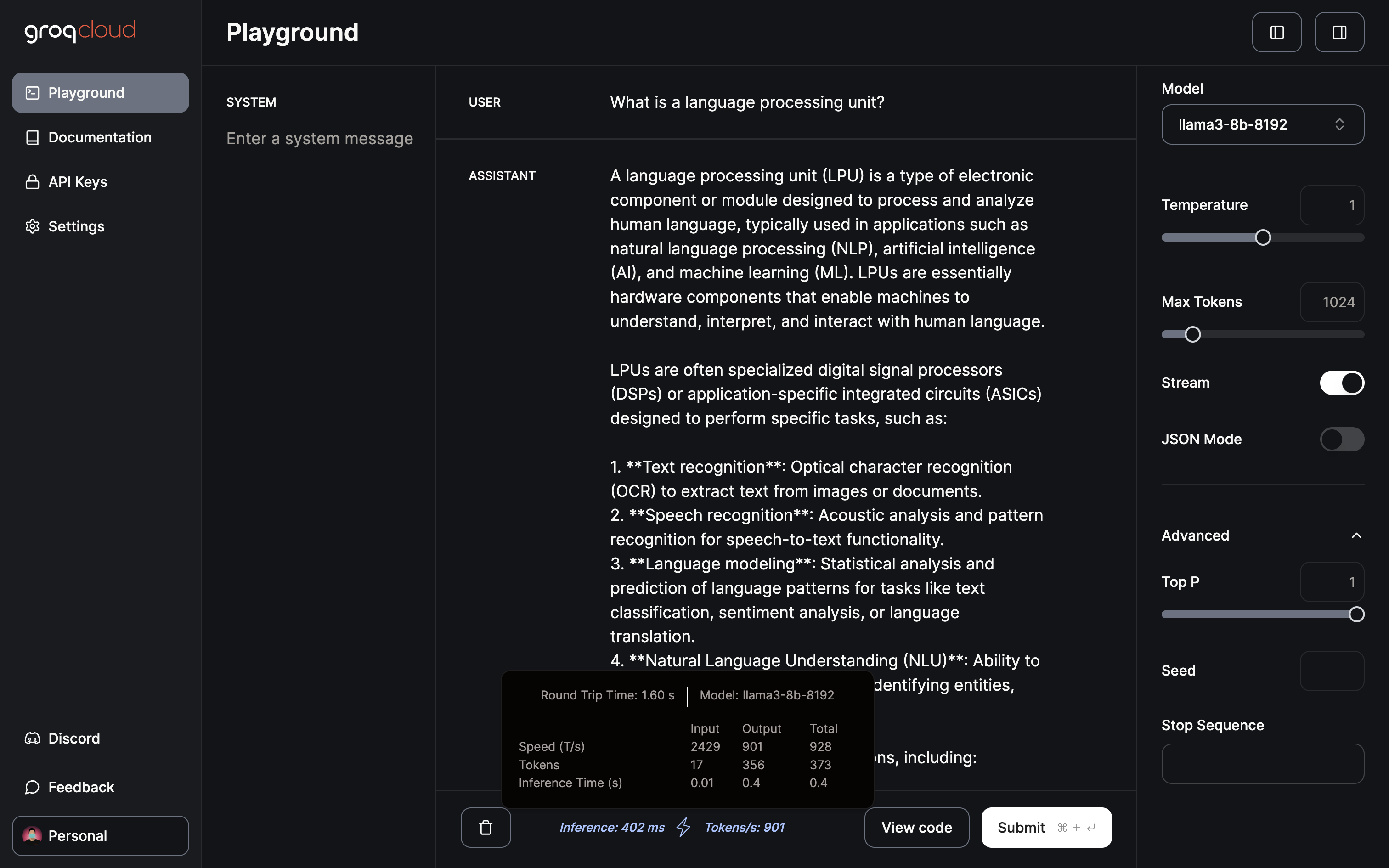

라마 3를 테스트하려면 메타 AI 또는 Groq 플레이그라운드를 이용할 수 있습니다. Llama 3로 테스트하여 Groq의 성능을 보여드리겠습니다.

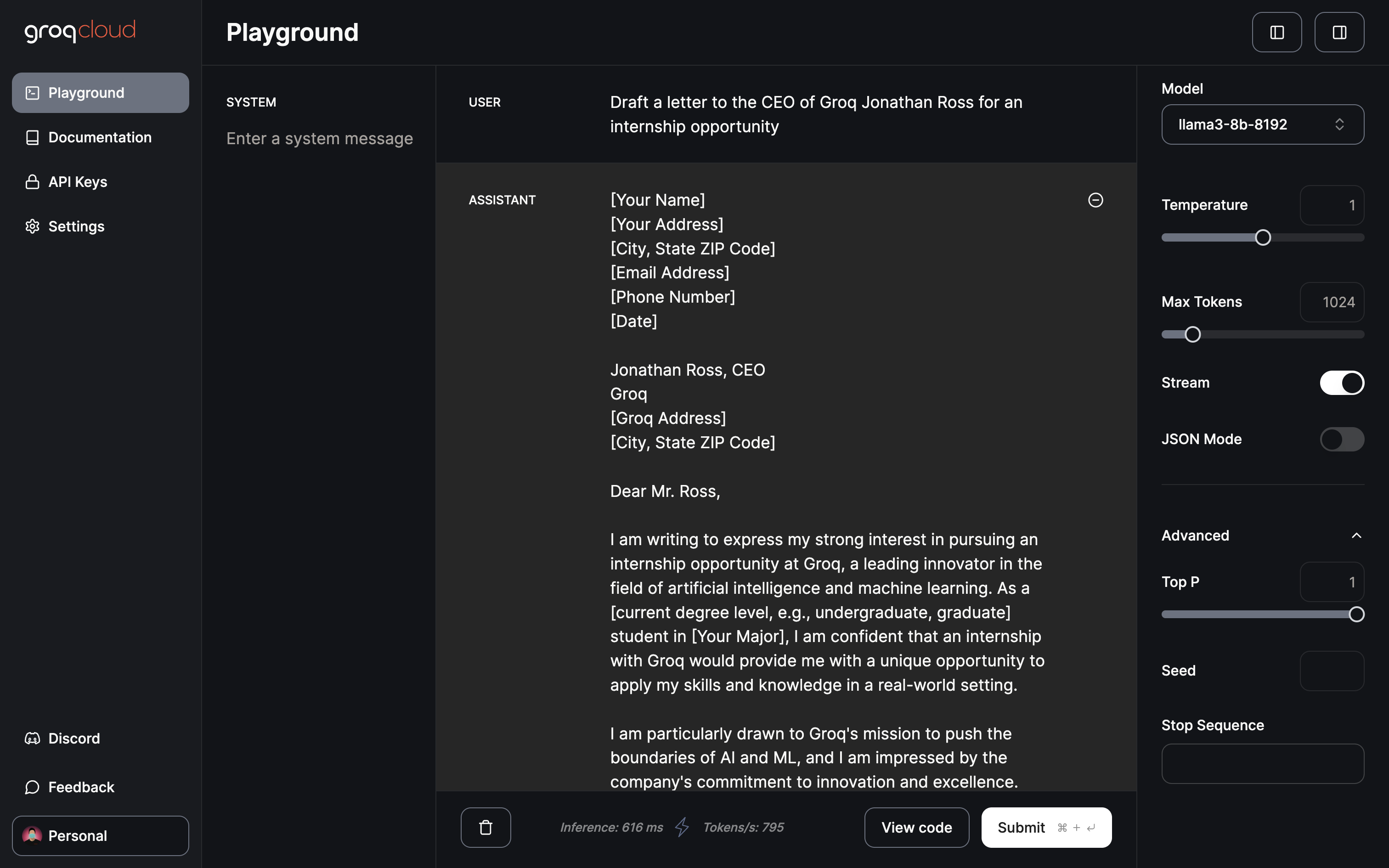

그루크 플레이그라운드

현재 그루크 놀이터에서는 젬마 7B, 라마 3 70B 및 8B, 믹스트랄 8x7b를 무료로 이용할 수 있습니다. 플레이그라운드에서는 온도, 최대 토큰, 스트리밍 토글 등의 매개변수를 조정할 수 있습니다. 또한 JSON 출력만 생성하는 전용 JSON 모드가 있습니다.

901토큰/s의 속도로 추론하는 데 402ms밖에 걸리지 않습니다.

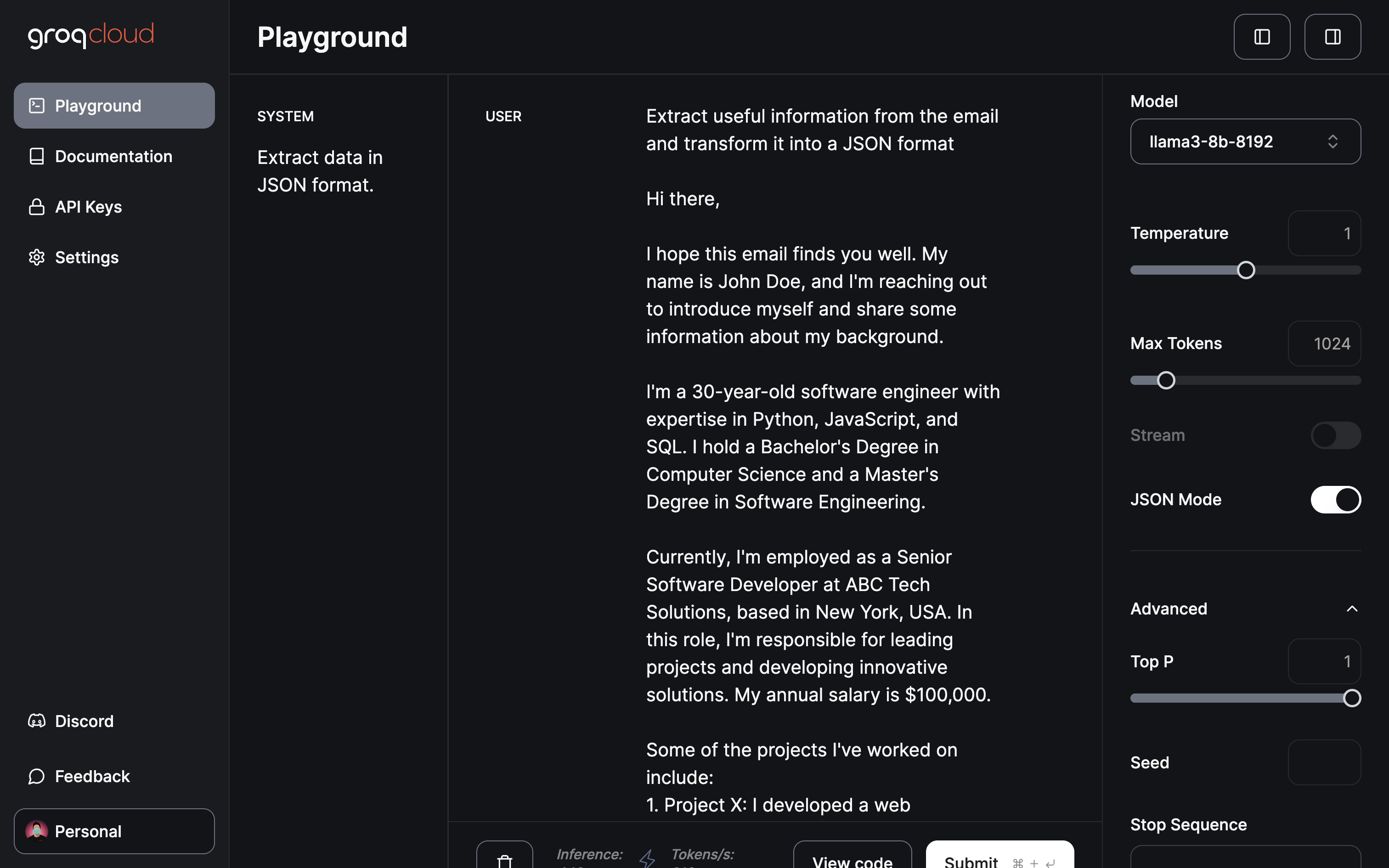

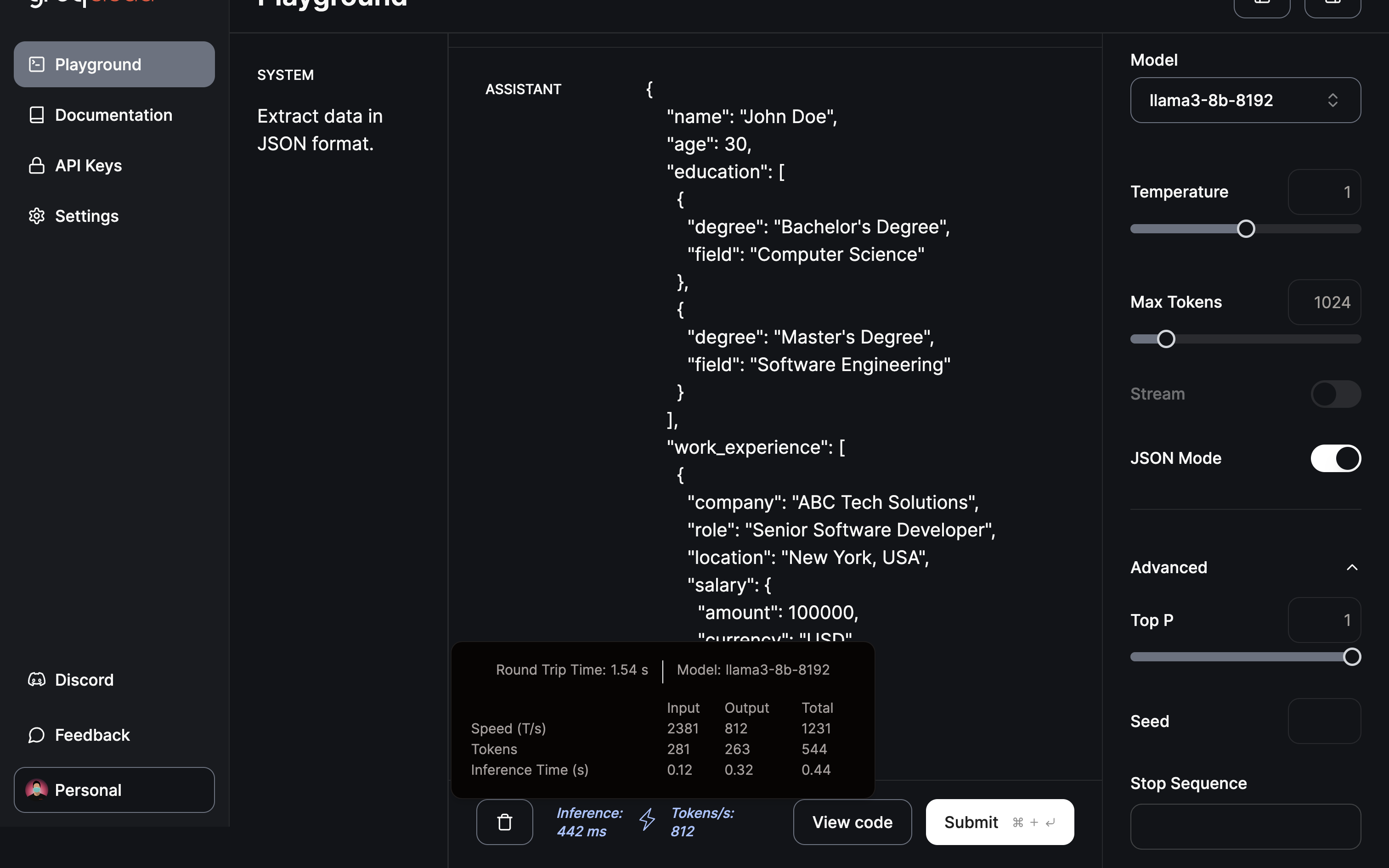

제 생각에 가장 영향력 있는 도메인/애플리케이션으로 데이터 추출 및 변환을 꼽을 수 있습니다:

모델에 유용한 정보를 추출하도록 요청하고 JSON 모드를 사용하여 JSON을 제공합니다.

추출 및 JSON 형식으로의 변환은 0.5초 이내에 완료되었습니다.

결론

앞서 살펴본 바와 같이, Groq은 혁신적인 LPU 추론 엔진으로 LLM 업계의 판도를 바꾸는 기업으로 부상했습니다. 여기에 소개된 빠른 변화는 AI 애플리케이션을 가속화할 수 있는 엄청난 잠재력을 암시합니다. 앞으로 Groq의 혁신에 대해 추측할 수 있을 뿐입니다. 이미지 처리 장치는 이미지 생성 모델에 혁신을 일으켜 AI 동영상 생성의 발전에 기여할 수 있습니다. 정말 기대되는 미래입니다.

앞으로 LLM 교육이 더욱 효율적으로 진행됨에 따라 로컬 디바이스의 데이터로 미세 조정된 개인화된 ChatGPT를 사용할 수 있는 잠재력이 더욱 커질 것입니다. 이러한 기능을 제공하는 플랫폼 중 하나는 다양한 측면에서 비즈니스를 지원하기 위해 맞춤화된 지능형 AI 어시스턴트인 Cody입니다. ChatGPT와 마찬가지로 코디는 고유한 지식 기반을 사용하여 비즈니스 데이터, 팀, 프로세스 및 고객에 대한 교육을 받을 수 있습니다.

코디를 통해 기업은 AI의 힘을 활용하여 각자의 필요에 맞는 개인화된 지능형 비서를 만들 수 있으며, 이는 AI 기반 비즈니스 솔루션의 세계를 더욱 확장할 수 있는 유망한 솔루션이 될 것입니다.