Améliorer la productivité de la recherche grâce aux outils d’IA

Le paysage de la recherche moderne est en train de se transformer grâce à l’avènement de l’intelligence artificielle (IA).

Ces systèmes intelligents permettent aux chercheurs de traiter plus facilement de grandes quantités de données et d’en extraire rapidement des informations précieuses.

Un élément crucial de cette transformation est la suite d’outils alimentés par des transformateurs génératifs pré-entraînés (GPT), qui sont conçus pour traiter des tâches complexes avec une grande efficacité.

Les outils d’IA deviennent de plus en plus indispensables dans les milieux de la recherche universitaire et professionnelle.

Ils permettent de résumer des documents de recherche complexes, d’effectuer des recherches avancées et d’améliorer la qualité de la documentation.

En tirant parti de ces outils, les chercheurs peuvent rationaliser considérablement leurs flux de travail et se concentrer davantage sur la pensée innovante et la résolution de problèmes.

1. Résumer des documents de recherche complexes

L’une des tâches les plus fastidieuses dans le domaine de la recherche consiste à déchiffrer des documents complexes.

Heureusement, les outils alimentés par les TPG sont devenus inestimables dans ce domaine. SummarizePaper.com est un outil d’IA open-source spécialement conçu pour résumer les articles d’arXiv et les rendre plus digestes pour les chercheurs.

En outre, Unriddl rationalise les sujets complexes et fournit des résumés concis, permettant aux chercheurs de saisir rapidement des idées complexes.

Un autre outil remarquable est Wordtune, qui peut résumer rapidement de longs documents, aidant ainsi à comprendre efficacement de vastes informations.

Ces avancées permettent aux chercheurs de gagner du temps et de se concentrer sur l’analyse critique et l’innovation.

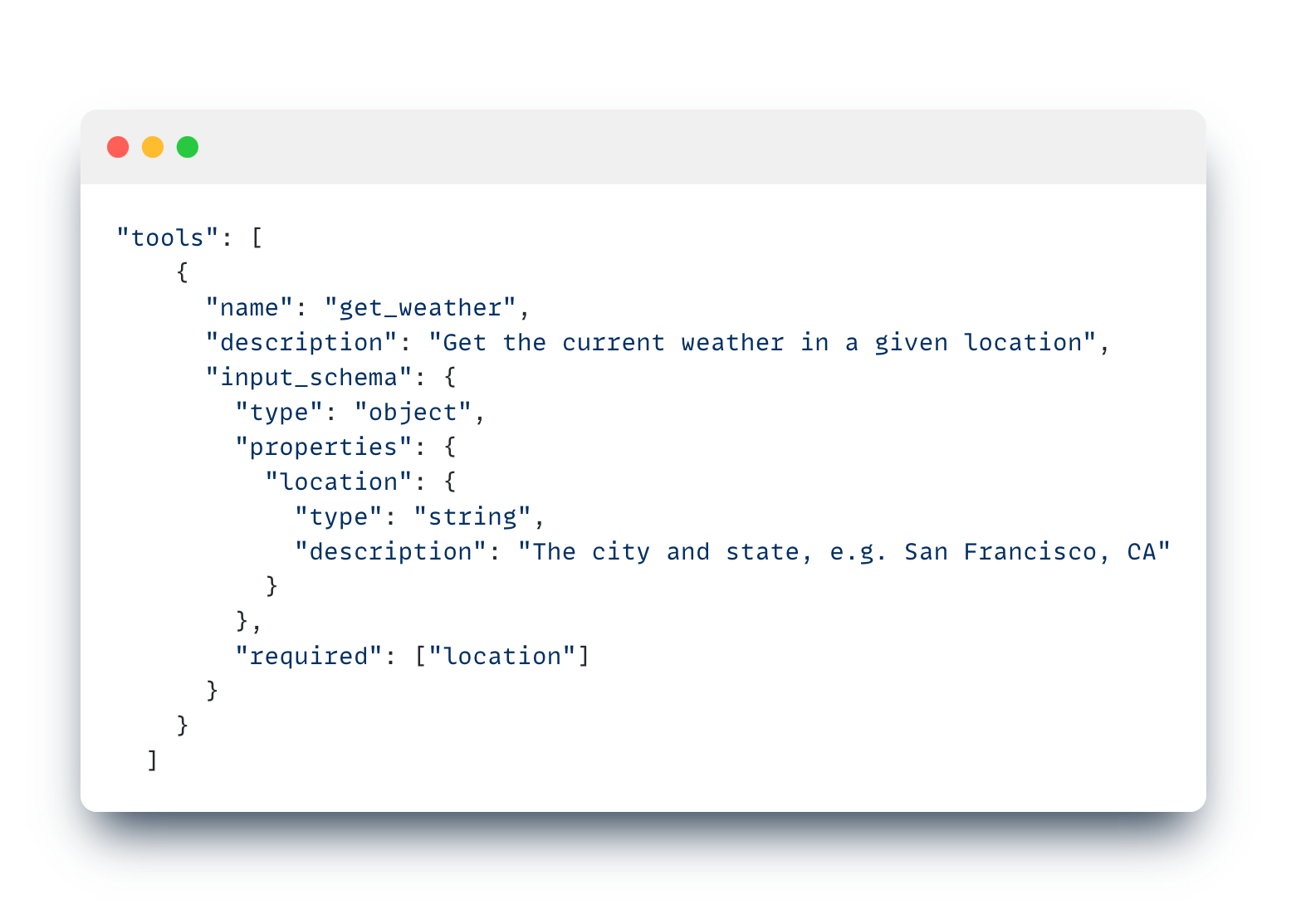

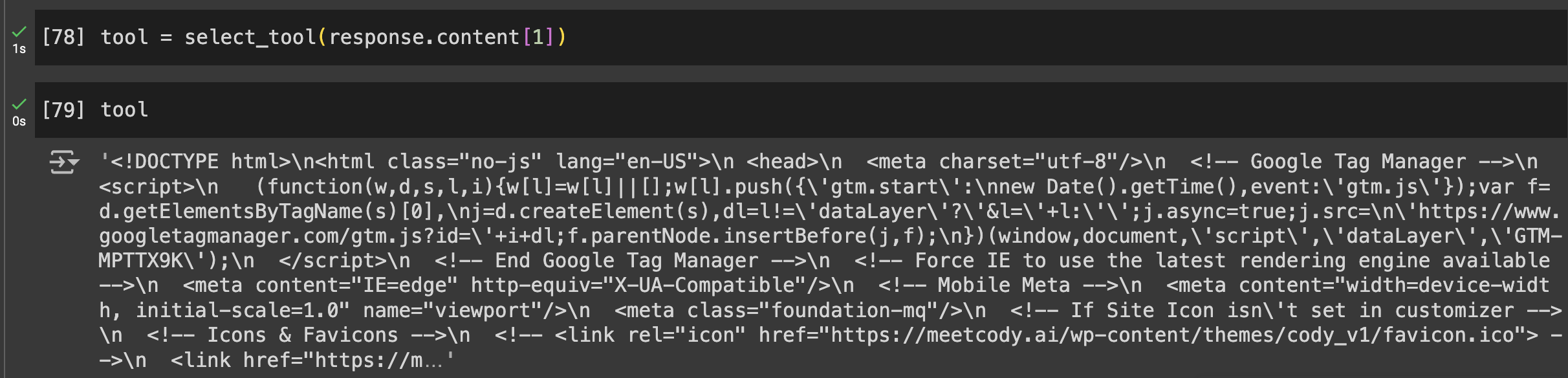

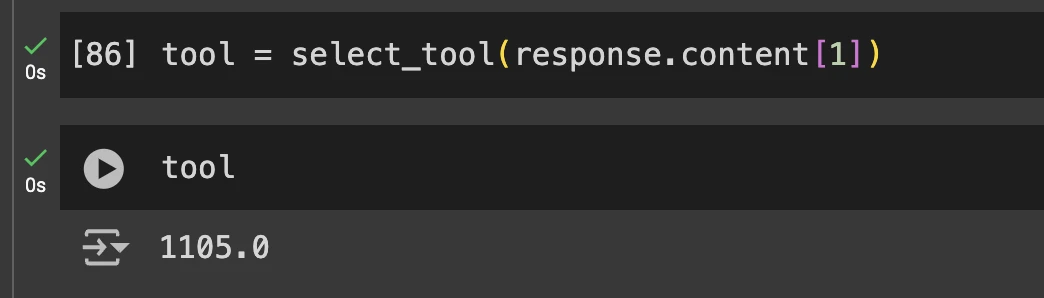

Pour les personnes à la recherche d’un outil plus polyvalent doté de fonctionnalités intuitives telles que l’analyse sélective de documents, la nature agnostique des modèles et la possibilité de partager des robots formés sur vos documents de recherche, Cody AI est un autre excellent choix qui intègre toutes ces fonctionnalités.

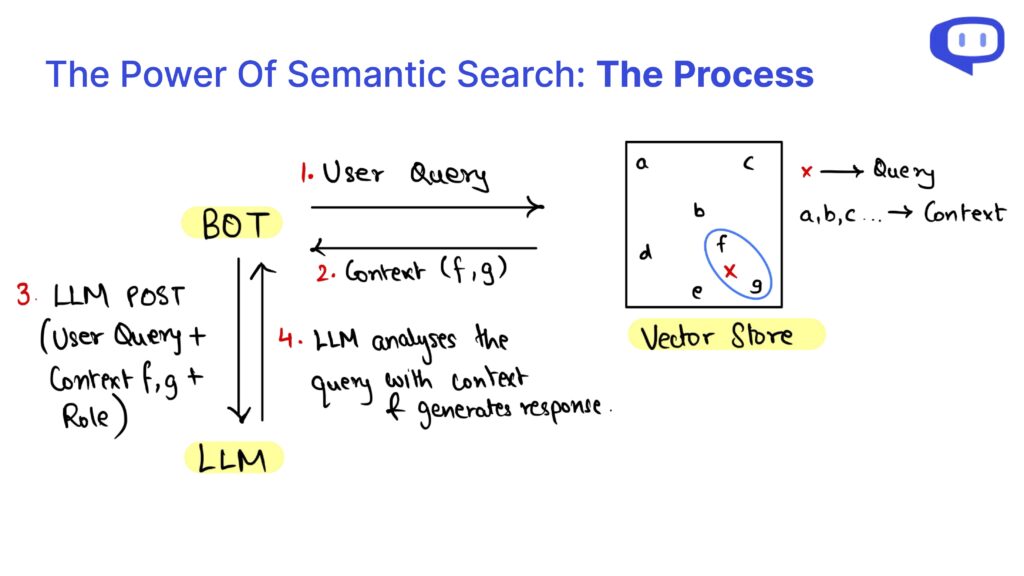

2. Recherche avancée et recherche d’informations

Trouver rapidement des informations précises est primordial dans la recherche, et les outils d’IA excellent dans ce domaine. Searcholic est un moteur de recherche alimenté par l’IA qui aide les chercheurs à localiser un large éventail de livres électroniques et de documents sans effort.

Cet outil facilite l’accès à diverses sources d’information et permet aux chercheurs d’avoir un contenu complet à portée de main.

Un autre outil puissant est Semantic Scholar, qui donne accès à plus de 211 millions d’articles scientifiques.

Cet outil d’IA permet aux utilisateurs d’effectuer des analyses documentaires approfondies en offrant des fonctionnalités de recherche avancée adaptées à la recherche scientifique.

Enfin, Perplexity combine les fonctionnalités d’un moteur de recherche et d’un chatbot, permettant aux chercheurs de poser des questions et de recevoir rapidement des réponses détaillées.

Cette approche hybride permet non seulement de gagner du temps, mais aussi d’améliorer l’efficacité de la recherche d’informations, ce qui en fait un outil indispensable pour les chercheurs modernes.

3. Améliorer la documentation de la recherche

Une documentation efficace est essentielle pour la diffusion et la validation de la recherche. Penelope AI est un outil inestimable qui permet aux chercheurs de vérifier leurs manuscrits académiques avant de les soumettre aux revues, en s’assurant que leur travail respecte des normes et des lignes directrices élevées.

Un autre outil indispensable est Grammarly, qui corrige les erreurs de grammaire et d’orthographe, améliorant ainsi la lisibilité et le professionnalisme des documents de recherche.

Cela contribue à la qualité et à la clarté globales de la recherche, la rendant plus accessible à un public plus large.

En outre, Kudos aide les chercheurs à expliquer leur travail dans un langage simple et à créer des pages visuellement attrayantes.

Ce service améliore la visibilité de la recherche en traduisant des sujets complexes en un contenu plus compréhensible, élargissant ainsi l’impact potentiel des résultats de la recherche.

L’ensemble de ces outils garantit que la documentation de recherche est complète, bien présentée et compréhensible, ce qui contribue en fin de compte à une communication efficace des découvertes scientifiques.

Conclusion : L’IA au service de la recherche future

L’intégration d’outils de TPG et d’IA dans le processus de recherche offre de nombreux avantages, qu’il s’agisse de résumer des documents de recherche complexes ou d’améliorer la documentation.

Des outils tels que SummarizePaper.com et Unriddl simplifient la compréhension de sujets complexes en fournissant des résumés concis, rendant ainsi la littérature académique plus accessible.

En outre, des moteurs de recherche alimentés par l’IA comme Semant Scholar facilitent la recherche efficace d’informations, ce qui améliore considérablement le flux de travail de la recherche.

Pour la documentation, des outils tels que Penelope AI et Grammarly garantissent que les articles répondent à des normes élevées et communiquent clairement.

Kudos élargit encore la portée de la recherche en traduisant les résultats complexes en langage clair.

Ces outils d’IA améliorent collectivement la précision, l’efficacité et l’impact des activités de recherche.

En continuant à utiliser l’IA dans la recherche, nous améliorons non seulement les flux de travail individuels, mais nous contribuons également à la communauté scientifique dans son ensemble.

L’intégration de ces outils avancés est une étape vers une recherche plus efficace, plus précise et plus accessible, favorisant l’innovation et les découvertes futures.