Poprawa produktywności badań dzięki narzędziom AI

Krajobraz współczesnych badań przechodzi transformację dzięki pojawieniu się sztucznej inteligencji (AI).

Te inteligentne systemy ułatwiają badaczom przetwarzanie ogromnych ilości danych i szybkie wydobywanie cennych spostrzeżeń.

Kluczowym elementem tej transformacji jest zestaw narzędzi zasilanych przez Generative Pre-trained Transformers (GPT), które zostały zaprojektowane do obsługi złożonych zadań z wysoką wydajnością.

Narzędzia sztucznej inteligencji stają się coraz bardziej niezbędne w akademickich i profesjonalnych środowiskach badawczych.

Pomagają one w podsumowywaniu skomplikowanych prac badawczych, przeprowadzaniu zaawansowanych wyszukiwań i poprawianiu jakości dokumentacji.

Wykorzystując te narzędzia, naukowcy mogą znacznie usprawnić swoje przepływy pracy i skupić się bardziej na innowacyjnym myśleniu i rozwiązywaniu problemów.

1. Podsumowywanie złożonych artykułów naukowych

Jednym z najbardziej czasochłonnych zadań w badaniach naukowych jest rozszyfrowywanie złożonych dokumentów.

Na szczęście narzędzia oparte na GPT stały się nieocenione w tej dziedzinie. SummarizePaper. com to narzędzie AI o otwartym kodzie źródłowym, zaprojektowane specjalnie do podsumowywania artykułów z arXiv, dzięki czemu są one bardziej strawne dla naukowców.

Dodatkowo, Unriddl usprawnia złożone tematy i zapewnia zwięzłe podsumowania, umożliwiając badaczom szybkie zrozumienie zawiłych pomysłów.

Innym godnym uwagi narzędziem jest Wordtune, które może szybko podsumować długie dokumenty, pomagając w ten sposób w skutecznym zrozumieniu ogromnych informacji.

Postępy te pozwalają naukowcom zaoszczędzić czas i skupić się na krytycznej analizie i innowacjach.

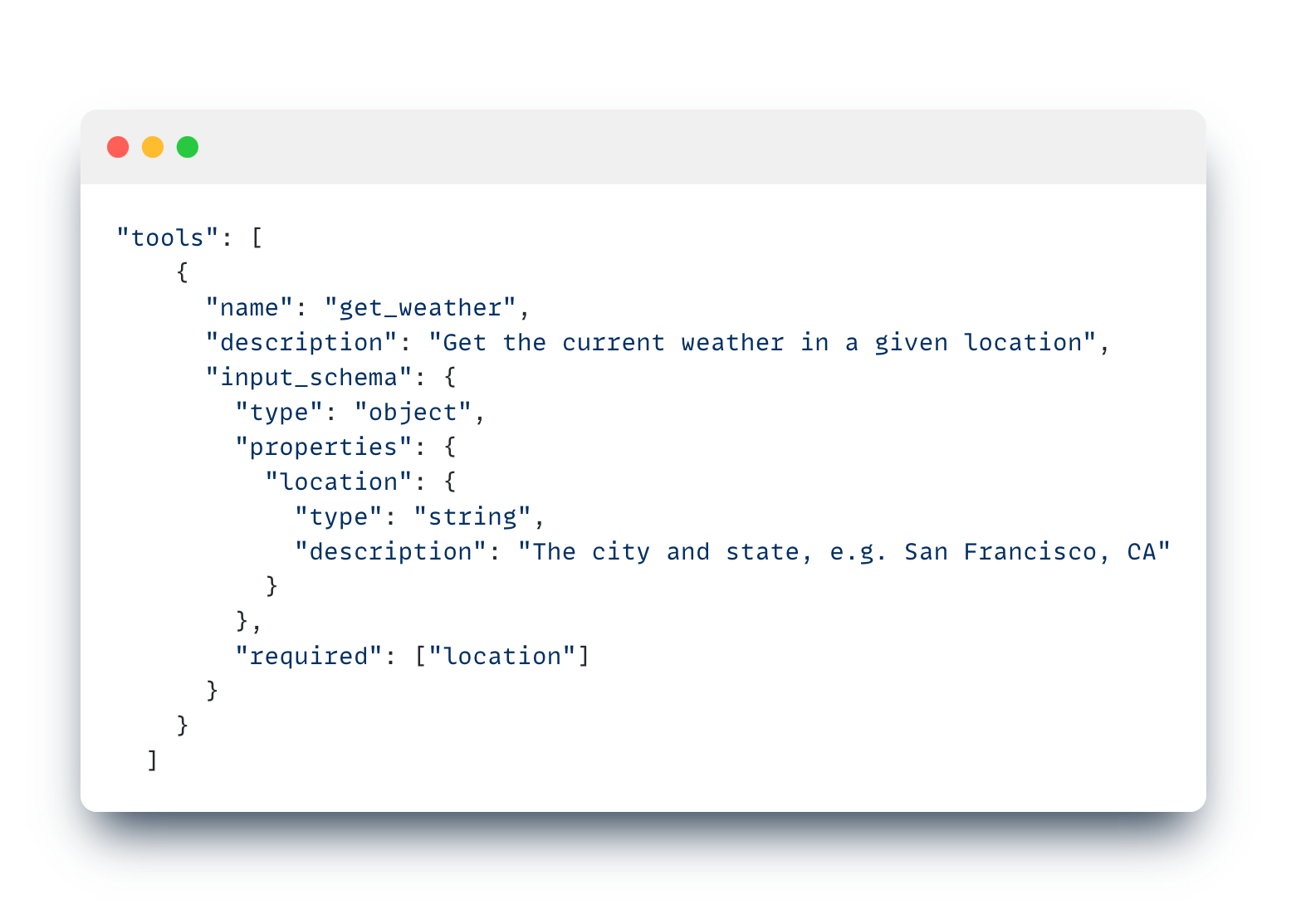

Dla osób poszukujących bardziej wszechstronnego narzędzia z intuicyjnymi funkcjami, takimi jak selektywna analiza dokumentów, charakter niezależny od modelu i możliwość udostępniania botów przeszkolonych w zakresie dokumentów badawczych – Cody AI to kolejny świetny wybór, który zawiera wszystkie te funkcje.

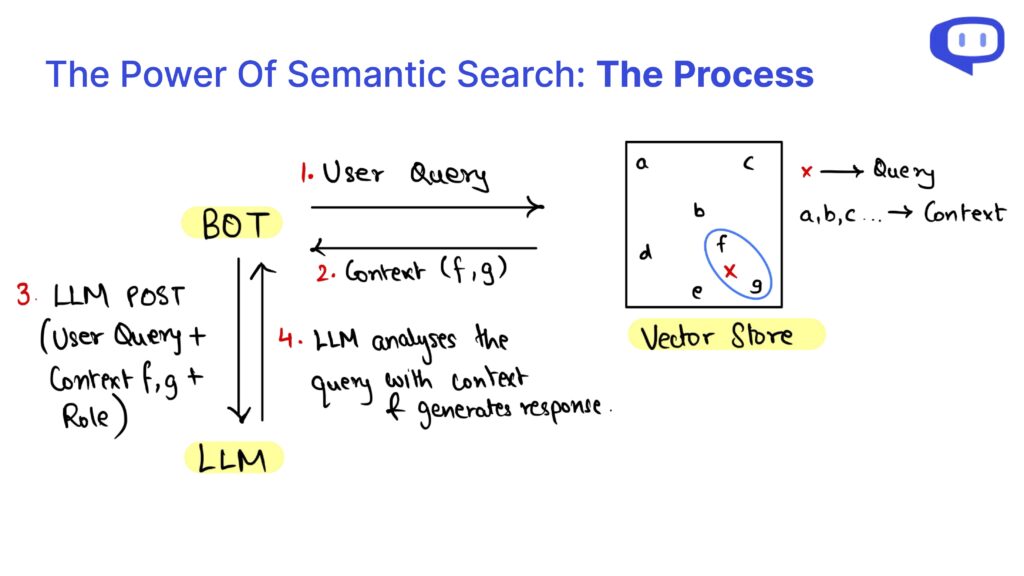

2. Zaawansowane wyszukiwanie i odzyskiwanie informacji

Szybkie znajdowanie precyzyjnych informacji ma kluczowe znaczenie w badaniach naukowych, a narzędzia oparte na sztucznej inteligencji doskonale sprawdzają się w tym obszarze. Searcholic to oparta na sztucznej inteligencji wyszukiwarka, która pomaga badaczom bez wysiłku zlokalizować szeroką gamę e-booków i dokumentów.

Narzędzie to ułatwia dostęp do różnych źródeł informacji, zapewniając badaczom dostęp do kompleksowych treści na wyciągnięcie ręki.

Innym potężnym narzędziem jest Semantic Scholar, który oferuje dostęp do ponad 211 milionów artykułów naukowych.

To narzędzie sztucznej inteligencji umożliwia użytkownikom przeprowadzanie dokładnych przeglądów literatury, zapewniając zaawansowane funkcje wyszukiwania dostosowane do badań naukowych.

Wreszcie, Perplexity łączy w sobie funkcje wyszukiwarki i chatbota, umożliwiając badaczom zadawanie pytań i szybkie otrzymywanie szczegółowych odpowiedzi.

To hybrydowe podejście nie tylko oszczędza czas, ale także poprawia efektywność wyszukiwania informacji, czyniąc je niezbędnym narzędziem dla współczesnych badaczy.

3. Ulepszanie dokumentacji badawczej

Skuteczna dokumentacja ma kluczowe znaczenie dla rozpowszechniania i walidacji badań naukowych. Penelope AI to nieocenione narzędzie, które pozwala badaczom sprawdzać swoje manuskrypty naukowe przed przesłaniem ich do czasopism, zapewniając, że ich praca jest zgodna z wysokimi standardami i wytycznymi.

Innym niezbędnym narzędziem jest Grammarly, które poprawia błędy gramatyczne i ortograficzne, poprawiając w ten sposób czytelność i profesjonalizm dokumentów badawczych.

Przyczynia się to do ogólnej jakości i przejrzystości badań, czyniąc je bardziej dostępnymi dla szerszego grona odbiorców.

Co więcej, Kudos pomaga badaczom wyjaśniać ich pracę prostym językiem i tworzyć atrakcyjne wizualnie strony.

Usługa ta zwiększa widoczność badań poprzez tłumaczenie złożonych tematów na bardziej zrozumiałe treści, zwiększając w ten sposób potencjalny wpływ wyników badań.

Narzędzia te wspólnie zapewniają, że dokumentacja badawcza jest dokładna, dobrze przedstawiona i zrozumiała, co ostatecznie pomaga w skutecznej komunikacji odkryć naukowych.

Podsumowanie: Wykorzystanie sztucznej inteligencji w przyszłych badaniach

Włączenie narzędzi GPT i AI do procesu badawczego oferuje liczne korzyści, od podsumowywania złożonych prac badawczych po ulepszanie dokumentacji.

Narzędzia takie jak SummarizePaper.com i Unriddl upraszczają zrozumienie skomplikowanych tematów poprzez dostarczanie zwięzłych podsumowań, dzięki czemu literatura akademicka staje się bardziej dostępna.

Ponadto wyszukiwarki oparte na sztucznej inteligencji, takie jak Semant Scholar, ułatwiają efektywne wyszukiwanie informacji, znacznie usprawniając przepływ pracy badawczej.

W przypadku dokumentacji, narzędzia takie jak Penelope AI i Grammarly zapewniają, że dokumenty spełniają wysokie standardy i jasno się komunikują.

Kudos dodatkowo poszerza zasięg badań, tłumacząc złożone wyniki na prosty język.

Te narzędzia sztucznej inteligencji wspólnie zwiększają precyzję, wydajność i wpływ działań badawczych.

Kontynuując wdrażanie sztucznej inteligencji w badaniach, nie tylko usprawniamy indywidualne przepływy pracy, ale także przyczyniamy się do rozwoju szerszej społeczności naukowej.

Integracja tych zaawansowanych narzędzi jest krokiem w kierunku bardziej wydajnych, dokładnych i dostępnych badań, napędzających przyszłe innowacje i odkrycia.