AI 도구로 연구 생산성 향상

인공지능(AI)의 등장으로 현대 연구의 환경은 혁신적인 변화를 겪고 있습니다.

이러한 지능형 시스템을 통해 연구자들은 방대한 양의 데이터를 더 쉽게 처리하고 가치 있는 인사이트를 빠르게 추출할 수 있게 되었습니다.

이러한 변화의 핵심 요소는 복잡한 작업을 높은 효율로 처리하도록 설계된 생성적 사전 훈련 트랜스포머(GPT)로 구동되는 도구 제품군입니다.

AI 도구는 학술 및 전문 연구 환경에서 점점 더 필수 불가결한 도구가 되어가고 있습니다.

복잡한 연구 논문을 요약하고, 고급 검색을 수행하고, 문서 품질을 향상시키는 데 도움을 줍니다.

이러한 도구를 활용하면 연구자들은 워크플로우를 크게 간소화하고 혁신적인 사고와 문제 해결에 더 집중할 수 있습니다.

1. 복잡한 연구 논문 요약

연구 분야에서 가장 시간이 많이 걸리는 작업 중 하나는 복잡한 논문을 해독하는 것입니다.

다행히도 이 분야에서는 GPT 기반 도구가 매우 유용하게 사용되고 있습니다. SummarizePaper.com은 arXiv의 논문을 요약하여 연구자들이 더 쉽게 이해할 수 있도록 특별히 설계된 오픈 소스 AI 도구입니다.

또한 Unriddl은 복잡한 주제를 간소화하고 간결한 요약을 제공하여 연구자들이 복잡한 아이디어를 빠르게 파악할 수 있도록 도와줍니다.

또 다른 주목할 만한 도구로는 긴 문서를 빠르게 요약하여 방대한 정보를 효율적으로 이해하는 데 도움을 주는 워드튠이 있습니다.

이러한 발전 덕분에 학자들은 시간을 절약하고 중요한 분석과 혁신에 집중할 수 있습니다.

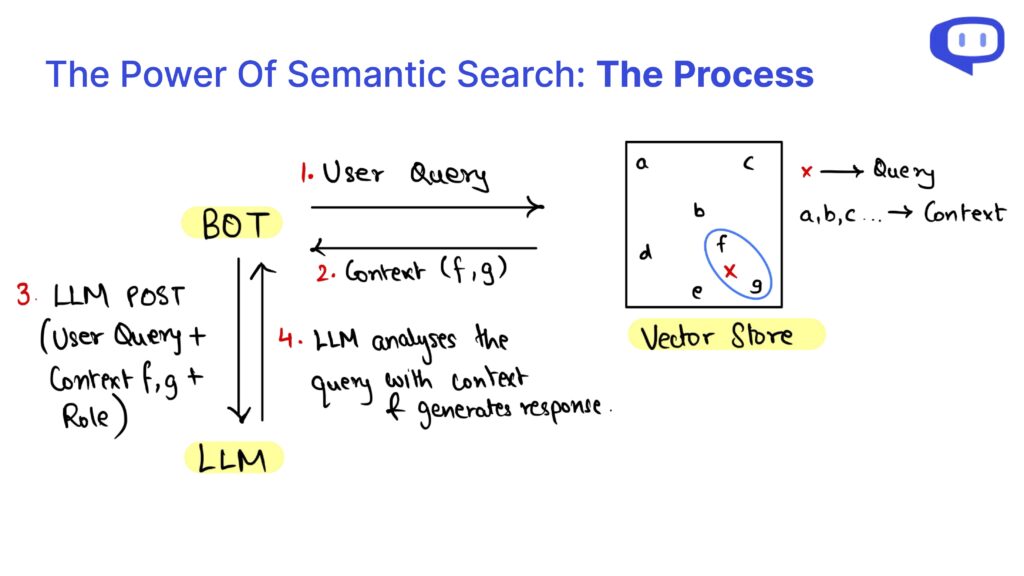

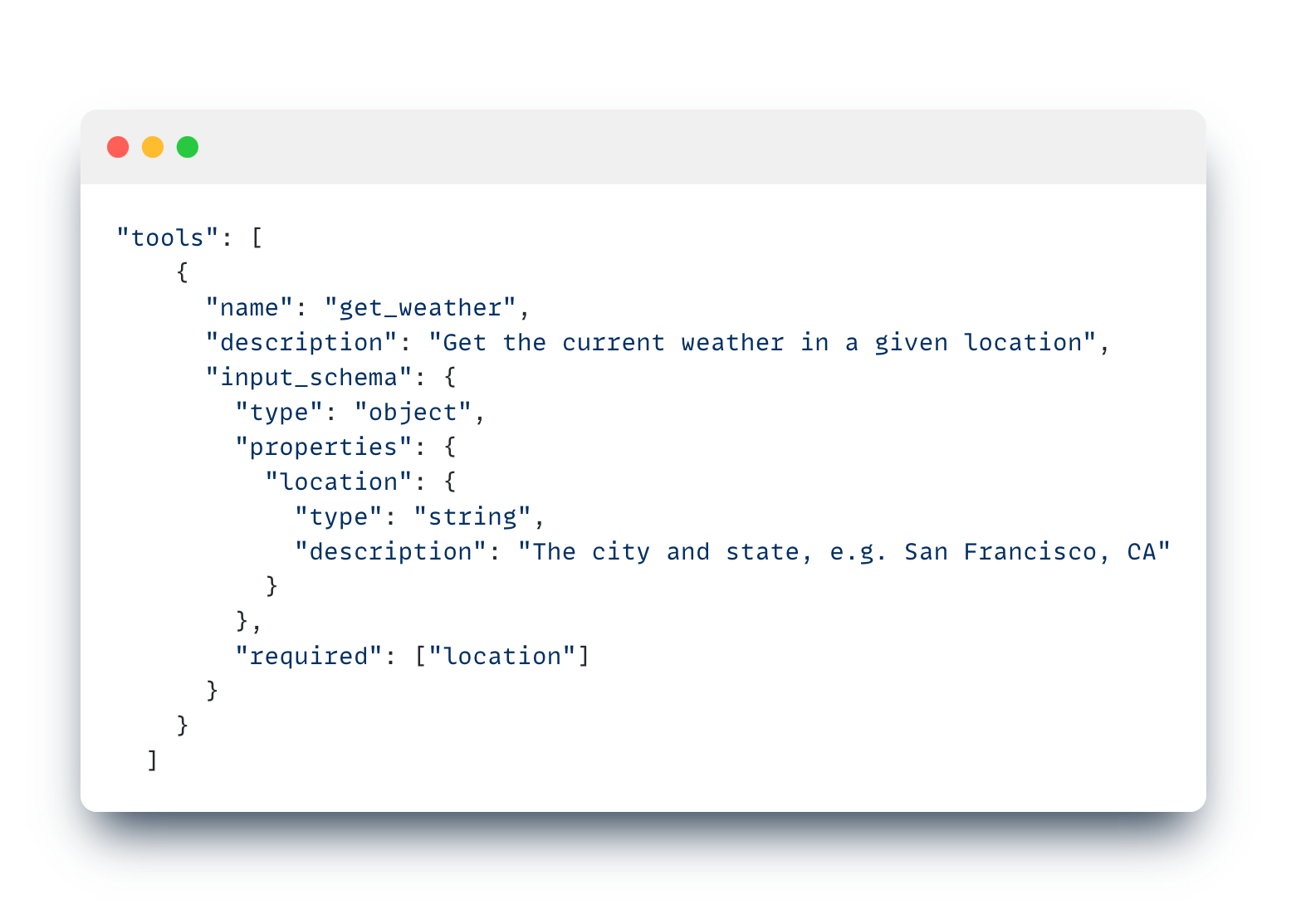

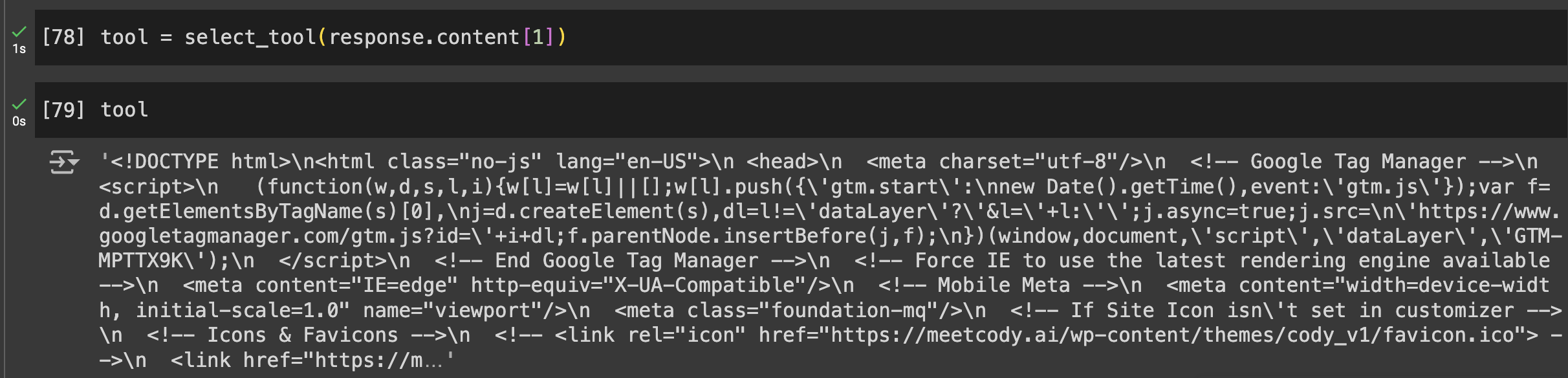

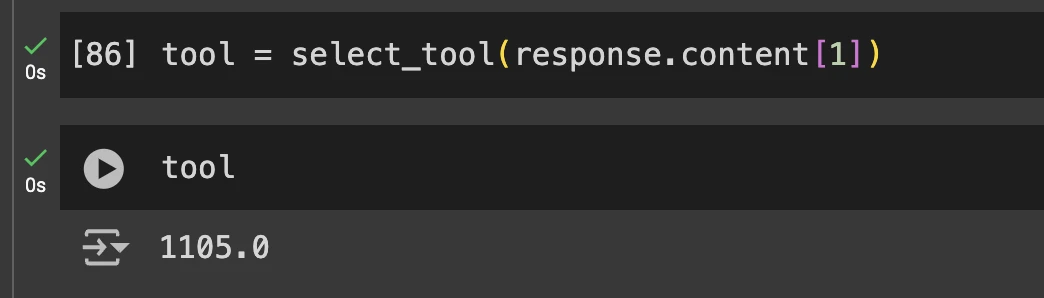

선택적 문서 분석, 모델에 구애받지 않는 특성, 연구 논문에 대해 학습된 봇을 공유하는 기능 등 직관적인 기능을 갖춘 보다 다재다능한 도구를 찾는 분들에게는 이러한 모든 기능을 통합한 Cody AI도 훌륭한 선택이 될 수 있습니다.

2. 고급 검색 및 정보 검색

연구 분야에서는 정확한 정보를 빠르게 찾는 것이 가장 중요하며, AI 도구는 이 분야에서 탁월한 능력을 발휘합니다. Searcholic은 연구자들이 다양한 전자책과 문서를 손쉽게 찾을 수 있도록 도와주는 AI 기반 검색 엔진입니다.

이 도구를 사용하면 다양한 정보 소스에 더 쉽게 액세스할 수 있으므로 연구자는 포괄적인 콘텐츠를 손쉽게 이용할 수 있습니다.

또 다른 강력한 도구로는 2억 1,100만 개가 넘는 과학 논문에 액세스할 수 있는 시맨틱 스콜라가 있습니다.

이 AI 도구는 과학 연구에 맞춤화된 고급 검색 기능을 제공하여 사용자가 철저한 문헌 검토를 수행할 수 있게 해줍니다.

마지막으로 퍼플렉시티는 검색 엔진과 챗봇의 기능을 결합하여 연구자들이 신속하게 질문하고 상세한 답변을 받을 수 있도록 합니다.

이러한 하이브리드 접근 방식은 시간을 절약할 뿐만 아니라 정보 검색의 효율성을 향상시켜 현대 연구자에게 없어서는 안 될 도구입니다.

3. 연구 문서 강화

효과적인 문서화는 연구의 보급과 검증에 매우 중요합니다. Penelope AI는 연구자가 학술지에 제출하기 전에 학술 원고를 점검하여 작업이 높은 기준과 지침을 준수하는지 확인할 수 있는 귀중한 도구입니다.

또 다른 필수 도구는 문법과 철자 오류를 수정하여 연구 문서의 가독성과 전문성을 향상시키는 Grammarly입니다.

이는 연구의 전반적인 품질과 명확성에 기여하여 더 많은 사람들이 더 쉽게 접근할 수 있도록 합니다.

또한 Kudos는 연구자가 자신의 연구를 평이한 언어로 설명하고 시각적으로 매력적인 페이지를 만들 수 있도록 도와줍니다.

이 서비스는 복잡한 주제를 보다 이해하기 쉬운 콘텐츠로 번역하여 연구의 가시성을 높여 연구 결과의 잠재적 영향력을 넓혀줍니다.

이러한 도구를 종합적으로 사용하면 연구 문서가 철저하고 명확하며 이해하기 쉽게 작성되어 궁극적으로 과학적 발견을 효과적으로 전달할 수 있습니다.

결론 결론: 미래 연구를 위한 AI 수용

복잡한 연구 논문을 요약하는 것부터 문서를 개선하는 것까지, 연구 프로세스에 GPT와 AI 도구를 통합하면 다양한 이점을 얻을 수 있습니다.

SummarizePaper.com이나 Unriddl과 같은 도구는 간결한 요약을 제공하여 복잡한 주제의 이해를 단순화함으로써 학술 문헌의 접근성을 높여줍니다.

또한 Semant Scholar와 같은 AI 기반 검색 엔진은 효율적인 정보 검색을 용이하게 하여 연구 워크플로우를 크게 향상시킵니다.

문서화의 경우, Penelope AI 및 Grammarly와 같은 도구는 논문이 높은 기준을 충족하고 명확하게 전달되도록 보장합니다.

Kudos는 복잡한 연구 결과를 평이한 언어로 번역하여 연구의 범위를 더욱 넓혀줍니다.

이러한 AI 도구는 연구 활동의 정확성, 효율성, 영향력을 총체적으로 향상시킵니다.

연구에 AI를 지속적으로 도입하면서 개별 워크플로우를 개선할 뿐만 아니라 더 넓은 과학 커뮤니티에도 기여하고 있습니다.

이러한 고급 도구를 통합하는 것은 보다 효율적이고 정확하며 접근하기 쉬운 연구를 위한 단계이며, 미래의 혁신과 발견을 촉진합니다.