AIツールで研究の生産性を向上

人工知能(AI)の登場により、現代の研究の状況は一変しつつある。

これらのインテリジェント・システムは、研究者が膨大な量のデータを処理し、価値ある洞察を迅速に抽出することを容易にしている。

この変革に欠かせないのが、複雑なタスクを高い効率で処理するように設計されたGPT(Generative Pre-trained Transformers)を搭載したツール群である。

AIツールは、学術的・専門的な研究現場において、ますます不可欠なものとなりつつある。

AIツールは、複雑な研究論文の要約、高度な検索、文書品質の向上を支援する。

これらのツールを活用することで、研究者はワークフローを大幅に効率化し、革新的な思考と問題解決により集中することができる。

1.複雑な研究論文を要約する

研究において最も時間のかかる作業の一つは、複雑な論文を解読することである。

幸いなことに、GPTを利用したツールはこの分野で非常に貴重なものとなっている。SummarizePaper.comは、arXivの論文を要約するために特別に設計されたオープンソースのAIツールで、研究者にとってより消化しやすくなっている。

さらに、Unriddlは複雑なトピックを合理化し、簡潔な要約を提供することで、研究者が複雑なアイデアを素早く把握できるようにする。

もう一つの注目すべきツールはWordtuneで、長い文書を素早く要約し、膨大な情報を効率的に理解するのに役立つ。

これらの進歩により、学者は時間を節約し、重要な分析と革新に集中することができる。

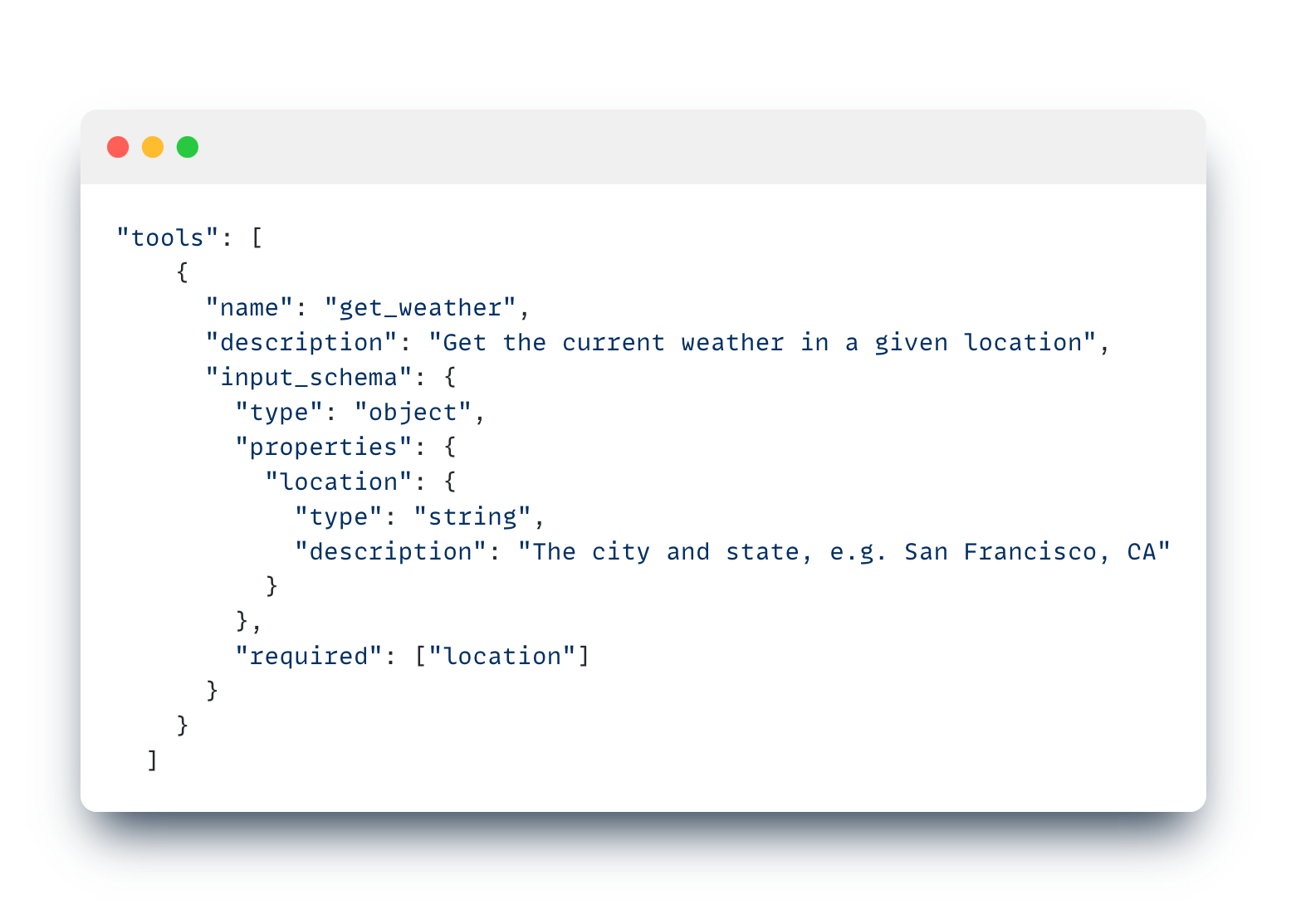

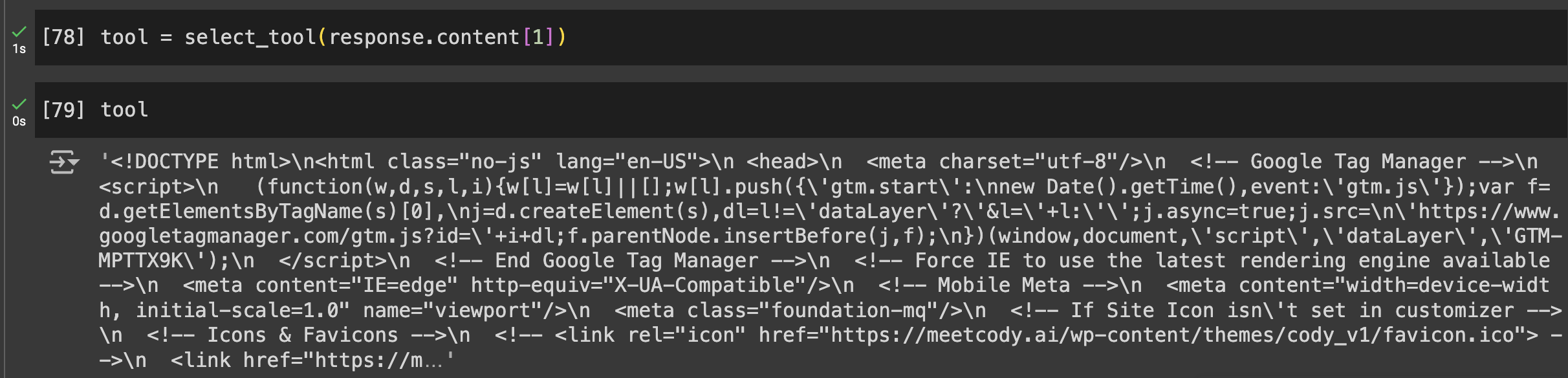

選択的な文書分析、モデルにとらわれない性質、研究論文で訓練されたボットを共有する機能など、直感的な機能を備えたより多機能なツールをお探しの方には、これらの機能をすべて備えたCody AIも最適な選択肢です。

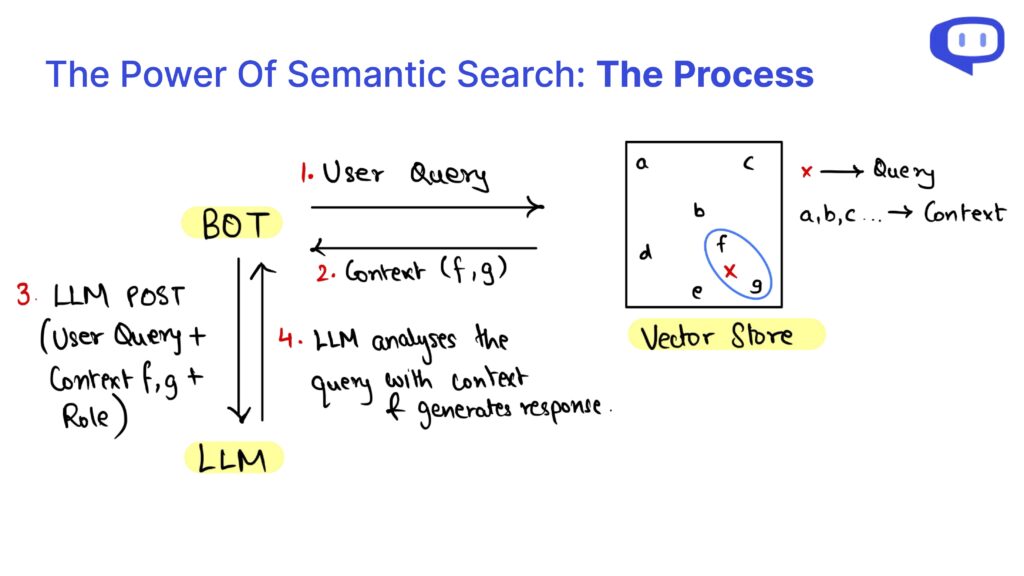

2.高度な検索と情報検索

研究において正確な情報を素早く見つけることは最も重要であり、AIツールはこの分野で優れています。SearcholicはAIを搭載した検索エンジンで、研究者が様々な電子書籍や文書を簡単に検索できるようにします。

このツールを使えば、多様な情報源へのアクセスが容易になり、研究者は包括的なコンテンツをすぐに手に入れることができる。

もう一つの強力なツールはSemantic Scholarで、2億1100万件以上の科学論文にアクセスできる。

このAIツールは、科学研究に合わせた高度な検索機能を提供することで、徹底的な文献レビューを可能にする。

最後に、Perplexityは検索エンジンとチャットボットの機能を兼ね備えており、研究者は質問をすると詳細な回答を迅速に受け取ることができる。

このハイブリッドなアプローチは、時間を節約するだけでなく、情報検索の効率も向上させ、現代の研究者にとって不可欠なツールとなっている。

3.研究ドキュメンテーションの強化

効果的な文書化は、研究の普及と検証にとって極めて重要です。Penelope AIは、研究者が学術雑誌に投稿する前に学術原稿をチェックできる貴重なツールで、研究成果が高い水準とガイドラインに準拠していることを保証します。

文法やスペルミスを修正し、研究文書の読みやすさと専門性を向上させるGrammarlyも欠かせないツールです。

これにより、研究の全体的な品質と明瞭さが向上し、より多くの読者がアクセスしやすくなります。

さらに、Kudosは、研究者が研究内容を平易な言葉で説明し、視覚的に魅力的なページを作成するのに役立ちます。

このサービスは、複雑なトピックをより理解しやすいコンテンツに変換することで、研究の認知度を高め、研究成果の潜在的な影響力を拡大します。

これらのツールは総体として、研究文書が綿密で、うまく表現され、理解しやすいものであることを保証し、最終的には科学的発見の効果的なコミュニケーションに役立ちます。

結論今後の研究のためにAIを取り入れる

GPTやAIツールを研究プロセスに取り入れることで、複雑な研究論文の要約からドキュメンテーションの強化まで、多くの利点が得られます。

SummarizePaper.comやUnriddlのようなツールは、簡潔な要約を提供することで複雑なトピックの理解を簡素化し、学術文献をより身近なものにする。

さらに、Semant ScholarのようなAIを搭載した検索エンジンは、効率的な情報検索を促進し、研究ワークフローを大幅に強化します。

文書作成では、Penelope AIやGrammarlyなどのツールが、論文が高い基準を満たし、明確に伝わるようにします。

Kudosは、複雑な知見を平易な言葉に翻訳することで、研究の幅をさらに広げる。

これらのAIツールは総体的に、研究活動の精度、効率、影響力を高める。

研究にAIを導入し続けることで、個人のワークフローを改善するだけでなく、より広範な科学コミュニティに貢献することができます。

これらの先進的なツールを統合することは、より効率的で、正確で、利用しやすい研究への一歩であり、将来の革新と発見を促進します。