جروق ولاما 3: ثنائي يغير قواعد اللعبة

قبل شهرين ، ظهرت شركة جديدة تسمى “Groq” على ما يبدو من العدم ، محققة طفرة في صناعة الذكاء الاصطناعي. لقد وفروا منصة للمطورين للوصول إلى وحدات LPU كمحركات استدلال ل LLMs ، خاصة تلك مفتوحة المصدر مثل Llama و Mixtral و Gemma. في هذه المدونة ، دعنا نستكشف ما الذي يجعل Groq مميزا للغاية ونتعمق في الأعجوبة وراء LPUs.

ما هو جروق؟

“Groq في مهمة لوضع معيار لسرعة الاستدلال GenAI ، مما يساعد تطبيقات الذكاء الاصطناعي في الوقت الفعلي على الظهور اليوم.” – موقع Groq

Groq ليست شركة تقوم بتطوير LLMs مثل GPT أو Gemini. بدلا من ذلك ، يركز Groq على تعزيز أسس هذه النماذج اللغوية الكبيرة – الأجهزة التي تعمل عليها. إنه بمثابة “محرك الاستدلال”. حاليا ، تستخدم معظم LLMs في السوق وحدات معالجة الرسومات التقليدية المنتشرة على الخوادم الخاصة أو السحابة. في حين أن وحدات معالجة الرسومات هذه باهظة الثمن وقوية ، يتم الحصول عليها من شركات مثل Nvidia ، إلا أنها لا تزال تعتمد على بنية GPU التقليدية ، والتي قد لا تكون مناسبة بشكل مثالي لاستدلال LLM (على الرغم من أنها تظل قوية ومفضلة لنماذج التدريب).

يعمل محرك الاستدلال الذي توفره Groq على وحدات معالجة اللغة LPUs.

ما هو LPU؟

وحدة معالجة اللغة هي شريحة مصممة خصيصا ل LLMs وهي مبنية على بنية فريدة تجمع بين وحدات المعالجة المركزية ووحدات معالجة الرسومات لتحويل وتيرة الحلول الذكاء الاصطناعي وإمكانية التنبؤ بها وأدائها ودقتها ل LLMs.

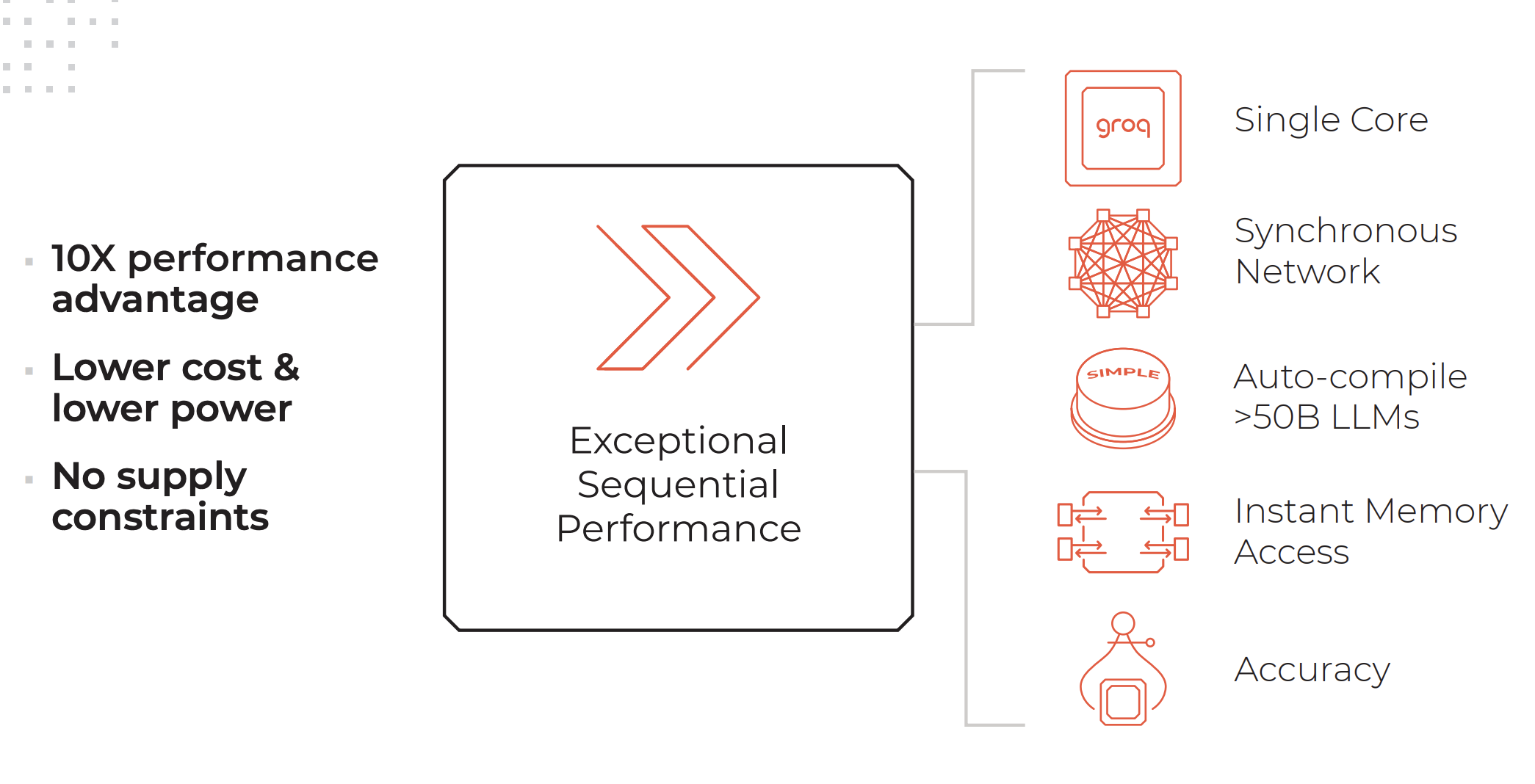

السمات الرئيسية لنظام LPU. ائتمانات: جروق

يحتوي نظام LPU على قدر كبير أو أكثر من الحوسبة مثل معالج الرسومات (GPU) ويقلل من مقدار الوقت لكل كلمة محسوبة ، مما يسمح بتوليد تسلسلات نصية بشكل أسرع.

ميزات محرك الاستدلال LPU كما هو مدرج في موقع Groq:

- أداء تسلسلي استثنائي

- بنية أحادية النواة

- الشبكات المتزامنة التي يتم الحفاظ عليها حتى لعمليات النشر واسعة النطاق

- القدرة على التجميع >التلقائي ل 50B LLMs

- الوصول الفوري إلى الذاكرة

- دقة عالية يتم الحفاظ عليها حتى في مستويات الدقة المنخفضة

الخدمات التي تقدمها جروق:

- جروك كلاود: وحدات LPU على السحابة

- GroqRack: رف 42U مع ما يصل إلى 64 شريحة مترابطة

- GroqNode: نظام حوسبة قابل للتطوير جاهز للحامل 4U يضم ثمانية مسرعات GroqCard™ مترابطة

- جروقكارد: شريحة واحدة في عامل شكل PCIe Gen 4×16 قياسي يوفر تكاملا خاليا من المتاعب للخادم

“على عكس وحدة المعالجة المركزية التي تم تصميمها للقيام بنوع مختلف تماما من المهام عن الذكاء الاصطناعي ، أو وحدة معالجة الرسومات التي تم تصميمها بناء على وحدة المعالجة المركزية للقيام بشيء يشبه الذكاء الاصطناعي عن طريق الصدفة ، أو TPU التي عدلت وحدة معالجة الرسومات لجعلها أفضل بالنسبة الذكاء الاصطناعي ، فإن Groq من الألف إلى الياء ، المبادئ الأولى ، نظام كمبيوتر ل الذكاء الاصطناعي”- دانيال وارفيلد ، نحو علم البيانات

لمعرفة المزيد حول كيفية اختلاف وحدات LPU عن وحدات معالجة الرسومات ووحدات TPU ووحدات المعالجة المركزية ، نوصي بقراءة هذه المقالة الشاملة التي كتبها دانيال وارفيلد ل نحو علوم البيانات.

ما الهدف من جروق؟

LLMs قوية بشكل لا يصدق ، وقادرة على مهام تتراوح من تحليل البيانات غير المهيكلة إلى الإجابة على أسئلة حول جاذبية القطط. ومع ذلك ، فإن عيبها الرئيسي يكمن حاليا في وقت الاستجابة. يؤدي وقت الاستجابة البطيء إلى زمن انتقال كبير عند استخدام LLMs في عمليات الواجهة الخلفية. على سبيل المثال ، يعد جلب البيانات من قاعدة بيانات وعرضها بتنسيق JSON حاليا أسرع بكثير عند القيام به باستخدام المنطق التقليدي بدلا من تمرير البيانات عبر LLM للتحويل. ومع ذلك ، تكمن ميزة LLMs في قدرتها على فهم استثناءات البيانات والتعامل معها.

مع سرعة الاستدلال المذهلة التي تقدمها Groq ، يمكن تقليل هذا العيب في LLMs بشكل كبير. هذا يفتح حالات استخدام أفضل وأوسع ل LLMs ويقلل من التكاليف ، كما هو الحال مع LPU ، ستتمكن من نشر نماذج مفتوحة المصدر أرخص بكثير للتشغيل مع أوقات استجابة سريعة حقا.

لاما 3 على جروق

قبل أسبوعين ، كشفت Meta النقاب عن أحدث إصدار لها من LLM مفتوح المصدر القوي بالفعل وذو القدرة العالية – Llama 3. إلى جانب التحسينات النموذجية في السرعة وفهم البيانات وتوليد الرموز المميزة ، يبرز تحسينان مهمان:

- تم تدريبه على مجموعة بيانات أكبر 7 مرات من Llama 2 ، مع كود أكثر 4 مرات.

- مضاعفة طول السياق إلى 8000 رمز مميز.

كان Llama 2 بالفعل LLM هائلا مفتوح المصدر ، ولكن مع هذين التحديثين ، من المتوقع أن يرتفع أداء Llama 3 بشكل كبير.

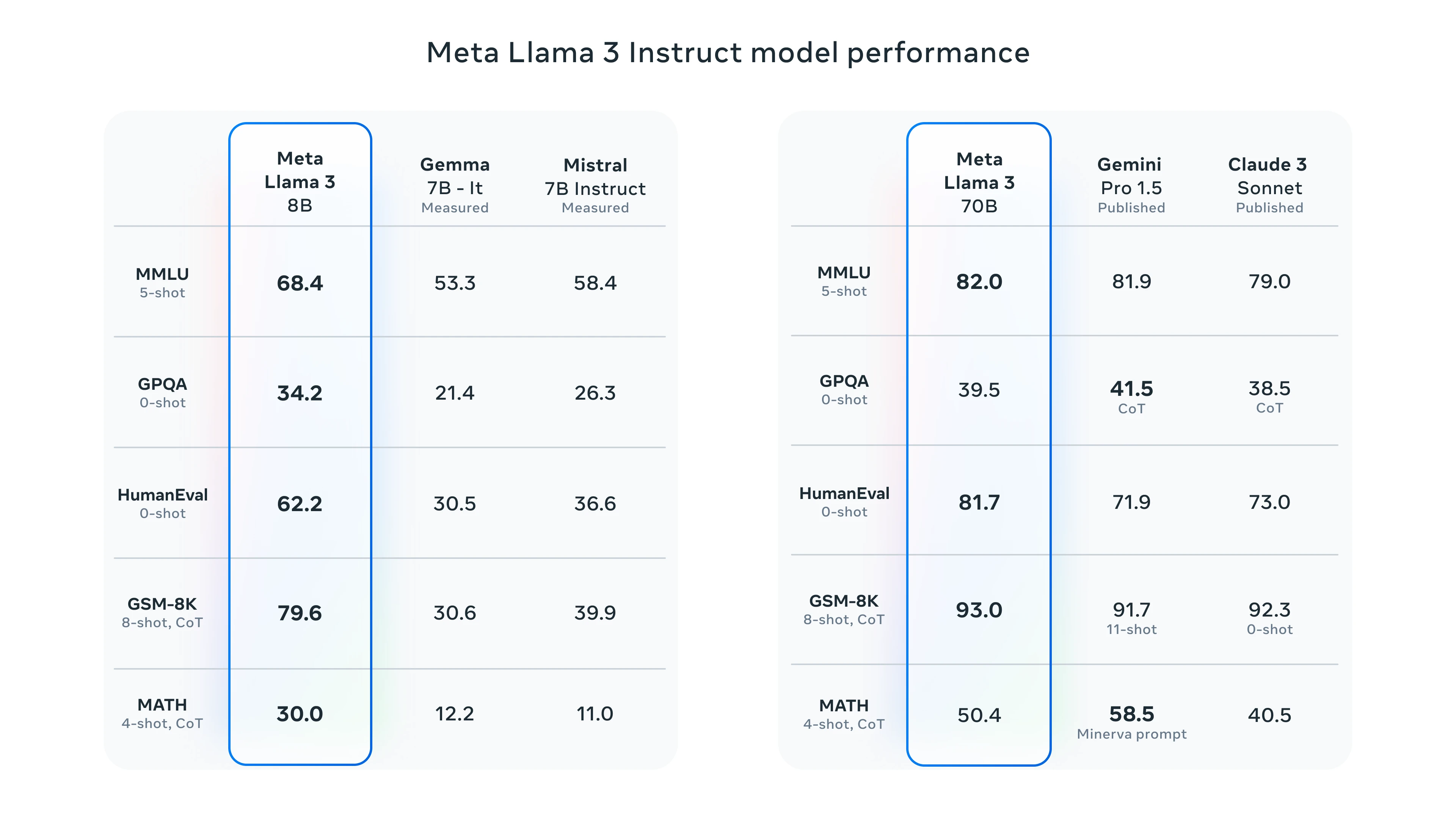

اللاما 3 المعايير

لاختبار اللاما 3 ، لديك خيار استخدام Meta الذكاء الاصطناعي أو ملعب Groq. سنعرض أداء Groq من خلال اختباره مع Llama 3.

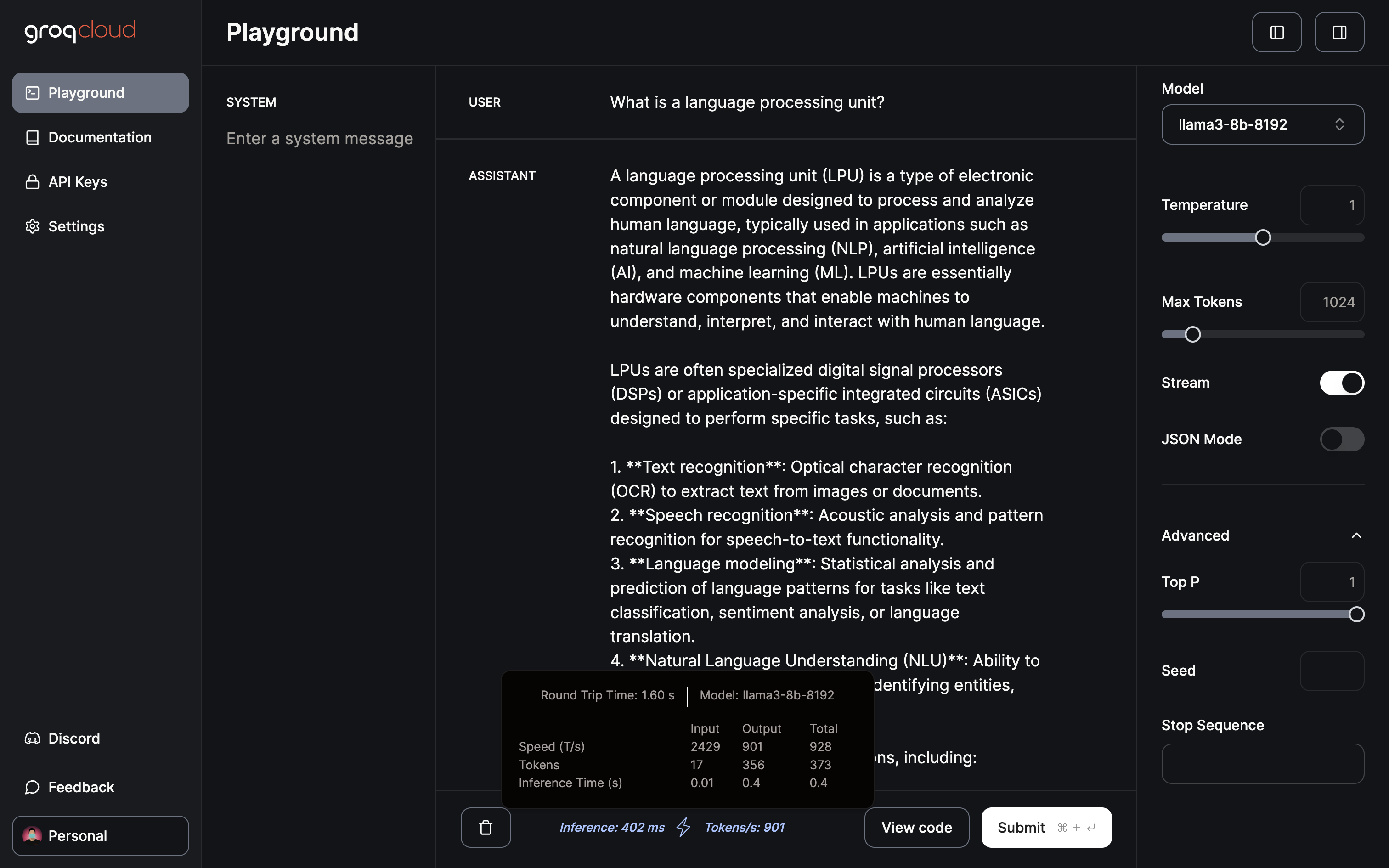

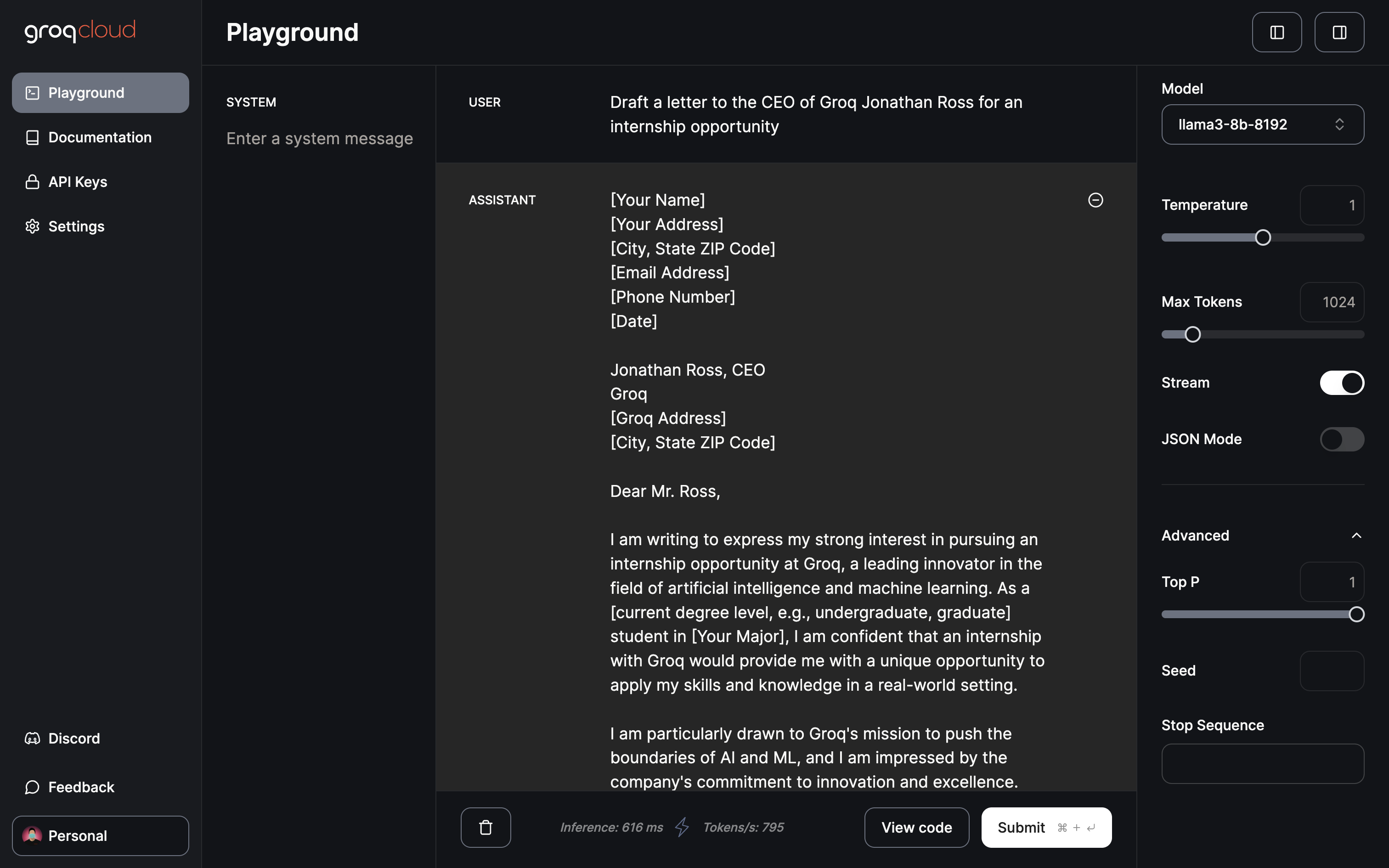

ملعب جروق

يوفر ملعب Groq حاليا الدخول المجاني إلى Gemma 7B و Llama 3 70B و 8B و Mixtral 8x7b. يسمح لك الملعب بضبط المعلمات مثل درجة الحرارة والحد الأقصى للرموز المميزة وتبديل البث. بالإضافة إلى ذلك ، يتميز بوضع JSON مخصص لإنشاء إخراج JSON فقط.

فقط 402 مللي ثانية للاستدلال بمعدل 901 رمز / ثانية

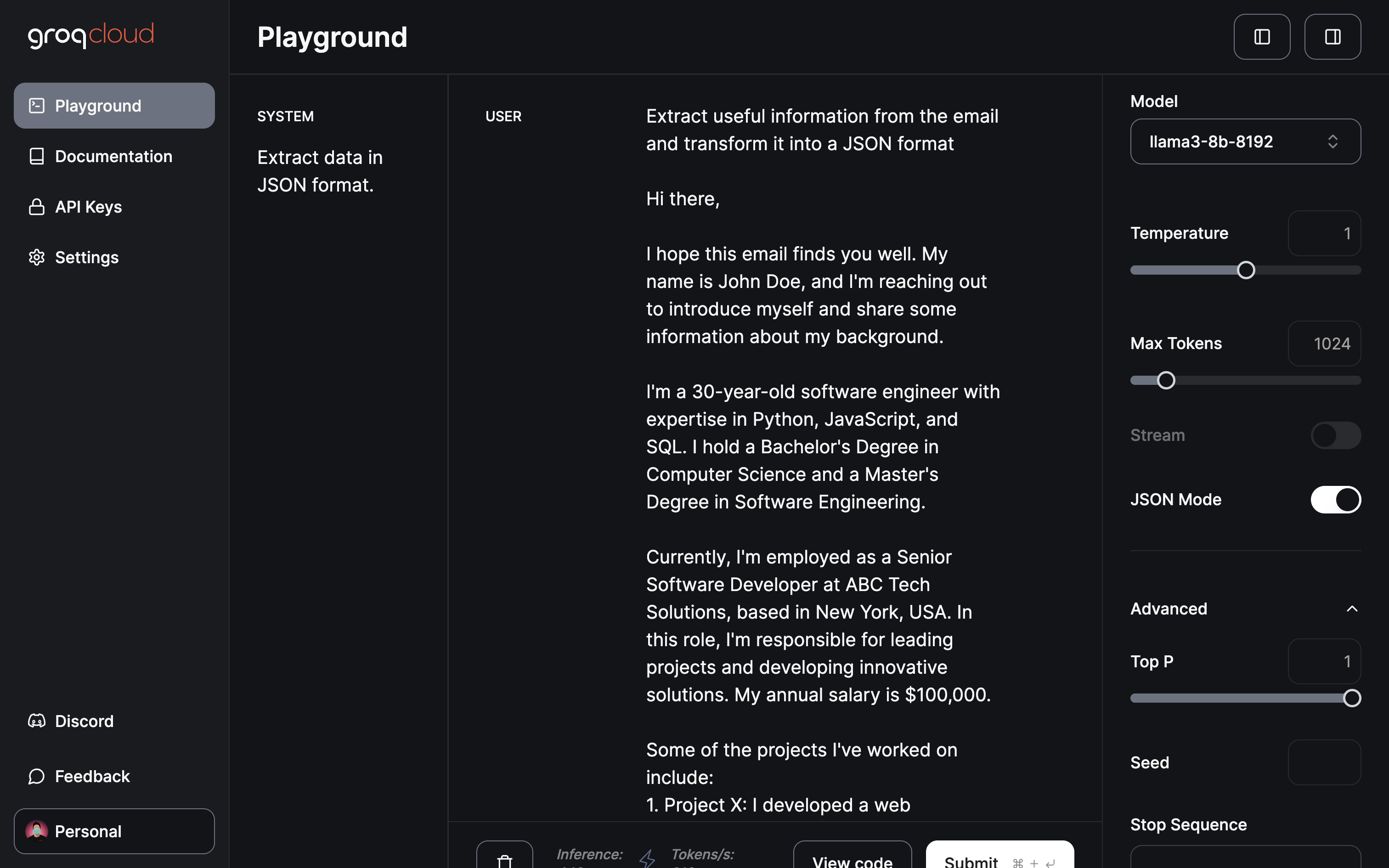

عند الوصول إلى المجال / التطبيق الأكثر تأثيرا في رأيي ، استخراج البيانات وتحويلها:

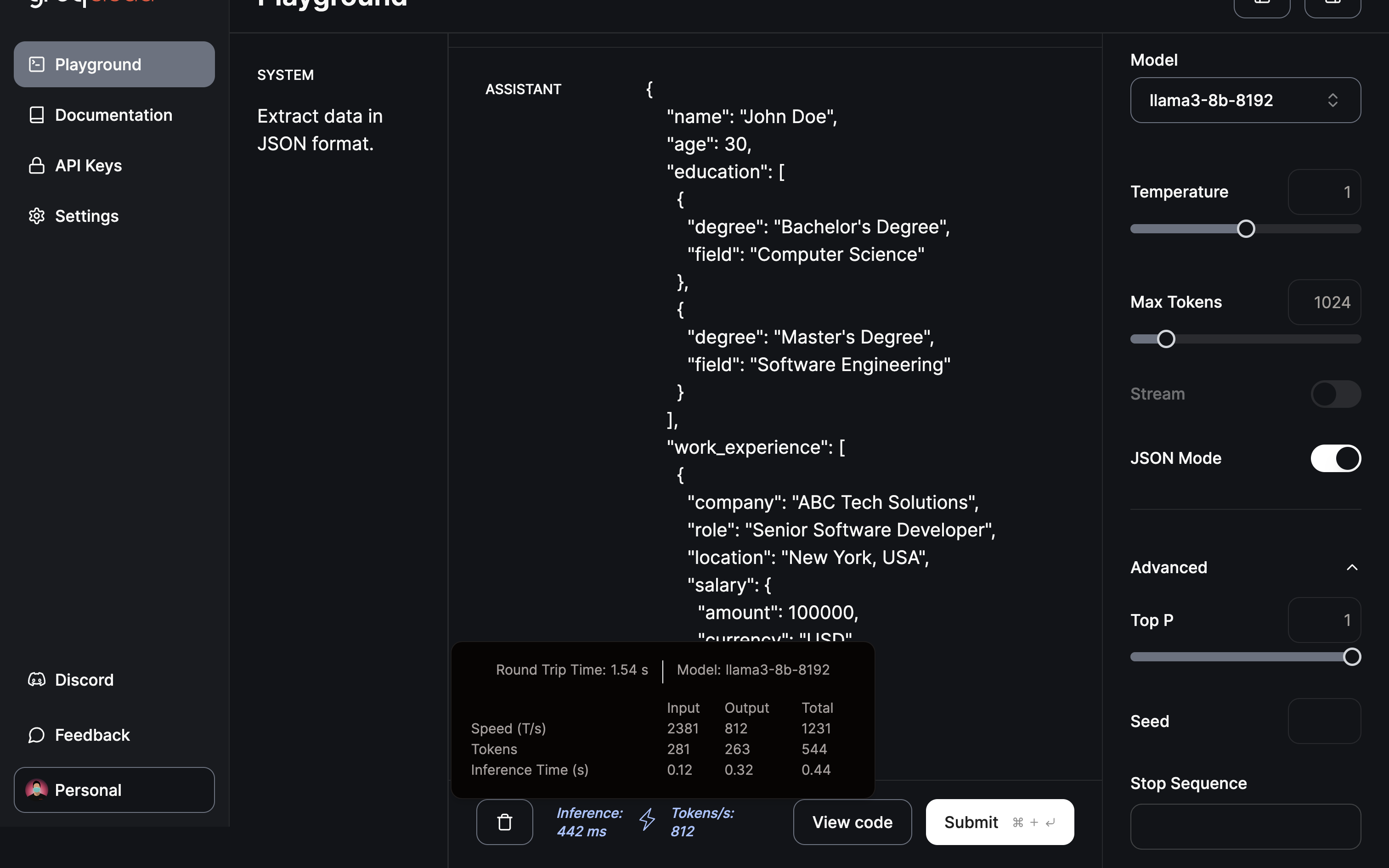

مطالبة النموذج باستخراج معلومات مفيدة وتوفير JSON باستخدام وضع JSON.

تم الانتهاء من الاستخراج والتحويل إلى تنسيق JSON في أقل من نصف ثانية.

استنتاج

كما هو موضح ، برزت Groq كمغير لقواعد اللعبة في مشهد LLM من خلال محرك الاستدلال LPU المبتكر. يشير التحول السريع المعروض هنا إلى الإمكانات الهائلة لتسريع تطبيقات الذكاء الاصطناعي. بالنظر إلى المستقبل ، لا يسع المرء إلا أن يتكهن بالابتكارات المستقبلية من Groq. ربما ، يمكن لوحدة معالجة الصور أن تحدث ثورة في نماذج توليد الصور ، مما يساهم في التقدم في توليد الفيديو الذكاء الاصطناعي. في الواقع ، إنه مستقبل مثير لتوقعه.

بالنظر إلى المستقبل ، نظرا لأن تدريب LLM أصبح أكثر كفاءة ، فإن إمكانية الحصول على ChatGPT مخصص ، مضبوط بدقة مع بياناتك على جهازك المحلي ، يصبح احتمالا محيرا. إحدى المنصات التي توفر مثل هذه القدرات هي Cody ، وهو مساعد الذكاء الاصطناعي ذكي مصمم خصيصا لدعم الشركات في مختلف الجوانب. مثل ChatGPT ، يمكن تدريب Cody على بيانات عملك وفريقك وعملياتك وعملائك ، باستخدام قاعدة المعرفة الفريدة الخاصة بك.

مع Cody ، يمكن للشركات تسخير قوة الذكاء الاصطناعي لإنشاء مساعد شخصي وذكي يلبي احتياجاتهم على وجه التحديد ، مما يجعله إضافة واعدة لعالم حلول الأعمال التي تعتمد على الذكاء الاصطناعي.