تحسين الإنتاجية البحثية باستخدام أدوات الذكاء الاصطناعي

يشهد مشهد البحوث الحديثة تحولاً جذرياً بفضل ظهور الذكاء الاصطناعي (AI).

تسهل هذه الأنظمة الذكية على الباحثين معالجة كميات هائلة من البيانات واستخراج رؤى قيمة بسرعة.

ومن العناصر الحاسمة في هذا التحول مجموعة الأدوات التي تدعمها المحولات التوليدية المدربة مسبقًا (GPT)، والتي تم تصميمها للتعامل مع المهام المعقدة بكفاءة عالية.

أصبحت أدوات الذكاء الاصطناعي لا غنى عنها بشكل متزايد في البيئات البحثية الأكاديمية والمهنية.

فهي تساعد في تلخيص الأوراق البحثية المعقدة، وإجراء عمليات بحث متقدمة، وتحسين جودة الوثائق.

وبالاستفادة من هذه الأدوات، يمكن للباحثين تبسيط سير عملهم بشكل كبير والتركيز بشكل أكبر على التفكير الابتكاري وحل المشكلات.

1. تلخيص الأوراق البحثية المعقدة

إحدى أكثر المهام التي تستغرق وقتاً طويلاً في البحث هي فك رموز الأوراق المعقدة.

لحسن الحظ، أصبحت الأدوات التي تعمل بالذكاء الاصطناعي GPT لا تقدر بثمن في هذا المجال. SummarizePaper.com هي أداة ذكاء اصطناعي مفتوحة المصدر مصممة خصيصًا لتلخيص المقالات من arXiv، مما يجعلها أكثر سهولة في الفهم بالنسبة للباحثين.

بالإضافة إلى ذلك، تعمل أداة Unriddl على تبسيط الموضوعات المعقدة وتوفر ملخصات موجزة، مما يسمح للباحثين بفهم الأفكار المعقدة بسرعة.

ومن الأدوات البارزة الأخرى أداة Wordtune، التي يمكنها تلخيص المستندات الطويلة بسرعة، مما يساعد في فهم المعلومات الهائلة بكفاءة.

تمكّن هذه التطورات الباحثين من توفير الوقت والتركيز على التحليل النقدي والابتكار.

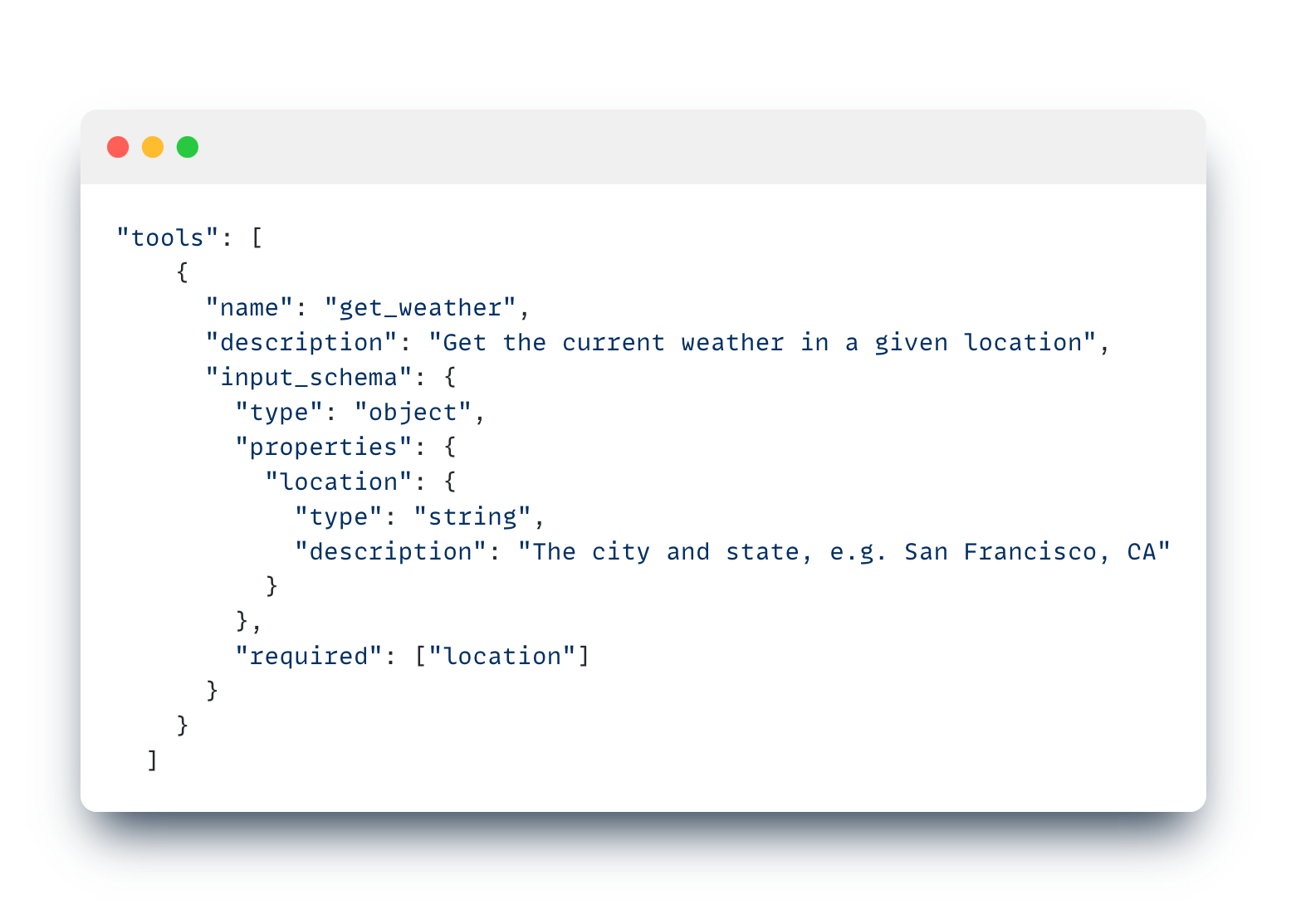

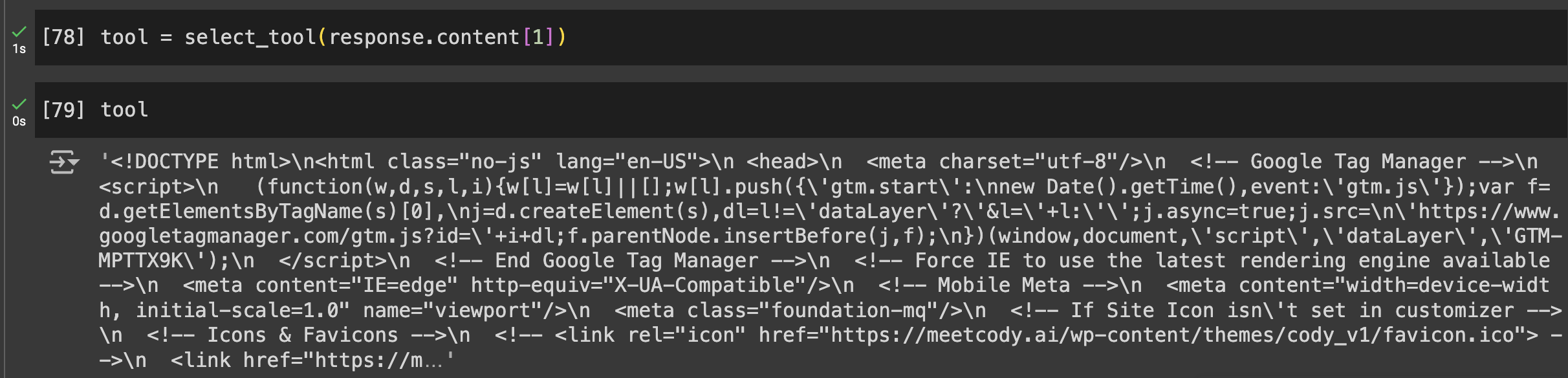

بالنسبة للأشخاص الذين يبحثون عن أداة أكثر تنوعًا مع ميزات بديهية مثل التحليل الانتقائي للوثائق، والطبيعة الانتقائية للنماذج، والقدرة على مشاركة الروبوتات المدربة على أوراقك البحثية – يعد Cody AI خيارًا رائعًا آخر يتضمن كل هذه الميزات.

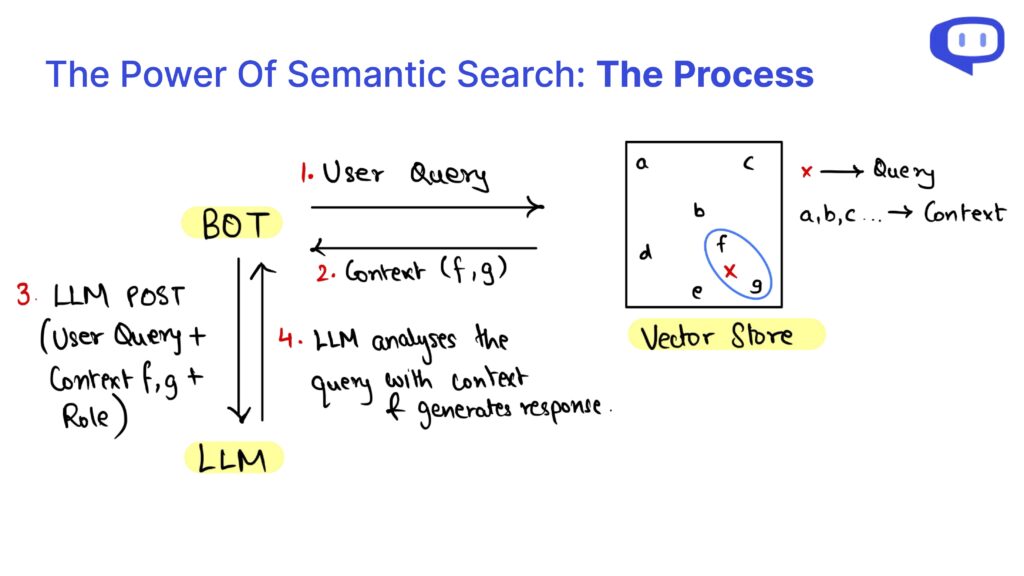

2. البحث المتقدم واسترجاع المعلومات

العثور على المعلومات الدقيقة بسرعة أمر بالغ الأهمية في البحث، وتتفوق أدوات الذكاء الاصطناعي في هذا المجال. Searcholic هو محرك بحث مدعوم بالذكاء الاصطناعي يساعد الباحثين في تحديد موقع مجموعة كبيرة من الكتب الإلكترونية والوثائق دون عناء.

تسهل هذه الأداة الوصول إلى مصادر المعلومات المتنوعة، مما يضمن حصول الباحثين على محتوى شامل في متناول أيديهم.

أداة قوية أخرى هي Semantic Scholar، التي تتيح الوصول إلى أكثر من 211 مليون ورقة علمية.

تُمكِّن أداة الذكاء الاصطناعي هذه المستخدمين من إجراء مراجعات شاملة للأدبيات من خلال توفير وظائف بحث متقدمة مصممة خصيصًا للبحث العلمي.

وأخيراً، يجمع تطبيق Perplexity بين وظائف محرك البحث وروبوت الدردشة، مما يسمح للباحثين بطرح الأسئلة وتلقي إجابات مفصلة بسرعة.

هذا النهج الهجين لا يوفر الوقت فحسب، بل يحسن أيضًا من كفاءة استرجاع المعلومات، مما يجعله أداة لا غنى عنها للباحثين المعاصرين.

3. تعزيز التوثيق البحثي

التوثيق الفعال أمر بالغ الأهمية لنشر البحوث والتحقق من صحتها. يعد Penelope AI أداة لا تقدر بثمن تسمح للباحثين بالتحقق من مخطوطاتهم الأكاديمية قبل تقديمها إلى المجلات، مما يضمن التزام عملهم بالمعايير والإرشادات العالية.

هناك أداة أخرى لا غنى عنها وهي Grammarly، التي تصحح الأخطاء النحوية والإملائية، وبالتالي تحسين قابلية قراءة المستندات البحثية واحترافيتها.

يساهم ذلك في تحسين جودة البحث ووضوحه بشكل عام، مما يجعله في متناول جمهور أوسع.

وعلاوة على ذلك، تساعد كودوس الباحثين على شرح أعمالهم بلغة بسيطة وإنشاء صفحات جذابة بصريًا.

وتعزز هذه الخدمة من وضوح البحث من خلال ترجمة الموضوعات المعقدة إلى محتوى أكثر قابلية للفهم، وبالتالي توسيع نطاق التأثير المحتمل لنتائج البحث.

تضمن هذه الأدوات مجتمعةً أن يكون توثيق البحوث شاملًا ومعروضًا بشكل جيد ومفهوم، مما يساعد في نهاية المطاف في التواصل الفعال للاكتشافات العلمية.

الخاتمة: احتضان الذكاء الاصطناعي للأبحاث المستقبلية

يوفر دمج أدوات GPT والذكاء الاصطناعي في عملية البحث العديد من الفوائد، بدءًا من تلخيص الأوراق البحثية المعقدة إلى تعزيز التوثيق.

تعمل أدوات مثل SummarizePaper.com و Unriddl على تبسيط فهم الموضوعات المعقدة من خلال توفير ملخصات موجزة، مما يجعل الوصول إلى المؤلفات الأكاديمية أكثر سهولة.

بالإضافة إلى ذلك، تعمل محركات البحث التي تعمل بالذكاء الاصطناعي مثل Semant Scholar على تسهيل استرجاع المعلومات بكفاءة، مما يعزز بشكل كبير سير العمل البحثي.

أما بالنسبة للتوثيق، فتضمن أدوات مثل Penelope AI و Grammarly أن تستوفي الأوراق البحثية معايير عالية وتتواصل بوضوح.

كما تعمل Kudos على توسيع نطاق البحث من خلال ترجمة النتائج المعقدة إلى لغة بسيطة.

تعمل أدوات الذكاء الاصطناعي هذه مجتمعة على تعزيز دقة الأنشطة البحثية وكفاءتها وتأثيرها.

ومع استمرارنا في تبني الذكاء الاصطناعي في مجال البحث، فإننا لا نحسّن سير العمل الفردي فحسب، بل نساهم أيضًا في المجتمع العلمي الأوسع نطاقًا.

يُعد دمج هذه الأدوات المتقدمة خطوة نحو إجراء بحوث أكثر كفاءة ودقة وسهولة في الوصول إليها، مما يؤدي إلى الابتكار والاكتشافات المستقبلية.