Groq e Llama 3: uma dupla que muda o jogo

Há alguns meses, uma nova empresa chamada “Groq” surgiu aparentemente do nada, fazendo um grande avanço no setor de IA. Eles forneceram uma plataforma para os desenvolvedores acessarem as LPUs como mecanismos de inferência para LLMs, especialmente os de código aberto, como Llama, Mixtral e Gemma. Neste blog, vamos explorar o que torna o Groq tão especial e nos aprofundar na maravilha por trás das LPUs.

O que é Groq?

“A Groq tem a missão de definir o padrão para a velocidade de inferência da GenAI, ajudando os aplicativos de IA em tempo real a ganhar vida hoje.” – Site da Groq

A Groq não é uma empresa que desenvolve LLMs como a GPT ou a Gemini. Em vez disso, o Groq se concentra em aprimorar as bases desses grandes modelos de linguagem – o hardware em que operam. Ele funciona como um “mecanismo de inferência”. Atualmente, a maioria dos LLMs no mercado utiliza GPUs tradicionais implantadas em servidores privados ou na nuvem. Embora essas GPUs sejam caras e potentes, fornecidas por empresas como a Nvidia, elas ainda dependem da arquitetura tradicional de GPU, que pode não ser ideal para a inferência LLM (embora continuem sendo potentes e preferidas para modelos de treinamento).

O mecanismo de inferência fornecido pelo Groq funciona em LPUs – Unidades de Processamento de Linguagem.

O que é uma LPU?

Uma Unidade de Processamento de Linguagem é um chip projetado especificamente para LLMs e é construído em uma arquitetura exclusiva que combina CPUs e GPUs para transformar o ritmo, a previsibilidade, o desempenho e a precisão das soluções de IA para LLMs.

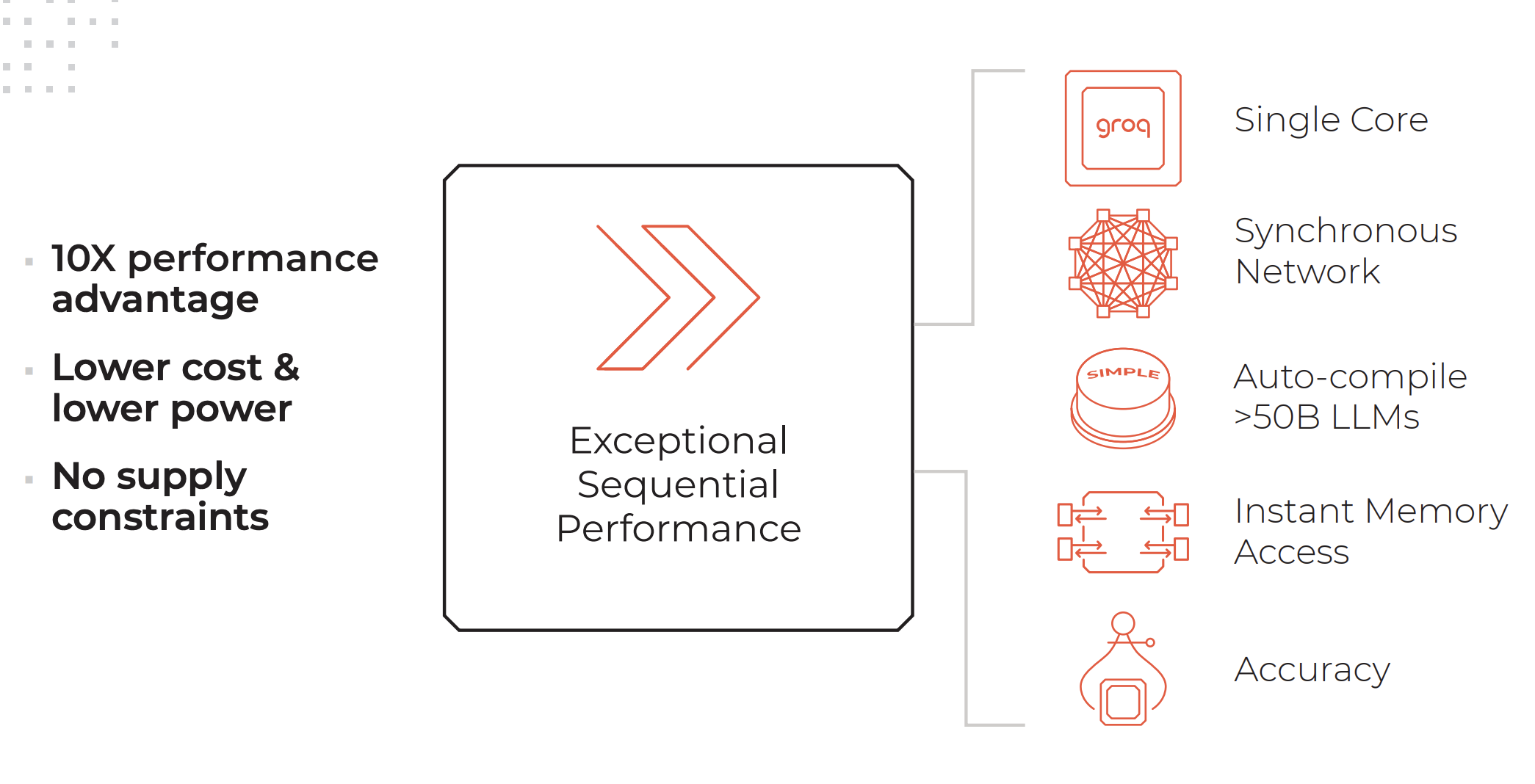

Principais atributos de um sistema de LPU. Créditos: Groq

Um sistema LPU tem tanto ou mais computação do que um processador gráfico (GPU) e reduz o tempo de cálculo por palavra, permitindo a geração mais rápida de sequências de texto.

Recursos de um mecanismo de inferência de LPU, conforme listado no site do Groq:

- Desempenho sequencial excepcional

- Arquitetura de núcleo único

- Rede síncrona que é mantida mesmo em implementações de grande escala

- Capacidade de compilar automaticamente >50B LLMs

- Acesso instantâneo à memória

- Alta precisão que é mantida mesmo em níveis de precisão mais baixos

Serviços fornecidos pela Groq:

- GroqCloud: LPUs na nuvem

- GroqRack: rack de 42U com até 64 chips interconectados

- GroqNode: Sistema de computação escalável pronto para rack 4U com oito aceleradores GroqCard™ interconectados

- GroqCard: Um único chip em um fator de forma padrão PCIe Gen 4×16 que oferece integração de servidor sem complicações

“Diferentemente da CPU, que foi projetada para realizar um tipo de tarefa completamente diferente da IA, ou da GPU, que foi projetada com base na CPU para fazer algo parecido com a IA por acidente, ou da TPU, que modificou a GPU para torná-la melhor para a IA, o Groq é, desde o início, um sistema de computador para IA” – Daniel Warfield, Towards Data Science

Para saber mais sobre como as LPUs diferem das GPUs, TPUs e CPUs, recomendamos que você leia este artigo abrangente escrito por Daniel Warfield para a Towards Data Science.

Qual é o objetivo do Groq?

Os LLMs são incrivelmente avançados, capazes de realizar tarefas que vão desde a análise de dados não estruturados até a resposta a perguntas sobre a fofura dos gatos. No entanto, sua principal desvantagem atualmente está no tempo de resposta. O tempo de resposta mais lento leva a uma latência significativa ao usar LLMs em processos de back-end. Por exemplo, buscar dados de um banco de dados e exibi-los no formato JSON é atualmente muito mais rápido quando você usa a lógica tradicional em vez de passar os dados por um LLM para transformação. No entanto, a vantagem dos LLMs está em sua capacidade de entender e lidar com exceções de dados.

Com a incrível velocidade de inferência oferecida pelo Groq, essa desvantagem dos LLMs pode ser bastante reduzida. Isso abre casos de uso melhores e mais amplos para os LLMs e reduz os custos, pois, com uma LPU, você poderá implantar modelos de código aberto que são muito mais baratos de executar com tempos de resposta realmente rápidos.

Llama 3 no Groq

Há algumas semanas, a Meta apresentou sua mais recente iteração do LLM-Llama 3, um software de código aberto já poderoso e altamente capaz. Além dos aprimoramentos típicos em velocidade, compreensão de dados e geração de tokens, dois aprimoramentos significativos se destacam:

- Treinado em um conjunto de dados 7 vezes maior que o Llama 2, com 4 vezes mais código.

- Dobrou o tamanho do contexto para 8.000 tokens.

O Llama 2 já era um LLM de código aberto formidável, mas com essas duas atualizações, espera-se que o desempenho do Llama 3 aumente significativamente.

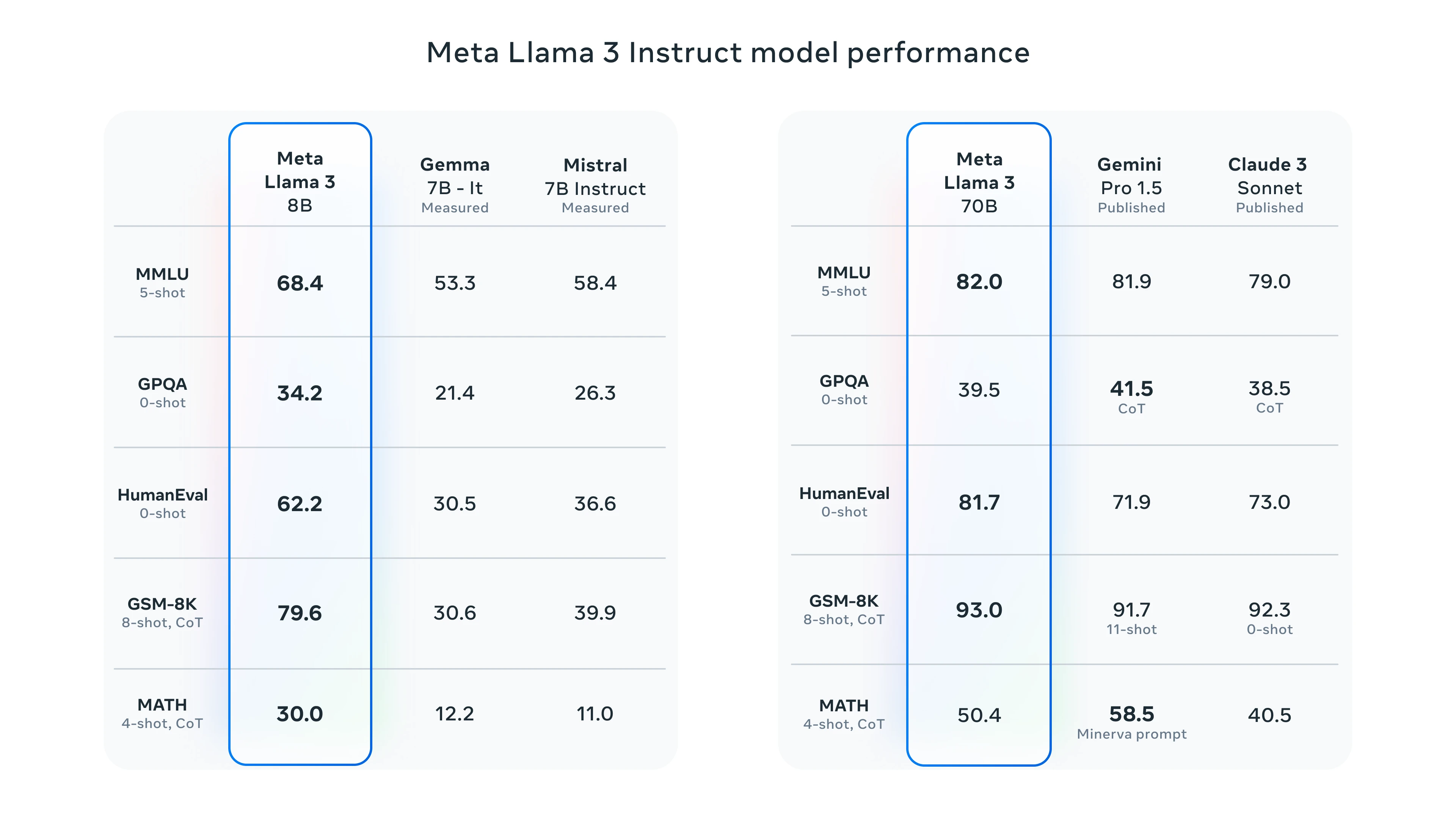

Benchmarks do Llama 3

Para testar o Llama 3, você tem a opção de utilizar o Meta AI ou o playground do Groq. Mostraremos o desempenho do Groq testando-o com o Llama 3.

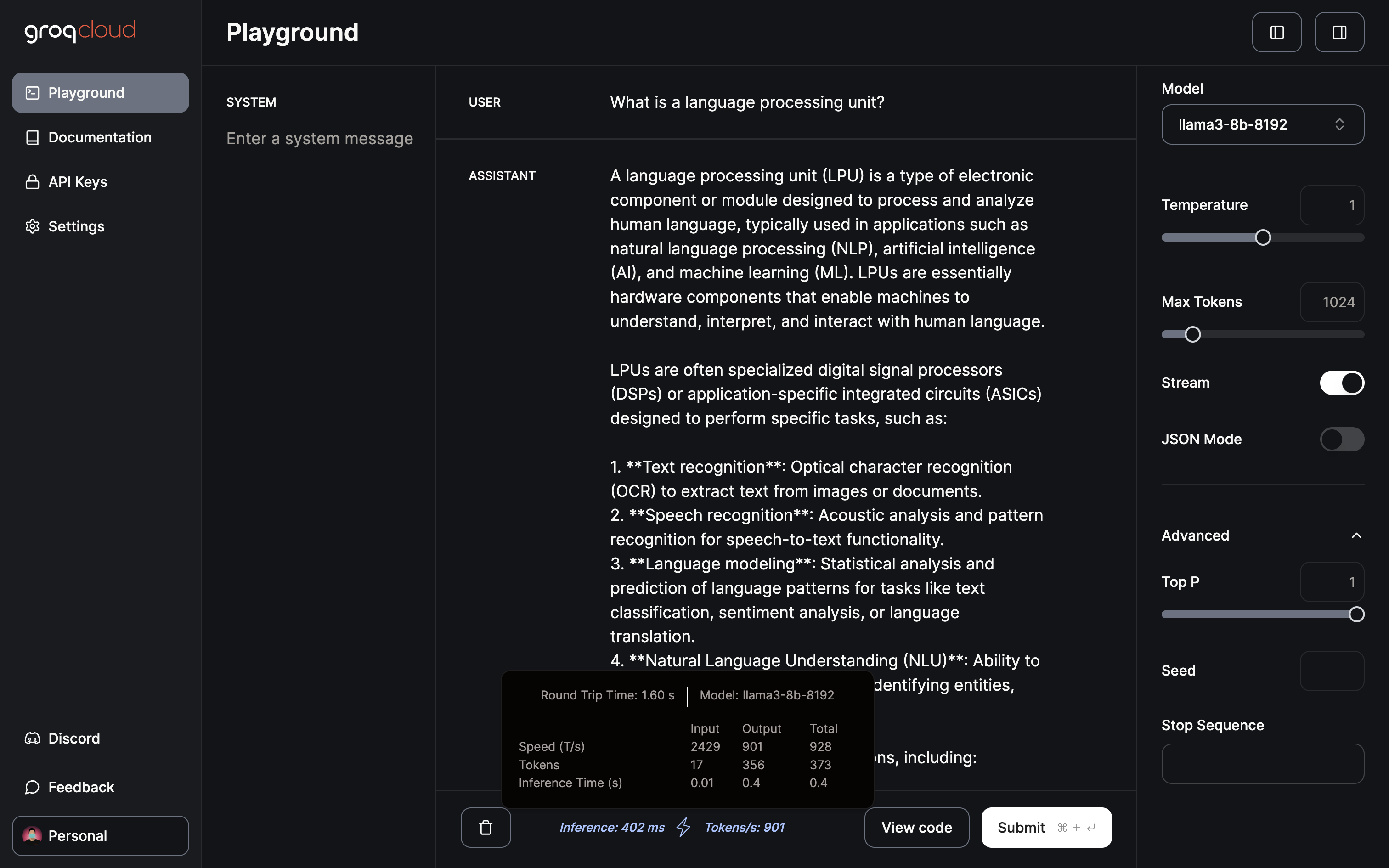

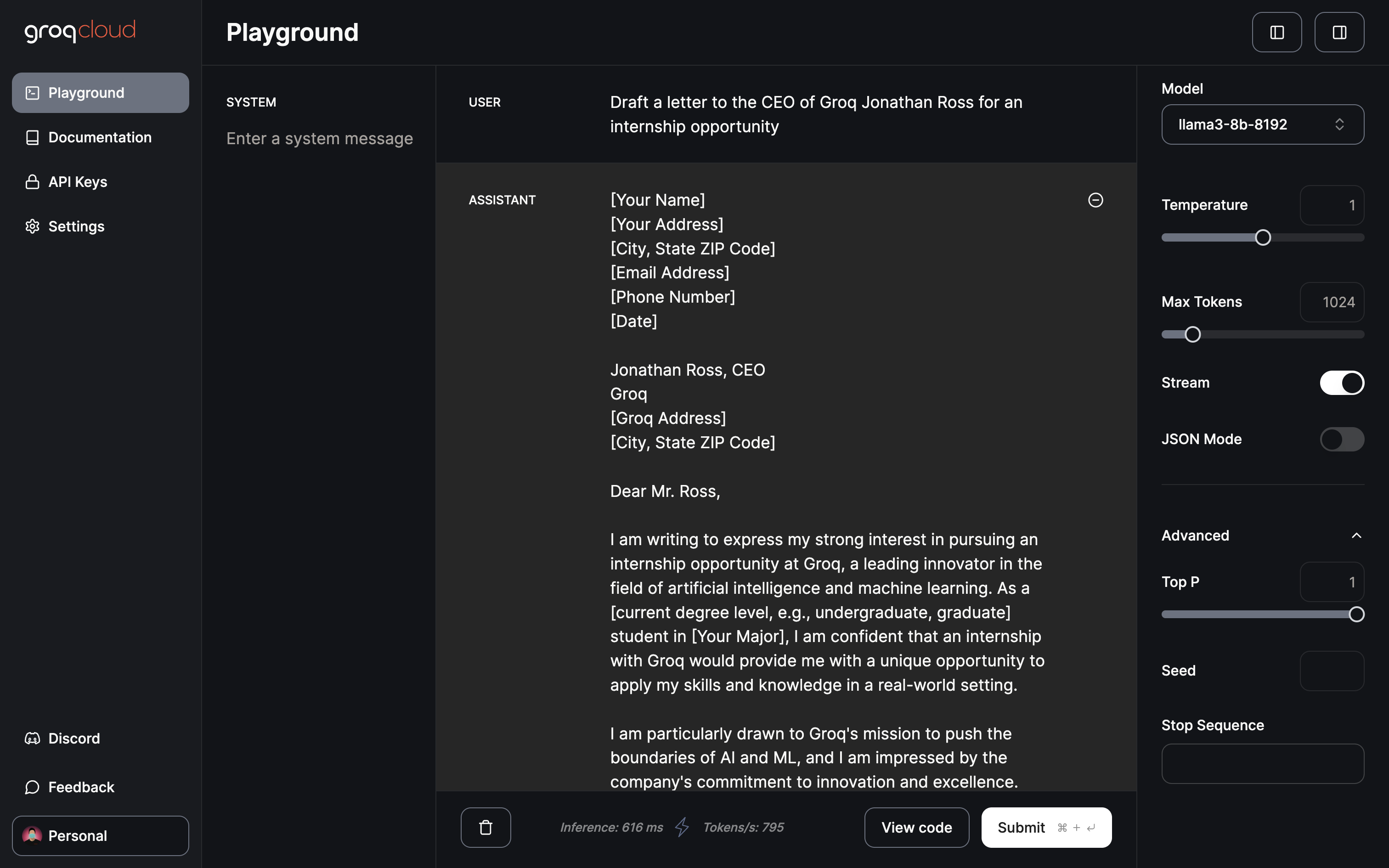

Groq Playground

Atualmente, o playground do Groq oferece acesso gratuito ao Gemma 7B, ao Llama 3 70B e 8B e ao Mixtral 8x7b. O playground permite que você ajuste parâmetros como temperatura, tokens máximos e alternância de streaming. Além disso, ele apresenta um modo JSON dedicado para gerar somente saída JSON.

Apenas 402 ms para inferência a uma taxa de 901 tokens/s

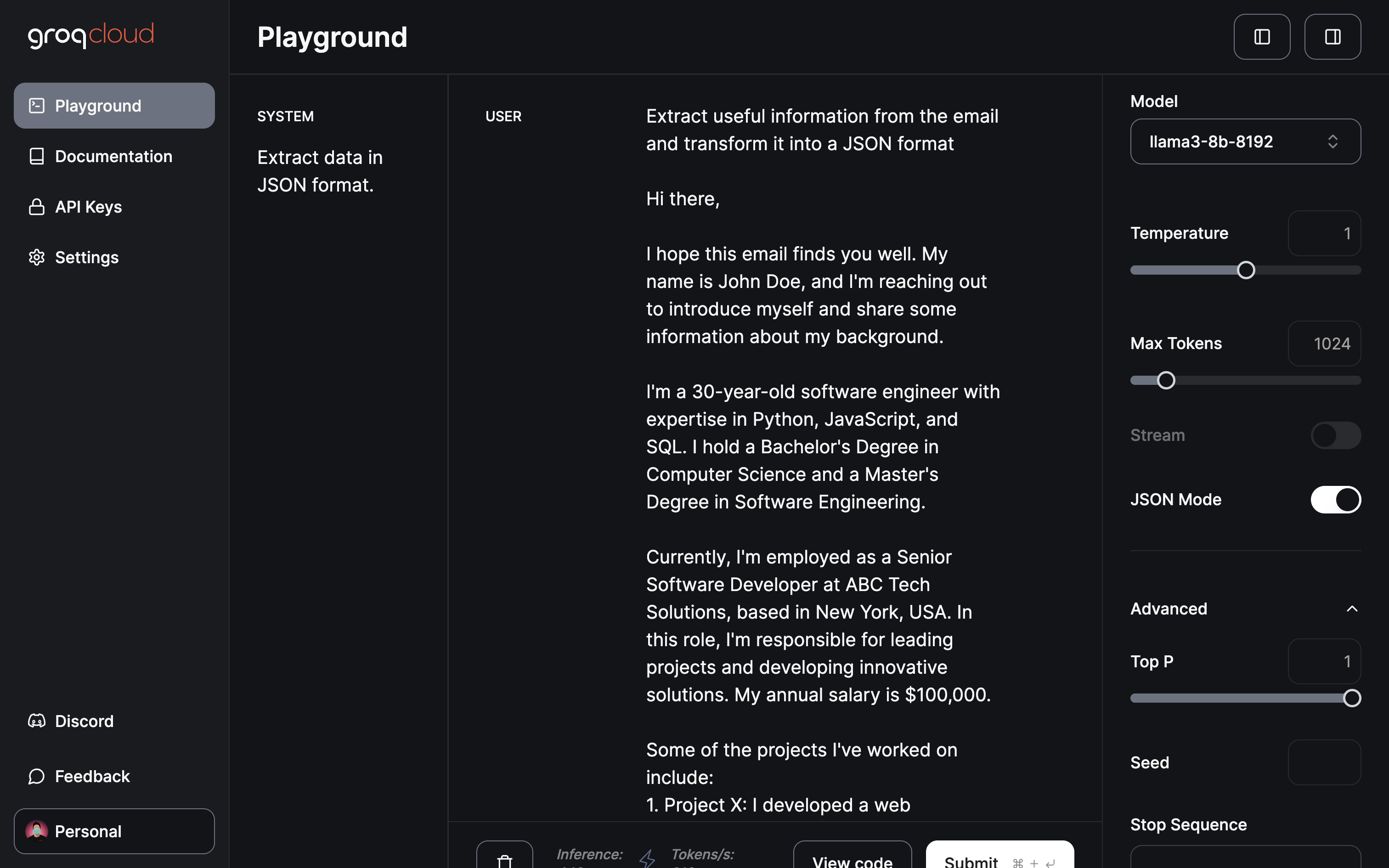

Chegando ao domínio/aplicativo de maior impacto, na minha opinião, a extração e transformação de dados:

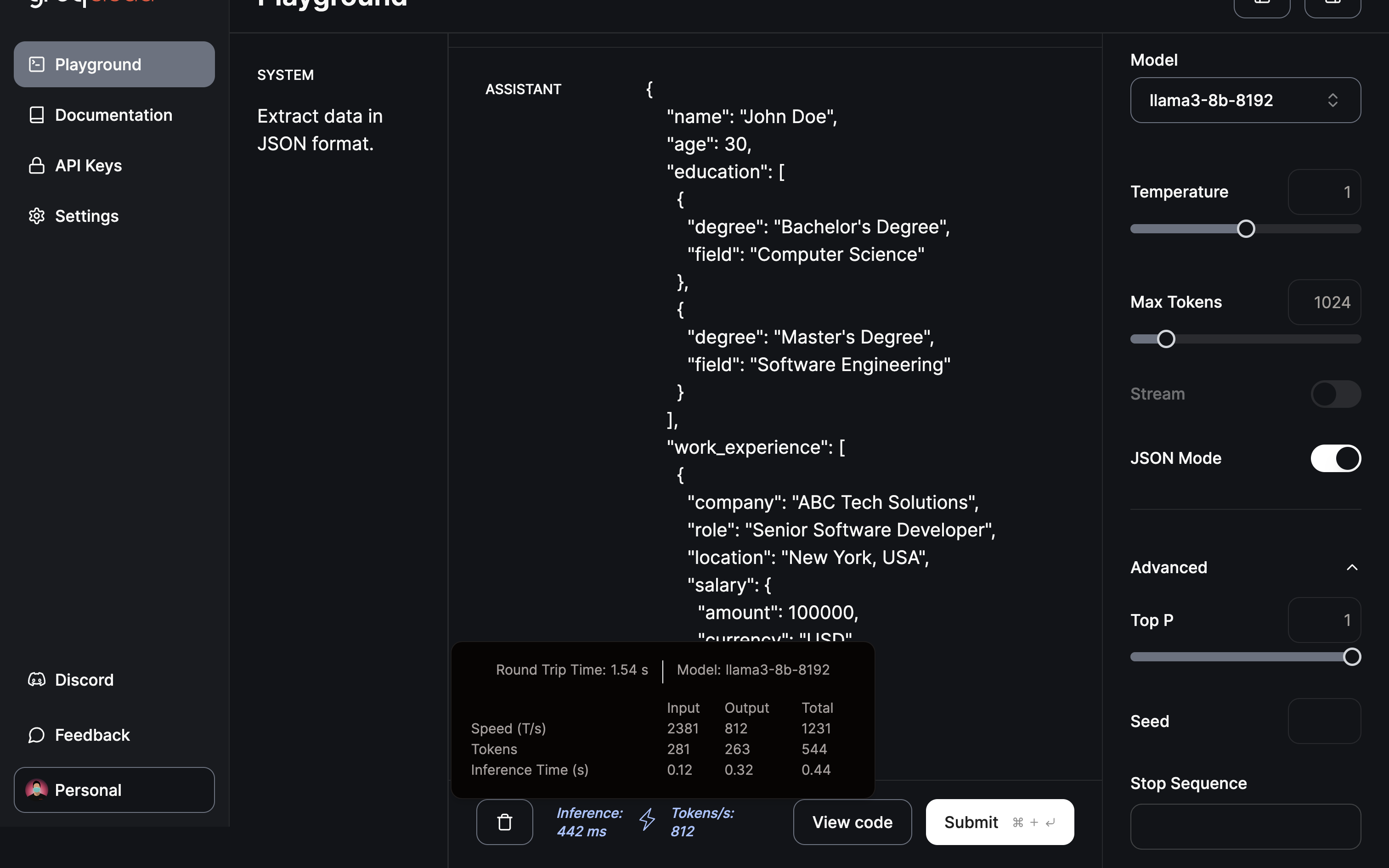

Solicitar ao modelo que extraia informações úteis e fornecer um JSON usando o modo JSON.

A extração e a transformação para o formato JSON foram concluídas em menos de meio segundo.

Conclusão

Conforme demonstrado, a Groq surgiu como um divisor de águas no cenário do LLM com seu inovador mecanismo de inferência de LPU. A rápida transformação mostrada aqui indica o imenso potencial para acelerar os aplicativos de IA. Olhando para o futuro, você só pode especular sobre as futuras inovações da Groq. Talvez uma unidade de processamento de imagens possa revolucionar os modelos de geração de imagens, contribuindo para os avanços na geração de vídeos com IA. De fato, é um futuro empolgante para você prever.

Olhando para o futuro, à medida que a formação LLM se torna mais eficiente, a possibilidade de ter um ChatGPT personalizado, ajustado com os seus dados no seu dispositivo local, torna-se uma perspetiva tentadora. Uma plataforma que oferece essas capacidades é a Cody, um assistente inteligente de IA concebido para apoiar as empresas em vários aspectos. Tal como o ChatGPT, o Cody pode ser treinado nos dados da sua empresa, equipa, processos e clientes, utilizando a sua base de conhecimentos exclusiva.

Com o Cody, as empresas podem tirar partido do poder da IA para criar um assistente personalizado e inteligente que se adapta especificamente às suas necessidades, o que o torna uma adição promissora ao mundo das soluções empresariais orientadas para a IA.