Bardzo oczekiwane wydarzenie DevDay OpenAI przyniosło kilka ekscytujących wiadomości i przecieków cenowych, które sprawiły, że społeczność AI brzęczała z niecierpliwością. Wśród najważniejszych wydarzeń znalazły się: premiera GPT-4 Turbo, znaczące obniżki cen różnych usług, okno kontekstowe GPT-4 turbo 128k oraz prezentacja API Assistants. Zagłębmy się w szczegóły i zobaczmy, jak te zmiany kształtują przyszłość sztucznej inteligencji.

GPT-4 Turbo: Więcej mocy w niższej cenie

Najważniejszym wydarzeniem było bez wątpienia zaprezentowanie GPT-4 Turbo. Ten zaawansowany model AI oferuje oszałamiające okno kontekstowe 128K, co stanowi znaczący krok naprzód w porównaniu z jego poprzednikiem, GPT-3.5. Dzięki temu rozszerzonemu kontekstowi GPT-4 Turbo może odczytywać i przetwarzać informacje odpowiadające 400-stronicowej książce w jednym oknie kontekstowym. Ta nowo odkryta zdolność eliminuje jeden z kluczowych wyróżników Anthropic, firmy siostrzanej OpenAI, ponieważ GPT-4 Turbo oferuje teraz porównywalny rozmiar kontekstu.

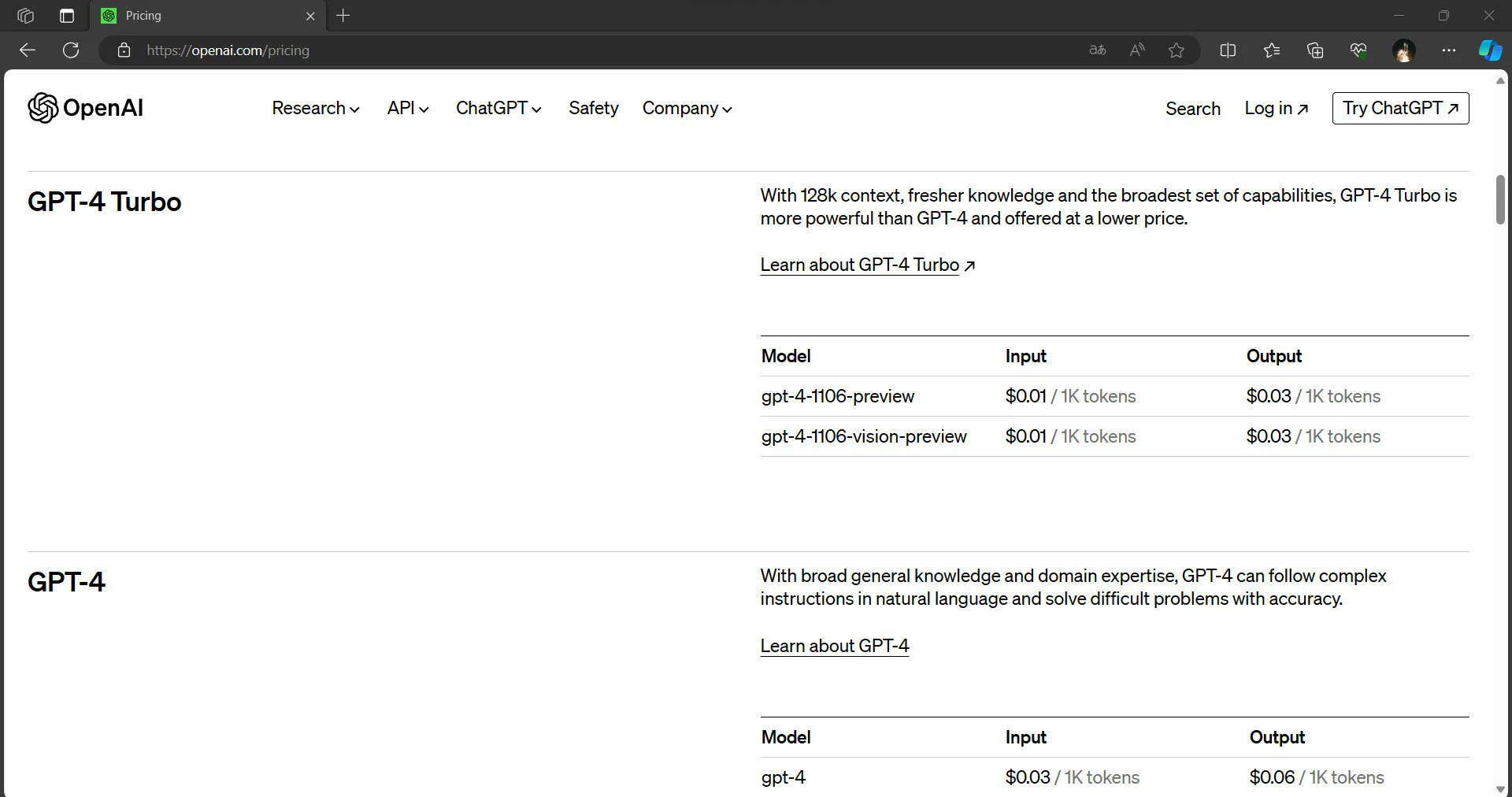

Na tym jednak wiadomości się nie kończą. GPT-4 Turbo nie tylko oferuje większe okno kontekstowe, ale także zapewnia szybszą wydajność i jest dostępny za ułamek ceny wejściowej i wyjściowej GPT-4. To połączenie zwiększonych możliwości i opłacalności sprawia, że GPT-4 Turbo jest przełomem w świecie sztucznej inteligencji.

Obniżki cen we wszystkich obszarach

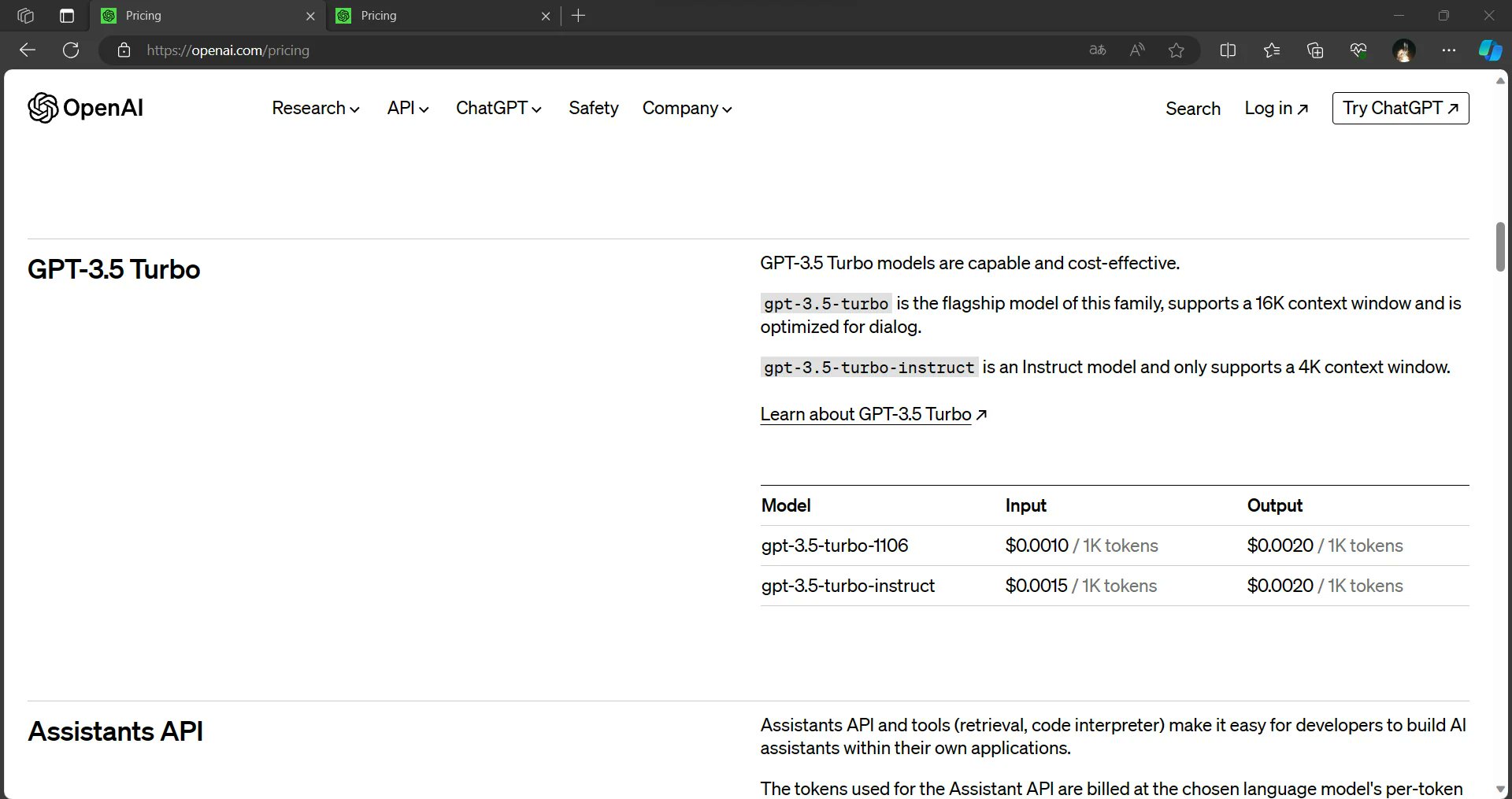

OpenAI sprawia, że sztuczna inteligencja jest bardziej dostępna i przystępna cenowo niż kiedykolwiek wcześniej. Wyciekłe informacje sugerują, że koszty wejściowe dla GPT-3.5 zostały obniżone o 33%. Dodatkowo, modele GPT-3.5 będą teraz domyślnie ustawione na 16K, dzięki czemu będą bardziej opłacalne dla użytkowników. Zmiany te mają na celu demokratyzację wykorzystania sztucznej inteligencji, umożliwiając szerszemu gronu odbiorców wykorzystanie mocy tych modeli.

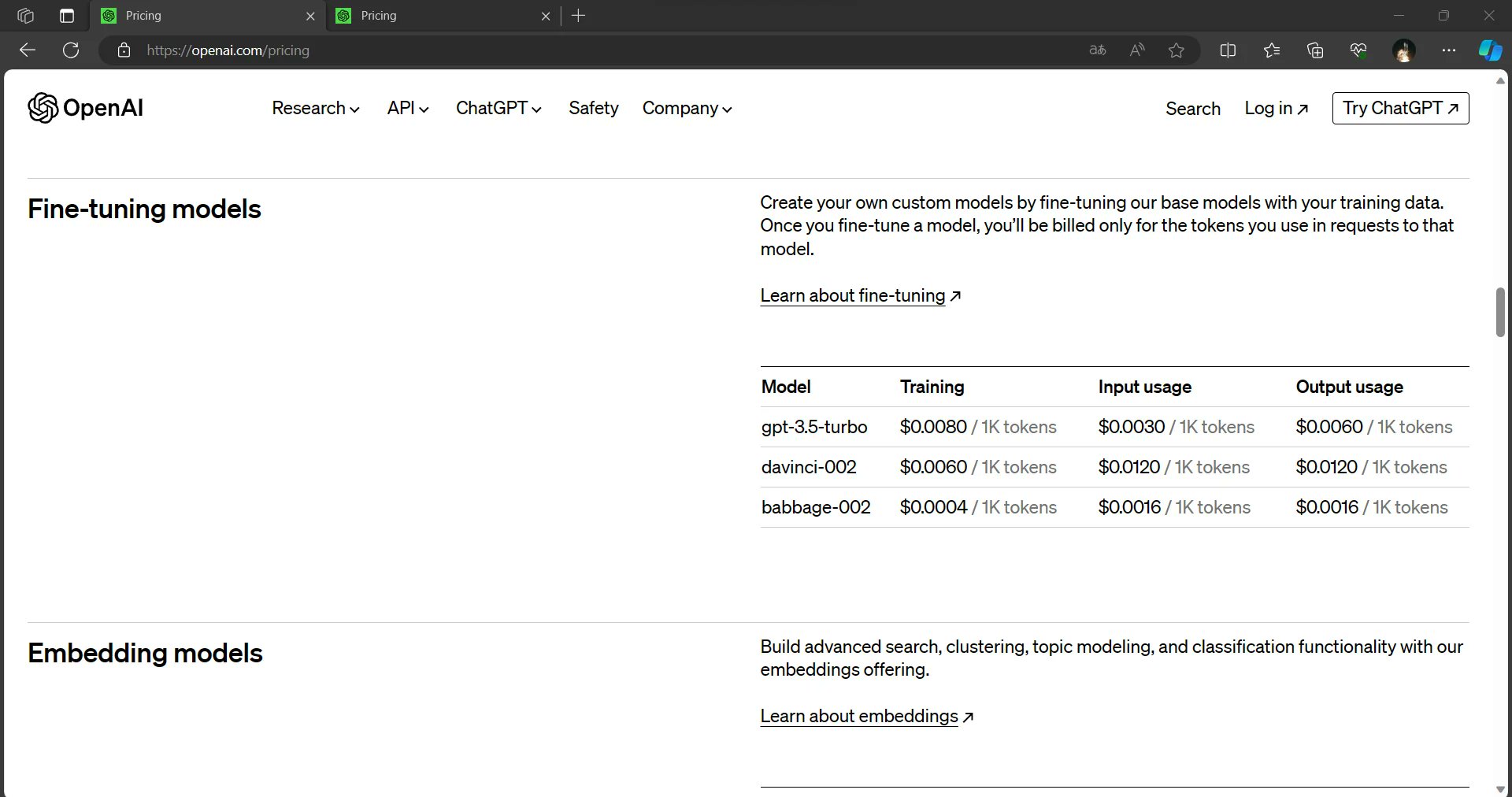

Precyzyjnie dostrojone modele, kluczowe zasoby dla wielu aplikacji AI, również korzystają ze znacznych obniżek cen. Koszty wnioskowania dla precyzyjnie dostrojonych modeli zostały podobno obniżone o 75% dla danych wejściowych i prawie 60% dla danych wyjściowych. Obniżki te obiecują umożliwić programistom i organizacjom wdrażanie rozwiązań opartych na sztucznej inteligencji w bardziej ekonomiczny sposób.

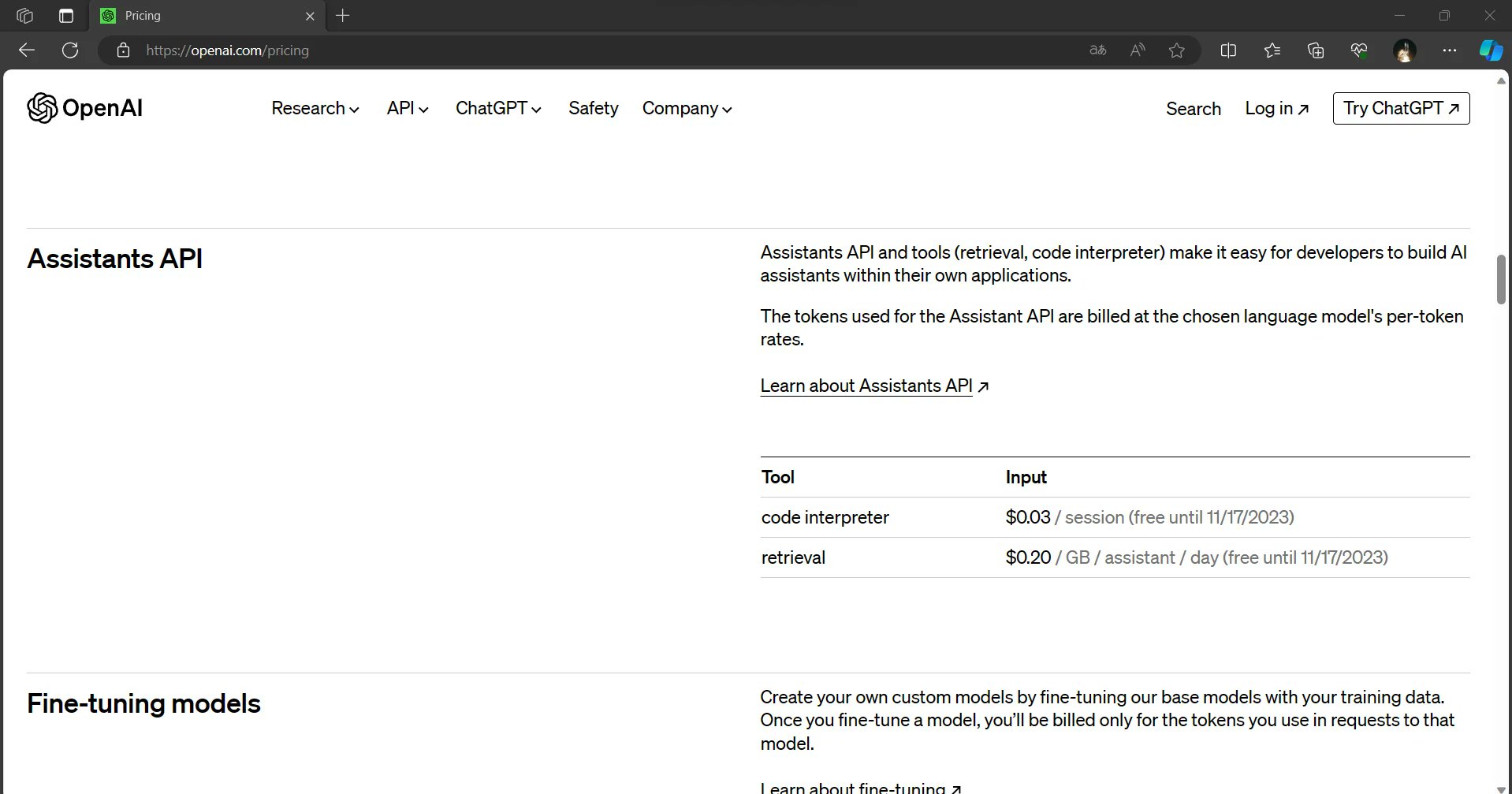

Assistants API: Nowa granica w sztucznej inteligencji

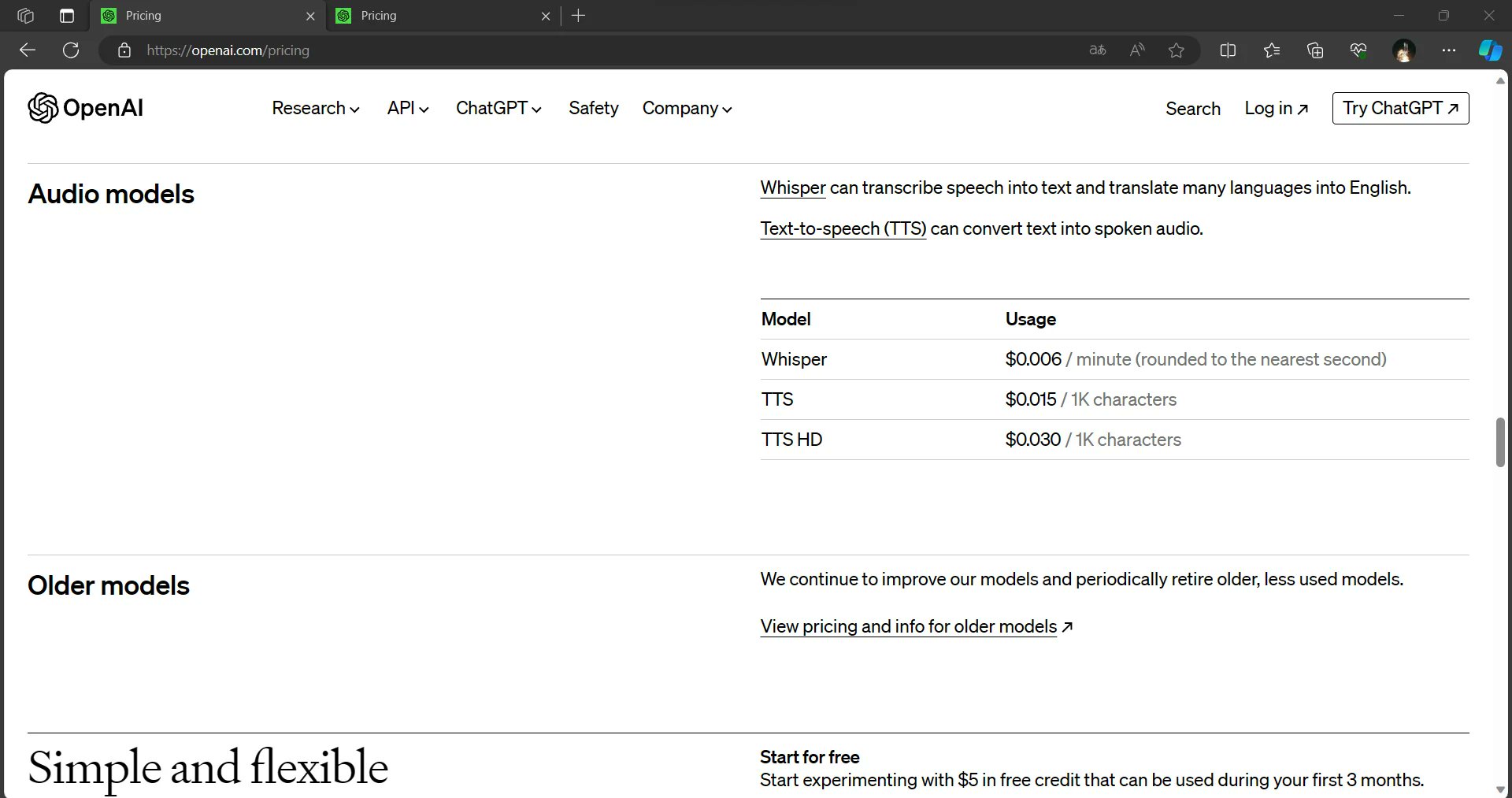

Podczas OpenAI DevDay zaprezentowano również nadchodzący interfejs API Assistants, który ma zapewnić użytkownikom interpreter kodu i możliwości wyszukiwania za pośrednictwem interfejsu API. Oczekuje się, że ta innowacja usprawni integrację sztucznej inteligencji z różnymi aplikacjami, umożliwiając programistom tworzenie jeszcze bardziej wydajnych i dynamicznych rozwiązań.

Dall-E 3 i Dall-E 3 HD: poszerzanie kreatywnych horyzontów

Wydarzenie ujawniło również wprowadzenie Dall-E 3 i Dall-E 3 HD. Chociaż modele te obiecują przesunąć granice kreatywnej sztucznej inteligencji, są one pozycjonowane jako droższe opcje w porównaniu do Dall-E 2. Rozszerzone możliwości tych modeli mogą jednak uzasadniać wyższe koszty dla użytkowników poszukujących najnowocześniejszej sztucznej inteligencji do generowania i manipulowania obrazami.

Moc kontekstu 128K

Mówiąc prościej, okno kontekstowe GPT-4 Turbo 128K pozwala mu przetwarzać i rozumieć zadziwiającą ilość informacji w pojedynczej instancji. W przypadku kontekstu, poprzednia generacja, GPT-3, miała okno kontekstowe składające się z 1024 tokenów. Tokeny mogą reprezentować słowa, znaki, a nawet podsłowa, w zależności od języka i tekstu. Okno kontekstowe GPT-4 Turbo 128K jest około 125 razy większe niż w przypadku GPT-3, co czyni go prawdziwym gigantem w świecie modeli językowych AI.

Praktyczne implikacje

Wprowadzenie GPT-4 Turbo z oknem kontekstowym 128K to znaczący krok naprzód w dziedzinie sztucznej inteligencji. Jego zdolność do przetwarzania i rozumienia ogromnych ilości informacji może zrewolucjonizować sposób, w jaki wchodzimy w interakcje z systemami AI, prowadzimy badania, tworzymy treści i nie tylko. W miarę jak programiści i badacze odkrywają możliwości tego potężnego narzędzia, możemy spodziewać się innowacyjnych aplikacji, które wykorzystają pełny potencjał możliwości GPT-4 Turbo, odblokowując nowe horyzonty w sztucznej inteligencji.

Kompleksowe zrozumienie

Z kontekstem 128K, GPT-4 Turbo może odczytywać i analizować obszerne dokumenty, artykuły lub zestawy danych w całości. Umożliwia to dostarczanie bardziej kompleksowych i dokładnych odpowiedzi na złożone pytania, zadania badawcze lub potrzeby analizy danych.

Ciągłość kontekstowa

Poprzednie modele często miały trudności z utrzymaniem kontekstu w długich dokumentach, co prowadziło do chaotycznych lub nieistotnych odpowiedzi. Okno GPT-4 Turbo 128K pozwala mu zachować kontekst w dłuższych fragmentach, co skutkuje bardziej spójnymi i kontekstowo istotnymi interakcjami.

Zmniejszenie przeciążenia informacjami

W erze nadmiaru informacji, zdolność GPT-4 Turbo do przetwarzania ogromnych ilości danych za jednym razem może być przełomem. Potrafi przesiewać duże zbiory danych, wyodrębniać kluczowe spostrzeżenia i zapewniać zwięzłe podsumowania, oszczędzając użytkownikom cenny czas i wysiłek.

Zaawansowane badania i pisanie

Naukowcy, pisarze i twórcy treści mogą odnieść znaczne korzyści z kontekstu 128K GPT-4 Turbo. Może pomóc w generowaniu dogłębnych prac badawczych, artykułów i raportów z głębokim zrozumieniem tematu.

Ulepszone tłumaczenie językowe

Zadania tłumaczenia językowego mogą również korzystać z szerszego kontekstu. GPT-4 Turbo może lepiej zrozumieć niuanse językowe, wyrażenia idiomatyczne i kontekst kulturowy, co prowadzi do dokładniejszych tłumaczeń.

Wyzwania i rozważania

Podczas gdy kontekst GPT-4 Turbo 128K niewątpliwie zmienia zasady gry, stanowi on również wyzwanie. Obsługa tak dużych modeli wymaga znacznych zasobów obliczeniowych, co może ograniczać dostępność dla niektórych użytkowników. Ponadto, w miarę jak modele AI stają się coraz potężniejsze, należy zająć się kwestiami etycznymi związanymi z prywatnością danych i generowaniem treści.

Więcej w drodze dla GPT-4?

Wydarzenie OpenAI DevDay dostarczyło wielu ekscytujących aktualizacji i wycieków cen, które mają kształtować krajobraz sztucznej inteligencji. GPT-4 Turbo wyróżnia się imponującym oknem kontekstowym 128K, szybszą wydajnością i niższą ceną. Ogólne obniżki cen za dane wejściowe, wyjściowe i dopracowane modele mają na celu demokratyzację wykorzystania sztucznej inteligencji, czyniąc ją bardziej dostępną dla szerszego grona odbiorców. Nadchodzące modele Assistants API i Dall-E 3 dodatkowo podkreślają zaangażowanie OpenAI w innowacje i rozwój w dziedzinie sztucznej inteligencji.

W miarę rozwoju sytuacji staje się jasne, że OpenAI jest zdeterminowana, aby zapewnić programistom, firmom i kreatywnym umysłom najnowocześniejsze narzędzia i usługi AI. Przyszłość sztucznej inteligencji wygląda jaśniej i jest bardziej dostępna niż kiedykolwiek wcześniej.

Czytaj więcej: OpenAI’s ChatGPT Enterprise: Koszty, korzyści i bezpieczeństwo