Groq i Llama 3: Duet zmieniający zasady gry

Kilka miesięcy temu nowa firma o nazwie “Groq” pojawiła się pozornie znikąd, dokonując przełomu w branży sztucznej inteligencji. Zapewniły one platformę dla programistów, aby uzyskać dostęp do LPU jako silników wnioskowania dla LLM, zwłaszcza tych open-source, takich jak Llama, Mixtral i Gemma. W tym blogu zbadamy, co sprawia, że Groq jest tak wyjątkowy i zagłębimy się w cud stojący za LPU.

Czym jest Groq?

“Misją Groq jest ustanowienie standardu szybkości wnioskowania GenAI, pomagając aplikacjom AI w czasie rzeczywistym już dziś”. – Strona internetowa Groq

Groq nie jest firmą, która rozwija LLM jak GPT czy Gemini. Zamiast tego Groq koncentruje się na ulepszaniu fundamentów tych dużych modeli językowych – sprzętu, na którym działają. Służy jako “silnik wnioskowania”. Obecnie większość dostępnych na rynku rozwiązań LLM wykorzystuje tradycyjne procesory graficzne wdrożone na prywatnych serwerach lub w chmurze. Chociaż te procesory graficzne są drogie i wydajne, pochodzą od firm takich jak Nvidia, nadal opierają się na tradycyjnej architekturze GPU, która może nie być optymalnie dostosowana do wnioskowania LLM (choć pozostają one wydajne i preferowane do trenowania modeli).

Silnik wnioskowania dostarczany przez Groq działa na jednostkach LPU – Language Processing Units.

Co to jest LPU?

Language Processing Unit to układ zaprojektowany specjalnie dla LLM i zbudowany w oparciu o unikalną architekturę łączącą CPU i GPU, aby zmienić tempo, przewidywalność, wydajność i dokładność rozwiązań AI dla LLM.

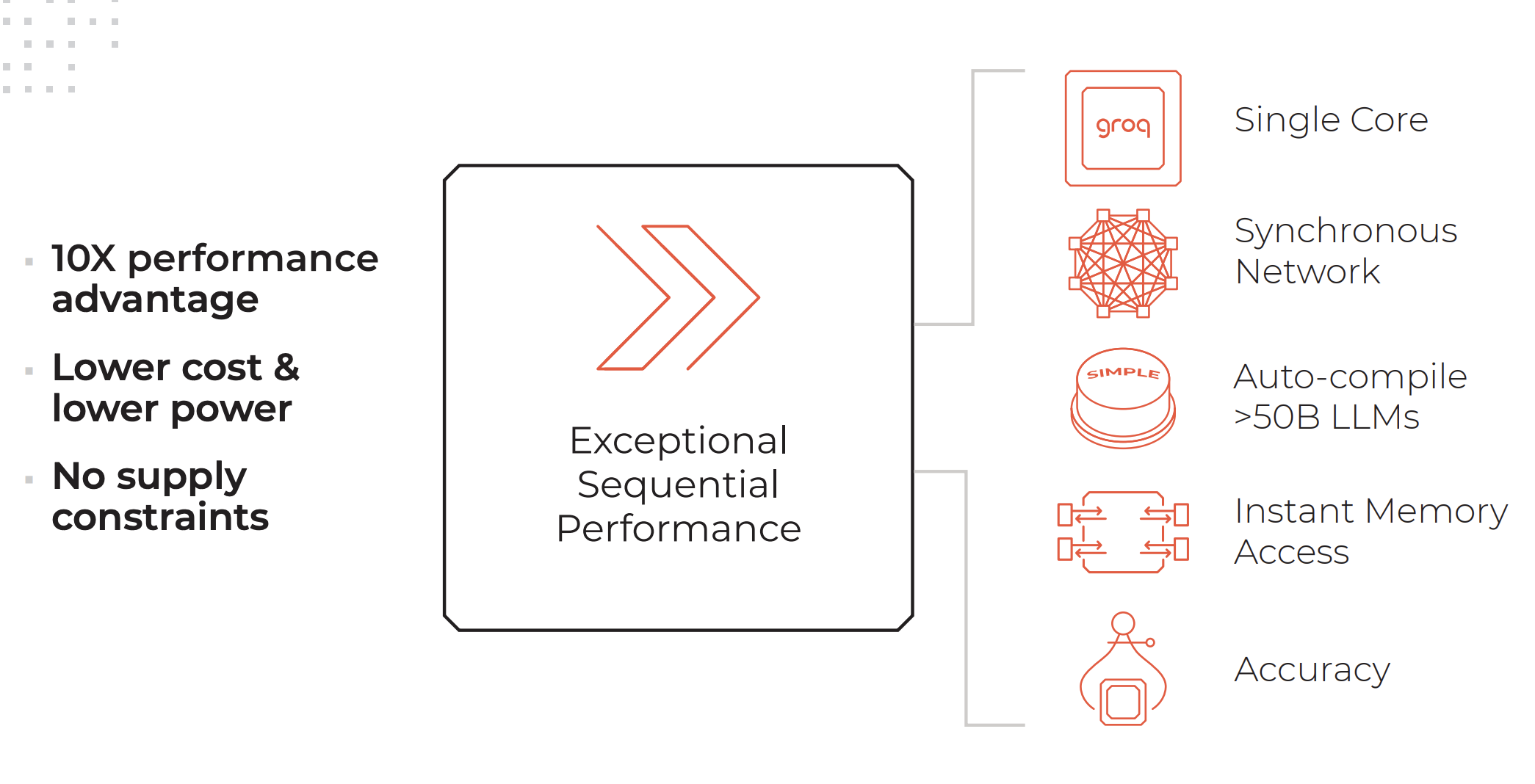

Kluczowe atrybuty systemu LPU. Kredyty: Groq

System LPU ma tyle samo lub więcej mocy obliczeniowej co procesor graficzny (GPU) i skraca czas obliczania każdego słowa, umożliwiając szybsze generowanie sekwencji tekstowych.

Cechy silnika wnioskowania LPU wymienione na stronie internetowej Groq:

- Wyjątkowa wydajność sekwencyjna

- Architektura jednordzeniowa

- Synchroniczne połączenie sieciowe utrzymywane nawet w przypadku wdrożeń na dużą skalę

- Możliwość automatycznej kompilacji >50B LLMs

- Natychmiastowy dostęp do pamięci

- Wysoka dokładność utrzymywana nawet przy niższych poziomach precyzji

Usługi świadczone przez Groq:

- GroqCloud: LPU w chmurze

- GroqRack: stelaż 42U z maksymalnie 64 połączonymi chipami

- GroqNode: Skalowalny system obliczeniowy 4U z ośmioma połączonymi akceleratorami GroqCard™.

- GroqCard: Pojedynczy układ w standardowej obudowie PCIe Gen 4×16 zapewniający bezproblemową integrację z serwerem

“W przeciwieństwie do CPU, który został zaprojektowany do wykonywania zupełnie innego rodzaju zadań niż sztuczna inteligencja, lub GPU, który został zaprojektowany w oparciu o CPU, aby zrobić coś w rodzaju sztucznej inteligencji przez przypadek, lub TPU, który zmodyfikował GPU, aby uczynić go lepszym dla sztucznej inteligencji, Groq jest od podstaw, od pierwszych zasad, systemem komputerowym dla sztucznej inteligencji” – Daniel Warfield, Towards Data Science

Aby dowiedzieć się więcej o tym, czym LPU różnią się od GPU, TPU i CPU, zalecamy przeczytanie tego obszernego artykułu napisanego przez Daniela Warfielda dla Towards Data Science.

Jaki jest sens Groq?

Maszyny LLM są niezwykle potężne, zdolne do wykonywania różnych zadań, od analizowania nieustrukturyzowanych danych po odpowiadanie na pytania dotyczące słodkości kotów. Jednak ich główną wadą jest obecnie czas reakcji. Wolniejszy czas reakcji prowadzi do znacznych opóźnień podczas korzystania z LLM w procesach backendowych. Na przykład pobieranie danych z bazy danych i wyświetlanie ich w formacie JSON jest obecnie znacznie szybsze, gdy odbywa się przy użyciu tradycyjnej logiki, a nie przekazywania danych przez LLM do transformacji. Zaletą LLM jest jednak ich zdolność do rozumienia i obsługi wyjątków danych.

Dzięki niesamowitej szybkości wnioskowania oferowanej przez Groq, ta wada LLM może zostać znacznie zmniejszona. Otwiera to lepsze i szersze zastosowania dla LLM i obniża koszty, ponieważ dzięki LPU będziesz w stanie wdrożyć modele open-source, które są znacznie tańsze w eksploatacji z naprawdę krótkim czasem reakcji.

Llama 3 na Groq

Kilka tygodni temu Meta zaprezentowała najnowszą wersję już potężnego i wysoce wydajnego oprogramowania open-source LLM-Llama 3. Oprócz typowych ulepszeń w zakresie szybkości, rozumienia danych i generowania tokenów, wyróżniają się dwa znaczące ulepszenia:

- Przetrenowany na zbiorze danych 7 razy większym niż Llama 2, z 4 razy większą ilością kodu.

- Podwojona długość kontekstu do 8000 tokenów.

Llama 2 była już potężnym open-source’owym LLM, ale dzięki tym dwóm aktualizacjom oczekuje się, że wydajność Llamy 3 znacznie wzrośnie.

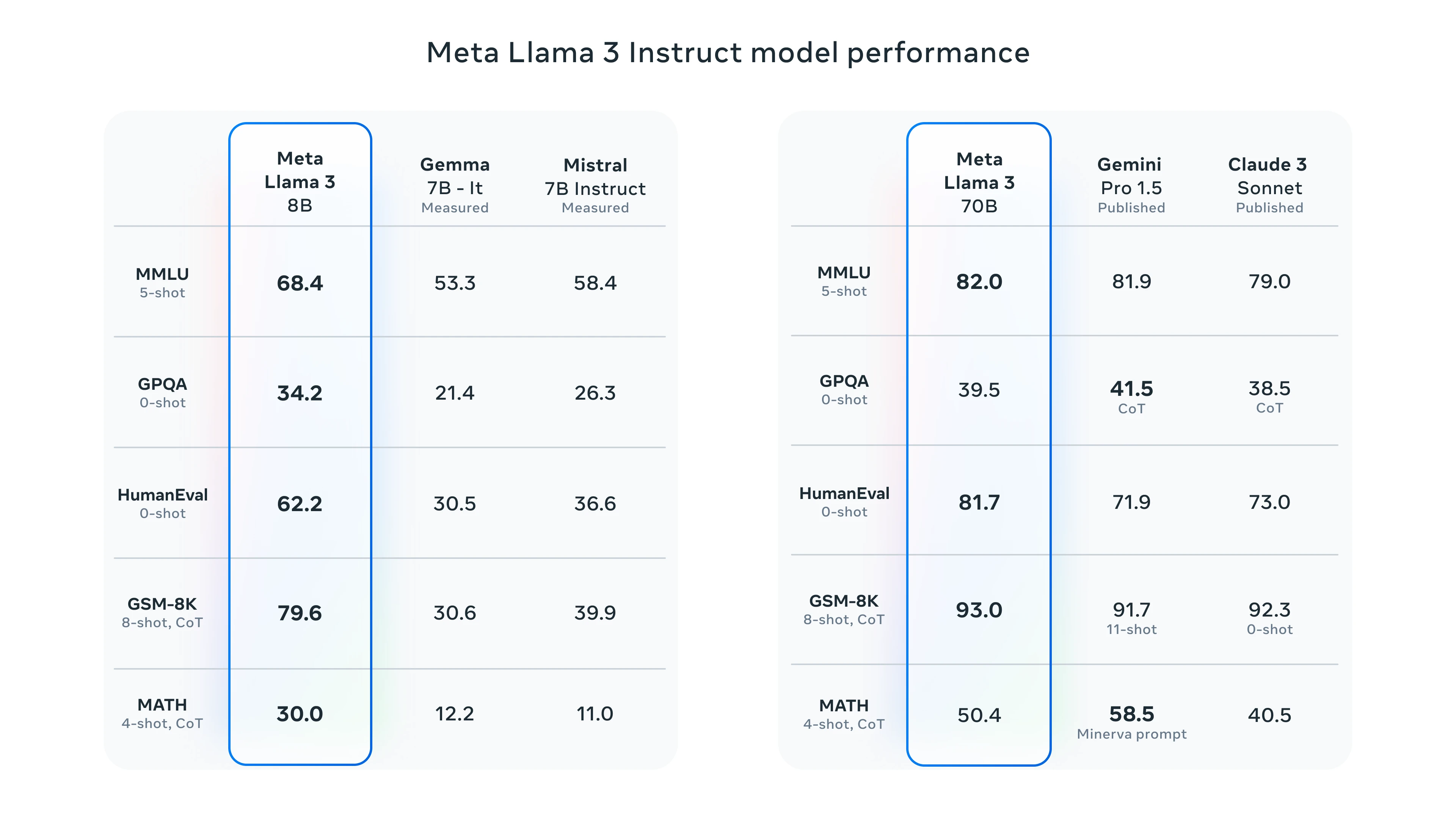

Testy porównawcze Llama 3

Aby przetestować Llama 3, możesz skorzystać z Meta AI lub placu zabaw Groq. Zaprezentujemy wydajność Groq, testując go z Llama 3.

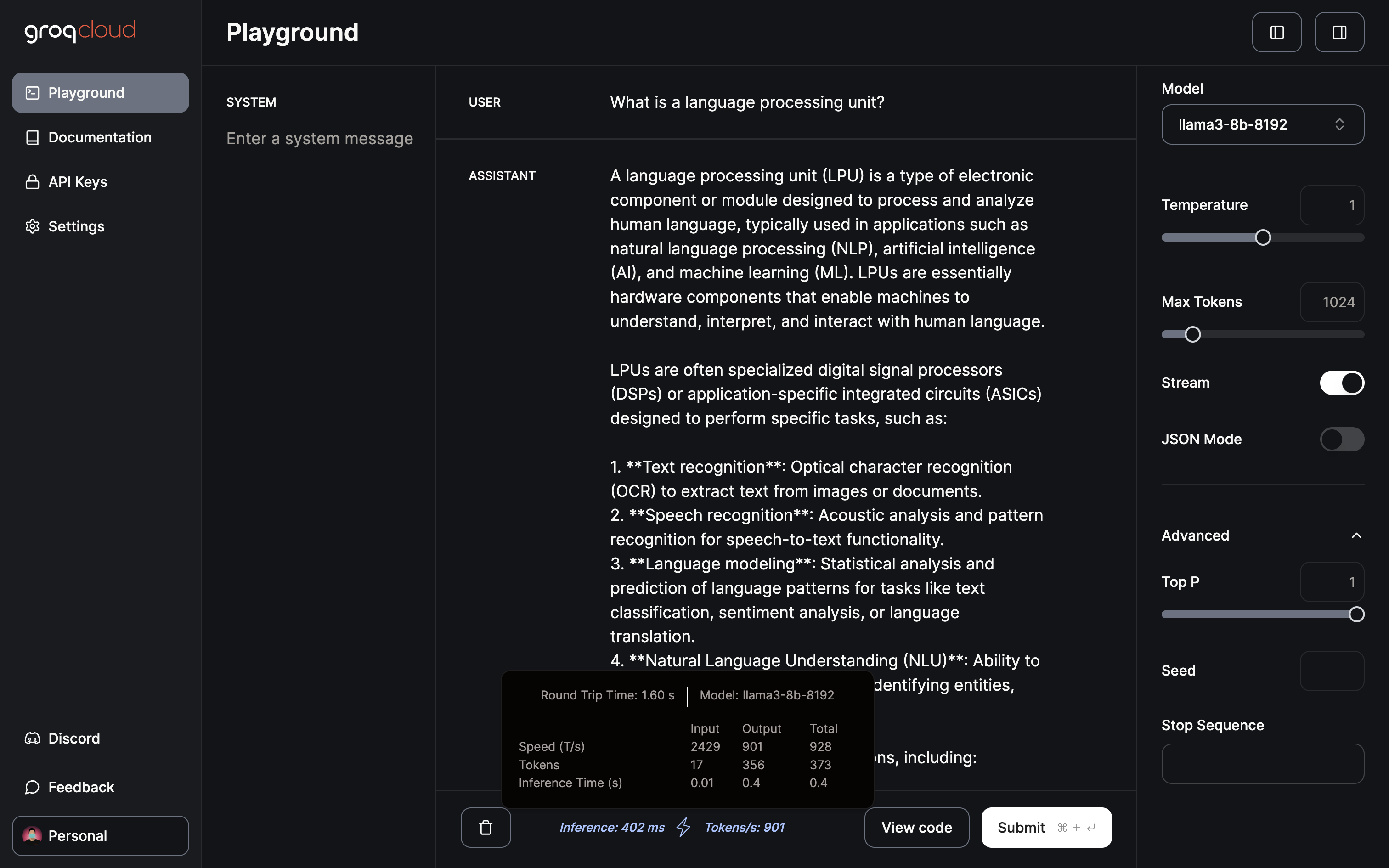

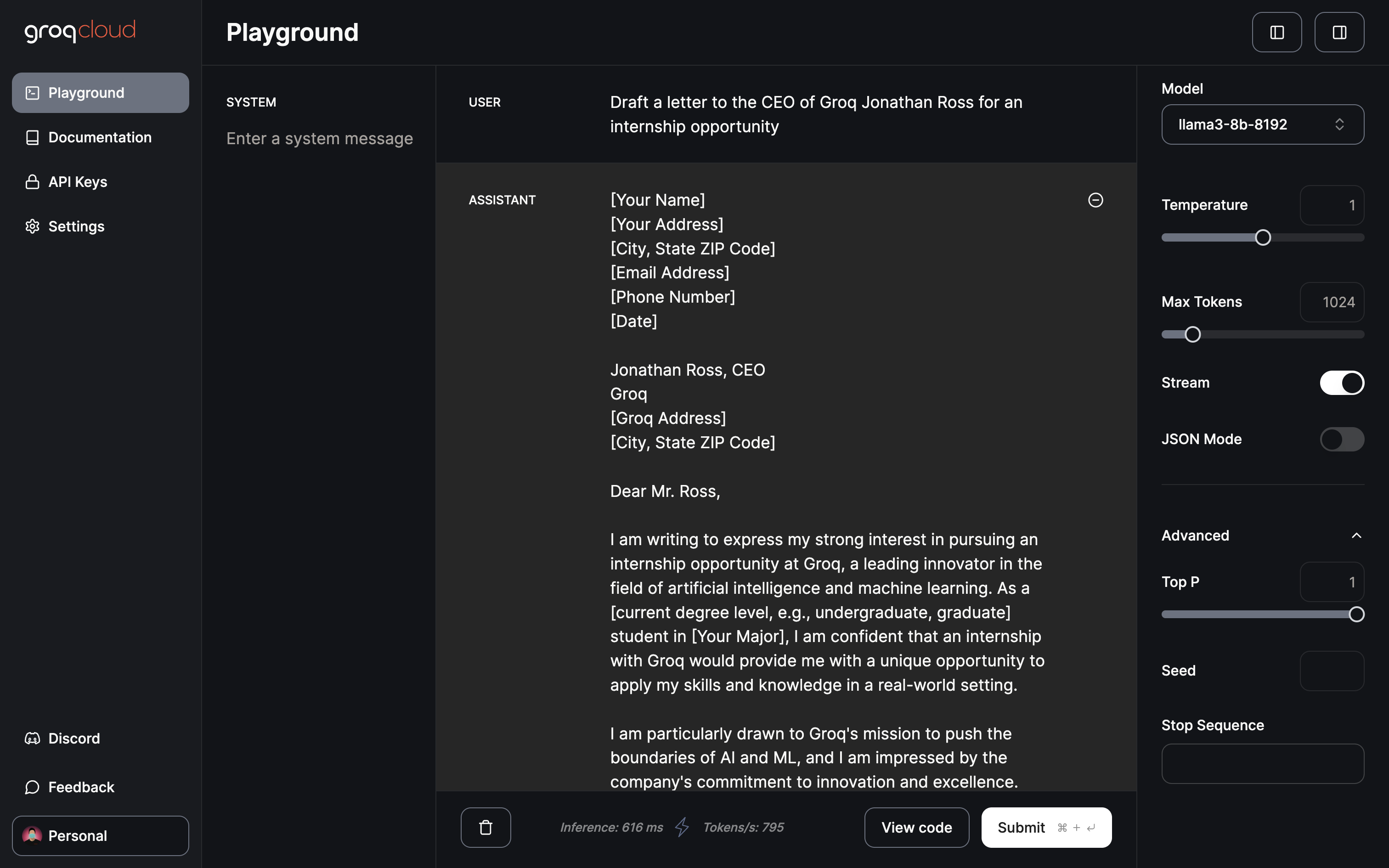

Plac zabaw Groq

Obecnie plac zabaw Groq oferuje bezpłatny dostęp do Gemma 7B, Llama 3 70B i 8B oraz Mixtral 8x7b. Plac zabaw umożliwia dostosowanie parametrów, takich jak temperatura, maksymalna liczba tokenów i przełączanie strumieniowania. Dodatkowo posiada dedykowany tryb JSON do generowania wyłącznie danych wyjściowych JSON.

Tylko 402 ms na wnioskowanie przy szybkości 901 tokenów/s

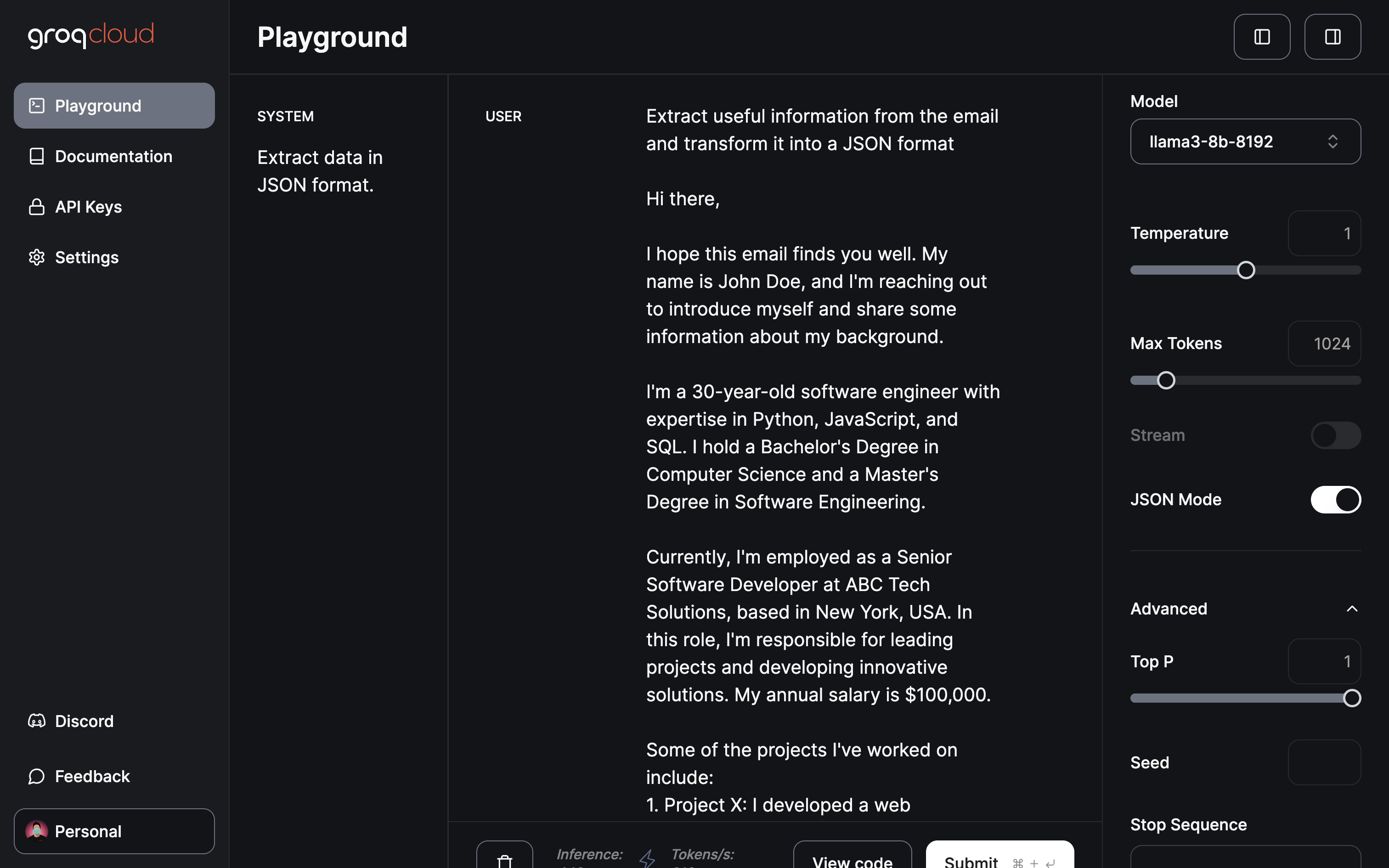

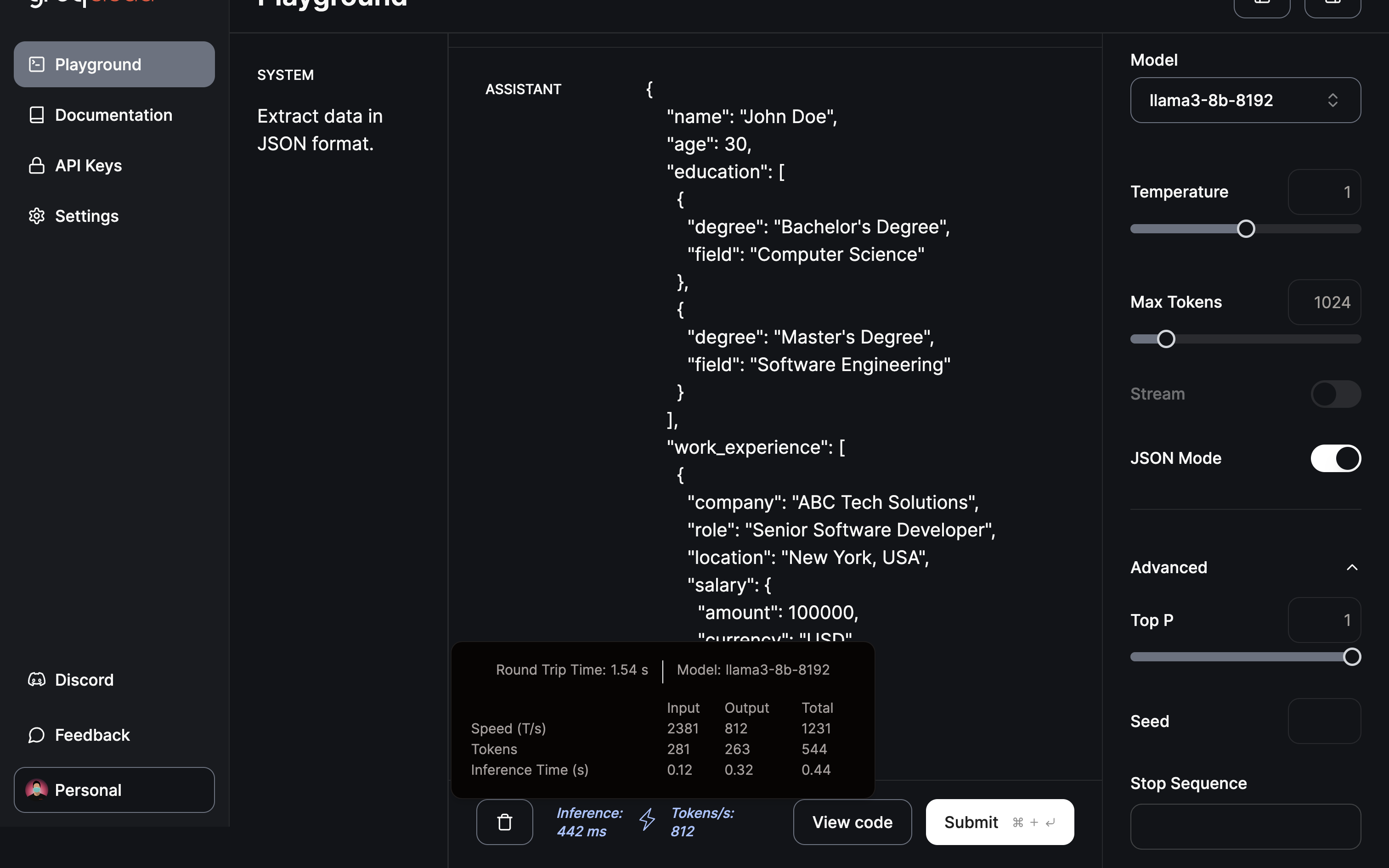

Przechodząc do najbardziej wpływowej domeny/aplikacji w mojej opinii, ekstrakcji i transformacji danych:

Poproszenie modelu o wyodrębnienie przydatnych informacji i dostarczenie JSON przy użyciu trybu JSON.

Ekstrakcja i transformacja do formatu JSON została zakończona w mniej niż pół sekundy.

Wnioski

Jak wykazano, Groq wyłonił się jako gracz zmieniający krajobraz LLM dzięki swojemu innowacyjnemu silnikowi wnioskowania LPU. Zaprezentowana tutaj szybka transformacja wskazuje na ogromny potencjał przyspieszenia aplikacji AI. Patrząc w przyszłość, można tylko spekulować na temat przyszłych innowacji Groq. Być może jednostka przetwarzania obrazu mogłaby zrewolucjonizować modele generowania obrazu, przyczyniając się do postępów w generowaniu wideo przez sztuczną inteligencję. Rzeczywiście, to ekscytująca przyszłość.

Patrząc w przyszłość, w miarę jak szkolenia LLM stają się coraz bardziej wydajne, potencjał posiadania spersonalizowanego ChatGPT, dostosowanego do danych użytkownika na urządzeniu lokalnym, staje się kuszącą perspektywą. Jedną z platform oferujących takie możliwości jest Cody, inteligentny asystent AI dostosowany do wspierania firm w różnych aspektach. Podobnie jak ChatGPT, Cody może zostać przeszkolony w zakresie danych biznesowych, zespołu, procesów i klientów, korzystając z unikalnej bazy wiedzy.

Dzięki Cody firmy mogą wykorzystać moc sztucznej inteligencji do stworzenia spersonalizowanego i inteligentnego asystenta, który zaspokaja ich potrzeby, co czyni go obiecującym dodatkiem do świata rozwiązań biznesowych opartych na sztucznej inteligencji.