RAG-as-a-Service:あなたのビジネスにジェネレーティブAIを

大規模言語モデル(LLM)とジェネレーティブAIのトレンドの台頭により、ジェネレーティブAIソリューションをビジネスに統合することで、ワークフローの効率を大幅に向上させることができます。 初めてジェネレーティブAIに触れる人は、専門用語の多さに戸惑うかもしれない。 このブログでは、ジェネレーティブAIの基本的な用語について説明し、RAG-as-a-Serviceを使用してビジネスのためのカスタムAIソリューションを開始する方法について説明します。

検索拡張世代(RAG)とは?

Retrieval Augmented Generation(RAG)は、LLMや生成AIをビジネス・ワークフローに導入する際の重要なコンセプトである。 RAGは、事前にトレーニングされたTransformerモデルを活用し、特定の知識ベースから関連するデータをクエリプロセスに注入することで、ビジネス関連のクエリに回答します。 LLMが訓練を受けていない可能性のあるこのデータは、正確で適切な回答を生成するために使用される。

RAGは費用対効果が高く効率的であるため、ジェネレーティブAIをより身近なものにする。 RAGに関連する重要な用語をいくつか探ってみよう。

RAGの主要用語

チャンキング

LLMはリソースを必要とし、「コンテキスト・ウィンドウ」と呼ばれる管理可能なデータ長で学習される。コンテキスト・ウィンドウは使用するLLMによって異なる。 その限界に対処するため、文書やテキスト文献として提供されるビジネスデータは、より小さな塊にセグメント化される。 これらのチャンクは、クエリー検索プロセスで利用される。

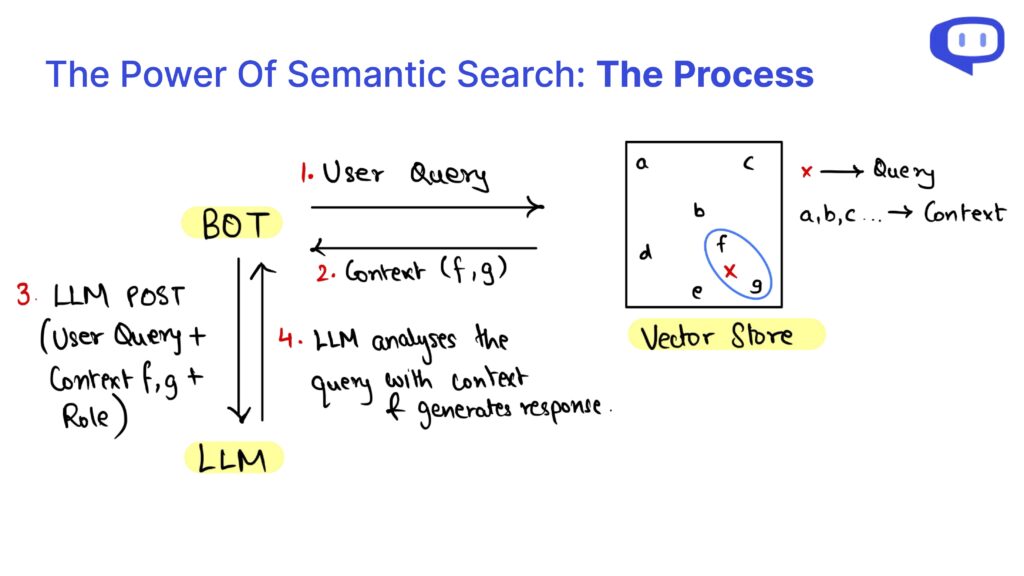

チャンクは非構造化であり、クエリは知識ベースデータと構文的に異なる可能性があるため、チャンクはセマンティック検索を使って検索される。

ベクター・データベース

Pinecone、Chromadb、FAISSのようなベクターデータベースは、ビジネスデータの埋め込みを保存する。 エンベッディングは、テキストデータをその意味に基づいて数値化し、意味的に類似したデータが近接する高次元ベクトル空間に格納される。

ユーザーによるクエリが行われると、そのクエリの埋め込みがベクトル・データベース内の意味的に類似したチャンクを見つけるために使われる。

RAGアズ・ア・サービス

技術的な専門知識がない場合、RAGをビジネスに導入するのは大変なことです。 そこでRAG-as-a-Service(RaaS)が登場する。

私たちmeetcody.aiは、お客様のビジネスニーズに合わせたプラグアンドプレイのソリューションを提供します。 アカウントを作成するだけで、無料でご利用いただけます。 チャンキング、ベクター・データベース、そしてRAGの全プロセスを私たちが行いますので、ご安心ください。

よくあるご質問

1.RAG-as-a-Service(RaaS)とは何ですか?

RAG-as-a-Service(RaaS)は、お客様のビジネスのための検索拡張世代プロセス全体を処理する包括的なソリューションです。 これには、データのチャンキング、埋め込みデータのベクトルデータベースへの格納、クエリに関連するデータを検索するためのセマンティック検索の管理などが含まれる。

2.チャンキングはRAGプロセスにどのように役立ちますか?

チャンキングは、大きなビジネス文書を、LLMのコンテキスト・ウィンドウに収まるように、管理しやすい小さな断片に分割します。 このセグメンテーションにより、LLMはセマンティック検索を使って関連情報をより効率的に処理し、取り出すことができる。

3.ベクター・データベースとは何か?

ベクターデータベースは、ビジネスデータの数値表現(埋め込み)を保存します。 これらの埋め込みは、クエリが行われたときに、意味的に類似したデータを効率的に検索することを可能にし、LLMからの正確で適切な応答を保証する。

RAG-as-a-Serviceのパワーを活用することで、RAGを簡単かつ効率的にお客様のビジネスに統合することができます。 今すぐmeetcody.aiを使い始め、高度なジェネレーティブAIソリューションでワークフローを変革しましょう。