L’événement DevDay de l’OpenAI, très attendu, a apporté des nouvelles passionnantes et des fuites de prix qui ont laissé la communauté de l’IA dans l’expectative. Parmi les points forts, citons la sortie de GPT-4 Turbo, des réductions de prix significatives pour divers services, la fenêtre contextuelle GPT-4 turbo 128k et le dévoilement de l’API Assistants. Entrons dans les détails et voyons comment ces développements façonnent l’avenir de l’IA.

GPT-4 Turbo : Plus de puissance à moindre coût

L’événement le plus marquant a été sans conteste la présentation du GPT-4 Turbo. Ce modèle d’IA avancé est doté d’une fenêtre contextuelle de 128 000 caractères, ce qui représente une avancée considérable par rapport à son prédécesseur, le GPT-3.5. Grâce à ce contexte élargi, GPT-4 Turbo peut lire et traiter des informations équivalentes à un livre de 400 pages dans une seule fenêtre contextuelle. Cette nouvelle capacité élimine l’un des principaux facteurs de différenciation d’Anthropic, la société sœur d’OpenAI, car GPT-4 Turbo offre désormais une taille de contexte comparable.

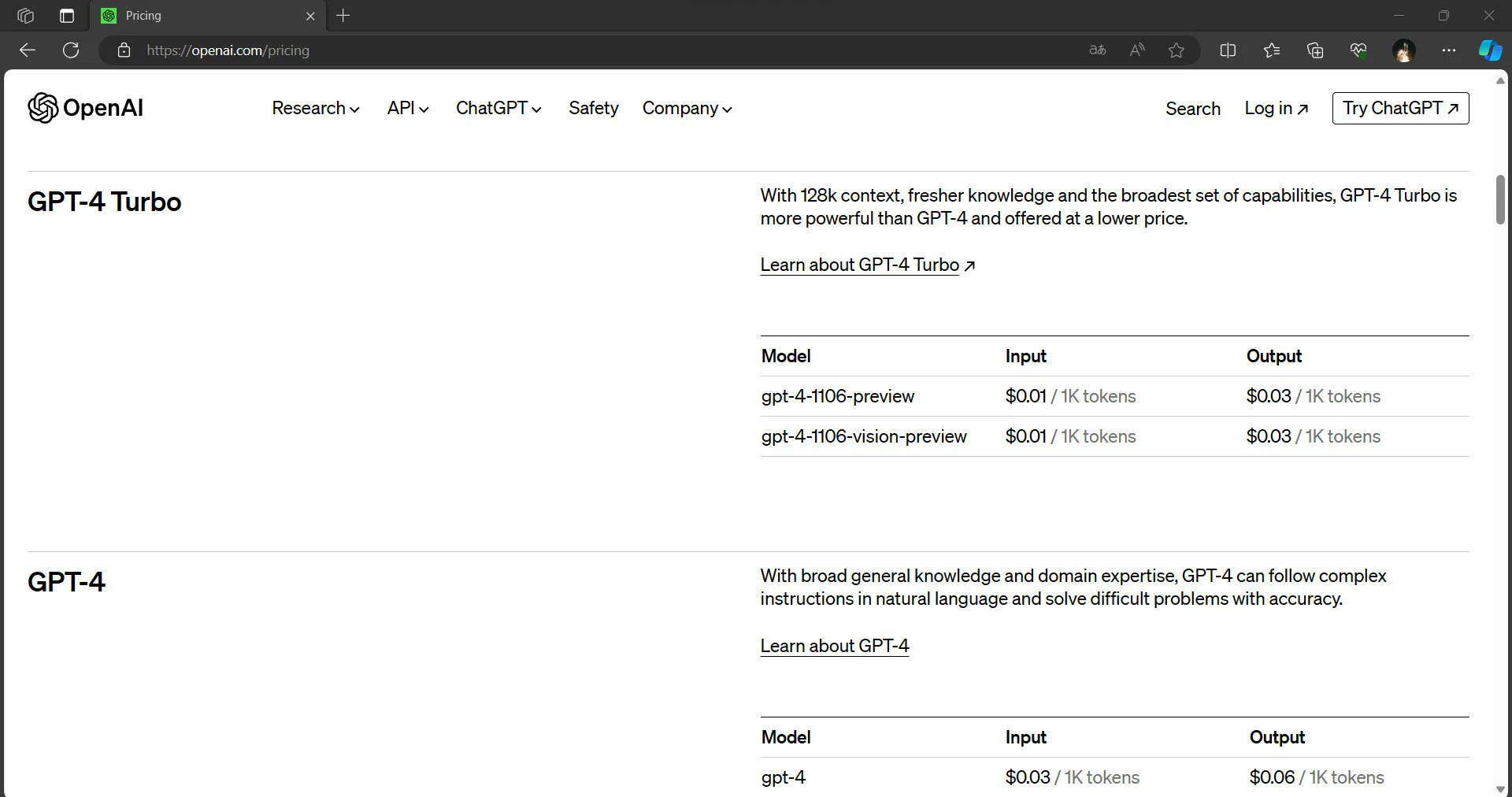

Mais les nouvelles ne s’arrêtent pas là. Le GPT-4 Turbo offre non seulement une fenêtre contextuelle plus large, mais aussi des résultats plus rapides. Il est disponible à une fraction des prix d’entrée et de sortie du GPT-4. Cette combinaison de capacités accrues et de rentabilité fait du GPT-4 Turbo un élément qui change la donne dans le monde de l’IA.

Des réductions de prix dans tous les domaines

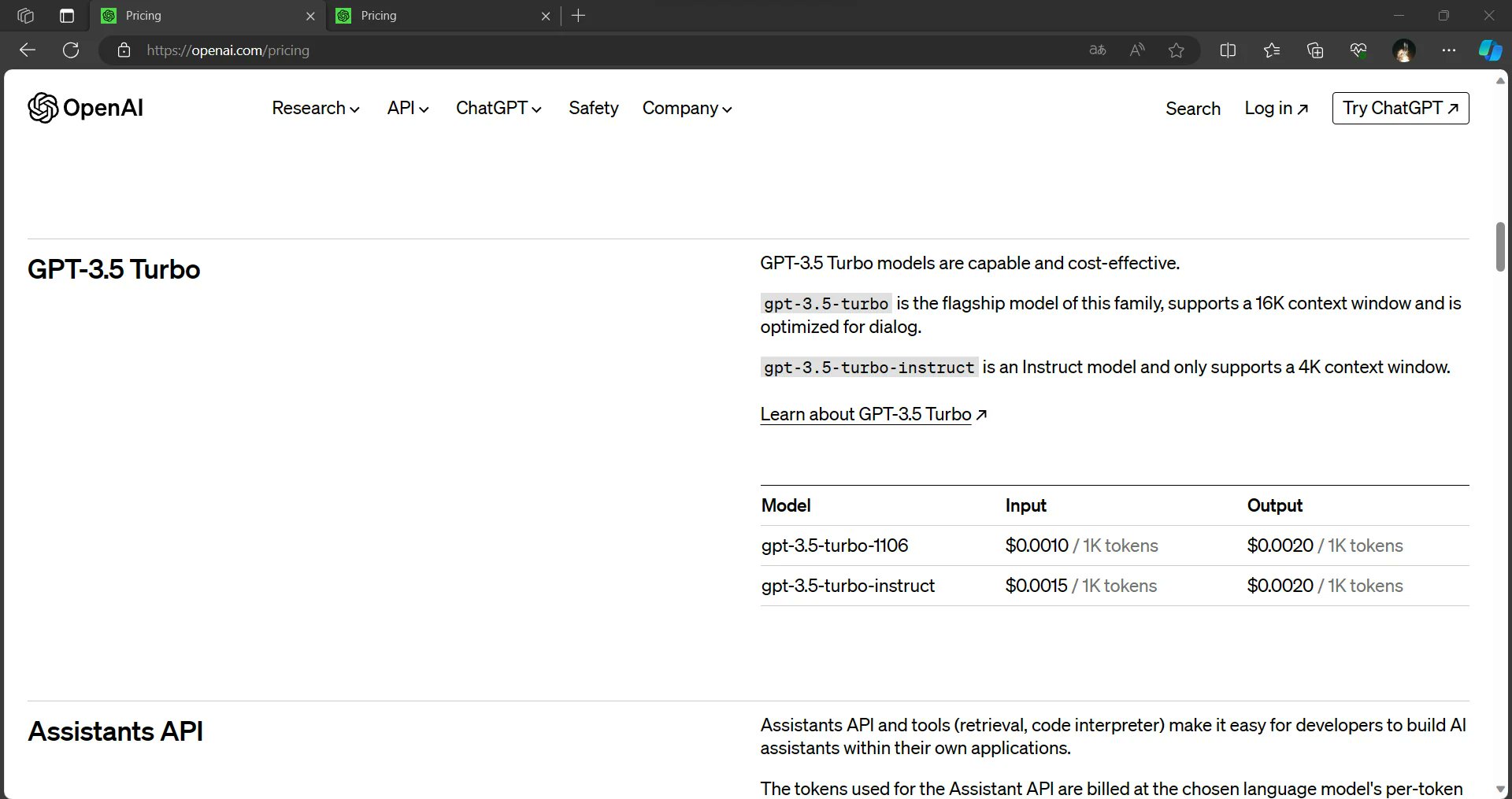

L’OpenAI rend l’IA plus accessible et plus abordable que jamais. Les informations divulguées suggèrent que le coût des intrants pour le GPT-3.5 a été réduit de 33 %. En outre, les modèles GPT-3.5 seront désormais réglés par défaut sur 16K, ce qui les rendra plus rentables pour les utilisateurs. Ces changements visent à démocratiser l’utilisation de l’IA, en permettant à un public plus large d’exploiter la puissance de ces modèles.

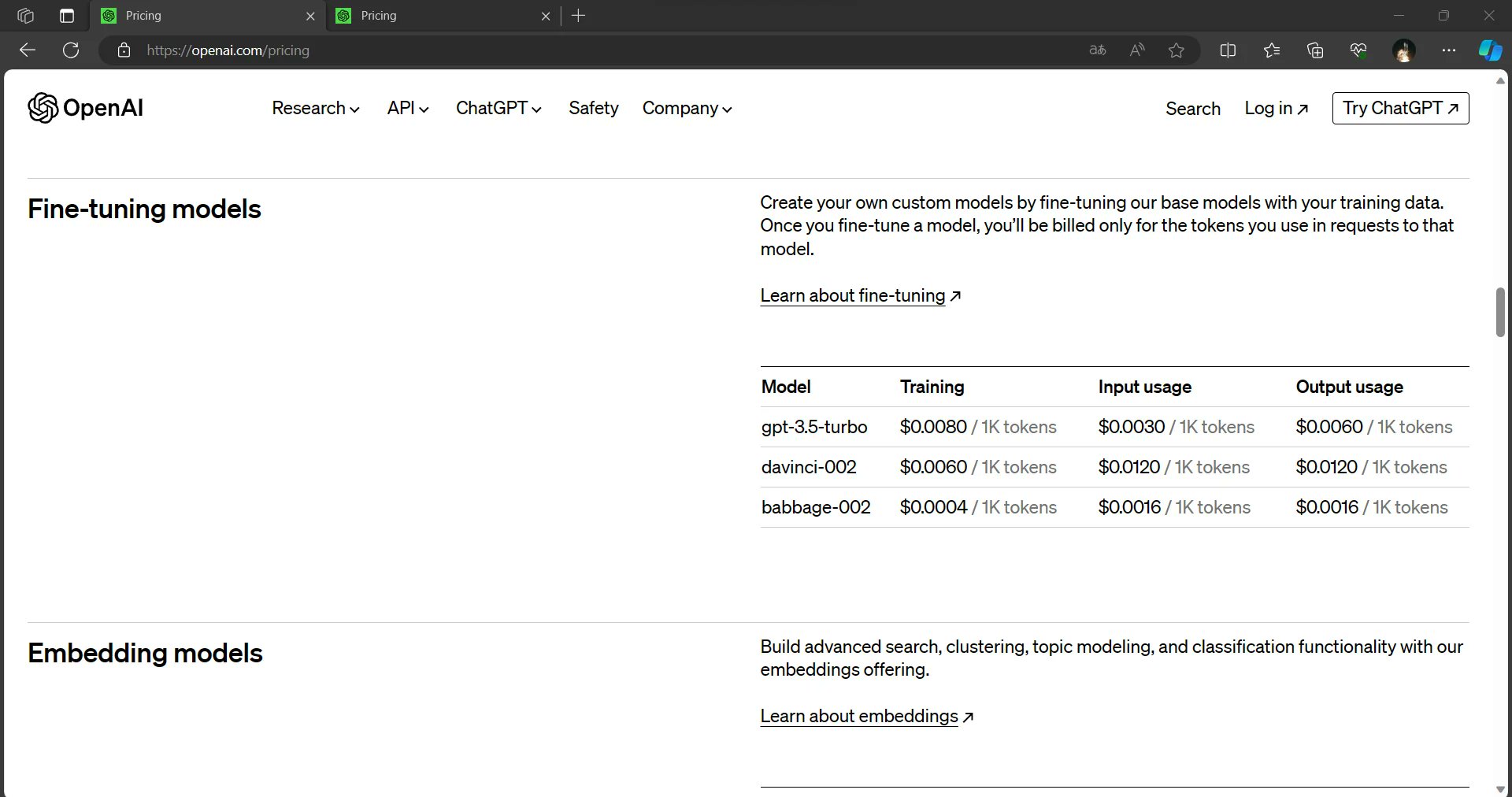

Les modèles affinés, une ressource cruciale pour de nombreuses applications d’IA, bénéficient également de réductions de prix substantielles. Les coûts d’inférence pour les modèles affinés seraient réduits de 75 % pour les données d’entrée et de près de 60 % pour les données de sortie. Ces réductions promettent de permettre aux développeurs et aux organisations de déployer des solutions basées sur l’IA de manière plus économique.

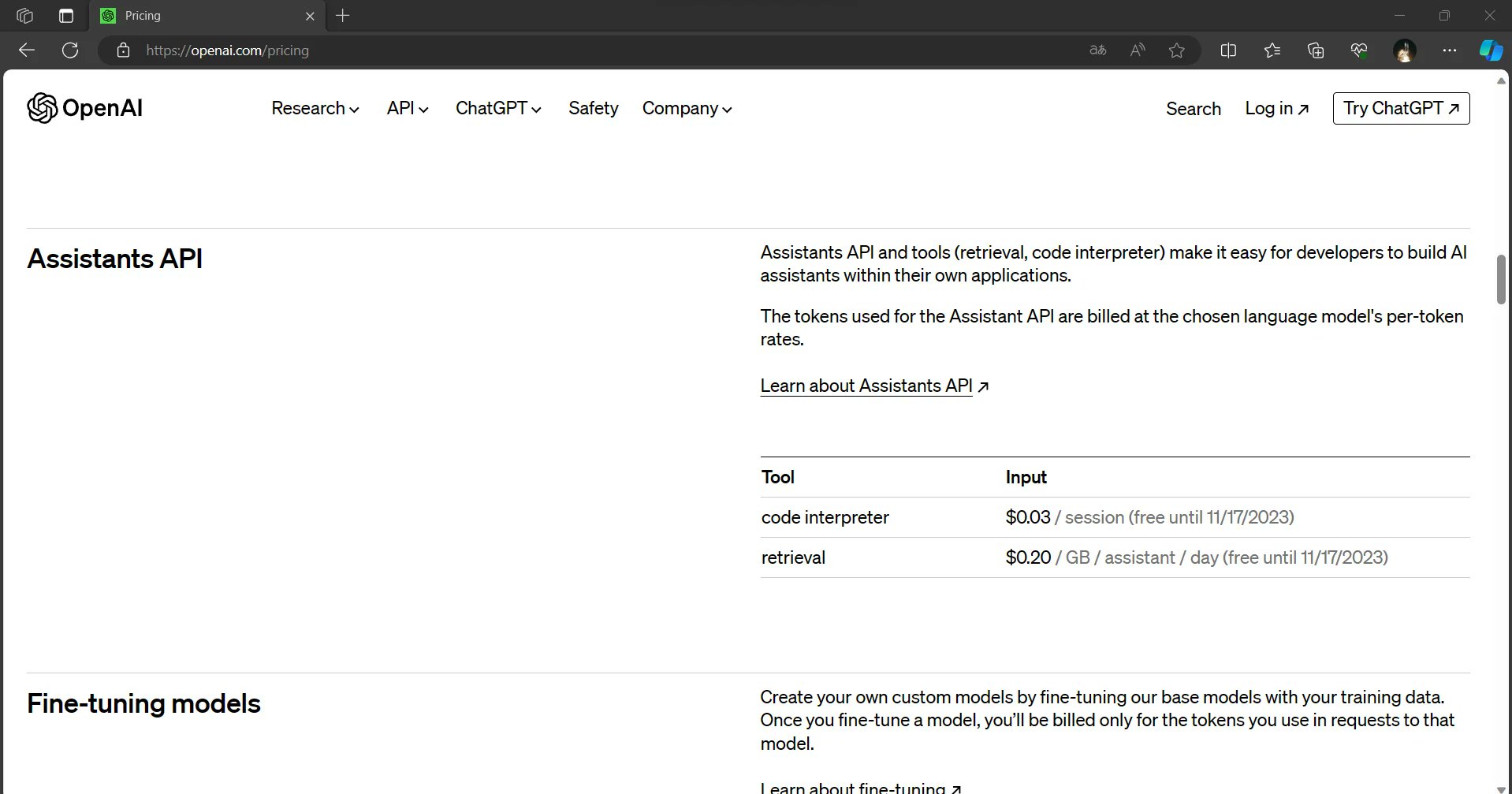

L’API des assistants : Une nouvelle frontière pour l’IA

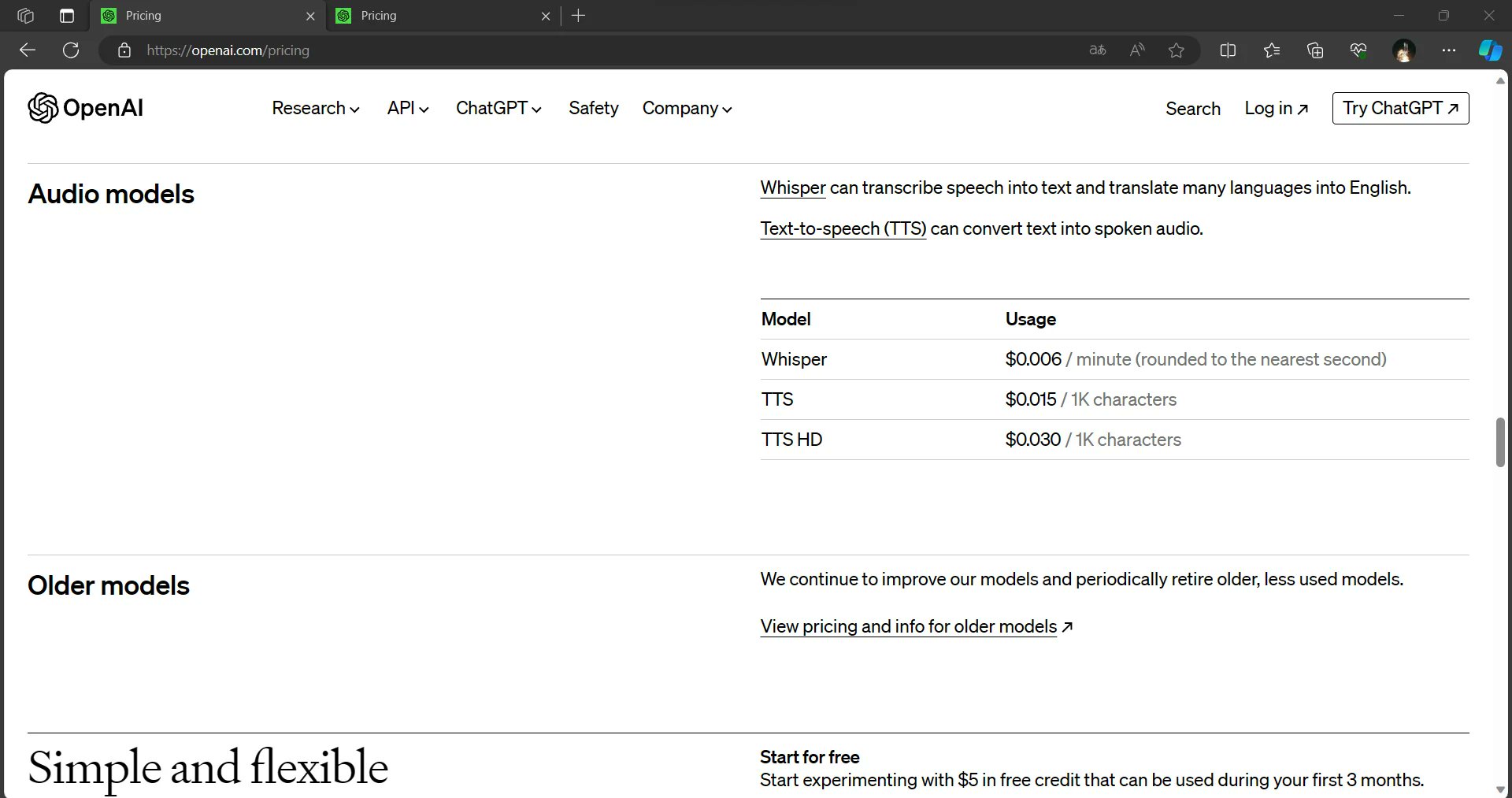

Le DevDay d’OpenAI a également été l’occasion de présenter la future API Assistants, qui devrait fournir aux utilisateurs un interprète de code et des capacités de récupération via une API. Cette innovation devrait rationaliser l’intégration de l’IA dans diverses applications, permettant aux développeurs de créer des solutions encore plus puissantes et dynamiques.

Dall-E 3 et Dall-E 3 HD : élargir les horizons créatifs

L’événement a également révélé l’introduction de Dall-E 3 et Dall-E 3 HD. Bien que ces modèles promettent de repousser les limites de l’IA créative, ils sont positionnés comme des options plus coûteuses par rapport à Dall-E 2. Toutefois, les capacités accrues de ces modèles peuvent justifier le coût plus élevé pour les utilisateurs qui recherchent une IA de pointe pour la génération et la manipulation d’images.

La puissance du contexte 128K

En d’autres termes, la fenêtre contextuelle du GPT-4 Turbo 128K lui permet de traiter et de comprendre une quantité étonnante d’informations en une seule fois. En ce qui concerne le contexte, la génération précédente, GPT-3, disposait d’une fenêtre contextuelle de 1 024 tokens. Les jetons peuvent représenter des mots, des caractères ou même des sous-mots, en fonction de la langue et du texte. La fenêtre contextuelle de GPT-4 Turbo 128K est environ 125 fois plus grande que celle de GPT-3, ce qui en fait un véritable mastodonte dans le monde des modèles linguistiques d’IA.

Implications pratiques

L’introduction de GPT-4 Turbo avec sa fenêtre contextuelle de 128K constitue une avancée remarquable dans le domaine de l’IA. Sa capacité à traiter et à comprendre de grandes quantités d’informations pourrait révolutionner la manière dont nous interagissons avec les systèmes d’IA, dont nous menons des recherches, dont nous créons du contenu, etc. À mesure que les développeurs et les chercheurs explorent les possibilités de ce puissant outil, nous pouvons nous attendre à voir apparaître des applications innovantes qui exploitent tout le potentiel des capacités de GPT-4 Turbo, ouvrant ainsi de nouveaux horizons à l’intelligence artificielle.

Compréhension globale

Avec un contexte de 128K, le GPT-4 Turbo peut lire et analyser des documents, des articles ou des ensembles de données volumineux dans leur intégralité. Cette capacité lui permet de fournir des réponses plus complètes et plus précises à des questions complexes, à des tâches de recherche ou à des besoins d’analyse de données.

Continuité contextuelle

Les modèles précédents avaient souvent du mal à maintenir le contexte dans de longs documents, ce qui entraînait des réponses décousues ou non pertinentes. La fenêtre GPT-4 Turbo 128K lui permet de maintenir le contexte sur des passages prolongés, ce qui se traduit par des interactions plus cohérentes et plus pertinentes sur le plan contextuel.

Réduire la surcharge d’informations

À l’ère de la surcharge d’informations, la capacité de GPT-4 Turbo à traiter de grandes quantités de données en une seule fois peut changer la donne. Il peut passer au crible de vastes ensembles de données, extraire des informations clés et fournir des résumés succincts, ce qui permet aux utilisateurs de gagner un temps précieux et d’économiser des efforts.

Recherche avancée et rédaction

Les chercheurs, les écrivains et les créateurs de contenu peuvent bénéficier de manière significative du contexte 128K de GPT-4 Turbo. Il peut aider à produire des documents de recherche, des articles et des rapports approfondis avec une compréhension approfondie du sujet.

Traduction linguistique améliorée

Les tâches de traduction peuvent également bénéficier d’un contexte plus large. GPT-4 Turbo peut mieux comprendre les nuances des langues, les expressions idiomatiques et le contexte culturel, ce qui permet d’obtenir des traductions plus précises.

Défis et considérations

Si le contexte GPT-4 Turbo 128K change incontestablement la donne, il présente également des défis. Le traitement de ces grands modèles nécessite des ressources informatiques importantes, ce qui peut limiter l’accessibilité pour certains utilisateurs. En outre, les considérations éthiques relatives à la confidentialité des données et à la génération de contenu doivent être prises en compte à mesure que les modèles d’IA deviennent plus puissants.

Le GPT-4 en a encore sous le pied ?

L’événement DevDay de l’OpenAI a donné lieu à une multitude de mises à jour passionnantes et de fuites de prix qui devraient façonner le paysage de l’IA. L’impressionnante fenêtre contextuelle de 128 K de GPT-4 Turbo, son rendement plus rapide et son prix réduit en font une offre exceptionnelle. Les réductions de prix globales pour les intrants, les extrants et les modèles affinés devraient démocratiser l’utilisation de l’IA et la rendre plus accessible à un public plus large. La future API Assistants et les modèles Dall-E 3 soulignent l’engagement d’OpenAI en faveur de l’innovation et de l’avancement du domaine de l’intelligence artificielle.

Au fur et à mesure de ces développements, il est clair que l’OpenAI est déterminée à donner aux développeurs, aux entreprises et aux esprits créatifs les moyens de disposer d’outils et de services d’IA à la pointe de la technologie. L’avenir de l’IA est plus prometteur et plus accessible que jamais.

En savoir plus : L’entreprise ChatGPT d’OpenAI : Coût, avantages et sécurité