Comment Cody génère-t-il des réponses à partir de vos documents ?

Lorsque vous commencez à utiliser Cody, il est possible que vous soyez déçu ou découragé par l’incapacité de Cody à générer les réponses attendues. Dans ce court blog, nous n’approfondirons pas la façon dont vous devriez utiliser Cody, mais nous vous donnerons une idée de la façon dont Cody utilise vos documents pour générer des réponses afin que vous puissiez mieux comprendre le processus de génération et l’expérimenter.

Deux facteurs principaux influencent la génération de réponses à l’aide de vos documents :

- Chunking

- Fenêtre contextuelle

Ces deux terminologies, le découpage et la fenêtre contextuelle, sont interdépendantes. On peut faire une analogie simple en comparant la génération de réponses à la cuisson des aliments. Les morceaux peuvent être vus comme des pièces individuelles de légumes que vous coupez, tandis que la fenêtre contextuelle représente la taille de l’ustensile de cuisine. Il est important de couper les légumes en morceaux de taille optimale pour améliorer le goût général, et un ustensile plus grand permet d’ajouter plus de morceaux de légumes.

Qu’est-ce que le découpage ?

En termes simples, le découpage est l’action de diviser le contenu en morceaux gérables pour une utilisation efficace de la mémoire. Si vous avez lu nos blogs, vous savez sans doute que les modèles tels que le GPT nécessitent des ressources importantes et que, pour faire face aux contraintes de la fenêtre contextuelle, nous employons de multiples processus tels que le découpage en morceaux.

Le regroupement est un processus effectué après le téléchargement des documents dans Cody. Il divise ou segmente le document en plusieurs morceaux, chaque morceau contenant un contexte environnant pertinent. Des étiquettes numériques sont ensuite attribuées à ces morceaux pour faciliter le calcul, ce qui est connu sous le nom de “embedding” (intégration). Il est important de trouver la taille optimale des morceaux. Une taille de morceau plus petite réduit la pertinence du contexte, tandis qu’une taille de morceau plus grande introduit plus de bruit. L’algorithme de découpage de Cody ajuste dynamiquement la taille des morceaux en fonction de la distribution des jetons définie par l’utilisateur.

Comment la fenêtre contextuelle affecte-t-elle les réponses du bot ?

Différents facteurs tels que la personnalité, le score de pertinence, etc., influencent la qualité des réponses des robots. La fenêtre contextuelle du modèle joue également un rôle important dans la détermination de la qualité. La fenêtre contextuelle fait référence à la quantité de texte qu’un modèle linguistique peut traiter en un seul appel. Puisque Cody utilise les embeddings et l’injection de contexte pour générer des réponses à l’aide de modèles OpenAI, une fenêtre de contexte plus large permet au modèle d’ingérer plus de données dans chaque requête.

💡 Chaque requête (≤ fenêtre contextuelle) = Personnalité du robot + morceaux de connaissance + historique + données de l’utilisateur + réponse

Fenêtres contextuelles de différents modèles :

- GPT-3.5 : 4096 tokens (≈3500 mots)

- GPT-3.5 16K : 16000 tokens (≈13000 mots)

- GPT-4 : 8000 tokens (≈7000 mots)

Lorsque la fenêtre contextuelle est plus grande, elle permet d’afficher une plus grande proportion de chaque paramètre, y compris la personnalité, les morceaux, l’historique, l’entrée et la réponse. Ce contexte élargi permet au bot de générer des réponses plus pertinentes, plus cohérentes et plus créatives.

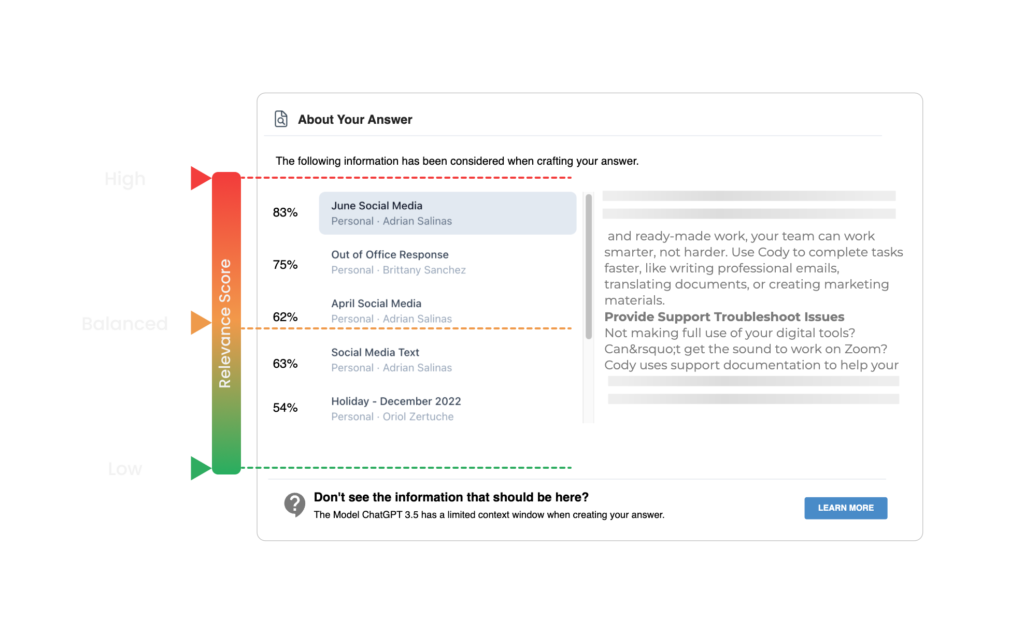

Le dernier ajout de Cody permet aux utilisateurs de vérifier les citations de documents en cliquant sur le nom du document à la fin des réponses. Ces citations correspondent aux morceaux obtenus par la recherche sémantique. Cody détermine le seuil des morceaux pour le contexte sur la base du score de pertinence défini par l’utilisateur. Si l’utilisateur définit un score de pertinence élevé, Cody n’utilise que les morceaux qui dépassent un seuil prédéfini comme contexte pour générer la réponse.

Exemple

En supposant un seuil limite prédéfini de 90 % pour un score de pertinence élevé, Cody écarte tous les morceaux dont le score de pertinence est inférieur à 90 %. Nous recommandons aux nouveaux utilisateurs de commencer par un score de pertinence moins élevé (faible ou équilibré), en particulier lorsqu’ils utilisent des documents téléchargés (PDF, PowerPoint, Word, etc.) ou des sites web. Les documents ou sites web téléchargés peuvent rencontrer des problèmes de formatage et de lisibilité lors du prétraitement, ce qui peut se traduire par des scores de pertinence inférieurs. La mise en forme du document à l’aide de notre éditeur de texte intégré, au lieu de télécharger des documents bruts, garantit la plus grande précision et la meilleure cote de confiance.

Si vous avez trouvé ce blog intéressant et que vous souhaitez approfondir les concepts de fenêtre contextuelle et de découpage, nous vous recommandons vivement de lire ce blog écrit par Kristian de All About AI. Pour plus de ressources, vous pouvez également consulter notre Centre d’aide et rejoindre notre communauté Discord.