Wie generiert Cody Antworten aus Ihren Dokumenten?

Wenn Sie mit Cody anfangen, kann es sein, dass Sie enttäuscht oder entmutigt sind, weil Cody nicht die erwarteten Antworten liefert. In diesem kurzen Blog werden wir nicht näher darauf eingehen, wie Sie Cody verwenden sollten, aber wir werden Ihnen eine grobe Vorstellung davon geben, wie Cody Ihre Dokumente verwendet, um Antworten zu generieren, damit Sie den Generierungsprozess besser verstehen und mit ihm experimentieren können.

Zwei Hauptfaktoren beeinflussen hauptsächlich die Generierung von Reaktionen auf Ihre Dokumente:

- Chunking

- Kontext-Fenster

Diese beiden Begriffe, Chunking und Kontextfenster, sind miteinander verknüpft. Eine einfache Analogie lässt sich ziehen, wenn man die Erzeugung von Reaktionen mit dem Kochen von Speisen vergleicht. Die Stücke können als die einzelnen Gemüsestücke gesehen werden, die Sie schneiden, während das Kontextfenster die Größe des Kochgeschirrs darstellt. Es ist wichtig, das Gemüse in optimal große Stücke zu schneiden, um den Gesamtgeschmack zu verbessern, und ein größeres Kochgeschirr ermöglicht es, mehr Gemüsestücke hinzuzufügen.

Was ist Chunking?

Einfach ausgedrückt bedeutet Chunking die Aufteilung von Inhalten in überschaubare Teile, um den Speicher effizient zu nutzen. Wenn Sie unsere Blogs gelesen haben, wissen Sie vielleicht, dass Modelle wie GPT beträchtliche Ressourcen benötigen, und um die Beschränkungen des Kontextfensters zu bewältigen, setzen wir mehrere Verfahren wie Chunking ein.

Das Chunking ist ein Prozess, der nach dem Hochladen der Dokumente in Cody durchgeführt wird. Das Dokument wird in mehrere Teile (Chunks) unterteilt, wobei jeder Chunk einen relevanten Umgebungskontext enthält. Diesen Chunks werden dann zur leichteren Berechnung numerische Tags zugewiesen, was als Einbettung bezeichnet wird. Es ist wichtig, die optimale Chunk-Größe zu finden. Eine kleinere Stückgröße verringert die Kontextrelevanz, während eine größere Stückgröße zu mehr Rauschen führt. Der Chunking-Algorithmus von Cody passt die Chunk-Größe dynamisch an die vom Benutzer festgelegte Token-Verteilung an.

Wie wirkt sich das Kontextfenster auf die Bot-Antworten aus?

Die Qualität der Bot-Antworten wird durch verschiedene Faktoren beeinflusst, z. B. durch die Persönlichkeit der Eingabeaufforderung, die Relevanzbewertung usw. Auch das Kontextfenster des Modells spielt eine wichtige Rolle bei der Bestimmung der Qualität. Das Kontextfenster bezieht sich auf die Textmenge, die ein LLM (Language Model) in einem einzigen Aufruf verarbeiten kann. Da Cody Einbettungen und Kontextinjektion verwendet, um Antworten mit OpenAI-Modellen zu generieren, ermöglicht ein größeres Kontextfenster eine größere Datenaufnahme durch das Modell bei jeder Anfrage.

💡 Jede Abfrage (≤ Kontextfenster) = Bot-Persönlichkeit + Wissensbrocken + Verlauf + Benutzereingabe + Antwort

Kontextfenster der verschiedenen Modelle:

- GPT-3.5: 4096 Token (≈3500 Wörter)

- GPT-3.5 16K: 16000 Token (≈13000 Wörter)

- GPT-4: 8000 Token (≈7000 Wörter)

Je größer das Kontextfenster ist, desto größer ist der Anteil der einzelnen Parameter, einschließlich Persönlichkeit, Chunks, Verlauf, Eingabe und Antwort. Dieser erweiterte Kontext befähigt den Bot, relevantere, kohärentere und kreativere Antworten zu geben.

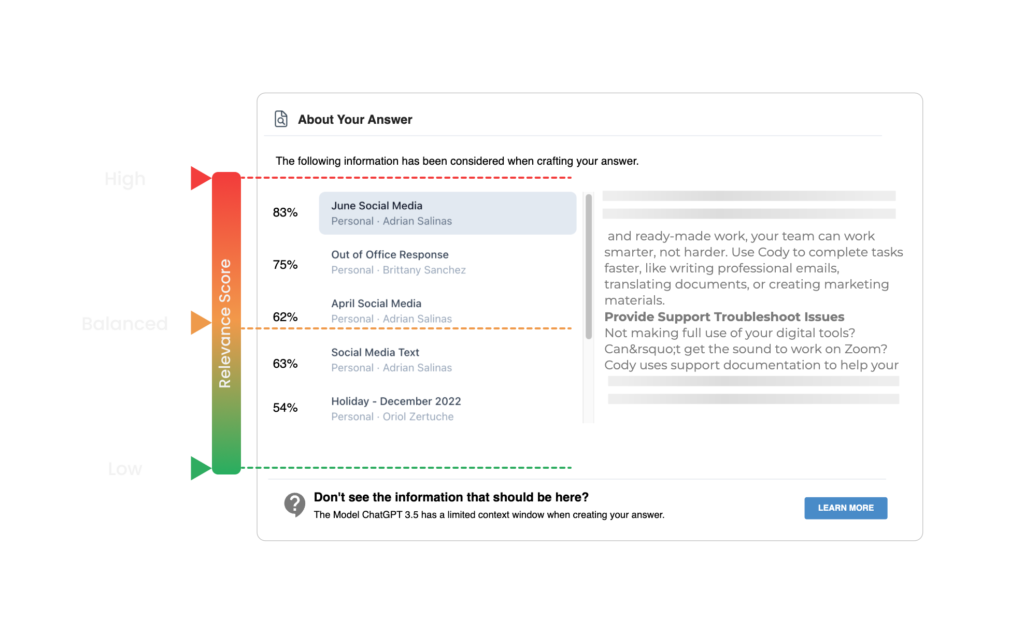

Die neueste Ergänzung von Cody ermöglicht es den Benutzern, Dokumentzitate zu überprüfen, indem sie auf den Dokumentnamen am Ende der Antworten klicken. Diese Zitate entsprechen den durch die semantische Suche ermittelten Chunks. Cody bestimmt den Chunk-Schwellenwert für den Kontext auf der Grundlage der vom Benutzer festgelegten Relevanzbewertung. Wenn der Benutzer einen hohen Relevanzwert festlegt, verwendet Cody nur die Teile, die einen vordefinierten Schwellenwert überschreiten, als Kontext für die Generierung der Antwort.

Beispiel

Ausgehend von einem vordefinierten Grenzwert von 90 % für eine hohe Relevanzbewertung verwirft Cody alle Chunks mit einer Relevanzbewertung von weniger als 90 %. Wir empfehlen neuen Nutzern, mit einer niedrigen Relevanzbewertung (niedrig oder ausgeglichen) zu beginnen, insbesondere wenn sie hochgeladene Dokumente (PDFs, Powerpoints, Word usw.) oder Websites verwenden. Hochgeladene Dokumente oder Websites können bei der Vorverarbeitung Formatierungs- und Lesbarkeitsprobleme aufweisen, was zu einer geringeren Relevanzbewertung führen kann. Die Formatierung des Dokuments mit unserem integrierten Texteditor anstelle des Hochladens von Rohdokumenten gewährleistet die höchste Genauigkeit und Vertrauenswürdigkeit.

Wenn Sie diesen Blog interessant fanden und sich eingehender mit den Konzepten von Kontextfenstern und Chunking beschäftigen möchten, empfehlen wir Ihnen diesen Blog von Kristian von All About AI. Weitere Ressourcen finden Sie auch in unserem Hilfe-Center und in unserer Discord-Community.