W jaki sposób Cody generuje odpowiedzi przy użyciu dokumentów użytkownika?

Po rozpoczęciu pracy z Cody możliwe jest, że poczujesz się rozczarowany lub zniechęcony tym, dlaczego Cody nie jest w stanie wygenerować oczekiwanych odpowiedzi. W tym krótkim blogu nie będziemy zagłębiać się w to, jak powinieneś używać Cody, ale damy ci przybliżony obraz tego, jak Cody wykorzystuje twoje dokumenty do generowania odpowiedzi, abyś mógł lepiej zrozumieć proces generowania i eksperymentować z nim.

Na generowanie odpowiedzi przy użyciu dokumentów wpływają głównie dwa czynniki:

- Chunking

- Okno kontekstowe

Obie te terminologie, chunking i okno kontekstowe, są ze sobą powiązane. Prostą analogią może być porównanie generowania odpowiedzi do gotowania jedzenia. Kawałki mogą być postrzegane jako pojedyncze kawałki warzyw, które kroisz, podczas gdy okno kontekstowe reprezentuje rozmiar naczynia do gotowania. Ważne jest, aby pokroić warzywa na kawałki o optymalnej wielkości, aby poprawić ogólny smak, a większe naczynie pozwala na dodanie większej ilości kawałków warzyw.

Czym jest Chunking?

Mówiąc prościej, chunking to czynność polegająca na dzieleniu treści na łatwe do zarządzania fragmenty w celu efektywnego wykorzystania pamięci. Jeśli czytałeś nasze blogi, być może wiesz, że modele takie jak GPT wymagają znacznych zasobów, a aby poradzić sobie z ograniczeniami okna kontekstowego, stosujemy wiele procesów, takich jak chunking.

Chunking to proces wykonywany po przesłaniu dokumentów do Cody. Dzieli lub segmentuje dokument na wiele fragmentów, z których każdy zawiera odpowiedni kontekst otaczający. Fragmenty te są następnie przypisywane do znaczników numerycznych w celu ułatwienia obliczeń, co jest znane jako osadzanie. Ważne jest, aby znaleźć optymalny rozmiar fragmentu. Mniejszy rozmiar fragmentu zmniejsza znaczenie kontekstu, podczas gdy większy rozmiar fragmentu wprowadza więcej szumu. Algorytm chunkingu Cody’ego dynamicznie dostosowuje rozmiar fragmentu w oparciu o dystrybucję tokenów ustawioną przez użytkownika.

Jak okno kontekstowe wpływa na odpowiedzi bota?

Na jakość odpowiedzi botów wpływają różne czynniki, takie jak osobowość, wynik trafności itp. Okno kontekstowe modelu również odgrywa znaczącą rolę w określaniu jakości. Okno kontekstowe odnosi się do ilości tekstu, który LLM (Language Model) może przetworzyć w jednym wywołaniu. Ponieważ Cody wykorzystuje osadzanie i wstrzykiwanie kontekstu do generowania odpowiedzi przy użyciu modeli OpenAI, większe okno kontekstowe pozwala na pozyskanie większej ilości danych przez model w każdym zapytaniu.

Każde zapytanie (≤ okno kontekstowe) = osobowość bota + fragmenty wiedzy + historia + dane wejściowe użytkownika + odpowiedź

Okna kontekstowe różnych modeli:

- GPT-3.5: 4096 tokenów (≈3500 słów)

- GPT-3.5 16K: 16000 tokenów (≈13000 słów)

- GPT-4: 8000 tokenów (≈7000 słów)

Gdy okno kontekstowe jest większe, umożliwia większą część każdego parametru, w tym Osobowość, Fragmenty, Historia, Wejście i Odpowiedź. Ten rozszerzony kontekst umożliwia botowi generowanie odpowiedzi, które są bardziej trafne, spójne i kreatywne.

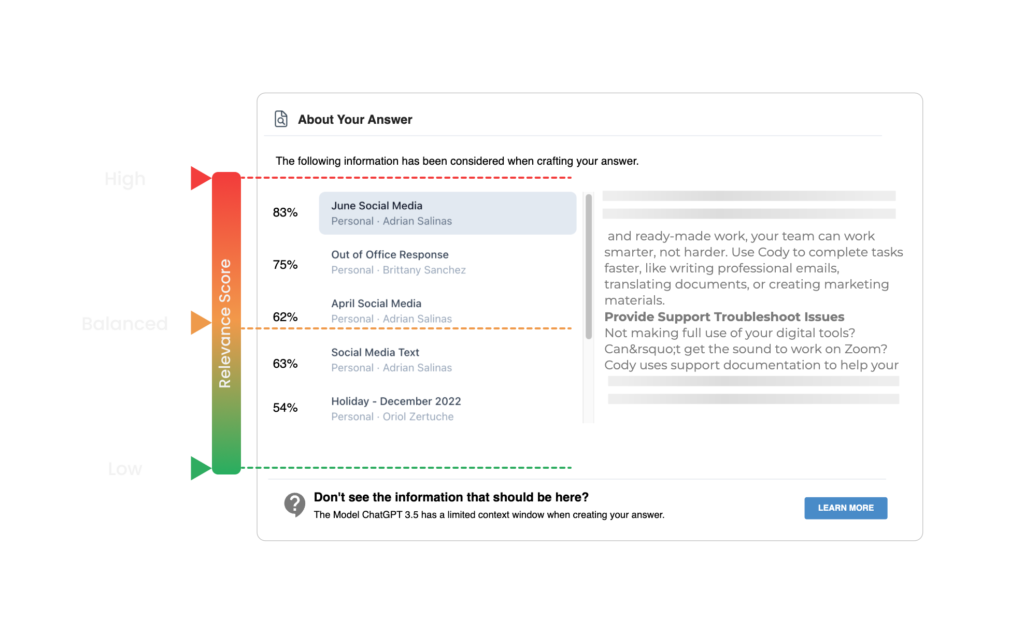

Najnowszy dodatek Cody’ego umożliwia użytkownikom sprawdzanie cytatów dokumentów poprzez kliknięcie nazwy dokumentu na końcu odpowiedzi. Cytaty te odpowiadają fragmentom uzyskanym w wyniku wyszukiwania semantycznego. Cody określa próg fragmentu dla kontekstu na podstawie wyniku trafności ustawionego przez użytkownika. Jeśli użytkownik ustawi wysoki wynik trafności, Cody używa tylko fragmentów, które przekraczają wstępnie zdefiniowany próg jako kontekst do generowania odpowiedzi.

Przykład

Przyjmując wstępnie zdefiniowaną wartość graniczną 90% dla wysokiego wyniku trafności, Cody odrzuca wszystkie fragmenty z wynikiem trafności niższym niż 90%. Nowym użytkownikom zalecamy rozpoczęcie od niższego wyniku trafności (niski lub zrównoważony), szczególnie w przypadku korzystania z przesłanych dokumentów (PDF, PowerPoint, Word itp.) lub stron internetowych. Przesłane dokumenty lub strony internetowe mogą napotkać problemy z formatowaniem i czytelnością podczas wstępnego przetwarzania, co może skutkować niższymi wynikami trafności. Formatowanie dokumentu za pomocą naszego wbudowanego edytora tekstu zamiast przesyłania surowych dokumentów zapewni najwyższą dokładność i wynik zaufania.

Jeśli zainteresował Cię ten blog i chcesz zagłębić się w koncepcje okna kontekstowego i chunkingu, gorąco polecamy przeczytanie tego bloga napisanego przez Kristiana z All About AI. Aby uzyskać więcej zasobów, możesz również sprawdzić nasze Centrum pomocy i dołączyć do naszej społeczności Discord.