Mejorar la productividad de la investigación con herramientas de IA

El panorama de la investigación moderna está experimentando un cambio transformador, gracias a la llegada de la Inteligencia Artificial (IA).

Estos sistemas inteligentes están facilitando a los investigadores el procesamiento de grandes cantidades de datos y la rápida extracción de información valiosa.

Un componente crucial de esta transformación es el conjunto de herramientas potenciadas por los Transformadores Generativos Preentrenados (GPT), que están diseñados para manejar tareas complejas con gran eficacia.

Las herramientas de IA son cada vez más indispensables en entornos de investigación académicos y profesionales.

Ayudan a resumir intrincados trabajos de investigación, realizar búsquedas avanzadas y mejorar la calidad de la documentación.

Aprovechando estas herramientas, los investigadores pueden agilizar considerablemente sus flujos de trabajo y centrarse más en el pensamiento innovador y la resolución de problemas .

1. Resumir trabajos de investigación complejos

Una de las tareas que más tiempo consume en la investigación es descifrar documentos complejos.

Afortunadamente, las herramientas potenciadas por GPT se han convertido en algo inestimable en este campo. SummarizePaper.com es una herramienta de IA de código abierto diseñada específicamente para resumir artículos de arXiv, haciéndolos más digeribles para los investigadores.

Además, Unriddl agiliza los temas complejos y proporciona resúmenes concisos, permitiendo a los investigadores captar rápidamente ideas intrincadas.

Otra herramienta notable es Wordtune, que puede resumir rápidamente documentos largos, ayudando así a comprender la información de forma eficiente.

Estos avances permiten a los académicos ahorrar tiempo y centrarse en el análisis crítico y la innovación.

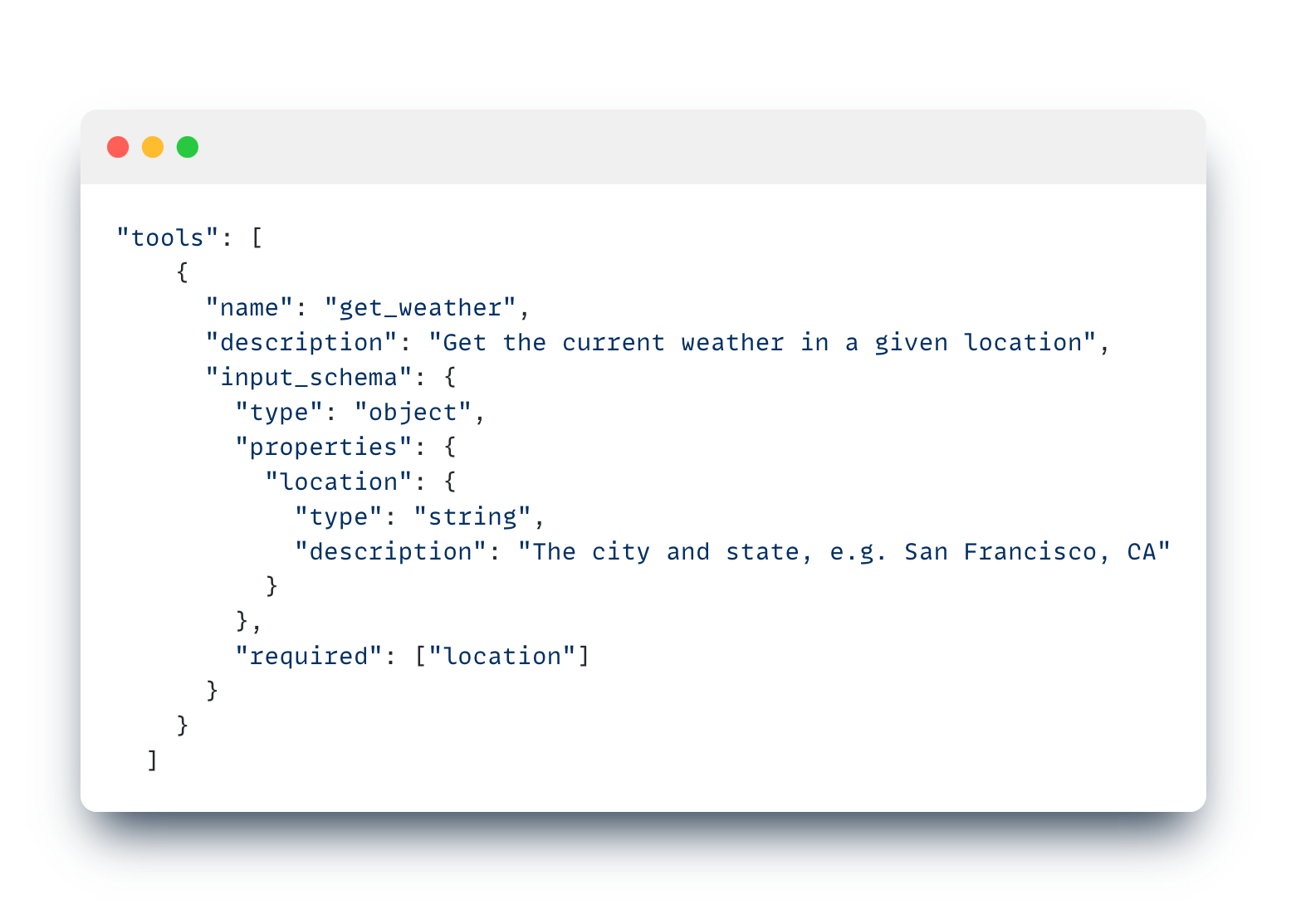

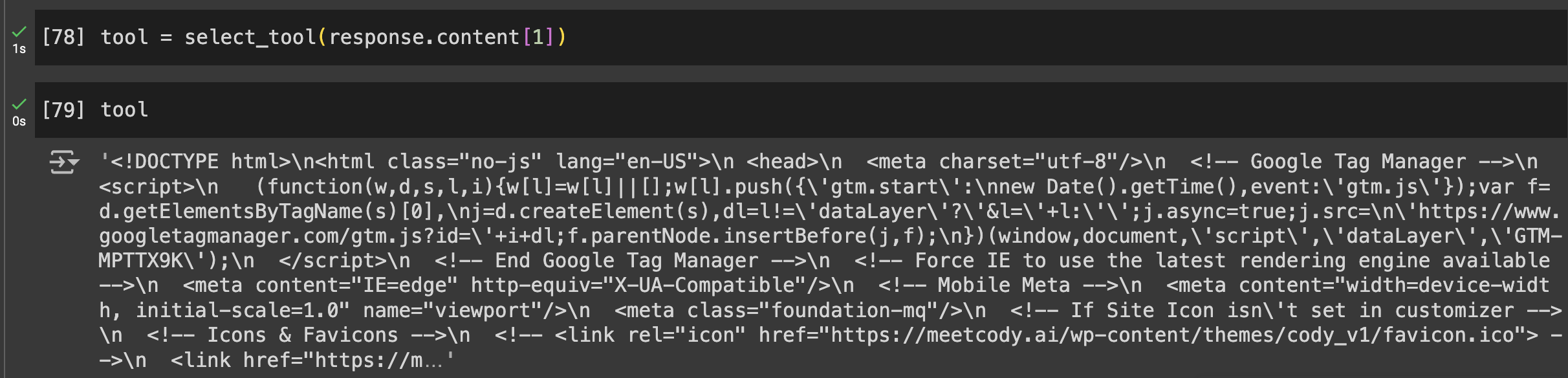

Para quienes busquen una herramienta más versátil con funciones intuitivas como el análisis selectivo de documentos, la naturaleza agnóstica de los modelos y la posibilidad de compartir bots entrenados en tus trabajos de investigación, Cody AI es otra gran opción que incorpora todas estas características.

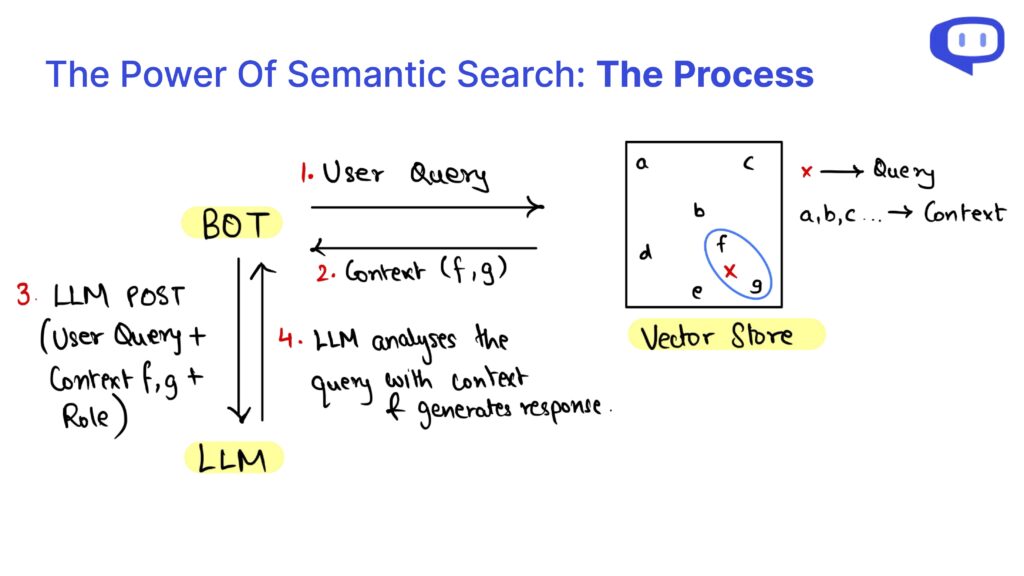

2. Búsqueda avanzada y recuperación de información

Encontrar información precisa con rapidez es primordial en la investigación, y las herramientas de IA destacan en este ámbito. Searcholic es un motor de búsqueda potenciado por IA que ayuda a los investigadores a localizar una amplia gama de libros electrónicos y documentos sin esfuerzo.

Esta herramienta facilita el acceso a diversas fuentes de información, garantizando que los investigadores dispongan de contenidos completos al alcance de la mano.

Otra potente herramienta es Semantic Scholar, que ofrece acceso a más de 211 millones de artículos científicos.

Esta herramienta de IA permite a los usuarios realizar revisiones bibliográficas exhaustivas, proporcionando funcionalidades de búsqueda avanzada adaptadas a la investigación científica.

Por último, Perplexity combina las funcionalidades de un motor de búsqueda y un chatbot, permitiendo a los investigadores hacer preguntas y recibir respuestas detalladas rápidamente.

Este enfoque híbrido no sólo ahorra tiempo, sino que también mejora la eficacia de la recuperación de información, convirtiéndolo en una herramienta indispensable para los investigadores modernos.

3. Mejorar la documentación de la investigación

Una documentación eficaz es crucial para la difusión y validación de la investigación. Penelope AI es una herramienta inestimable que permite a los investigadores comprobar sus manuscritos académicos antes de enviarlos a las revistas, garantizando que su trabajo se ajusta a normas y directrices exigentes.

Otra herramienta indispensable es Grammarly, que corrige los errores gramaticales y ortográficos, mejorando así la legibilidad y profesionalidad de los documentos de investigación.

Esto contribuye a la calidad y claridad general de la investigación, haciéndola más accesible a un público más amplio.

Además, Kudos ayuda a los investigadores a explicar su trabajo en un lenguaje sencillo y a crear páginas visualmente atractivas.

Este servicio aumenta la visibilidad de la investigación al traducir temas complejos en contenidos más comprensibles, ampliando así el impacto potencial de los resultados de la investigación.

En conjunto, estas herramientas garantizan que la documentación de la investigación sea exhaustiva, bien presentada y comprensible, ayudando en última instancia a la comunicación eficaz de los descubrimientos científicos.

Conclusiones: Adoptar la IA para la investigación futura

Incorporar herramientas de GPT e IA al proceso de investigación ofrece numerosas ventajas, desde resumir complejos trabajos de investigación hasta mejorar la documentación.

Herramientas como SummarizePaper.com y Unriddl simplifican la comprensión de temas intrincados proporcionando resúmenes concisos, haciendo más accesible la literatura académica.

Además, los motores de búsqueda basados en IA, como Semant Scholar, facilitan la recuperación eficaz de la información, mejorando enormemente el flujo de trabajo de la investigación.

En cuanto a la documentación, herramientas como Penelope AI y Grammarly garantizan que los documentos cumplan normas estrictas y se comuniquen con claridad.

Kudos amplía aún más el alcance de la investigación traduciendo los resultados complejos a un lenguaje sencillo.

Estas herramientas de IA mejoran colectivamente la precisión, la eficacia y el impacto de las actividades de investigación.

A medida que seguimos adoptando la IA en la investigación, no sólo mejoramos los flujos de trabajo individuales, sino que también contribuimos a la comunidad científica en general.

Integrar estas herramientas avanzadas es un paso hacia una investigación más eficiente, precisa y accesible, que impulse la innovación y los descubrimientos futuros.