Groq und Llama 3: Ein spielveränderndes Duo

Vor ein paar Monaten tauchte wie aus dem Nichts ein neues Unternehmen namens ‘Groq’ auf, das einen Durchbruch in der KI-Branche erzielte. Sie boten Entwicklern eine Plattform für den Zugriff auf LPUs als Inferencing-Engines für LLMs, insbesondere für Open-Source-Lösungen wie Llama, Mixtral und Gemma. In diesem Blog wollen wir erkunden, was Groq so besonders macht und das Wunder hinter LPUs ergründen.

Was ist Groq?

“Groq hat es sich zur Aufgabe gemacht, den Standard für die Geschwindigkeit von GenAI-Inferenzen zu setzen und so KI-Anwendungen in Echtzeit zum Leben zu erwecken.” – Die Groq Website

Groq ist kein Unternehmen, das LLMs wie GPT oder Gemini entwickelt. Stattdessen konzentriert sich Groq darauf, die Grundlagen dieser großen Sprachmodelle zu verbessern – die Hardware, auf der sie arbeiten. Sie dient als ‘Inferenzmaschine’. Derzeit nutzen die meisten LLMs auf dem Markt herkömmliche GPUs, die auf privaten Servern oder in der Cloud eingesetzt werden. Diese Grafikprozessoren sind zwar teuer und leistungsstark und stammen von Unternehmen wie Nvidia, aber sie basieren immer noch auf der traditionellen GPU-Architektur, die für LLM-Inferencing nicht optimal geeignet ist (obwohl sie nach wie vor leistungsstark und für das Training von Modellen bevorzugt sind).

Die von Groq bereitgestellte Inferenzmaschine arbeitet mit LPUs – Language Processing Units.

Was ist eine LPU?

Eine Language Processing Unit ist ein Chip, der speziell für LLMs entwickelt wurde. Er basiert auf einer einzigartigen Architektur, die CPUs und GPUs kombiniert, um Tempo, Vorhersagbarkeit, Leistung und Genauigkeit von KI-Lösungen für LLMs zu verbessern.

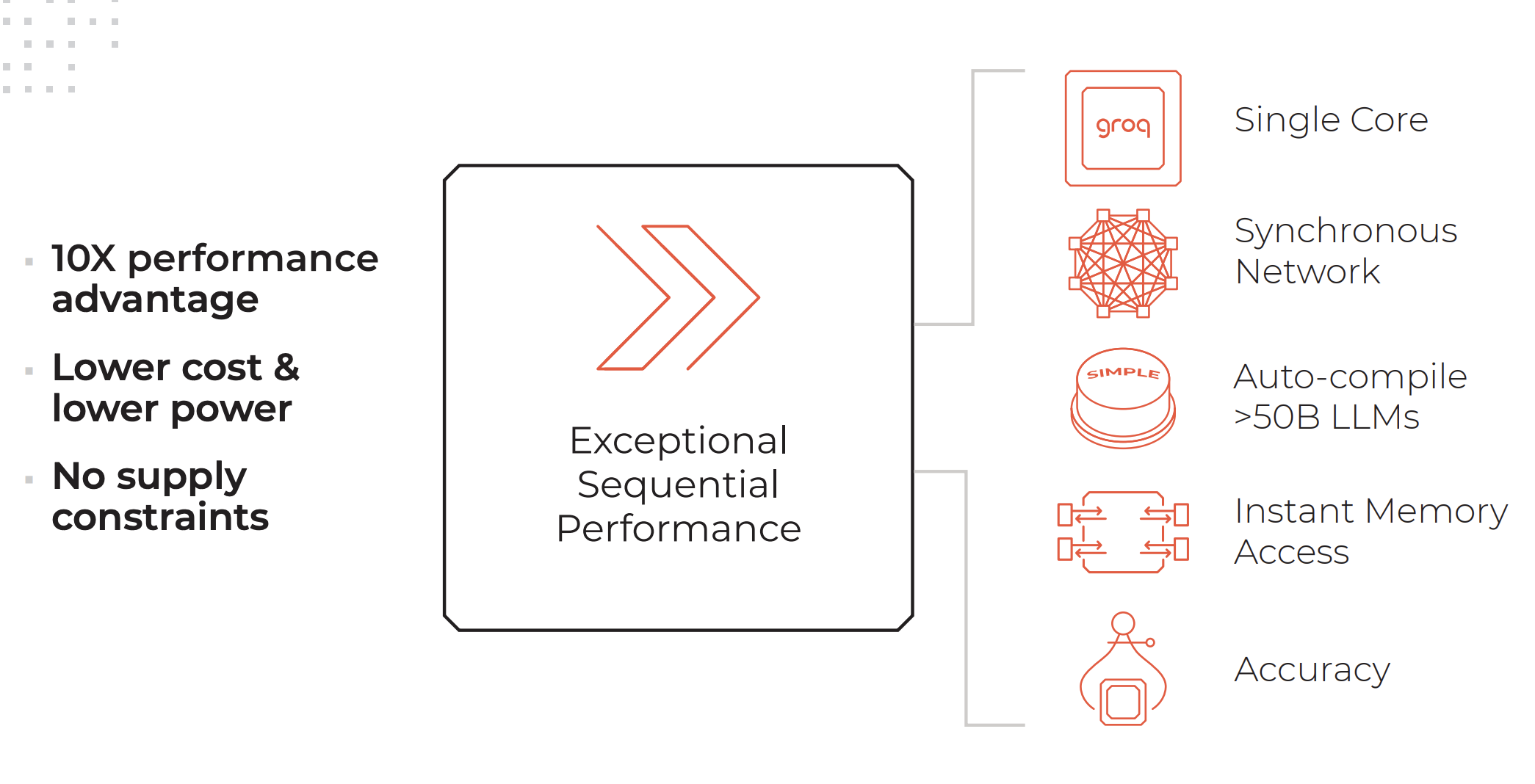

Die wichtigsten Merkmale eines LPU-Systems. Kredite: Groq

Ein LPU-System verfügt über so viel oder mehr Rechenleistung wie ein Grafikprozessor (GPU) und reduziert die Rechenzeit pro Wort, was eine schnellere Generierung von Textsequenzen ermöglicht.

Merkmale einer LPU-Inferenzmaschine, wie auf der Groq-Website aufgeführt:

- Außergewöhnliche sequentielle Leistung

- Architektur mit einem Kern

- Synchrone Vernetzung, die auch bei großen Implementierungen erhalten bleibt

- Fähigkeit zur automatischen Kompilierung >50B LLMs

- Sofortiger Speicherzugriff

- Hohe Genauigkeit, die auch bei niedrigeren Genauigkeitsstufen erhalten bleibt

Dienstleistungen von Groq:

- GroqCloud: LPUs in der Cloud

- GroqRack: 42U-Rack mit bis zu 64 zusammengeschalteten Chips

- GroqNode: Skalierbares 4U-Rack-Rechnersystem mit acht miteinander verbundenen GroqCard™-Beschleunigern

- GroqCard: Ein einziger Chip in einem Standard-PCIe Gen 4×16-Formfaktor für problemlose Serverintegration

“Anders als die CPU, die für eine völlig andere Art von Aufgabe als KI entwickelt wurde, oder die GPU, die auf der Grundlage der CPU entwickelt wurde, um zufällig etwas Ähnliches wie KI zu tun, oder die TPU, die die GPU modifiziert hat, um sie besser für KI zu machen, ist Groq von Grund auf, von den ersten Prinzipien her, ein Computersystem für KI” – Daniel Warfield, Towards Data Science

Um mehr darüber zu erfahren, wie sich LPUs von GPUs, TPUs und CPUs unterscheiden, empfehlen wir Ihnen, diesen umfassenden Artikel von Daniel Warfield für Towards Data Science zu lesen.

Was ist der Sinn von Groq?

LLMs sind unglaublich leistungsfähig und können Aufgaben bewältigen, die von der Analyse unstrukturierter Daten bis zur Beantwortung von Fragen über die Niedlichkeit von Katzen reichen. Ihr größter Nachteil liegt jedoch derzeit in der Reaktionszeit. Die langsamere Reaktionszeit führt bei der Verwendung von LLMs in Backend-Prozessen zu erheblichen Latenzzeiten. Beispielsweise ist das Abrufen von Daten aus einer Datenbank und die Anzeige im JSON-Format derzeit viel schneller, wenn es mit herkömmlicher Logik erfolgt, anstatt die Daten zur Transformation durch einen LLM zu leiten. Der Vorteil von LLMs liegt jedoch in ihrer Fähigkeit, Datenausnahmen zu verstehen und zu behandeln.

Mit der unglaublichen Inferenzgeschwindigkeit, die Groq bietet, kann dieser Nachteil von LLMs stark reduziert werden. Dies eröffnet bessere und breitere Einsatzmöglichkeiten für LLMs und senkt die Kosten, denn mit einer LPU können Sie Open-Source-Modelle einsetzen, die viel billiger zu betreiben sind und sehr schnelle Reaktionszeiten haben.

Llama 3 auf Groq

Vor ein paar Wochen hat Meta die neueste Version des ohnehin schon leistungsstarken und äußerst fähigen Open-Source-Programms LLM-Llama 3 vorgestellt. Neben den typischen Verbesserungen bei der Geschwindigkeit, dem Datenverständnis und der Token-Generierung stechen zwei wesentliche Verbesserungen hervor:

- Trainiert auf einem 7-mal größeren Datensatz als Llama 2, mit 4-mal mehr Code.

- Verdoppelung der Kontextlänge auf 8.000 Token.

Llama 2 war bereits ein hervorragender Open-Source-LLM, aber mit diesen beiden Updates wird die Leistung von Llama 3 voraussichtlich deutlich steigen.

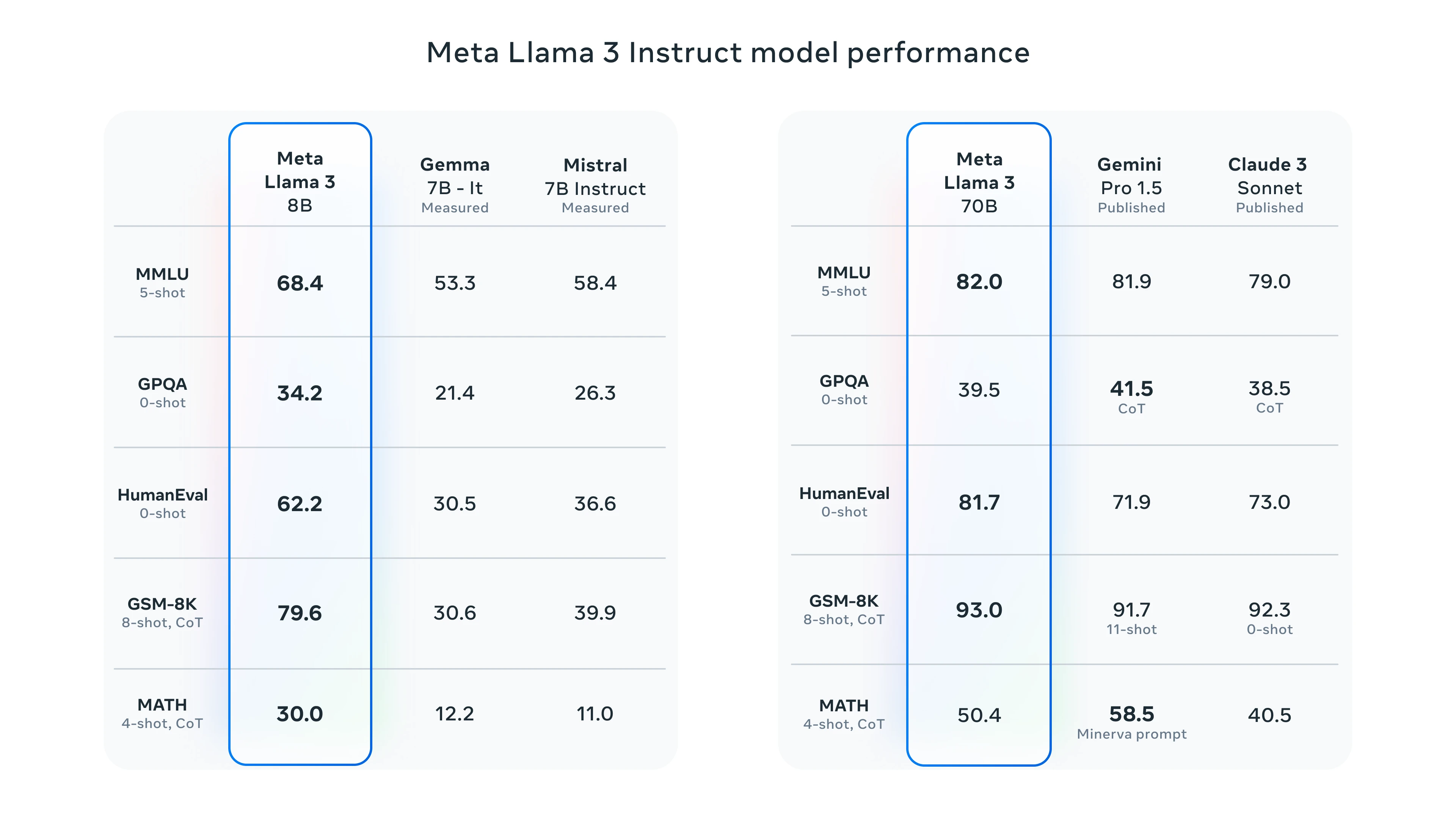

Llama 3 Benchmarks

Um Llama 3 zu testen, haben Sie die Möglichkeit, Meta AI oder den Groq-Spielplatz zu nutzen. Wir werden die Leistung von Groq mit Llama 3 testen.

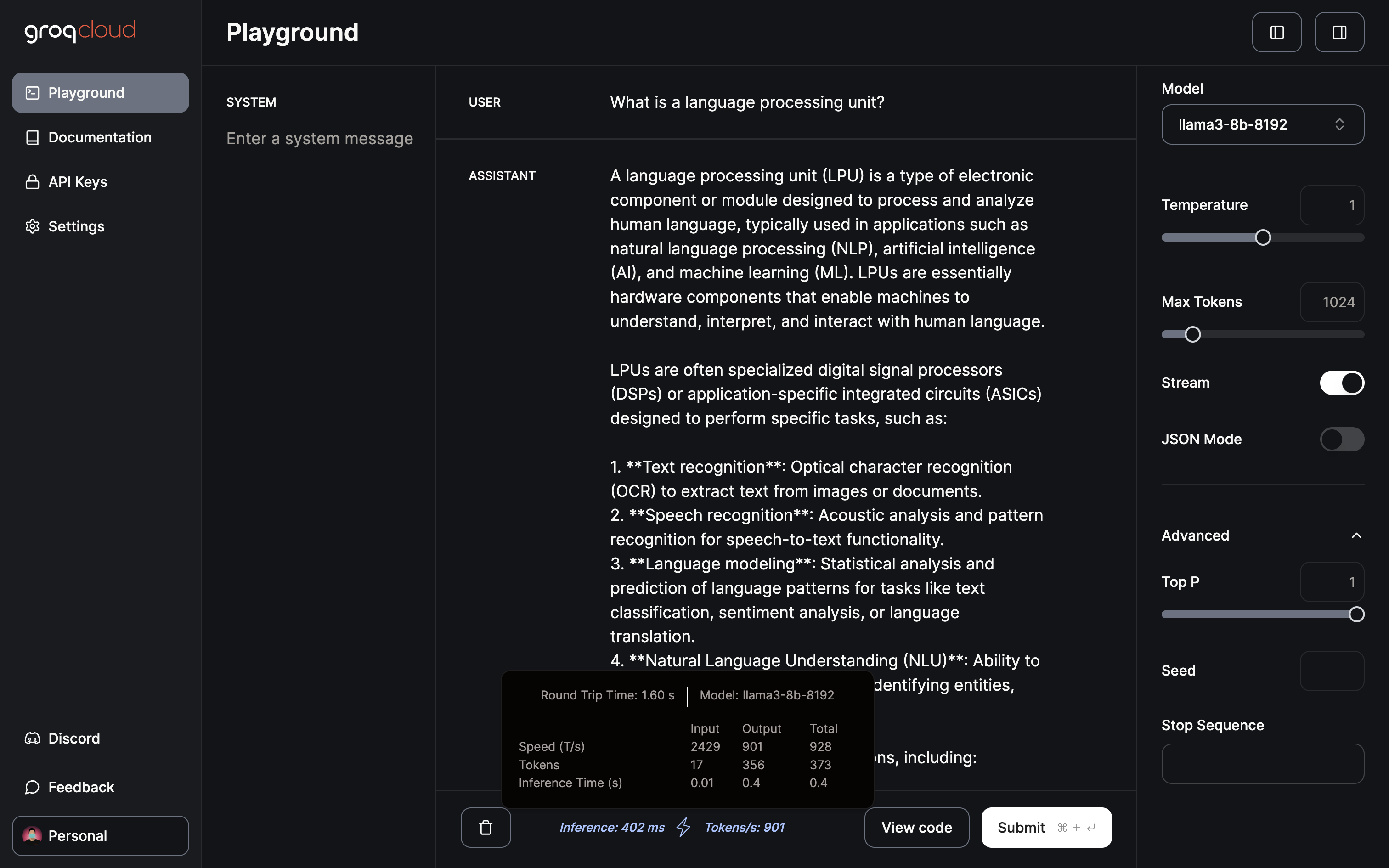

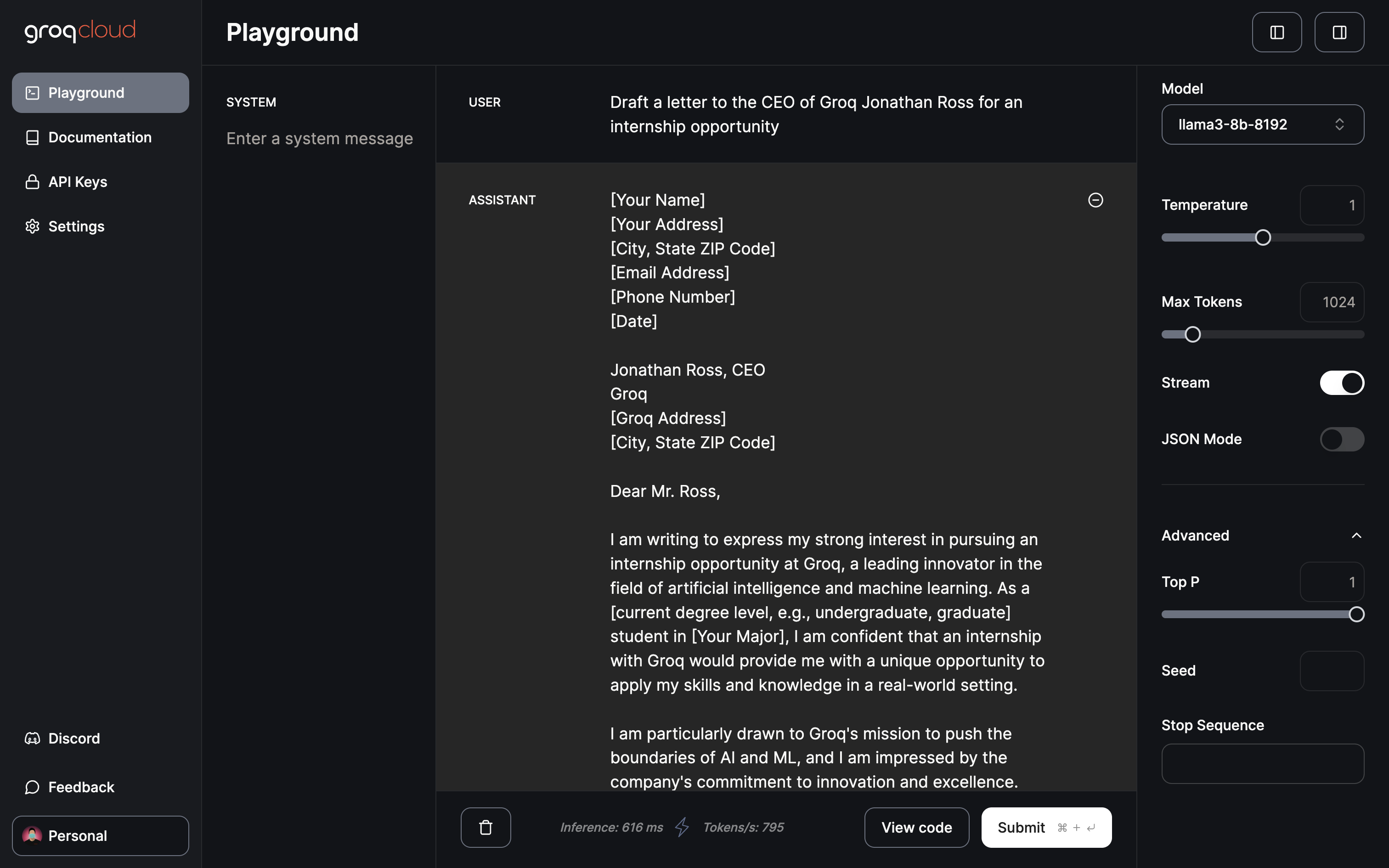

Groq Spielplatz

Derzeit bietet der Groq-Spielplatz freien Zugang zu Gemma 7B, Llama 3 70B und 8B und Mixtral 8x7b. Auf dem Spielplatz können Sie Parameter wie die Temperatur, die maximale Anzahl von Token und die Streaming-Umschaltung einstellen. Außerdem verfügt es über einen speziellen JSON-Modus, um ausschließlich JSON-Ausgaben zu erzeugen.

Nur 402ms für die Inferenz bei einer Rate von 901 Token/s

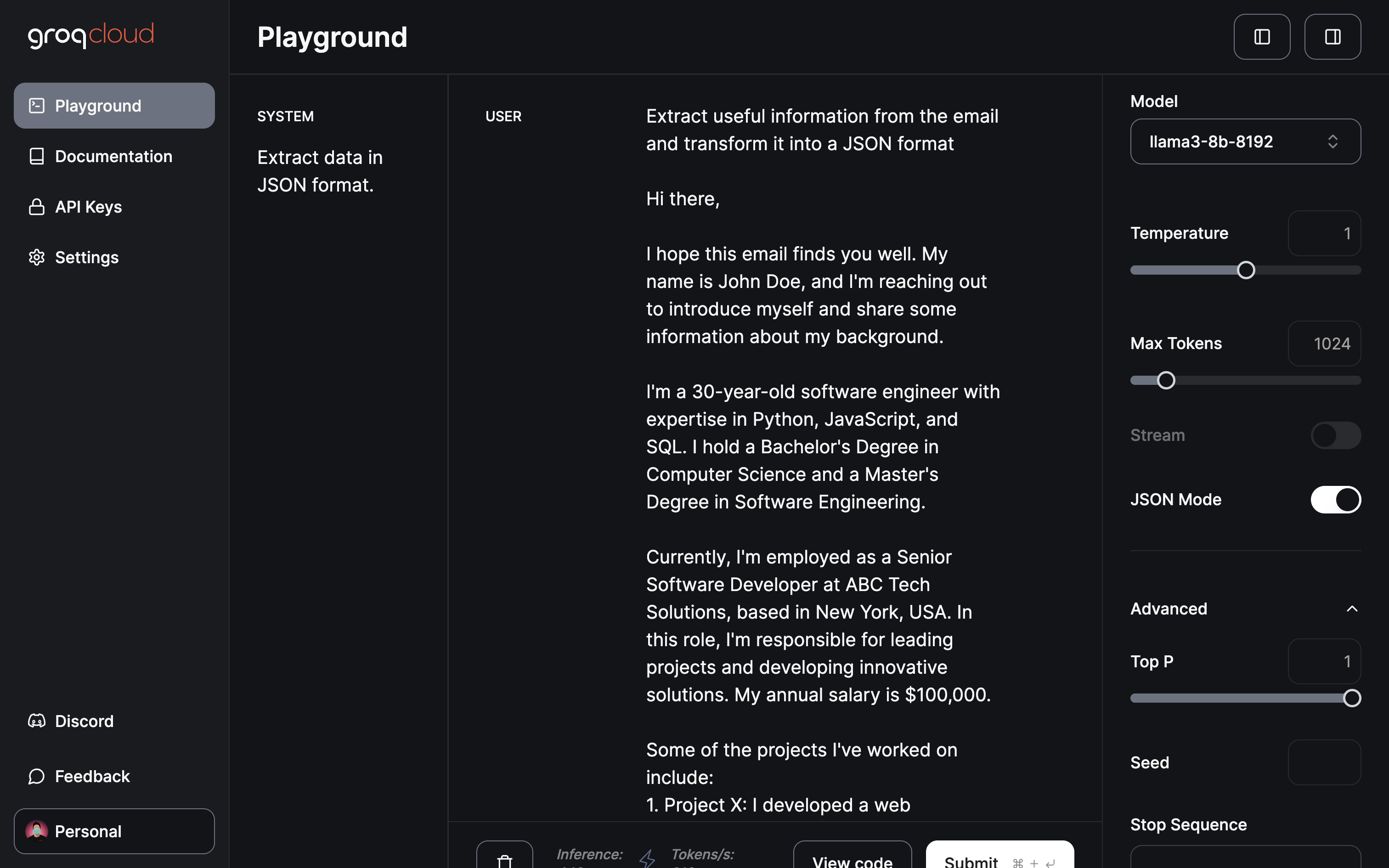

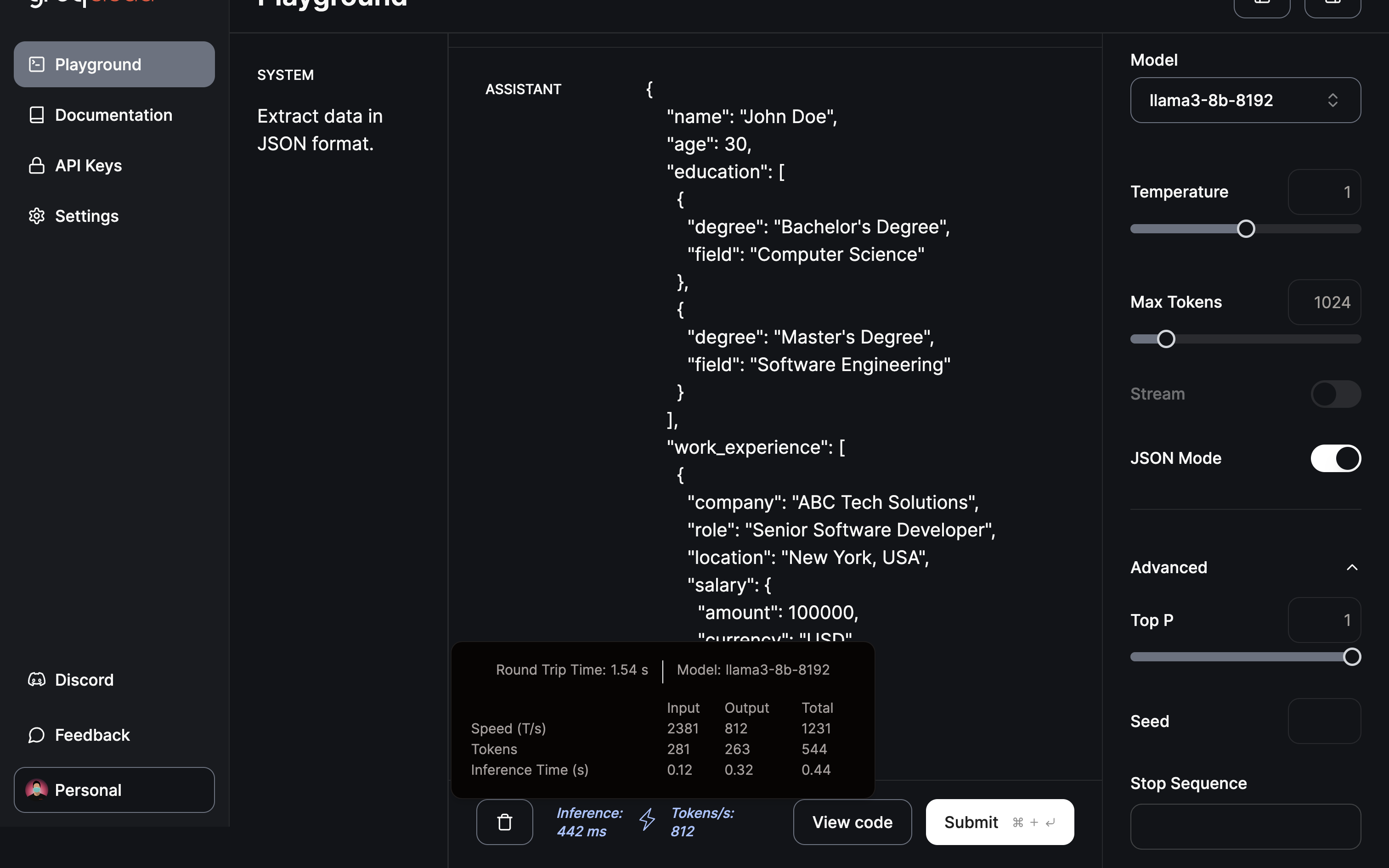

Ich komme nun zu dem Bereich/Anwendung, der meiner Meinung nach am meisten Einfluss hat: Datenextraktion und -umwandlung:

Bitten Sie das Modell, nützliche Informationen zu extrahieren und ein JSON mit dem JSON-Modus bereitzustellen.

Die Extraktion und Umwandlung in das JSON-Format war in weniger als einer halben Sekunde abgeschlossen.

Schlussfolgerung

Wie gezeigt, hat Groq mit seiner innovativen LPU Inference Engine die LLM-Landschaft entscheidend verändert. Der hier gezeigte schnelle Wandel deutet auf das immense Potenzial für die Beschleunigung von KI-Anwendungen hin. Über die zukünftigen Innovationen von Groq kann man nur spekulieren. Vielleicht könnte eine Bildverarbeitungseinheit die Bilderzeugungsmodelle revolutionieren und zu Fortschritten bei der KI-Videoerzeugung beitragen. Es ist in der Tat eine aufregende Zukunft, die Sie erwarten können.

Da die LLM-Schulung immer effizienter wird, ist die Aussicht auf ein personalisiertes ChatGPT, das auf Ihre Daten auf Ihrem lokalen Gerät abgestimmt ist, eine verlockende Aussicht. Eine Plattform, die solche Möglichkeiten bietet, ist Cody, ein intelligenter KI-Assistent, der darauf zugeschnitten ist, Unternehmen in verschiedenen Bereichen zu unterstützen. Ähnlich wie ChatGPT kann Cody auf Ihre Geschäftsdaten, Ihr Team, Ihre Prozesse und Ihre Kunden geschult werden, wobei Ihre einzigartige Wissensbasis genutzt wird.

Mit Cody können Unternehmen die Leistung der KI nutzen, um einen personalisierten und intelligenten Assistenten zu schaffen, der speziell auf ihre Bedürfnisse zugeschnitten ist. Das macht Cody zu einer vielversprechenden Ergänzung in der Welt der KI-gesteuerten Unternehmenslösungen.