Verbesserung der Forschungsproduktivität mit KI-Tools

Die Landschaft der modernen Forschung befindet sich dank des Aufkommens der Künstlichen Intelligenz (KI) in einem tiefgreifenden Umbruch.

Diese intelligenten Systeme erleichtern es den Forschern, riesige Datenmengen zu verarbeiten und schnell wertvolle Erkenntnisse zu gewinnen.

Eine entscheidende Komponente dieses Wandels ist die Suite von Tools, die auf Generative Pre-trained Transformers (GPT) beruhen, die komplexe Aufgaben mit hoher Effizienz bewältigen können.

KI-Tools werden in akademischen und professionellen Forschungsumgebungen zunehmend unverzichtbar.

Sie helfen bei der Zusammenfassung komplexer Forschungsarbeiten, bei der Durchführung fortgeschrittener Suchen und bei der Verbesserung der Dokumentationsqualität.

Durch den Einsatz dieser Tools können Forscher ihre Arbeitsabläufe erheblich rationalisieren und sich stärker auf innovatives Denken und Problemlösungen konzentrieren.

1. Komplexe Forschungspapiere zusammenfassen

Eine der zeitaufwändigsten Aufgaben in der Forschung ist das Entschlüsseln komplexer Dokumente.

Glücklicherweise sind GPT-gestützte Tools in diesem Bereich von unschätzbarem Wert geworden. SummarizePaper.com ist ein Open-Source-KI-Tool, das speziell dafür entwickelt wurde, Artikel von arXiv zusammenzufassen und sie so für Forscher leichter verdaulich zu machen.

Darüber hinaus vereinfacht Unriddl komplexe Themen und liefert prägnante Zusammenfassungen, die es Forschern ermöglichen, komplizierte Ideen schnell zu erfassen.

Ein weiteres bemerkenswertes Tool ist Wordtune, das lange Dokumente schnell zusammenfassen kann und so hilft, umfangreiche Informationen effizient zu verstehen.

Diese Fortschritte ermöglichen es Wissenschaftlern, Zeit zu sparen und sich auf kritische Analysen und Innovationen zu konzentrieren.

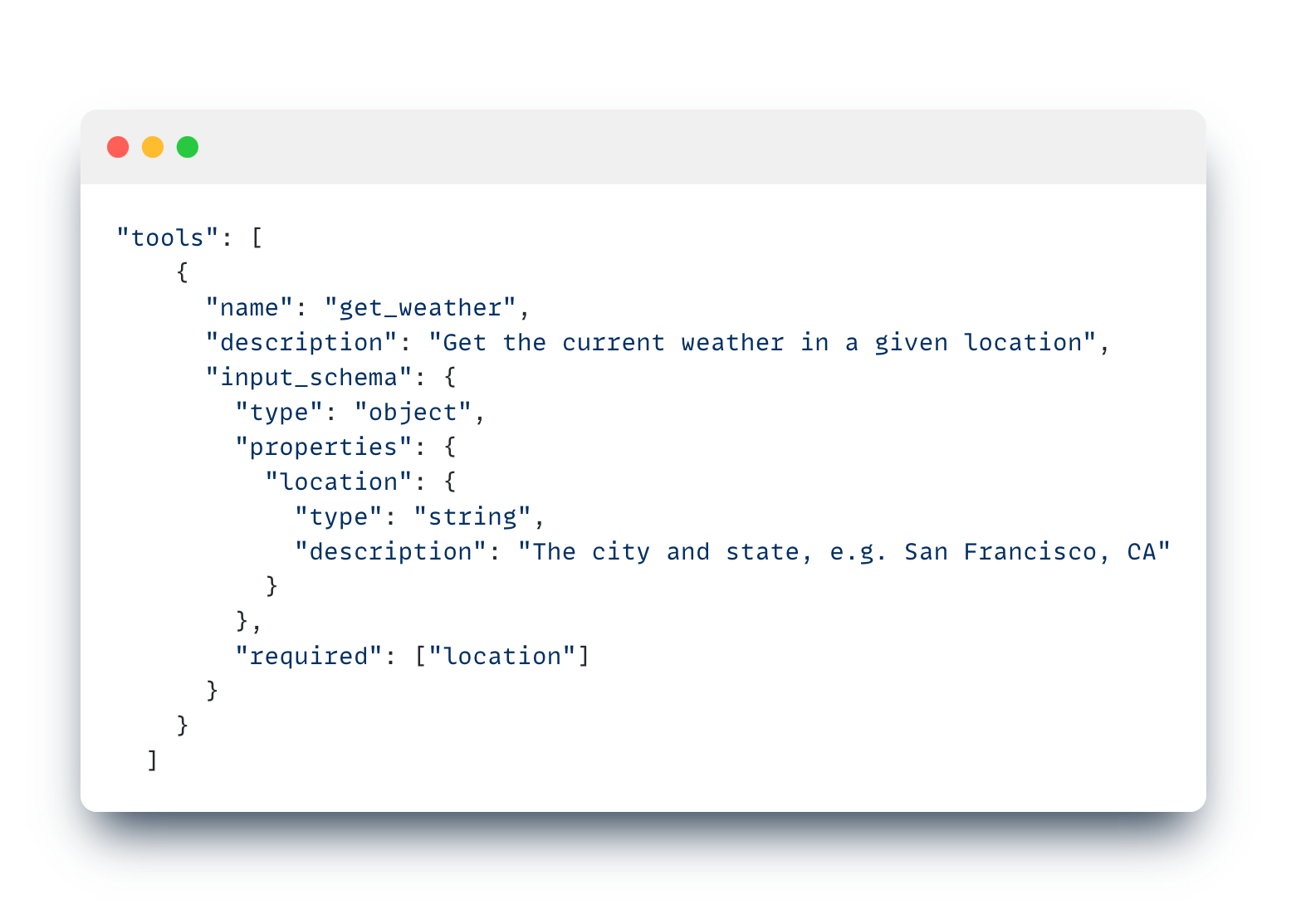

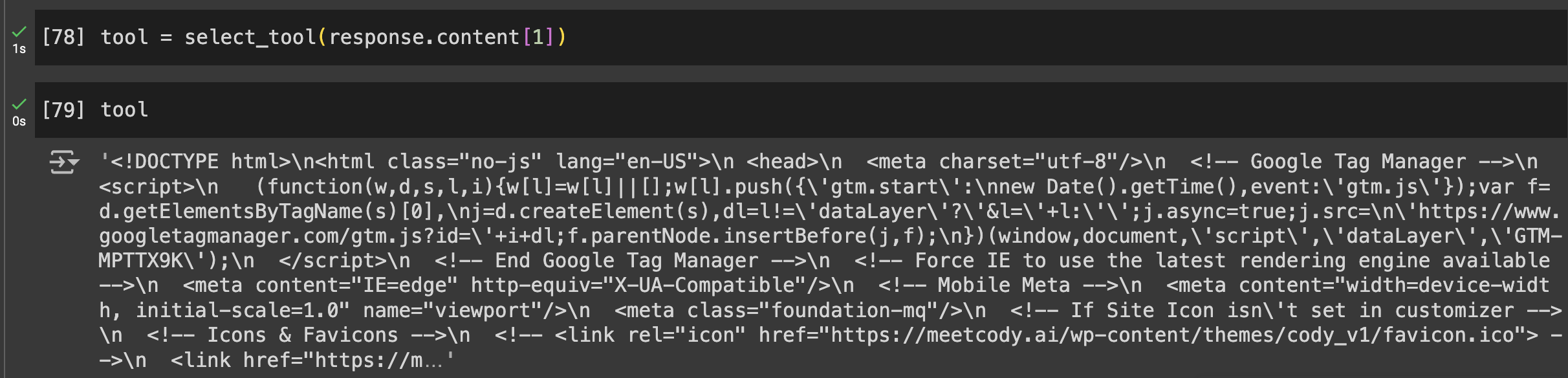

Wenn Sie auf der Suche nach einem vielseitigeren Tool mit intuitiven Funktionen wie der selektiven Dokumentenanalyse, der Modellagnostik und der Möglichkeit, Bots, die auf Ihre Forschungsarbeiten trainiert wurden, mit anderen zu teilen, ist Cody AI eine weitere gute Wahl, die all diese Funktionen bietet.

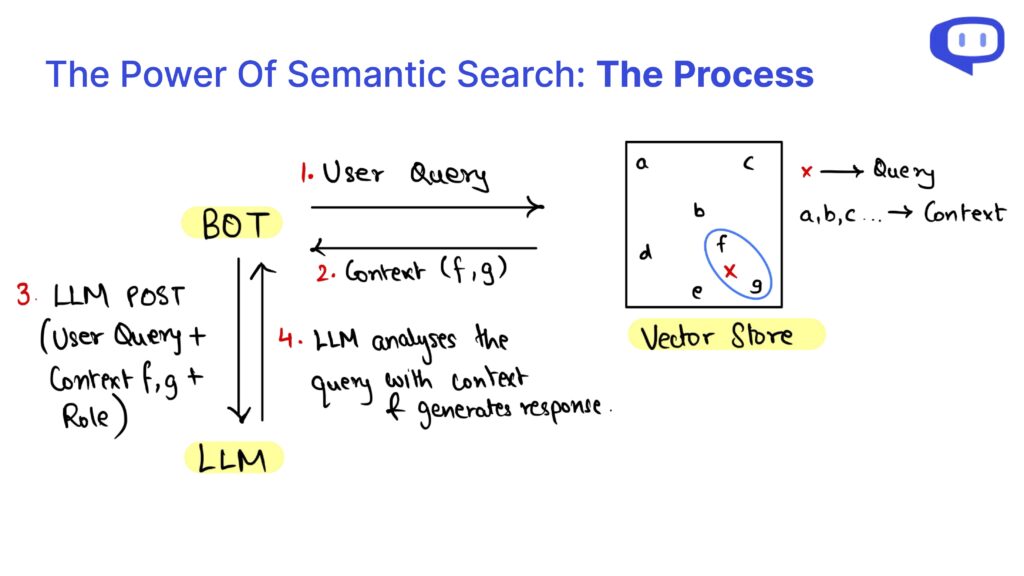

2. Erweiterte Suche und Informationsabrufe

Das schnelle Auffinden präziser Informationen ist in der Forschung von größter Bedeutung, und KI-Tools zeichnen sich in diesem Bereich aus. Searcholic ist eine KI-gestützte Suchmaschine, die Forschern hilft, mühelos eine Vielzahl von eBooks und Dokumenten zu finden.

Dieses Tool erleichtert den Zugang zu verschiedenen Informationsquellen und stellt sicher, dass Forscher umfassende Inhalte zur Verfügung haben.

Ein weiteres leistungsstarkes Tool ist Semantic Scholar, das Zugang zu über 211 Millionen wissenschaftlichen Artikeln bietet.

Dieses KI-Tool ermöglicht es Benutzern, gründliche Literaturrecherchen durchzuführen, indem es erweiterte, auf die wissenschaftliche Forschung zugeschnittene Suchfunktionen bietet.

Perplexity schließlich kombiniert die Funktionen einer Suchmaschine mit denen eines Chatbots und ermöglicht es Forschern, Fragen zu stellen und schnell detaillierte Antworten zu erhalten.

Dieser hybride Ansatz spart nicht nur Zeit, sondern verbessert auch die Effizienz der Informationsbeschaffung und ist damit ein unverzichtbares Werkzeug für moderne Forscher.

3. Verbessern der Forschungsdokumentation

Eine effektive Dokumentation ist entscheidend für die Verbreitung und Validierung von Forschungsergebnissen. Penelope AI ist ein unschätzbares Werkzeug, mit dem Forscher ihre akademischen Manuskripte vor der Einreichung bei Zeitschriften überprüfen können, um sicherzustellen, dass ihre Arbeit hohen Standards und Richtlinien entspricht.

Ein weiteres unverzichtbares Tool ist Grammarly, das Grammatik- und Rechtschreibfehler korrigiert und so die Lesbarkeit und Professionalität von Forschungsdokumenten verbessert.

Dies trägt zur allgemeinen Qualität und Klarheit der Forschungsarbeit bei und macht sie für ein breiteres Publikum zugänglich.

Außerdem hilft Kudos Forschern, ihre Arbeit in einfacher Sprache zu erklären und optisch ansprechende Seiten zu erstellen.

Dieser Service erhöht die Sichtbarkeit der Forschung, indem er komplexe Themen in verständlichere Inhalte übersetzt und so die potenzielle Wirkung der Forschungsergebnisse vergrößert.

Diese Tools stellen gemeinsam sicher, dass die Forschungsdokumentation gründlich, gut präsentiert und verständlich ist, was letztendlich zur effektiven Kommunikation wissenschaftlicher Entdeckungen beiträgt.

Schlussfolgerung: KI für die zukünftige Forschung nutzen

Die Einbindung von GPT- und KI-Tools in den Forschungsprozess bietet zahlreiche Vorteile, von der Zusammenfassung komplexer Forschungsarbeiten bis hin zur Verbesserung der Dokumentation.

Tools wie SummarizePaper.com und Unriddl vereinfachen das Verständnis komplizierter Themen, indem sie prägnante Zusammenfassungen liefern und die akademische Literatur leichter zugänglich machen.

Darüber hinaus erleichtern KI-gestützte Suchmaschinen wie Semant Scholar das effiziente Auffinden von Informationen, was den Arbeitsablauf in der Forschung erheblich verbessert.

Für die Dokumentation sorgen Tools wie Penelope AI und Grammarly dafür, dass die Dokumente hohen Standards entsprechen und klar kommuniziert werden.

Kudos vergrößert die Reichweite der Forschung, indem es komplexe Ergebnisse in einfache Sprache übersetzt.

Diese KI-Tools verbessern gemeinsam die Präzision, Effizienz und Wirkung von Forschungsaktivitäten.

Wenn wir weiterhin KI in der Forschung einsetzen, verbessern wir nicht nur die individuellen Arbeitsabläufe, sondern tragen auch zur breiteren wissenschaftlichen Gemeinschaft bei.

Die Integration dieser fortschrittlichen Tools ist ein Schritt hin zu einer effizienteren, präziseren und leichter zugänglichen Forschung, die zukünftige Innovationen und Entdeckungen vorantreibt.