O evento DevDay da OpenAI, muito aguardado, trouxe algumas notícias interessantes e fugas de informação sobre preços que deixaram a comunidade de IA a fervilhar de expetativa. Entre os principais destaques estão o lançamento do GPT-4 Turbo, reduções significativas de preços para vários serviços, a janela de contexto GPT-4 turbo 128k e a revelação da API Assistants. Vamos aprofundar os pormenores e ver como estes desenvolvimentos estão a moldar o futuro da IA.

GPT-4 Turbo: Mais potência a um preço mais baixo

O ponto alto do evento foi, sem dúvida, a apresentação do GPT-4 Turbo. Este modelo avançado de IA possui uma impressionante janela de contexto de 128K, um salto significativo em relação ao seu antecessor, o GPT-3.5. Com este contexto alargado, o GPT-4 Turbo pode ler e processar informações equivalentes a um livro de 400 páginas numa única janela de contexto. Esta nova capacidade elimina um dos principais factores de diferenciação da Anthropic, a empresa irmã da OpenAI, uma vez que o GPT-4 Turbo oferece agora um tamanho de contexto comparável.

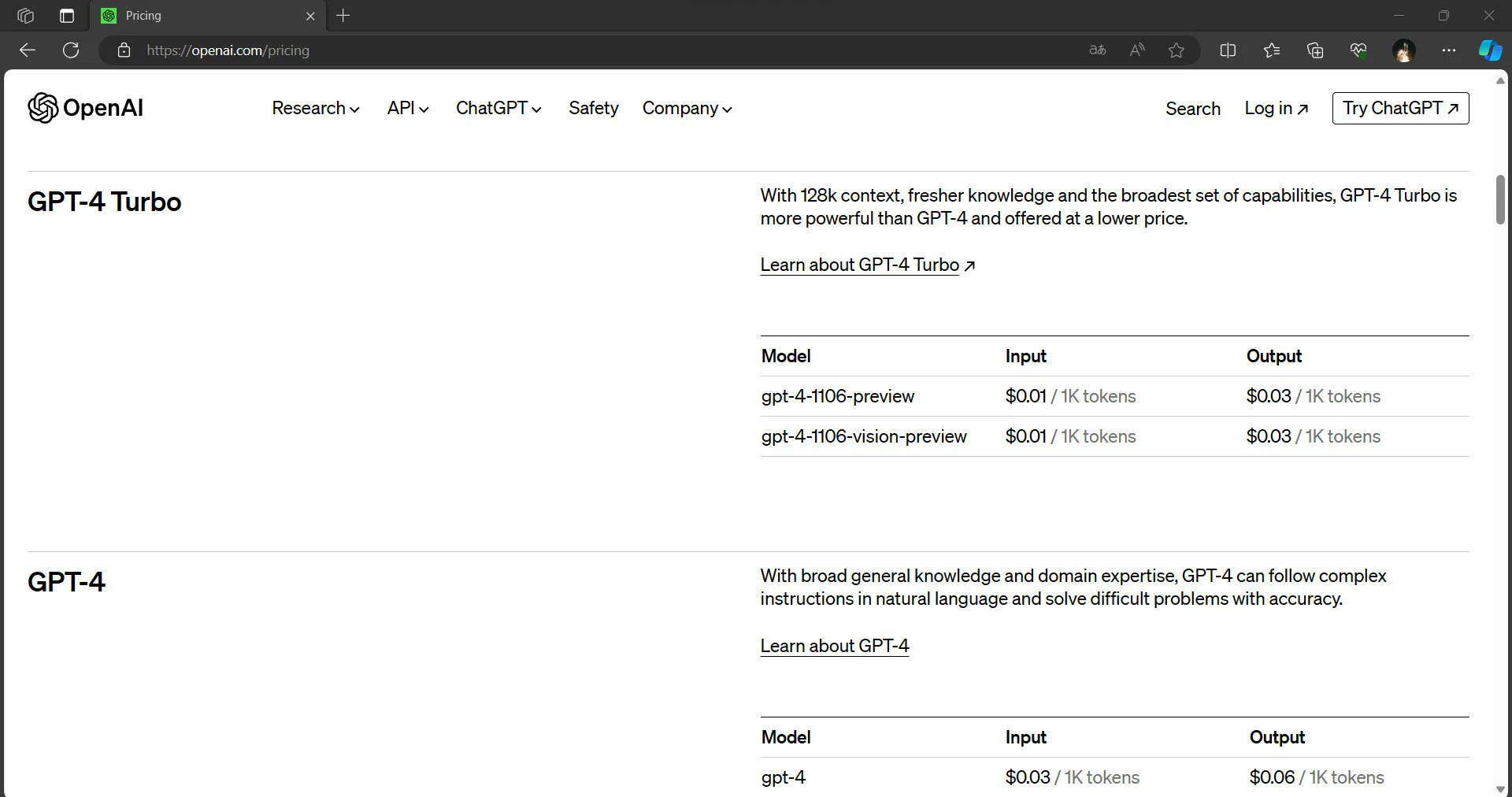

Mas as notícias não se ficam por aqui. O GPT-4 Turbo não só oferece uma janela de contexto maior, como também proporciona uma saída mais rápida e está disponível por uma fração dos preços de entrada e saída do GPT-4. Esta combinação de capacidades melhoradas e rentabilidade posiciona o GPT-4 Turbo como um fator de mudança no mundo da IA.

Reduções de preços em toda a linha

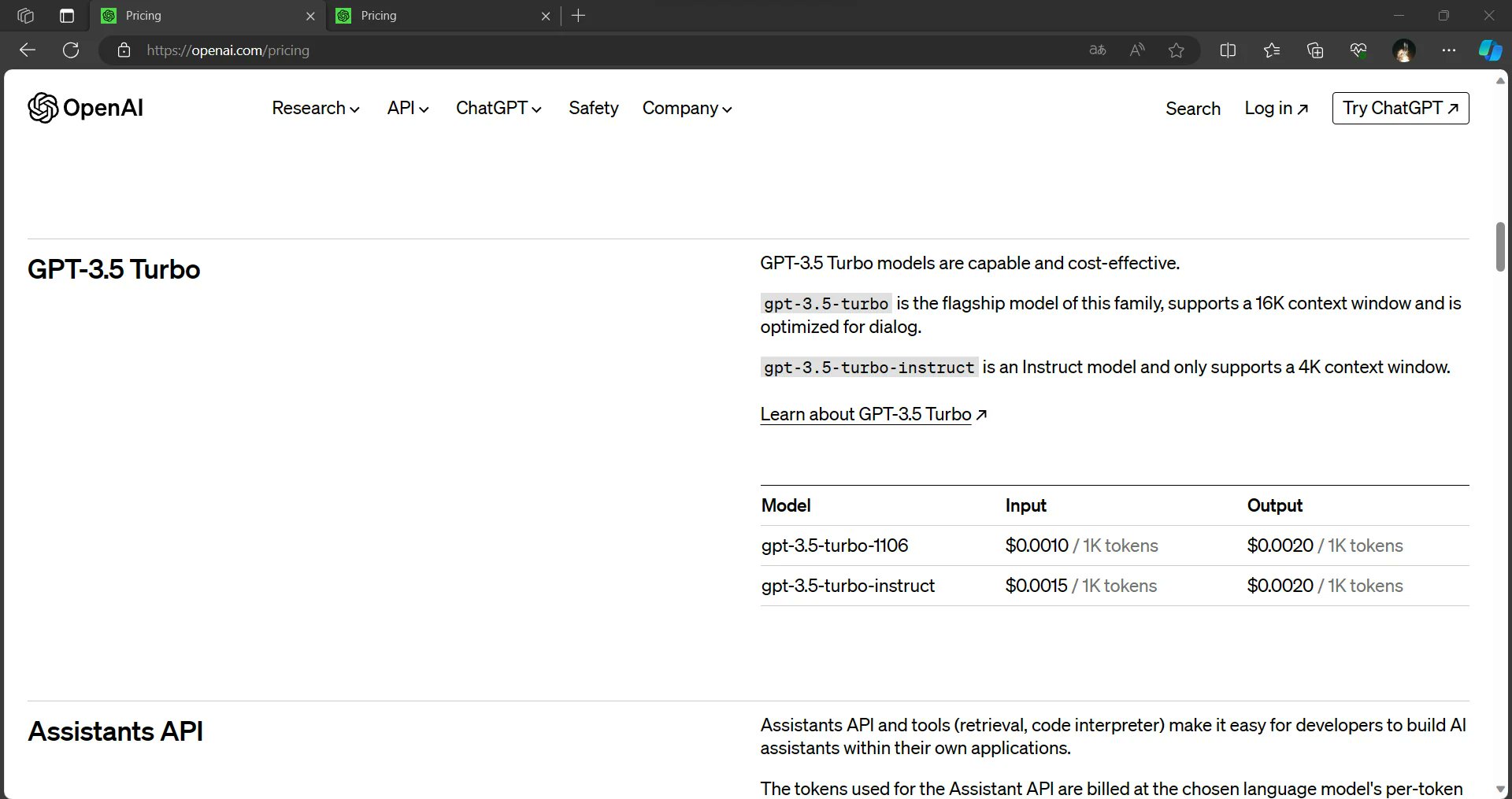

A OpenAI está a tornar a IA mais acessível e económica do que nunca. As informações divulgadas sugerem que o custo dos factores de produção da GPT-3.5 foi reduzido em 33%. Além disso, os modelos GPT-3.5 serão agora predefinidos para 16K, tornando-os mais económicos para os utilizadores. Estas alterações visam democratizar a utilização da IA, permitindo que um público mais vasto aproveite o poder destes modelos.

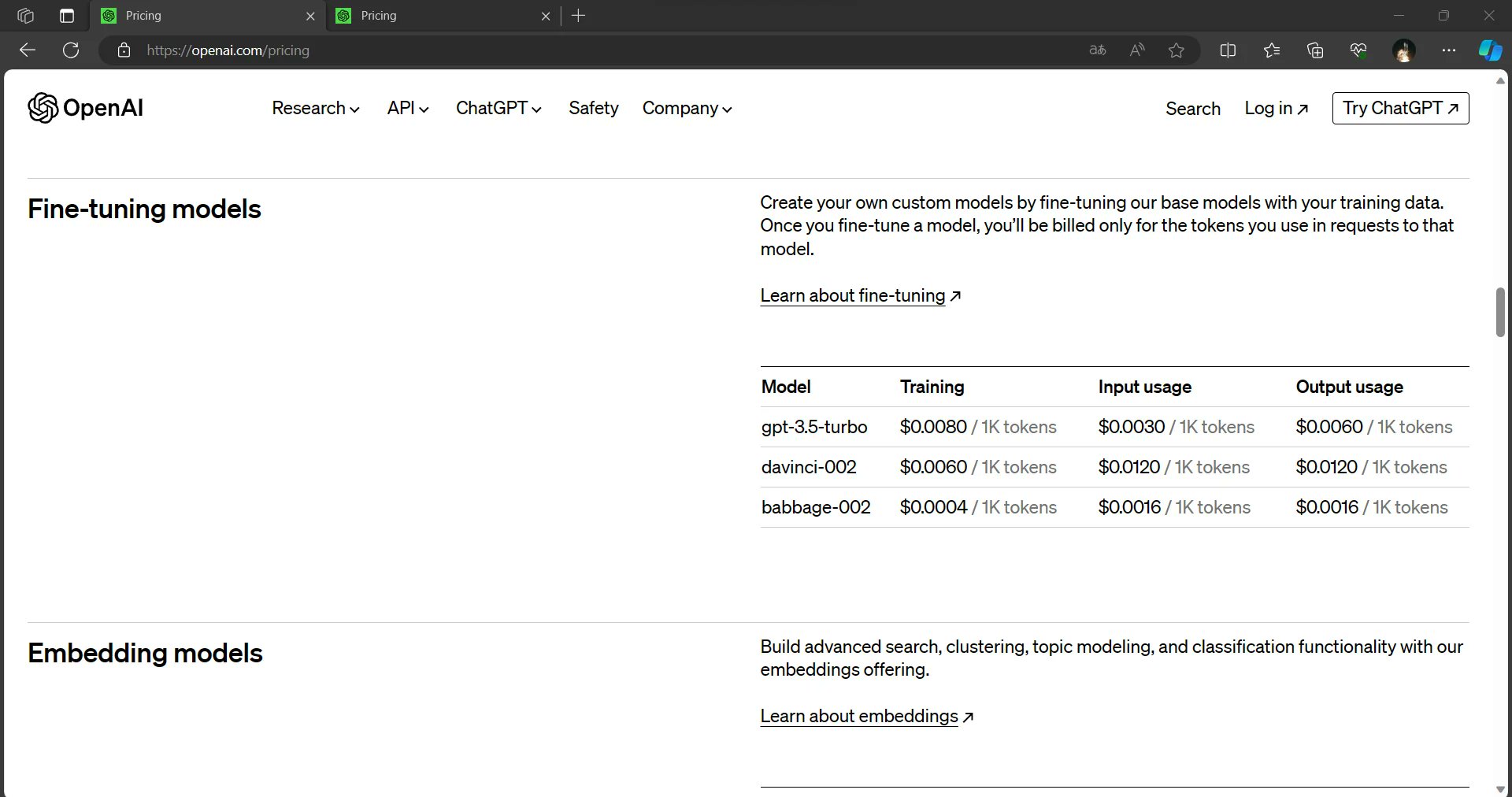

Os modelos aperfeiçoados, um recurso crucial para muitas aplicações de IA, também beneficiam de reduções substanciais de preços. Os custos de inferência para modelos ajustados são alegadamente reduzidos em 75% para a entrada e quase 60% para a saída. Estas reduções prometem permitir que os programadores e as organizações implementem soluções baseadas em IA de forma mais económica.

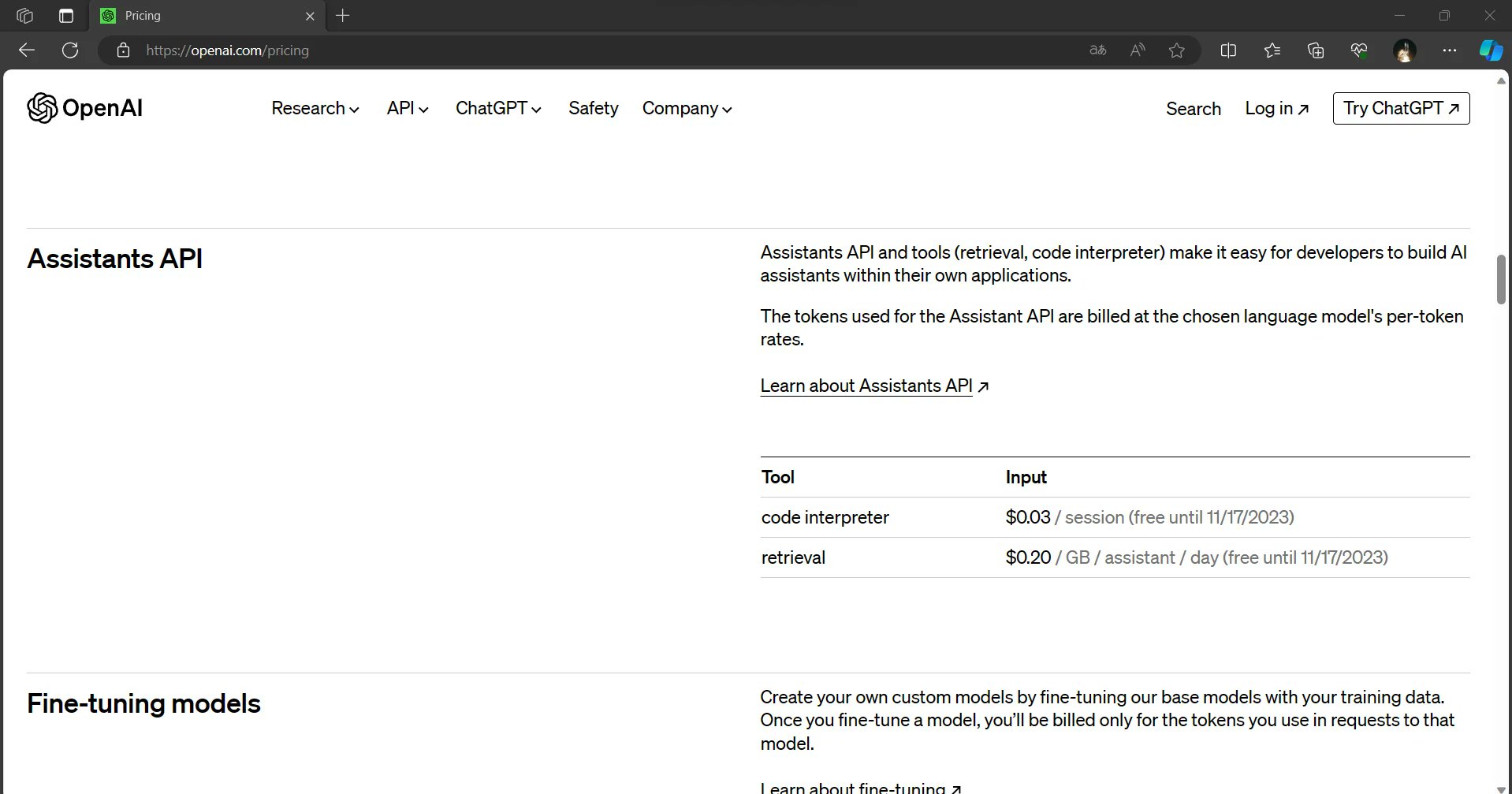

API de assistentes: Uma nova fronteira na IA

O DevDay da OpenAI também apresentou a futura API de assistentes, que deverá fornecer aos utilizadores um intérprete de código e capacidades de recuperação através de uma API. Espera-se que esta inovação simplifique a integração da IA em várias aplicações, permitindo que os programadores criem soluções ainda mais poderosas e dinâmicas.

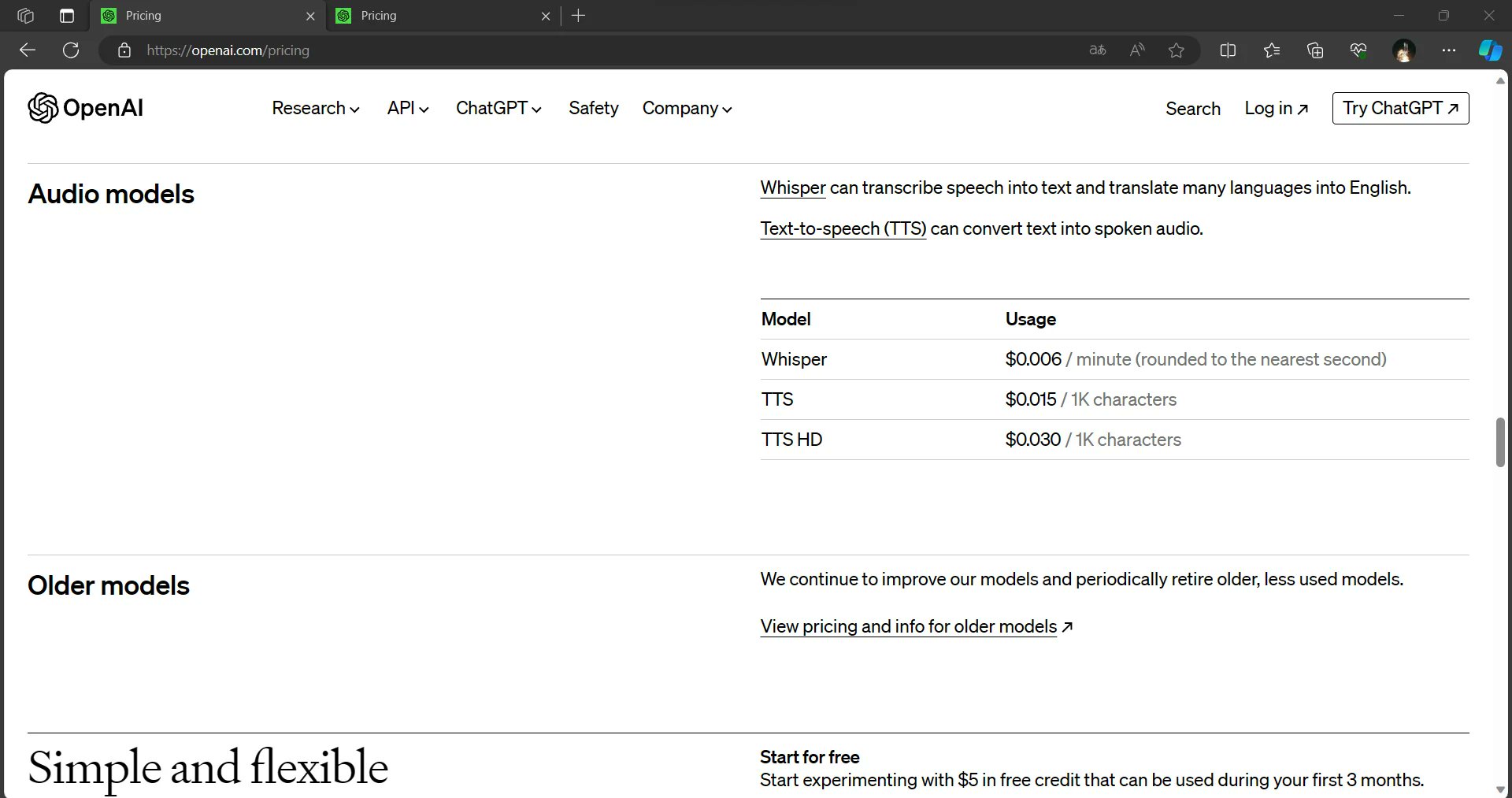

Dall-E 3 e Dall-E 3 HD: Expandir os horizontes criativos

O evento também revelou a introdução do Dall-E 3 e do Dall-E 3 HD. Embora estes modelos prometam alargar os limites da IA criativa, estão posicionados como opções mais caras em comparação com o Dall-E 2. No entanto, as capacidades melhoradas destes modelos podem justificar o custo mais elevado para os utilizadores que procuram uma IA de ponta para a geração e manipulação de imagens.

O poder do contexto de 128K

Simplificando, a janela de contexto do GPT-4 Turbo 128K permite-lhe processar e compreender uma quantidade surpreendente de informações numa única instância. Para o contexto, a geração anterior, GPT-3, tinha uma janela de contexto de 1024 tokens. Os símbolos podem representar palavras, caracteres ou mesmo sub-palavras, dependendo da língua e do texto. A janela de contexto do GPT-4 Turbo 128K é aproximadamente 125 vezes maior do que a do GPT-3, o que faz dele um verdadeiro gigante no mundo dos modelos de linguagem de IA.

Implicações práticas

A introdução do GPT-4 Turbo com a sua janela de contexto de 128K é um passo notável no domínio da IA. A sua capacidade de processar e compreender grandes quantidades de informação tem o potencial de revolucionar a forma como interagimos com os sistemas de IA, realizamos investigação, criamos conteúdos e muito mais. À medida que os programadores e investigadores exploram as possibilidades desta poderosa ferramenta, podemos esperar ver aplicações inovadoras que aproveitam todo o potencial das capacidades do GPT-4 Turbo, desbloqueando novos horizontes na inteligência artificial.

Compreensão global

Com um contexto de 128K, o GPT-4 Turbo pode ler e analisar documentos extensos, artigos ou conjuntos de dados na sua totalidade. Esta capacidade permite-lhe dar respostas mais completas e precisas a perguntas complexas, tarefas de investigação ou necessidades de análise de dados.

Continuidade contextual

Os modelos anteriores tinham frequentemente dificuldades em manter o contexto em documentos longos, o que levava a respostas desarticuladas ou irrelevantes. A janela GPT-4 Turbo 128K permite-lhe manter o contexto em passagens longas, resultando em interacções mais coerentes e contextualmente relevantes.

Reduzir a sobrecarga de informação

Numa era de sobrecarga de informação, a capacidade do GPT-4 Turbo para processar grandes quantidades de dados de uma só vez pode ser um fator de mudança. Pode analisar grandes conjuntos de dados, extrair informações importantes e fornecer resumos sucintos, poupando aos utilizadores tempo e esforço valiosos.

Investigação e redação avançadas

Os investigadores, escritores e criadores de conteúdos podem beneficiar significativamente do contexto de 128K do GPT-4 Turbo. Pode ajudar a gerar trabalhos de investigação, artigos e relatórios aprofundados com um conhecimento profundo do assunto.

Tradução linguística melhorada

As tarefas de tradução de línguas também podem beneficiar de um contexto mais alargado. O GPT-4 Turbo consegue compreender melhor as nuances das línguas, as expressões idiomáticas e o contexto cultural, o que leva a traduções mais exactas.

Desafios e considerações

Embora o contexto GPT-4 Turbo 128K seja, sem dúvida, um fator de mudança, também apresenta desafios. O tratamento de modelos tão grandes exige recursos computacionais significativos, o que pode limitar a acessibilidade de alguns utilizadores. Além disso, as considerações éticas em torno da privacidade dos dados e da geração de conteúdos têm de ser abordadas à medida que os modelos de IA se tornam mais poderosos.

Mais a caminho do GPT-4?

O evento DevDay da OpenAI apresentou uma grande quantidade de actualizações interessantes e fugas de informação sobre preços que irão moldar o panorama da IA. A impressionante janela de contexto de 128K do GPT-4 Turbo, a produção mais rápida e o preço reduzido fazem dele uma oferta de destaque. As reduções globais de preços para os modelos de entrada, de saída e aperfeiçoados deverão democratizar a utilização da IA, tornando-a mais acessível a um público mais vasto. Os futuros modelos Assistants API e Dall-E 3 realçam ainda mais o compromisso da OpenAI com a inovação e o avanço no domínio da inteligência artificial.

À medida que estes desenvolvimentos se desenrolam, é evidente que a OpenAI está determinada a capacitar os programadores, as empresas e as mentes criativas com ferramentas e serviços de IA de última geração. O futuro da IA está a parecer mais brilhante e mais acessível do que nunca.

Leia mais: ChatGPT Enterprise da OpenAI: Custo, benefícios e segurança