W 2025 r. świat sztucznej inteligencji stał się bardzo ekscytujący, a duże firmy technologiczne zaciekle rywalizują o stworzenie najbardziej zaawansowanych systemów sztucznej inteligencji w historii. Ta intensywna konkurencja wywołała wiele nowych pomysłów, przesuwając granice tego, co sztuczna inteligencja może zrobić w myśleniu, rozwiązywaniu problemów i interakcji z ludźmi. W ciągu ostatniego miesiąca dokonano niesamowitych ulepszeń, w których prym wiodą dwaj główni gracze: Google Gemini 2.5 Pro i OpenAI GPT-4.5. W wielkim ujawnieniu w marcu 2025 r. Google zaprezentowało Gemini 2.5 Pro, które nazwali swoim najmądrzejszym jak dotąd dziełem. Szybko stał się on liderem w rankingu LMArena, wyprzedzając swoich konkurentów. Tym, co wyróżnia Gemini 2.5, jest jego zdolność do dokładnego rozważania odpowiedzi, co pomaga mu lepiej wykonywać złożone zadania wymagające głębokiego myślenia.

Nie chcąc pozostać w tyle, OpenAI uruchomiło GPT-4.5, ich największy i najbardziej zaawansowany model czatu do tej pory. Model ten jest świetny w rozpoznawaniu wzorców, nawiązywaniu połączeń i wymyślaniu kreatywnych pomysłów. Wczesne testy pokazują, że interakcja z GPT-4.5 jest bardzo naturalna, dzięki szerokiemu zakresowi wiedzy i lepszemu zrozumieniu tego, co użytkownicy mają na myśli. OpenAI podkreśla znaczną poprawę GPT-4.5 w uczeniu się bez bezpośredniego nadzoru, zaprojektowaną z myślą o płynnej współpracy z ludźmi.

Te systemy AI to nie tylko imponująca technologia; zmieniają one sposób działania firm, przyspieszają odkrycia naukowe i przekształcają kreatywne projekty. W miarę jak sztuczna inteligencja staje się normalną częścią codziennego życia, modele takie jak Gemini 2.5 Pro i GPT-4.5 rozszerzają to, co uważamy za możliwe. Dzięki lepszym umiejętnościom rozumowania, mniejszemu prawdopodobieństwu rozpowszechniania fałszywych informacji i opanowaniu złożonych problemów, torują one drogę dla systemów sztucznej inteligencji, które naprawdę wspierają ludzki postęp.

Zrozumienie Gemini 2.5 Pro

25 marca 2025 r. Google oficjalnie zaprezentowało Gemini 2.5 Pro, opisany jako “najbardziej inteligentny model sztucznej inteligencji” do tej pory. Wydanie to stanowiło kamień milowy w rozwoju sztucznej inteligencji Google, po kilku iteracjach modeli 2.0. Strategia wydania rozpoczęła się od wersji eksperymentalnej, dając subskrybentom Gemini Advanced wczesny dostęp do testowania jego możliwości.

Tym, co odróżnia Gemini 2.5 Pro od jego poprzedników, jest jego fundamentalna architektura jako“myślącego modelu”. W przeciwieństwie do poprzednich generacji, które opierały się głównie na wyszkolonych wzorcach danych, ten model może aktywnie rozumować poprzez swoje myśli przed udzieleniem odpowiedzi, naśladując ludzkie procesy rozwiązywania problemów. Stanowi to znaczący postęp w sposobie, w jaki systemy sztucznej inteligencji przetwarzają informacje i generują odpowiedzi.

Kluczowe funkcje i możliwości:

- Zwiększone zdolności rozumowania – Zdolność do rozwiązywania problemów krok po kroku w złożonych dziedzinach.

- Rozszerzone okno kontekstowe – pojemność 1 miliona tokenów (z planami rozszerzenia do 2 milionów)

- Natywna multimodalność – płynnie przetwarza tekst, obrazy, audio, wideo i kod.

- Zaawansowane możliwości kodu – Znaczące ulepszenia w tworzeniu aplikacji internetowych i transformacji kodu

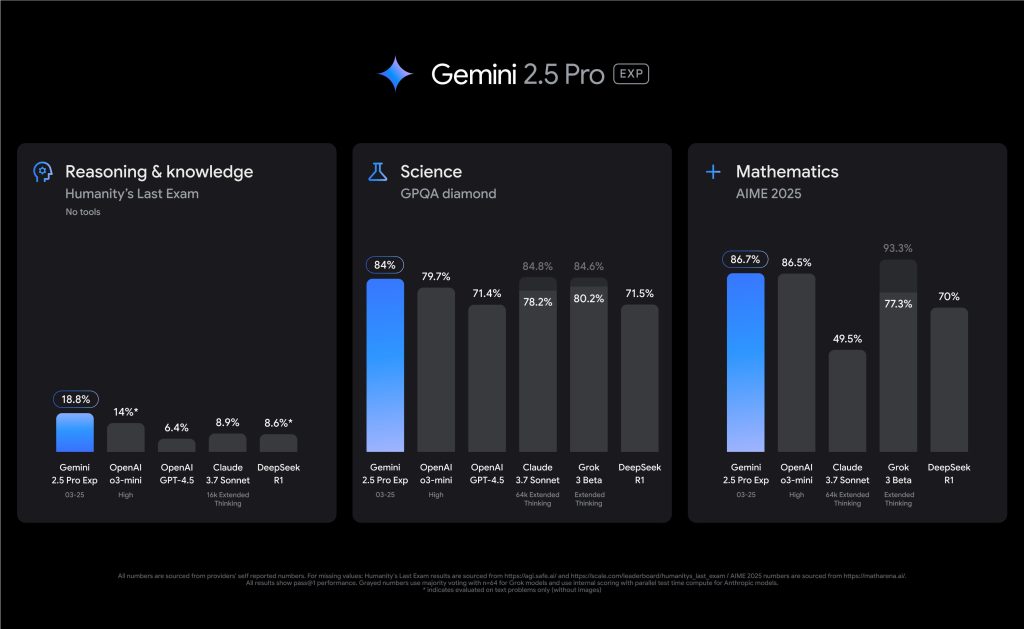

Gemini 2.5 Pro ugruntował swoją pozycję lidera wydajności, debiutując na pozycji nr 1 w rankingu LMArena. Szczególnie wyróżnia się w testach porównawczych wymagających zaawansowanego rozumowania, uzyskując wiodący w branży wynik 18,8% w ostatnim egzaminie ludzkości bez korzystania z narzędzi zewnętrznych. W matematyce i naukach ścisłych wykazuje niezwykłe kompetencje z wynikami odpowiednio 86,7% w AIME 2025 i 79,7% w GPQA diamond.

W porównaniu do poprzednich modeli Gemini, wersja 2.5 Pro stanowi znaczący krok naprzód. Podczas gdy Gemini 2.0 wprowadził ważne podstawowe możliwości, 2.5 Pro łączy znacznie ulepszony model bazowy z ulepszonymi technikami po treningu. Najbardziej zauważalne ulepszenia dotyczą wydajności kodowania, głębokości rozumowania i zrozumienia kontekstowego – obszarów, w których wcześniejsze wersje wykazywały ograniczenia.

Eksploracja GPT-4.5

W kwietniu 2025 r. OpenAI wprowadziło GPT-4.5, opisując go jako “największy i najbardziej zaawansowany model czatu do tej pory”, co oznacza godne uwagi osiągnięcie w ewolucji dużych modeli językowych. Ta zapowiedź badawcza wywołała natychmiastowe podekscytowanie w społeczności AI, a wstępne testy wykazały, że interakcje z modelem są wyjątkowo naturalne, dzięki obszernej bazie wiedzy i zwiększonej zdolności rozumienia intencji użytkownika.

GPT-4.5 prezentuje znaczący postęp w zakresie możliwości uczenia się bez nadzoru. OpenAI osiągnęła ten postęp poprzez skalowanie zarówno mocy obliczeniowej, jak i danych wejściowych, a także stosowanie innowacyjnych strategii architektonicznych i optymalizacyjnych. Model został przeszkolony na superkomputerach Microsoft Azure AI, kontynuując partnerstwo, które umożliwiło OpenAI przekraczanie granic możliwości.

Podstawowe ulepszenia i możliwości:

- Ulepszone rozpoznawanie wzorców – Znacznie poprawiona zdolność rozpoznawania wzorców, rysowania połączeń i generowania kreatywnych spostrzeżeń.

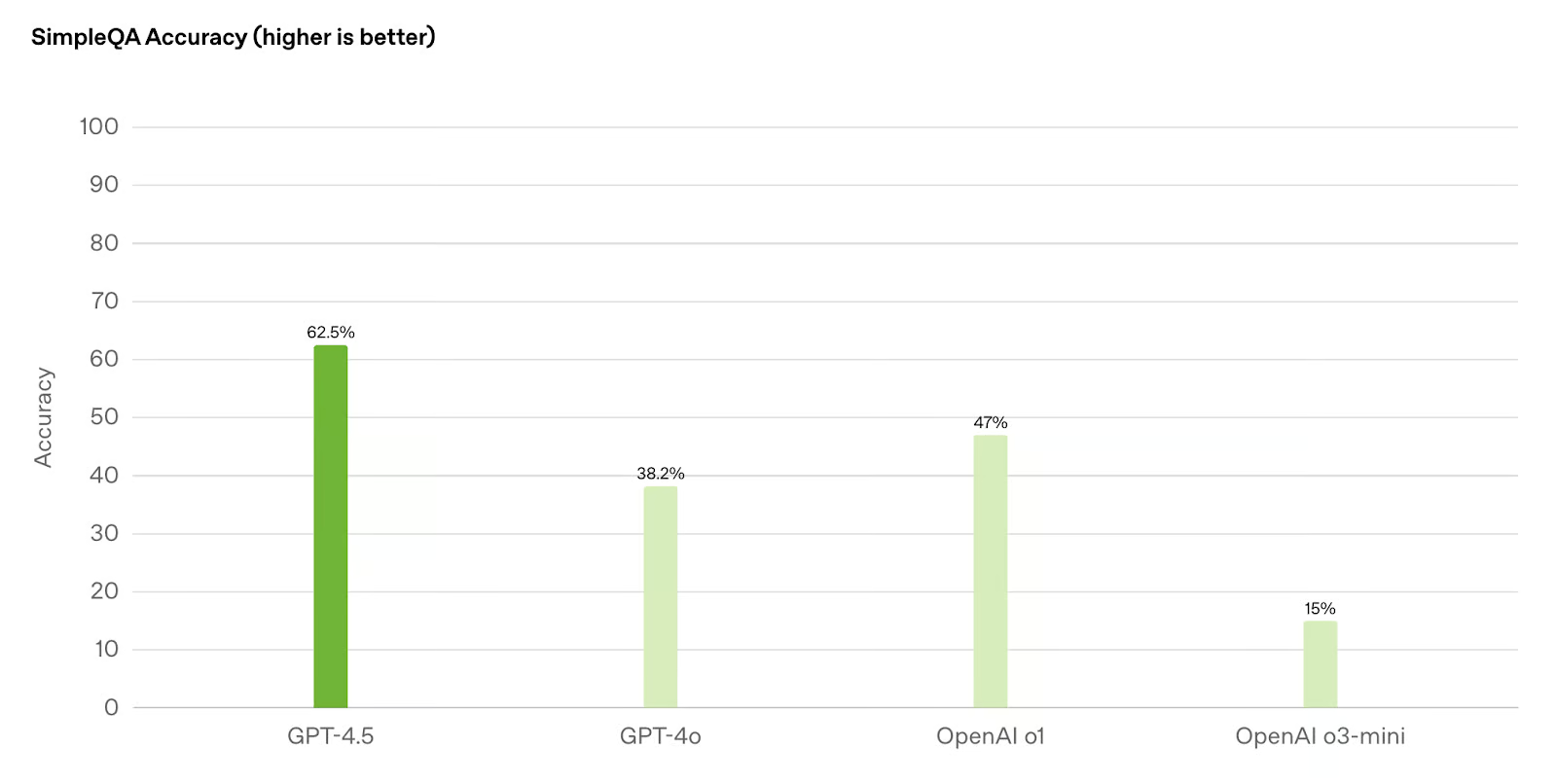

- Mniej halucynacji – mniejsze prawdopodobieństwo generowania fałszywych informacji w porównaniu z poprzednimi modelami, takimi jak GPT-4o i o1.

- Poprawione “EQ” – Większa inteligencja emocjonalna i zrozumienie niuansów interakcji międzyludzkich.

- Zaawansowana sterowność – lepsze zrozumienie i przestrzeganie złożonych instrukcji użytkownika

OpenAI położyło szczególny nacisk na szkolenie GPT-4.5 do współpracy z ludźmi. Nowe techniki zwiększają sterowność modelu, zrozumienie niuansów i naturalny przepływ konwersacji. Sprawia to, że jest on szczególnie skuteczny w pisaniu i pomocy przy projektowaniu, gdzie wykazuje silniejszą intuicję estetyczną i kreatywność niż poprzednie iteracje.

W rzeczywistych zastosowaniach GPT-4.5 wykazuje niezwykłą wszechstronność. Jego rozszerzona baza wiedzy i ulepszone możliwości rozumowania sprawiają, że nadaje się do szerokiego zakresu zadań, od szczegółowego tworzenia treści po zaawansowane rozwiązywanie problemów. CEO OpenAI, Sam Altman, opisał model w pozytywnych słowach, podkreślając jego “wyjątkową skuteczność”, mimo że nie jest on liderem we wszystkich kategoriach testów porównawczych.

Strategia wdrażania GPT-4.5 odzwierciedla wyważone podejście OpenAI do wydawania potężnych systemów sztucznej inteligencji. Początkowo dostępny dla subskrybentów ChatGPT Pro i programistów na płatnych poziomach za pośrednictwem różnych interfejsów API, firma planuje stopniowo rozszerzać dostęp do subskrybentów ChatGPT Plus, Team, Edu i Enterprise. To stopniowe wdrażanie pozwala OpenAI monitorować wydajność i bezpieczeństwo w miarę wzrostu wykorzystania.

Wskaźniki wydajności: Analiza porównawcza

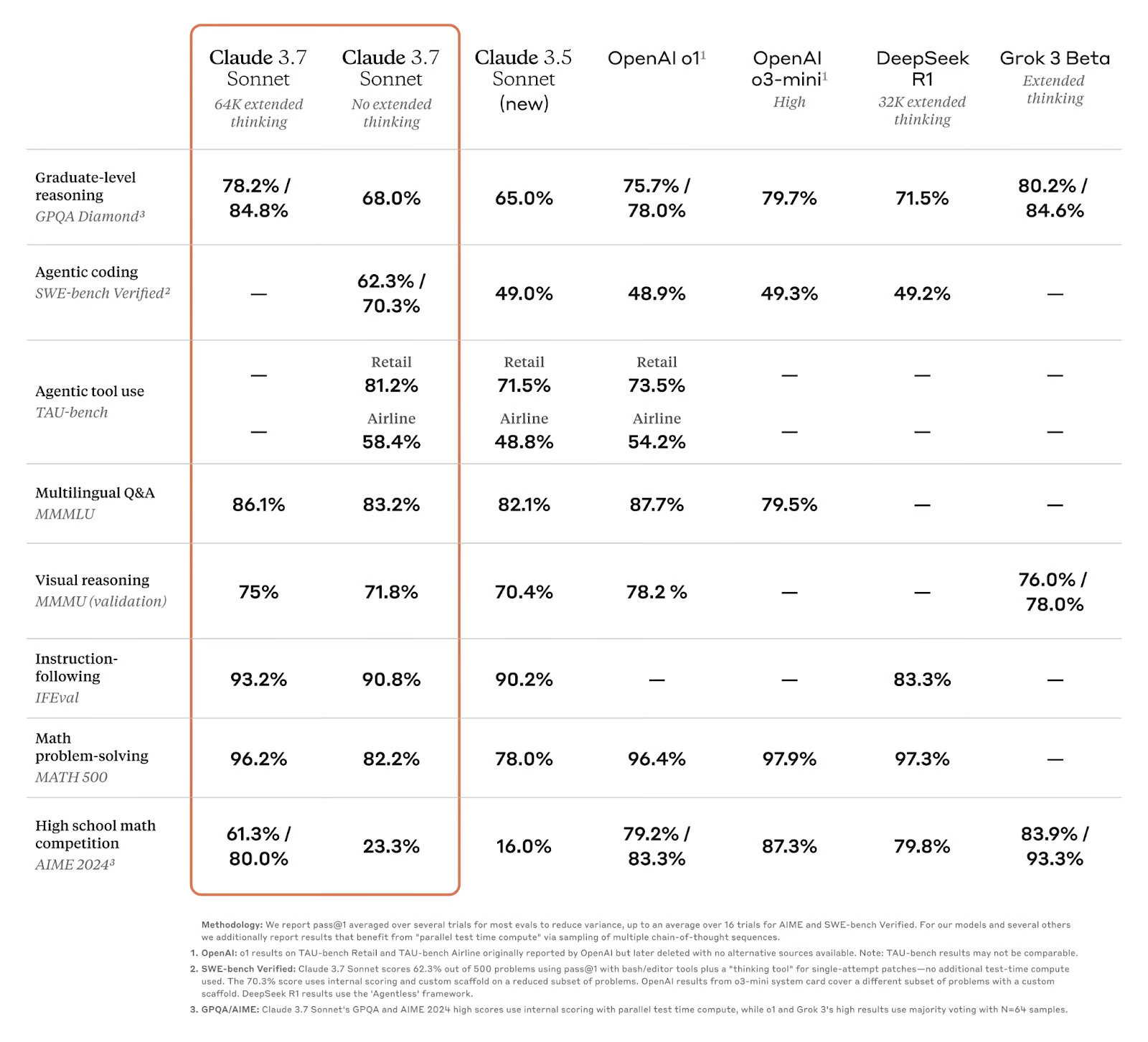

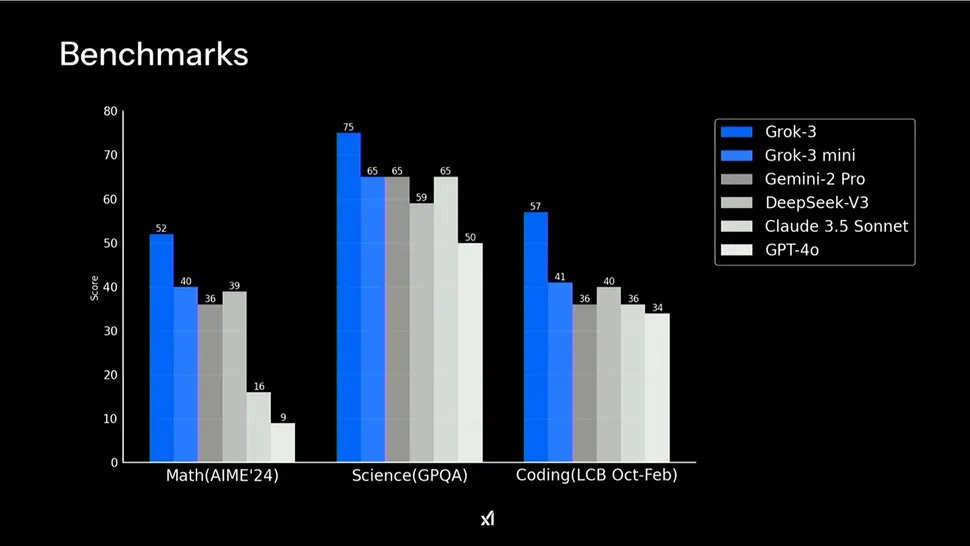

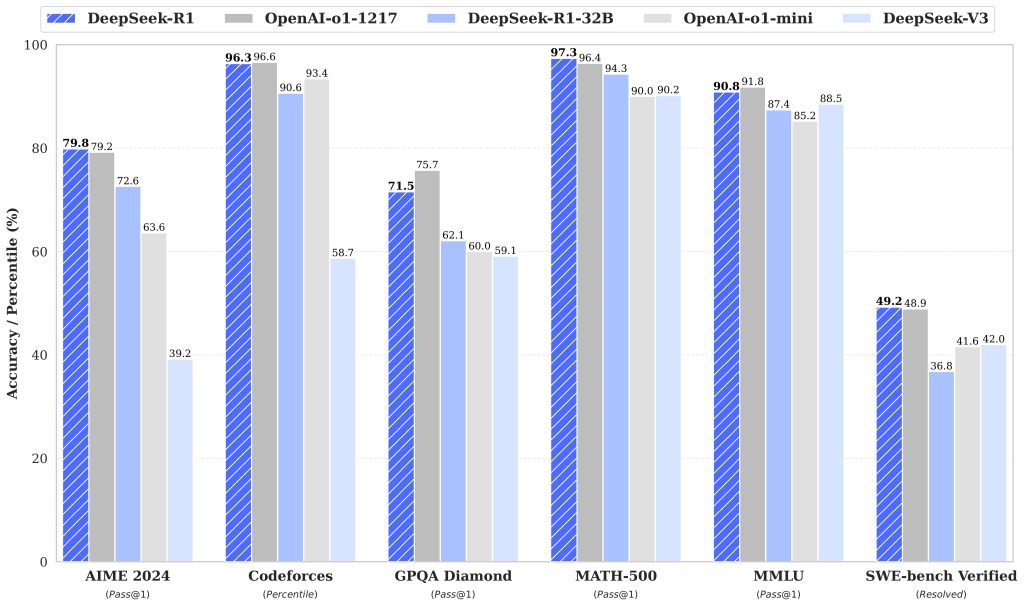

Podczas badania możliwości technicznych tych zaawansowanych modeli sztucznej inteligencji, wyniki testów porównawczych zapewniają najbardziej obiektywną miarę ich możliwości. Gemini 2.5 Pro i GPT-4.5 wykazują unikalne mocne strony w różnych dziedzinach, a testy porównawcze ujawniają ich wyraźne zalety.

| Benchmark | Gemini 2.5 Pro (03-25) | OpenAI GPT-4.5 | Claude 3.7 Sonnet | Grok 3 Preview |

|---|---|---|---|---|

| LMArena (Overall) | #1 | 2 | 21 | 2 |

| Ostatni egzamin ludzkości (bez narzędzi) | 18.8% | 6.4% | 8.9% | – |

| GPQA Diamond (pojedyncza próba) | 84.0% | 71.4% | 78.2% | 80.2% |

| AIME 2025 (pojedyncza próba) | 86.7% | – | 49.5% | 77.3% |

| SWE-Bench Zweryfikowano | 63.8% | 38.0% | 70.3% | – |

| Aider Polyglot (Whole/Diff) | 74.0% / 68.6% | 44,9% diff | 64,9% diff | – |

| MRCR (128k) | 91.5% | 48.8% | – | – |

Gemini 2.5 Pro wykazuje wyjątkową siłę w zadaniach wymagających intensywnego rozumowania, szczególnie wyróżniając się w rozumowaniu w długim kontekście i retencji wiedzy. Znacznie przewyższa konkurentów w ostatnim egzaminie ludzkości, który testuje granicę ludzkiej wiedzy. Wykazuje jednak względne słabości w generowaniu kodu, kodowaniu agentowym i czasami zmaga się z faktami w niektórych domenach.

Z kolei GPT-4.5 wykazuje szczególną doskonałość w rozpoznawaniu wzorców, kreatywnym generowaniu spostrzeżeń i rozumowaniu naukowym. Osiąga lepsze wyniki w benchmarku GPQA diamond, wykazując duże możliwości w dziedzinach naukowych. Model wykazuje również zwiększoną inteligencję emocjonalną i intuicję estetyczną, co czyni go szczególnie cennym dla aplikacji kreatywnych i zorientowanych na projektowanie. Kluczową zaletą jest zmniejszona tendencja do generowania fałszywych informacji w porównaniu do swoich poprzedników.

W praktyce Gemini 2.5 Pro stanowi najlepszy wybór do zadań wymagających głębokiego rozumowania, rozumienia multimodalnego i obsługi bardzo długich kontekstów. GPT-4.5 oferuje korzyści w kreatywnej pracy, pomocy przy projektowaniu i aplikacjach, w których precyzja faktów i naturalny przepływ konwersacji są najważniejsze.

Aplikacje i przypadki użycia

Podczas gdy wyniki benchmarków dostarczają cennych informacji technicznych, prawdziwą miarą tych zaawansowanych modeli sztucznej inteligencji są ich praktyczne zastosowania w różnych dziedzinach. Zarówno Gemini 2.5 Pro, jak i GPT-4.5 wykazują wyraźne mocne strony, które sprawiają, że nadają się do różnych zastosowań, a organizacje już zaczynają wykorzystywać ich możliwości do rozwiązywania złożonych problemów.

Gemini 2.5 Pro w dziedzinach naukowych i technicznych

Wyjątkowe możliwości wnioskowania Gemini 2.5 Pro i rozbudowane okno kontekstowe sprawiają, że jest on szczególnie cenny w badaniach naukowych i zastosowaniach technicznych. Jego zdolność do przetwarzania i analizowania danych multimodalnych – w tym tekstu, obrazów, audio, wideo i kodu – pozwala mu radzić sobie ze złożonymi problemami, które wymagają syntezy informacji z różnych źródeł. Ta wszechstronność otwiera wiele możliwości w branżach wymagających technicznej precyzji i kompleksowej analizy.

- Badania naukowe i analiza danych – dobre wyniki Gemini 2.5 Pro w testach porównawczych, takich jak GPQA (79,7%), pokazują jego potencjał w zakresie wspierania badaczy w analizowaniu złożonej literatury naukowej, generowaniu hipotez i interpretowaniu wyników eksperymentów.

- Rozwój i inżynieria oprogramowania – model wyróżnia się w tworzeniu aplikacji internetowych, wykonywaniu transformacji kodu i opracowywaniu złożonych programów z wynikiem 63,8% w SWE-Bench Verified przy użyciu niestandardowych konfiguracji agentów.

- Diagnostyka medyczna i opieka zdrowotna – jego możliwości rozumowania umożliwiają analizę obrazów medycznych wraz z danymi pacjenta w celu wsparcia pracowników służby zdrowia w procesach diagnostycznych.

- Analityka dużych zbiorów danych i zarządzanie wiedzą – okno kontekstowe z 1 milionem tokenów (wkrótce zostanie rozszerzone do 2 milionów) umożliwia przetwarzanie całych zbiorów danych i repozytoriów kodu za pomocą jednego monitu.

Doskonałość GPT-4.5 w zadaniach kreatywnych i komunikacyjnych

Z kolei GPT-4.5 wykazuje szczególną siłę w zadaniach wymagających zniuansowanej komunikacji, kreatywnego myślenia i oceny estetycznej. OpenAI położyło nacisk na szkolenie tego modelu specjalnie pod kątem współpracy międzyludzkiej, co zaowocowało zwiększonymi możliwościami tworzenia treści, pomocy w projektowaniu i naturalnej komunikacji.

- Tworzenie treści i pisanie – GPT-4.5 wykazuje zwiększoną intuicję estetyczną i kreatywność, dzięki czemu jest cenny przy generowaniu kopii marketingowych, artykułów, skryptów i innych treści pisemnych.

- Współpraca przy projektowaniu – Lepsze zrozumienie niuansów i kontekstu przez model sprawia, że jest on skutecznym partnerem w procesach projektowania, od konceptualizacji po dopracowanie.

- Zaangażowanie klienta – dzięki większej inteligencji emocjonalnej, GPT-4.5 zapewnia bardziej odpowiednie i naturalne reakcje w kontekście obsługi klienta.

- Rozwój treści edukacyjnych – model ten doskonale sprawdza się w dostosowywaniu wyjaśnień do różnych poziomów wiedzy i stylów uczenia się.

Firmy z różnych sektorów już integrują te modele w swoich przepływach pracy. Microsoft włączył technologię OpenAI bezpośrednio do swojego pakietu produktów, zapewniając użytkownikom korporacyjnym natychmiastowy dostęp do możliwości GPT-4.5. Podobnie Gemini 2.5 Pro firmy Google znajduje zastosowanie w instytucjach badawczych i firmach technologicznych, które chcą wykorzystać jego możliwości rozumowania i multimodalności.

Uzupełniające się mocne strony tych modeli sugerują, że wiele organizacji może odnieść korzyści z wykorzystania obu, w zależności od konkretnych przypadków użycia. W miarę dojrzewania tych technologii możemy spodziewać się coraz bardziej wyrafinowanych aplikacji, które zasadniczo przekształcą pracę opartą na wiedzy, procesy twórcze i rozwiązywanie problemów w różnych branżach.

Przyszłość sztucznej inteligencji: co dalej?

W miarę jak Gemini 2.5 Pro i GPT-4.5 przesuwają granice tego, co możliwe, przyszła trajektoria rozwoju sztucznej inteligencji staje się coraz wyraźniejsza. Zaangażowanie Google w “budowanie możliwości myślenia bezpośrednio we wszystkich modelach” sugeruje przyszłość, w której rozumowanie stanie się standardem w systemach sztucznej inteligencji. Podobnie podejście OpenAI polegające na “skalowaniu nienadzorowanego uczenia się i rozumowania” wskazuje na modele o coraz większych możliwościach rozumienia i generowania treści podobnych do ludzkich.

W nadchodzących latach prawdopodobnie pojawią się modele sztucznej inteligencji z radykalnie rozszerzonymi oknami kontekstowymi wykraczającymi poza obecne ograniczenia, bardziej wyrafinowanym rozumowaniem i płynną integracją we wszystkich modalnościach. Możemy być również świadkami powstania prawdziwie autonomicznych agentów AI zdolnych do wykonywania złożonych zadań przy minimalnym nadzorze ze strony człowieka. Postępy te niosą jednak ze sobą poważne wyzwania. Wraz ze wzrostem możliwości sztucznej inteligencji, rośnie również znaczenie radzenia sobie z potencjalnymi zagrożeniami związanymi z dezinformacją, prywatnością i wypieraniem ludzkiej pracy.

Kwestie etyczne muszą pozostać na pierwszym planie rozwoju sztucznej inteligencji. OpenAI przyznaje, że “każdy wzrost możliwości modeli jest okazją do uczynienia ich bezpieczniejszymi”, podkreślając podwójną odpowiedzialność za postęp i ochronę. Społeczność AI będzie musiała opracować solidne ramy zarządzania, które będą zachęcać do innowacji, jednocześnie chroniąc przed niewłaściwym wykorzystaniem.

Rewolucja AI reprezentowana przez Gemini 2.5 Pro i GPT-4.5 dopiero się rozpoczyna. Podczas gdy tempo postępu przynosi zarówno podekscytowanie, jak i obawy, jedna rzecz pozostaje jasna: przyszłość sztucznej inteligencji będzie definiowana nie tylko przez możliwości technologiczne, ale także przez to, jak zdecydujemy się je wykorzystać z korzyścią dla ludzi. Nadając priorytet odpowiedzialnemu rozwojowi, który zwiększa ludzki potencjał, a nie go zastępuje, możemy zapewnić, że następna generacja modeli sztucznej inteligencji będzie służyć jako potężne narzędzia dla wspólnego postępu.