RAG-as-a-Service : Débloquez l’IA générative pour votre entreprise

Avec l’essor des grands modèles de langage (LLM) et les tendances de l’IA générative, l’intégration de solutions d’IA générative dans votre entreprise peut renforcer l’efficacité du flux de travail. Si vous êtes novice en matière d’IA générative, la pléthore de jargon peut vous intimider. Ce blog démystifiera les terminologies de base de l’IA générative et vous guidera sur la façon de démarrer une solution d’IA personnalisée pour votre entreprise avec RAG-as-a-Service.

Qu’est-ce que la Génération Augmentée de Récupération (GAR) ?

La génération augmentée par récupération (RAG) est un concept clé dans la mise en œuvre des LLM ou de l’IA générative dans les flux de travail des entreprises. RAG s’appuie sur des modèles Transformer pré-entraînés pour répondre à des requêtes liées à l’entreprise en injectant des données pertinentes de votre base de connaissances spécifique dans le processus de requête. Ces données, sur lesquelles les LLM n’ont peut-être pas été formés, sont utilisées pour générer des réponses précises et pertinentes.

RAG est à la fois rentable et efficace, ce qui rend l’IA générative plus accessible. Examinons quelques terminologies clés liées aux RAG.

Terminologie clé du RAG

Chunking

Les LLM sont gourmands en ressources et sont formés sur des longueurs de données gérables connues sous le nom de “fenêtre contextuelle”. La fenêtre contextuelle varie en fonction du LLM utilisé. Pour pallier ses limites, les données commerciales fournies sous forme de documents ou de littérature textuelle sont segmentées en plus petits morceaux. Ces morceaux sont utilisés au cours du processus de recherche.

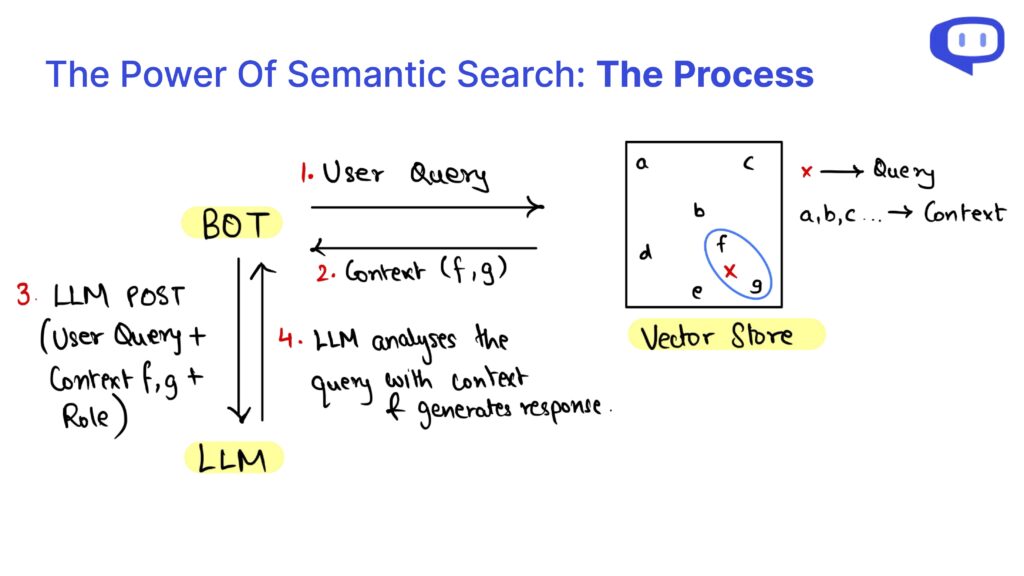

Comme les morceaux ne sont pas structurés et que les requêtes peuvent différer syntaxiquement des données de la base de connaissances, les morceaux sont récupérés à l’aide d’une recherche sémantique.

Bases de données vectorielles

Les bases de données vectorielles telles que Pinecone, Chromadb et FAISS stockent l’intégration des données commerciales. Les embeddings convertissent les données textuelles en forme numérique sur la base de leur signification et sont stockés dans un espace vectoriel à haute dimension où les données sémantiquement similaires sont plus proches les unes des autres.

Lorsqu’une requête est formulée par un utilisateur, les liens de la requête sont utilisés pour trouver des morceaux sémantiquement similaires dans la base de données vectorielle.

RAG-as-a-Service

La mise en œuvre du système RAG dans votre entreprise peut s’avérer décourageante si vous ne disposez pas de l’expertise technique nécessaire. C’est là que RAG-as-a-Service (RaaS) entre en jeu.

Chez meetcody.ai, nous proposons une solution prête à l’emploi pour répondre aux besoins de votre entreprise. Il vous suffit de créer un compte et de commencer à travailler gratuitement. Nous nous occupons du regroupement, des bases de données vectorielles et de l’ensemble du processus RAG, ce qui vous garantit une totale tranquillité d’esprit.

FAQ

1. Qu’est-ce que RAG-as-a-Service (RaaS) ?

RAG-as-a-Service (RaaS) est une solution complète qui gère l’ensemble du processus de Génération Augmentée de Récupération pour votre entreprise. Il s’agit notamment de regrouper les données, de les stocker dans des bases de données vectorielles et de gérer la recherche sémantique afin d’extraire les données pertinentes pour les requêtes.

2. Comment le découpage en morceaux contribue-t-il au processus RAG ?

Le découpage segmente les documents commerciaux volumineux en éléments plus petits et plus faciles à gérer, qui s’intègrent dans la fenêtre contextuelle du LLM. Cette segmentation permet au LLM de traiter et d’extraire des informations pertinentes de manière plus efficace grâce à la recherche sémantique.

3. Que sont les bases de données vectorielles et pourquoi sont-elles importantes ?

Les bases de données vectorielles stockent les représentations numériques (embeddings) de vos données commerciales. Ces enchâssements permettent d’extraire efficacement des données sémantiquement similaires lors d’une requête, ce qui garantit des réponses précises et pertinentes de la part du mécanisme d’apprentissage tout au long de la vie.

Intégrez RAG dans votre entreprise avec facilité et efficacité en tirant parti de la puissance de RAG-as-a-Service. Commencez dès aujourd’hui avec meetcody.ai et transformez votre flux de travail grâce à des solutions d’IA générative avancées.