En 2025, le monde de l’intelligence artificielle est devenu très excitant, les grandes entreprises technologiques se livrant une concurrence féroce pour créer les systèmes d’IA les plus avancés qui soient. Cette compétition intense a suscité de nombreuses idées nouvelles, repoussant les limites de ce que l’IA peut faire en matière de réflexion, de résolution de problèmes et d’interaction avec les humains. Au cours du mois dernier, des améliorations étonnantes ont été réalisées, avec deux acteurs principaux en tête : Gemini 2.5 Pro de Google et GPT-4.5 d’OpenAI. Lors d’une grande révélation en mars 2025, Google a présenté Gemini 2.5 Pro, qu’il qualifie de création la plus intelligente à ce jour. Il est rapidement devenu le plus performant du classement LMArena, surpassant ses concurrents. La particularité de Gemini 2.5 réside dans sa capacité à examiner attentivement les réponses, ce qui lui permet d’être plus performant dans les tâches complexes nécessitant une réflexion approfondie.

Ne voulant pas se laisser distancer, OpenAI a lancé GPT-4.5, son modèle de chat le plus grand et le plus avancé à ce jour. Ce modèle est capable de reconnaître des modèles, d’établir des connexions et de trouver des idées créatives. Les premiers tests montrent que l’interaction avec GPT-4.5 semble très naturelle, grâce à son large éventail de connaissances et à sa meilleure compréhension de ce que les utilisateurs veulent dire. OpenAI souligne les améliorations significatives de GPT-4.5 en matière d’apprentissage sans supervision directe, conçu pour une collaboration harmonieuse avec les humains.

Ces systèmes d’IA ne sont pas seulement une technologie impressionnante ; ils modifient le fonctionnement des entreprises, accélèrent les découvertes scientifiques et transforment les projets créatifs. Alors que l’IA devient un élément normal de la vie quotidienne, des modèles comme Gemini 2.5 Pro et GPT-4.5 élargissent ce que nous pensons être possible. Avec de meilleures capacités de raisonnement, moins de risques de diffusion de fausses informations et une maîtrise des problèmes complexes, ils ouvrent la voie à des systèmes d’IA qui soutiennent véritablement le progrès humain.

Comprendre Gemini 2.5 Pro

Le 25 mars 2025, Google a officiellement dévoilé Gemini 2.5 Pro, décrit comme son “modèle d’IA le plus intelligent” à ce jour. Cette version a marqué une étape importante dans le développement de l’IA de Google, après plusieurs itérations de ses modèles 2.0. La stratégie de lancement a commencé par la version expérimentale, donnant aux abonnés de Gemini Advanced un accès anticipé pour tester ses capacités.

Ce qui distingue Gemini 2.5 Pro de ses prédécesseurs, c’est son architecture fondamentale en tant que“modèle de réflexion“. Contrairement aux générations précédentes qui s’appuyaient principalement sur des modèles de données entraînés, ce modèle peut raisonner activement avant de répondre, imitant ainsi les processus humains de résolution de problèmes. Il s’agit d’une avancée significative dans la manière dont les systèmes d’IA traitent les informations et génèrent des réponses.

Principales caractéristiques et capacités :

- Capacités de raisonnement accrues – Capacité à résoudre des problèmes étape par étape dans des domaines complexes

- Fenêtre contextuelle élargie – capacité de 1 million de jetons (avec des projets d’extension à 2 millions)

- Multimodalité native – Traite de manière transparente le texte, les images, l’audio, la vidéo et le code.

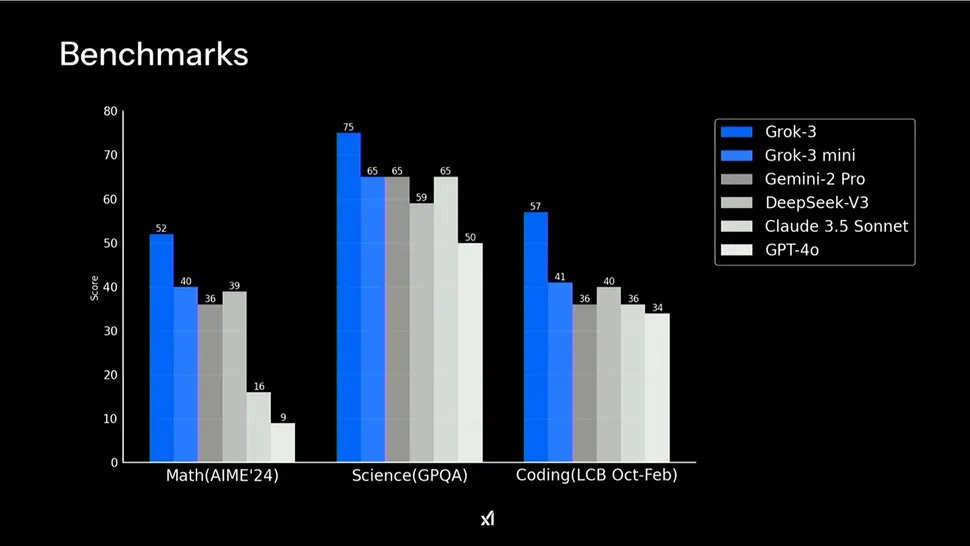

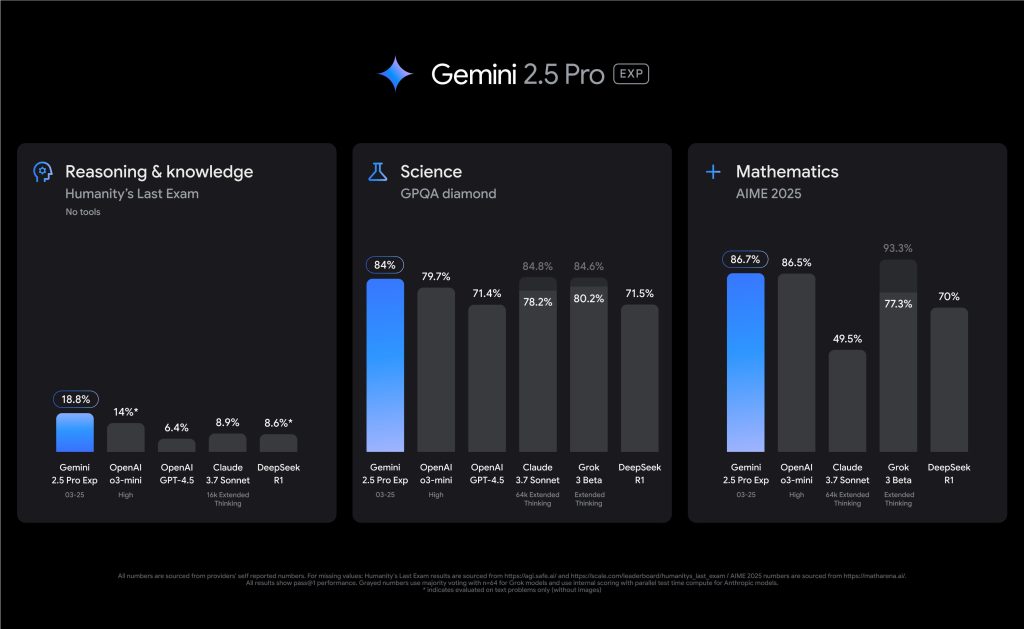

- Capacités de codage avancées – Améliorations significatives de la création d’applications web et de la transformation du code

Gemini 2.5 Pro s’est imposé comme un leader en matière de performances, en se plaçant au premier rang du classement LMArena. Il excelle particulièrement dans les benchmarks nécessitant un raisonnement avancé, obtenant un score record de 18,8 % à Humanity’s Last Exam sans utiliser d’outils externes. En mathématiques et en sciences, il fait preuve d’une compétence remarquable avec des scores de 86,7 % sur AIME 2025 et de 79,7 % sur GPQA diamond respectivement.

Par rapport aux modèles Gemini précédents, la version 2.5 Pro représente une avancée substantielle. Alors que Gemini 2.0 a introduit d’importantes capacités fondamentales, la version 2.5 Pro combine un modèle de base considérablement amélioré avec des techniques de post-entraînement plus performantes. Les améliorations les plus notables concernent les performances de codage, la profondeur du raisonnement et la compréhension du contexte, domaines dans lesquels les versions précédentes présentaient des limites.

Explorer GPT-4.5

En avril 2025, l’OpenAI a présenté GPT-4.5, le décrivant comme son “modèle de chat le plus grand et le plus avancé à ce jour”, ce qui représente une avancée notable dans l’évolution des grands modèles de langage. Cet aperçu de la recherche a immédiatement suscité l’enthousiasme de la communauté de l’IA, les premiers tests indiquant que les interactions avec le modèle semblent exceptionnellement naturelles, grâce à sa vaste base de connaissances et à sa capacité accrue à comprendre l’intention de l’utilisateur.

GPT-4.5 présente des avancées significatives dans les capacités d’apprentissage non supervisé. OpenAI a réalisé ces progrès en augmentant à la fois la puissance de calcul et les entrées de données, tout en employant des stratégies architecturales et d’optimisation innovantes. Le modèle a été entraîné sur les supercalculateurs Microsoft Azure AI, poursuivant un partenariat qui a permis à OpenAI de repousser les limites du possible.

Améliorations et capacités essentielles :

- Amélioration de la reconnaissance des schémas – Amélioration significative de la capacité à reconnaître les schémas, à établir des liens et à générer des idées créatives.

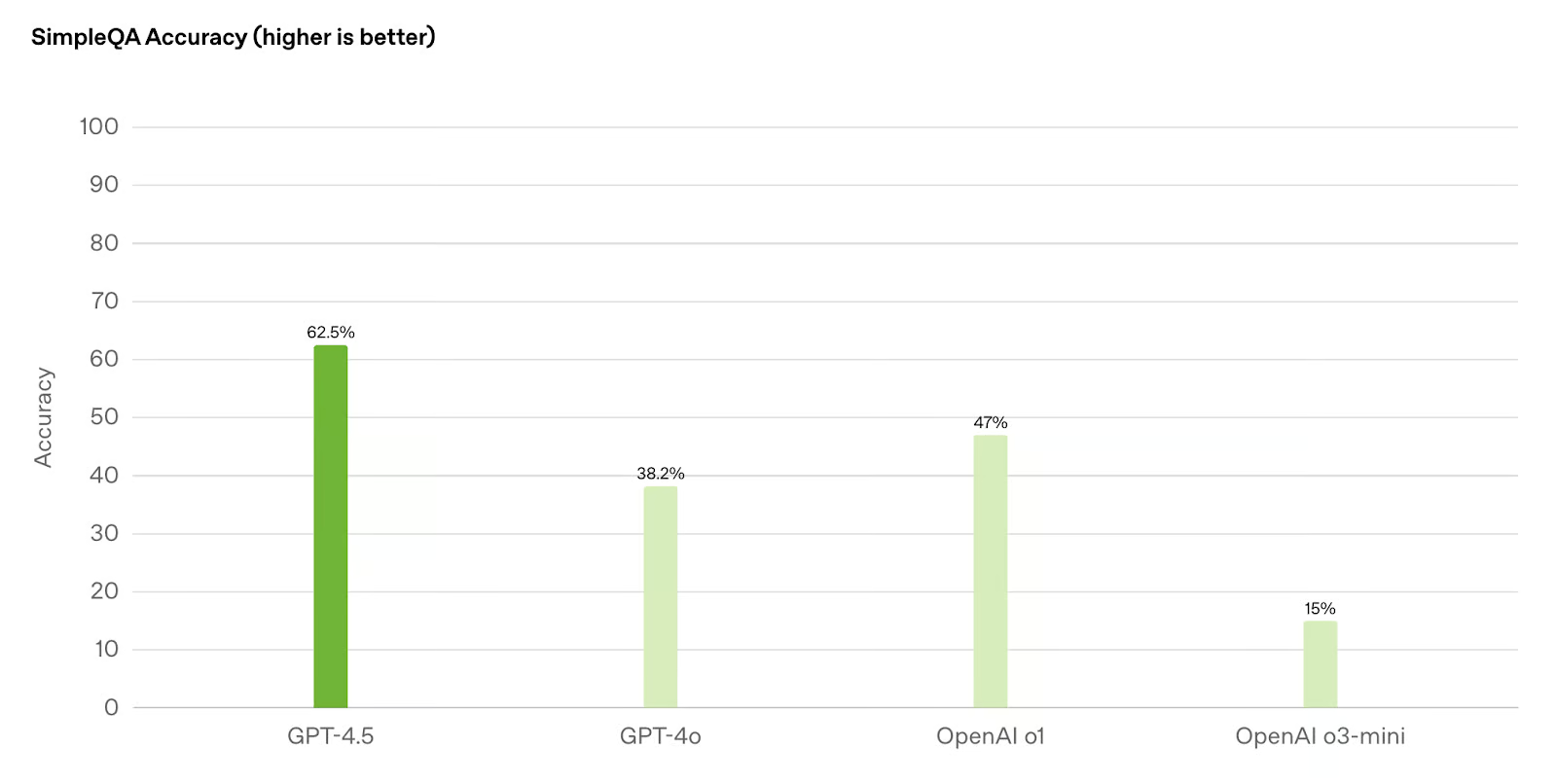

- Réduction des hallucinations – Moins de risques de générer de fausses informations par rapport aux modèles précédents tels que GPT-4o et o1

- Amélioration du “QE” – Plus grande intelligence émotionnelle et compréhension des interactions humaines nuancées

- Pilotage avancé – Meilleure compréhension et respect des instructions complexes de l’utilisateur

L’OpenAI a mis l’accent sur la formation de GPT-4.5 à la collaboration humaine. De nouvelles techniques améliorent la dirigeabilité du modèle, sa compréhension des nuances et le flux naturel des conversations. Cela le rend particulièrement efficace dans l’assistance à la rédaction et à la conception, où il fait preuve d’une intuition esthétique et d’une créativité plus fortes que les itérations précédentes.

Dans les applications réelles, GPT-4.5 fait preuve d’une polyvalence remarquable. Sa base de connaissances élargie et ses capacités de raisonnement améliorées lui permettent de s’adapter à un large éventail de tâches, de la création de contenu détaillé à la résolution de problèmes sophistiqués. Le PDG d’OpenAI, Sam Altman, a décrit le modèle en termes positifs, soulignant son “efficacité unique” bien qu’il ne soit pas en tête dans toutes les catégories de référence.

La stratégie de déploiement de GPT-4.5 reflète l’approche mesurée d’OpenAI en ce qui concerne le lancement de puissants systèmes d’IA. Initialement disponible pour les abonnés de ChatGPT Pro et les développeurs sur les paliers payants par le biais de diverses API, l’entreprise prévoit d’étendre progressivement l’accès aux abonnés de ChatGPT Plus, Team, Edu et Enterprise. Ce déploiement progressif permet à OpenAI de contrôler les performances et la sécurité au fur et à mesure de l’augmentation de l’utilisation.

Mesures de performance : Une analyse comparative

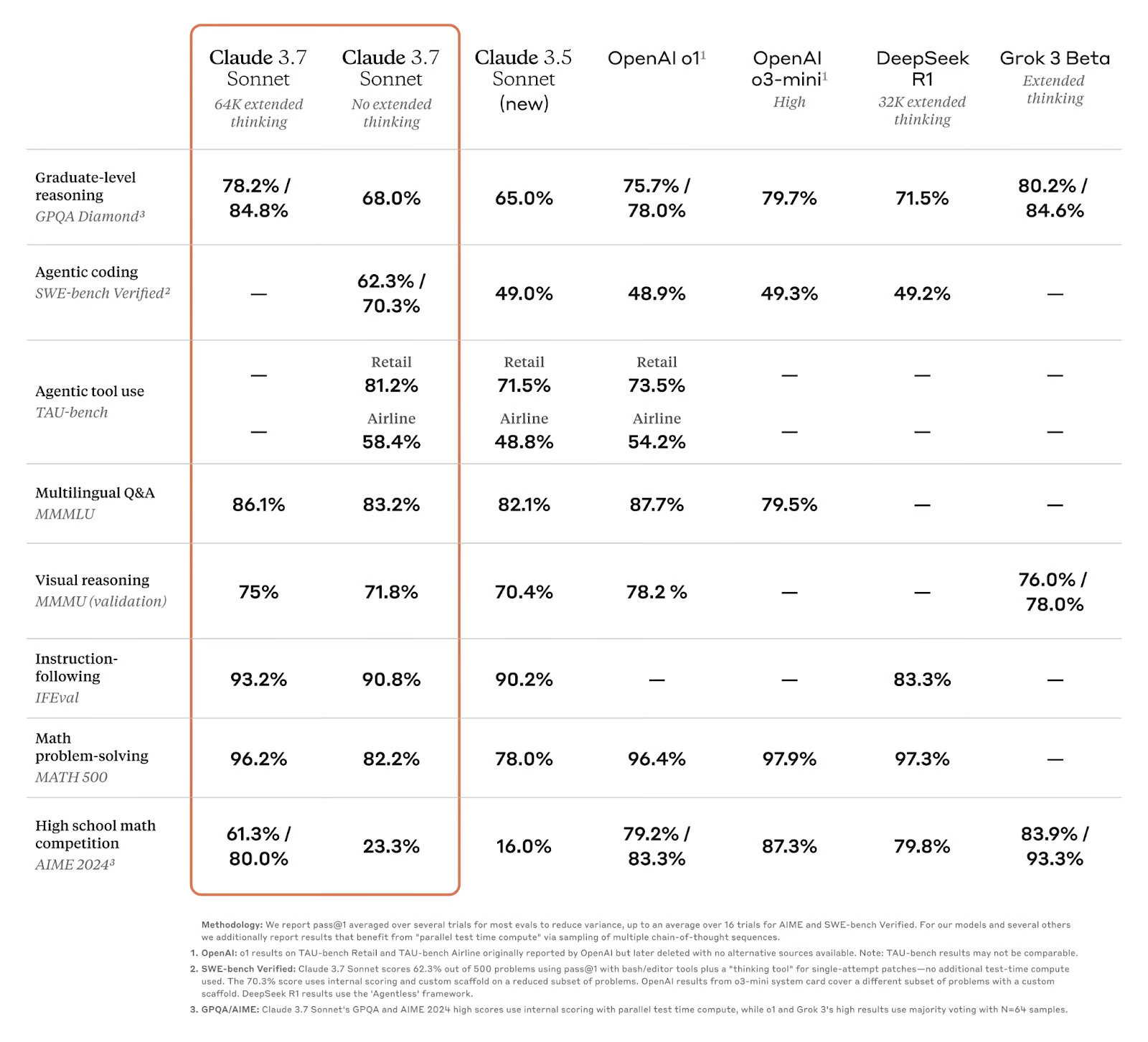

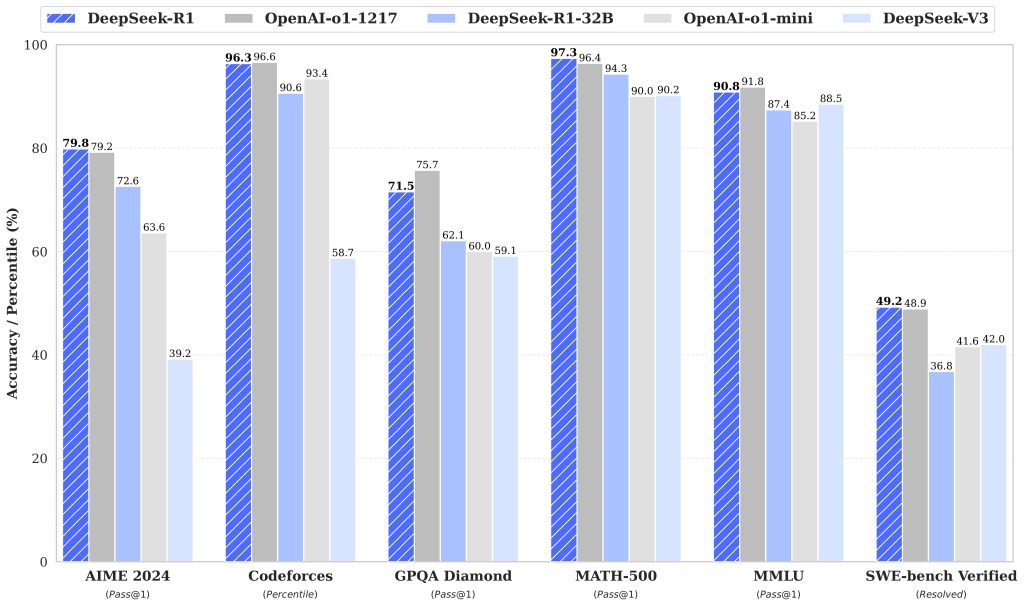

Lorsque l’on examine les capacités techniques de ces modèles d’IA avancés, les performances des tests de référence fournissent la mesure la plus objective de leurs capacités. Gemini 2.5 Pro et GPT-4.5 démontrent chacun des forces uniques dans divers domaines, les tests de référence révélant leurs avantages distincts.

| Point de repère | Gemini 2.5 Pro (03-25) | OpenAI GPT-4.5 | Claude 3.7 Sonnet | Aperçu de Grok 3 |

|---|---|---|---|---|

| LMArena (Total) | #1 | 2 | 21 | 2 |

| Le dernier examen de l’humanité (sans outils) | 18.8% | 6.4% | 8.9% | – |

| GPQA Diamant (tentative unique) | 84.0% | 71.4% | 78.2% | 80.2% |

| AIME 2025 (tentative unique) | 86.7% | – | 49.5% | 77.3% |

| SWE-Bench Vérifié | 63.8% | 38.0% | 70.3% | – |

| Aider Polyglotte (Entier/Diff) | 74.0% / 68.6% | 44,9% diff | 64,9% diff | – |

| MRCR (128k) | 91.5% | 48.8% | – | – |

Gemini 2.5 Pro fait preuve d’une force exceptionnelle dans les tâches de raisonnement intensif, excellant particulièrement dans le raisonnement à contexte long et la rétention des connaissances. Il surpasse largement ses concurrents lors du dernier examen de l’humanité, qui teste les limites de la connaissance humaine. Cependant, il montre des faiblesses relatives dans la génération de code, le codage agentique, et se bat occasionnellement avec la factualité dans certains domaines.

Le GPT-4.5, quant à lui, fait preuve d’une excellence particulière en matière de reconnaissance des formes, de génération d’idées créatives et de raisonnement scientifique. Il surpasse le benchmark GPQA diamant, montrant de fortes capacités dans les domaines scientifiques. Le modèle fait également preuve d’une intelligence émotionnelle et d’une intuition esthétique accrues, ce qui le rend particulièrement utile pour les applications créatives et axées sur la conception. L’un de ses principaux avantages est qu’il a moins tendance à générer de fausses informations que ses prédécesseurs.

En termes pratiques, Gemini 2.5 Pro représente le meilleur choix pour les tâches nécessitant un raisonnement approfondi, une compréhension multimodale et le traitement de contextes extrêmement longs. GPT-4.5 offre des avantages pour le travail créatif, l’assistance à la conception et les applications où la précision des faits et le flux naturel de la conversation sont primordiaux.

Applications et cas d’utilisation

Bien que les performances de référence fournissent des informations techniques précieuses, la véritable mesure de ces modèles d’IA avancés réside dans leurs applications pratiques dans divers domaines. Gemini 2.5 Pro et GPT-4.5 présentent tous deux des atouts distincts qui les rendent adaptés à différents cas d’utilisation, et les entreprises commencent déjà à tirer parti de leurs capacités pour résoudre des problèmes complexes.

Gemini 2.5 Pro dans les domaines scientifiques et techniques

Les capacités de raisonnement exceptionnelles de Gemini 2.5 Pro et sa fenêtre contextuelle étendue en font un outil particulièrement précieux pour la recherche scientifique et les applications techniques. Sa capacité à traiter et à analyser des données multimodales (texte, images, audio, vidéo et code) lui permet de traiter des problèmes complexes nécessitant la synthèse d’informations provenant de sources diverses. Cette polyvalence ouvre de nombreuses possibilités dans les secteurs qui exigent une précision technique et une analyse complète.

- Recherche scientifique et analyse de données – Les excellentes performances de Gemini 2.5 Pro sur des benchmarks tels que GPQA (79,7 %) démontrent son potentiel à aider les chercheurs à analyser des documents scientifiques complexes, à générer des hypothèses et à interpréter des résultats expérimentaux.

- Développement et ingénierie de logiciels – Le modèle excelle dans la création d’applications web, la transformation de code et le développement de programmes complexes avec un score de 63,8 % sur SWE-Bench Verified en utilisant des configurations d’agents personnalisées.

- Diagnostic médical et soins de santé – Ses capacités de raisonnement permettent d’analyser l’imagerie médicale et les données des patients afin d’aider les professionnels de la santé dans leurs processus de diagnostic.

- Analyse des big data et gestion des connaissances – La fenêtre contextuelle de 1 million de jetons (bientôt 2 millions) permet de traiter des ensembles de données et des référentiels de code entiers en une seule fois.

Excellence du GPT-4.5 dans les tâches de création et de communication

En revanche, le GPT-4.5 se montre particulièrement performant dans les tâches nécessitant une communication nuancée, une réflexion créative et un jugement esthétique. OpenAI a mis l’accent sur l’entraînement de ce modèle spécifiquement pour la collaboration humaine, ce qui a permis d’améliorer les capacités de création de contenu, d’assistance à la conception et de communication naturelle.

- Création de contenu et rédaction – GPT-4.5 fait preuve d’une intuition esthétique et d’une créativité accrues, ce qui le rend précieux pour la rédaction de textes marketing, d’articles, de scripts et d’autres contenus écrits.

- Collaboration à la conception – La meilleure compréhension des nuances et du contexte par le modèle en fait un partenaire efficace dans les processus de conception, de l’élaboration à la mise au point.

- Engagement des clients – Grâce à une plus grande intelligence émotionnelle, GPT-4.5 fournit des réponses plus appropriées et plus naturelles dans les contextes de service à la clientèle.

- Développement de contenus éducatifs – Le modèle permet d’adapter les explications aux différents niveaux de connaissances et styles d’apprentissage.

Des entreprises de divers secteurs intègrent déjà ces modèles dans leurs processus de travail. Microsoft a incorporé la technologie d’OpenAI directement dans sa suite de produits, offrant aux utilisateurs professionnels un accès immédiat aux capacités de GPT-4.5. De même, Gemini 2.5 Pro de Google trouve des applications dans les instituts de recherche et les entreprises technologiques qui cherchent à tirer parti de ses capacités de raisonnement et de multimodalité.

Les forces complémentaires de ces modèles suggèrent que de nombreuses organisations pourraient bénéficier de l’utilisation des deux, en fonction des cas d’utilisation spécifiques. Au fur et à mesure que ces technologies mûrissent, nous pouvons nous attendre à voir des applications de plus en plus sophistiquées qui transforment fondamentalement le travail de connaissance, les processus créatifs et la résolution de problèmes dans tous les secteurs.

L’avenir de l’IA : que nous réserve l’avenir ?

Alors que Gemini 2.5 Pro et GPT-4.5 repoussent les limites du possible, la trajectoire future du développement de l’IA se précise. L’engagement de Google à “intégrer des capacités de raisonnement directement dans tous les modèles” laisse entrevoir un avenir où le raisonnement deviendra la norme dans tous les systèmes d’IA. De même, l’approche d’OpenAI, qui consiste à “étendre l’apprentissage et le raisonnement non supervisés”, laisse entrevoir des modèles dotés de capacités de plus en plus étendues pour comprendre et générer des contenus semblables à ceux des humains.

Les années à venir verront probablement des modèles d’IA avec des fenêtres contextuelles considérablement élargies au-delà des limites actuelles, un raisonnement plus sophistiqué et une intégration transparente dans toutes les modalités. Nous pourrions également assister à la montée en puissance d’agents d’IA véritablement autonomes, capables d’exécuter des tâches complexes avec une supervision humaine minimale. Toutefois, ces progrès s’accompagnent de défis importants. À mesure que les capacités de l’IA augmentent, il devient de plus en plus important d’aborder les risques potentiels liés à la désinformation, à la protection de la vie privée et au déplacement de la main-d’œuvre humaine.

Les considérations éthiques doivent rester au premier plan du développement de l’IA. L’OpenAI reconnaît que “chaque augmentation des capacités des modèles est une occasion de les rendre plus sûrs”, soulignant la double responsabilité du progrès et de la protection. La communauté de l’IA devra développer des cadres de gouvernance solides qui encouragent l’innovation tout en protégeant contre les abus.

La révolution de l’IA représentée par Gemini 2.5 Pro et GPT-4.5 ne fait que commencer. Si le rythme des progrès suscite à la fois excitation et appréhension, une chose reste claire : l’avenir de l’IA sera défini non seulement par les capacités technologiques, mais aussi par la manière dont nous choisirons de les exploiter au profit de l’homme. En donnant la priorité à un développement responsable qui renforce le potentiel humain au lieu de le remplacer, nous pouvons faire en sorte que la prochaine génération de modèles d’IA serve d’outils puissants pour le progrès collectif.