El esperado evento DevDay de OpenAI trajo consigo algunas noticias emocionantes y filtraciones de precios que han dejado a la comunidad de IA zumbando de expectación. Entre los aspectos más destacados se encuentran el lanzamiento de GPT-4 Turbo, importantes reducciones de precio en varios servicios, la ventana contextual GPT-4 turbo 128k y la presentación de la API Assistants. Profundicemos en los detalles y veamos cómo estos avances están configurando el futuro de la IA.

GPT-4 Turbo: Más potencia a menor precio

El acontecimiento más destacado fue, sin duda, la presentación del GPT-4 Turbo. Este avanzado modelo de IA cuenta con una asombrosa ventana de contexto de 128.000, lo que supone un importante salto adelante con respecto a su predecesor, GPT-3.5. Con este contexto ampliado, GPT-4 Turbo puede leer y procesar información equivalente a un libro de 400 páginas en una sola ventana de contexto. Esta nueva capacidad elimina uno de los principales factores diferenciadores de Anthropic, la empresa hermana de OpenAI, ya que GPT-4 Turbo ofrece ahora un tamaño de contexto comparable.

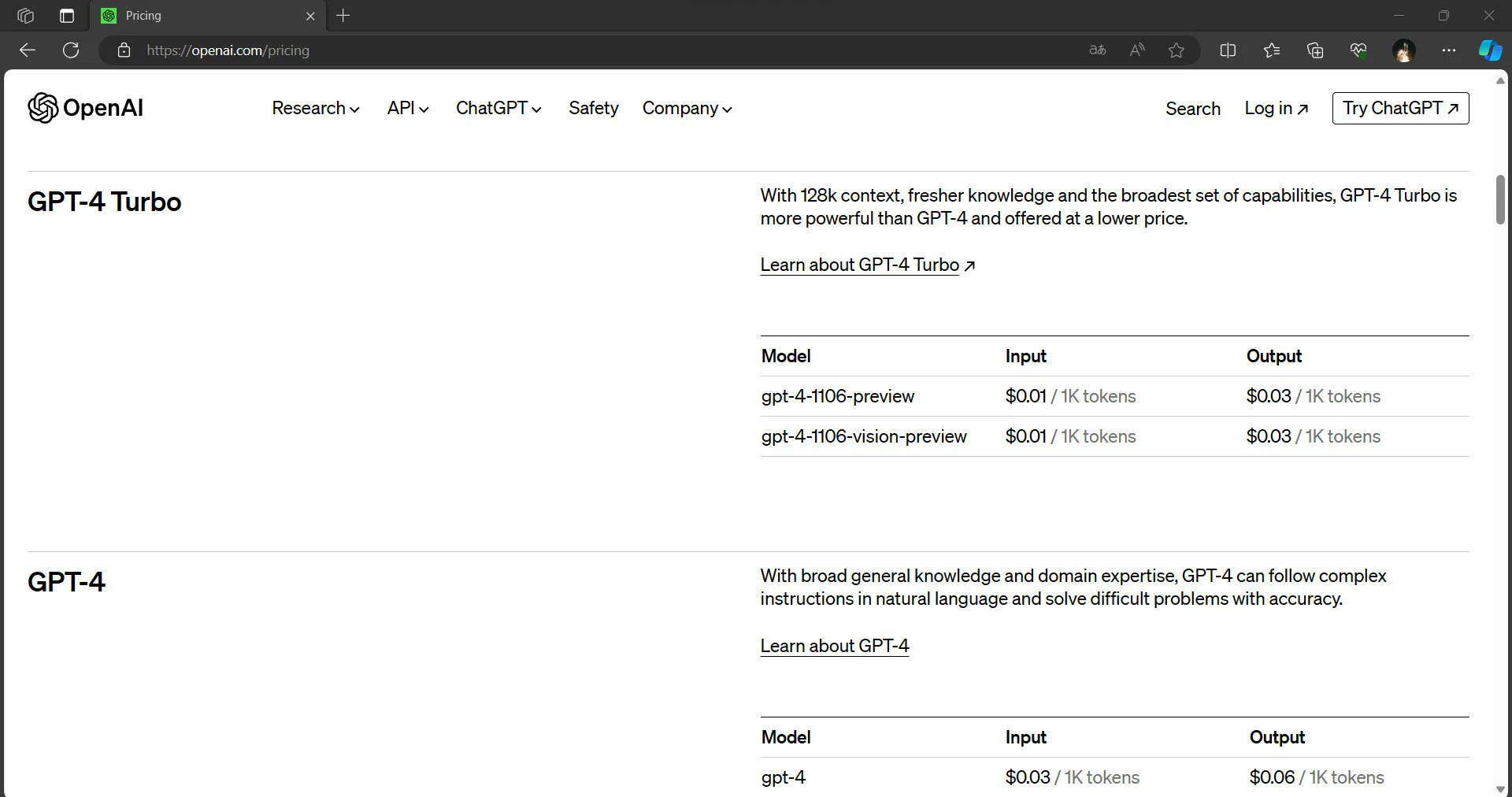

Pero las noticias no acaban ahí. GPT-4 Turbo no sólo ofrece una ventana contextual más amplia, sino que también proporciona una salida más rápida y está disponible a una fracción de los precios de entrada y salida de GPT-4. Esta combinación de capacidades mejoradas y rentabilidad posiciona a GPT-4 Turbo como un cambio de juego en el mundo de la IA.

Rebajas generalizadas

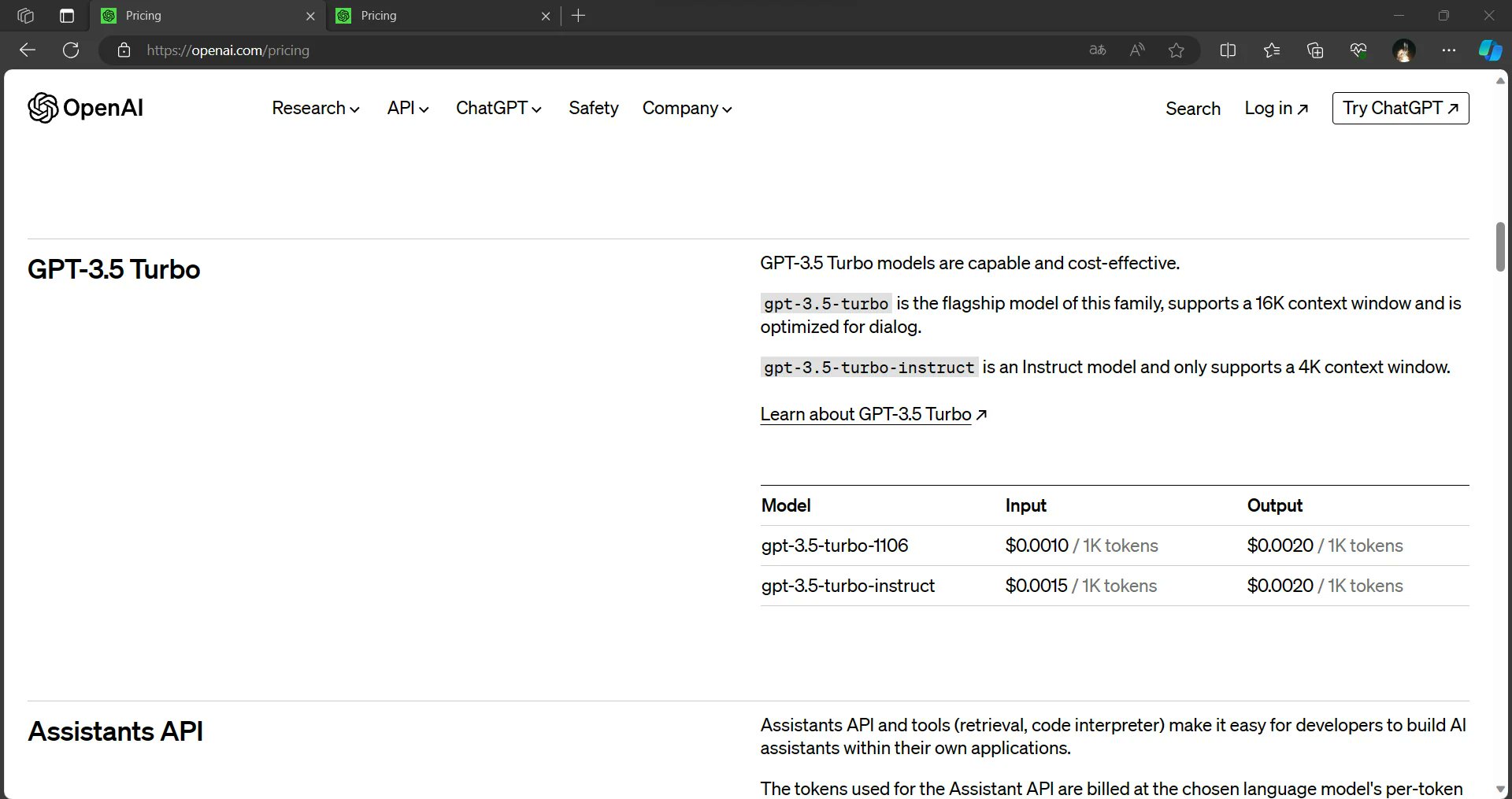

OpenAI está haciendo que la IA sea más accesible y asequible que nunca. La información filtrada sugiere que el coste de los insumos para GPT-3.5 se ha reducido en un 33%. Además, los modelos GPT-3.5 ahora tendrán por defecto 16K, lo que los hará más rentables para los usuarios. Estos cambios pretenden democratizar el uso de la IA, permitiendo que un público más amplio aproveche el poder de estos modelos.

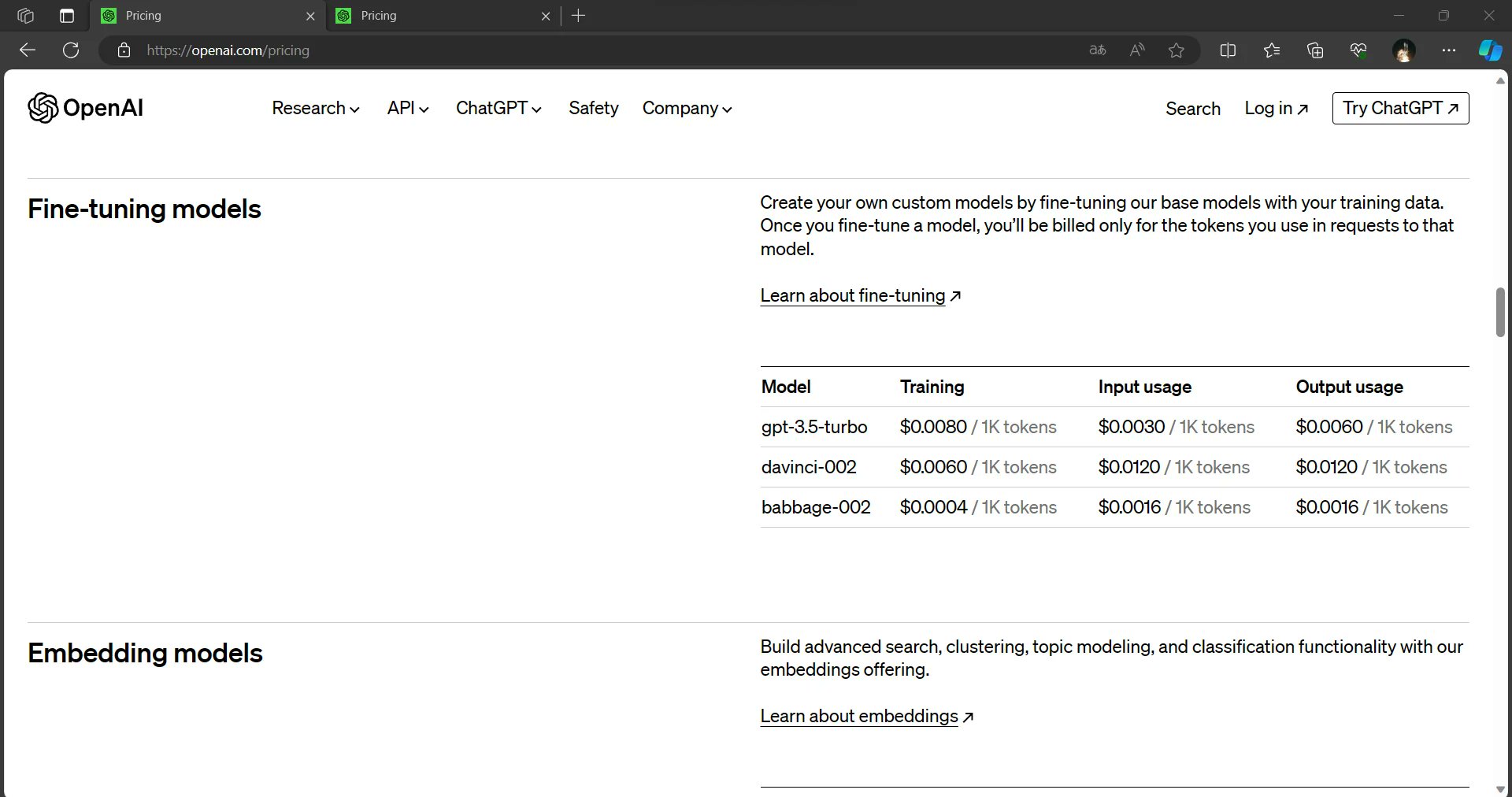

Los modelos perfeccionados, un recurso crucial para muchas aplicaciones de IA, también se benefician de importantes reducciones de precio. Los costes de inferencia de los modelos ajustados se reducen en un 75% para la entrada y casi un 60% para la salida. Estas reducciones prometen capacitar a desarrolladores y organizaciones para implantar soluciones basadas en IA de forma más económica.

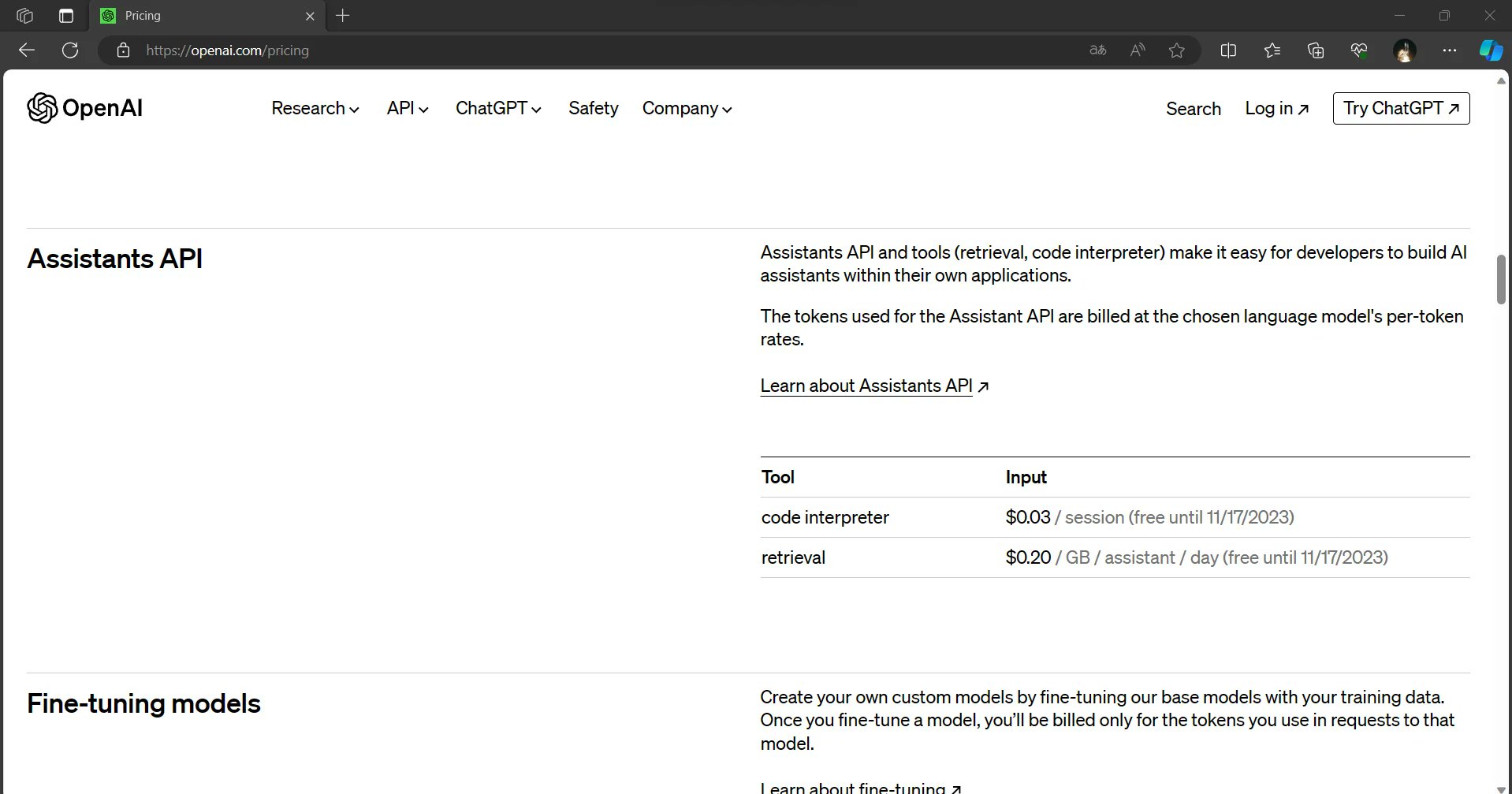

API de asistentes: Una nueva frontera en la IA

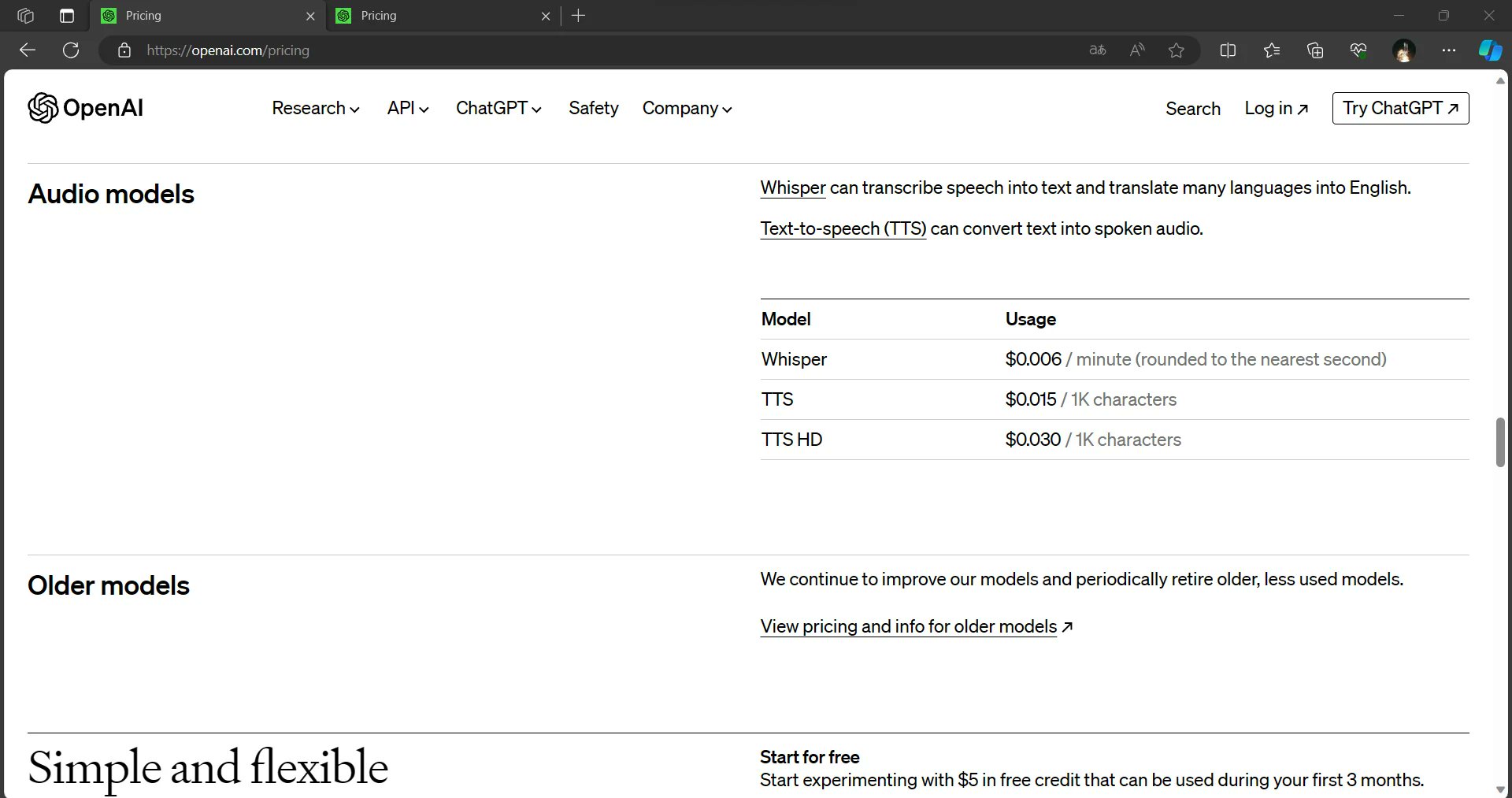

En el DevDay de OpenAI también se presentó la próxima API Assistants, que proporcionará a los usuarios un intérprete de código y funciones de recuperación a través de una API. Se espera que esta innovación agilice la integración de la IA en diversas aplicaciones, permitiendo a los desarrolladores crear soluciones aún más potentes y dinámicas.

Dall-E 3 y Dall-E 3 HD: ampliar los horizontes creativos

En el acto también se presentó Dall-E 3 y Dall-E 3 HD. Aunque estos modelos prometen superar los límites de la IA creativa, se posicionan como opciones más caras en comparación con Dall-E 2. Sin embargo, las capacidades mejoradas de estos modelos pueden justificar el mayor coste para los usuarios que buscan IA de vanguardia para la generación y manipulación de imágenes.

El poder del contexto 128K

En pocas palabras, la ventana contextual del GPT-4 Turbo 128K le permite procesar y comprender una cantidad asombrosa de información en una sola instancia. En cuanto al contexto, la generación anterior, GPT-3, tenía una ventana de contexto de 1.024 tokens. Los tokens pueden representar palabras, caracteres o incluso subpalabras, según el idioma y el texto. La ventana de contexto de GPT-4 Turbo 128K es aproximadamente 125 veces mayor que la de GPT-3, lo que la convierte en un auténtico gigante en el mundo de los modelos lingüísticos de IA.

Implicaciones prácticas

La introducción de GPT-4 Turbo con su ventana de contexto de 128K es un notable paso adelante en el campo de la IA. Su capacidad para procesar y comprender grandes cantidades de información puede revolucionar la forma en que interactuamos con los sistemas de IA, investigamos, creamos contenidos y mucho más. A medida que los desarrolladores e investigadores exploren las posibilidades de esta poderosa herramienta, podemos esperar ver aplicaciones innovadoras que aprovechen todo el potencial de las capacidades de GPT-4 Turbo, abriendo nuevos horizontes en la inteligencia artificial.

Comprensión global

Con un contexto de 128K, GPT-4 Turbo puede leer y analizar documentos extensos, artículos o conjuntos de datos en su totalidad. Esta capacidad le permite dar respuestas más completas y precisas a preguntas complejas, tareas de investigación o necesidades de análisis de datos.

Continuidad contextual

Los modelos anteriores solían tener problemas para mantener el contexto en documentos extensos, lo que daba lugar a respuestas inconexas o irrelevantes. La ventana GPT-4 Turbo 128K le permite mantener el contexto en pasajes extensos, lo que se traduce en interacciones más coherentes y relevantes desde el punto de vista contextual.

Reducir la sobrecarga de información

En la era de la sobrecarga de información, la capacidad de GPT-4 Turbo para procesar grandes cantidades de datos de una sola vez puede cambiar las reglas del juego. Puede cribar grandes conjuntos de datos, extraer información clave y ofrecer resúmenes sucintos, ahorrando a los usuarios tiempo y esfuerzo.

Investigación y redacción avanzadas

Los investigadores, escritores y creadores de contenidos pueden beneficiarse significativamente del contexto de 128K de GPT-4 Turbo. Puede ayudar a generar documentos de investigación en profundidad, artículos e informes con un profundo conocimiento de la materia.

Traducción lingüística mejorada

Las tareas de traducción de idiomas también pueden beneficiarse de un contexto más amplio. GPT-4 Turbo puede comprender mejor los matices de los idiomas, las expresiones idiomáticas y el contexto cultural, lo que se traduce en traducciones más precisas.

Retos y consideraciones

Aunque el contexto GPT-4 Turbo 128K supone sin duda un cambio de juego, también presenta retos. Manejar modelos tan grandes requiere importantes recursos informáticos, lo que puede limitar la accesibilidad de algunos usuarios. Además, a medida que los modelos de IA se vuelven más potentes, es necesario abordar las consideraciones éticas en torno a la privacidad de los datos y la generación de contenidos.

¿Más en camino para GPT-4?

El evento DevDay de OpenAI ofreció una gran cantidad de interesantes actualizaciones y filtraciones de precios que van a dar forma al panorama de la IA. La impresionante ventana de contexto de 128 K de GPT-4 Turbo, su mayor velocidad de salida y su precio reducido lo convierten en una oferta sobresaliente. La reducción general de los precios de los modelos de entrada, salida y perfeccionamiento está llamada a democratizar el uso de la IA, haciéndola más accesible a un público más amplio. Los próximos modelos Assistants API y Dall-E 3 ponen aún más de relieve el compromiso de OpenAI con la innovación y el avance en el campo de la inteligencia artificial.

A medida que se desarrollan estos acontecimientos, queda claro que OpenAI está decidida a dotar a desarrolladores, empresas y mentes creativas de herramientas y servicios de IA de última generación. El futuro de la IA se presenta más brillante y accesible que nunca.

Más información: ChatGPT Enterprise de OpenAI: Coste, beneficios y seguridad