Der mit Spannung erwartete DevDay-Event von OpenAI brachte einige aufregende Neuigkeiten und Preisangaben, die die KI-Community in helle Aufregung versetzten. Zu den wichtigsten Highlights gehören die Veröffentlichung von GPT-4 Turbo, erhebliche Preissenkungen für verschiedene Dienste, das GPT-4 Turbo 128k Kontextfenster und die Vorstellung der Assistenten-API. Schauen wir uns die Details an und sehen wir, wie diese Entwicklungen die Zukunft der KI gestalten.

GPT-4 Turbo: Mehr Leistung zu einem niedrigeren Preis

Das Highlight der Veranstaltung war zweifelsohne die Vorstellung des GPT-4 Turbo. Dieses fortschrittliche KI-Modell verfügt über ein beeindruckendes 128K-Kontextfenster, ein bedeutender Fortschritt gegenüber seinem Vorgänger GPT-3.5. Mit diesem erweiterten Kontext kann GPT-4 Turbo Informationen lesen und verarbeiten, die einem 400-seitigen Buch in einem einzigen Kontextfenster entsprechen. Diese neue Fähigkeit beseitigt eines der Hauptunterscheidungsmerkmale für Anthropic, dem Schwesterunternehmen von OpenAI, da GPT-4 Turbo nun eine vergleichbare Kontextgröße bietet.

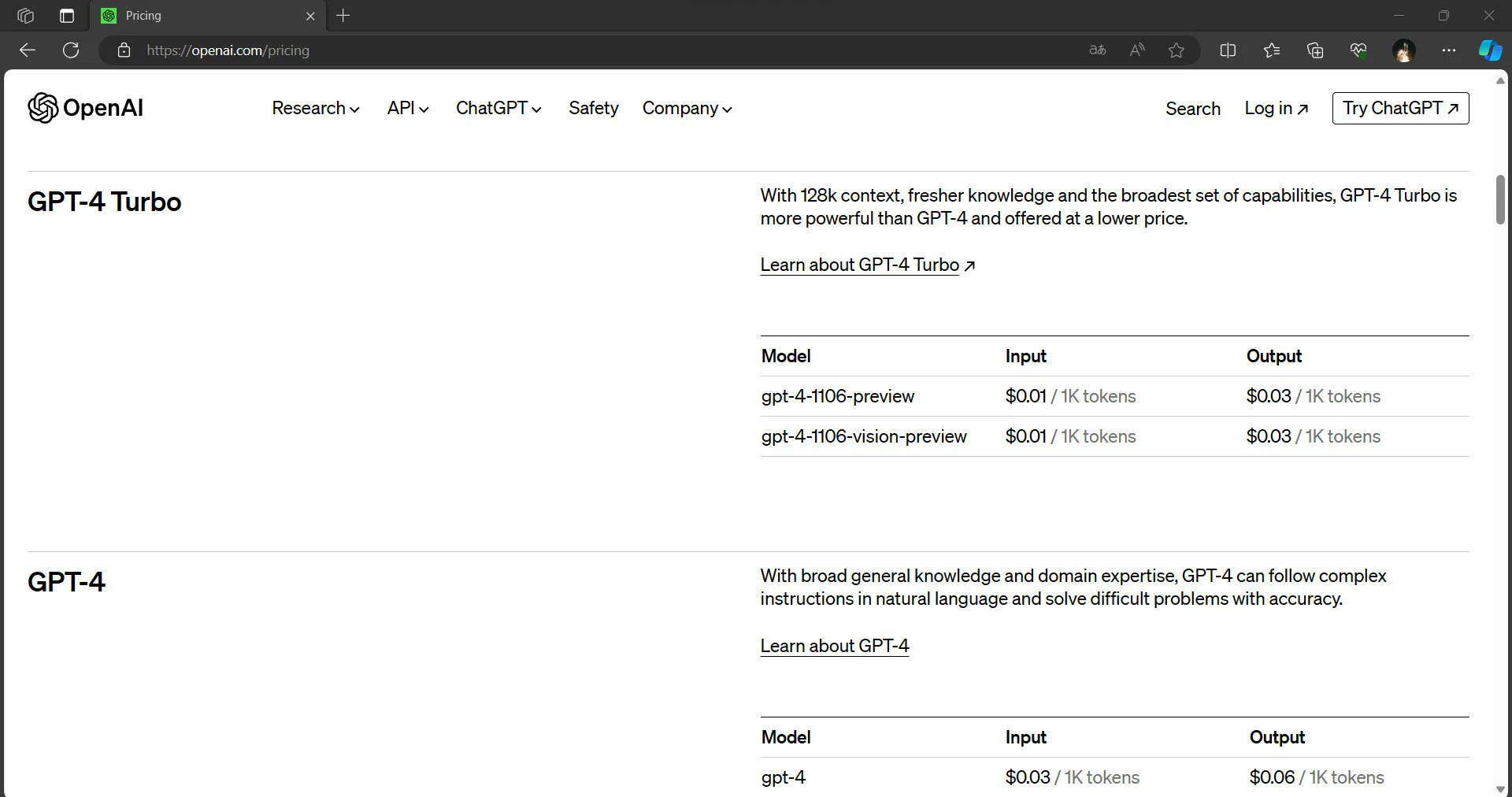

Aber das ist noch nicht alles. GPT-4 Turbo bietet nicht nur ein größeres Kontextfenster, sondern auch einen schnelleren Output und ist zu einem Bruchteil der Input- und Output-Preise von GPT-4 erhältlich. Diese Kombination aus verbesserten Fähigkeiten und Kosteneffizienz macht GPT-4 Turbo zu einem neuen Wegbereiter in der Welt der KI.

Preissenkungen auf breiter Front

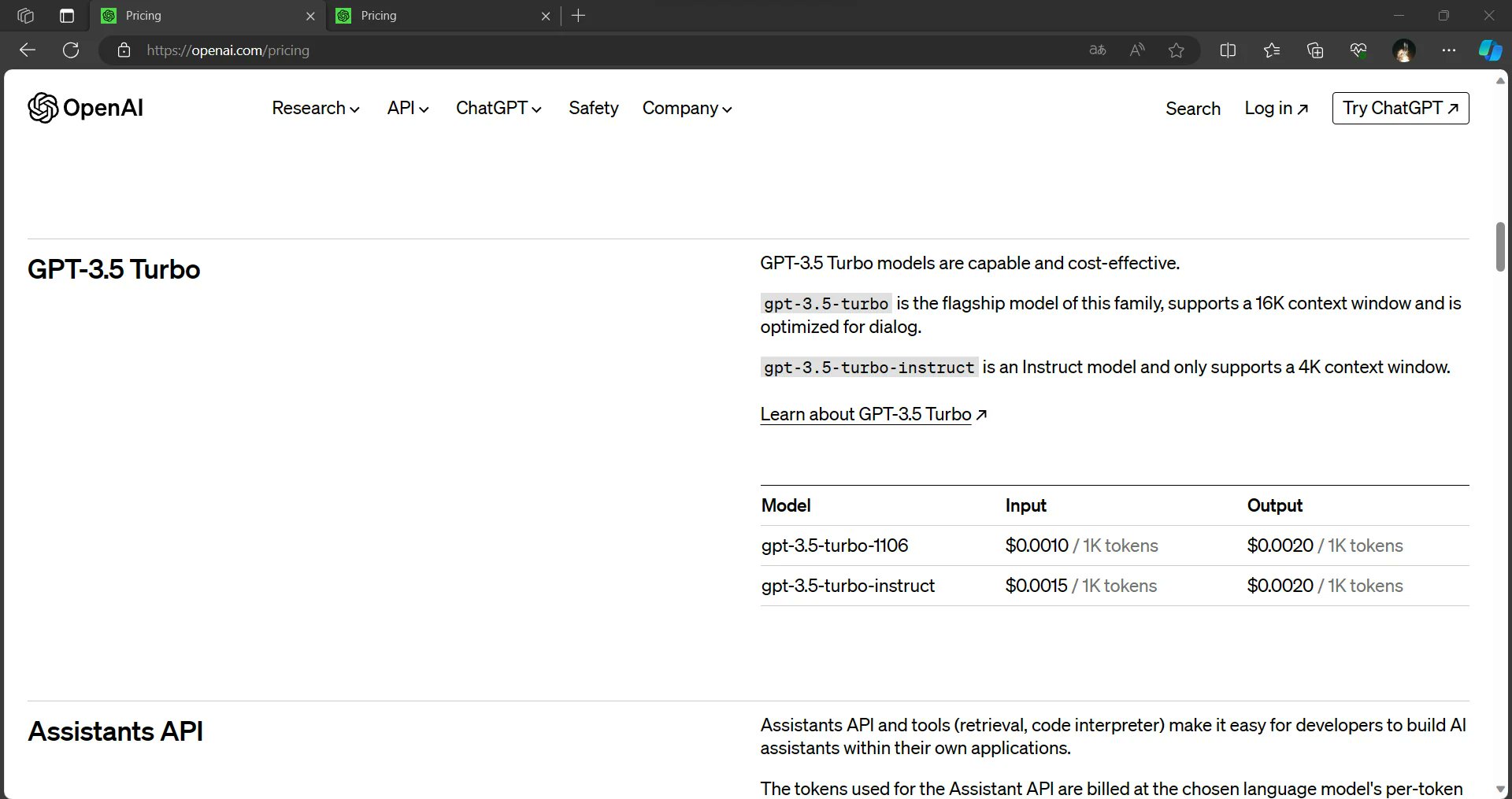

OpenAI macht KI so zugänglich und erschwinglich wie nie zuvor. Die durchgesickerten Informationen deuten darauf hin, dass die Inputkosten für GPT-3.5 um 33 % gesenkt wurden. Darüber hinaus sind die GPT-3.5-Modelle jetzt standardmäßig auf 16K eingestellt, was die Kosten für die Benutzer verringert. Diese Änderungen zielen darauf ab, die Nutzung von KI zu demokratisieren und einem breiteren Publikum die Möglichkeit zu geben, die Leistungsfähigkeit dieser Modelle zu nutzen.

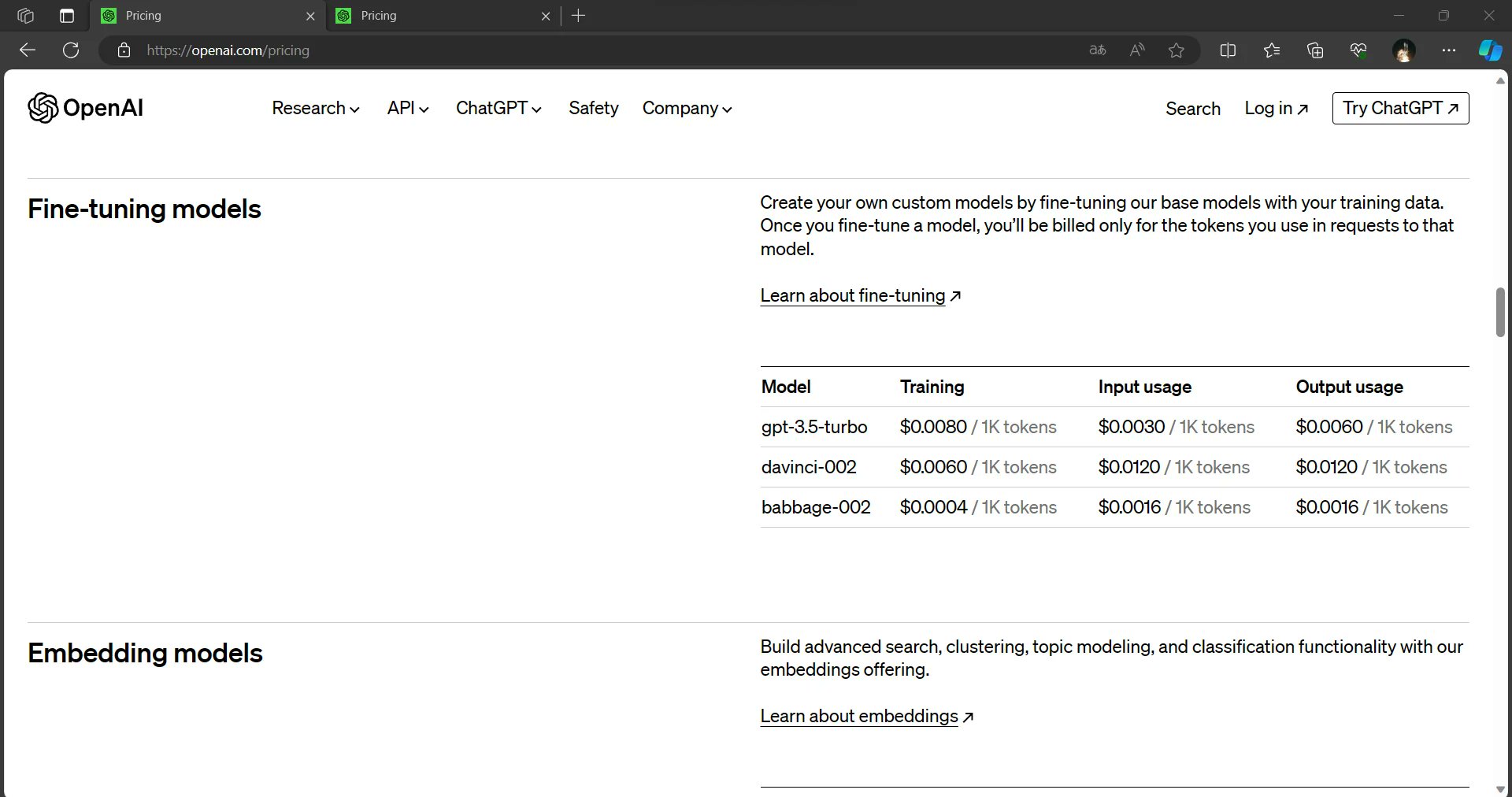

Fein abgestimmte Modelle, die für viele KI-Anwendungen von entscheidender Bedeutung sind, profitieren ebenfalls von erheblichen Preissenkungen. Die Inferenzkosten für fein abgestimmte Modelle werden Berichten zufolge um satte 75 % bei der Eingabe und fast 60 % bei der Ausgabe gesenkt. Diese Einsparungen versprechen, dass Entwickler und Unternehmen KI-gesteuerte Lösungen kostengünstiger einsetzen können.

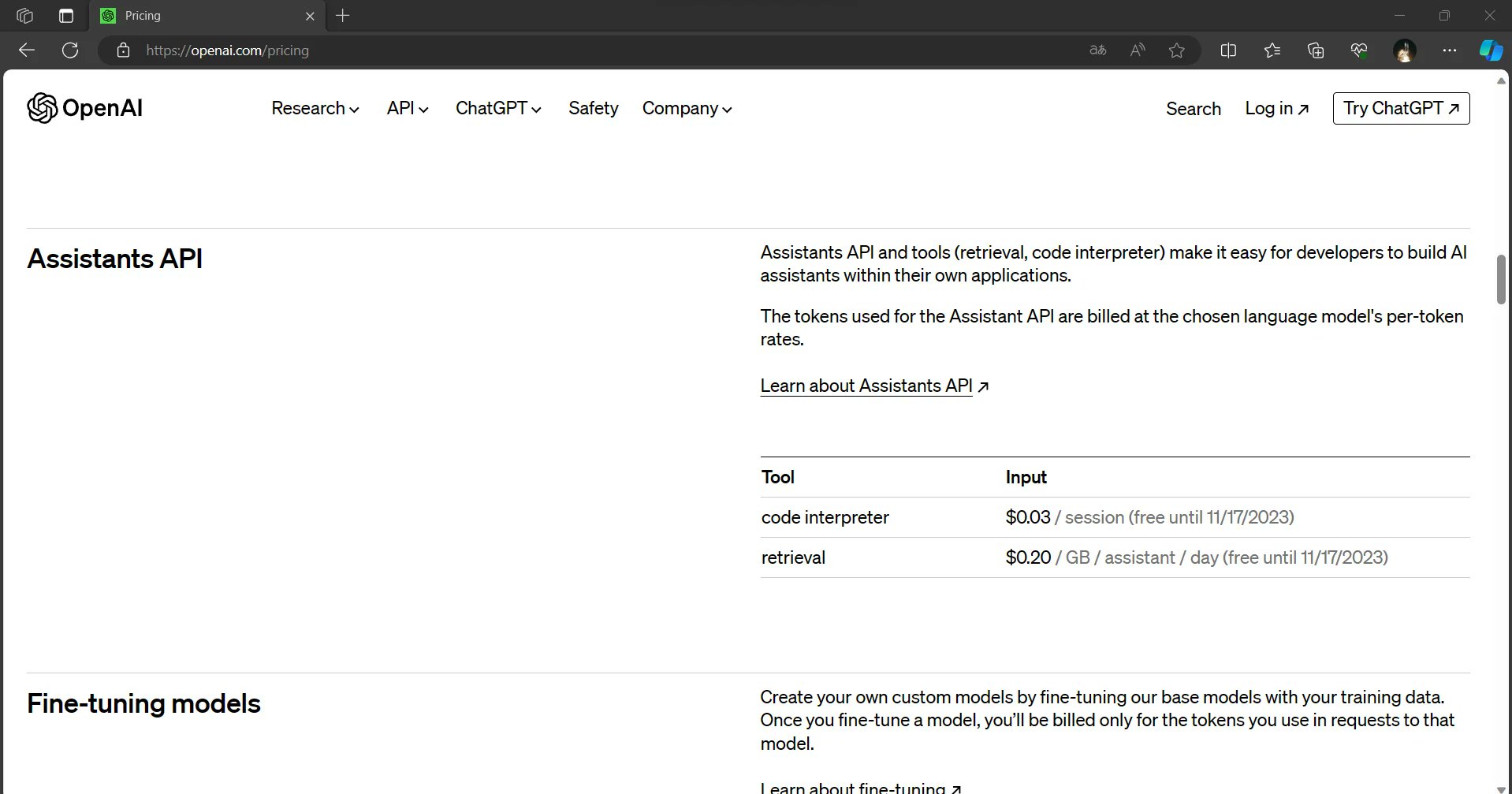

Assistenten-API: Eine neue Grenze der KI

Auf dem DevDay von OpenAI wurde auch die kommende Assistenten-API vorgestellt, die den Nutzern einen Code-Interpreter und Abfragemöglichkeiten über eine API bieten soll. Es wird erwartet, dass diese Innovation die Integration von KI in verschiedene Anwendungen vereinfacht und es Entwicklern ermöglicht, noch leistungsfähigere und dynamischere Lösungen zu entwickeln.

Dall-E 3 und Dall-E 3 HD: Kreative Horizonte erweitern

Auf der Veranstaltung wurde auch die Einführung von Dall-E 3 und Dall-E 3 HD bekannt gegeben. Diese Modelle versprechen zwar, die Grenzen der kreativen KI zu erweitern, sind aber im Vergleich zu Dall-E 2 als teurere Optionen positioniert. Die verbesserten Fähigkeiten dieser Modelle können jedoch die höheren Kosten für Nutzer rechtfertigen, die eine hochmoderne KI für die Bilderzeugung und -manipulation suchen.

Die Macht des 128K-Kontextes

Vereinfacht ausgedrückt, kann der GPT-4 Turbo 128K Kontextfenster eine erstaunliche Menge an Informationen in einer einzigen Instanz verarbeiten und verstehen. Die vorherige Generation, GPT-3, hatte ein Kontextfenster von 1.024 Token. Token können je nach Sprache und Text Wörter, Zeichen oder sogar Teilwörter darstellen. Das Kontextfenster von GPT-4 Turbo 128K ist etwa 125 Mal größer als das von GPT-3, was es zu einem wahren Giganten in der Welt der KI-Sprachmodelle macht.

Praktische Implikationen

Die Einführung von GPT-4 Turbo mit seinem 128K-Kontextfenster ist ein bemerkenswerter Schritt nach vorn im Bereich der KI. Ihre Fähigkeit, riesige Informationsmengen zu verarbeiten und zu verstehen, hat das Potenzial, die Art und Weise zu revolutionieren, wie wir mit KI-Systemen interagieren, Forschung betreiben, Inhalte erstellen und vieles mehr. Wenn Entwickler und Forscher die Möglichkeiten dieses leistungsstarken Tools erforschen, können wir mit innovativen Anwendungen rechnen, die das volle Potenzial von GPT-4 Turbo ausschöpfen und neue Horizonte der künstlichen Intelligenz erschließen.

Umfassendes Verständnis

Mit einem 128K-Kontext kann GPT-4 Turbo umfangreiche Dokumente, Artikel oder Datensätze in ihrer Gesamtheit lesen und analysieren. Diese Fähigkeit ermöglicht es, umfassendere und genauere Antworten auf komplexe Fragen, Forschungsaufgaben oder Datenanalyseanforderungen zu geben.

Kontinuität im Kontext

Frühere Modelle hatten oft Probleme, den Kontext über lange Dokumente hinweg zu erhalten, was zu unzusammenhängenden oder irrelevanten Antworten führte. Das GPT-4 Turbo 128K-Fenster ermöglicht es, den Kontext über längere Passagen aufrechtzuerhalten, was zu kohärenteren und kontextuell relevanten Interaktionen führt.

Verringerung der Informationsflut

Im Zeitalter der Informationsüberflutung kann die Fähigkeit des GPT-4 Turbo, große Datenmengen auf einmal zu verarbeiten, eine entscheidende Rolle spielen. Es kann große Datensätze durchsuchen, wichtige Erkenntnisse extrahieren und prägnante Zusammenfassungen liefern, was den Benutzern wertvolle Zeit und Mühe erspart.

Fortgeschrittene Recherche und Schreiben

Forscher, Autoren und Verfasser von Inhalten können von dem 128K-Kontext des GPT-4 Turbo erheblich profitieren. Es kann bei der Erstellung von fundierten Forschungsarbeiten, Artikeln und Berichten helfen, die ein tiefes Verständnis der Materie vermitteln.

Verbesserte Sprachübersetzung

Auch Übersetzungsaufgaben können von dem breiteren Kontext profitieren. GPT-4 Turbo kann die Nuancen von Sprachen, idiomatischen Ausdrücken und den kulturellen Kontext besser verstehen, was zu genaueren Übersetzungen führt.

Herausforderungen und Überlegungen

Der GPT-4-Turbo-128K-Kontext ist zweifelsohne ein großer Fortschritt, aber er bringt auch Herausforderungen mit sich. Die Bearbeitung solch großer Modelle erfordert beträchtliche Rechenressourcen, was die Zugänglichkeit für einige Nutzer einschränken kann. Darüber hinaus müssen ethische Überlegungen zum Datenschutz und zur Generierung von Inhalten berücksichtigt werden, da die KI-Modelle immer leistungsfähiger werden.

Mehr auf dem Weg für GPT-4?

OpenAIs DevDay-Veranstaltung lieferte eine Fülle von spannenden Updates und Preisangaben, die die KI-Landschaft prägen werden. Das beeindruckende 128K-Kontextfenster, die schnellere Ausgabe und der niedrigere Preis machen den GPT-4 Turbo zu einem herausragenden Angebot. Die allgemeinen Preissenkungen für Input-, Output- und Feinabstimmungsmodelle werden die Nutzung von KI demokratisieren und sie für ein breiteres Publikum zugänglich machen. Die bevorstehende Assistenten-API und die Dall-E 3-Modelle unterstreichen das Engagement von OpenAI für Innovation und die Weiterentwicklung des Bereichs der künstlichen Intelligenz.

Diese Entwicklungen machen deutlich, dass OpenAI entschlossen ist, Entwicklern, Unternehmen und kreativen Köpfen modernste KI-Tools und -Dienste zur Verfügung zu stellen. Die Zukunft der künstlichen Intelligenz ist vielversprechender und leichter zugänglich als je zuvor.

Lesen Sie mehr: ChatGPT Enterprise von OpenAI: Kosten, Nutzen und Sicherheit