RAG-as-a-Service: Desbloqueie a IA generativa para sua empresa

Com o aumento dos modelos de linguagem grande (LLMs) e das tendências de IA generativa, a integração de soluções de IA generativa em sua empresa pode aumentar a eficiência do fluxo de trabalho. Se você não conhece a IA generativa, a infinidade de jargões pode ser intimidadora. Este blog desmistificará as terminologias básicas da IA generativa e orientará você sobre como começar a criar uma solução de IA personalizada para sua empresa com o RAG-as-a-Service.

O que é Retrieval Augmented Generation (RAG)?

O Retrieval Augmented Generation (RAG) é um conceito fundamental na implementação de LLMs ou IA generativa em fluxos de trabalho comerciais. O RAG utiliza modelos Transformer pré-treinados para responder a consultas relacionadas a negócios, injetando dados relevantes da sua base de conhecimento específica no processo de consulta. Esses dados, com os quais os LLMs podem não ter sido treinados, são usados para gerar respostas precisas e relevantes.

O RAG é econômico e eficiente, tornando a IA generativa mais acessível. Vamos explorar algumas das principais terminologias relacionadas ao RAG.

Principais terminologias no RAG

Fragmentação

Os LLMs consomem muitos recursos e são treinados em comprimentos de dados gerenciáveis, conhecidos como “janela de contexto”. A janela de contexto varia de acordo com o LLM usado. Para resolver suas limitações, os dados comerciais fornecidos como documentos ou literatura textual são segmentados em partes menores. Esses blocos são utilizados durante o processo de recuperação da consulta.

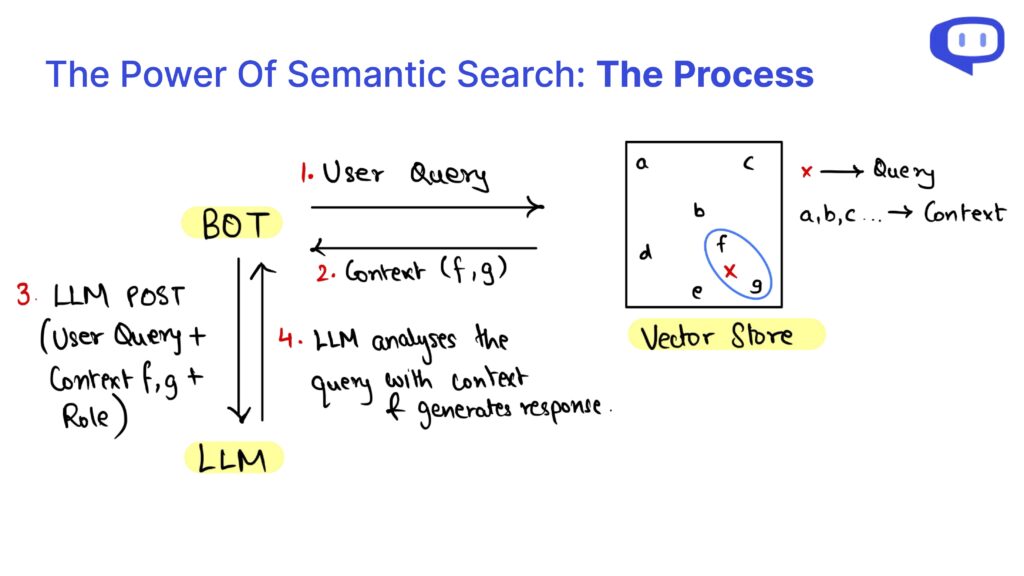

Como os blocos não são estruturados e as consultas podem diferir sintaticamente dos dados da base de conhecimento, os blocos são recuperados usando a pesquisa semântica.

Bancos de dados vetoriais

Os bancos de dados vetoriais, como Pinecone, Chromadb e FAISS, armazenam as incorporações de dados comerciais. Os Embeddings convertem dados textuais em formato numérico com base em seu significado e são armazenados em um espaço vetorial de alta dimensão, onde dados semanticamente semelhantes estão mais próximos.

Quando uma consulta do usuário é feita, os embeddings da consulta são usados para encontrar pedaços semanticamente semelhantes no banco de dados de vetores.

RAG como um serviço

A implementação do RAG em sua empresa pode ser assustadora se você não tiver conhecimento técnico. É nesse ponto que o RAG-as-a-Service (RaaS) entra em ação.

Nós, da meetcody.ai, oferecemos uma solução plug-and-play para suas necessidades comerciais. Basta criar uma conta conosco e começar a trabalhar gratuitamente. Nós cuidamos do chunking, dos bancos de dados de vetores e de todo o processo RAG, proporcionando a você total tranquilidade.

Perguntas frequentes

1. O que é RAG-as-a-Service (RaaS)?

O RAG-as-a-Service (RaaS) é uma solução abrangente que lida com todo o processo de Retrieval Augmented Generation para sua empresa. Isso inclui a fragmentação de dados, o armazenamento de embeddings em bancos de dados vetoriais e o gerenciamento da pesquisa semântica para recuperar dados relevantes para consultas.

2. Como o chunking ajuda no processo RAG?

O Chunking segmenta grandes documentos comerciais em partes menores e gerenciáveis que se encaixam na janela de contexto do LLM. Essa segmentação permite que o LLM processe e recupere informações relevantes com mais eficiência usando a pesquisa semântica.

3. O que são bancos de dados vetoriais e por que eles são importantes?

Os bancos de dados vetoriais armazenam as representações numéricas (embeddings) dos dados de sua empresa. Essas incorporações permitem a recuperação eficiente de dados semanticamente semelhantes quando uma consulta é feita, garantindo respostas precisas e relevantes do LLM.

Integre o RAG à sua empresa com facilidade e eficiência, aproveitando o poder do RAG-as-a-Service. Comece a usar o meetcody.ai hoje mesmo e transforme seu fluxo de trabalho com soluções avançadas de IA generativa.