Em 2025, o mundo da inteligência artificial se tornou muito empolgante, com grandes empresas de tecnologia competindo ferozmente para criar os sistemas de IA mais avançados de todos os tempos. Essa intensa competição gerou muitas ideias novas, ampliando os limites do que a IA pode fazer para pensar, resolver problemas e interagir como os humanos. No último mês, houve melhorias incríveis, com dois participantes principais liderando o caminho: O Gemini 2.5 Pro do Google e o GPT-4.5 da OpenAI. Em uma grande revelação em março de 2025, o Google apresentou o Gemini 2.5 Pro, que eles chamam de sua criação mais inteligente até o momento. Ele rapidamente se tornou o melhor desempenho na tabela de classificação da LMArena, superando seus concorrentes. O que torna o Gemini 2.5 especial é sua capacidade de considerar cuidadosamente as respostas, o que o ajuda a ter um desempenho melhor em tarefas complexas que exigem raciocínio profundo.

Não querendo ficar para trás, a OpenAI lançou o GPT-4.5, seu maior e mais avançado modelo de bate-papo até agora. Esse modelo é excelente para reconhecer padrões, fazer conexões e ter ideias criativas. Os primeiros testes mostram que a interação com o GPT-4.5 é muito natural, graças à sua ampla gama de conhecimentos e à melhor compreensão do que os usuários querem dizer. A OpenAI enfatiza os aprimoramentos significativos do GPT-4.5 no aprendizado sem supervisão direta, projetado para uma colaboração tranquila com humanos.

Esses sistemas de IA não são apenas uma tecnologia impressionante; eles estão mudando a forma como as empresas operam, acelerando as descobertas científicas e transformando projetos criativos. À medida que a IA se torna uma parte normal da vida cotidiana, modelos como o Gemini 2.5 Pro e o GPT-4.5 estão expandindo o que pensamos ser possível. Com melhores habilidades de raciocínio, menos chances de espalhar informações falsas e domínio de problemas complexos, eles estão abrindo caminho para sistemas de IA que realmente apoiam o progresso humano.

Entendendo o Gemini 2.5 Pro

Em 25 de março de 2025, o Google apresentou oficialmente o Gemini 2.5 Pro, descrito como seu “modelo de IA mais inteligente” até o momento. Esse lançamento representou um marco significativo na jornada de desenvolvimento de IA do Google, após várias iterações de seus modelos 2.0. A estratégia de lançamento começou com a versão experimental primeiro, dando aos assinantes do Gemini Advanced acesso antecipado para testar seus recursos.

O que separa o Gemini 2.5 Pro de seus antecessores é sua arquitetura fundamental como um“modelo de pensamento”. Ao contrário das gerações anteriores, que se baseavam principalmente em padrões de dados treinados, esse modelo pode raciocinar ativamente em seus pensamentos antes de responder, imitando os processos humanos de solução de problemas. Isso representa um avanço significativo na forma como os sistemas de IA processam informações e geram respostas.

Principais recursos e capacidades:

- Habilidades de raciocínio aprimoradas – capaz de resolver problemas passo a passo em domínios complexos

- Janela de contexto expandida – capacidade de 1 milhão de tokens (com planos de expansão para 2 milhões)

- Multimodalidade nativa – processa perfeitamente texto, imagens, áudio, vídeo e código

- Recursos avançados de código – Melhorias significativas na criação de aplicativos da Web e na transformação de código

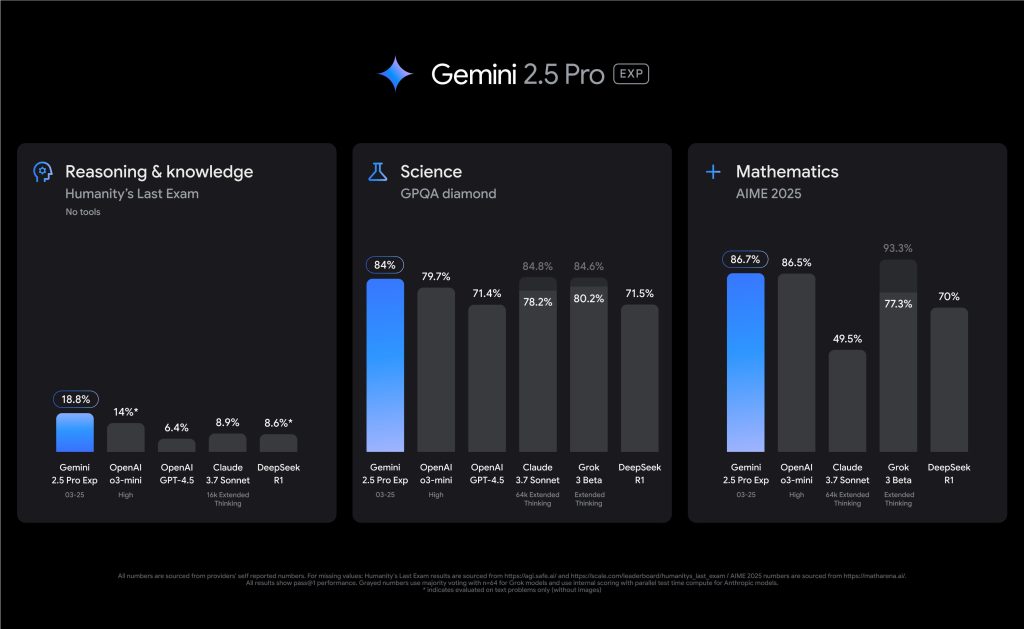

O Gemini 2.5 Pro se estabeleceu como líder em desempenho, estreando na posição número 1 na tabela de classificação da LMArena. Ele se destaca especialmente em benchmarks que exigem raciocínio avançado, obtendo uma pontuação líder do setor de 18,8% no Humanity’s Last Exam sem usar ferramentas externas. Em matemática e ciências, ele demonstra uma competência notável com pontuações de 86,7% no AIME 2025 e 79,7% no GPQA diamond, respectivamente.

Em comparação com os modelos Gemini anteriores, a versão 2.5 Pro representa um avanço substancial. Enquanto o Gemini 2.0 introduziu importantes recursos básicos, o 2.5 Pro combina um modelo básico significativamente aprimorado com técnicas aprimoradas de pós-treinamento. As melhorias mais notáveis aparecem no desempenho da codificação, na profundidade do raciocínio e na compreensão contextual – áreas em que as versões anteriores apresentavam limitações.

Explorando o GPT-4.5

Em abril de 2025, a OpenAI apresentou o GPT-4.5, descrevendo-o como seu “maior e mais avançado modelo de bate-papo até o momento”, o que significa uma conquista notável na evolução de grandes modelos de linguagem. Essa prévia da pesquisa provocou entusiasmo imediato na comunidade de IA, com testes iniciais indicando que as interações com o modelo parecem excepcionalmente naturais, graças à sua ampla base de conhecimento e à capacidade aprimorada de compreender a intenção do usuário.

O GPT-4.5 apresenta avanços significativos nos recursos de aprendizado não supervisionado. A OpenAI realizou esse progresso ao dimensionar a potência computacional e as entradas de dados, além de empregar estratégias inovadoras de arquitetura e otimização. O modelo foi treinado nos supercomputadores de IA do Microsoft Azure, dando continuidade a uma parceria que permitiu à OpenAI ampliar os limites das possibilidades.

Principais aprimoramentos e recursos:

- Reconhecimento aprimorado de padrões – Capacidade significativamente maior de reconhecer padrões, estabelecer conexões e gerar percepções criativas

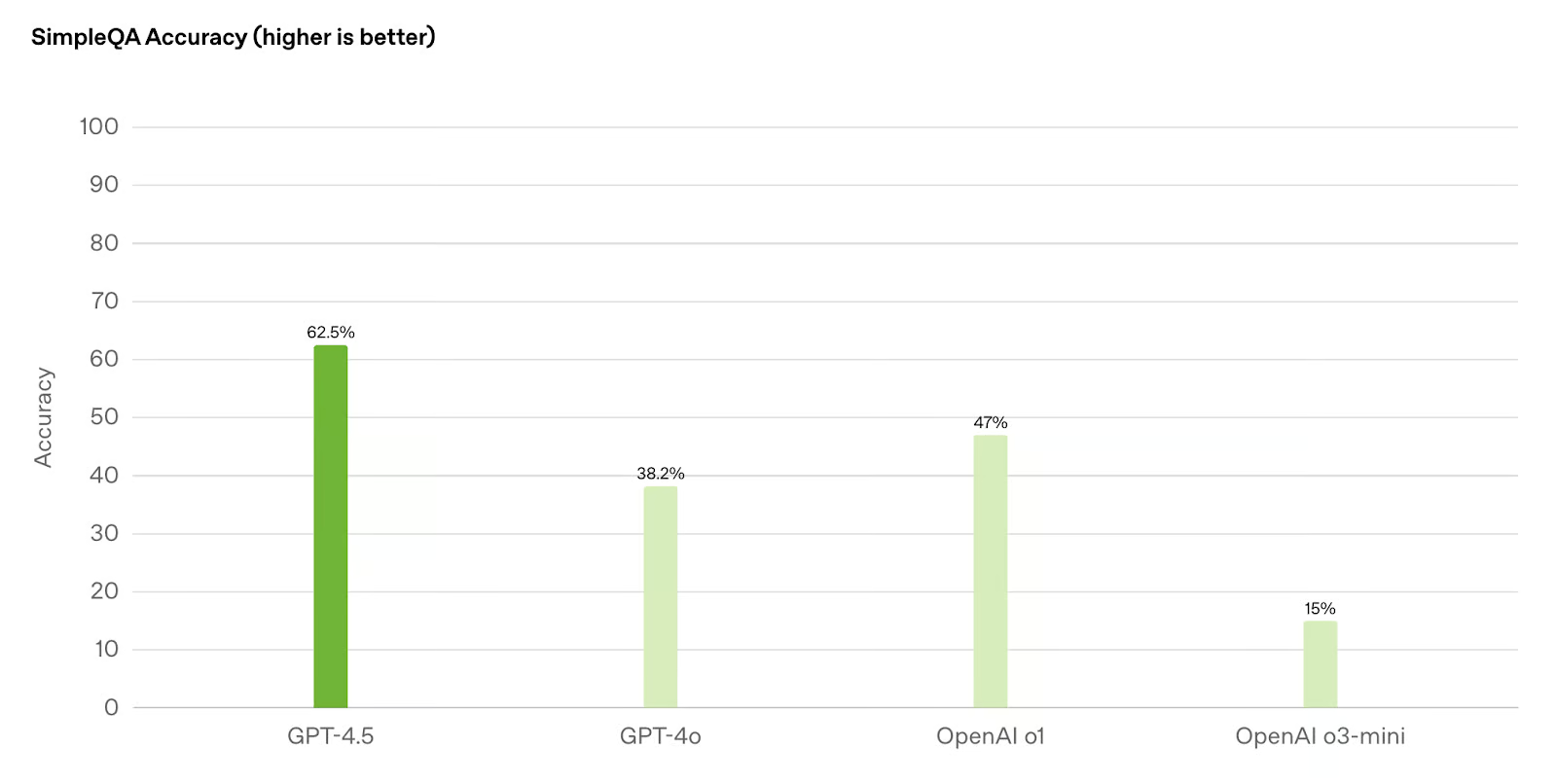

- Alucinações reduzidas – Menor probabilidade de gerar informações falsas em comparação com modelos anteriores como GPT-4o e o1

- Melhoria do “QE” – Maior inteligência emocional e compreensão das interações humanas diferenciadas

- Capacidade de direção avançada – Melhor compreensão e adesão a instruções complexas do usuário

A OpenAI deu ênfase especial ao treinamento do GPT-4.5 para a colaboração humana. Novas técnicas aprimoram a capacidade de direção do modelo, a compreensão das nuances e o fluxo natural da conversa. Isso o torna particularmente eficaz na assistência à escrita e ao design, onde demonstra intuição estética e criatividade mais fortes do que as iterações anteriores.

Em aplicativos do mundo real, o GPT-4.5 demonstra uma versatilidade notável. Sua base de conhecimento ampliada e os recursos de raciocínio aprimorados o tornam adequado para uma ampla gama de tarefas, desde a criação de conteúdo detalhado até a solução de problemas sofisticados. O CEO da OpenAI, Sam Altman, descreveu o modelo em termos positivos, destacando sua “eficácia única”, apesar de não liderar em todas as categorias de benchmark.

A estratégia de implementação do GPT-4.5 reflete a abordagem ponderada da OpenAI para o lançamento de poderosos sistemas de IA. Inicialmente disponível para os assinantes e desenvolvedores do ChatGPT Pro em níveis pagos por meio de várias APIs, a empresa planeja expandir gradualmente o acesso aos assinantes do ChatGPT Plus, Team, Edu e Enterprise. Essa implementação em fases permite que a OpenAI monitore o desempenho e a segurança à medida que o uso aumenta.

Métricas de desempenho: Uma análise comparativa

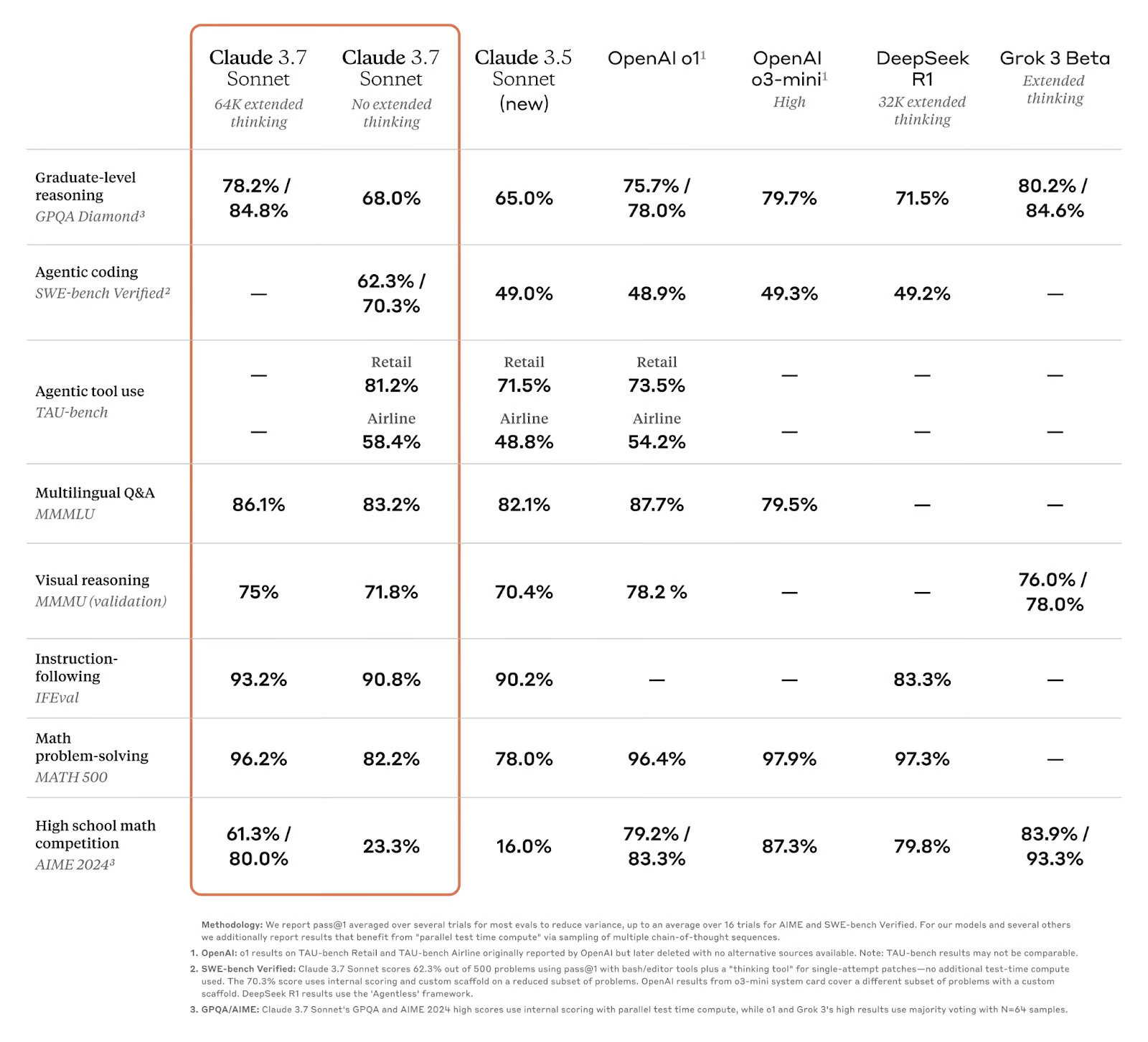

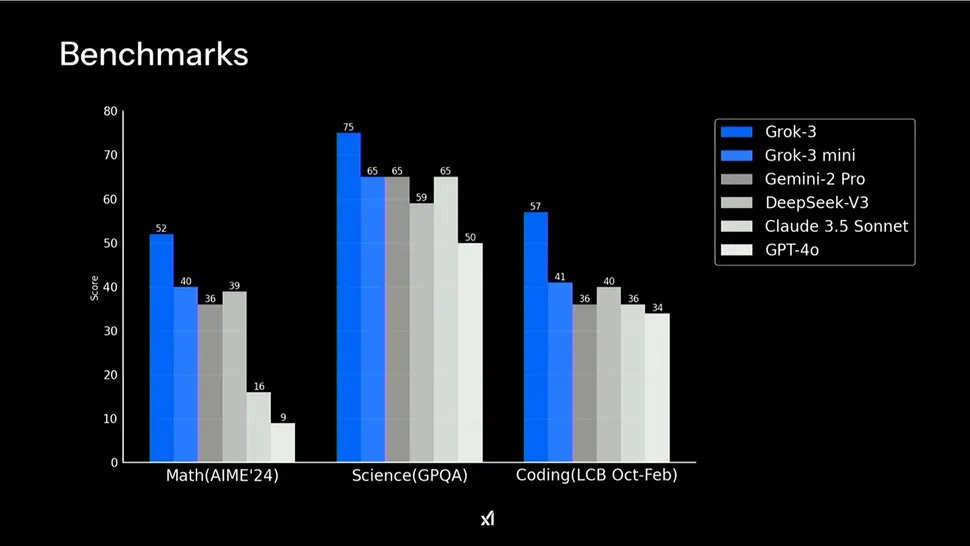

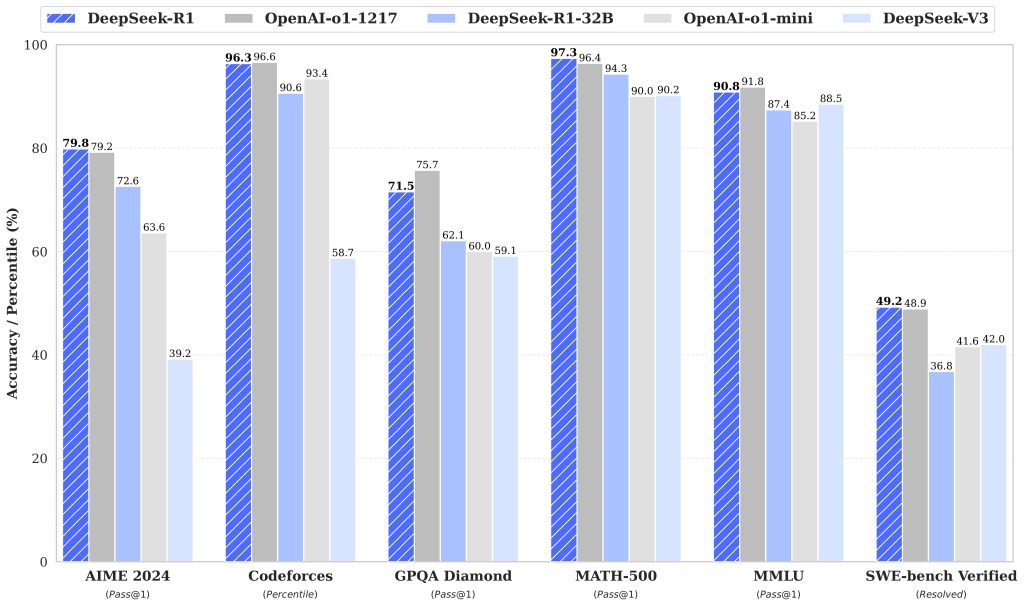

Ao examinar os recursos técnicos desses modelos avançados de IA, o desempenho de benchmark fornece a medida mais objetiva de suas habilidades. O Gemini 2.5 Pro e o GPT-4.5 demonstram pontos fortes exclusivos em vários domínios, com testes de benchmark que revelam suas vantagens distintas.

| Referência | Gemini 2.5 Pro (03-25) | OpenAI GPT-4.5 | Claude 3.7 Sonnet | Grok 3 Preview |

|---|---|---|---|---|

| LMArena (geral) | #1 | 2 | 21 | 2 |

| O Último Exame da Humanidade (sem ferramentas) | 18.8% | 6.4% | 8.9% | – |

| GPQA Diamante (tentativa única) | 84.0% | 71.4% | 78.2% | 80.2% |

| AIME 2025 (tentativa única) | 86.7% | – | 49.5% | 77.3% |

| SWE-Bench Verificado | 63.8% | 38.0% | 70.3% | – |

| Aider Polyglot (Integral/Difuso) | 74.0% / 68.6% | 44,9% diff | 64,9% diff | – |

| MRCR (128k) | 91.5% | 48.8% | – | – |

O Gemini 2.5 Pro mostra uma força excepcional em tarefas de raciocínio intensivo, destacando-se particularmente no raciocínio de contexto longo e na retenção de conhecimento. Ele supera significativamente os concorrentes no Humanity’s Last Exam, que testa a fronteira do conhecimento humano. No entanto, ele apresenta fraquezas relativas na geração de código, codificação agêntica e, ocasionalmente, tem dificuldades com a factualidade em determinados domínios.

O GPT-4.5, por outro lado, demonstra excelência especial em reconhecimento de padrões, geração de insights criativos e raciocínio científico. Seu desempenho é superior ao do benchmark de diamante GPQA, demonstrando fortes capacidades em domínios científicos. O modelo também apresenta inteligência emocional e intuição estética aprimoradas, o que o torna particularmente valioso para aplicativos criativos e voltados para o design. Uma vantagem importante é sua tendência reduzida de gerar informações falsas em comparação com seus antecessores.

Em termos práticos, o Gemini 2.5 Pro representa a melhor opção para tarefas que exigem raciocínio profundo, compreensão multimodal e manipulação de contextos extremamente longos. O GPT-4.5 oferece vantagens no trabalho criativo, na assistência ao design e em aplicativos em que a precisão factual e o fluxo natural de conversação são fundamentais.

Aplicativos e casos de uso

Embora os desempenhos de benchmark forneçam percepções técnicas valiosas, a verdadeira medida desses modelos avançados de IA está em suas aplicações práticas em vários domínios. Tanto o Gemini 2.5 Pro quanto o GPT-4.5 demonstram pontos fortes distintos que os tornam adequados para diferentes casos de uso, com as organizações já começando a aproveitar seus recursos para resolver problemas complexos.

Gemini 2.5 Pro em domínios científicos e técnicos

Os excepcionais recursos de raciocínio e a ampla janela de contexto do Gemini 2.5 Pro o tornam particularmente valioso para pesquisas científicas e aplicações técnicas. Sua capacidade de processar e analisar dados multimodais – incluindo texto, imagens, áudio, vídeo e código – permite lidar com problemas complexos que exigem a síntese de informações de diversas fontes. Essa versatilidade abre inúmeras possibilidades nos setores que exigem precisão técnica e análise abrangente.

- Pesquisa científica e análise de dados – O bom desempenho do Gemini 2.5 Pro em benchmarks como o GPQA (79,7%) demonstra seu potencial para auxiliar os pesquisadores na análise de literatura científica complexa, na geração de hipóteses e na interpretação de resultados experimentais.

- Desenvolvimento e engenharia de software – O modelo se destaca na criação de aplicativos da Web, na realização de transformações de código e no desenvolvimento de programas complexos com uma pontuação de 63,8% no SWE-Bench Verified usando configurações de agentes personalizados

- Diagnóstico médico e assistência médica – Seus recursos de raciocínio permitem a análise de imagens médicas juntamente com dados de pacientes para dar suporte aos profissionais de saúde nos processos de diagnóstico

- Análise de Big Data e gerenciamento de conhecimento – A janela de contexto de 1 milhão de tokens (que será expandida em breve para 2 milhões) permite o processamento de conjuntos de dados e repositórios de código inteiros em um único prompt

Excelência em tarefas criativas e de comunicação do GPT-4.5

Por outro lado, o GPT-4.5 demonstra uma força especial em tarefas que exigem comunicação diferenciada, pensamento criativo e julgamento estético. A OpenAI enfatizou o treinamento desse modelo especificamente para a colaboração humana, resultando em recursos aprimorados para a criação de conteúdo, assistência ao design e comunicação natural.

- Criação de conteúdo e redação – O GPT-4.5 mostra intuição estética e criatividade aprimoradas, o que o torna valioso para gerar textos de marketing, artigos, roteiros e outros conteúdos escritos

- Colaboração no design – A melhor compreensão das nuances e do contexto do modelo o torna um parceiro eficaz nos processos de design, desde a conceituação até o refinamento

- Envolvimento do cliente – Com maior inteligência emocional, o GPT-4.5 fornece respostas mais adequadas e naturais em contextos de atendimento ao cliente

- Desenvolvimento de conteúdo educacional – O modelo é excelente para adaptar as explicações a diferentes níveis de conhecimento e estilos de aprendizagem

Empresas de vários setores já estão integrando esses modelos em seus fluxos de trabalho. A Microsoft incorporou a tecnologia da OpenAI diretamente ao seu pacote de produtos, proporcionando aos usuários corporativos acesso imediato aos recursos do GPT-4.5. Da mesma forma, o Gemini 2.5 Pro do Google está encontrando aplicações em instituições de pesquisa e empresas de tecnologia que buscam aproveitar seus recursos de raciocínio e multimodais.

Os pontos fortes complementares desses modelos sugerem que muitas organizações podem se beneficiar da utilização de ambos, dependendo dos casos de uso específicos. À medida que essas tecnologias continuam a amadurecer, podemos esperar ver aplicativos cada vez mais sofisticados que transformam fundamentalmente o trabalho de conhecimento, os processos criativos e a solução de problemas em todos os setores.

O futuro da IA: o que vem a seguir?

À medida que o Gemini 2.5 Pro e o GPT-4.5 ultrapassam os limites do que é possível, a trajetória futura do desenvolvimento da IA fica mais nítida. O compromisso do Google de “desenvolver recursos de raciocínio diretamente em todos os modelos” sugere um futuro em que o raciocínio se tornará padrão em todos os sistemas de IA. Da mesma forma, a abordagem da OpenAI de “escalonar o aprendizado e o raciocínio não supervisionados” aponta para modelos com recursos cada vez maiores para entender e gerar conteúdo semelhante ao humano.

É provável que nos próximos anos você veja modelos de IA com janelas de contexto muito mais amplas do que os limites atuais, raciocínio mais sofisticado e integração perfeita em todas as modalidades. Também poderemos testemunhar o surgimento de agentes de IA verdadeiramente autônomos, capazes de executar tarefas complexas com o mínimo de supervisão humana. No entanto, esses avanços trazem desafios significativos. À medida que os recursos de IA aumentam, também aumenta a importância de abordar os possíveis riscos relacionados à desinformação, à privacidade e ao deslocamento do trabalho humano.

As considerações éticas devem permanecer na vanguarda do desenvolvimento da IA. A OpenAI reconhece que “cada aumento nos recursos dos modelos é uma oportunidade de torná-los mais seguros”, destacando a dupla responsabilidade do avanço e da proteção. A comunidade de IA precisará desenvolver estruturas de governança robustas que incentivem a inovação e, ao mesmo tempo, protejam contra o uso indevido.

A revolução da IA representada pelo Gemini 2.5 Pro e pelo GPT-4.5 está apenas começando. Embora o ritmo do avanço traga tanto entusiasmo quanto apreensão, uma coisa permanece clara: o futuro da IA será definido não apenas pelas capacidades tecnológicas, mas pela forma como escolhermos aproveitá-las para o benefício humano. Ao priorizar o desenvolvimento responsável que aumenta o potencial humano em vez de substituí-lo, podemos garantir que a próxima geração de modelos de IA sirva como ferramentas poderosas para o progresso coletivo.