RAG jako usługa: Odblokuj generatywną sztuczną inteligencję dla swojej firmy

Wraz z rozwojem dużych modeli językowych (LLM) i trendów generatywnej sztucznej inteligencji, integracja rozwiązań generatywnej sztucznej inteligencji w firmie może zwiększyć wydajność przepływu pracy. Jeśli dopiero zaczynasz przygodę z generatywną sztuczną inteligencją, mnogość żargonu może być onieśmielająca. Ten blog objaśni podstawową terminologię generatywnej sztucznej inteligencji i poprowadzi Cię, jak rozpocząć korzystanie z niestandardowego rozwiązania AI dla Twojej firmy dzięki usłudze RAG-as-a-Service.

Czym jest Retrieval Augmented Generation (RAG)?

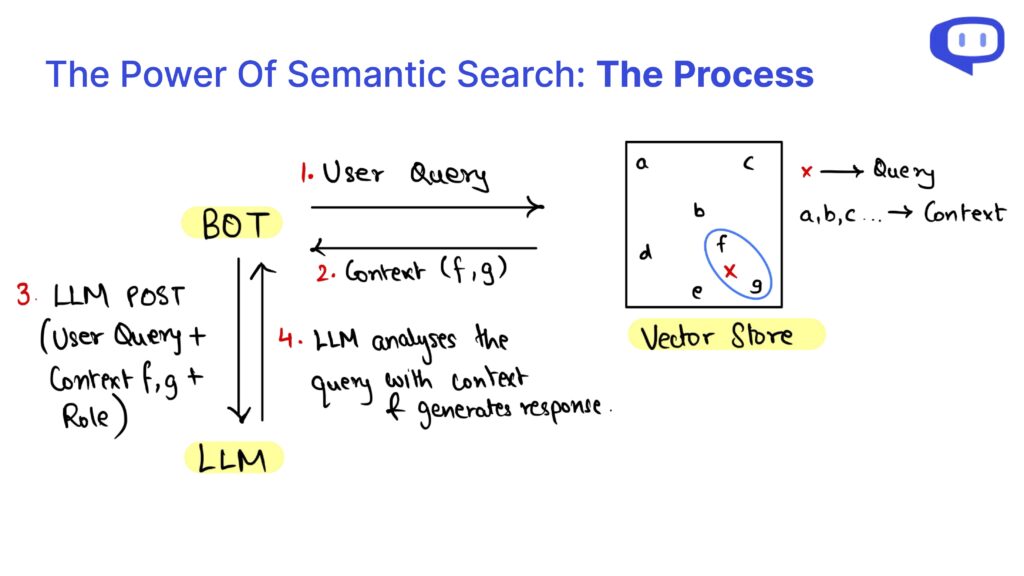

Retrieval Augmented Generation (RAG) jest kluczową koncepcją we wdrażaniu LLM lub generatywnej sztucznej inteligencji w biznesowych przepływach pracy. RAG wykorzystuje wstępnie wytrenowane modele Transformer, aby odpowiadać na zapytania związane z biznesem, wstrzykując odpowiednie dane z określonej bazy wiedzy do procesu zapytania. Dane te, na których LLM mogły nie zostać przeszkolone, są wykorzystywane do generowania dokładnych i trafnych odpowiedzi.

RAG jest zarówno opłacalny, jak i wydajny, dzięki czemu generatywna sztuczna inteligencja jest bardziej dostępna. Przyjrzyjmy się kilku kluczowym terminologiom związanym z RAG.

Kluczowe terminologie w RAG

Chunking

LLM wymagają dużych zasobów i są szkolone na zarządzalnych długościach danych znanych jako “okno kontekstowe”. Okno kontekstu różni się w zależności od używanego LLM. Aby zaradzić tym ograniczeniom, dane biznesowe dostarczane jako dokumenty lub literatura tekstowa są dzielone na mniejsze fragmenty. Fragmenty te są wykorzystywane podczas procesu wyszukiwania zapytań.

Ponieważ fragmenty są nieustrukturyzowane, a zapytania mogą różnić się składniowo od danych bazy wiedzy, fragmenty są pobierane za pomocą wyszukiwania semantycznego.

Wektorowe bazy danych

Wektorowe bazy danych, takie jak Pinecone, Chromadb i FAISS, przechowują osadzone dane biznesowe. Embeddings konwertują dane tekstowe na postać numeryczną w oparciu o ich znaczenie i są przechowywane w wielowymiarowej przestrzeni wektorowej, w której semantycznie podobne dane są bliżej siebie.

Gdy użytkownik zadaje zapytanie, osadzenie zapytania jest wykorzystywane do znalezienia semantycznie podobnych fragmentów w wektorowej bazie danych.

RAG jako usługa

Wdrożenie RAG w firmie może być zniechęcające, jeśli brakuje wiedzy technicznej. W tym miejscu do gry wkracza usługa RAG-as-a-Service (RaaS).

W meetcody. ai oferujemy rozwiązanie plug-and-play dla Twoich potrzeb biznesowych. Po prostu załóż konto i zacznij grać za darmo. Zajmujemy się chunkingiem, wektorowymi bazami danych i całym procesem RAG, zapewniając całkowity spokój ducha.

Najczęściej zadawane pytania

1. Czym jest usługa RAG-as-a-Service (RaaS)?

RAG-as-a-Service (RaaS) to kompleksowe rozwiązanie, które obsługuje cały proces Retrieval Augmented Generation dla Twojej firmy. Obejmuje to dzielenie danych, przechowywanie osadzeń w wektorowych bazach danych i zarządzanie wyszukiwaniem semantycznym w celu pobierania odpowiednich danych do zapytań.

2. W jaki sposób chunking pomaga w procesie RAG?

Chunking dzieli duże dokumenty biznesowe na mniejsze, łatwe do zarządzania części, które mieszczą się w oknie kontekstowym LLM. Segmentacja ta pozwala LLM na bardziej efektywne przetwarzanie i pobieranie istotnych informacji za pomocą wyszukiwania semantycznego.

3. Czym są wektorowe bazy danych i dlaczego są ważne?

Wektorowe bazy danych przechowują numeryczne reprezentacje (osadzenia) danych biznesowych. Osadzenia te pozwalają na efektywne pobieranie semantycznie podobnych danych w przypadku zapytania, zapewniając dokładne i trafne odpowiedzi z LLM.

Zintegruj RAG ze swoją firmą z łatwością i wydajnością, wykorzystując moc RAG jako usługi. Rozpocznij pracę z meetcody.ai już dziś i przekształć swój przepływ pracy dzięki zaawansowanym rozwiązaniom generatywnej sztucznej inteligencji.