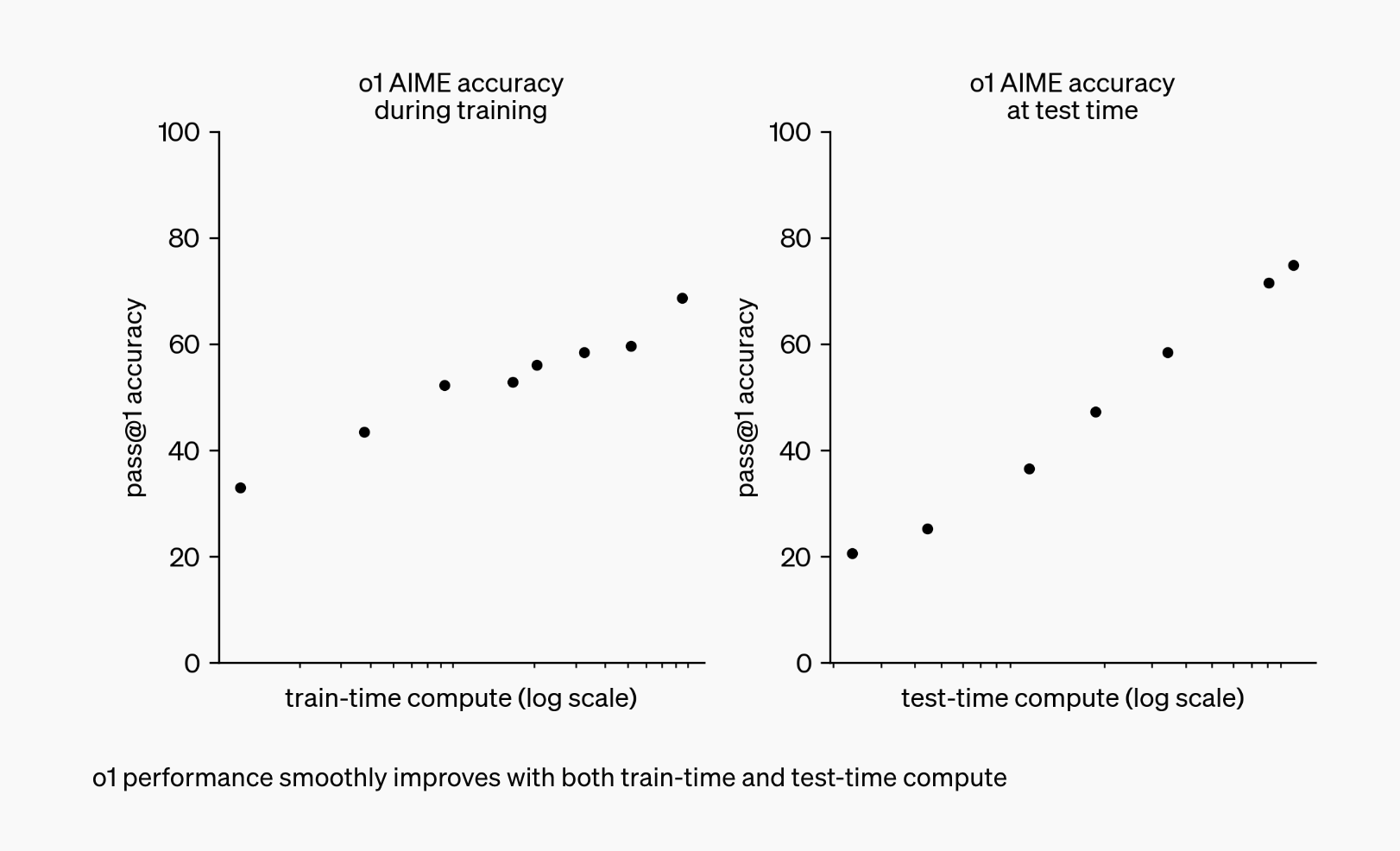

W przełomowym posunięciu, OpenAI niedawno zakończyło 12-dniowe wydarzenie, które poruszyło świat sztucznej inteligencji. Najważniejszym punktem tego wydarzenia było wprowadzenie modeli OpenAI o3, nowej rodziny modeli rozumowania AI, która obiecuje zmienić krajobraz sztucznej inteligencji. Na czele tej serii znajdują się dwa niezwykłe modele: o1 i o3. Modele te stanowią znaczący krok naprzód w stosunku do swojego poprzednika, GPT-4, prezentując zwiększoną inteligencję, szybkość i możliwości multimodalne. Model o1, który jest teraz dostępny dla subskrybentów Plus i Pro, oferuje o 50% szybszy czas przetwarzania i popełnia o 34% mniej poważnych błędów w porównaniu z wersją zapoznawczą. Jednak to model o3 naprawdę przesuwa granice rozumowania AI. Dzięki zaawansowanym możliwościom poznawczym i złożonym umiejętnościom rozwiązywania problemów, o3 stanowi znaczący krok w kierunku sztucznej inteligencji ogólnej (AGI). Model ten wykazał się bezprecedensową wydajnością w kodowaniu, matematyce i rozumowaniu naukowym, wyznaczając nowe standardy w tej dziedzinie. Seria o wyznacza kluczowy moment w rozwoju sztucznej inteligencji, nie tylko ze względu na imponujące możliwości, ale także skupienie się na bezpieczeństwie i dostosowaniu do ludzkich wartości. Gdy zagłębiamy się w specyfikę tych modeli, staje się jasne, że OpenAI nie tylko rozwija technologię AI, ale także nadaje priorytet odpowiedzialnemu i etycznemu rozwojowi AI.

OpenAI o3 vs o1: Analiza porównawcza

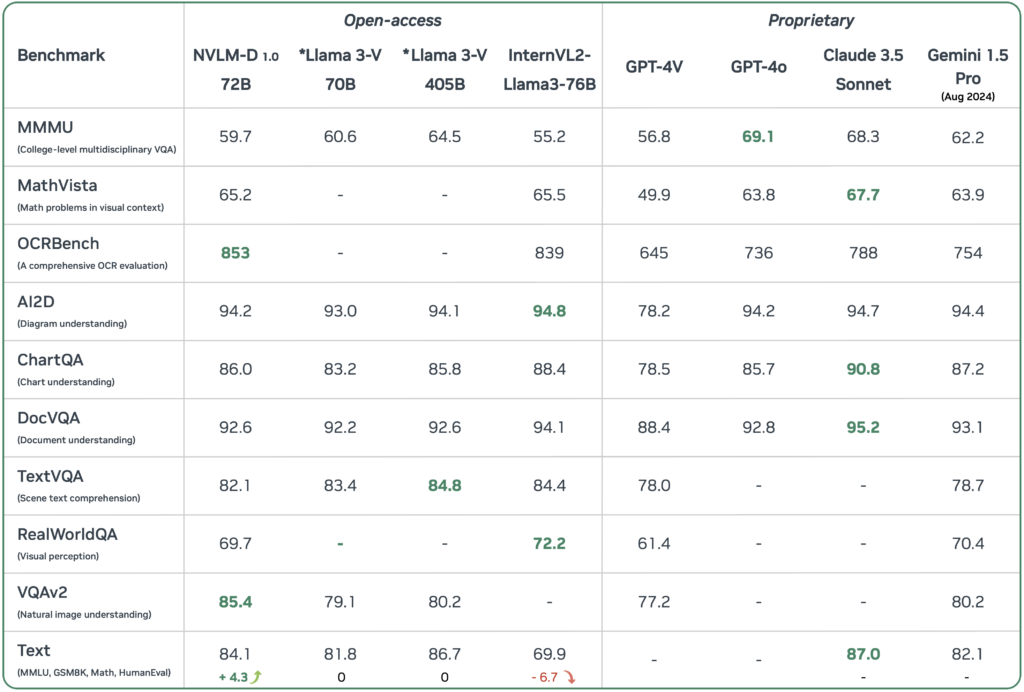

Chociaż zarówno o1, jak i o3 stanowią znaczący postęp w rozumowaniu sztucznej inteligencji, różnią się one znacznie pod względem możliwości, wydajności i opłacalności. Aby lepiej zrozumieć te różnice, przyjrzyjmy się analizie porównawczej tych modeli.

| Metryczny | o3 | o1 Podgląd |

|---|---|---|

| Wynik Codeforces | 2727 | 1891 |

| Wynik SWE-bench | 71.7% | 48.9% |

| Wynik AIME 2024 | 96.7% | N/A |

| Diamentowy wynik GPQA | 87.7% | 78% |

| Okno kontekstu | 256K tokenów | 128 tys. tokenów |

| Maksymalna liczba tokenów wyjściowych | 100K | 32K |

| Szacowany koszt zadania | $1,000 | $5 |

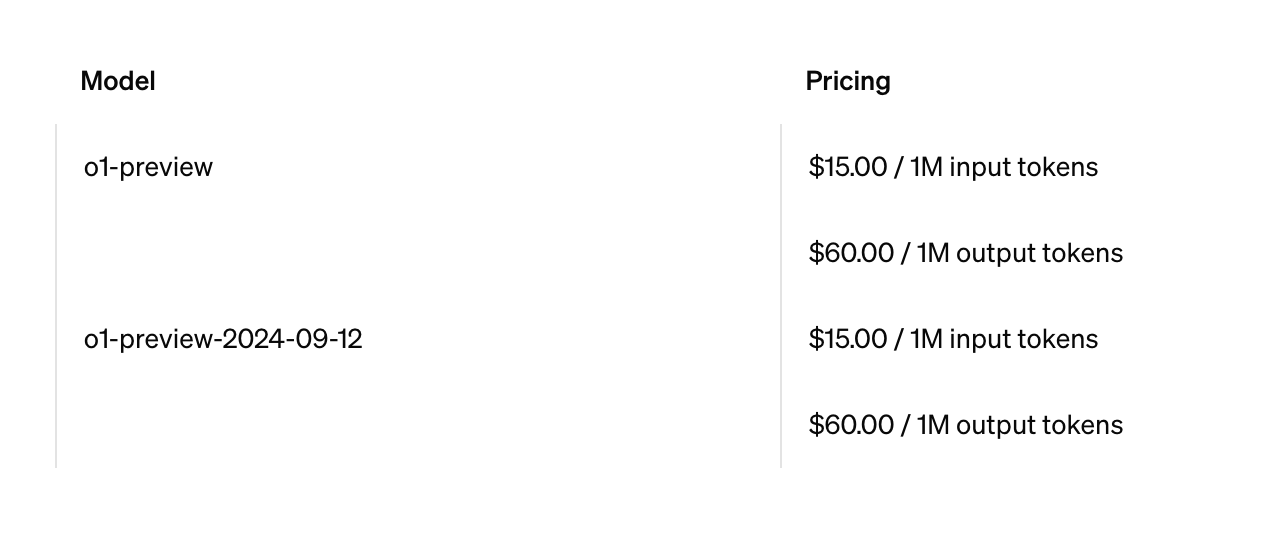

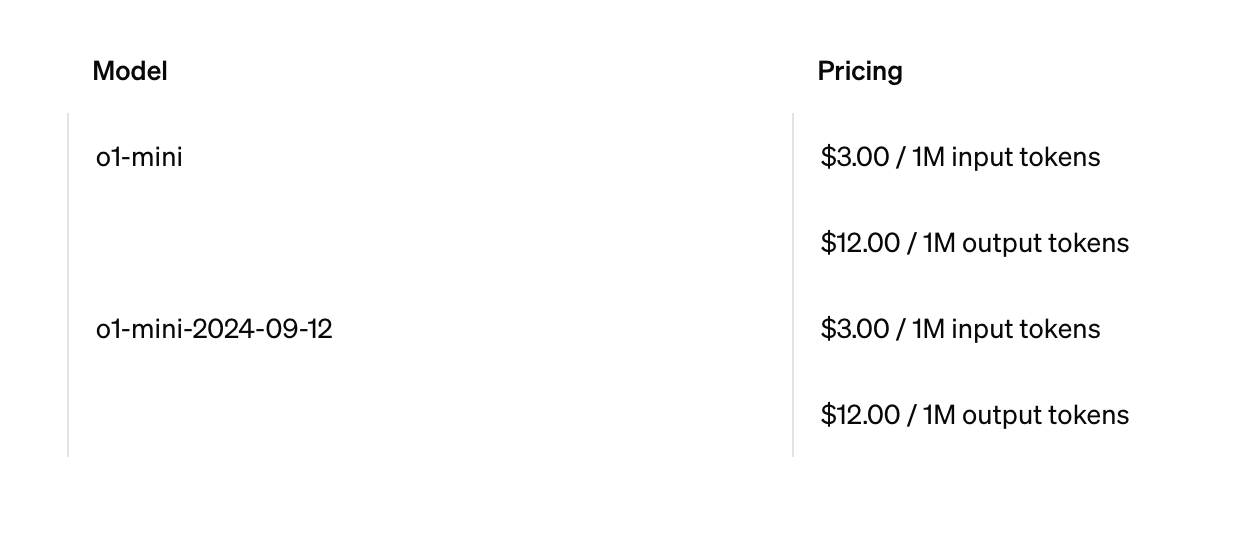

Jak wynika z porównania, o3 znacznie przewyższa o1 Preview w różnych testach porównawczych. Jednak ta doskonała wydajność wiąże się ze znacznymi kosztami. Szacowany koszt 1000 USD za zadanie dla O3 przewyższa 5 USD za zadanie dla O1 Preview i zaledwie centy dla O1 Mini. Biorąc pod uwagę te różnice, wybór między o3 i o1 w dużej mierze zależy od złożoności zadania i ograniczeń budżetowych. o3 najlepiej nadaje się do złożonego kodowania, zaawansowanej matematyki i zadań naukowych, które wymagają jego doskonałych możliwości rozumowania. Z drugiej strony, o1 Preview jest bardziej odpowiedni do szczegółowego kodowania i analizy prawnej, podczas gdy O1 Mini jest idealny do szybkiego, wydajnego kodowania zadań z podstawowymi wymaganiami dotyczącymi rozumowania.

Źródło: OpenAI

Uznając potrzebę znalezienia rozwiązania pośredniego, OpenAI wprowadziła o3 Mini. Model ten ma na celu wypełnienie luki między wysokowydajnym o3 i bardziej ekonomicznym o1 Mini, oferując równowagę między zaawansowanymi możliwościami i rozsądnymi kosztami obliczeniowymi. Podczas gdy szczegółowe informacje na temat o3 Mini wciąż się pojawiają, obiecuje on zapewnić opłacalne rozwiązanie dla zadań, które wymagają bardziej zaawansowanego rozumowania niż o1 Mini, ale nie gwarantują pełnej mocy obliczeniowej o3.

Bezpieczeństwo i celowe dostosowanie w OpenAI o3

W miarę jak modele sztucznej inteligencji, takie jak o1 i o3, stają się coraz potężniejsze, zapewnienie ich zgodności z ludzkimi wartościami i protokołami bezpieczeństwa staje się sprawą najwyższej wagi. OpenAI jest pionierem nowego paradygmatu bezpieczeństwa zwanego “celowym dostosowaniem”, aby rozwiązać te obawy.

- Deliberatywne dostosowanie to wyrafinowane podejście.

- Trenuje modele sztucznej inteligencji, aby odwoływały się do polityki bezpieczeństwa OpenAI podczas fazy wnioskowania.

- Proces ten obejmuje mechanizm łańcucha myśli.

- Modele wewnętrznie rozważają, jak bezpiecznie reagować na podpowiedzi.

- Znacznie poprawia to ich zgodność z zasadami bezpieczeństwa.

- Zmniejsza to prawdopodobieństwo niebezpiecznych reakcji.

Wdrożenie deliberatywnego dopasowania w modelach o1 i o3 przyniosło obiecujące rezultaty. Modele te wykazują zwiększoną zdolność do odpowiadania na bezpieczne pytania, jednocześnie odrzucając niebezpieczne, przewyższając inne zaawansowane modele w opieraniu się powszechnym próbom ominięcia środków bezpieczeństwa. Aby jeszcze bardziej zapewnić bezpieczeństwo i niezawodność tych modeli, OpenAI przeprowadza rygorystyczne wewnętrzne i zewnętrzne testy bezpieczeństwa dla o3 i o3 mini. Zewnętrzni badacze zostali zaproszeni do udziału w tym procesie, a aplikacje są otwarte do 10 stycznia. To wspólne podejście podkreśla zaangażowanie OpenAI w rozwój sztucznej inteligencji, która jest nie tylko potężna, ale także zgodna z ludzkimi wartościami i względami etycznymi.

Współpraca i przyszły rozwój

Opierając się na swoim zaangażowaniu w bezpieczeństwo i etyczny rozwój sztucznej inteligencji, OpenAI aktywnie angażuje się we współpracę i planuje przyszłe postępy dla swoich modeli z serii o. Nawiązano znaczące partnerstwo z Arc Price Foundation, koncentrując się na opracowywaniu i udoskonalaniu testów porównawczych AI. OpenAI nakreśliło ambitną mapę drogową dla modeli z serii o. Firma planuje uruchomić o3 mini do końca stycznia, a wkrótce potem pełną wersję o3, w zależności od opinii i wyników testów bezpieczeństwa. Te premiery wprowadzą ekscytujące nowe funkcje, w tym możliwości API, takie jak wywoływanie funkcji i ustrukturyzowane wyjścia, szczególnie korzystne dla programistów pracujących nad szeroką gamą aplikacji. Zgodnie ze swoim podejściem opartym na współpracy, OpenAI aktywnie poszukuje opinii użytkowników i udziału w procesach testowania. Zewnętrzni badacze zostali zaproszeni do ubiegania się o testy bezpieczeństwa do 10 stycznia, podkreślając zaangażowanie firmy w dokładną ocenę i udoskonalanie swoich modeli. To otwarte podejście rozciąga się na rozwój nowych funkcji dla warstwy Pro, która skupi się na zadaniach wymagających dużej mocy obliczeniowej, jeszcze bardziej rozszerzając możliwości serii o. Wspierając tę współpracę i utrzymując otwarty dialog z użytkownikami i badaczami, OpenAI nie tylko rozwija swoją technologię sztucznej inteligencji, ale także zapewnia, że postępy te są zgodne z szerszymi potrzebami społecznymi i względami etycznymi. Takie podejście stawia modele z serii O na czele odpowiedzialnego rozwoju sztucznej inteligencji, torując drogę do transformacyjnych zastosowań w różnych dziedzinach.

Przyszłość rozumowania AI

Wprowadzenie modeli OpenAI z serii o stanowi kamień milowy w ewolucji rozumowania AI. Dzięki o3 wykazującemu bezprecedensową wydajność w różnych testach porównawczych, w tym 87,5% wynik w teście ARC-AGI, jesteśmy świadkami skoku w kierunku bardziej wydajnych i wyrafinowanych systemów AI. Postępy te podkreślają jednak kluczowe znaczenie ciągłych badań i rozwoju w zakresie bezpieczeństwa AI. OpenAI przewiduje przyszłość, w której rozumowanie AI nie tylko przesuwa granice osiągnięć technologicznych, ale także pozytywnie wpływa na społeczeństwo. Ciągła współpraca z partnerami zewnętrznymi, takimi jak Arc Price Foundation, oraz nacisk na opinie użytkowników świadczą o zaangażowaniu OpenAI we wspólne i przejrzyste podejście do rozwoju sztucznej inteligencji. Ponieważ stoimy u progu potencjalnie transformacyjnych możliwości AI, nie można przecenić znaczenia aktywnego uczestnictwa w procesie rozwoju. OpenAI nadal zachęca badaczy i użytkowników do angażowania się w testy i przekazywania informacji zwrotnych, zapewniając, że ewolucja rozumowania AI jest zgodna z szerszymi potrzebami społecznymi i względami etycznymi. Ta wspólna podróż w kierunku zaawansowanego rozumowania AI niesie ze sobą obietnicę odblokowania nowych granic w rozwiązywaniu problemów i innowacji, kształtując przyszłość, w której AI i ludzka inteligencja działają w harmonii.

W porównaniu do swoich poprzedników, oba modele charakteryzują się lepszą opłacalnością.

W porównaniu do swoich poprzedników, oba modele charakteryzują się lepszą opłacalnością.