GPT-3.5 16Kの威力

Codyの有料版にアップグレードするべきか? その理由は以下の通りだ。

数日前、OpenAIのリリース直後に、すべての有料ユーザー向けに新しいモデルをリリースしました:GPT-3.5 16kです。 気後れするように聞こえるかもしれないが、それはあなたのビジネスにとって画期的なことかもしれない。 このブログでは、GPT-3.5 16kの使用例を掘り下げ、その利点を探り、既存のGPT-3.5モデルや最新の上位モデルGPT-4との違いを強調します。

GPT-3.5 16Kとは?

Codyの無料版を使ったことがある人なら、OpenAIのgpt-3.5-turbo モデルを利用したGPT-3.5のバニラモデルをすでに知っているかもしれない。 このモデルは、ほとんどの場合、手頃な価格、スピード、信頼性を提供するため、多くのユーザーに人気のある選択肢である。 一方、GPT-3.5-16kはOpenAIのgpt-3.5-turbo-16k 。これはgpt-3.5-turbo を拡張したモデルである。 大きな違いは「16K」という点にある。

16Kとは?

16K」という接尾辞は、モデルが16,000トークンのコンテキスト・ウィンドウを持つことを示す。 前回のブログでは、トークンとは何かについて詳しく説明した。 モデルのコンテキストウィンドウを小さくすると、以下のようないくつかの制限が生じる:

- 関連性の欠如:コンテキストウィンドウが限られているため、会話やタスクの幅広いコンテキストとの関連性を捉え、維持するのに苦労する可能性がある。

- 文脈を維持できない:コンテキストウィンドウが小さいと、モデルが会話の前の部分の情報を覚えて参照することが難しくなり、矛盾が生じたり、首尾一貫した対話を維持することが難しくなります。

- 入力クエリの長さの制約:コンテキストウィンドウが短くなると、入力クエリの長さに制約が生じ、包括的な情報を提供したり、複雑な質問をしたりすることが難しくなる。

- 知識ベースのコンテキストの制限:コンテキスト・ウィンドウが小さいと、データ取り込みの制限により、知識から関連文書からの知識を取り込むことに限界が生じる可能性がある。

大きなコンテキストウィンドウの利点

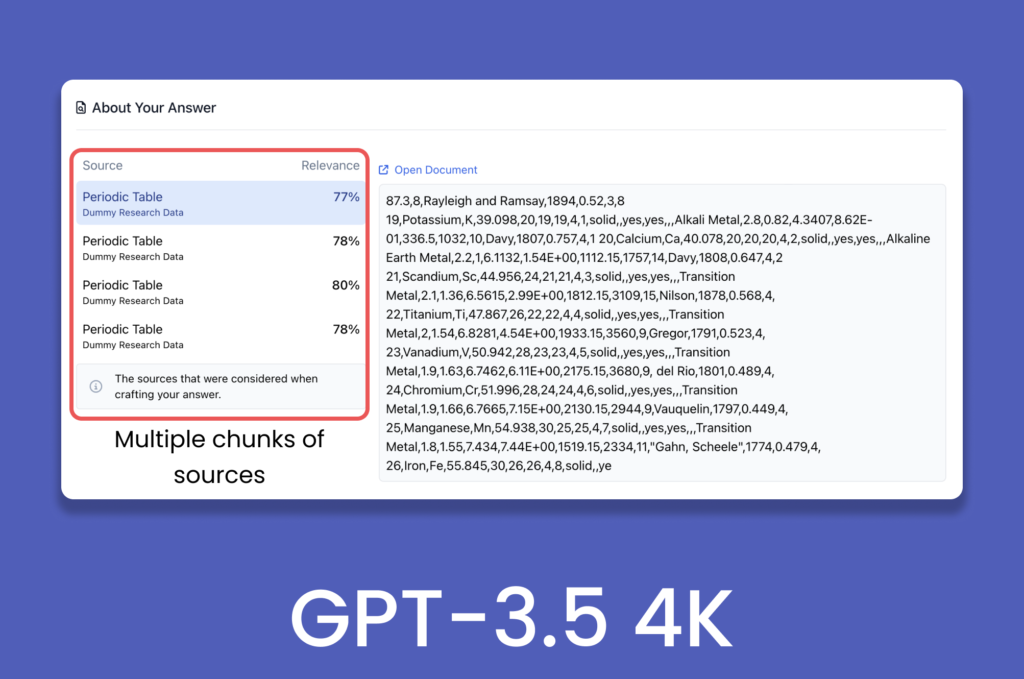

GPT-3.5は4096トークンしか持たないにもかかわらず、どうして1000以上のウェブページや文書をコーディで処理できるのだろう? 生成AI分野の進歩により、コンテキストを提供することは、GPT-3.5ターボのような言語モデルに文書全体をそのまま送り込むことを意味しない。 チャンキング、埋め込み、ベクトルデータベースなどのバックエンド処理は、データの前処理に利用され、チャンク内の関連性を維持し、モデルが事前に定義されたコンテキストウィンドウをナビゲートできるようにする。

現在のシナリオでは、より大きなコンテキスト・ウィンドウは、より大きく複雑な入力に対応することで、AIの全体的なパフォーマンスを向上させると同時に、応答を生成するために必要なベクトル・ストレージ・トランザクションの数を減らすことができる。 コンテキストウィンドウは入力と出力の両方を含むので、ウィンドウを大きくすれば、会話コンテキストを維持しながら、精巧で首尾一貫した応答を提供することも可能になる。

コンテキストウィンドウを大きくすれば、会話中のトークン制限を超えたときに起こる幻覚を軽減することもできる。

GPT-3.5ターボ16K対GPT-4

gpt-3.5-turbo-16k はOpenAIの最新リリースだが、gpt-4 は、視覚的コンテキストの理解、創造性の向上、一貫性、多言語性能など、さまざまな面で依然としてOpenAIを凌駕している。 GPT-3.5-16kが優れている唯一の分野はコンテキストウィンドウで、GPT-4は現在8kのバリアントで利用可能で、32kのバリアントはまだ徐々に展開されている。

一方、32k版gpt-4 が広く普及するまでは、より大きなコンテキスト・ウィンドウを持つGPT-3.5-16kが傑出している。 より広範なコンテキストウィンドウを提供するモデルを特にお探しなら、GPT-3.5-16kが理想的な選択です。

大きなコンテキストウィンドウの使用例

- カスタマーサポート: コンテキストウィンドウを大きくすることで、モデルの短期記憶が強化され、カスタマーサポート、フォーム入力、ユーザーデータ収集などのアプリケーションに適しています。 これによって、モデルはより長い期間にわたってコンテキストを維持することができ、名前、顧客ID、苦情、フィードバックなどのユーザー入力に対して、より適切な応答を導くことができる。

- 従業員トレーニング 従業員トレーニングにCodyを活用することは非常に効果的である。 従業員トレーニングには、業務活動、ステップ、プロセスに関連する膨大なデータが含まれることが多い。 トレーニングプログラム全体を通して文脈の関連性を維持するためには、訓練生の会話履歴をすべて取り入れる必要がある。 コンテキストウィンドウを大きくすることで、より多くの履歴情報を含めることができ、より包括的で効果的なトレーニング体験が可能になる。

- データ分析: 財務分析や統計的推論を含むタスクでは、意味のある洞察を導き出すために大量のデータを処理する必要があることが多い。 コンテキストウィンドウを大きくすることで、モデルは計算中により多くの関連情報を保持することができ、その結果、より首尾一貫した正確な分析が可能になる。 例えば、貸借対照表や企業全体の業績を前年比で比較する場合、より大きなコンテクスト・ウィンドウがあれば、より効果的に実行できる。

GPT-3.5 4Kと16Kの比較

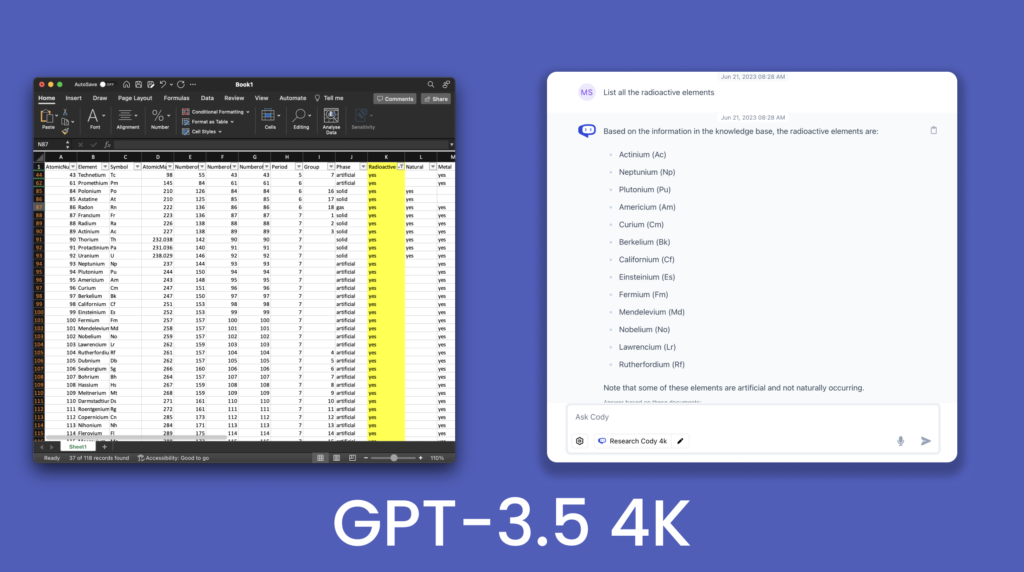

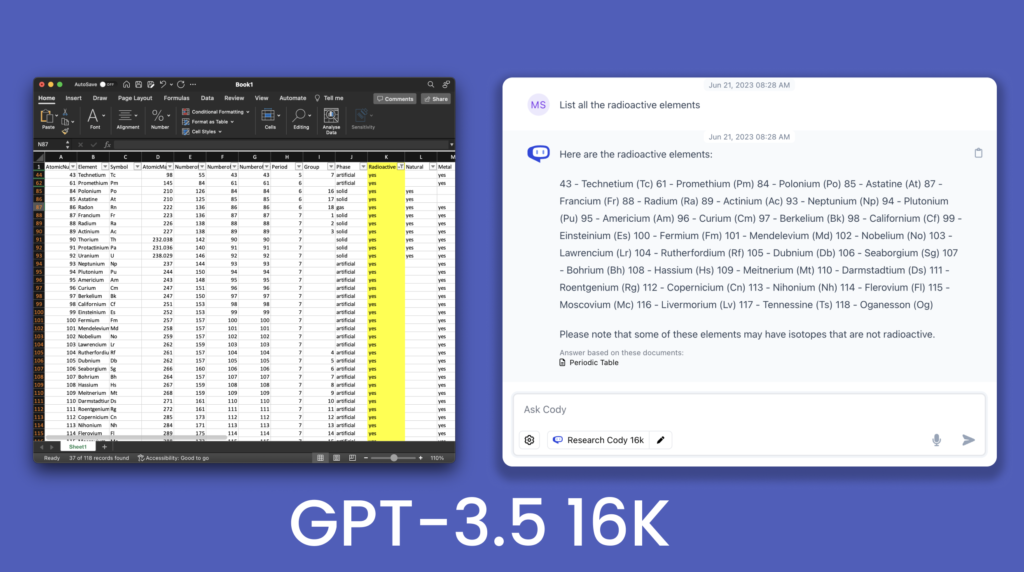

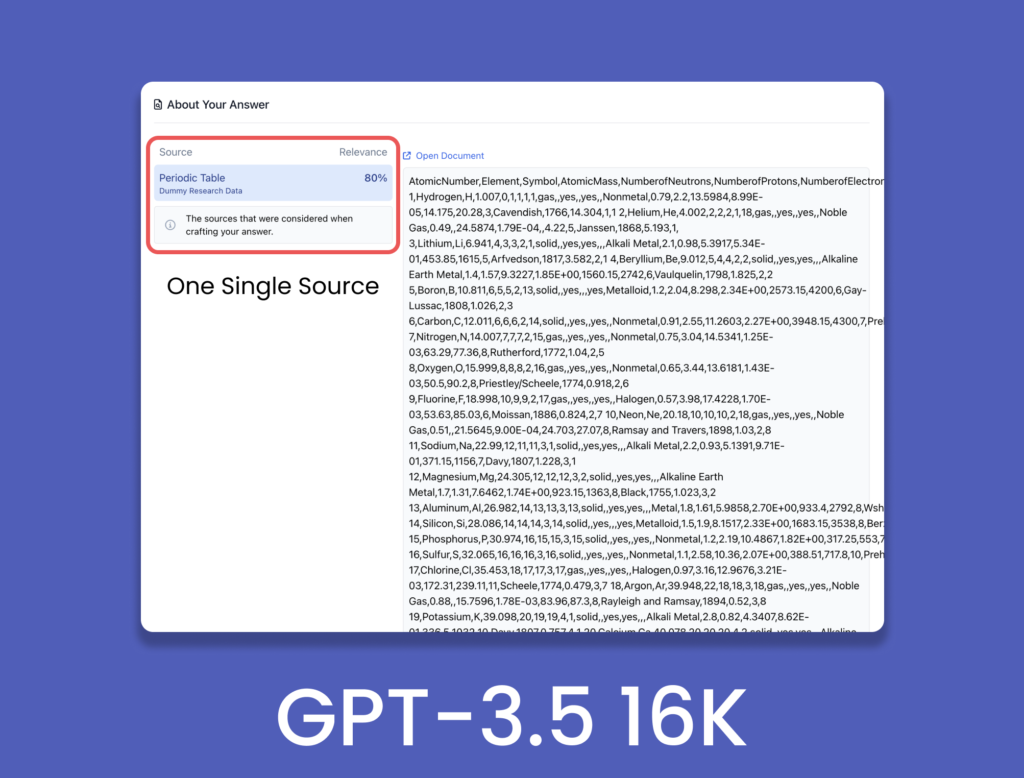

16Kモデルでの改良を実証するために、118の元素とその特徴を含む周期表の.csv ファイルを照会した。

この比較から、GPT-3.5 4Kはすべての放射性元素を反応させることができず、いくつかの元素をスキップしていることがわかる。 対照的に、GPT-3.5 16Kは、提供された表に存在するほとんどすべての放射性元素を生成した。 これは、コンテクストウィンドウを大きくしたことによって、回答の精緻さが向上したことを示している。 これは、16Kコンテキスト・ウィンドウが持つ可能性をほんの少し垣間見たに過ぎず、その応用や実装は無限にある。 GPT-4 32Kがパイプラインにあれば、16Kモデルはより大きなコンテキスト・ウィンドウへの移行をスムーズにすることができる。

アップグレードすべきか?

より大きなコンテキスト・ウィンドウは間違いなく重要なアップデートであり、単なるギミックではない。 文脈理解の向上は、応答の質を高める上で重要な役割を果たし、より大きな文脈ウィンドウは、言語モデルモデル(LLM)の大きな可能性を解き放つ。 会話の履歴や文脈上の手がかりをより広範囲に把握できるようにすることで、LLMはより正確で文脈に適したアウトプットを提供できる。

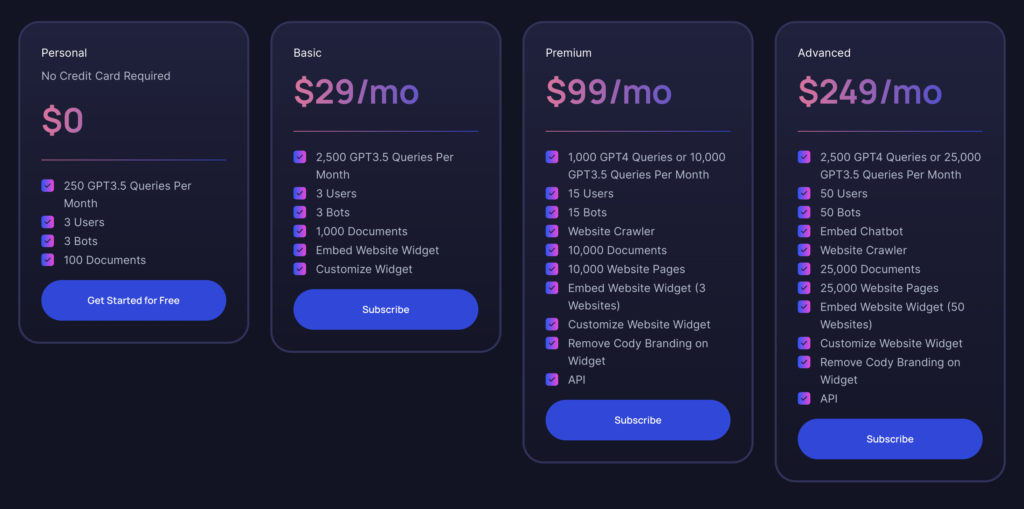

前述したように、GPT-3.5の16Kバリアントは、ベーシックプランからすべてのユーザーが利用できる。 パーソナル(無料)プランを以前から使っている人なら、コーディが提供する機能はすでに体験済みだろう。 ベーシックプランは、GPT-4の追加機能を必要としない場合、特に優れたコストパフォーマンスを発揮します。 GPT-3.5 16Kのモデル選択が追加され、プロジェクトやビジネスのプロトタイプとしてボットを製作する個人に適している。 将来、GPT-4 32K バリアントをリリースする際、より多くのトークンが必要になった場合は、いつでもプレミアムプランにアップグレードすることができます。

大企業向けのアドバンスド・プランは、最も強力なオプションで、リソース集約的で大容量の使用要件に対応します。 大規模なオペレーションに対応する包括的な機能を備えている。