LLaMA 2:メタのオープンソースAIモデル

街で最も新しいLLMは宣伝に値するか?

数日前、メタ社はマイクロソフト社とのコラボレーションにより、LLMの最新バージョン「ラマ2」をリリースした。 LLMの宣伝文句を追いかけている人なら、すでに耳にしたり、新機能について読んだりしているかもしれない。 物事を単純化するために、Llama 2がこれほど大評判になっている4つの理由と、いくつかの最高のLLMとの比較を列挙する。

研究・商用利用無料

Llama 2が人々の興味を引いた大きな理由のひとつは、メタ社が特定の条件がある一部の大企業を除き、ほぼすべての人に全モデルを無料にしたことだ。 この動きは、起業やジェネレーティブAIの世界への進出を考えている個人にエキサイティングな機会を提供する。 今こそAIの世界に飛び込む絶好の機会であり、特にこのレベルの言語モデルが自由に利用できるのだから。 オープンソースのモデルはすでに複数存在していたが、メタ社のような大企業が作ったものはなく、GPTの直接の競争相手にはなり得なかった。

「BLOOM(Scaoら、2022)、LLaMa-1(Touvronら、2023)、Falcon(Penedoら、2023)など、GPT-3(Brownら、2020)やChinchilla(Hoffmannら、2022)のようなクローズドな事前訓練された競合の性能に匹敵する事前訓練されたLLMが公開されています、2020)やChinchilla (Hoffmann et al., 2022)のようなクローズドな事前訓練された競合に匹敵する性能を持つが、これらのモデルのどれもがChatGPT、BARD、Claudeのようなクローズドな “製品 “LLMの代替には適していない。”- メタ研究論文

安全性

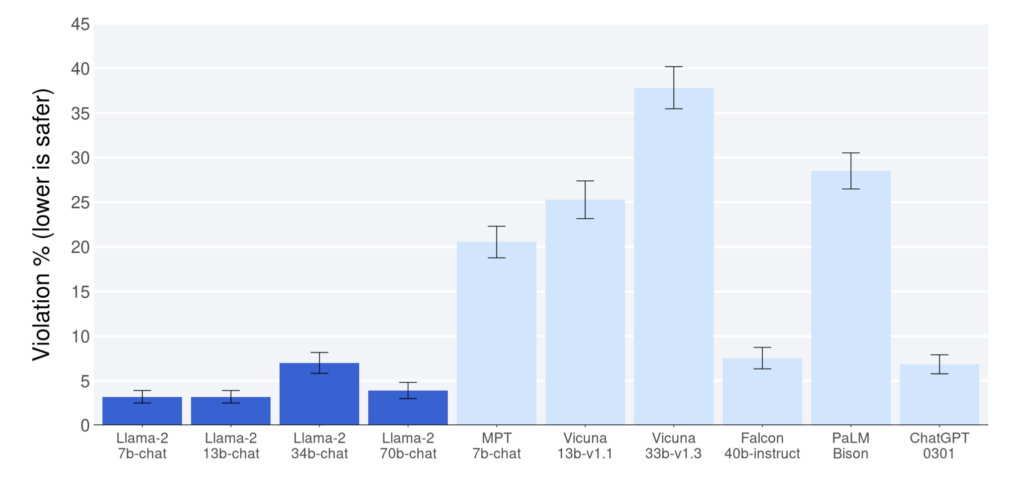

Meta research paperで発表された報告によると、Llama 2は、他のオープンソースモデルと比較して、有用性と安全性のベンチマークで優れたパフォーマンスを示している。 これらの点で、ChatGPT(7b、13b、70bモデル)を上回っている。 しかし、この研究論文は、ラマ2世に有利な偏ったデータがある可能性を認めており、結果を解釈する際にはそれを考慮する必要があることに注意する必要がある。 とはいえ、たとえラマ2がChatGPTベンチマークに近づいたとしても、賞賛に値する。

ラマ2の安全性に寄与する最も重要な要因のひとつは、そのデータプライバシーである。 いくつかのモデルとは異なり、Llama 2はOpenAIのような外部サーバーにデータを送信して応答を取得する必要はありません。 このユニークな属性は、ユーザーのデータを保護し、プライバシーを維持するのに役立つため、重要で機密性の高いユースケースで特に価値のあるモデルとなっている。 ユーザーは、自分のインフラ内にデータを収めたプライベートサーバー上でモデルを実行することができる。

オープンソース

現在使用されている最も一般的なLLMは、ブラックボックスとして動作しており、ユーザーはその機能を限定的にしか理解できない。 対照的に、オープンソースのモデルは透明なアプローチを提供し、ユーザーはその内部構造を理解することができる。 この透明性によって、スパムや偽情報の生成といった課題に直面する可能性があるにもかかわらず、このようなモデルを使用する際の自信と確信が生まれる。

さらに、これらのモデルのオープンソースとしての性質は、共同作業を促し、LLMの分野における継続的な改善と発展につながる。 その結果、オープンソースのモデルは、言語モデルの世界の進歩を推進する上で重要な役割を果たしている。

「そして、私たちはその方が安全だと信じています。今日のAIモデルへのアクセスをオープンにするということは、開発者や研究者の世代が、コミュニティとしてそれらをストレステストし、問題を迅速に特定し、解決できることを意味します。これらのツールが他の人々によってどのように使われているかを見ることで、我々のチームは彼らから学び、ツールを改善し、脆弱性を修正することができる。”- メタウェブサイト

Llama 2はオープンライセンスだが、Meta社は学習させたデータをまだ公開していない。 Meta社は、Llama 2の研究論文の中で、「個人に関する個人情報が大量に含まれていることが知られている特定のサイトからデータを削除する努力をした」と述べているが、そのサイトが何であるかは記載していない。

パフォーマンス

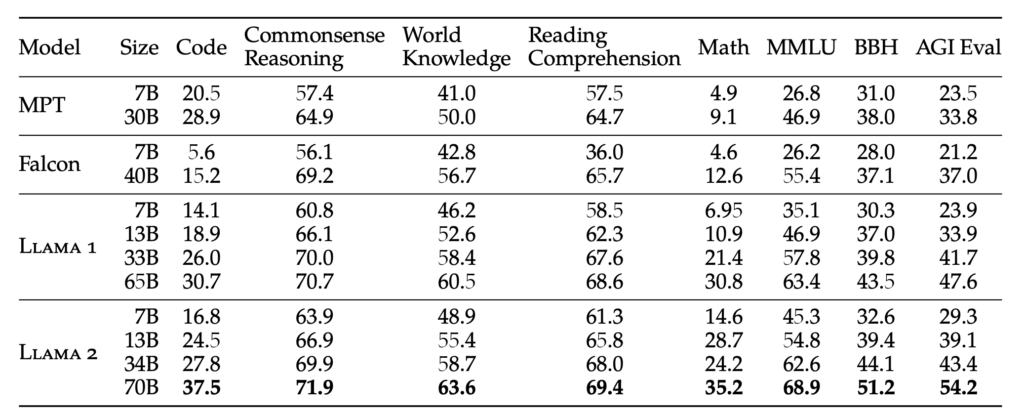

ラマ2のウエイトは4種類:7B、13B、34B、70B。 ウェイトは、モデルが学習したパラメータの数を表す。 一般的に、パラメータサイズが大きいほど、より正確で信頼性の高い応答が得られますが、計算リソースも大きくなります。 このモデルの人間らしい特性を向上させるため、ラマ2はインストラクション・チューニングと、GPTでも使われているRLHF(人間フィードバックによる強化学習)手法を使って微調整を行っている。

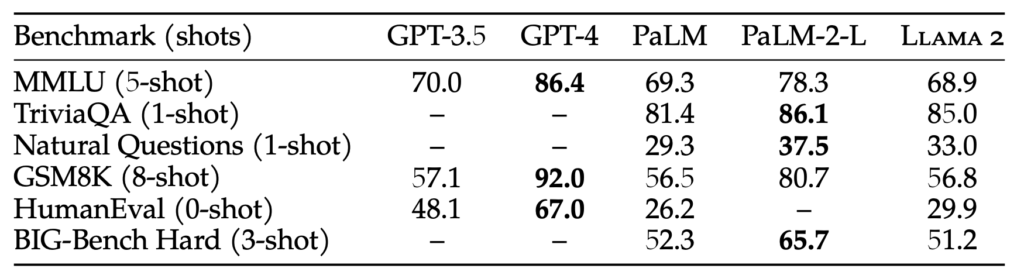

70Bのパラメータ・サイズはかなりのものだが、それでも175Bのパラメータ・サイズを持つGPT-3.5には及ばない。 その結果、Llama 2の性能はGPT-3.5には及ばないかもしれないが、ベンチマークテストでは、パラメータサイズが小さくても拮抗していることが示されている。 この違いにもかかわらず、Llama 2は現在入手可能な既存のオープンソースモデルをすべて凌駕している。

「RLHFは、微調整された言語モデルに適用されるモデル学習手順である。 人間の嗜好と指示に従ったモデル動作。我々は、経験的にサンプリングされた人間の嗜好を表すデータを収集し、それによって人間の注釈者が2つのモデル出力のうちどちらを好むかを選択する。この人間のフィードバックは、その後、報酬モデルの訓練に使用され、人間の注釈者の嗜好のパターンを学習し、嗜好の決定を自動化することができる。”- メタ研究論文

結論

実際、オープンソースのモデルは数多く登場しており、ラマ2のリリースによって、その可能性は無限に広がっている。 これらのオープンソースモデルがGPT-4のような先進的なものと直接競合するには時間がかかるかもしれないが、GPT-3.5の能力に近いモデルを手に入れることに興奮がある。 この進歩自体は本当に驚くべきことだ。

今後、LLMトレーニングの効率化が進めば、自分のローカル・デバイスで、自分のデータをもとに微調整されたパーソナライズされたChatGPTを利用できる可能性が出てくる。 そのような機能を提供するプラットフォームのひとつが、ビジネスをさまざまな側面からサポートするために調整されたインテリジェントなAIアシスタント、Codyである。 ChatGPTのように、Codyはあなたのビジネスデータ、チーム、プロセス、顧客について、独自のナレッジベースを使ってトレーニングすることができます。

Codyを利用することで、企業はAIの力を活用し、ニーズに特化したパーソナライズされたインテリジェントなアシスタントを作成することができる。