RAG como servicio: Desbloquea la IA Generativa para tu empresa

Con el auge de los grandes modelos lingüísticos (LLM) y las tendencias de la IA generativa, integrar soluciones de IA generativa en tu empresa puede potenciar la eficacia del flujo de trabajo. Si eres nuevo en la IA generativa, la plétora de jerga puede intimidarte. Este blog desmitificará las terminologías básicas de la IA generativa y te guiará sobre cómo empezar con una solución de IA personalizada para tu empresa con RAG-as-a-Service.

¿Qué es la Generación Aumentada de Recuperación (GRA)?

La Generación Aumentada por Recuperación (GRA) es un concepto clave en la aplicación de los LLM o la IA generativa en los flujos de trabajo empresariales. RAG aprovecha los modelos Transformer preentrenados para responder a consultas relacionadas con la empresa inyectando datos relevantes de tu base de conocimientos específica en el proceso de consulta. Estos datos, con los que los LLM pueden no haber sido entrenados, se utilizan para generar respuestas precisas y pertinentes.

La RAG es rentable y eficaz, lo que hace que la IA generativa sea más accesible. Exploremos algunas terminologías clave relacionadas con el GAR.

Terminologías clave en GAR

Agrupar

Los LLM consumen muchos recursos y se entrenan con longitudes de datos manejables conocidas como “Ventana de Contexto”. La Ventana de Contexto varía en función del LLM utilizado. Para abordar sus limitaciones, los datos empresariales proporcionados como documentos o literatura textual se segmentan en trozos más pequeños. Estos trozos se utilizan durante el proceso de recuperación de la consulta.

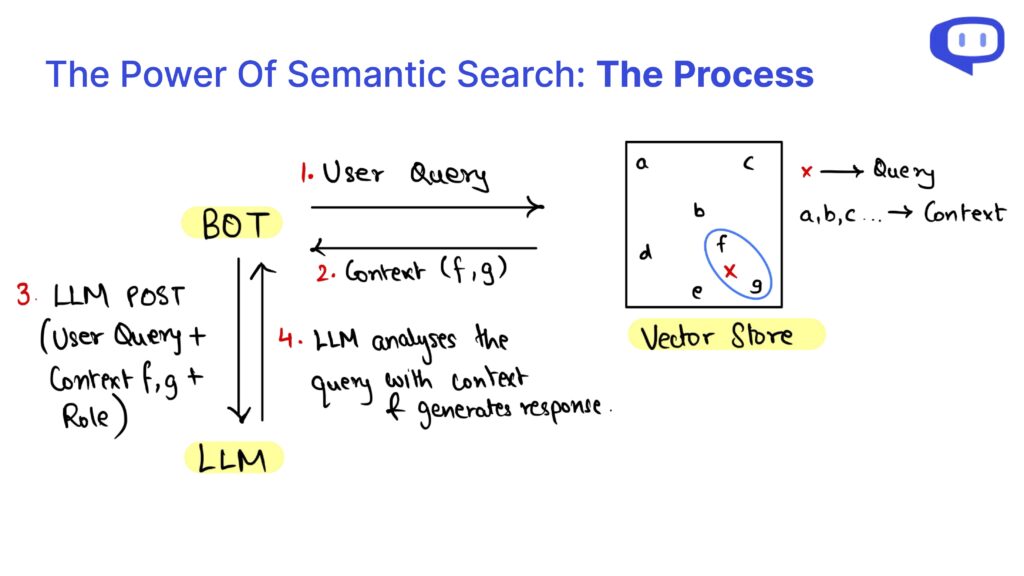

Como los trozos no están estructurados y las consultas pueden diferir sintácticamente de los datos de la base de conocimientos, los trozos se recuperan utilizando la búsqueda semántica.

Bases de datos vectoriales

Las bases de datos vectoriales como Pinecone, Chromadb y FAISS almacenan las incrustaciones de los datos empresariales. Las incrustaciones convierten los datos textuales en forma numérica basándose en su significado y se almacenan en un espacio vectorial de alta dimensión donde los datos semánticamente similares están más próximos.

Cuando se realiza una consulta de usuario, se utilizan las incrustaciones de la consulta para encontrar trozos semánticamente similares en la base de datos vectorial.

RAG como servicio

Implantar el GAR en tu empresa puede ser desalentador si careces de conocimientos técnicos. Aquí es donde entra en juego el RAG como servicio (RaaS).

En meetcody.ai ofrecemos una solución plug-and-play para las necesidades de tu empresa. Sólo tienes que crear una cuenta con nosotros y empezar gratis. Nos encargamos de la fragmentación, las bases de datos vectoriales y todo el proceso de RAG, proporcionándote total tranquilidad.

Preguntas frecuentes

1. ¿Qué es RAG-as-a-Service (RaaS)?

RAG-as-a-Service (RaaS) es una solución integral que gestiona todo el proceso de Generación Aumentada de Recuperación para tu empresa. Esto incluye la fragmentación de datos, el almacenamiento de incrustaciones en bases de datos vectoriales y la gestión de la búsqueda semántica para recuperar datos relevantes para las consultas.

2. ¿Cómo ayuda la fragmentación en el proceso GAR?

La fragmentación divide los grandes documentos empresariales en partes más pequeñas y manejables que encajan en la Ventana de Contexto del LLM. Esta segmentación permite a la LLM procesar y recuperar información relevante de forma más eficaz mediante la búsqueda semántica.

3. ¿Qué son las bases de datos vectoriales y por qué son importantes?

Las bases de datos vectoriales almacenan las representaciones numéricas (incrustaciones) de los datos de tu empresa. Estas incrustaciones permiten la recuperación eficaz de datos semánticamente similares cuando se realiza una consulta, garantizando respuestas precisas y pertinentes del LLM.

Integra RAG en tu empresa con facilidad y eficacia aprovechando la potencia de RAG como servicio. Empieza hoy mismo con meetcody.ai y transforma tu flujo de trabajo con soluciones avanzadas de IA generativa.