Im Jahr 2025 ist die Welt der künstlichen Intelligenz sehr aufregend geworden. Die großen Technologieunternehmen liefern sich einen erbitterten Wettbewerb, um die fortschrittlichsten KI-Systeme aller Zeiten zu entwickeln. Dieser intensive Wettbewerb hat viele neue Ideen hervorgebracht und die Grenzen dessen, was KI beim Denken, beim Lösen von Problemen und bei der Interaktion mit dem Menschen leisten kann, verschoben. In den letzten Monaten gab es erstaunliche Verbesserungen, wobei zwei Hauptakteure den Weg geebnet haben: Googles Gemini 2.5 Pro und OpenAIs GPT-4.5. In einer großen Enthüllung im März 2025 stellte Google Gemini 2.5 Pro vor, das sie als ihre bisher intelligenteste Kreation bezeichnen. Es wurde schnell zum Spitzenreiter in der LMArena-Rangliste und ließ seine Konkurrenten hinter sich. Das Besondere an Gemini 2.5 ist seine Fähigkeit, Antworten sorgfältig abzuwägen, wodurch er bei komplexen Aufgaben, die tiefes Denken erfordern, besser abschneidet.

Um nicht ins Hintertreffen zu geraten, hat OpenAI GPT-4.5 auf den Markt gebracht, ihr bisher größtes und fortschrittlichstes Chat-Modell. Dieses Modell ist hervorragend darin, Muster zu erkennen, Verbindungen herzustellen und kreative Ideen zu entwickeln. Erste Tests zeigen, dass sich die Interaktion mit GPT-4.5 sehr natürlich anfühlt, da es über ein breites Wissen verfügt und besser versteht, was die Benutzer meinen. OpenAI hebt die signifikanten Verbesserungen von GPT-4.5 beim Lernen ohne direkte Aufsicht hervor, die für eine reibungslose Zusammenarbeit mit Menschen entwickelt wurden.

Diese KI-Systeme sind nicht nur eine beeindruckende Technologie, sie verändern auch die Art und Weise, wie Unternehmen arbeiten, beschleunigen wissenschaftliche Entdeckungen und transformieren kreative Projekte. Während KI ein normaler Bestandteil des täglichen Lebens wird, erweitern Modelle wie Gemini 2.5 Pro und GPT-4.5 das, was wir für möglich halten. Mit besseren Denkfähigkeiten, einer geringeren Wahrscheinlichkeit, falsche Informationen zu verbreiten, und der Beherrschung komplexer Probleme ebnen sie den Weg für KI-Systeme, die den menschlichen Fortschritt wirklich unterstützen.

Verstehen von Gemini 2.5 Pro

Am 25. März 2025 stellte Google offiziell Gemini 2.5 Pro vor, das als sein bisher “intelligentestes KI-Modell” bezeichnet wird. Diese Veröffentlichung markiert einen bedeutenden Meilenstein in der KI-Entwicklung von Google, nachdem mehrere Iterationen der 2.0-Modelle erfolgt waren. Die Veröffentlichungsstrategie begann zunächst mit der experimentellen Version, die den Abonnenten von Gemini Advanced einen frühen Zugang zum Testen der Fähigkeiten ermöglichte.

Was Gemini 2.5 Pro von seinen Vorgängern unterscheidet, ist seine grundlegende Architektur als“Denkmodell”. Im Gegensatz zu früheren Generationen, die sich in erster Linie auf trainierte Datenmuster stützten, kann dieses Modell aktiv über seine Gedanken nachdenken, bevor es antwortet, und so menschliche Problemlösungsprozesse imitieren. Dies ist ein bedeutender Fortschritt in der Art und Weise, wie KI-Systeme Informationen verarbeiten und Antworten erzeugen.

Hauptmerkmale und Funktionen:

- Verbessertes logisches Denken – Fähigkeit zur schrittweisen Problemlösung in komplexen Bereichen

- Erweitertes Kontext-Fenster – 1 Million Token-Kapazität (mit Plänen zur Erweiterung auf 2 Millionen)

- Native Multimodalität – Nahtlose Verarbeitung von Text, Bildern, Audio, Video und Code

- Erweiterte Code-Funktionen – Signifikante Verbesserungen bei der Erstellung von Webanwendungen und der Codeumwandlung

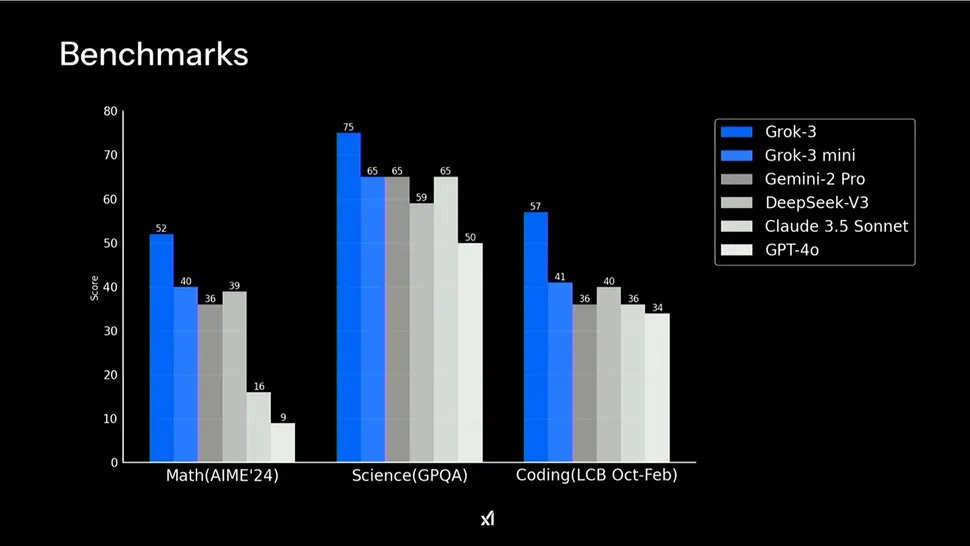

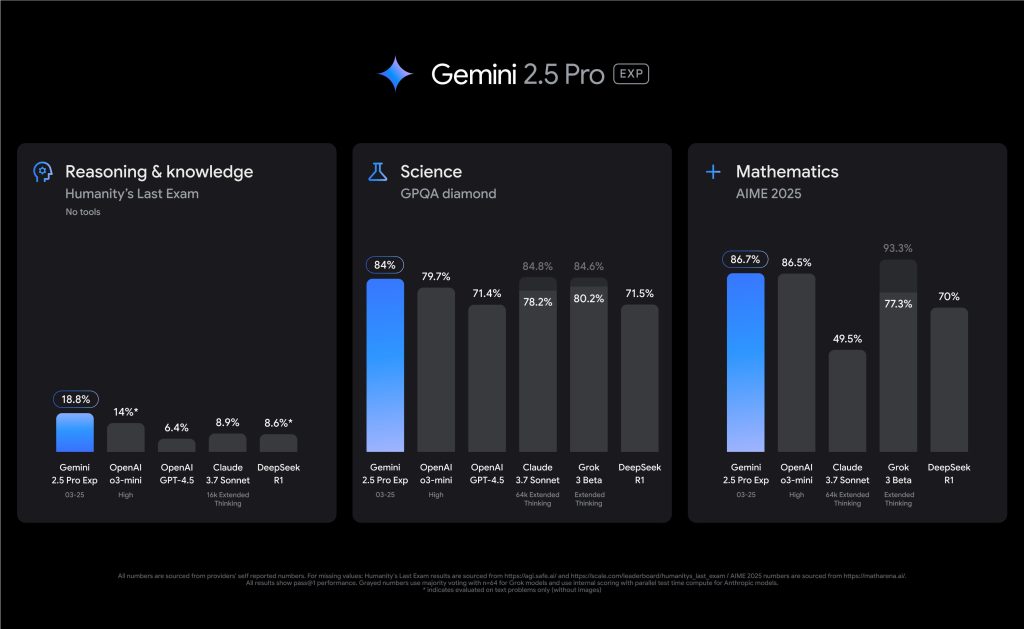

Gemini 2.5 Pro hat sich als Leistungsführer etabliert und steht erstmals auf Platz 1 der LMArena-Bestenliste. Es zeichnet sich besonders bei Benchmarks aus, die fortgeschrittenes logisches Denken erfordern, und erzielte bei Humanity’s Last Exam ohne externe Hilfsmittel ein branchenführendes Ergebnis von 18,8%. In den Bereichen Mathematik und Naturwissenschaften beweist er eine bemerkenswerte Kompetenz mit Ergebnissen von 86,7% bei AIME 2025 bzw. 79,7% bei GPQA diamond.

Im Vergleich zu früheren Gemini-Modellen stellt die Version 2.5 Pro einen erheblichen Sprung nach vorn dar. Während Gemini 2.0 wichtige grundlegende Fähigkeiten einführte, kombiniert 2.5 Pro ein deutlich verbessertes Basismodell mit verbesserten Post-Training-Techniken. Die bemerkenswertesten Verbesserungen zeigen sich bei der Kodierleistung, der Argumentationstiefe und dem kontextuellen Verständnis – Bereiche, in denen frühere Versionen Einschränkungen aufwiesen.

GPT-4.5 erforschen

Im April 2025 stellte OpenAI GPT-4.5 vor und bezeichnete es als sein “bisher größtes und fortschrittlichstes Chat-Modell”, was eine bemerkenswerte Leistung in der Entwicklung großer Sprachmodelle darstellt. Diese Forschungsvorschau löste in der KI-Gemeinschaft sofort Begeisterung aus. Erste Tests zeigten, dass sich die Interaktionen mit dem Modell dank seiner umfangreichen Wissensbasis und seiner verbesserten Fähigkeit, die Absicht des Benutzers zu verstehen, außergewöhnlich natürlich anfühlen.

GPT-4.5 zeigt bedeutende Fortschritte bei den unüberwachten Lernfähigkeiten. OpenAI hat diesen Fortschritt durch die Skalierung der Rechenleistung und des Dateninputs sowie durch den Einsatz innovativer Architektur- und Optimierungsstrategien erzielt. Das Modell wurde auf Microsoft Azure KI-Supercomputern trainiert, womit eine Partnerschaft fortgesetzt wird, die es OpenAI ermöglicht, die Grenzen des Möglichen zu erweitern.

Kernverbesserungen und -fähigkeiten:

- Verbesserte Mustererkennung – Erheblich verbesserte Fähigkeit, Muster zu erkennen, Verbindungen herzustellen und kreative Einsichten zu gewinnen

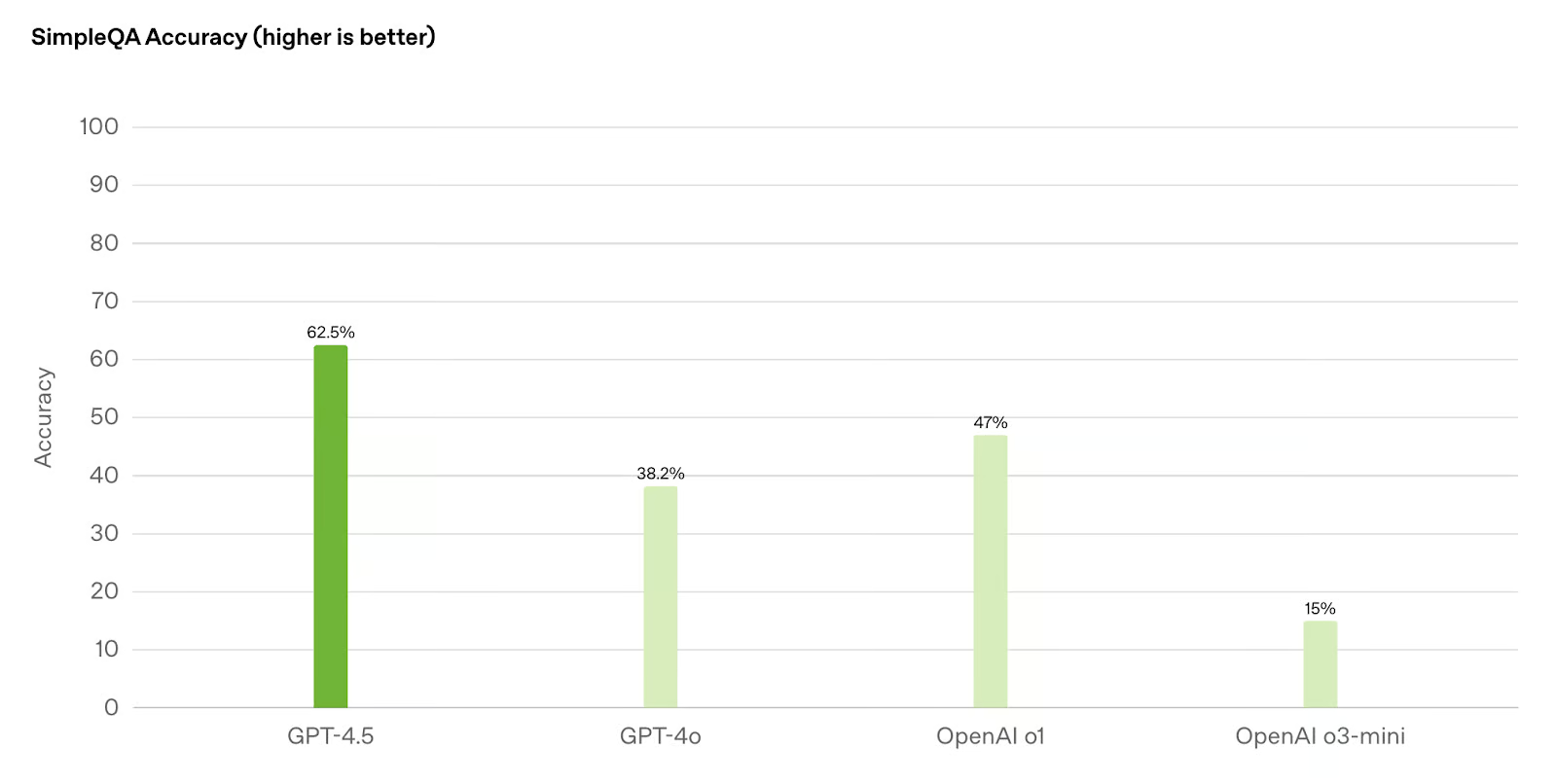

- Weniger Halluzinationen – Geringere Wahrscheinlichkeit der Erzeugung falscher Informationen im Vergleich zu früheren Modellen wie GPT-4o und o1

- Verbesserter “EQ” – Größere emotionale Intelligenz und Verständnis für nuancierte menschliche Interaktionen

- Erweiterte Steuerbarkeit – Besseres Verständnis und Befolgung komplexer Benutzeranweisungen

OpenAI hat besonderen Wert darauf gelegt, GPT-4.5 für die menschliche Zusammenarbeit zu trainieren. Neue Techniken verbessern die Steuerbarkeit des Modells, das Verständnis für Nuancen und den natürlichen Gesprächsfluss. Das macht es besonders effektiv in der Schreib- und Designunterstützung, wo es eine stärkere ästhetische Intuition und Kreativität zeigt als frühere Versionen.

In realen Anwendungen zeigt GPT-4.5 eine bemerkenswerte Vielseitigkeit. Dank seiner erweiterten Wissensbasis und verbesserten Argumentationsfähigkeiten eignet es sich für eine breite Palette von Aufgaben, von der detaillierten Erstellung von Inhalten bis hin zu anspruchsvollen Problemlösungen. Der CEO von OpenAI, Sam Altman, hat das Modell positiv beschrieben und seine “einzigartige Effektivität” hervorgehoben, obwohl es nicht in allen Benchmark-Kategorien führend ist.

Die Einführungsstrategie für GPT-4.5 spiegelt den maßvollen Ansatz von OpenAI bei der Veröffentlichung leistungsstarker KI-Systeme wider. Zunächst steht es ChatGPT Pro-Abonnenten und Entwicklern auf kostenpflichtigen Ebenen über verschiedene APIs zur Verfügung. Das Unternehmen plant, den Zugang schrittweise auf ChatGPT Plus-, Team-, Edu- und Enterprise-Abonnenten auszuweiten. Diese schrittweise Einführung ermöglicht es OpenAI, die Leistung und Sicherheit zu überwachen, wenn die Nutzung zunimmt.

Leistungsmetriken: Eine vergleichende Analyse

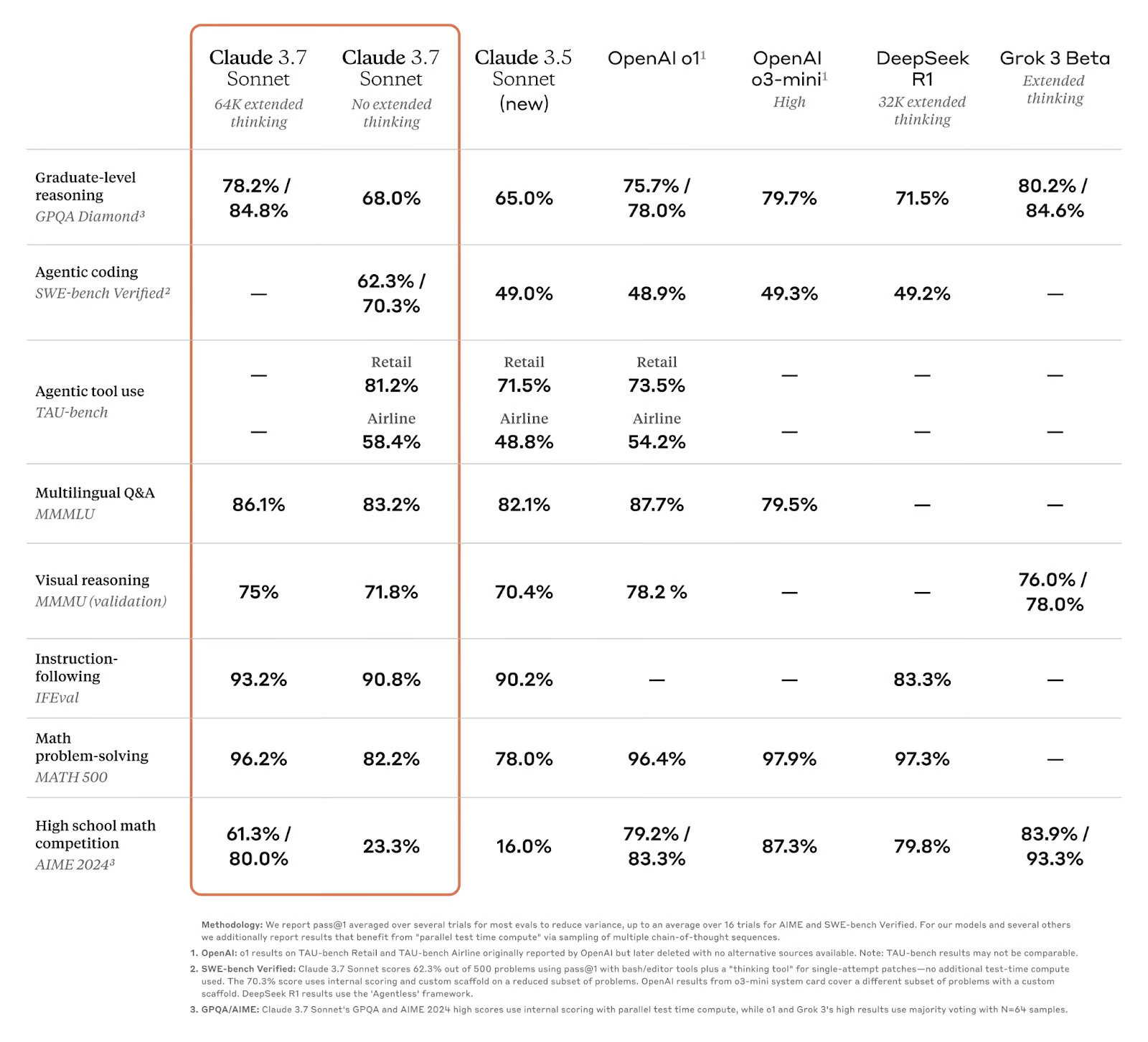

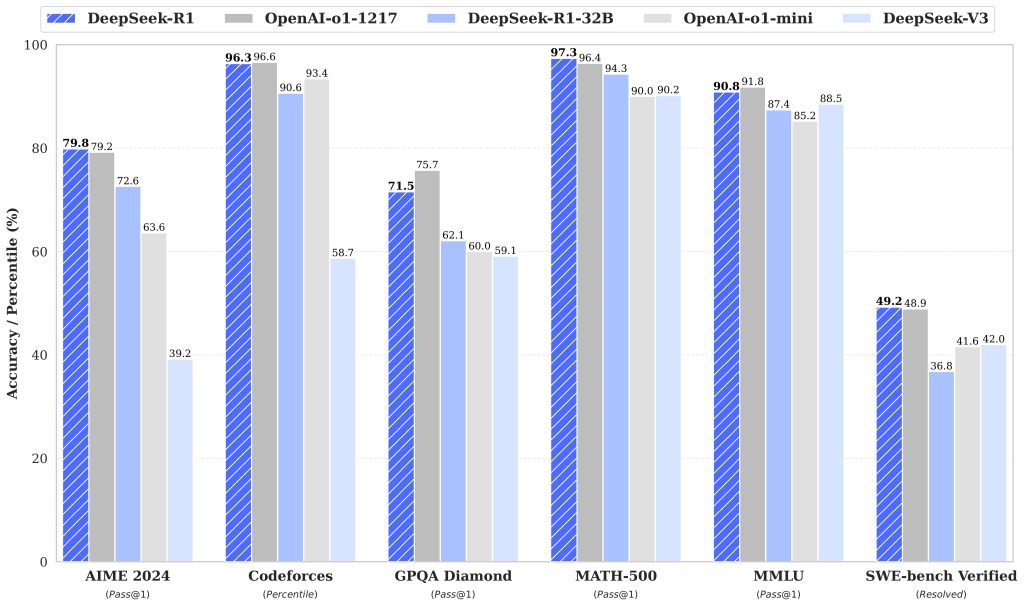

Bei der Untersuchung der technischen Fähigkeiten dieser fortschrittlichen KI-Modelle ist die Benchmark-Leistung der objektivste Maßstab für ihre Fähigkeiten. Gemini 2.5 Pro und GPT-4.5 zeigen jeweils einzigartige Stärken in verschiedenen Bereichen, wobei Benchmark-Tests ihre deutlichen Vorteile offenbaren.

| Benchmark | Gemini 2.5 Pro (03-25) | OpenAI GPT-4.5 | Claude 3.7 Sonnet | Grok 3 Vorschau |

|---|---|---|---|---|

| LMArena (Gesamt) | #1 | 2 | 21 | 2 |

| Die letzte Prüfung der Menschheit (Keine Werkzeuge) | 18.8% | 6.4% | 8.9% | – |

| GPQA Diamant (Einzelversuch) | 84.0% | 71.4% | 78.2% | 80.2% |

| AIME 2025 (Einzelversuch) | 86.7% | – | 49.5% | 77.3% |

| SWE-Bench Verifiziert | 63.8% | 38.0% | 70.3% | – |

| Aider Polyglot (Ganzes/Diff) | 74.0% / 68.6% | 44.9% diff | 64,9% diff | – |

| MRCR (128k) | 91.5% | 48.8% | – | – |

Gemini 2.5 Pro zeigt eine außergewöhnliche Stärke bei schlussfolgernden Aufgaben, insbesondere beim Denken in langen Zusammenhängen und beim Behalten von Wissen. Bei der letzten Prüfung der Menschheit, bei der die Grenzen des menschlichen Wissens getestet werden, übertrifft er die Konkurrenz deutlich. Allerdings zeigt es relative Schwächen bei der Codegenerierung und der agentenbasierten Kodierung und kämpft gelegentlich mit der Faktizität in bestimmten Bereichen.

GPT-4.5 hingegen zeigt besondere Exzellenz bei der Mustererkennung, der Generierung kreativer Erkenntnisse und dem wissenschaftlichen Denken. Es schneidet im GPQA-Diamant-Benchmark am besten ab und zeigt starke Fähigkeiten in wissenschaftlichen Domänen. Das Modell weist auch eine verbesserte emotionale Intelligenz und ästhetische Intuition auf, was es für kreative und designorientierte Anwendungen besonders wertvoll macht. Ein entscheidender Vorteil ist die geringere Tendenz zur Generierung falscher Informationen im Vergleich zu seinen Vorgängern.

In der Praxis ist Gemini 2.5 Pro die beste Wahl für Aufgaben, die tiefes logisches Denken, multimodales Verstehen und den Umgang mit extrem langen Kontexten erfordern. GPT-4.5 bietet Vorteile bei der kreativen Arbeit, bei der Designunterstützung und bei Anwendungen, bei denen sachliche Präzision und ein natürlicher Gesprächsfluss von größter Bedeutung sind.

Anwendungen und Anwendungsfälle

Während die Benchmark-Leistungen wertvolle technische Erkenntnisse liefern, liegt der wahre Maßstab für diese fortschrittlichen KI-Modelle in ihren praktischen Anwendungen in verschiedenen Bereichen. Sowohl Gemini 2.5 Pro als auch GPT-4.5 weisen unterschiedliche Stärken auf, die sie für verschiedene Anwendungsfälle geeignet machen. Unternehmen haben bereits damit begonnen, ihre Fähigkeiten zur Lösung komplexer Probleme zu nutzen.

Gemini 2.5 Pro in wissenschaftlichen und technischen Bereichen

Die außergewöhnlichen Argumentationsfähigkeiten und das umfangreiche Kontextfenster von Gemini 2.5 Pro machen es besonders wertvoll für wissenschaftliche Forschung und technische Anwendungen. Seine Fähigkeit, multimodale Daten – einschließlich Text, Bilder, Audio, Video und Code – zu verarbeiten und zu analysieren, ermöglicht es, komplexe Probleme zu bewältigen, die eine Synthese von Informationen aus verschiedenen Quellen erfordern. Diese Vielseitigkeit eröffnet zahlreiche Möglichkeiten in Branchen, die technische Präzision und umfassende Analysen erfordern.

- Wissenschaftliche Forschung und Datenanalyse – Die starke Leistung von Gemini 2.5 Pro bei Benchmarks wie GPQA (79,7%) zeigt, dass es Forschern bei der Analyse komplexer wissenschaftlicher Literatur, der Erstellung von Hypothesen und der Interpretation von Versuchsergebnissen helfen kann.

- Software-Entwicklung und -Engineering – Das Modell zeichnet sich durch die Erstellung von Webanwendungen, die Durchführung von Code-Transformationen und die Entwicklung komplexer Programme aus (63,8% im SWE-Bench Verified unter Verwendung benutzerdefinierter Agenten-Setups).

- Medizinische Diagnose und Gesundheitsfürsorge – Seine Schlussfolgerungsfunktionen ermöglichen die Analyse medizinischer Bilder zusammen mit Patientendaten, um medizinisches Fachpersonal bei Diagnoseprozessen zu unterstützen.

- Big Data-Analysen und Wissensmanagement – Das Kontextfenster mit 1 Million Token (bald auf 2 Millionen erweiterbar) ermöglicht die Verarbeitung ganzer Datensätze und Code-Repositories in einer einzigen Eingabeaufforderung

GPT-4.5’s Exzellenz in kreativen und kommunikativen Aufgaben

Im Gegensatz dazu zeigt GPT-4.5 eine besondere Stärke bei Aufgaben, die eine nuancierte Kommunikation, kreatives Denken und ästhetisches Urteilsvermögen erfordern. OpenAI hat dieses Modell speziell für die menschliche Zusammenarbeit trainiert, was zu verbesserten Fähigkeiten bei der Erstellung von Inhalten, der Designunterstützung und der natürlichen Kommunikation führt.

- Erstellung von Inhalten und Schreiben – GPT-4.5 zeigt ein verbessertes ästhetisches Gespür und Kreativität, was es für die Erstellung von Marketingtexten, Artikeln, Drehbüchern und anderen schriftlichen Inhalten wertvoll macht.

- Zusammenarbeit beim Design – Das verbesserte Verständnis von Nuancen und Kontexten macht das Modell zu einem effektiven Partner in Designprozessen, von der Konzeption bis zur Verfeinerung

- Kundenengagement – Mit einer größeren emotionalen Intelligenz bietet GPT-4.5 angemessenere und natürlichere Reaktionen im Kundenservice.

- Entwicklung von Bildungsinhalten – Das Modell eignet sich hervorragend, um Erklärungen auf unterschiedliche Wissensstände und Lernstile abzustimmen.

Unternehmen aus verschiedenen Branchen integrieren diese Modelle bereits in ihre Arbeitsabläufe. Microsoft hat die Technologie von OpenAI direkt in seine Produktsuite integriert, so dass Unternehmensanwender unmittelbaren Zugang zu den Fähigkeiten von GPT-4.5 haben. In ähnlicher Weise findet Googles Gemini 2.5 Pro Anwendung in Forschungsinstituten und Technologieunternehmen, die seine Stärken im Bereich des Denkens und der Multimodalität nutzen wollen.

Die komplementären Stärken dieser Modelle lassen vermuten, dass viele Unternehmen je nach Anwendungsfall von der Nutzung beider Modelle profitieren können. Mit der weiteren Reifung dieser Technologien können wir mit immer ausgefeilteren Anwendungen rechnen, die Wissensarbeit, kreative Prozesse und Problemlösungen in allen Branchen grundlegend verändern.

Die Zukunft der KI: Was kommt als Nächstes?

Während Gemini 2.5 Pro und GPT-4.5 die Grenzen des Machbaren verschieben, wird die zukünftige Entwicklung der KI immer deutlicher. Das Engagement von Google, “Denkfähigkeiten direkt in alle Modelle einzubauen”, deutet auf eine Zukunft hin, in der logisches Denken zum Standard in allen KI-Systemen wird. Auch der Ansatz von OpenAI, “unüberwachtes Lernen und schlussfolgerndes Denken zu skalieren”, deutet auf Modelle hin, deren Fähigkeiten, menschenähnliche Inhalte zu verstehen und zu generieren, ständig zunehmen.

In den kommenden Jahren werden wir wahrscheinlich KI-Modelle sehen, deren Kontextfenster über die derzeitigen Grenzen hinaus dramatisch erweitert werden, die anspruchsvollere Schlussfolgerungen ziehen und die nahtlose Integration über alle Modalitäten hinweg ermöglichen. Wir könnten auch den Aufstieg wirklich autonomer KI-Agenten erleben, die in der Lage sind, komplexe Aufgaben mit minimaler menschlicher Aufsicht auszuführen. Diese Fortschritte bringen jedoch auch erhebliche Herausforderungen mit sich. In dem Maße, in dem die KI-Fähigkeiten zunehmen, wird es auch immer wichtiger, potenzielle Risiken in Bezug auf Fehlinformationen, Datenschutz und die Verdrängung menschlicher Arbeitskraft zu bewältigen.

Ethische Überlegungen müssen bei der Entwicklung von KI an vorderster Front stehen. OpenAI erkennt an, dass “jede Steigerung der Modellfähigkeiten eine Gelegenheit ist, die Modelle sicherer zu machen”, und betont die doppelte Verantwortung für Fortschritt und Schutz. Die KI-Gemeinschaft muss robuste Governance-Rahmenwerke entwickeln, die Innovationen fördern und gleichzeitig vor Missbrauch schützen.

Die KI-Revolution, für die Gemini 2.5 Pro und GPT-4.5 stehen, steht erst am Anfang. Während das Tempo des Fortschritts sowohl Aufregung als auch Besorgnis hervorruft, ist eines klar: Die Zukunft der KI wird nicht nur durch die technologischen Fähigkeiten definiert, sondern auch dadurch, wie wir sie zum Nutzen der Menschen einsetzen. Wenn wir einer verantwortungsvollen Entwicklung den Vorrang geben, die das menschliche Potenzial erweitert, anstatt es zu ersetzen, können wir sicherstellen, dass die nächste Generation von KI-Modellen als leistungsstarke Werkzeuge für den kollektiven Fortschritt dienen.